关于kafka-clients JAVA API的基本使用

首先老规矩, 引入maven依赖

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>1.0.0</version>

</dependency>

关于kafka-clients的消息生产者:

@Slf4j

public class KafkaProducerClient { public static void pushMsg(String msg) throws Exception {

Properties props = new Properties();

props.put("bootstrap.servers", KafkaConstant.KAFKA_SERVER_ADDRESS);

props.put("acks", "0");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer producer = new KafkaProducer(props);

ProducerRecord<String, String> record = new ProducerRecord<>(KafkaConstant.KAFKA_TOPIC_NAME, 0, "123", msg);

producer.send(record, new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception e) {

if (e != null) {

e.printStackTrace();

}

log.info("pushMsg of msg: {}, metadata: {}", msg, metadata);

}

});

producer.close();

} }

关于kafka-clients的消息消费者

@Slf4j

public class KafkaConsumerClient extends Thread { private KafkaConsumerClient() {

} /**

* 初始化consumer

*/

public void initKafkaConsumer () {

log.info("init Kafka Consumer");

new KafkaConsumerClient().start();

} @Override

public void run() {

Properties props = new Properties(); props.put("bootstrap.servers", KafkaConstant.KAFKA_SERVER_ADDRESS);

props.put("group.id", "1");

props.put("enable.auto.commit", "true");

props.put("auto.commit.interval.ms", "1000");

props.put("session.timeout.ms", "30000");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer"); Consumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Arrays.asList(KafkaConstant.KAFKA_TOPIC_NAME));

consumer.seekToBeginning(new ArrayList<>()); // ===== 拿到所有的topic ===== //

Map<String, List<PartitionInfo>> listTopics = consumer.listTopics();

Set<Map.Entry<String, List<PartitionInfo>>> entries = listTopics.entrySet(); while (true) {

ConsumerRecords<String, String> records = consumer.poll(1000 * 60);

for(ConsumerRecord<String, String> record : records) {

System.out.println("[fetched from partition " + record.partition() + ", offset: " + record.offset() + ", message: " + record.value() + "]");

}

}

}

}

我们需要在项目启动的时候将消费者consumer启动起来

<bean id="initKafkaConsumer" class="com.dywl.zhoushan.kafka.KafkaConsumerClient" init-method="initKafkaConsumer"></bean>

然后调用生产者producer时, 消费者consumer就能拿到消息

如:

@Override

public void pushMsgById(Long id) throws Exception {

User user = new User();

user.setId(id);

user.setUsername("test11111111");

user.setPassword("test22222222");

String str = JsonUtil.toCompactJsonString(user);

log.info("pushMsgById is user: {}", str);

KafkaProducerClient.pushMsg(str);

}

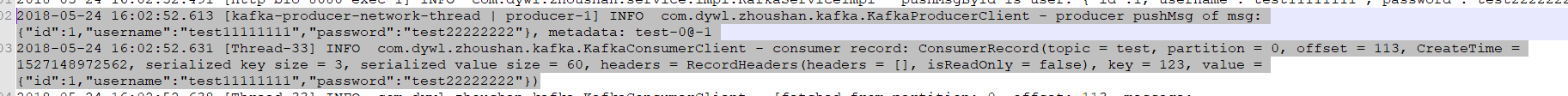

得到结果:

关于kafka-clients JAVA API的基本使用的更多相关文章

- kafka系列五、kafka常用java API

引入maven包 <dependency> <groupId>org.apache.kafka</groupId> <artifactId>kafka- ...

- java api如何获取kafka所有Topic列表,并放置为一个list

kafka内部所有的实现都是通过TopicCommand的main方法,通过java代码调用API,TopicCommand.main(options)的方式只能打印到控制台,不能转换到一个list. ...

- kafka2.9.2的伪分布式集群安装和demo(java api)测试

目录: 一.什么是kafka? 二.kafka的官方网站在哪里? 三.在哪里下载?需要哪些组件的支持? 四.如何安装? 五.FAQ 六.扩展阅读 一.什么是kafka? kafka是LinkedI ...

- ubuntu12.04+kafka2.9.2+zookeeper3.4.5的伪分布式集群安装和demo(java api)测试

博文作者:迦壹 博客地址:http://idoall.org/home.php?mod=space&uid=1&do=blog&id=547 转载声明:可以转载, 但必须以超链 ...

- 4 kafka集群部署及kafka生产者java客户端编程 + kafka消费者java客户端编程

本博文的主要内容有 kafka的单机模式部署 kafka的分布式模式部署 生产者java客户端编程 消费者java客户端编程 运行kafka ,需要依赖 zookeeper,你可以使用已有的 zo ...

- Java API获取topic所占磁盘空间(Kafka 1.0.0)

很多用户都有这样的需求:实时监控某个topic各分区在broker上所占的磁盘空间大小总和.Kafka并没有提供直接的脚本工具用于统计这些数据. 如果依然要实现这个需求,一种方法是通过监控JMX指标得 ...

- Kafka系列三 java API操作

使用java API操作kafka 1.pom.xml <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xs ...

- Kafka笔记整理(二):Kafka Java API使用

下面的测试代码使用的都是下面的topic: $ kafka-topics.sh --describe hadoop --zookeeper uplooking01:,uplooking02:,uplo ...

- kafka java API的使用

Kafka包含四种核心的API: 1.Producer API支持应用将数据流发送到Kafka集群的主题 2.Consumer API支持应用从Kafka集群的主题中读取数据流 3.Streams A ...

- _00017 Kafka的体系结构介绍以及Kafka入门案例(0基础案例+Java API的使用)

博文作者:妳那伊抹微笑 itdog8 地址链接 : http://www.itdog8.com(个人链接) 博客地址:http://blog.csdn.net/u012185296 博文标题:_000 ...

随机推荐

- HDU3549 最大流 裸题

EK算法 时间复杂度o(n*m*m) 因为有反向边每次bfs时间为 n*m 每次删一条边 最多m次 代码 #include<iostream> #include<string.h& ...

- POJ 2192 【DP】

题意: 给三个字符串,判断前两个在相对顺序不变的情况下是否可以组成第三个字符串. 思路: 先说屌丝: dp[i][j]代表1串的前i个和2串的前j个字符在3串的前i+j个字符中最多能够组合出几个字符. ...

- Java日志框架-Logback手册中文版以及官方配置文档教程

Logback手册中文版:(链接: https://pan.baidu.com/s/1bpMyasR 密码: 6u5c),虽然版本有点旧,但是大体意思差不多,先用中文版了解个大概,然后一切最新的配置以 ...

- iOS中MRC和ARC混编

1. 在targets的build phases选项下Compile Sources下选择,不使用arc编译的文件.双击它.输入 -fno-objc-arc 就可以(这个类就能够使用MRC模式) 2. ...

- COCOS2DX学习之Box2d物理引擎使用之------动态物体的创建

1.创建一个物理世界 首先要引入一个头文件#include "Box2D\Box2D.h" 之后利用b2word创建一个对象,而且指定这个物理世界中的加速度方向. word = n ...

- 说说Android应用的persistent属性(转)

1 启动persistent应用 在Android系统中,有一种永久性应用.它们对应的AndroidManifest.xml文件里,会将persistent属性设为true,比如: <appli ...

- 常用近百个js代码汇总

//檢查空串 function isEmpty(str){ )) return (true); else return(false); } //檢查是否未數字 function isDigit(the ...

- oracle获取字符串长度函数length()和lengthb()

oracle获取字符串长度函数length()和lengthb() lengthb(string)计算string所占的字节长度:返回字符串的长度,单位是字节 length(string)计算st ...

- 4448: [Scoi2015]情报传递|主席树|离线操作

能够把全部的操作离线,然后树链剖分将全部人搜集情报的时间增加到主席树中,查询的时候能够直接查询搜集情报时间≤i−C[i]−1的人的个数 时间复杂度n∗log22n,空间复杂度n∗log2n #incl ...

- 安卓版本和Api Level

Platform Version API Level VERSION_CODE Notes Android 4.4 19 KITKAT Platform Highlights Android 4.3 ...