python分布式进程

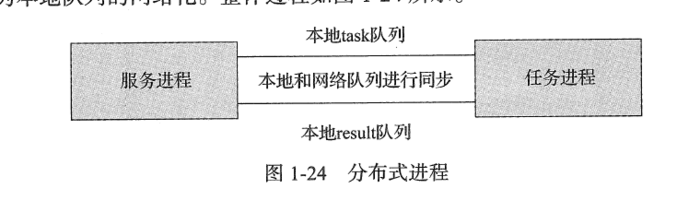

分布式进程指的是将Process进程分布到多台机器上,充分利用多态机器的性能完成复杂的任务

分布式进程在python 中依然要用到multiprocessing 模块。multiprocessing模块不但支持多进程,其中managers子模块还支持把多进程分布到多台机器上。可以写一个服务进程作为调度者,将任务分布到其他多

个进程中,依靠网络通信进行管理。例子:在做爬虫程序时,抓取某个网站的所有图片,如果使用多进程的话,一般是一个进程负责抓取图片的链接地址,将链接地址放到queue中,另外的进程负责从queue中取链接地址进行下载和存储到本地。现在把这个过程做成分布式,一台机器上的进程负责抓取链接地址,其他机器上的进程负责系在存储。那么遇到的主要问题是将queue 暴露到网络中,让其他机器进程都可以访问,分布式进程就是将这个过程进行了封装,我们可以将这个过程称为本地队列的网络化

要实现上面例子的功能,创建分布式进程需要分为 六个步骤

- 建立队列Queue ,用来进行进程间通信。服务进程创建任务队列task_queue 用来作为传递任务给任务进程的通道;服务进程创建结果队列result_queue ,作为任务进程完成任务后回复服务进程的通道。在分布式多进程环境下,必须由Queuemanager获得Queue 接口来添加任务

- 把第一步中建立的队列在网络上注册,暴露给其他进程(主机),注册后获得网络队列,相当于本地队列的映像

- 建立一个对象(Queuemanager(BaseManager))实例manager,绑定端口和验证口令

- 启动第三步中建立的实例,即启动管理manager,监管信息通道

- 通过管理实例的方法获得通过网络访问的Queue对象,即再把网络队列实体化成可以使用的本地队列

- 创建任务到 “本地”队列中,自动上传任务到网络队列中,分配给任务进程进行处理

接下来通过程序实现上面的列子(window版),首先编写的是服务进程(taskManager.py)

#!coding:utf-8

from multiprocessing.managers import BaseManager

from multiprocessing import freeze_support, Queue

# 任务个数

task_number = 10

# 收发队列

task_quue = Queue(task_number)

result_queue = Queue(task_number)

def get_task():

return task_quue

def get_result():

return result_queue

# 创建类似的queueManager

class QueueManager(BaseManager):

pass

def win_run():

# 注册在网络上,callable 关联了Queue 对象

# 将Queue对象在网络中暴露

#window下绑定调用接口不能直接使用lambda,所以只能先定义函数再绑定

QueueManager.register('get_task_queue', callable=get_task)

QueueManager.register('get_result_queue', callable=get_result)

# 绑定端口和设置验证口令

manager = QueueManager(address=('127.0.0.1', 8001), authkey='qiye'.encode())

# 启动管理,监听信息通道

manager.start()

try:

# 通过网络获取任务队列和结果队列

task = manager.get_task_queue()

result = manager.get_result_queue()

# 添加任务

for url in ["ImageUrl_" + str(i) for i in range(10)]:

print('url is %s' % url)

task.put(url)

print('try get result')

for i in range(10):

print('result is %s' % result.get(timeout=10))

except:

print 'Manager error'

finally:

manager.shutdown()

if __name__ == '__main__':

# window下多进程可能有问题,添加这句话缓解

freeze_support()

win_run()

服务进程已经编写好,接下来任务进程(taskWorker.py)创建四步骤:

- 使用QueueManager注册用于获取Queue的方法名称,任务进程只能通过名称来网络获取Queue

- 连接服务器,端口和验证口令注意保持与服务器进程中完全一致

- 从网络获取Queue,进行本地化

- 从task队列获取任务,并且把结果写入result队列

#coding:utf-8

import time

from multiprocessing.managers import BaseManager

# 创建类似的QueueManager:

class QueueManager(BaseManager):

pass

# 实现第一步:使用QueueManager注册获取Queue的方法名称

QueueManager.register('get_task_queue')

QueueManager.register('get_result_queue')

# 实现第二步:连接到服务器:

server_addr = '127.0.0.1'

print('Connect to server %s...' % server_addr)

# 端口和验证口令注意保持与服务进程设置的完全一致:

m = QueueManager(address=(server_addr, 8001), authkey='qiye')

# 从网络连接:

m.connect()

# 实现第三步:获取Queue的对象:

task = m.get_task_queue()

result = m.get_result_queue()

# 实现第四步:从task队列取任务,并把结果写入result队列:

while(not task.empty()):

image_url = task.get(True,timeout=5)

print('run task download %s...' % image_url)

time.sleep(1)

result.put('%s--->success'%image_url)

# 处理结束:

print('worker exit.')

运行结果:

- taskManager.py

C:\Python27\python.exe F:/python_scrapy/python_study/taskManager.py

url is ImageUrl_0

url is ImageUrl_1

url is ImageUrl_2

url is ImageUrl_3

url is ImageUrl_4

url is ImageUrl_5

url is ImageUrl_6

url is ImageUrl_7

url is ImageUrl_8

url is ImageUrl_9

try get result

result is ImageUrl_0--->success

result is ImageUrl_1--->success

result is ImageUrl_2--->success

result is ImageUrl_3--->success

result is ImageUrl_4--->success

result is ImageUrl_5--->success

result is ImageUrl_6--->success

result is ImageUrl_7--->success

result is ImageUrl_8--->success

result is ImageUrl_9--->success

Process finished with exit code 0

- 任务进程(taskWorker.py)

C:\Python27\python.exe F:/python_scrapy/python_study/taskWorker.py

Connect to server 127.0.0.1...

run task download ImageUrl_0...

run task download ImageUrl_1...

run task download ImageUrl_2...

run task download ImageUrl_3...

run task download ImageUrl_4...

run task download ImageUrl_5...

run task download ImageUrl_6...

run task download ImageUrl_7...

run task download ImageUrl_8...

run task download ImageUrl_9...

worker exit.

Process finished with exit code 0

python分布式进程的更多相关文章

- python 分布式进程体验

抽了点时间体验了一把python 分布式进程,有点像分布式计算的意思,不过我现在还没有这个需求,先把简单体验的脚本发出来,供路过的各位高手指教 注:需要先下载multiprocessing 的pyth ...

- python分布式进程(windows下)

分布式进程: 在Thread和Process中,应当优选Process,因为Process更稳定,而且,Process可以分布到多台机器上,而Thread最多只能分布到同一台机器的多个CPU上. Py ...

- Python分布式进程报错:pickle模块不能序列化lambda函数

今天在学习到廖老师Python教程的分布式进程时,遇到了一个错误:_pickle.PicklingError: Can't pickle <function <lambda> at ...

- Python 分布式进程

#-*-coding:utf-8-*- '''分布式进程指的是将Process进程分不到多台机器上,充分利用多台机器的性能完成复杂的任务''' #服务器端 #--------------------- ...

- python 进程和线程-进程和线程的比较以及分布式进程

进程和线程的比较 参考链接:https://www.liaoxuefeng.com/wiki/1016959663602400/1017631469467456 我们介绍了多进程和多线程,这是实现多任 ...

- python多进程,进程池,数据共享,进程通信,分布式进程

一.操作系统中相关进程的知识 Unix/Linux操作系统提供了一个fork()系统调用,它非常特殊.普通的函数调用,调用一次,返回一次,但是fork()调用一次,返回两次,因为操作系统自动把当前 ...

- 【python】进程与线程

No1: 多进程 from multiprocessing import Process import os # 子进程要执行的代码 def run_proc(name): print('Run ch ...

- 【Python】进程和线程

多进程 多线程 ThreadLocal 进程vs线程 分布式进程 Top 学习廖老师的py官网的笔记 多任务的实现方式有三种方式: 1.多进程 2.多线程 3.多进程+多线程(这种比较复杂,实际很少采 ...

- Python分布式爬虫打造搜索引擎完整版-基于Scrapy、Redis、elasticsearch和django打造一个完整的搜索引擎网站

Python分布式爬虫打造搜索引擎 基于Scrapy.Redis.elasticsearch和django打造一个完整的搜索引擎网站 https://github.com/mtianyan/Artic ...

随机推荐

- python+Appium自动化:各种元素定位方法

name定位 driver.find_element_by_name('飞利浦净水').click() 测试结果报错:selenium.common.exceptions.InvalidSelecto ...

- nginx基本概述

上级回顾: 1.NFS 2.Sersync 3.SSH 1.ssh使用两种登录服务器的方式,哪两种? 密码 用户名 + 密码 秘钥 用户名 + 秘钥(私钥) 公钥加密 私钥解密 2.大家常说的 塞ke ...

- maven命令创建web骨架项目

maven命令创建web骨架项目有以下两种方式: mvn archetype:create -DgroupId=org.seckill -DartifactId=seckill -Darchetype ...

- [angular2/4/8]用ng new创建项目卡住的解决办法

官方文档 英文版:https://angular.io/guide/quickstart 中文版:https://angular.cn/guide/quickstart Installing pack ...

- Dom修改元素样式

提纲:我们可以通过js来修改元素的大小,颜色,位置等样式 1.element.style 行内样式的操作 2.element.className ...

- Java 转发和重定向的区别

转发是服务器行为,重定向是客户端行为 1.转发在服务器端完成的;重定向是在客户端完成的 2.转发的速度快;重定向速度慢 3.转发的是同一次请求;重定向是两次不同请求 4.转发不会执行转发后的代码;重定 ...

- mongodb 批量添加、修改和删除

1.使用MongoTemplate a.批量插入 Insert a Collection of objects into a collection in a single batch write to ...

- 【数据库】-各类数据库链接驱动和URL的书写格式

oracle: driver="oracle.jdbc.driver.OracleDriver" url="jdbc:oracle:thin:@localhost:152 ...

- Axure RP 8 破解汉化(实测可用)

Axure的安装教程初学乍练,从安装应用程序开始1.下载 下载地址:https://www.axure.com.cn/3510/ 2.破解:注册码(源于博主“前端大白兔”,原博客网址:http://b ...

- hdu 5726 GCD GCD+线段树+区间预处理+map

GCD Time Limit: 10000/5000 MS (Java/Others) Memory Limit: 65536/65536 K (Java/Others)Total Submis ...