爬虫---Beautiful Soup 爬取图片

上一篇简单的介绍Beautiful Soup 的基本用法,这一篇写下如何爬取网站上的图片,并保存下来

爬取图片

1.找到一个福利网站:http://www.xiaohuar.com/list-1-1.html

2.通过F12进行定位图片

3.通过下图可以看到标签为img,然后通过width="210"的属性

爬取方法

1.通过find_all()的方法进行查找图片位置

2.筛选出图片的URL和图片名称

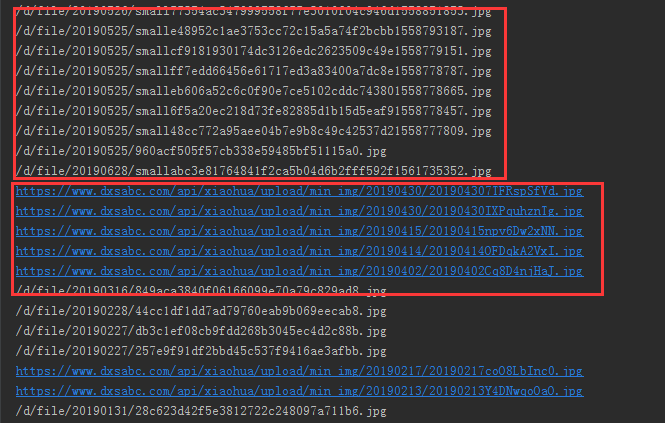

3.筛选后会发现其中有一些图片URL不完整

4.这个时候需要在代码中加一个判断,如何URL不完整 我们就给他补充完整

import requests

from bs4 import BeautifulSoup

import os

# 请求地址

url = 'http://www.xiaohuar.com/list-1-1.html'

html = requests.get(url).content

# BeautifulSoup 实例化

soup = BeautifulSoup(html,'html.parser')

jpg_data = soup.find_all('img',width="")

for i in jpg_data:

data = i['src']

name = i['alt']

# 判断URL是否完整

if "https://www.dxsabc.com/" not in data:

data = 'http://www.xiaohuar.com'+ data

保存图片

1.判断一个文件夹是否存在,不存在就重新创建

2.request模块请求图片的URL

3.通过content返回图片二进制,进行写入文件夹中

# coding:utf-8

import requests

from bs4 import BeautifulSoup

import os

# 创建一个文件夹名称

FileName = 'tupian'

if not os.path.exists(os.path.join(os.getcwd(), FileName)): # 新建文件夹

print(u'建了一个名字叫做', FileName, u'的文件夹!')

os.mkdir(os.path.join(os.getcwd(),'tupian'))

else:

print(u'名字叫做', FileName, u'的文件夹已经存在了!')

url = 'http://www.xiaohuar.com/list-1-1.html'

html = requests.get(url).content # 返回html

soup = BeautifulSoup(html,'html.parser') # BeautifulSoup对象

jpg_data = soup.find_all('img',width="") # 找到图片信息

for i in jpg_data:

data = i['src'] # 图片的URL

name = i['alt'] # 图片的名称

if "https://www.dxsabc.com/" not in data:

data = 'http://www.xiaohuar.com'+data

r2 = requests.get(data)

fpath = os.path.join(FileName,name)

with open(fpath+'.jpg','wb+')as f : # 循环写入图片

f.write(r2.content)

print('保存成功,快去查看图片吧!!')

图片就不贴了,喜欢的可以自己动手写一写。

爬虫---Beautiful Soup 爬取图片的更多相关文章

- 一起学爬虫——使用Beautiful Soup爬取网页

要想学好爬虫,必须把基础打扎实,之前发布了两篇文章,分别是使用XPATH和requests爬取网页,今天的文章是学习Beautiful Soup并通过一个例子来实现如何使用Beautiful Soup ...

- 使用Beautiful Soup爬取猫眼TOP100的电影信息

使用Beautiful Soup爬取猫眼TOP100的电影信息,将排名.图片.电影名称.演员.时间.评分等信息,提取的结果以文件形式保存下来. import time import json impo ...

- 爬虫---Beautiful Soup 初始

我们在工作中,都会听说过爬虫,那么什么是爬虫呢? 什么是网络爬虫 爬虫基本原理 所谓网络爬虫就是一个自动化数据采集工具,你只要告诉它要采集哪些数据,丢给它一个 URL,就能自动地抓取数据了.其背后的基 ...

- 爬虫---Beautiful Soup 通过添加不同的IP请求

上一篇爬虫写了如何应付反爬的一些策略也简单的举了根据UA的例子,今天写一篇如何根据不同IP进行访问豆瓣网获取排行版 requests添加IP代理 如果使用代理的话可以通过requests中的方法pro ...

- 爬虫---Beautiful Soup 反反爬虫事例

前两章简单的讲了Beautiful Soup的用法,在爬虫的过程中相信都遇到过一些反爬虫,如何跳过这些反爬虫呢?今天通过知乎网写一个简单的反爬中 什么是反爬虫 简单的说就是使用任何技术手段,阻止别人批 ...

- scrapy爬虫系列之三--爬取图片保存到本地

功能点:如何爬取图片,并保存到本地 爬取网站:斗鱼主播 完整代码:https://files.cnblogs.com/files/bookwed/Douyu.zip 主要代码: douyu.py im ...

- 爬虫-Beautiful Soup模块

阅读目录 一 介绍 二 基本使用 三 遍历文档树 四 搜索文档树 五 修改文档树 六 总结 一 介绍 Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通 ...

- python3爬虫-快速入门-爬取图片和标题

直接上代码,先来个爬取豆瓣图片的,大致思路就是发送请求-得到响应数据-储存数据,原理的话可以先看看这个 https://www.cnblogs.com/sss4/p/7809821.html impo ...

- Python爬虫学习 - day1 - 爬取图片

利用Python完成简单的图片爬取 最近学习到了爬虫,瞬时觉得很高大上,想取什么就取什么,感觉要上天.这里分享一个简单的爬取汽车之家文章列表的图片教程,供大家学习. 需要的知识点储备 本次爬虫脚本依赖 ...

随机推荐

- undefined reference to symbol 'dlclose@@GLIBC_2.2.5'

解决方法 在QT工程的.pro文件中添加如下内容: LIBS=-ldl

- day65_10_9vue循环指令与组件

一.v-once v-once指令赋值给标签后,这个标签中的所有变量都不能被更改,只能被渲染一次.之后的改动不能改变该标签中的值: <div id="app"> < ...

- 【Eureka篇三】Eureka服务发现(4)

注:该知识点并不是重点. 修改子模块:microservicecloud-provider-dept-8001 1. 修改DeptController @Autowired private org.s ...

- ln -s 文件夹变成文件(txt) / linux 链接出错

问题: 平时没有注意过这这个问题,当我使用ln -s xxx yyy 将xxx 移动到yyy 路径时,文件夹就变成了txt文件, 解决: 找了半天,在stackoverflow上找到了答案,很简单, ...

- ABP docker发布

环境:CentOS 7.6 64位 linux基本命令: cd:进入某个文件夹 mkdir:创建文件夹 ls:显示文件 ll:罗列出当前文件或目录的详细信息 判断是文件 还是文件夹: Linux系统中 ...

- python进阶之命名空间与作用域

命名空间 Namespace Namespace命名空间,命名空间是一个字典(dictionary),它的键就是变量名,它的值就是那些变量的值.命名空间的一大作用是避免名字冲突. python使用命名 ...

- 算法六Z自形变换

将一个给定字符串根据给定的行数,以从上往下.从左到右进行 Z 字形排列. 比如输入字符串为 "LEETCODEISHIRING" 行数为 3 时,排列如下: L C ...

- Java连载7-变量&数据类型

一.变量 1.注意点: 在同一个“作用域”中,变量名不能重名,但是变量可以重新赋值. 2.什么是作用域? 答:描述的是变量的有效范围,在范围之内是可以被访问的,只要出了作用域就无法访问(也就是在大括号 ...

- PHP匿名函数的写法

传统写法<pre>function timer () { echo "hello world";}Swoole\Timer::tick(2000, 'timer');& ...

- docker入门与部署微服务--学习笔记

最近公司进一步去windows,走向 linux+云化. 原来的一大坨windows虚拟机服务器都要转向linux, 既然走向linux的话,那么docker肯定是要涉足的. 故学习了docker入门 ...