Mysql数据实时同步

企业运维的数据库最常见的是 mysql;但是 mysql 有个缺陷:当数据量达到千万条的时候,mysql 的相关操作会变的非常迟缓; 如果这个时候有需求需要实时展示数据;对于 mysql 来说是一种灾难;而且对于 mysql 来说,同一时间还要给多个开发人员和用户操作; 所以经过调研,将 mysql 数据实时同步到 hbase 中;

最开始使用的架构方案:

Mysql---logstash—kafka---sparkStreaming---hbase---web

Mysql—sqoop---hbase---web

但是无论使用 logsatsh 还是使用 kafka,都避免不了一个尴尬的问题:

他们在导数据过程中需要去 mysql 中做查询操作:

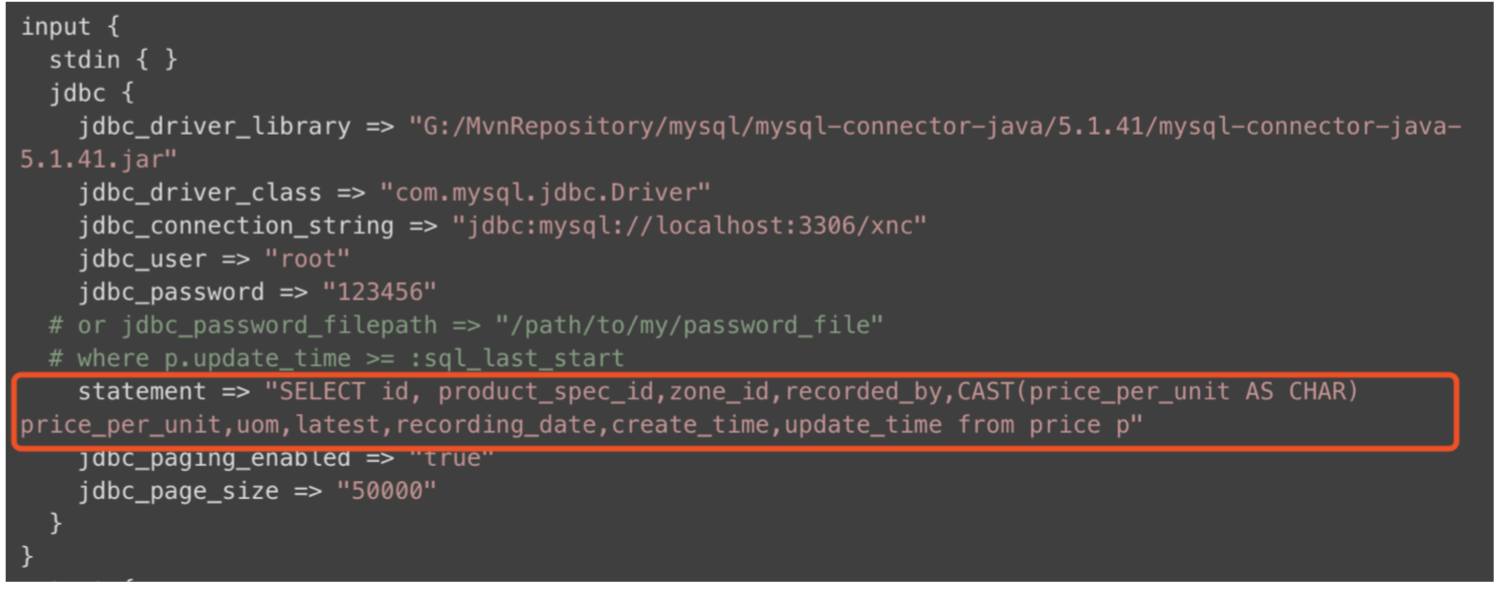

比如 logstash:

比如 sqoop:

不可避免的,都需要去 sql 中查询出相关数据,然后才能进行同步;这样对于 mysql 来说本身就是增加负荷操作; 所以我们真正需要考虑的问题是:有没有什么方法,能将 mysql 数据实时同步到 hbase;但是不增加 mysql 的负担; 答案是有的:可以使用 canal 或者 maxwell 来解析 mysql 的 binlog 日志

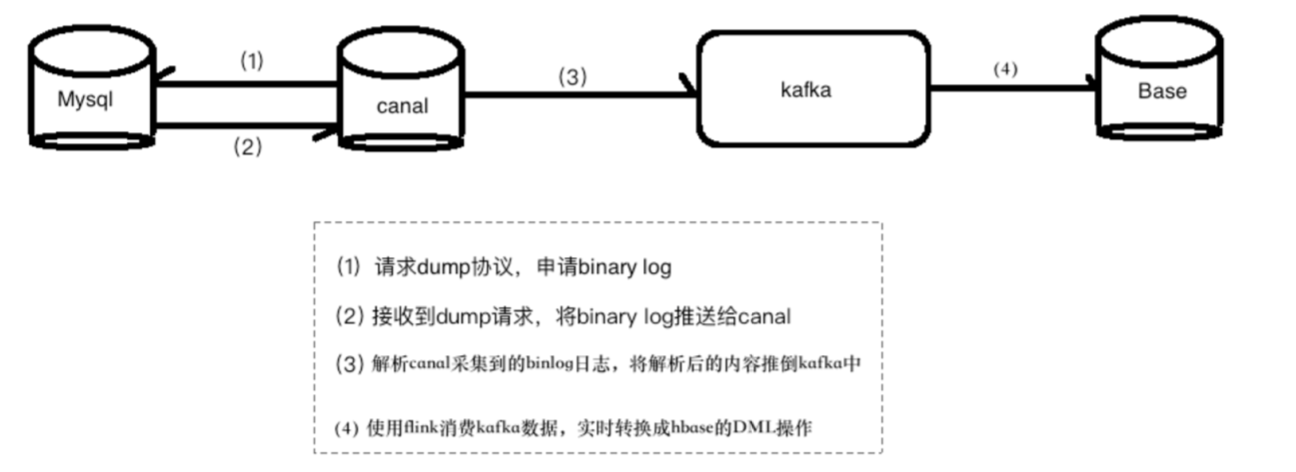

那么之前的架构就需要改动了:

Mysql---canal—kafka—flink—hbase—web

第一步:开启 mysql 的 binlog 日志

Mysql 的 binlog 日志作用是用来记录 mysql 内部增删等对 mysql 数据库有更新的内容的 记录(对数据库的改动),对数据库的查询 select 或 show 等不会被 binlog 日志记录;主 要用于数据库的主从复制以及增量恢复。

mysql 的 binlog 日志必须打开 log-bin 功能才能生存 binlog 日志

-rw-rw---- 1 mysql mysql 669 5 月 10 21:29 mysql-bin.000001

-rw-rw---- 1 mysql mysql 126 5 月 10 22:06 mysql-bin.000002

-rw-rw---- 1 mysql mysql 11799 5 月 15 18:17 mysql-bin.000003

(1):修改/etc/my.cnf,在里面添加如下内容

log-bin=/var/lib/mysql/mysql-bin 【binlog 日志存放路径】

binlog-format=ROW 【⽇日志中会记录成每⼀一⾏行行数据被修改的形式】

server_id=1 【指定当前机器的服务 ID(如果是集群,不能重复)】

(2):配置完毕之后,登录 mysql,输入如下命令:

show variables like ‘%log_bin%’

出现如下形式,代表 binlog 开启;

第二步:安装 canal

Canal 介绍 canal 是阿里巴巴旗下的一款开源项目,纯 Java 开发。基于数据库增量日志解析,提供增量数据订阅&消费,目前主要支持了 MySQL(也支持 mariaDB)。

起源:早期,阿里巴巴 B2B 公司因为存在杭州和美国双机房部署,存在跨机房同步的业务需求。不过早期的数据库同步业务,主要是基于 trigger 的方式获取增量变更,不过从 2010 年开始,阿里系公司开始逐步的尝试基于数据库的日志解析,获取增量变更进行同步,由此衍生出了增量订阅 &消费的业务,从此开启了一段新纪元。

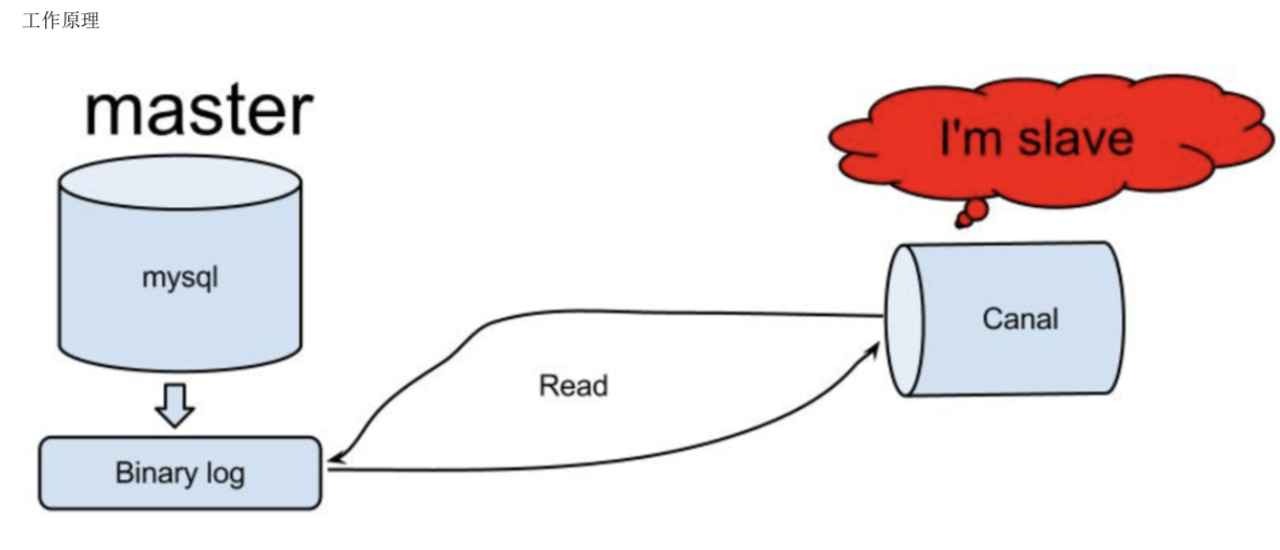

原理相对比较简单:

1、canal 模拟 mysql slave 的交互协议,伪装自己为 mysql slave,向 mysql master 发送 dump 协议

2、mysql master 收到 dump 请求,开始推送 binary log 给 slave(也就是 canal) 3、canal 解析 binary log 对象(原始为 byte 流)

使用 canal 解析 binlog,数据落地到 kafka

(1):解压安装包:canal.deployer-1.0.23.tar.gz

tar -zxvf canal.deployer-1.0.23.tar.gz -C /export/servers/canal 修改配置文件:

vim /export/servers/canal/conf/example/instance.properties

(2):编写 canal 代码

仅仅安装了 canal 是不够的;canal 从架构的意义上来说相当于 mysql 的“从库”,此时还并不能将 binlog 解析出来实时转发到 kafka 上,因此需 要进一步开发 canal 代码;

Canal 已经帮我们提供了示例代码,只需要根据需求稍微更改即可;

Canal 提供的代码:

上面的代码中可以解析出 binlog 日志,但是没有将数据落地到 kafka 的代码逻辑,所以我们还需要添加将数据落地 kafka 的代码; Maven 导入依赖:

<groupId>com.alibaba.otter</groupId> <artifactId>canal.client</artifactId>

<version>1.0.23</version>

</dependency> <!-- https://mvnrepository.com/artifact/org.apache.kafka/kafka -->

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka_2.11</artifactId>

<version>0.9.0.1</version>

</dependency>

测试 canal 代码

1、 启动 kafka 并创建 topic

/export/servers/kafka/bin/kafka-server-start.sh /export/servers/kafka/config/server.properties >/dev/null 2>&1 & /export/servers/kafka/bin/kafka-topics.sh --create --zookeeper hadoop01:2181 --replication-factor 1 --partitions 1 --topic mycanal

2、 启动 mysql 的消费者客户端,观察 canal 是否解析 binlog

/export/servers/kafka/bin/kafka-console-consumer.sh --zookeeper hadoop01:2181 --from-beginning --topic mycanal 2、启动 mysql:service mysqld start

3、启动 canal:canal/bin/startup.sh

4、进入 mysql:mysql -u 用户 -p 密码;然后进行增删改

使用 flink 将 kafka 中的数据解析成 Hbase 的 DML 操作

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<zookeeper.version>3.4.5</zookeeper.version>

<scala.version>2.11.5</scala.version>

<hadoop.version>2.6.1</hadoop.version>

<flink.version>1.5.0</flink.version>

</properties> <dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>${scala.version}</version>

</dependency> <dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-scala_2.11</artifactId>

<version>${flink.version}</version>

</dependency> <dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-scala_2.11</artifactId>

<version>${flink.version}</version>

</dependency> <dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients_2.11</artifactId>

<version>${flink.version}</version>

</dependency> <dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table_2.11</artifactId>

<version>${flink.version}</version>

</dependency> <dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>${hadoop.version}</version>

<exclusions>

<exclusion>

<groupId>com.google.protobuf</groupId>

<artifactId>protobuf-java</artifactId>

</exclusion>

</exclusions>

</dependency> <dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka-0.9_2.11</artifactId>

<version>${flink.version}</version>

</dependency> <dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-hbase_2.11</artifactId>

<version>${flink.version}</version>

</dependency>

代码:

import java.util

import java.util.Properties

import org.apache.commons.lang3.StringUtils

import org.apache.flink.streaming.api.scala.StreamExecutionEnvironment

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer09

import org.apache.flink.streaming.util.serialization.SimpleStringSchema

import org.apache.flink.api.scala._

import org.apache.flink.runtime.state.filesystem.FsStateBackend

import org.apache.flink.streaming.api.{CheckpointingMode, TimeCharacteristic}

import org.apache.hadoop.hbase.{HBaseConfiguration, HColumnDescriptor, HTableDescriptor, TableName}

import org.apache.hadoop.hbase.client.{ConnectionFactory, Delete, Put}

import org.apache.hadoop.hbase.util.Bytes /**

* Created by angel;

*/

//[uname, spark, true], [upassword, 11122221, true]

case class UpdateFields(key:String , value:String) //(fileName , fileOffset , dbName , tableName ,eventType, columns , rowNum)

case class Canal(fileName:String ,

fileOffset:String,

dbName:String ,

tableName:String ,

eventType:String ,

columns:String ,

rowNum:String

)

object DataExtraction {

//1指定相关信息

val zkCluster = "hadoop01,hadoop02,hadoop03"

val kafkaCluster = "hadoop01:9092,hadoop02:9092,hadoop03:9092"

val kafkaTopicName = "canal"

val hbasePort = "2181"

val tableName:TableName = TableName.valueOf("canal")

val columnFamily = "info" def main(args: Array[String]): Unit = {

//2.创建流处理环境

val env = StreamExecutionEnvironment.getExecutionEnvironment

env.setStateBackend(new FsStateBackend("hdfs://hadoop01:9000/flink-checkpoint/checkpoint/"))

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)

env.getConfig.setAutoWatermarkInterval(2000)//定期发送

env.getCheckpointConfig.setCheckpointingMode(CheckpointingMode.EXACTLY_ONCE)

env.getCheckpointConfig.setCheckpointInterval(6000)

System.setProperty("hadoop.home.dir", "/");

//3.创建kafka数据流

val properties = new Properties()

properties.setProperty("bootstrap.servers", kafkaCluster)

properties.setProperty("zookeeper.connect", zkCluster)

properties.setProperty("group.id", kafkaTopicName)

val kafka09 = new FlinkKafkaConsumer09[String](kafkaTopicName, new SimpleStringSchema(), properties)

//4.添加数据源addSource(kafka09)

val text = env.addSource(kafka09).setParallelism(1)

//5、解析kafka数据流,封装成canal对象

val values = text.map{

line =>

val values = line.split("#CS#")

val valuesLength = values.length

//

val fileName = if(valuesLength > 0) values(0) else ""

val fileOffset = if(valuesLength > 1) values(1) else ""

val dbName = if(valuesLength > 2) values(2) else ""

val tableName = if(valuesLength > 3) values(3) else ""

val eventType = if(valuesLength > 4) values(4) else ""

val columns = if(valuesLength > 5) values(5) else ""

val rowNum = if(valuesLength > 6) values(6) else ""

//(mysql-bin.000001,7470,test,users,[uid, 18, true, uname, spark, true, upassword, 1111, true],null,1)

Canal(fileName , fileOffset , dbName , tableName ,eventType, columns , rowNum)

} //6、将数据落地到Hbase

val list_columns_ = values.map{

line =>

//处理columns字符串

val strColumns = line.columns

println(s"strColumns --------> ${strColumns}")

//[[uid, 22, true], [uname, spark, true], [upassword, 1111, true]]

val array_columns = packaging_str_list(strColumns)

//获取主键

val primaryKey = getPrimaryKey(array_columns)

//拼接rowkey DB+tableName+primaryKey

val rowkey = line.dbName+"_"+line.tableName+"_"+primaryKey

//获取操作类型INSERT UPDATE DELETE

val eventType = line.eventType

//获取触发的列:inser update val triggerFileds: util.ArrayList[UpdateFields] = getTriggerColumns(array_columns , eventType)

// //因为不同表直接有关联,肯定是有重合的列,所以hbase表=line.dbName + line.tableName

// val hbase_table = line.dbName + line.tableName

//根据rowkey删除数据

if(eventType.equals("DELETE")){

operatorDeleteHbase(rowkey , eventType)

}else{

if(triggerFileds.size() > 0){

operatorHbase(rowkey , eventType , triggerFileds)

} }

}

env.execute() } //封装字符串列表

def packaging_str_list(str_list:String):String ={

val substring = str_list.substring(1 , str_list.length-1) substring

} //获取每个表的主键

def getPrimaryKey(columns :String):String = {

// [uid, 1, false], [uname, abc, false], [upassword, uabc, false]

val arrays: Array[String] = StringUtils.substringsBetween(columns , "[" , "]")

val primaryStr: String = arrays(0)//uid, 13, true

primaryStr.split(",")(1).trim

} //获取触发更改的列

def getTriggerColumns(columns :String , eventType:String): util.ArrayList[UpdateFields] ={

val arrays: Array[String] = StringUtils.substringsBetween(columns , "[" , "]")

val list = new util.ArrayList[UpdateFields]()

eventType match {

case "UPDATE" =>

for(index <- 1 to arrays.length-1){

val split: Array[String] = arrays(index).split(",")

if(split(2).trim.toBoolean == true){

list.add(UpdateFields(split(0) , split(1)))

}

}

list

case "INSERT" =>

for(index <- 1 to arrays.length-1){

val split: Array[String] = arrays(index).split(",")

list.add(UpdateFields(split(0) , split(1)))

}

list

case _ =>

list }

}

//增改操作

def operatorHbase(rowkey:String , eventType:String , triggerFileds:util.ArrayList[UpdateFields]): Unit ={

val config = HBaseConfiguration.create();

config.set("hbase.zookeeper.quorum", zkCluster);

config.set("hbase.master", "hadoop01:60000");

config.set("hbase.zookeeper.property.clientPort", hbasePort);

config.setInt("hbase.rpc.timeout", 20000);

config.setInt("hbase.client.operation.timeout", 30000);

config.setInt("hbase.client.scanner.timeout.period", 200000);

val connect = ConnectionFactory.createConnection(config);

val admin = connect.getAdmin

//构造表描述器

val hTableDescriptor = new HTableDescriptor(tableName)

//构造列族描述器

val hColumnDescriptor = new HColumnDescriptor(columnFamily)

hTableDescriptor.addFamily(hColumnDescriptor)

if(!admin.tableExists(tableName)){

admin.createTable(hTableDescriptor);

}

//如果表存在,则开始插入数据

val table = connect.getTable(tableName)

val put = new Put(Bytes.toBytes(rowkey))

//获取对应的列[UpdateFields(uname, spark), UpdateFields(upassword, 1111)]

for(index <- 0 to triggerFileds.size()-1){

val fields = triggerFileds.get(index)

val key = fields.key

val value = fields.value

put.addColumn(Bytes.toBytes(columnFamily) , Bytes.toBytes(key) , Bytes.toBytes(value))

}

table.put(put)

}

//删除操作

def operatorDeleteHbase(rowkey:String , eventType:String): Unit ={

val config = HBaseConfiguration.create();

config.set("hbase.zookeeper.quorum", zkCluster);

config.set("hbase.zookeeper.property.clientPort", hbasePort);

config.setInt("hbase.rpc.timeout", 20000);

config.setInt("hbase.client.operation.timeout", 30000);

config.setInt("hbase.client.scanner.timeout.period", 200000);

val connect = ConnectionFactory.createConnection(config);

val admin = connect.getAdmin

//构造表描述器

val hTableDescriptor = new HTableDescriptor(tableName)

//构造列族描述器

val hColumnDescriptor = new HColumnDescriptor(columnFamily)

hTableDescriptor.addFamily(hColumnDescriptor)

if(admin.tableExists(tableName)){

val table = connect.getTable(tableName)

val delete = new Delete(Bytes.toBytes(rowkey))

table.delete(delete)

}

} }

打包scala程序

将上述的maven依赖红色标记处修改成:

<**sourceDirectory**>**src/main/scala**</**sourceDirectory**> <**mainClass**>scala的驱动类</**mainClass**>

运行canal代码

java -jar canal.jar -Xms100m -Xmx100m

运行flink代码

/opt/cdh/flink-1.5.0/bin/flink run -m yarn-cluster -yn 2 -p 1 /home/elasticsearch/flinkjar/SynDB-1.0-SNAPSHOT.jar

Mysql数据实时同步的更多相关文章

- canal整合springboot实现mysql数据实时同步到redis

业务场景: 项目里需要频繁的查询mysql导致mysql的压力太大,此时考虑从内存型数据库redis里查询,但是管理平台里会较为频繁的修改增加mysql里的数据 问题来了: 如何才能保证mysql的数 ...

- mysql数据实时同步到Elasticsearch

业务需要把mysql的数据实时同步到ES,实现低延迟的检索到ES中的数据或者进行其它数据分析处理.本文给出以同步mysql binlog的方式实时同步数据到ES的思路, 实践并验证该方式的可行性,以供 ...

- 【转】美团 MySQL 数据实时同步到 Hive 的架构与实践

文章转载自公众号 美团技术团队 , 作者 萌萌 背景 在数据仓库建模中,未经任何加工处理的原始业务层数据,我们称之为ODS(Operational Data Store)数据.在互联网企业中,常见的 ...

- elasticsearch+logstash_jdbc 实现mysql数据实时同步至es

jdk安装1.8版本,es.ls.ik.kibana版本一致我这里使用的6.6.2版本 安装es tar xf elasticsearch-6.6.2.tar.gz mv elasticsearch- ...

- MySQL数据实时增量同步到Kafka - Flume

转载自:https://www.cnblogs.com/yucy/p/7845105.html MySQL数据实时增量同步到Kafka - Flume 写在前面的话 需求,将MySQL里的数据实时 ...

- MySQL 到 ES 数据实时同步技术架构

MySQL 到 ES 数据实时同步技术架构 我们已经讨论了数据去规范化的几种实现方式.MySQL 到 ES 数据同步本质上是数据去规范化多种实现方式中的一种,即通过"数据迁移同步" ...

- sersync实现数据实时同步

1.1 第一个里程碑:安装sersync软件 1.1.1 将软件上传到服务器当中并解压 1.上传软件到服务器上 rz -E 为了便于管理上传位置统一设置为 /server/tools 中 2.解压软件 ...

- CentOS7下Rsync+sersync实现数据实时同步

近期公司要上线新项目,后台框架选型我选择当前较为流行的laravel,运行环境使用lnmp. 之前我这边项目tp32+apache,开发工具使用phpstorm. 新建/编辑文件通过phpstorm配 ...

- Linux下Rsync+sersync实现数据实时同步

inotify 的同步备份机制有着缺点,于是看了sersync同步,弥补了rsync的缺点.以下转自:http://www.osyunwei.com/archives/7447.html 前言: 一. ...

随机推荐

- Vuex、axios、跨域请求处理和import/export的注意问题

一.Vuex 1.介绍 vuex是一个专门为Vue.js设计的集中式状态管理架构. 对于状态,我们把它理解为在data中需要共享给其他组件使用的部分数据. Vuex和单纯的全局对象有以下不同: 1. ...

- nginx 80 端口 部署多个Web

1.修改默认nginx.conf 文件 加入 include /usr/www/ngconfs/*.conf; 读取ngconfs文件下所有 *.conf文件 2.ngconfs 下多个文件创建 第二 ...

- 2.7 json 模块

- luoguP4705 玩游戏

好好玩 即对于k∈[1,t] 求(ax+by)^k 以下图片均来自于: 在Ta的博客查看 一 二项式展开: 设: 那么: 可以卷积了 二 求: (PS:随机序列的0~k次方和,这是一个经典问题.) 我 ...

- 来了解质量管理工具——质量屋(HOQ)

质量屋(The House Of Quality),又名HOQ,它是质量功能配置(QFD)的核心.一般QFD的学习会涉及到.同时HOQ也是项目管理十大知识领域领域中质量管理工具中的一种,今天我们就来了 ...

- Day048--jQuery自定义动画和DOM操作

内容回顾 BOM location.reload() 全局刷新页面 location.href location.hash location.pathname location.hostname lo ...

- FreeNAS:创建 CIFS 匿名共享

第一部分:数据集权限设定 浏览器访问 FreeNAS 系统的 WebGUI 管理界面,点选 “Storage” 存储图标打开存储选项卡,在卷列表中点选用于匿名共享的数据集,如有需要,也可以自行创建新的 ...

- c语言中堆栈和静态空间

什么是堆空间.栈空间与静态空间 堆空间:由程序员自己分配空间,如malloc需要指定分配多少个多大的字节空间,不用的时候需要自己释放 栈空间:栈空间是由系统自动分配与释放,如int,char等大小都已 ...

- 分布式监控系统开发【day38】:主机存活检测程序解析(七)

一.目录结构 二.入口 1.文件MonitorServer.py import os import sys if __name__ == "__main__": os.enviro ...

- 面向对象之组合、封装、多态、property装饰器

概要: 组合 封装 property装饰器 多态 Python推崇鸭子类型:解耦合,统一标准(不用继承) 1. 组合 继承:会传递给子类强制属性 组合:解耦合,减少占用内存.如:正常继承,如果一个班级 ...