<scrapy爬虫>爬取猫眼电影top100详细信息

1.创建scrapy项目

dos窗口输入:

scrapy startproject maoyan

cd maoyan

2.编写item.py文件(相当于编写模板,需要爬取的数据在这里定义)

# -*- coding: utf-8 -*- # Define here the models for your scraped items

#

# See documentation in:

# https://doc.scrapy.org/en/latest/topics/items.html import scrapy class MaoyanItem(scrapy.Item):

# define the fields for your item here like:

#影片中文名称/英文名称

ztitle = scrapy.Field()

etitle = scrapy.Field()

#影片类型

type = scrapy.Field()

#导演

dname = scrapy.Field()

#主演

star = scrapy.Field()

#上映时间

releasetime = scrapy.Field()

#影片时间

time = scrapy.Field()

# 评分

score = scrapy.Field()

#图片链接

image = scrapy.Field()

#详情信息

info = scrapy.Field()

3.创建爬虫文件

dos窗口输入:

scrapy genspider -t crawl myspider maoyan.com

4.编写myspider.py文件(接收响应,处理数据)

# -*- coding: utf-8 -*-

import scrapy

#导入链接规则匹配

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

#导入模板

from maoyan.items import MaoyanItem class MaoyanSpider(CrawlSpider):

name = 'myspider'

allowed_domains = ['maoyan.com']

start_urls = ['https://maoyan.com/board/4?offset=0'] rules = (

Rule(LinkExtractor(allow=r'offset=\d+'),follow=True),

Rule(LinkExtractor(allow=r'/films/\d+'),callback='parse_maoyan',follow=False),

) def parse_maoyan(self, response):

item = MaoyanItem()

# 影片中文名称/英文名称

item['ztitle'] = response.xpath('//h3/text()').extract()[0]

item['etitle'] = response.xpath('//div[@class="ename ellipsis"]/text()').extract()[0]

# 影片类型

item['type'] = response.xpath('//li[@class="ellipsis"][1]/text()').extract()[0]

# 导演

item['dname'] = response.xpath('//a[@class="name"]/text()').extract()[0].strip()

# 主演

star_1 = response.xpath('//li[@class="celebrity actor"][1]//a[@class="name"]/text()').extract()[0].strip()

star_2 = response.xpath('//li[@class="celebrity actor"][2]//a[@class="name"]/text()').extract()[0].strip()

star_3 = response.xpath('//li[@class="celebrity actor"][3]//a[@class="name"]/text()').extract()[0].strip()

item['star'] = star_1 + "\\" + star_2 + '\\' +star_3

# 上映时间

item['releasetime'] = response.xpath('//li[@class="ellipsis"][3]/text()').extract()[0]

# 影片时间

item['time'] = response.xpath('//li[@class="ellipsis"][2]/text()').extract()[0].strip()[-5:]

# 评分,没抓到

# item['score'] = response.xpath('//span[@class="stonefont"]/text()').extract()[0]

item['score'] = "None"

# 图片链接

item['image'] = response.xpath('//img[@class="avatar"]/@src').extract()[0]

# 详情信息

item['info'] = response.xpath('//span[@class="dra"]/text()').extract()[0].strip() yield item

5.编写pipelines.py(存储数据)

# -*- coding: utf-8 -*- # Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://doc.scrapy.org/en/latest/topics/item-pipeline.html

import json class MaoyanPipeline(object):

def __init__(self):

self.filename = open('maoyan.txt','wb') def process_item(self, item, spider):

text = json.dumps(dict(item),ensure_ascii=False) + '\n'

self.filename.write(text.encode('utf-8'))

return item def close_spider(self,spider):

self.filename.close()

6.编写settings.py(设置headers,pipelines等)

robox协议

# Obey robots.txt rules

ROBOTSTXT_OBEY = False

headers

DEFAULT_REQUEST_HEADERS = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

# 'Accept-Language': 'en',

}

pipelines

ITEM_PIPELINES = {

'maoyan.pipelines.MaoyanPipeline': 300,

}

7.运行爬虫

dos窗口输入:

scrapy crawl myspider

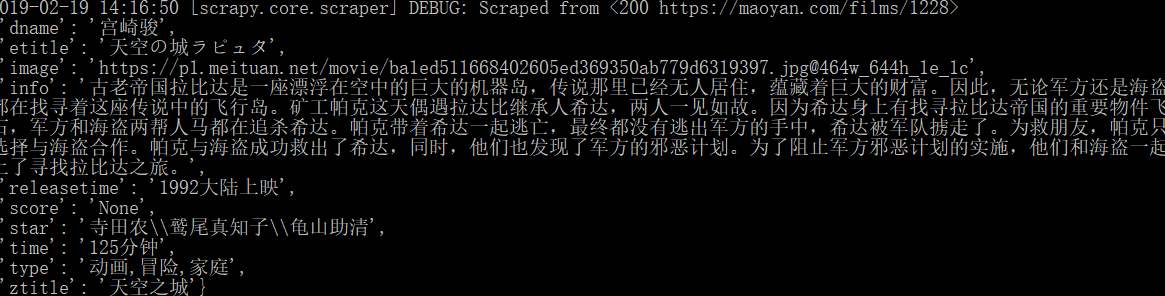

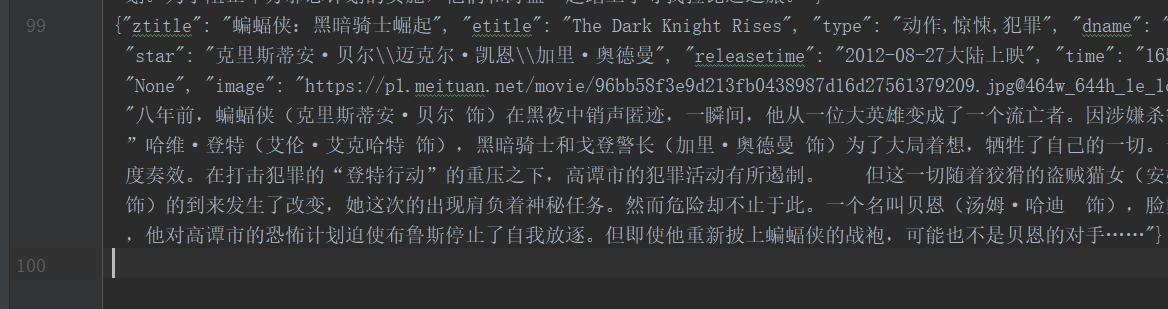

运行结果:

emmmm,top100只爬到99个,

问题:

源码里面评分是□.□!!!全是套路,外面可以找到这个评分,懒得折腾了

单独爬取zname是100个,可能是哪个属性的xpath匹配,网页详情页没有,实现功能就行了

爬取成功

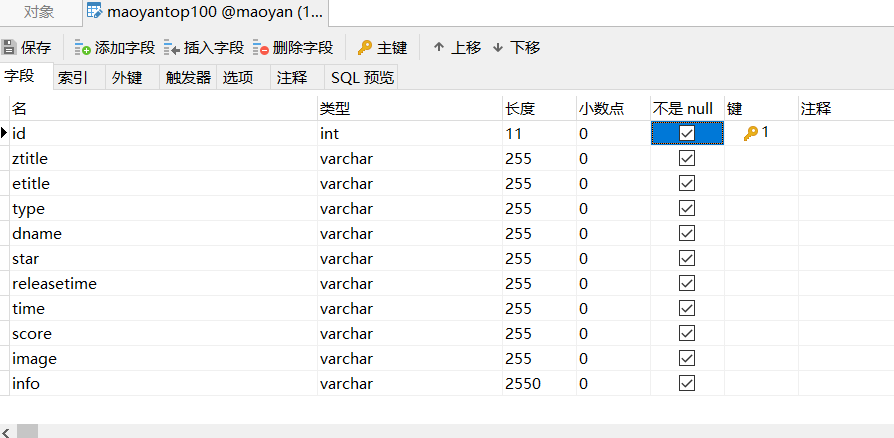

8.存储到mysql数据库

在mysql数据库建立相应的数据库和表:

改写一下pipelines.py文件即可:

import pymysql.cursors class MaoyanPipeline(object):

def __init__(self):

#连接数据库

self.connect = pymysql.connect(

host = 'localhost',

user = 'root',

password = '',

database = 'maoyan',

charset = 'utf8' # 别写成utf-8

)

self.cursor = self.connect.cursor() # 建立游标 def process_item(self, item, spider):

item = dict(item)

sql = "insert into maoyantop100(ztitle,etitle,type,dname,star,releasetime,time,score,image,info) values(%s,%s,%s,%s,%s,%s,%s,%s,%s,%s)"

self.cursor.execute(sql,(item['ztitle'],item['etitle'],item['type'],item['dname'],item['star'],item['releasetime'],item['time'],item['score'],item['image'],item['info'],))

self.connect.commit()

return item def close_spider(self,spider):

self.cursor.close()

self.connect.close()

运行:

存储成功:

<scrapy爬虫>爬取猫眼电影top100详细信息的更多相关文章

- python3爬虫爬取猫眼电影TOP100(含详细爬取思路)

待爬取的网页地址为https://maoyan.com/board/4,本次以requests.BeautifulSoup css selector为路线进行爬取,最终目的是把影片排名.图片.名称.演 ...

- 爬虫系列(1)-----python爬取猫眼电影top100榜

对于Python初学者来说,爬虫技能是应该是最好入门,也是最能够有让自己有成就感的,今天在整理代码时,整理了一下之前自己学习爬虫的一些代码,今天先上一个简单的例子,手把手教你入门Python爬虫,爬取 ...

- 50 行代码教你爬取猫眼电影 TOP100 榜所有信息

对于Python初学者来说,爬虫技能是应该是最好入门,也是最能够有让自己有成就感的,今天,恋习Python的手把手系列,手把手教你入门Python爬虫,爬取猫眼电影TOP100榜信息,将涉及到基础爬虫 ...

- python 爬取猫眼电影top100数据

最近有爬虫相关的需求,所以上B站找了个视频(链接在文末)看了一下,做了一个小程序出来,大体上没有修改,只是在最后的存储上,由txt换成了excel. 简要需求:爬虫爬取 猫眼电影TOP100榜单 数据 ...

- PYTHON 爬虫笔记八:利用Requests+正则表达式爬取猫眼电影top100(实战项目一)

利用Requests+正则表达式爬取猫眼电影top100 目标站点分析 流程框架 爬虫实战 使用requests库获取top100首页: import requests def get_one_pag ...

- # [爬虫Demo] pyquery+csv爬取猫眼电影top100

目录 [爬虫Demo] pyquery+csv爬取猫眼电影top100 站点分析 代码君 [爬虫Demo] pyquery+csv爬取猫眼电影top100 站点分析 https://maoyan.co ...

- 40行代码爬取猫眼电影TOP100榜所有信息

主要内容: 一.基础爬虫框架的三大模块 二.完整代码解析及效果展示 1️⃣ 基础爬虫框架的三大模块 1.HTML下载器:利用requests模块下载HTML网页. 2.HTML解析器:利用re正则表 ...

- 用requests库爬取猫眼电影Top100

这里需要注意一下,在爬取猫眼电影Top100时,网站设置了反爬虫机制,因此需要在requests库的get方法中添加headers,伪装成浏览器进行爬取 import requests from re ...

- # 爬虫连载系列(1)--爬取猫眼电影Top100

前言 学习python有一段时间了,之前一直忙于学习数据分析,耽搁了原本计划的博客更新.趁着这段空闲时间,打算开始更新一个爬虫系列.内容大致包括:使用正则表达式.xpath.BeautifulSoup ...

随机推荐

- jq的绑定动态元素

在项目中经常会遇到需要在页面中插入动态元素的情况,比如页面中有一个按钮: <div id="btn">确定</div> 点击按钮时在body中插入一段div ...

- Java中逗号运算符的使用

今天看到一道面试题,题目如下: 题目解释: 上面有一个类,有四个成员属性,以及两个构造方法(一个四个参数,一个两个参数),题目给出四个选项,问哪些选项可以满足在在四个参数的构造方法中完成x=a,y=b ...

- python3和python2编码拾遗

py2编码 tr和unicode str和unicode都是basestring的子类.严格意义上说,str其实是字节串,它是unicode经过编码后的字节组成的序列.对UTF-8编码的str'苑'使 ...

- PHP MVC运用

php中的MVC模式运用 首先我来举个例子: 一个简单的文章显示系统 简单期间,我们假定这个文章系统是只读的,也就是说这个例子将不涉及文章的发布,现在开始了. 由于只涉及数据库的读取,所以我定义了两个 ...

- (转)[视频压制/转换技术] I帧 B帧 P帧 IDR帧 等帧用途详细说明

转:http://www.u2game.net/bbs/thread-46116-1-1.html 在视频压制.转换中,经常会看到:I帧 B帧 P帧 IDR帧 等名词,这里就是通用的解释一下这些帧的用 ...

- 应用程序正常初始化(0xc0150002)失败的终极解决方案

转自VC错误:http://www.vcerror.com/?p=62 最近做一个项目写了一个VC6下的MFC程序,结果传到别人的机子上(WIN7)出现了应用程序正常初始化(0xc0150002)失败 ...

- Python 日期和时间_python 当前日期时间_python日期格式化

Python 日期和时间_python 当前日期时间_python日期格式化 Python程序能用很多方式处理日期和时间,转换日期格式是一个常见的功能. Python 提供了一个 time 和 cal ...

- 求N!中素数的个数

int degree_in_fact(int n, int x)//求n!中素数x的次数 { if(m) return degree_in_fact(n/x,x)+n/x; ; }

- Python对接支付宝支付自实现

Python对接支付宝支付自实现 # -*- coding: utf-8 -*- import base64 import json import urllib.parse from datetime ...

- <Python基础>字典的基本操作

''' 小知识 1.字典的键只能是不可变数据类型:int 元组 bool str(可哈希) 字典查找数据会使用二分查找,会先用哈希表将键转化为数字然后进行查找 ''' s = { "name ...