消息中间件kafka学习记录

1. 概述

Apache Kafka是一个分布式消息系统,凭借其优异的特性而被广泛使用。

- 高性能:O(1)复杂度消息快速持久化。

- 高吞吐率: 单机每秒10w条消息传输。

- 支持消息分区和分布式消费。

- 支持在线水平扩展。

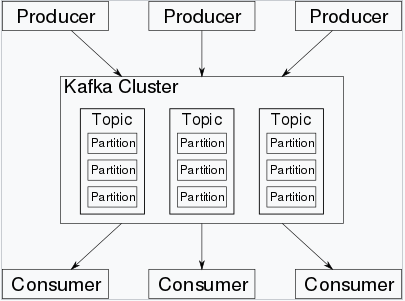

架构及核心组件

- Producer: 消息生产者,即向kafka broker发送消息的客户端。

- Consumer:消息消费者,即从kafka broker获取消息的客户端。

- Topic:消息根据topic进行归类。

- Partition:消息分片,每个topic中的消息被分为n个独立的partition,以提高消息处理效率。

- Broker:kafka集群中的kafka实例(服务器节点),一个broker可以容纳多个topic。

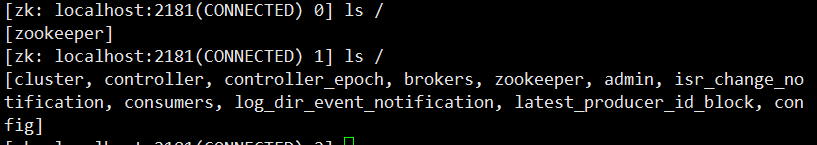

Kafka依赖于zookeeper保存一些meta信息,来保证系统可用性。

2. 环境准备

2.1 安装zookeeper

zk官网下载安装包,如zookeeper-3.4.13.tar.gz,解压即可。

- 启动服务,默认监听端口2181

./bin/zkServer.sh start

- 客户端连接

./bin/zkCli.sh -server 10.183.222.203:2181

2.2 安装kafka

kafka官网下载安装包,如kafka_2.12-2.0.0.tgz,解压即可。

/config/server.properties配置:

log.dirs=/tmp/kafka-logs

listeners=PLAINTEXT://10.183.222.203:9092

zookeeper.connect=10.183.222.203:2181 #连接zookeeper

- 启动服务,默认监听端口9092

./bin/kafka-server-start.sh config/server.properties &

启动kafka后,zk增加了brokers、consumers等节点:

3. 命令行常用命令

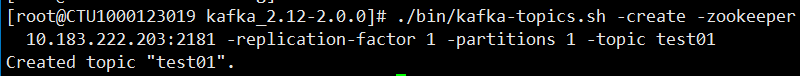

创建topic (-create)

# 创建topic:test01,并指定了replication-factor和partitions分别为1。

# replication-factor控制一个Message会被写到多少台服务器上,因此这个值必须≤Broker数量。

./bin/kafka-topics.sh -create -zookeeper 10.183.222.203:2181 -replication-factor 1 -partitions 1 -topic test01

查看topic详情 (-describe)

./bin/kafka-topics.sh -describe -zookeeper 10.183.222.203:2181

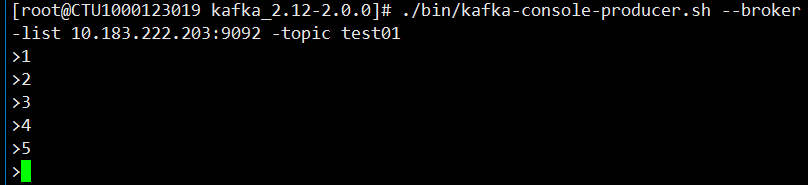

发送消息到指定topic

./bin/kafka-console-producer.sh --broker-list 10.183.222.203:9092 -topic test01

消费指定topic上的消息

./bin/kafka-console-consumer.sh -bootstrap-server 10.183.222.203:9092 -topic test01 -from-beginning

4. java api实现

4.1 添加maven配置

<!-- https://mvnrepository.com/artifact/org.apache.kafka/kafka-clients -->

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>2.0.0</version>

</dependency>

4.2 消息生产者

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerConfig;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;

/**

* 消息生产者

*/

public class ProducerDemo {

private static final String helloTopic = "HelloWorld";

public static void main(String[] args) {

// 1. 构造Propertity,进行producer 相关配置。

Properties properties = new Properties();

properties.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "10.183.222.203:9092");

properties.put(ProducerConfig.ACKS_CONFIG, "all");

properties.put(ProducerConfig.RETRIES_CONFIG, 0);

properties.put(ProducerConfig.BATCH_SIZE_CONFIG, 16384);

properties.put(ProducerConfig.LINGER_MS_CONFIG, 1);

properties.put(ProducerConfig.BATCH_SIZE_CONFIG, 33554432);

// 消息序列化方式

properties.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

properties.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = null;

try {

// 2. 构造Producer对象

producer = new KafkaProducer<>(properties);

for (int i = 0; i < 10; i++) {

String msgValue = "Message " + i;

// 3. 发送消息

producer.send(new ProducerRecord<>(helloTopic, msgValue));

System.out.println("Sent:" + msg);

}

} catch (Exception e) {

e.printStackTrace();

} finally {

if (producer != null) {

producer.close();

}

}

}

}

4.3 消息消费者

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.util.Collections;

import java.util.Properties;

/**

* consumer从kafka读取消息

*/

public class ConsumerDemo {

private static final String helloTopic = "HelloWorld";

public static void main(String[] args) {

// 1. 构造Propertity,进行consumer相关配置。

Properties properties = new Properties();

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "10.183.222.203:9092");

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "group-1");

properties.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, "true");

properties.put(ConsumerConfig.AUTO_COMMIT_INTERVAL_MS_CONFIG, "1000");

properties.put(ConsumerConfig.AUTO_OFFSET_RESET_CONFIG, "earliest");

properties.put(ConsumerConfig.SESSION_TIMEOUT_MS_CONFIG, "30000");

// 消息反序列化方式

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

// 2. 生成消费实例

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(properties);

// 3. 订阅相应的 topic

// 说明:可以消费多个topic: Arrays.asList(topic);

// topic支持正则表达式:如:subscribe(Pattern.compile("test.*")

consumer.subscribe(Collections.singleton(helloTopic));

// 4. 循环消费消息

while (true) {

try {

// 4.1 poll方法拉取订阅的消息, 消费者必须不断的执行poll,获取消息、维持连接。

ConsumerRecords<String, String> records = consumer.poll(1000);

// 4.2 消费数据,必须在下次poll之前消费完这些数据, 且总耗时不得超过SESSION_TIMEOUT_MS_CONFIG

// 若不能在下次poll之前消费完,则会触发一次负载均衡,产生卡顿。

// 可以开一个单独的线程池来消费消息,然后异步返回结果。

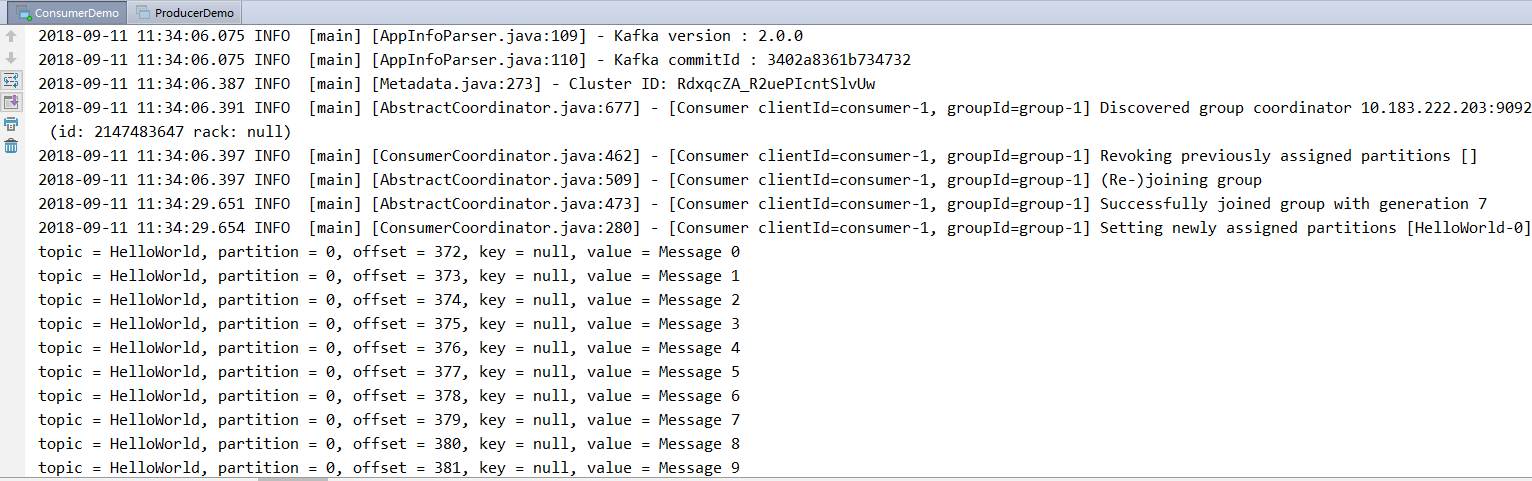

for (ConsumerRecord<String, String> record : records) {

System.out.printf("topic = %s, partition = %d, offset = %d, key = %s, value = %s\n",

record.topic(), record.partition(), record.offset(), record.key(), record.value());

}

} finally {

// 不再消费主动关闭

consumer.close();

}

}

}

}

kafka作为目前广泛使用的消息中间件。本文对其核心组件和基本用法做了学习记录。

参考:Kafka: The Definitive Guide

消息中间件kafka学习记录的更多相关文章

- Kafka学习记录

1 Kafka的基本介绍 Apache Kafka是分布式发布-订阅消息系统.它最初由LinkedIn公司开发,之后成为Apache项目的一部分.具有快速.可扩展.分布式.可复制等特点.Kafka与传 ...

- 消息队列Kafka学习记录

Kafka其实只是众多消息队列中的一种,对于Kafka的具体释义我这里就不多说了,详见:http://baike.baidu.com/link?url=HWFYszYuMdP_lueFH5bmYnlm ...

- kafka学习笔记——基本概念与安装

Kafka是一个开源的,轻量级的.分布式的.具有复制备份.基于zooKeeper协调管理的分布式消息系统. 它具备以下三个特性: 能够发布订阅流数据: 存储流数据时,提供相应的容错机制 当流数据到达时 ...

- kafka学习笔记(一)消息队列和kafka入门

概述 学习和使用kafka不知不觉已经将近5年了,觉得应该总结整理一下之前的知识更好,所以决定写一系列kafka学习笔记,在总结的基础上希望自己的知识更上一层楼.写的不对的地方请大家不吝指正,感激万分 ...

- Kafka学习-简介

Kafka是由LinkedIn开发的一个分布式的消息系统,使用Scala编写,它以可水平扩展和高吞吐率而被广泛使用.目前越来越多的开源分布式处理系统如Cloudera.Apache Storm.S ...

- java后端学习记录2019

学习计划 2019年计划 1.学习计算机基础,并加以实践.包括LeetCode刷题.数据库原理(索引和锁.Sql优化等).网络协议(Http.Tcp).操作系统(加深Linux).<Http权威 ...

- 区块链Hyperledger Fabric 学习记录(一)开发环境搭建(ubuntu16.04/ubuntu18.04)

目录 Fabric开发环境搭建 更新说明 教程环境及软件版本 Docker 安装Docker 配置用户组 配置Aliyun Docker加速器 安装docker-compose Go 下载源码 安装源 ...

- Spring Boot 2.0 教程 | 快速集成整合消息中间件 Kafka

欢迎关注个人微信公众号: 小哈学Java, 每日推送 Java 领域干货文章,关注即免费无套路附送 100G 海量学习.面试资源哟!! 个人网站: https://www.exception.site ...

- Spring Boot 2.0 快速集成整合消息中间件 Kafka

欢迎关注个人微信公众号: 小哈学Java, 每日推送 Java 领域干货文章,关注即免费无套路附送 100G 海量学习.面试资源哟!! 个人网站: https://www.exception.site ...

随机推荐

- spark的任务调度模式

spark任务调度和资源分配 1.Spark调度模式 FIFO和FAIR Spark中的调度模式主要有两种:FIFO和FAIR. 默认情况下Spark的调度模式是FIFO(先进先出),谁先提交谁先执行 ...

- ebay上传图片的要求

eBay's Picture Requirements Introduction to Pictures in Listings Pictures make an item more appealin ...

- (¥1011)->(一千零一拾一元整)输出

public class RenMingBi { /** * @param args add by zxx ,Nov 29, 2008 */ private static final char[] d ...

- 2、Android自动测试之Monkey工具

Android自动测试之Monkey工具 APP测试工作中经常会听到领导说,APP压力测试做了吗?刚入行时,不知道什么是 APP压力测试,找了半天没找到自己想要的.过了几年,回头想这个问题,发现牵扯了 ...

- This function has none of DETERMINISTIC, NO SQL, or READS SQL DATA in its de 错误解决

这是我们开启了bin-log, 我们就必须指定我们的函数是否是1 DETERMINISTIC 不确定的2 NO SQL 没有SQl语句,当然也不会修改数据3 READS SQL DATA 只是读取数据 ...

- 2019河北省大学生程序设计竞赛(重现赛) L题-smart robot(深度优先搜索)

题目链接:https://ac.nowcoder.com/acm/contest/903/L 题意:给你 n * n的方阵,你可以从任意一个数字开始走,可以走上下左右四个方向,走过的数字会被拼合,拼合 ...

- vue 笔记,ref 及 $event 事件对象

本文仅用作简单记录 ref : 在标签上添加 ref = “name” ,表示获取当前元素节点 <input type="text" ref="info" ...

- ajax 回传参数

JSONObject json = new JSONObject(); json.put("msg", msg); json.put("success", co ...

- [已解决]报错:ValueError: Expected 2D array, got scalar array instead

报错代码: new_x = 84610 pre_y = model.predict(new_x) print(pre_y) 报错结果: ValueError: Expected 2D array, g ...

- 在ubuntu16下安装virtualenv+virtualenvwrapper

ubuntu16已经安装好了py2和py3(自带的) bigni@bigni-Latitude-E6230:~/python_file/Django_project$ python python py ...