python-scrapy爬取某招聘网站(二)

首先要准备python3+scrapy+pycharm

一、首先让我们了解一下网站

拉勾网https://www.lagou.com/

和Boss直聘类似的网址设计方式,与智联招聘不同,它采用普通的页面加载方式

我们采用scrapy中的crawlspider爬取

二、创建爬虫程序

scrapy startproject lagou

创建爬虫文件

scrapy genspider -t crawl zhaopin "www.lagou.com"

由此爬虫程序创建完毕

三、编写爬虫程序

出于演示和测试,我们这次只爬取一条数据。

items文件

import scrapy class BossItem(scrapy.Item):

# 岗位名称

jobName = scrapy.Field()

zhaopin.py爬虫文件

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from boss.items import BossItem class ZhipinSpider(CrawlSpider):

name = 'zhipin'

allowed_domains = ['www.lagou.com']

start_urls = ['https://www.lagou.com'] rules = (

Rule(LinkExtractor(allow=r'com/zhaopin/\w+/'), callback='zhilianParse', follow=False), #采用正则匹配的方式,获取网页url

) def zhilianParse(self, response):

datas = response.xpath('//ul[@class="item_con_list"]/li') #通过xpath方式获取要爬取的域

for data in datas: #逐层迭代

item = BossItem()

# 岗位名称

item["jobName"] = data.xpath('//div//div/a/h3[1]/text()').get() #定位爬取信息

yield item #rule会迭代所有的url不需要再写回调函数

管道文件

import json

import os

class BossPipeline(object):

def __init__(self):

self.filename = open("Boss.json", "wb")

self.path = "G:\images\p"

if not os.path.exists(self.path):

os.mkdir(self.path) #判断路径

def process_item(self, item, spider):

# 岗位名称

jobName = item['jobName']

js = json.dumps(dict(item), ensure_ascii=False) + "\n"

self.filename.write(js.encode("utf-8"))

return item

def __close__(self):

self.filename.close()

配置settings文件

DEFAULT_REQUEST_HEADERS = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36',

}

ITEM_PIPELINES = {

'boss.pipelines.BossPipeline': 300,

}

LOG_FILE="log.log" #放日志文件用的,可有可无

ROBOTSTXT_OBEY = False

四、启动爬虫

scrapy crawl zhaopin

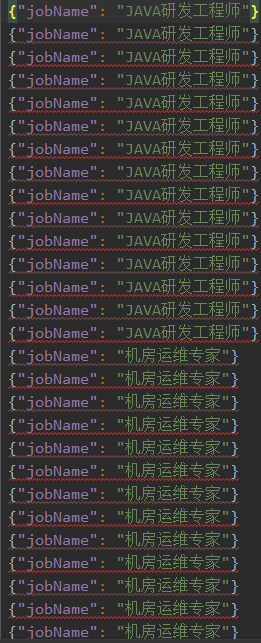

爬取结果

在第一篇文章中讲了如何存入mysql,这里我就不多赘述了,大家自行查阅。

python-scrapy爬取某招聘网站(二)的更多相关文章

- Python——Scrapy爬取链家网站所有房源信息

用scrapy爬取链家全国以上房源分类的信息: 路径: items.py # -*- coding: utf-8 -*- # Define here the models for your scrap ...

- python scrapy爬取前程无忧招聘信息

使用scrapy框架之前,使用以下命令下载库: pip install scrapy -i https://pypi.tuna.tsinghua.edu.cn/simple 1.创建项目文件夹 scr ...

- scrapy爬取西刺网站ip

# scrapy爬取西刺网站ip # -*- coding: utf-8 -*- import scrapy from xici.items import XiciItem class Xicispi ...

- python scrapy爬取HBS 汉堡南美航运公司柜号信息

下面分享个scrapy的例子 利用scrapy爬取HBS 船公司柜号信息 1.前期准备 查询提单号下的柜号有哪些,主要是在下面的网站上,输入提单号,然后点击查询 https://www.hamburg ...

- Python轻松爬取Rosimm写真网站全部图片

RosimmImage 爬取Rosimm写真网站图片 有图有真相 def main_start(url): """ 爬虫入口,主要爬取操作 ""&qu ...

- 利用python实现爬虫爬取某招聘网站,北京地区岗位名称包含某关键字的所有岗位平均月薪

#通过输入的关键字,爬取北京地区某岗位的平均月薪 # -*- coding: utf-8 -*- import re import requests import time import lxml.h ...

- Python网络爬虫 | Scrapy爬取妹子图网站全站照片

根据现有的知识,写了一个下载妹子图(meizitu.com)Scrapy脚本,把全站两万多张照片下载到了本地. 网站的分析 网页的网址分析 打开网站,发现网页的网址都是以 http://www.mei ...

- Python Scrapy 爬取煎蛋网妹子图实例(二)

上篇已经介绍了 图片的爬取,后来觉得不太好,每次爬取的图片 都在一个文件下,不方便区分,且数据库中没有爬取的时间标识,不方便后续查看 数据时何时爬取的,所以这里进行了局部修改 修改一:修改爬虫执行方式 ...

- 爬虫框架之Scrapy——爬取某招聘信息网站

案例1:爬取内容存储为一个文件 1.建立项目 C:\pythonStudy\ScrapyProject>scrapy startproject tenCent New Scrapy projec ...

随机推荐

- CAS学习过程中的一些记录

1 inline jint Atomic::cmpxchg (jint exchange_value, volatile jint* dest, jint compare_value) { 2 int ...

- 倾斜摄影实景三维在智慧工厂 Web 3D GIS 数字孪生应用

数字化推动钢铁工业转型升级 数字时代,随着数字地球,数字中国,数字工厂等数字化建设的不断深入,以地理信息系统(Geographic Information System, GIS)为基础,融合大数 ...

- PyQt(Python+Qt)学习随笔:QScrollArea的widgetResizable属性

老猿Python博文目录 专栏:使用PyQt开发图形界面Python应用 老猿Python博客地址 滚动区域的widgetResizable属性用于控制滚动区域的内容部署层是否应跟随滚动区域的大小变化 ...

- PyQt学习随笔:重写setData方法截获Model/View中视图数据项编辑的注意事项

根据<PyQt学习随笔:Model/View中视图数据项编辑变动实时获取变动数据的方法>可以重写从PyQt的Model类继承的setData方法来实时截获View中对数据的更改,但需要注意 ...

- 乌云wooyun网站硬盘复活

AWD比赛防止没有网络,在移动硬盘里面准备一个乌云漏洞库. 之前也想过弄一个乌云的镜像网站,无奈学生机性能太低下了,部署到公网上服务器存储空间都不够,只能部署在本地硬盘了. 乌云镜像的开源地址:htt ...

- 移动端H5测试调试利器 chrome://inspect/#devices

使用 chrome://inspect/#devices,可以使安卓手机里的WebView也能和chrome一样审查元素,调试和测试移动端H5页面. 我使用的是三星S6 (该功能支持安卓系统4.4及以 ...

- ripple Failed to load resource: the server responded with a status of 404 (Not Found)

在VS2015中使用Cordova + typescript开发中,遇到个问题. 在javascript console 中提示: Failed to load resource: the serve ...

- Day3 Scrum 冲刺博客

·线上会议: 昨天已完成的工作与今天计划完成的工作及工作中遇到的困难: 成员姓名 昨天完成工作 今天计划完成的工作 工作中遇到的困难 纪昂学 创建一个Cell类,用来表示一个小方块 就创建一个Tetr ...

- 一种不错的 BFF Microservice GraphQL/REST API 层的开发方式

云原生(Cloud Native)Node JS Express Reactive 微服务模板 (REST/GraphQL) 这个项目提供了完整的基于 Node JS / Typescript 的微服 ...

- 网络QoS的平衡之道——音视频弱网对抗策略介绍

作者:网易智企云信资深音视频引擎开发工程师 王兴鹤 随着AI和5G的到来,音视频应用将变得越来越广泛,人们对音视频的品质需求也越来越高,视频分辨率已经从高清发展为超高清.VR,视频帧率也已出现60fp ...