BeautifulSoup解析页面

beautiful soup是一个解析包,专门用来解析html语法的,lxml是一个解析器,用来分析以及定位内容的

.是class #是id

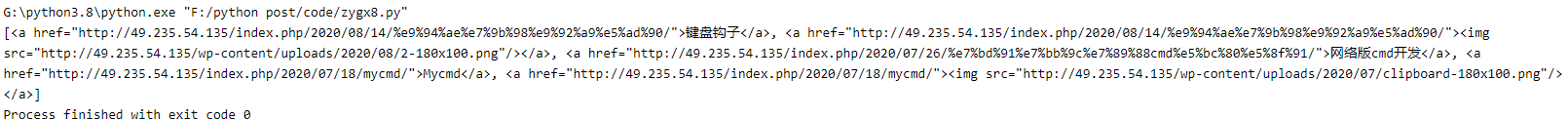

import requests

from bs4 import BeautifulSoup

html = requests.get('https://www.zygx8.com/forum.php')

soup = BeautifulSoup(html.text,'lxml')

tbody = soup.select('a font b')

print(tbody)

输出

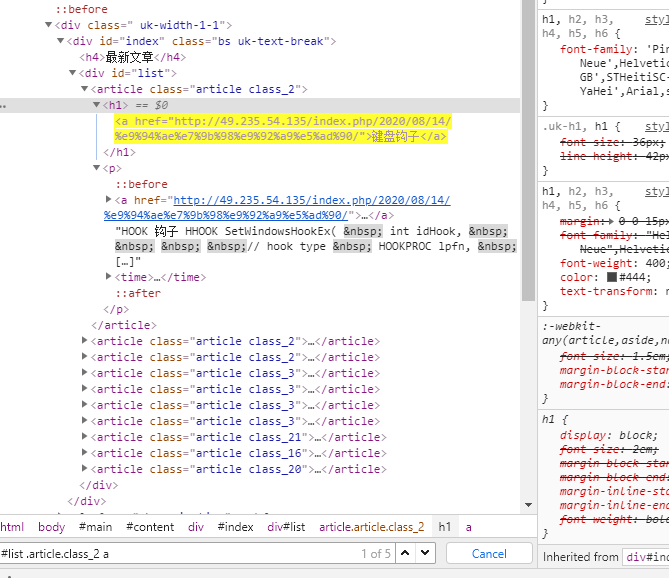

然后我们可以看到返回的都有个a标签,beautifulsoup其实有个自带的

for t in tbody:

print(t.text)

输出

键盘钩子

网络版cmd开发

Mycmd

这里选择器我们就用select,比如我们要获取title就直接soup.select('title'),通过tag逐层下找比如

soup.select('html head title')

soup.select('body a')

select_one只获取一个

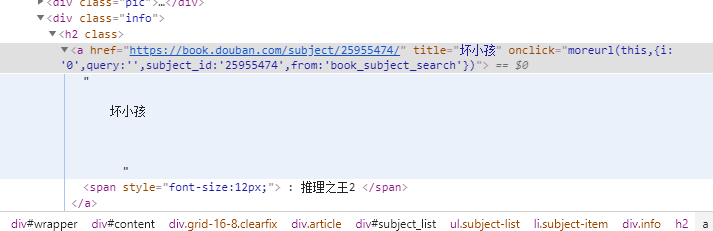

这里我们来测试豆瓣

import requests

from bs4 import BeautifulSoup

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36'

}

html = requests.get('https://book.douban.com/tag/%E5%B0%8F%E8%AF%B4',headers=headers)

soup = BeautifulSoup(html.text,'lxml')

title = soup.select('.subject-list .subject-item .info h2 a')

for t in title:

print(t.text.strip().replace('\n',''))

输出

G:\python3.8\python.exe "F:/python post/code/zygx8.py"

坏小孩 : 推理之王2

活着

白夜行

小王子

解忧杂货店

红楼梦

追风筝的人

百年孤独

房思琪的初恋乐园

长夜难明 : 推理之王3

嫌疑人X的献身

平凡的世界(全三部)

1984

月亮与六便士

霍乱时期的爱情

围城

云边有个小卖部

杀死一只知更鸟

局外人

烧纸

Process finished with exit code 0

我们再清洗下

print(t.text.strip().replace('\n','').replace(' ',''))

输出

G:\python3.8\python.exe "F:/python post/code/zygx8.py"

坏小孩:推理之王2

活着

白夜行

小王子

解忧杂货店

红楼梦

追风筝的人

百年孤独

房思琪的初恋乐园

长夜难明:推理之王3

嫌疑人X的献身

平凡的世界(全三部)

1984

月亮与六便士

霍乱时期的爱情

围城

云边有个小卖部

杀死一只知更鸟

局外人

烧纸

BeautifulSoup解析页面的更多相关文章

- python爬虫主要就是五个模块:爬虫启动入口模块,URL管理器存放已经爬虫的URL和待爬虫URL列表,html下载器,html解析器,html输出器 同时可以掌握到urllib2的使用、bs4(BeautifulSoup)页面解析器、re正则表达式、urlparse、python基础知识回顾(set集合操作)等相关内容。

本次python爬虫百步百科,里面详细分析了爬虫的步骤,对每一步代码都有详细的注释说明,可通过本案例掌握python爬虫的特点: 1.爬虫调度入口(crawler_main.py) # coding: ...

- Python爬虫 | Beautifulsoup解析html页面

引入 大多数情况下的需求,我们都会指定去使用聚焦爬虫,也就是爬取页面中指定部分的数据值,而不是整个页面的数据.因此,在聚焦爬虫中使用数据解析.所以,我们的数据爬取的流程为: 指定url 基于reque ...

- python爬虫解析页面数据的三种方式

re模块 re.S表示匹配单行 re.M表示匹配多行 使用re模块提取图片url,下载所有糗事百科中的图片 普通版 import requests import re import os if not ...

- beautifulsoup解析

beautifulsoup解析 python独有 优势:简单.便捷.高效 - 环境安装 需要将pip源设置为国内源 -需要安装:pip install bs4 bs4在使用时需要一个第三方库 pip ...

- python3+beautifulSoup4.6抓取某网站小说(三)网页分析,BeautifulSoup解析

本章学习内容:将网站上的小说都爬下来,存储到本地. 目标网站:www.cuiweijuxs.com 分析页面,发现一共4步:从主页进入分版打开分页列表.打开分页下所有链接.打开作品页面.打开单章内容. ...

- MiseringThread.java 解析页面线程

MiseringThread.java 解析页面线程 http://injavawetrust.iteye.com package com.iteye.injavawetrust.miner; imp ...

- MinerUrl.java 解析页面后存储URL类

MinerUrl.java 解析页面后存储URL类 package com.iteye.injavawetrust.miner; /** * 解析页面后存储URL类 * @author InJavaW ...

- BeautifulSoup解析器的选择

BeautifulSoup解析器 在我们使用BeautifulSoup的时候,选择怎样的解析器是至关重要的.使用不同的解析器有可能会出现不同的结果! 今天遇到一个坑,在解析某html的时候.使用htm ...

- Python3.x的BeautifulSoup解析html常用函数

Python3.x的BeautifulSoup解析html常用函数 1,初始化: soup = BeautifulSoup(html) # html为html源代码字符串,type(html) == ...

随机推荐

- Vue DevTools 安装应用

1.https: //github.com/vuejs/vue-devtools 从这上面下载Vue DevTools: 2.npm install(cnpm install) && ...

- springMVC入门(三)------springMVC的处理器映射器和处理器适配器配置

简介 springMVC的处理器映射器和处理器适配器存在多种配置,因此在此专门做一个总结 常见处理器映射器.适配器的配置 springmvc多个映射器多个处理器可以并存 所有的映射器都实现了Handl ...

- beego 快速入门

原文链接:https://beego.me/quickstart 1.安装依赖 git clone http://github.com/astaxie/beego.git git clone http ...

- ubuntu ARM 源配置

cat /etc/apt/sources.list deb http://mirrors.aliyun.com/ubuntu-ports/ xenial main deb-src http://mir ...

- 第5篇 Scrum冲刺博客

1.站立式会议 1.1 会议图片 1.2 项目进展 成员 昨日任务 今日计划完成任务 陈忠明 歌曲信息的上传/下载包 歌曲批量下载压缩包 吴茂平 完善评论系统 新消息提醒功能设计 黄海钊 修改代码规范 ...

- 精讲响应式WebClient第5篇-请求超时设置与异常处理

本文是精讲响应式WebClient第5篇,前篇的blog访问地址如下: 精讲响应式webclient第1篇-响应式非阻塞IO与基础用法 精讲响应式WebClient第2篇-GET请求阻塞与非阻塞调用方 ...

- Markdown - Typora 10分钟入门 - 精简归纳

Markdown - Typora 10分钟入门 - 精简归纳 JERRY_Z. ~ 2020 / 8 / 22 转载请注明出处! 目录 Markdown - Typora 10分钟入门 - 精简归纳 ...

- ID3\C4.5\CART

目录 树模型原理 ID3 C4.5 CART 分类树 回归树 树创建 ID3.C4.5 多叉树 CART分类树(二叉) CART回归树 ID3 C4.5 CART 特征选择 信息增益 信息增益比 基尼 ...

- 03.AOF持久化机制配置与工作流程

一.AOF持久化的配置 配置文件redis.conf,AOF持久化默认是关闭的,默认是打开RDB持久化 appendonly yes 二.工作流程: 打开AOF持久化机制之后,redis每次接 ...

- 【Android】Listview返回顶部,快速返回顶部的功能实现,详解代码。

作者:程序员小冰,GitHub主页:https://github.com/QQ986945193 新浪微博:http://weibo.com/mcxiaobing 首先给大家看一下我们今天这个最终实现 ...