SparkMLlib分类算法之决策树学习

SparkMLlib分类算法之决策树学习

(一) 决策树的基本概念

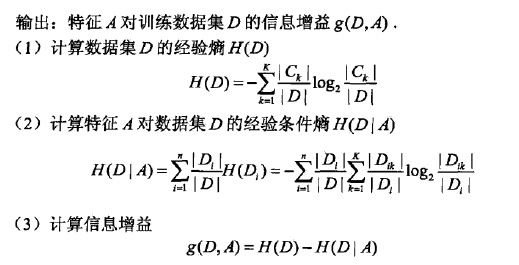

决策树(Decision Tree)是在已知各种情况发生概率的基础上,通过构成决策树来求取净现值的期望值大于等于零的概率,评价项目风险,判断其可行性的决策分析方法,是直观运用概率分析的一种图解法。由于这种决策分支画成图形很像一棵树的枝干,故称决策树。在机器学习中,决策树是一个预测模型,他代表的是对象属性与对象值之间的一种映射关系。Entropy = 系统的凌乱程度,使用算法ID3, C4.5和C5.0生成树算法使用熵。这一度量是基于信息学理论中熵的概念。通过信息增益来筛选出属性的优先性。

缺点:参考网址:http://www.ppvke.com/Blog/archives/25042

val orig_file=sc.textFile("train_nohead.tsv")

//println(orig_file.first())

val data_file=orig_file.map(_.split("\t")).map{

r =>

val trimmed =r.map(_.replace("\"",""))

val lable=trimmed(r.length-1).toDouble

val feature=trimmed.slice(4,r.length-1).map(d => if(d=="?")0.0

else d.toDouble)

LabeledPoint(lable,Vectors.dense(feature))

}

/*特征标准化优化,似乎对决策数没啥影响*/

val vectors=data_file.map(x =>x.features)

val rows=new RowMatrix(vectors)

println(rows.computeColumnSummaryStatistics().variance)//每列的方差

val scaler=new StandardScaler(withMean=true,withStd=true).fit(vectors)//标准化

val scaled_data=data_file.map(point => LabeledPoint(point.label,scaler.transform(point.features)))

.randomSplit(Array(0.7,0.3),11L)//固定seed为11L,确保每次每次实验能得到相同的结果

val data_train=scaled_data(0)

val data_test=scaled_data(1)

3,构建模型及模型评价

/*训练决策树模型*/

val model_DT=DecisionTree.train(data_train,Algo.Classification,Entropy,maxTreeDepth)

/*决策树的精确度*/

val predectionAndLabeledDT=data_test.map { point =>

val predectLabeled = if (model_DT.predict(point.features) > 0.5) 1.0 else 0.0

(predectLabeled,point.label)

}

val metricsDT=new MulticlassMetrics(predectionAndLabeledDT)

println(metricsDT.accuracy)//0.6273062730627307

/*决策树的PR曲线和AOC曲线*/

val dtMetrics = Seq(model_DT).map{ model =>

val scoreAndLabels = data_test.map { point =>

val score = model.predict(point.features)

(if (score > 0.5) 1.0 else 0.0, point.label)

}

val metrics = new BinaryClassificationMetrics(scoreAndLabels)

(model.getClass.getSimpleName, metrics.areaUnderPR, metrics.areaUnderROC)

}

val allMetrics = dtMetrics

allMetrics.foreach{ case (m, pr, roc) =>

println(f"$m, Area under PR: ${pr * 100.0}%2.4f%%, Area under ROC: ${roc * 100.0}%2.4f%%")

}

/*

DecisionTreeModel, Area under PR: 74.2335%, Area under ROC: 62.4326%

*/

4,模型参数调优(可以调解长度和纯度两方面考虑)

4.1 构建调参函数

/*调参函数*/

def trainDTWithParams(input: RDD[LabeledPoint], maxDepth: Int,

impurity: Impurity) = {

DecisionTree.train(input, Algo.Classification, impurity, maxDepth)

}

4.2 调解树的深度评估函数 (提高树的深度可以得到更精确的模型(这和预期一致,因为模型在更大的树深度下会变得更加复杂)。然而树的深度越大,模型对训练数据过拟合程度越严重)

/*改变深度*/

val dtResultsEntropy = Seq(1, 2, 3, 4, 5, 10, 20).map { param =>

val model = trainDTWithParams(data_train, param, Entropy)

val scoreAndLabels = data_test.map { point =>

val score = model.predict(point.features)

(if (score > 0.5) 1.0 else 0.0, point.label)

}

val metrics = new BinaryClassificationMetrics(scoreAndLabels)

(s"$param tree depth", metrics.areaUnderROC)

}

dtResultsEntropy.foreach { case (param, auc) => println(f"$param, " +

f"AUC = ${auc * 100}%2.2f%%") }

/*

1 tree depth, AUC = 58.57%

2 tree depth, AUC = 60.69%

3 tree depth, AUC = 61.40%

4 tree depth, AUC = 61.30%

5 tree depth, AUC = 62.43%

10 tree depth, AUC = 62.26%

20 tree depth, AUC = 60.59%

*/

2,调解纯度参数 (差异不是很明显。。)

/*改变纯度*/

val dtResultsEntropy = Seq(Gini,Entropy).map { param =>

val model = trainDTWithParams(data_train, 5, param)

val scoreAndLabels = data_test.map { point =>

val score = model.predict(point.features)

(if (score > 0.5) 1.0 else 0.0, point.label)

}

val metrics = new BinaryClassificationMetrics(scoreAndLabels)

(s"$param tree depth", metrics.areaUnderROC)

}

dtResultsEntropy.foreach { case (param, auc) => println(f"$param, " +

f"AUC = ${auc * 100}%2.2f%%") }

/*

org.apache.spark.mllib.tree.impurity.Gini$@32d8e58d tree depth, AUC = 62.37%

org.apache.spark.mllib.tree.impurity.Entropy$@1ddba7a0 tree depth, AUC = 62.43%

*/

(三) 交叉验证

1,数据集分类

创建三个数据集:训练集

评估集(类似上述测试集用于模型参数的调优,比如 lambda 和步长)

测试集(不用于模型的训练和参数调优,只用于估计模型在新数据中性能)

2,交叉验证的常用方法

一个流行的方法是 K- 折叠交叉验证,其中数据集被分成 K 个不重叠的部分。用数据中的 K-1 份训练模型,剩下一部分测试模型。而只分训练集和测试集可以看做是 2- 折叠交叉验证。

还有“留一交叉验证”和“随机采样”。更多资料详见 http://en.wikipedia.org/wiki/Cross-validation_(statistics) 。

SparkMLlib分类算法之决策树学习的更多相关文章

- Netflix工程总监眼中的分类算法:深度学习优先级最低

Netflix工程总监眼中的分类算法:深度学习优先级最低 摘要:不同分类算法的优势是什么?Netflix公司工程总监Xavier Amatriain根据奥卡姆剃刀原理依次推荐了逻辑回归.SVM.决策树 ...

- SparkMLlib分类算法之支持向量机

SparkMLlib分类算法之支持向量机 (一),概念 支持向量机(support vector machine)是一种分类算法,通过寻求结构化风险最小来提高学习机泛化能力,实现经验风险和置信范围的最 ...

- SparkMLlib回归算法之决策树

SparkMLlib回归算法之决策树 (一),决策树概念 1,决策树算法(ID3,C4.5 ,CART)之间的比较: 1,ID3算法在选择根节点和各内部节点中的分支属性时,采用信息增益作为评价标准.信 ...

- SparkMLlib分类算法之逻辑回归算法

SparkMLlib分类算法之逻辑回归算法 (一),逻辑回归算法的概念(参考网址:http://blog.csdn.net/sinat_33761963/article/details/5169383 ...

- 【分类算法】决策树(Decision Tree)

(注:本篇博文是对<统计学习方法>中决策树一章的归纳总结,下列的一些文字和图例均引自此书~) 决策树(decision tree)属于分类/回归方法.其具有可读性.可解释性.分类速度快等优 ...

- (ZT)算法杂货铺——分类算法之决策树(Decision tree)

https://www.cnblogs.com/leoo2sk/archive/2010/09/19/decision-tree.html 3.1.摘要 在前面两篇文章中,分别介绍和讨论了朴素贝叶斯分 ...

- 数据挖掘分类算法之决策树(zz)

决策树(Decision tree) 决策树是以实例为基础的归纳学习算法. 它从一组无次序.无规则的元组中推理出决策树表示形式的分类规则.它采用自顶向下的递归方式,在决策树的内部结点进行属性值 ...

- 分类算法:决策树(C4.5)(转)

C4.5是机器学习算法中的另一个分类决策树算法,它是基于ID3算法进行改进后的一种重要算法,相比于ID3算法,改进有如下几个要点: 1)用信息增益率来选择属性.ID3选择属性用的是子树的信息增益,这里 ...

- SparkMLlib学习分类算法之逻辑回归算法

SparkMLlib学习分类算法之逻辑回归算法 (一),逻辑回归算法的概念(参考网址:http://blog.csdn.net/sinat_33761963/article/details/51693 ...

随机推荐

- ARM 常用汇编指令

ARM 汇编程序的框架结构 .section .data <初始化的数据> .section.bss <未初始化的数据> .section .text .global _sta ...

- 阿里云腾讯云服务器ubuntu多域名配置

1.将域名A记录解析到服务器的公网 IP 地址,把www也添加A记录到公网ip 2.ubuntu系统修改hosts文件,hosts文件目录为/etc/hosts,可以用vim编辑 sudo vim ...

- BZOJ.4919.[Lydsy1706月赛]大根堆(线段树合并/启发式合并)

题目链接 考虑树退化为链的情况,就是求一个最长(严格)上升子序列. 对于树,不同子树间是互不影响的.仿照序列上的LIS,对每个点x维护一个状态集合,即合并其子节点后的集合,然后用val[x]替换掉第一 ...

- 洛谷.4512.[模板]多项式除法(NTT)

题目链接 多项式除法 & 取模 很神奇,记录一下. 只是主要部分,更详细的和其它内容看这吧. 给定一个\(n\)次多项式\(A(x)\)和\(m\)次多项式\(D(x)\),求\(deg(Q) ...

- 【BZOJ】2730: [HNOI2012]矿场搭建【Tarjan找割点】【分联通块割点个数】

2730: [HNOI2012]矿场搭建 Time Limit: 10 Sec Memory Limit: 128 MBSubmit: 3230 Solved: 1540[Submit][Stat ...

- 【8.13校内测试】【DP】【按除数分类】【二分】

感觉今天状态不太好啊一大早就很困,t1卡得有点久,以为三道题都是这个难度,结果难度完全是倒着排的啊!!在dp和数学上还得多练题!! 很像背包的一道DP??先不考虑树的结构,给每个点都先分配一个度数,剩 ...

- ZOJ 3235 Prototype

Prototype Time Limit: 1 Second Memory Limit: 32768 KB Prototype is a 3D game which allow you to ...

- 基于(Redis | Memcache)实现分布式互斥锁

设计一个缓存系统,不得不要考虑的问题就是:缓存穿透.缓存击穿与失效时的雪崩效应. 缓存击穿 缓存穿透是指查询一个一定不存在的数据,由于缓存是不命中时被动写的,并且出于容错考虑,如果从存储层查不到数据则 ...

- 获取数据库连接对象(线程ThreadLocal)

/** * 负责数据库连接定义的程序类 * 该类可以负责所有操作线程的数据库连接,利用get()方法可以获得连接对象 */ public class DatabaseConnection { priv ...

- Java_tomcat thread dump 分析

前言 Java Thread Dump 是一个非常有用的应用诊断工具, 通过thread dump出来的信息, 可以定位到你需要了解的线程, 以及这个线程的调用栈. 如果配合linux的top命令, ...