hadoop2.6.4 搭建伪分布式

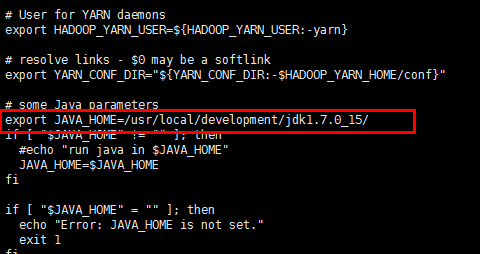

安装jdk1.7

http://www.cnblogs.com/zhangXingSheng/p/6228432.html

[root@node4 sysconfig]# more /etc/hosts

127.0.0.1 localhost

192.168.177.124 hadoop-node4.com node4

[root@node4 sysconfig]#

修改主机名

[root@node4 sysconfig]# more network

NETWORKING=yes

HOSTNAME=node4

[root@node4 sysconfig]#

配置hadoop环境变量(vi /etc/profile)

###############hadoop################

export HADOOP_HOME=/usr/local/development/hadoop-2.6.

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export JAVA_HOME=/usr/local/development/jdk1.7.0_15

[root@node4 hadoop]# more slaves

node4

[root@node4 hadoop]#

<configuration>

<property>

<name>hadoop.tmp.dir</name> //配置hadoop运行时临时文件的目录位置

<value>file:/home/zhangxs/data/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://hadoop-zhangxs.com:9000</value>//配置nameNode的端口

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

</configuration>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>//存储文件的副本数

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/zhangxs/data/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/zhangxs/data/hadoop/tmp/dfs/data</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

</configuration>

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop-zhangxs.com:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop-zhangxs.com:19888</value>

</property> </configuration>

<configuration> <!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop-zhangxs.com</value>

</property>

<property>

//nodeManager上运行的附属服务,需要配置mapreduce_shuffle才可以运行mapreduce程序

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

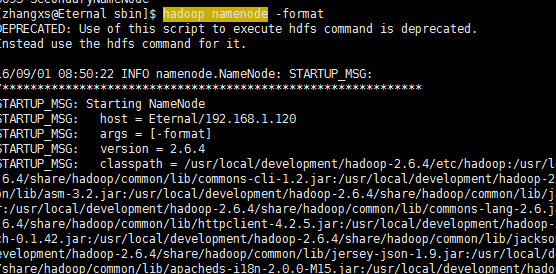

8-1:格式化hdfs文件系统(hadoop namenode -format)

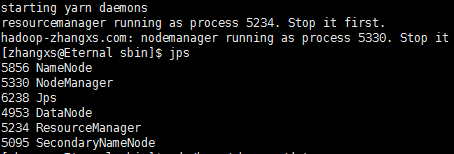

8-2:启动start.dsf.sh start yarn.sh

8-3:输入jps,查看运行进程

8-1 格式化hdfs文件系统(hadoop namenode -format)

8-2 启动start.dsf.sh start yarn.sh

8-3 输入jps,查看运行进程

http://192.168.177.124:50070 hdfs文件管理

http://192.168.177.124:8088 ResourceManager

-----------------------------------------------------------------------

如果页面访问不到,把linux的防火墙关闭

service iptables stop//这个只是暂时关闭,系统重启后失效

hadoop2.6.4 搭建伪分布式的更多相关文章

- hadoop(二)搭建伪分布式集群

前言 前面只是大概介绍了一下Hadoop,现在就开始搭建集群了.我们下尝试一下搭建一个最简单的集群.之后为什么要这样搭建会慢慢的分享,先要看一下效果吧! 一.Hadoop的三种运行模式(启动模式) 1 ...

- hadoop搭建伪分布式集群(centos7+hadoop-3.1.0/2.7.7)

目录: Hadoop三种安装模式 搭建伪分布式集群准备条件 第一部分 安装前部署 1.查看虚拟机版本2.查看IP地址3.修改主机名为hadoop4.修改 /etc/hosts5.关闭防火墙6.关闭SE ...

- centos7搭建伪分布式集群

centos7搭建伪分布式集群 需要 centos7虚拟机一台: jdk-linux安装包一个 hadoop-2.x安装包1个(推荐2.7.x) 一.设置虚拟机网络为静态IP(最好设成静态,为之后编程 ...

- 超详细!CentOS 7 + Hadoop3.0.0 搭建伪分布式集群

超详细!CentOS 7 + Hadoop3.0.0 搭建伪分布式集群 ps:本文的步骤已自实现过一遍,在正文部分避开了旧版教程在新版使用导致出错的内容,因此版本一致的情况下照搬执行基本不会有大错误. ...

- hadoop2.2.0 单机伪分布式(含64位hadoop编译) 及 eclipse hadoop开发环境搭建

hadoop中文镜像地址:http://mirrors.hust.edu.cn/apache/hadoop/core/hadoop-2.2.0/ 第一步,下载 wget 'http://archive ...

- Mac OS X上搭建伪分布式CDH版本Hadoop开发环境

最近在研究数据挖掘相关的东西,在本地 Mac 环境搭建了一套伪分布式的 hadoop 开发环境,采用CDH发行版本,省时省心. 参考来源 How-to: Install CDH on Mac OSX ...

- 搭建伪分布式 hadoop3.1.3 + zookeeper 3.5.7 + hbase 2.2.2

安装包 Hadoop 3.1.3 Zookeeper 3.5.7 Hbase 2.2.2 所需工具链接: 链接:https://pan.baidu.com/s/1jcenv7SeGX1gjPT9RnB ...

- Ubuntu-16.04-Desktop +Hadoop2.7.5+Eclipse-Neon的云计算开发环境的搭建(伪分布式方式)

主控终端 主机名 ubuntuhadoop.smartmap.com IP 192.168.1.60 Subnet mask 255.255.255.0 Gateway 192.168.1.1 DNS ...

- hadoop3.1.0 HDFS快速搭建伪分布式环境

1.环境准备 CenntOS7环境 JDK1.8-并配置好环境变量 下载Hadoop3.1.0二进制包到用户目录下 2.安装Hadoop 1.解压移动 #1.解压tar.gz tar -zxvf ha ...

随机推荐

- mysql 数据类型拾遗

写这篇博客的原因是在建表的过程我建表时,在表名和字段名上没有注意,违背了团队的开发规范.我们团队规范是,名字上要能够体现对象的特征. 比如: 数据库要写db_dbname 表名要写tb_tbname ...

- 【mysql】mysql 常用建表语句

[1]建立员工档案表要求字段:员工员工编号,员工姓名,性别,工资,email,入职时间,部门.[2]合理选择数据类型及字段修饰符,要求有NOT NULL,auto_increment, primary ...

- Swift中的可选链与内存管理(干货系列)

干货之前:补充一下可选链(optional chain) class A { var p: B? } class B { var p: C? } class C { func cm() -> S ...

- bootstrap学习笔记--bootstrap组件

前面已经学习了bootstrap环境搭建以及基本布局方面的知识,下面将学习下关于bootstrap的相关组件,知识点有点多. 关于bootstrap组件知识点目录: Bootstrap--代码显示 B ...

- Java网络编程--简单聊天程序

背景 毕业设计前的练手,学校小比赛中的一个题目. 开发环境 Java(eclipse)+Mysql 简介 使用Java+Mysql开发以个简单的聊天工具,在本次项目中实现了: 1. 用户登录(客户端至 ...

- php程序 注册机制

密码加密方式 1.直接md5加密 2.md5和随机数(也可以是固定参数,如(Rfd4WE784)) 3.md5(md5) 4. 参考 function sp_password($pw,$authcod ...

- Bubble Cup 8 finals B. Bribes (575B)

题意: 给定一棵n个点和有向边构成的树,其中一些边是合法边,一些边是非法边, 经过非法边需要1的费用,并且经过之后费用翻倍. 给定一个长为m的序列,问从点1开始按顺序移动到序列中对应点的总费用. 1& ...

- php扩展memcached和memcache的安装配置方法:转载

本文转载:http://www.jb51.net/article/56999.htm php连接memcached缓存服务器的客户端有两个,一个是memcache是比较底层的开发库,memcached ...

- iOS多线程-GCD之常用函数

延迟执行任务函数dispatch_after(.....) -(void)touchesBegan:(NSSet<UITouch *> *)touches withEvent:(UIEve ...

- sql手工注入时的探测技巧汇总

工具的灵活性肯定比不上人,在手工探测的基础上再去自定义工具,才是正道. sql注入时手工探测技巧 =================================================== ...