CentOS7 下 Hadoop 分布式部署

Hadoop 服务划分

使用三台节点,集群部署规划如下

|

服务\主机 |

hadoop1 |

hadoop2 |

hadoop3 |

|---|---|---|---|

|

HDFS |

NameNode DataNode |

DataNode |

SecondaryNameNode DataNode |

|

YARN |

NodeManager |

ResourceManager NodeManager |

NodeManager |

IP地址规划

hadoop1 192.168.123.11

hadoop2 192.168.123.12

hadoop3 192.168.123.13

系统环境配置

一、基本信息配置(三台节点需要分别配置)

IP地址配置

# 配置 IP 地址,网卡配置文件不一定相同

vim /etc/sysconfig/network-scripts/ifcfg-ens33 # 自启动网卡

ONBOOT="yes"

# IP地址

IPADDR="192.168.123.11"

# 子网页码

PREFIX=""

# 网关

GATEWAY="192.168.123.2"

# DNS 服务器

DNS1="119.29.29.29" # 重启网络服务

systemctl restart network

修改主机名

# 修改主机名字为 hadoop1

hostnamectl set-hostname hadoop1 # 退出当前用户再登录即可看见

logout

关闭防火墙,也可放行

# 关闭防火墙

systemctl stop firewalld # 关闭防火墙开机自启动

systemctl disable firewalld

安装 Rsync 工具,用于同步主机之间的文件,这样后面的配置文件修改就不用每台机器都改一遍,直接同步过去即可

# 清空 yum 源。若已配置源,直接安装即可

rm -rf /etc/yum.repos.d/* # 配置阿里 yum 源

curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo # 安装 rsync

yum install -y rsync

二、基本服务配置(配置一台主机,其他主机同步即可)

配置主机之间相互免密登录

# 以一台机器为例子,其他一样 # 生成密钥文件,一直回车

ssh-keygen -t ecdsa -b # 配置免密登录,需要输入远程主机密码,本机也需要配置

ssh-copy-id -i ~/.ssh/id_ecdsa.pub hadoop1

ssh-copy-id -i ~/.ssh/id_ecdsa.pub hadoop2

ssh-copy-id -i ~/.ssh/id_ecdsa.pub hadoop3 # 验证,不用输密码即为成功

ssh hadoop1 ls /

添加主机名到 Hosts 文件

vim /etc/hosts 127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

:: localhost localhost.localdomain localhost6 localhost6.localdomain6

# 对应本机IP地址,非 127.0.0.1

192.168.123.11 hadoop1

192.168.123.12 hadoop2

192.168.123.13 hadoop3

安装 JDK https://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

# 解压

tar -zxf /opt/jdk-8u202-linux-x64.tar.gz -C /opt/ # 配置环境变量

vim /etc/profile # JAVA_HOME

export JAVA_HOME=/opt/jdk1..0_202/

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$CLASSPATH

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH # 刷新环境变量

source /etc/profile # 验证

java -version # java version "1.8.0_202"

# Java(TM) SE Runtime Environment (build 1.8.0_202-b08)

# Java HotSpot(TM) -Bit Server VM (build 25.202-b08, mixed mode)

安装 Hadoop https://hadoop.apache.org/releases.html

# 解压

tar -zxf /opt/hadoop-2.9.-snappy-.tar.gz -C /opt/ # 配置环境变量

vim /etc/profile # HADOOP_HOME

export HADOOP_HOME=/opt/hadoop-2.9.

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin # 刷新环境变量

source /etc/profile # 验证

hadoop version # Hadoop 2.9.

# Subversion Unknown -r Unknown

# Compiled by root on --16T09:39Z

# Compiled with protoc 2.5.

# From source with checksum 3a9939967262218aa556c684d107985

# This command was run using /opt/hadoop-2.9./share/hadoop/common/hadoop-common-2.9..jar

同步服务到其他机器

# 同步 Hosts 文件

rsync -avz /etc/hosts hadoop2:/etc/

rsync -avz /etc/hosts hadoop3:/etc/ # 同步 JDK,源路径不要带斜杠

rsync -avz /opt/jdk1..0_202 hadoop2:/opt/

rsync -avz /opt/jdk1..0_202 hadoop3:/opt/ # 同步 Hadoop,源路径不要带斜杠

rsync -avz /opt/hadoop-2.9. hadoop2:/opt/

rsync -avz /opt/hadoop-2.9. hadoop3:/opt/ # 同步环境变量文件 profile,目标主机上的环境变量需要手动刷新:source /etc/profile

rsync -avz /etc/profile hadoop2:/etc/

rsync -avz /etc/profile hadoop3:/etc/

Hadoop分布式配置

配置一台机器,其他同步即可,配置文件目录:hadoop-2.9.2/etc/hadoop/

一、基本配置

core-site.xml

<configuration>

<!-- 指定HDFS中NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop1:9000</value>

</property> <!-- 指定Hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop-tmp</value>

</property>

</configuration>

hadoop-env.sh

# The java implementation to use.

export JAVA_HOME=/opt/jdk1..0_202/

二、HDFS 配置

hdfs-site.xml

<configuration>

<!-- 指定文件块副本数 -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property> <!-- 指定Hadoop辅助名称节点主机配置 -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop3:50090</value>

</property>

</configuration>

三、YARN 配置

yarn-env.sh

# some Java parameters

export JAVA_HOME=/opt/jdk1..0_202/

yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<!-- Reducer获取数据方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property> <!-- 指定YARN的ResourceManager地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop2</value>

</property>

</configuration>

四、MapReduce 配置

mapred-env.sh

# limitations under the License. export JAVA_HOME=/opt/jdk1..0_202/ # when HADOOP_JOB_HISTORYSERVER_HEAPSIZE is not defined, set it.

mapred-site.xml,将 mapred-site.xml.template 重命名为 mapred-site.xml

<configuration>

<!-- 指定MapReduce运行在Yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

五、集群节点地址配置

slaves

# 所有 DataNode 节点的主机地址

hadoop1

hadoop2

hadoop3

六、将配置文件同步到其他节点

# 将 Hadoop 配置文件同步到其他节点上

rsync -avz /opt/hadoop-2.9. hadoop2:/opt/

rsync -avz /opt/hadoop-2.9. hadoop3:/opt/

启动 Hadoop 集群

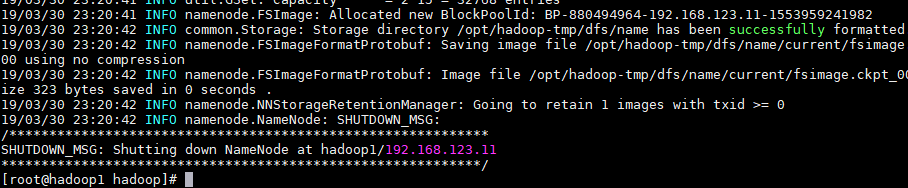

一、第一次使用需要先格式化 NameNode,这里是在 hadoop1 上执行格式化

hadoop namenode -format

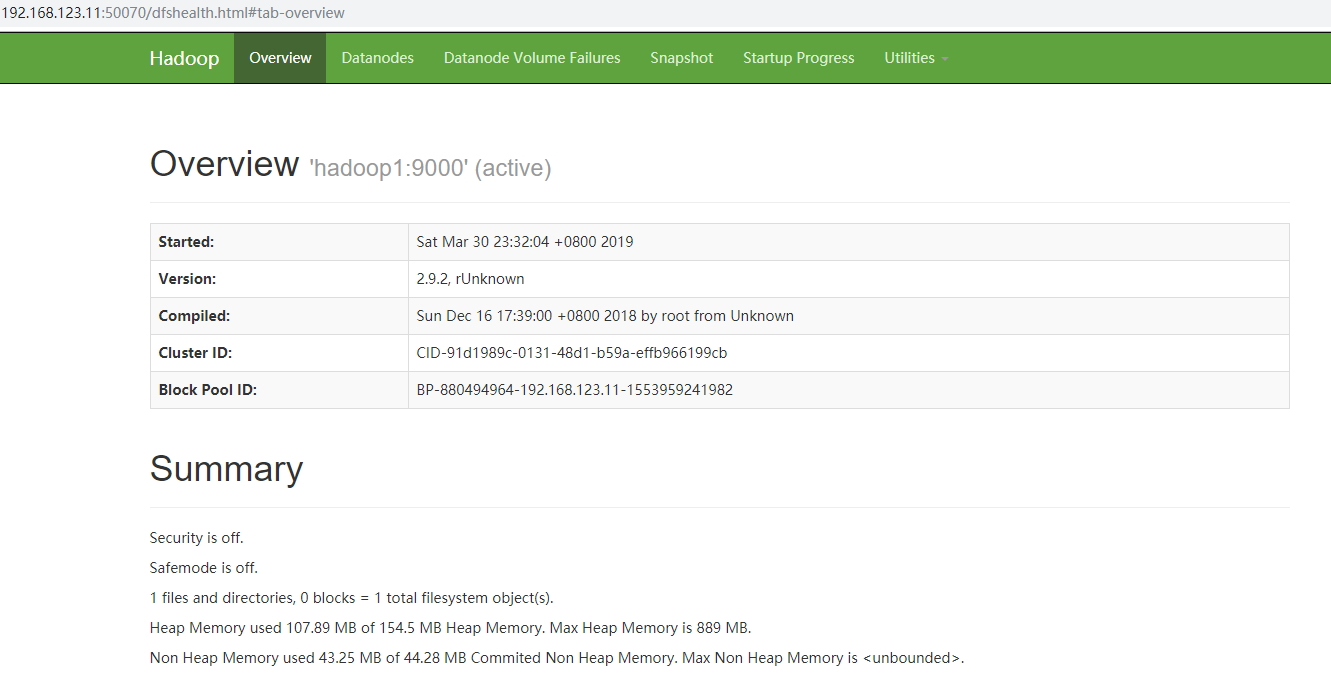

二、在 NameNode 所在节点启动 hdfs,这里是 hadoop1

start-dfs.sh

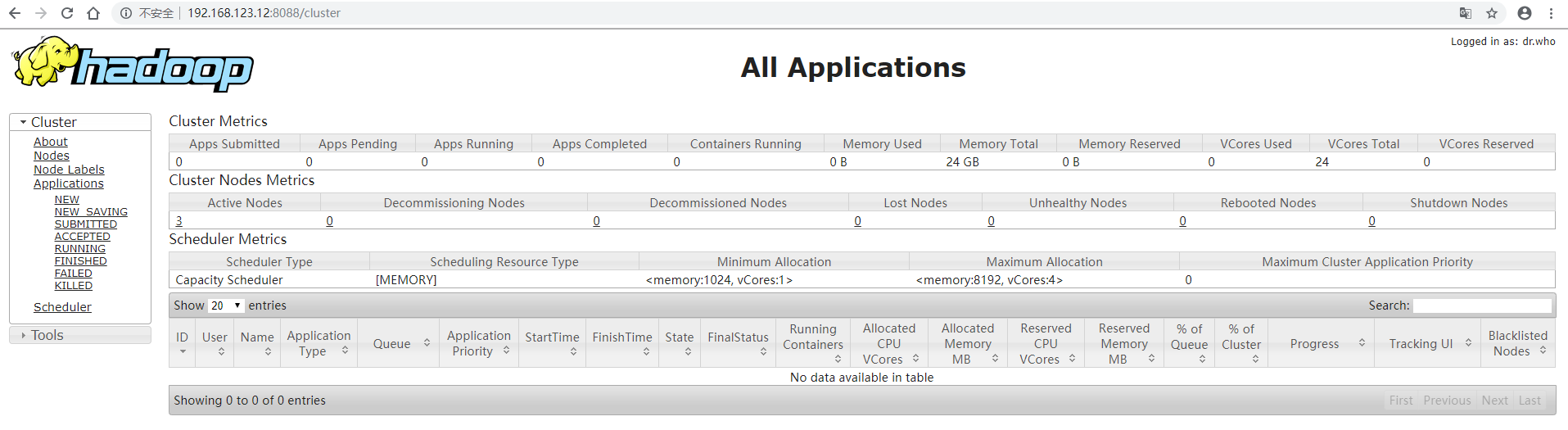

三、在 ResourceManger 所在节点启动 yarn,这里是 hadoop2

start-yarn.sh

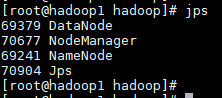

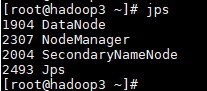

查看各个节点进程

配置时间服务

https://www.cnblogs.com/jhxxb/p/10579816.html

http://hadoop.apache.org/docs/current/hadoop-project-dist/hadoop-common/ClusterSetup.html

CentOS7 下 Hadoop 分布式部署的更多相关文章

- [过程记录]Centos7 下 Hadoop分布式集群搭建

过程如下: 配置hosts vim /etc/hosts 格式: ip hostname ip hostname 设置免密登陆 首先:每台主机使用ssh命令连接其余主机 ssh 用户名@主机名 提示是 ...

- CentOS7下Hadoop伪分布式环境搭建

CentOS7下Hadoop伪分布式环境搭建 前期准备 1.配置hostname(可选,了解) 在CentOS中,有三种定义的主机名:静态的(static),瞬态的(transient),和灵活的(p ...

- 在Centos7下安装与部署.net core

在Centos7下安装与部署.net core 2018年02月28日 19:36:16 阅读数:388 个人安装流程,参照文档 https://www.cnblogs.com/Burt/p/6566 ...

- # centos7下FFmpeg环境部署记录

# centos7下FFmpeg环境部署记录 随着视频在网站上的应用越来越多,越来越多的网站服务器需要支持视频转码,视频压缩,FFmpeg是目前最好用的网站服务器后台转码程序,应用最多.FFmpeg是 ...

- Centos7下GlusterFS 分布式文件系统环境搭建

Centos7下 GlusterFS 环境搭建准备工作glusterfs-3.6.9.tar.gzuserspace-rcu-master.zip三台服务器:192.168.133.53.192.16 ...

- CentOS7 下 Hadoop 单节点(伪分布式)部署

Hadoop 下载 (2.9.2) https://hadoop.apache.org/releases.html 准备工作 关闭防火墙 (也可放行) # 停止防火墙 systemctl stop f ...

- 【Hadoop 分布式部署 十 一: NameNode HA 自动故障转移】

问题描述: 上一篇就是NameNode 的HA 部署完成,但是存在问题,问题是如果 主NameNode的节点宕机了,还是需要人工去使用命令来切换NameNode的Acitve 这样很不方便,所以 ...

- 【Hadoop 分布式部署 六:环境问题解决和集群基准测试】

环境问题: 出现Temporary failure in name resolutionp-senior-zuoyan.com 的原因有很多,主要就是主机没有解析到, 那就在hadoop的sl ...

- 【Hadoop 分布式部署 四:配置Hadoop 2.x 中主节点(NN和RM)到从节点的SSH无密码登录】

******************* 一定要使这三台机器的用户名相同,安装目录相同 ************* SSH 无密钥登录的简单介绍(之前再搭 ...

随机推荐

- JPA save新增问题

前台传递json,有关联表的情况下 { //主键 "pId" : 0, "platformId" : 0, "poNo" : "p ...

- Codeforces Round #514 (Div. 2) C. Sequence Transformation 思维构造

题意 给出一个1-n的集合 gcd 集合里面的所有数 得到的 一个 数 然后自己选择删去一个数 要使得到的数 构成的数列 的字典序最大 思路: gcd所有数 那gcd得到的数肯定要小于数 ...

- 洛谷P1074 靶形数独(算竞进阶习题)

还是数独.. 比上一个多了个分数矩阵,其实没什么差别,但是数据好像水了许多... #include <bits/stdc++.h> #define INF 0x3f3f3f3f using ...

- 【BZOJ1013】【JSOI2008】球形空间产生器 高斯消元

题目描述 有一个\(n\)维空间中的球,告诉你球面上\(n+1\)个点的坐标,求球心的坐标. \(n\leq 10\) 题解 设\(a_{i,j}\)为第\(i\)个点的第\(j\)维坐标,\(i=0 ...

- [CF52C]Circular RMQ【线段树】

题目大意 给你一个环形数列,完成环形数列上区间加法和区间求最小值. 分析 算是一道比较水的线段树模板题. 如果l>r的话,那么修改l,n和1,r区间. 不然的话那么就修改l,r区间. 其他的基础 ...

- css文本设置

常用的应用文本的css样式: color 设置文字的颜色,如: color:red; font-size 设置文字的大小,如:font-size:12px; font-family 设置文字的字体,如 ...

- default.conf

1./etc/nginx/conf.d/ 下设置一个 default.conf,server_name 设置为 localhost,如果有其他非法域名 A 记录到该机器上,则返回默认的 Nginx 页 ...

- centos7下kafka集群安装部署

应用摘要: Apache kafka是由Apache软件基金会开发的一个开源流处理平台,由Scala和Java编写.Kafka是一种高吞吐量的 分布式发布订阅消息系统,是消息中间件的一种,用于构建实时 ...

- 杨辉三角 II

题目描述 给定一个非负索引 k,其中 k ≤ 33,返回杨辉三角的第 k 行. 在杨辉三角中,每个数是它左上方和右上方的数的和. 示例: 输入: 3 输出: [1,3,3,1] 贴出代码 class ...

- php 限制类的对象类型

事实上,采用哪种处理参数类型的策略,取决于任何潜在bug的严重程度.通常PHP会根据语境自动转换大多数基本数据类型. 因此,你需要在检测类型.转换类型和依赖良好清晰的文档(无论决定用哪一种,都应该提供 ...