【一起学源码-微服务】Nexflix Eureka 源码十二:EurekaServer集群模式源码分析

前言

前情回顾

上一讲看了Eureka 注册中心的自我保护机制,以及里面提到的bug问题。

哈哈 转眼间都2020年了,这个系列的文章从12.17 一直写到现在,也是不容易哈,每天持续不断学习,输出博客,这一段时间确实收获很多。

今天在公司给组内成员分享了Eureka源码剖析,反响效果还可以,也算是感觉收获了点东西。后面还会继续feign、ribbon、hystrix的源码学习,依然文章连载的形式输出。

本讲目录

本讲主要是EurekaServer集群模式的数据同步讲解,主要目录如下。

目录如下:

- eureka server集群机制

- 注册、下线、续约的注册表同步机制

- 注册表同步三层队列机制详解

技术亮点:

- 3层队列机制实现注册表的批量同步需求

说明

原创不易,如若转载 请标明来源!

博客地址:一枝花算不算浪漫

微信公众号:壹枝花算不算浪漫

源码分析

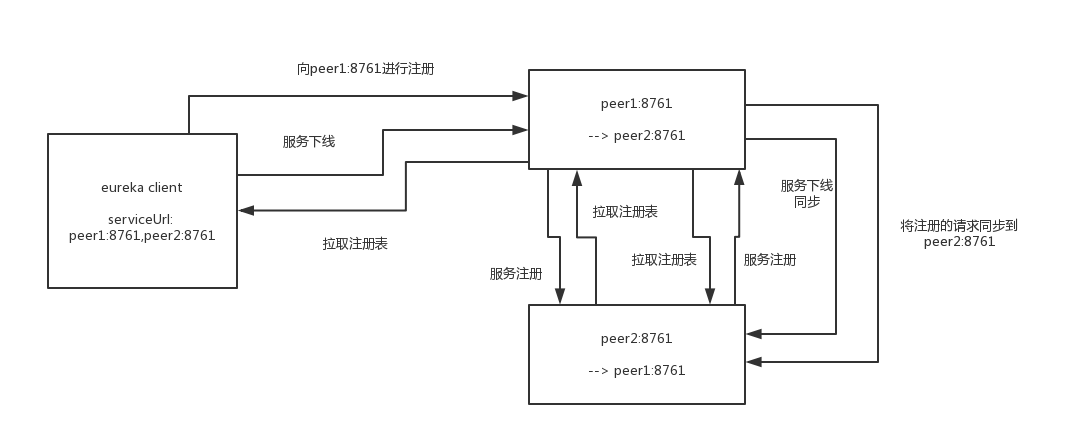

eureka server集群机制

Eureka Server会在注册、下线、续约的时候进行数据同步,将信息同步到其他Eureka Server节点。

可以想象到的是,这里肯定不会是实时同步的,往后继续看注册表的同步机制吧。

注册、下线、续约的注册表同步机制

我们以Eureka Client注册为例,看看Eureka Server是如何同步给其他节点的。

PeerAwareInstanceRegistryImpl.java :

public void register(final InstanceInfo info, final boolean isReplication) {

int leaseDuration = Lease.DEFAULT_DURATION_IN_SECS;

if (info.getLeaseInfo() != null && info.getLeaseInfo().getDurationInSecs() > 0) {

leaseDuration = info.getLeaseInfo().getDurationInSecs();

}

super.register(info, leaseDuration, isReplication);

replicateToPeers(Action.Register, info.getAppName(), info.getId(), info, null, isReplication);

}

private void replicateToPeers(Action action, String appName, String id,

InstanceInfo info /* optional */,

InstanceStatus newStatus /* optional */, boolean isReplication) {

Stopwatch tracer = action.getTimer().start();

try {

if (isReplication) {

numberOfReplicationsLastMin.increment();

}

// If it is a replication already, do not replicate again as this will create a poison replication

if (peerEurekaNodes == Collections.EMPTY_LIST || isReplication) {

return;

}

for (final PeerEurekaNode node : peerEurekaNodes.getPeerEurekaNodes()) {

// If the url represents this host, do not replicate to yourself.

if (peerEurekaNodes.isThisMyUrl(node.getServiceUrl())) {

continue;

}

replicateInstanceActionsToPeers(action, appName, id, info, newStatus, node);

}

} finally {

tracer.stop();

}

}

private void replicateInstanceActionsToPeers(Action action, String appName,

String id, InstanceInfo info, InstanceStatus newStatus,

PeerEurekaNode node) {

try {

InstanceInfo infoFromRegistry = null;

CurrentRequestVersion.set(Version.V2);

switch (action) {

case Cancel:

node.cancel(appName, id);

break;

case Heartbeat:

InstanceStatus overriddenStatus = overriddenInstanceStatusMap.get(id);

infoFromRegistry = getInstanceByAppAndId(appName, id, false);

node.heartbeat(appName, id, infoFromRegistry, overriddenStatus, false);

break;

case Register:

node.register(info);

break;

case StatusUpdate:

infoFromRegistry = getInstanceByAppAndId(appName, id, false);

node.statusUpdate(appName, id, newStatus, infoFromRegistry);

break;

case DeleteStatusOverride:

infoFromRegistry = getInstanceByAppAndId(appName, id, false);

node.deleteStatusOverride(appName, id, infoFromRegistry);

break;

}

} catch (Throwable t) {

logger.error("Cannot replicate information to {} for action {}", node.getServiceUrl(), action.name(), t);

}

}

- 注册完成后,调用

replicateToPeers(),注意这里面有一个参数isReplication,如果是true,代表是其他Eureka Server节点同步的,false则是EurekaClient注册来的。 replicateToPeers()中一段逻辑,如果isReplication为true则直接跳出,这里意思是client注册来的服务实例需要向其他节点扩散,如果不是则不需要去同步peerEurekaNodes.getPeerEurekaNodes()拿到所有的Eureka Server节点,循环遍历去同步数据,调用replicateInstanceActionsToPeers()replicateInstanceActionsToPeers()方法中根据注册、下线、续约等去处理不同逻辑

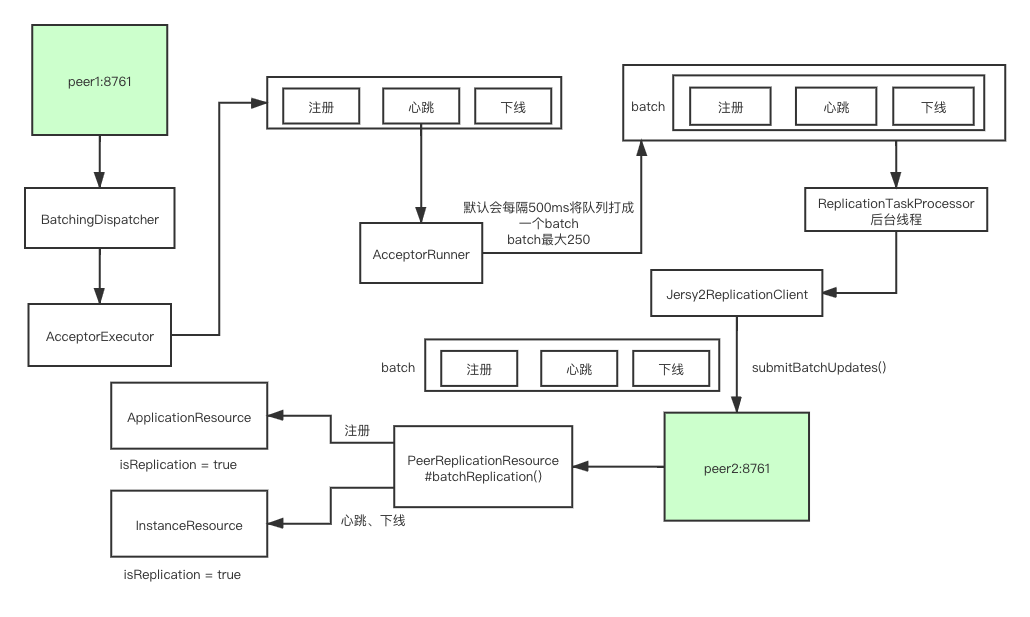

接下来就是真正执行同步逻辑的地方,这里主要用了三层队列对同步请求进行了batch操作,将请求打成一批批 然后向各个EurekaServer进行http请求。

注册表同步三层队列机制详解

到了这里就是真正进入了同步的逻辑,这里还是以上面注册逻辑为主线,接着上述代码继续往下跟:

PeerEurekaNode.java :

public void register(final InstanceInfo info) throws Exception {

long expiryTime = System.currentTimeMillis() + getLeaseRenewalOf(info);

batchingDispatcher.process(

taskId("register", info),

new InstanceReplicationTask(targetHost, Action.Register, info, null, true) {

public EurekaHttpResponse<Void> execute() {

return replicationClient.register(info);

}

},

expiryTime

);

}

这里会执行batchingDispatcher.process() 方法,我们继续点进去,然后会进入 TaskDispatchers.createBatchingTaskDispatcher() 方法,查看其中的匿名内部类中的process()方法:

void process(ID id, T task, long expiryTime) {

// 将请求都放入到acceptorQueue中

acceptorQueue.add(new TaskHolder<ID, T>(id, task, expiryTime));

acceptedTasks++;

}

将需要同步的Task数据放入到acceptorQueue队列中。

接着回到createBatchingTaskDispatcher()方法中,看下AcceptorExecutor,它的构造函数中会启动一个后台线程:

ThreadGroup threadGroup = new ThreadGroup("eurekaTaskExecutors");

this.acceptorThread = new Thread(threadGroup, new AcceptorRunner(), "TaskAcceptor-" + id);

我们继续跟AcceptorRunner.java:

class AcceptorRunner implements Runnable {

@Override

public void run() {

long scheduleTime = 0;

while (!isShutdown.get()) {

try {

// 处理acceptorQueue队列中的数据

drainInputQueues();

int totalItems = processingOrder.size();

long now = System.currentTimeMillis();

if (scheduleTime < now) {

scheduleTime = now + trafficShaper.transmissionDelay();

}

if (scheduleTime <= now) {

// 将processingOrder拆分成一个个batch,然后进行操作

assignBatchWork();

assignSingleItemWork();

}

// If no worker is requesting data or there is a delay injected by the traffic shaper,

// sleep for some time to avoid tight loop.

if (totalItems == processingOrder.size()) {

Thread.sleep(10);

}

} catch (InterruptedException ex) {

// Ignore

} catch (Throwable e) {

// Safe-guard, so we never exit this loop in an uncontrolled way.

logger.warn("Discovery AcceptorThread error", e);

}

}

}

private void drainInputQueues() throws InterruptedException {

do {

drainAcceptorQueue();

if (!isShutdown.get()) {

// If all queues are empty, block for a while on the acceptor queue

if (reprocessQueue.isEmpty() && acceptorQueue.isEmpty() && pendingTasks.isEmpty()) {

TaskHolder<ID, T> taskHolder = acceptorQueue.poll(10, TimeUnit.MILLISECONDS);

if (taskHolder != null) {

appendTaskHolder(taskHolder);

}

}

}

} while (!reprocessQueue.isEmpty() || !acceptorQueue.isEmpty() || pendingTasks.isEmpty());

}

private void drainAcceptorQueue() {

while (!acceptorQueue.isEmpty()) {

// 将acceptor队列中的数据放入到processingOrder队列中去,方便后续拆分成batch

appendTaskHolder(acceptorQueue.poll());

}

}

private void appendTaskHolder(TaskHolder<ID, T> taskHolder) {

if (isFull()) {

pendingTasks.remove(processingOrder.poll());

queueOverflows++;

}

TaskHolder<ID, T> previousTask = pendingTasks.put(taskHolder.getId(), taskHolder);

if (previousTask == null) {

processingOrder.add(taskHolder.getId());

} else {

overriddenTasks++;

}

}

}

认真跟这里面的代码,可以看到这里是将上面的acceptorQueue放入到processingOrder, 其中processingOrder也是一个队列。

在AcceptorRunner.java的run()方法中,还会调用assignBatchWork()方法,这里面就是将processingOrder打成一个个batch,接着看代码:

void assignBatchWork() {

if (hasEnoughTasksForNextBatch()) {

if (batchWorkRequests.tryAcquire(1)) {

long now = System.currentTimeMillis();

int len = Math.min(maxBatchingSize, processingOrder.size());

List<TaskHolder<ID, T>> holders = new ArrayList<>(len);

while (holders.size() < len && !processingOrder.isEmpty()) {

ID id = processingOrder.poll();

TaskHolder<ID, T> holder = pendingTasks.remove(id);

if (holder.getExpiryTime() > now) {

holders.add(holder);

} else {

expiredTasks++;

}

}

if (holders.isEmpty()) {

batchWorkRequests.release();

} else {

batchSizeMetric.record(holders.size(), TimeUnit.MILLISECONDS);

// 将批量数据放入到batchWorkQueue中

batchWorkQueue.add(holders);

}

}

}

}

private boolean hasEnoughTasksForNextBatch() {

if (processingOrder.isEmpty()) {

return false;

}

// 默认maxBufferSize为250

if (pendingTasks.size() >= maxBufferSize) {

return true;

}

TaskHolder<ID, T> nextHolder = pendingTasks.get(processingOrder.peek());

// 默认maxBatchingDelay为500ms

long delay = System.currentTimeMillis() - nextHolder.getSubmitTimestamp();

return delay >= maxBatchingDelay;

}

这里加入batch的规则是:maxBufferSize 默认为250

maxBatchingDelay 默认为500ms,打成一个个batch后就开始发送给server端。至于怎么发送 我们接着看 PeerEurekaNode.java, 我们在最开始调用register() 方法就是调用PeerEurekaNode.register(), 我们来看看它的构造方法:

PeerEurekaNode(PeerAwareInstanceRegistry registry, String targetHost, String serviceUrl,

HttpReplicationClient replicationClient, EurekaServerConfig config,

int batchSize, long maxBatchingDelayMs,

long retrySleepTimeMs, long serverUnavailableSleepTimeMs) {

this.registry = registry;

this.targetHost = targetHost;

this.replicationClient = replicationClient;

this.serviceUrl = serviceUrl;

this.config = config;

this.maxProcessingDelayMs = config.getMaxTimeForReplication();

String batcherName = getBatcherName();

ReplicationTaskProcessor taskProcessor = new ReplicationTaskProcessor(targetHost, replicationClient);

this.batchingDispatcher = TaskDispatchers.createBatchingTaskDispatcher(

batcherName,

config.getMaxElementsInPeerReplicationPool(),

batchSize,

config.getMaxThreadsForPeerReplication(),

maxBatchingDelayMs,

serverUnavailableSleepTimeMs,

retrySleepTimeMs,

taskProcessor

);

}

这里会实例化一个ReplicationTaskProcessor.java, 我们跟进去,发下它是实现TaskProcessor的,所以一定会执行此类中的process()方法,执行方法如下:

public ProcessingResult process(List<ReplicationTask> tasks) {

ReplicationList list = createReplicationListOf(tasks);

try {

EurekaHttpResponse<ReplicationListResponse> response = replicationClient.submitBatchUpdates(list);

int statusCode = response.getStatusCode();

if (!isSuccess(statusCode)) {

if (statusCode == 503) {

logger.warn("Server busy (503) HTTP status code received from the peer {}; rescheduling tasks after delay", peerId);

return ProcessingResult.Congestion;

} else {

// Unexpected error returned from the server. This should ideally never happen.

logger.error("Batch update failure with HTTP status code {}; discarding {} replication tasks", statusCode, tasks.size());

return ProcessingResult.PermanentError;

}

} else {

handleBatchResponse(tasks, response.getEntity().getResponseList());

}

} catch (Throwable e) {

if (isNetworkConnectException(e)) {

logNetworkErrorSample(null, e);

return ProcessingResult.TransientError;

} else {

logger.error("Not re-trying this exception because it does not seem to be a network exception", e);

return ProcessingResult.PermanentError;

}

}

return ProcessingResult.Success;

}

这里面是将List<ReplicationTask> tasks 通过submitBatchUpdate() 发送给server端。

server端在PeerReplicationResource.batchReplication()去处理,实际上就是循环调用ApplicationResource.addInstance() 方法,又回到了最开始注册的方法。

到此 EurekaServer同步的逻辑就结束了,这里主要是三层队列的数据结构很绕,通过一个batchList去批量同步数据的。

注意这里还有一个很重要的点,就是Client注册时调用addInstance()方法,这里到了server端PeerAwareInstanceRegistryImpl会执行同步其他EurekaServer逻辑。

而EurekaServer同步注册接口仍然会调用addInstance()方法,这里难不成就死循环调用了?当然不是,addInstance()中也有个参数:isReplication, 在最后调用server端方法的时候如下:registry.register(info, "true".equals(isReplication));

我们知道,EurekaClient在注册的时候isReplication传递为空,所以这里为false,而Server端同步的时候调用:

PeerReplicationResource:

private static Builder handleRegister(ReplicationInstance instanceInfo, ApplicationResource applicationResource) {

applicationResource.addInstance(instanceInfo.getInstanceInfo(), REPLICATION);

return new Builder().setStatusCode(Status.OK.getStatusCode());

}

这里的REPLICATION 为true

另外在AbstractJersey2EurekaHttpClient中发送register请求的时候,有个addExtraHeaders()方法,如下图:

如果是使用的Jersey2ReplicationClient发送的,那么header中的x-netflix-discovery-replication配置则为true,在后面执行注册的addInstance()方法中会接收这个参数的:

总结

仍然一图流,文中解析的内容都包含在这张图中了:

申明

本文章首发自本人博客:https://www.cnblogs.com/wang-meng 和公众号:壹枝花算不算浪漫,如若转载请标明来源!

感兴趣的小伙伴可关注个人公众号:壹枝花算不算浪漫

【一起学源码-微服务】Nexflix Eureka 源码十二:EurekaServer集群模式源码分析的更多相关文章

- 微服务管理平台nacos虚拟ip负载均衡集群模式搭建

一.Nacos简介 Nacos是用于微服务管理的平台,其核心功能是服务注册与发现.服务配置管理. Nacos作为服务注册发现组件,可以替换Spring Cloud应用中传统的服务注册于发现组件,如:E ...

- 【一起学源码-微服务】Eureka+Ribbon+Feign阶段性总结

前言 想说的话 这里已经梳理完Eureka.Ribbon.Feign三大组件的基本原理了,今天做一个总结,里面会有一个比较详细的调用关系流程图. 说明 原创不易,如若转载 请标明来源! 博客地址:一枝 ...

- Spring Boot + Spring Cloud 构建微服务系统(六):熔断监控集群(Turbine)

Spring Cloud Turbine 上一章我们集成了Hystrix Dashboard,使用Hystrix Dashboard可以看到单个应用内的服务信息,显然这是不够的,我们还需要一个工具能让 ...

- spring cloud微服务快速教程之(十二) 分布式ID解决方案(mybatis-plus篇)

0-前言 分布式系统中,分布式ID是个必须解决的问题点: 雪花算法是个好方式,不过不能直接使用,因为如果直接使用的话,需要配置每个实例workerId和datacenterId,在微服务中,实例一般动 ...

- .Net Core微服务——Consul(4):主从、集群

延续上一篇的话题继续,顺便放上一篇的传送门:点这里. 集群的必要性 consul本身就是管理集群的,现在还需要给consul搞个集群,这是为啥?因为consul单点也容易挂啊!万一管理集群的consu ...

- 【Azure微服务 Service Fabric 】如何转移Service Fabric集群中的种子节点(Seed Node)

注意:在对Service Fabric的节点做操作之前,请务必确认是否是种子节点(Seed Node)且当前节点的数量是否与SF的持久层要求的数量一致. 可靠性级别是 Service Fabric 群 ...

- 【一起学源码-微服务】Nexflix Eureka 源码十三:Eureka源码解读完结撒花篇~!

前言 想说的话 [一起学源码-微服务-Netflix Eureka]专栏到这里就已经全部结束了. 实话实说,从最开始Eureka Server和Eureka Client初始化的流程还是一脸闷逼,到现 ...

- 【一起学源码-微服务】Nexflix Eureka 源码十:服务下线及实例摘除,一个client下线到底多久才会被其他实例感知?

前言 前情回顾 上一讲我们讲了 client端向server端发送心跳检查,也是默认每30钟发送一次,server端接收后会更新注册表的一个时间戳属性,然后一次心跳(续约)也就完成了. 本讲目录 这一 ...

- 【一起学源码-微服务】Nexflix Eureka 源码五:EurekaClient启动要经历哪些艰难险阻?

前言 在源码分析三.四都有提及到EurekaClient启动的一些过程.因为EurekaServer在集群模式下 自己本身就是一个client,所以之前初始化eurekaServerContext就有 ...

随机推荐

- laravel 踩坑 env,config

正常情况: env 方法 可以获取 .env 文件的值 config 可以获取 config 文件夹下 指定配置的值 非正常情况: 当我们执行了 php artisan config:cache 之后 ...

- auto uninstaller密钥激活码破解注册机ver 8.8.58

auto uninstaller密钥破解注册机ver 8.8.58 楼主分享几个auto uninstaller密钥破解注册机,可以用于auto uninstaller 8.8.58 .因为每个版本的 ...

- Lambda plus: 云上大数据解决方案

本文会简述大数据分析场景需要解决的技术挑战,讨论目前主流大数据架构模式及其发展.最后我们将介绍如何结合云上存储.计算组件,实现更优的通用大数据架构模式,以及该模式可以涵盖的典型数据处理场景. 大数据处 ...

- 模板—Kruskal

int getf(int x){return (f[x]==x)?x:f[x]=getf(f[x]);} void hb(int x,int y){x=getf(x),y=getf(y),f[y]=x ...

- es6新增语法之`${}`

这是es6中新增的字符串方法 可以配合反单引号完成拼接字符串的功能 1.反单引号怎么打出来?将输入法调整为英文输入法,单击键盘上数字键1左边的按键. 2.用法step1: 定义需要拼接进去的字符串变量 ...

- python项目管理

Python 通常没有对应 Java 的 Ant / Maven 这样的 build tool,有一个用于打包的 setuptools / distutils 但也并不完全等价.如果是用来管理依赖包, ...

- python-字符编码数据类型转换

1 - 编码格式转换 1.1 编码格式介绍 字符集 介绍 ASCII ASCII 码使用指定的7 位或8 位二进制数组合来表示128 或256 种可能的字符 ANSI ANSI是一种字符代码,为使计算 ...

- Element-ui学习笔记3--Form表单(一)

Radio单选框 要使用 Radio 组件,只需要设置v-model绑定变量,选中意味着变量的值为相应 Radio label属性的值,label可以是String.Number或Boolean. & ...

- Python--day69--ORM聚合查询和分组查询

聚合查询和分组查询 聚合 aggregate()是QuerySet 的一个终止子句,意思是说,它返回一个包含一些键值对的字典. 键的名称是聚合值的标识符,值是计算出来的聚合值.键的名称是按照字段和聚合 ...

- python命令之m参数

在命令行中使用python时,python支持在其后面添加可选参数. python命令的可选参数有很多,例如:使用可选参数h可以查询python的帮助信息: 可选参数m 下面我们来说说python命令 ...