Gradient Descent 梯度下降法-R实现

梯度下降法:

【转载时请注明来源】:http://www.cnblogs.com/runner-ljt/

Ljt

作为一个初学者,水平有限,欢迎交流指正。

应用:求线性回归方程的系数

目标:最小化损失函数 (损失函数定义为残差的平方和)

搜索方向:负梯度方向,负梯度方向是下降最快的方向

梯度下降法的R实现

#Gradient Descent 梯度下降法

# 在直接设置固定的step时,不宜设置的过大,当步长过大时会报错:

# Error in while ((newerror > error) | (iter < maxiter)) { : missing value where TRUE/FALSE needed

#原因是step过大,会导致在迭代过程中梯度会特别的大,当超过1e+309时就会直接变成无穷Inf #梯度下降法求线性回归方程系数theta

#x为数据矩阵(mxn m:样本数 n:特征数 );y观测值(mx1);error终止条件,相邻两次搜索结果的幅度;

#step为设定的固定步长;maxiter最大迭代次数,alpha,beta为回溯下降法的参数

GradientDescent<-function(x,y,error,maxiter,stepmethod=T,step=0.001,alpha=0.25,beta=0.8)

{

m<-nrow(x)

x<-cbind(matrix(1,m,1),x)

n<-ncol(x)

theta<-matrix(rep(0,n),n,1) #theta初始值都设置为0

iter<-1

newerror<-1 while((newerror>error)|(iter<maxiter)){

iter<-iter+1

h<-x%*%theta

des<-t(t(h-y)%*%x) #梯度

#回溯下降法求步长t

if(stepmethod==T){

sstep=1

new_theta<-theta-sstep*des

new_h<-x%*%new_theta

costfunction<-t(h-y)%*%(h-y) #最小二乘损失函数

new_costfunction<-t(new_h-y)%*%(new_h-y)

#回溯下降法求步长sstep

while(new_costfunction>costfunction-alpha*sstep*sum(des*des)){

sstep<-sstep*beta

new_theta<-theta-sstep*des

new_h<-x%*%new_theta

new_costfunction<-t(new_h-y)%*%(new_h-y)

}

newerror<-t(theta-new_theta)%*%(theta-new_theta)

theta<-new_theta

} #直接设置固定步长

if(stepmethod==F){

new_theta<-theta-step*des

new_h<-x%*%new_theta

# new_costfunction<-t(new_h-y)%*%(new_h-y)

newerror<-t(theta-new_theta)%*%(theta-new_theta)

theta<-new_theta

} }

costfunction<-t(x%*%theta-y)%*%(x%*%theta-y)

result<-list(theta,iter,costfunction)

names(result)<-c('系数','迭代次数','误差')

result

}

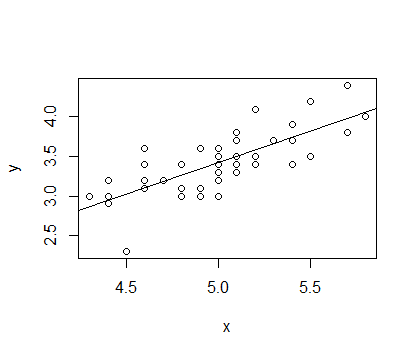

选取 IRIS 数据中种类为setosa的Sepal.Length和Sepal.Width数据分别作为x,y进行拟合,拟合函数为 y=α+βx

结果如下

> x<-matrix(iris[1:50,1],50,1)

> y<-matrix(iris[1:50,2],50,1)

> l<-lm(y~x)

> summary(l) Call:

lm(formula = y ~ x) Residuals:

Min 1Q Median 3Q Max

-0.72394 -0.18273 -0.00306 0.15738 0.51709 Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) -0.5694 0.5217 -1.091 0.281

x 0.7985 0.1040 7.681 6.71e-10 ***

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1 Residual standard error: 0.2565 on 48 degrees of freedom

Multiple R-squared: 0.5514, Adjusted R-squared: 0.542

F-statistic: 58.99 on 1 and 48 DF, p-value: 6.71e-10 >

> GradientDescent(x,y,1e-14,1000,stepmethod=T,step=0.001,alpha=0.25,beta=0.8)

$系数

[,1]

[1,] -0.5692863

[2,] 0.7984992 $迭代次数

[1] 23785 $误差

[,1]

[1,] 3.158675 >

> GradientDescent(x,y,1e-14,1000,stepmethod=F,step=0.001,alpha=0.25,beta=0.8)

$系数

[,1]

[1,] -0.5690111

[2,] 0.7984445 $迭代次数

[1] 31882 $误差

[,1]

[1,] 3.158675

Gradient Descent 梯度下降法-R实现的更多相关文章

- 深度学习课程笔记(四)Gradient Descent 梯度下降算法

深度学习课程笔记(四)Gradient Descent 梯度下降算法 2017.10.06 材料来自:http://speech.ee.ntu.edu.tw/~tlkagk/courses_MLDS1 ...

- Stochastic Gradient Descent 随机梯度下降法-R实现

随机梯度下降法 [转载时请注明来源]:http://www.cnblogs.com/runner-ljt/ Ljt 作为一个初学者,水平有限,欢迎交流指正. 批量梯度下降法在权值更新前对所有样本汇总 ...

- ML笔记:Gradient Descent

Review: Gradient Descent Tip 1: Tuning your learning rates eta恰好,可以走到局部最小值点; eta太小,走得太慢,也可以走到局部最小值点; ...

- 【笔记】机器学习 - 李宏毅 - 4 - Gradient Descent

梯度下降 Gradient Descent 梯度下降是一种迭代法(与最小二乘法不同),目标是解决最优化问题:\({\theta}^* = arg min_{\theta} L({\theta})\), ...

- 机器学习基础——梯度下降法(Gradient Descent)

机器学习基础--梯度下降法(Gradient Descent) 看了coursea的机器学习课,知道了梯度下降法.一开始只是对其做了下简单的了解.随着内容的深入,发现梯度下降法在很多算法中都用的到,除 ...

- Gradient Descent 和 Stochastic Gradient Descent(随机梯度下降法)

Gradient Descent(Batch Gradient)也就是梯度下降法是一种常用的的寻找局域最小值的方法.其主要思想就是计算当前位置的梯度,取梯度反方向并结合合适步长使其向最小值移动.通过柯 ...

- One-hot 编码/TF-IDF 值来提取特征,LAD/梯度下降法(Gradient Descent),Sigmoid

1. 多值无序类数据的特征提取: 多值无序类问题(One-hot 编码)把“耐克”编码为[0,1,0],其中“1”代表了“耐克”的中 间位置,而且是唯一标识.同理我们可以把“中国”标识为[1,0],把 ...

- [机器学习] ML重要概念:梯度(Gradient)与梯度下降法(Gradient Descent)

引言 机器学习栏目记录我在学习Machine Learning过程的一些心得笔记,涵盖线性回归.逻辑回归.Softmax回归.神经网络和SVM等等,主要学习资料来自网上的免费课程和一些经典书籍,免费课 ...

- (3)梯度下降法Gradient Descent

梯度下降法 不是一个机器学习算法 是一种基于搜索的最优化方法 作用:最小化一个损失函数 梯度上升法:最大化一个效用函数 举个栗子 直线方程:导数代表斜率 曲线方程:导数代表切线斜率 导数可以代表方向, ...

随机推荐

- Android签名与权限的安全问题(3)

签名和权限的作用 Android签名中使用到的一些加密技术有: 公/私钥, SHA1(CERT.SF,MANIFEST.MF), RSA(CERT.RSA), 消息摘要, 移动平台中的主流签名作用: ...

- 【安卓开发】用PageTransformer打造更好的动画效果

Android的ViewPager类已经变成一个相当流行的Android应用组件了.它简单直观,并且提供了极好的功能.你可以经常在设置向导,图片画廊种看到它,它还是分开应用内容的良好方式. 标准的Vi ...

- Dynamics CRM2016 Web API之Use custom FetchXML

CRM2016中新增的web api支持fetch xml了,之前使用FetchXML的场景是在后天代码中通过组织服务的retrieve multiple方法,但实际的应用效果有多大,还需要在实际的项 ...

- [django1.6]跑批任务错误(2006, 'MySQL server has gone away')

有个django的定时任务的需求,调用django的orm来对数据库进行数据处理. 在交互环境下直接启动pyhton脚本没有问题,放在定时任务中时候,总是出现 (2006, 'MySQL serve ...

- [csdn markdown]使用摘记一源代码高亮及图片上传和链接

本文主要内容是体验csdn markdown的代码块高亮显示和图片链接及上传. 图片上传 上边这是标题行,只需要使用一个#就可以表示,几个表示是几级标题 图片上传 本地图片上传控件 本地图片上传方式 ...

- 剑指offer面试题6 重建二叉树(c)

- java操作properties配置文件

Java中有个类Properties(Java.util.Properties),主要用于读取Java的配置文件,将一些可能需要变化的值存放在properties中进行配置,通常为为.properti ...

- MyBatis延迟加载及在spring中集成配置

当你要使用one to one,many to one 就会碰到N+1的问题.很明显,对象之间关联很多有A关联B,B关联C,C关联A这样的关系,如果不是采用延迟加载,很容易一下在出现成千上万对象 ...

- 04springMVC结构,mvc模式,spring-mvc流程,spring-mvc的第一个例子,三种handlerMapping,几种控制器,springmvc基于注解的开发,文件上传,拦截器,s

1. Spring-mvc介绍 1.1市面上流行的框架 Struts2(比较多) Springmvc(比较多而且属于上升的趋势) Struts1(即将被淘汰) 其他 1.2 spring-mv ...

- Java基础---Java---IO流-----BufferedReader、BufferedWriter、缓冲区、装饰设计模式及和继承的区别

IO流 IO流用来处理设备之间的数据传输 java对数据的操作是过流的方式 流按操作数据分为两种:字节流与字符流 流按流向分为:输入流,输出流. IO流常用基类 字节流的抽象基类:InputStrea ...