Kafka入门教程(二)

转自:https://blog.csdn.net/yuan_xw/article/details/79188061

Kafka集群环境安装

相关下载

JDK要求1.8版本以上。

JDK安装教程:http://blog.csdn.net/yuan_xw/article/details/49948285

Zookeeper安装教程:http://blog.csdn.net/yuan_xw/article/details/47148401

Kafka下载地址:http://mirrors.shu.edu.cn/apache/kafka/1.0.0/kafka_2.11-1.0.0.tgz

Kafka集群规划

| 主机名 | IP | 安装软件 |

|---|---|---|

| Kafka1 | 192.168.1.221 | Jdk、Zookeeper、Kafka |

| Kafka2 | 192.168.1.222 | Jdk、Zookeeper、Kafka |

| Kafka3 | 192.168.1.223 | Jdk、Zookeeper、Kafka |

配置ssh免密码登录:

产生密钥,执行命令:ssh-keygen -t rsa,按4回车,密钥文件位于\~/.ssh文件

在192.168.1.221上生产一对钥匙,将公钥拷贝到其他节点,包括自己,执行命令:

ssh-copy-id 192.168.1.221

ssh-copy-id 192.168.1.222

ssh-copy-id 192.168.1.223

在192.168.1.222上生产一对钥匙,将公钥拷贝到其他节点,包括自己,执行命令:

ssh-copy-id 192.168.1.221

ssh-copy-id 192.168.1.222

ssh-copy-id 192.168.1.223

在192.168.1.223上生产一对钥匙,将公钥拷贝到其他节点,包括自己,执行命令:

ssh-copy-id 192.168.1.221

ssh-copy-id 192.168.1.222

ssh-copy-id 192.168.1.223

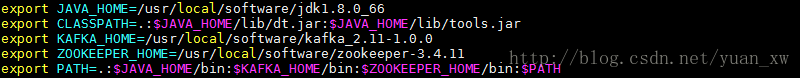

在所有的服务器上设置环境变量:

export JAVA_HOME=/usr/local/software/jdk1.8.0_66

export CLASSPATH=.:$JAVA_HOME</span>/lib/dt.<span class="hljs-symbol">jar:</span><span class="hljs-variable">$JAVA_HOME/lib/tools.jar

export KAFKA_HOME=/usr/local/software/kafka_2.11-1.0.0

export ZOOKEEPER_HOME=/usr/local/software/zookeeper-3.4.11

export PATH=.:$JAVA_HOME</span>/<span class="hljs-symbol">bin:</span><span class="hljs-variable">$KAFKA_HOME/bin:$ZOOKEEPER_HOME</span>/<span class="hljs-symbol">bin:</span><span class="hljs-variable">$PATH

刷新环境变量:source /etc/profile

关闭所有服务器上的防火墙:

systemctl stop firewalld.service

systemctl disable firewalld.service

安装Kafka

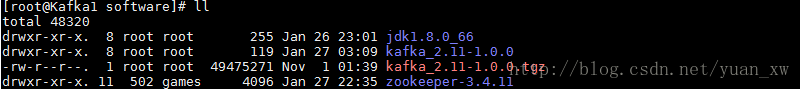

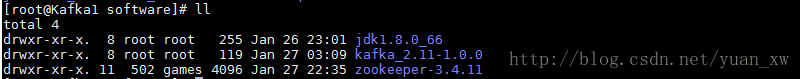

1.分别在[Kafka1、Kafka2、Kafka3]服务器下载:

tar -zxvf kafka_2.11-1.0.0.tgz

2. 修改配置文件:Kafka1服务器配置文件

broker.id=0

listeners=PLAINTEXT://:9092

log.dir= /usr/local/software/kafka_2.11-1.0.0/kafka-logs

Kafka2服务器配置文件

broker.id=1

listeners=PLAINTEXT://:9092

log.dir= /usr/local/software/kafka_2.11-1.0.0/kafka-logs

Kafka3服务器配置文件

broker.id=2

listeners=PLAINTEXT://:9092

log.dir= /usr/local/software/kafka_2.11-1.0.0/kafka-logs

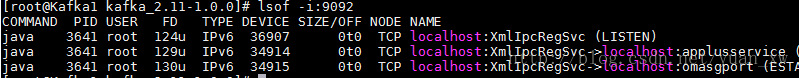

- 分别启动[Kafka1、Kafka2、Kafka3]服务器的kafka服务

启动命令:./bin/kafka-server-start.sh -daemon config/server.properties

查看启动日志:tail -100f logs/server.log

查看启动端口:lsof -i:9092

创建主题Topic

创建主题topic

执行命令:bin/kafka-topics.sh - -create - -zookeeper 192.168.1.221:2181

- -replication-factor 2 - -partitions 2 - -topic test

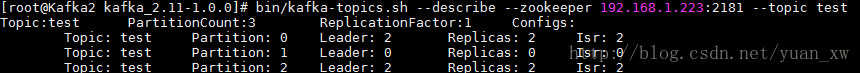

查看主题topic描述

执行命令:bin/kafka-topics.sh –list –zookeeper 192.168.1.223:2181

查看创建的所有主题执行命令:bin/kafka-topics.sh –list –zookeeper 192.168.1.223:2181

生产者生产消息

执行命令:bin/kafka-console-producer.sh –broker-list 192.168.1.221:9092 –topic test

消费者消费消息

执行命令:bin/kafka-console-consumer.sh –bootstrap-server 192.168.1.223:9092 –topic test –from-beginning

JAVA客户端

新建一个maven项目,项目名称:kafka-demo:

代码结构如下:

Maven的pom.xml文件:

<projectxmlns="http://maven.apache.org/POM/4.0.0"xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion> <groupId>com.kafka</groupId>

<artifactId>kafka-demo</artifactId>

<version>1.0-SNAPSHOT</version>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

</plugins>

</build>

<packaging>jar</packaging> <name>kafka-demo</name>

<url>http://maven.apache.org</url> <properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

</properties> <dependencies>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.12</version>

<scope>test</scope>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.kafka/kafka-clients -->

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>1.0.0</version>

</dependency>

</dependencies>

</project>

- 生产者代码实现:

package com.kafka;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord; import java.util.Properties;

/**

* 生产者代码

*/

public classDemoProducer{

public static void main( String[] args ){

Properties props = new Properties();

props.put("bootstrap.servers", "192.168.1.221:9092,192.168.1.222:9092,192.168.1.223:9092");

props.put("acks", "all");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("linger.ms", 1);

props.put("buffer.memory", 33554432);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer"); Producer<String, String> producer = new KafkaProducer<>(props);

for(int i = 0; i < 10; i++) {

producer.send(new ProducerRecord<>("test", Integer.toString(i), "message_value=====>" + i));

}

producer.close();

}

}

- 消费者代码实现:

package com.kafka;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer; import java.util.Arrays;

import java.util.Properties;

/**

* 消费者代码

*/

public classDemoConsumer {

public static void main(String[] args) {

Properties props = new Properties();

props.put("bootstrap.servers", "192.168.1.221:9092,192.168.1.222:9092,192.168.1.223:9092");

props.put("group.id", "test");

props.put("enable.auto.commit", "true");

props.put("auto.commit.interval.ms", "1000");

props.put("session.timeout.ms", "30000");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Arrays.asList("test"));

while(true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for(ConsumerRecord<String, String> record : records) {

System.out.printf("offset = %d, key = %s, value = %s\n", record.offset(), record.key(), record.value());

}

}

}

}

消息结果:

message_value=====>1

message_value=====>5

message_value=====>7

message_value=====>8

message_value=====>4

message_value=====>6

message_value=====>0

message_value=====>2

message_value=====>3

message_value=====>9

源代码下载地址:http://download.csdn.net/download/yuan_xw/10228246

学习Kafka推荐书籍:

《Kafka入门与实践》

《Kafka技术内幕 图文详解Kafka源码设计与实现》

《流式架构:Kafka与MapR Streams数据流处理》

《Scala语言基础与开发实战》

《Kafka权威指南》

《Kafka源码解析与实战》

–以上为《Kafka集群环境安装》,如有不当之处请指出,我后续逐步完善更正,大家共同提高。谢谢大家对我的关注。——厚积薄发(yuanxw)

Kafka入门教程(二)的更多相关文章

- 无废话ExtJs 入门教程二十一[继承:Extend]

无废话ExtJs 入门教程二十一[继承:Extend] extjs技术交流,欢迎加群(201926085) 在开发中,我们在使用视图组件时,经常要设置宽度,高度,标题等属性.而这些属性可以通过“继承” ...

- 无废话ExtJs 入门教程二十[数据交互:AJAX]

无废话ExtJs 入门教程二十[数据交互:AJAX] extjs技术交流,欢迎加群(521711109) 1.代码如下: 1 <!DOCTYPE html PUBLIC "-//W3C ...

- 无废话ExtJs 入门教程二[Hello World]

无废话ExtJs 入门教程二[Hello World] extjs技术交流,欢迎加群(201926085) 我们在学校里学习任何一门语言都是从"Hello World"开始,这里我 ...

- mongodb入门教程二

title: mongodb入门教程二 date: 2016-04-07 10:33:02 tags: --- 上一篇文章说了mongodb最基本的东西,这边博文就在深入一点,说一下mongo的一些高 ...

- SpringBoot入门教程(二)CentOS部署SpringBoot项目从0到1

在之前的博文<详解intellij idea搭建SpringBoot>介绍了idea搭建SpringBoot的详细过程, 并在<CentOS安装Tomcat>中介绍了Tomca ...

- PySide——Python图形化界面入门教程(二)

PySide——Python图形化界面入门教程(二) ——交互Widget和布局容器 ——Interactive Widgets and Layout Containers 翻译自:http://py ...

- Elasticsearch入门教程(二):Elasticsearch核心概念

原文:Elasticsearch入门教程(二):Elasticsearch核心概念 版权声明:本文为博主原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明. 本文链接:ht ...

- RabbitMQ入门教程(二):简介和基本概念

原文:RabbitMQ入门教程(二):简介和基本概念 版权声明:本文为博主原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明. 本文链接:https://blog.csdn ...

- JasperReports入门教程(二):中文打印

JasperReports入门教程(二):中文打印 背景 在上一篇中我们介绍了JasperReport的基本入门,也展示了一个报表.但是我们的示例都是使用的英文,如果我们把需要打印的数据改为中文会怎么 ...

随机推荐

- 第11课 OpenGL 飘动的旗帜

飘动的旗帜: 这一课从第六课的代码开始,创建一个飘动的旗帜.我相信在这课结束的时候,你可以掌握纹理映射和混合操作. 大家好!对那些想知道我在这里作了些什么的朋友,您可以先按文章的末尾所列出的链接,下载 ...

- shell 脚本控制命令的执行顺序

&&,||,(),{},& 五个符号的运用shell脚本执行命令的时候,有时候会依赖于前一个命令是否执行成功.而&&和||就是用来判断前一个命令执行效果的. 也 ...

- 初步认识express,并创建web服务器,挂载静态资源

1.Express简介 1.1什么是Express 官方给出的概念:Express 是基于 Node.js 平台,快速.开放.极简的 Web 开发框架,官方网址 相似用途:Express 的作用和 N ...

- JMeter学习笔记--录制脚本(二)

第一步:在JMeter中添加线程组,命名为访问首页 第二步:在线程组下添加HTTP请求默认值 添加->配置元件->HTTP请求默认值,设置服务器IP和端口号(JMeter默认使用80端口号 ...

- 1. 处理静态资源 2. controller如何接受请求得参数 3. 如何把controller得数据保存到view. 4. 在controller如何完成重定向到指定路径 5. controller返回json数据

1. 1. 处理静态资源2. controller如何接受请求得参数3. 如何把controller得数据保存到view.4. 在controller如何完成重定向到指定路径5. controller ...

- 关于Thread的interrupt

关于Thread的interrupt Thread的interrupt方法会引发线程中断. 主要有以下几个作用: 如Object的wait方法,Thread的sleep等等这些能够抛出Interrup ...

- c++学习笔记6(结构化程序设计)

结构化程序设计 c语言使用结构化程序设计: 程序=数据结构+算法 程序有全局变量以及众多相互调用的函数组成 算法以函数的形式实现,用于对数据结构进行操作 结构化程序设计不足

- 通过t-sql定期自动备份SQL Server 上的所有数据库

项目背景 解决方案 方案一,是采用SQL的定时备份,建立作业来操作,这里有完整的使用手册: 方案二:基于t-sql方法进行查询备份 方案思路: 1.1 在 Master 数据库上创建一个备份所有数据库 ...

- 【JavaScript定时器小案例】常见的几种定时器实现的案例

[JavaScript定时器小案例]常见的几种定时器实现的案例 博客说明 文章所涉及的资料来自互联网整理和个人总结,意在于个人学习和经验汇总,如有什么地方侵权,请联系本人删除,谢谢! 说明 在日常开发 ...

- C#练习2

using System;class Class1{ public int vlaue = 0;}class Test{ static void Main() { int v1 = 0; int v2 ...