Python 2.7 爬取51job 全国java岗位

一页有50条数据一共2000页 分页是get分页

#!/usr/bin/python

# encoding: utf-8

import requests

import threading

from lxml import etree

import sys

import os

import datetime

import re

import random

import time reload(sys) sys.setdefaultencoding('utf-8') # 定义写入日志的方法

def log(context):

txtName = "./log/log.txt"

f=file(txtName, "a+") f.writelines(context+"\n") f.close() def xin():

# 请求头

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9'

} count=1

# 一共2000页

while (count < 2000):

url="https://search.51job.com/list/000000,000000,0000,00,9,99,java,2,"+str(count)+".html?lang=c&stype=1&postchannel=0000&workyear=99&cotype=99°reefrom=99&jobterm=99&companysize=99&lonlat=0%2C0&radius=-1&ord_field=0&confirmdate=9&fromType=&dibiaoid=0&address=&line=&specialarea=00&from=&welfare=" response=requests.get(url,headers=header)

html=response.content.decode("gbk")

print(html)

selector=etree.HTML(html)

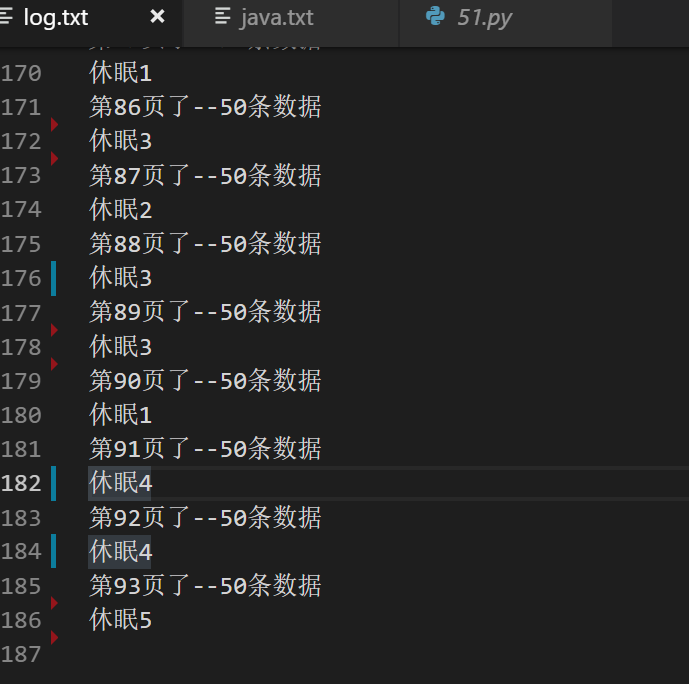

contents = selector.xpath('//div[@class="dw_table"]/div[@class="el"]') log("第"+str(count)+"页了--"+str(len(contents))+"条数据")

for eachlink in contents: company = eachlink.xpath('span[@class="t2"]/a/text()')[0]

url= eachlink.xpath('p/span/a/@href')[0]

name= eachlink.xpath('p/span/a/text()')[0]

city= eachlink.xpath('span[@class="t3"]/text()')[0] # 工资有的是没有的

key=""

if len(eachlink.xpath('span[@class="t4"]/text()'))<1:

key=""

else:

key= eachlink.xpath('span[@class="t4"]/text()')[0] # 把空格去掉

company=company.replace(' ','')

name=name.replace(' ','')

city=city.replace(' ','') zhi=name+"============="+company+"============="+city+"============="+str(key)+"============="+url txtName = "./file/java.txt"

f=file(txtName, "a+")

f.write(zhi)

f.close() sui=random.randint(1,5)

log("休眠"+str(sui))

time.sleep(sui)

count=count+1 if __name__=="__main__":

xin()

日志文件

爬去的数据

但是爬去的速度有点慢,

于是乎采用了多线程爬去,

但是51job 立刻就把IP段给封掉了,

于是用户4台服务器,每台爬取500条数据,最后再结合一起加到数据库中

人生苦短,我用Python!!!

Python 2.7 爬取51job 全国java岗位的更多相关文章

- Python的scrapy之爬取51job网站的职位

今天老师讲解了Python中的爬虫框架--scrapy,然后带领我们做了一个小爬虫--爬取51job网的职位信息,并且保存到数据库中 用的是Python3.6 pycharm编辑器 爬虫主体: im ...

- Python爬取51job实例

用Python爬取51job里面python相关职业.工作地址和薪资. 51job上的信息 程序代码 from bs4 import BeautifulSoup from urllib.request ...

- Java 爬取 51job 数据 WebMagic实现

Java 爬取 51job 数据 一.项目Maven环境配置 相关依赖 jar 包配置 <parent> <groupId>org.springframework.boot&l ...

- Python 招聘信息爬取及可视化

自学python的大四狗发现校招招python的屈指可数,全是C++.Java.PHP,但看了下社招岗位还是有的.于是为了更加确定有多少可能找到工作,就用python写了个爬虫爬取招聘信息,数据处理, ...

- [python] 常用正则表达式爬取网页信息及分析HTML标签总结【转】

[python] 常用正则表达式爬取网页信息及分析HTML标签总结 转http://blog.csdn.net/Eastmount/article/details/51082253 标签: pytho ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- Python:将爬取的网页数据写入Excel文件中

Python:将爬取的网页数据写入Excel文件中 通过网络爬虫爬取信息后,我们一般是将内容存入txt文件或者数据库中,也可以写入Excel文件中,这里介绍关于使用Excel文件保存爬取到的网页数据的 ...

- python之简单爬取一个网站信息

requests库是一个简介且简单的处理HTTP请求的第三方库 get()是获取网页最常用的方式,其基本使用方式如下 使用requests库获取HTML页面并将其转换成字符串后,需要进一步解析HTML ...

- [Python爬虫] Selenium爬取新浪微博客户端用户信息、热点话题及评论 (上)

转载自:http://blog.csdn.net/eastmount/article/details/51231852 一. 文章介绍 源码下载地址:http://download.csdn.net/ ...

随机推荐

- Cmake编译opencv下载不了ffmpeg时的解决办法

- JAVA-Unit02: Oracle字符串操作 、 Oracle数值操作 、 Oracle日期操作 、 空值操作

Unit02: Oracle字符串操作 . Oracle数值操作 . Oracle日期操作 . 空值操作 DQL数据查询语言 查询语句基本由SELECT子句由FROM子句构成. SELECT子句指定要 ...

- php 数据库类

<?php /** * 对Yii2数据封装 * @author nike@youfumama.com * @date 2017-03-08 * 抽象类不能被实例化 * eg1: select u ...

- Python基本序列-字典

Python 基本序列-字典 字典(dict)是"键-值 对"的无序可变序列,字典中的每个元素包含两部分,"键"和"值". 字典中的&quo ...

- mac 终端命令行操作

1,root 切换 sudo su 2,安装brew curl -L http://github.com/mxcl/homebrew/tarball/master | tar xz --strip 1 ...

- postman请求ajax失败的解决方法

第一步,把要提交的数据放到Body里 第二步:去掉请求头的Content-Length字段

- Hessian简要入门

原本系统之间通信采用Restful Web Service,但其中没有考虑安全性问题,因此决定使用稍微复杂点的二进制协议,Hessian服务. Hessian是一个轻量级的Remoting O ...

- 10 删除topic中的数据

1 打开 server.properties2 添加一条: delete.topic.enable=true 3 执行命令: bin/kafka-topics.sh --delete ...

- SSMS安装英文版后无法修改为中文

SSMS的UI语言和所安装的Visual Studio的语言是相关的,你这种情况应该是第一次安装的时候安装了英文版的visual studio isolated shell,在卸载的时候你没有卸载这个 ...

- react组件生命

组件的生命周期主要由三个部分组成: Mounting:组件正在被插入DOM中 Updating:如果DOM需要更新,组件正在被重新渲染 Unmounting:组件从DOM中移除 React提供了方法, ...