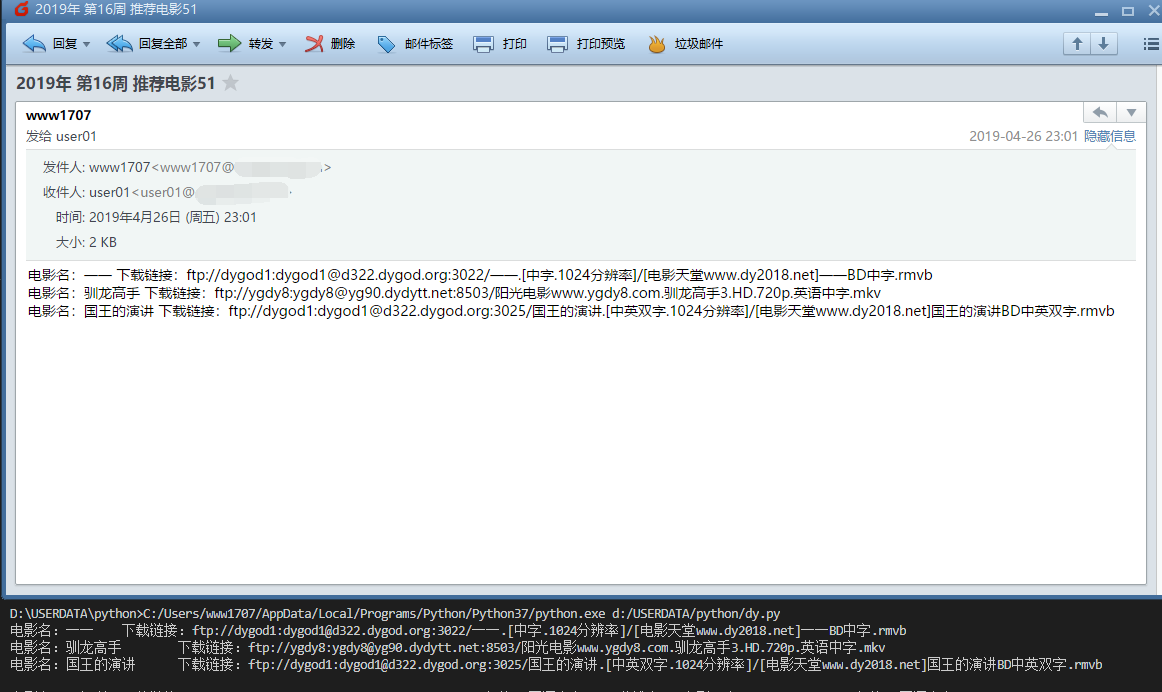

28、周末看电影(每周五自动从top250中随机选取三部电影,并将下载链接发到邮箱里)

import requests

import time

import schedule

import smtplib

import numpy

from urllib.request import quote

from bs4 import BeautifulSoup

from email.mime.text import MIMEText

from email.header import Header def fun_top250_3(): movie_names = [] for i in numpy.random.randint(0,249,3):

res = requests.get('https://movie.douban.com/top250?start={}'.format(i))

soup = BeautifulSoup(res.text,'html.parser')

item = soup.find('div',class_='item').find('span').text

movie_names.append(item) return movie_names def fun_download_url(): movie_names = fun_top250_3() movie_names_urls = '' for i in movie_names:

key_word = quote(i,encoding='gbk')

res = requests.get('http://s.ygdy8.com/plus/so.php?typeid=1&keyword={}'.format(key_word))

res.encoding='gbk'

soup = BeautifulSoup(res.text,'html.parser')

check_none = soup.find('div',class_='co_content8').find('table') if check_none:

item = soup.find('td',width='55%').find('b').find('a')

res = requests.get('https://www.ygdy8.com'+item['href'])

res.encoding='gbk'

soup = BeautifulSoup(res.text,'html.parser')

item = soup.find('td',style='WORD-WRAP: break-word').find('a').text

movie_names_urls += '电影名:{}\t下载链接:{}\n'.format(i,item)

else:

movie_names_urls += '电影名:{}\t下载链接:没有找到\n'.format(i) return movie_names_urls def fun_sendmail(): movie_names_urls = fun_download_url() mail_user = 'www1707@xxx.cn'

mail_pwd = 'yyy'

receiver = 'user01@xxx.cn'

subject = time.strftime('%Y{}%W{}%S').format('年 第','周 推荐电影')

content = movie_names_urls alimail = smtplib.SMTP()

alimail.connect('smtp.qiye.aliyun.com',25)

alimail.login(mail_user,mail_pwd) message = MIMEText(content,'plain','utf-8')

message['Subject'] = Header(subject,'utf-8')

message['From'] = Header(mail_user,'utf-8')

message['To'] = Header(receiver,'utf-8') alimail.sendmail(mail_user,receiver,message.as_string())

alimail.quit() print(movie_names_urls) #schedule.every().friday.do(fun_sendmail())

schedule.every(10).seconds.do(fun_sendmail) while True:

schedule.run_pending()

time.sleep(1)

import requests,csv,random,smtplib,schedule,time

from bs4 import BeautifulSoup

from urllib.request import quote

from email.mime.text import MIMEText

from email.header import Header def get_movielist():

csv_file=open('movieTop.csv', 'w', newline='',encoding='utf-8')

writer = csv.writer(csv_file)

for x in range(10):

url = 'https://movie.douban.com/top250?start=' + str(x*25) + '&filter='

res = requests.get(url)

bs = BeautifulSoup(res.text, 'html.parser')

bs = bs.find('ol', class_="grid_view")

for titles in bs.find_all('li'):

title = titles.find('span', class_="title").text

list1 = [title]

writer.writerow(list1)

csv_file.close() def get_randommovie():

movielist=[]

csv_file=open('movieTop.csv','r',newline='',encoding='utf-8')

reader=csv.reader(csv_file)

for row in reader:

movielist.append(row[0])

three_movies=random.sample(movielist,3)

contents=''

for movie in three_movies:

gbkmovie = movie.encode('gbk')

urlsearch = 'http://s.ygdy8.com/plus/so.php?typeid=1&keyword='+quote(gbkmovie)

res = requests.get(urlsearch)

res.encoding='gbk'

soup_movie = BeautifulSoup(res.text,'html.parser')

urlpart=soup_movie.find(class_="co_content8").find_all('table')

if urlpart:

urlpart=urlpart[0].find('a')['href']

urlmovie='https://www.ygdy8.com/'+urlpart

res1=requests.get(urlmovie)

res1.encoding='gbk'

soup_movie1=BeautifulSoup(res1.text,'html.parser')

urldownload=soup_movie1.find('div',id="Zoom").find('span').find('table').find('a')['href']

content=movie+'\n'+urldownload+'\n\n'

print(content)

contents=contents+content

else:

content='没有'+movie+'的下载链接'

print(content)

return contents def send_movielink(contents):

mailhost='smtp.qq.com'

qqmail = smtplib.SMTP()

qqmail.connect(mailhost,25)

account = '×××××××××@qq.com' # 因为是自己发给自己,所以邮箱账号、密码都可以提前设置好,当然,也可以发给别人啦

password = '×××××××××××××××' # 因为是自己发给自己,所以邮箱账号、密码都可以提前设置好,当然,也可以发给别人啦。

qqmail.login(account,password)

receiver='×××××××××@qq.com' # 因为是自己发给自己,所以邮箱账号、密码都可以提前设置好,当然,也可以发给别人啦。

message = MIMEText(contents, 'plain', 'utf-8')

subject = '电影链接'

message['Subject'] = Header(subject, 'utf-8')

try:

qqmail.sendmail(account, receiver, message.as_string())

print ('邮件发送成功')

except:

print ('邮件发送失败')

qqmail.quit() def job():

get_movielist()

contents=get_randommovie()

send_movielink(contents) schedule.every().friday.at("18:00").do(job)while True:

schedule.run_pending()

time.sleep(1)

28、周末看电影(每周五自动从top250中随机选取三部电影,并将下载链接发到邮箱里)的更多相关文章

- 人一生必看的100部电影(全球最佳电影排名榜TOP250)

人一生必看的100部电影(全球最佳电影排名榜TOP250) 人的一生能看多少部电影?假设我们每周都看一部,从10岁看到80岁将会看3640部.但是我们也不可能喜欢这全部的电影.大多数的可能,我们会根据 ...

- Huginn实现自动通过slack推送豆瓣高分电影

博客搬迁至https://blog.wangjiegulu.com RSS订阅:https://blog.wangjiegulu.com/feed.xml 原文链接:https://blog.wang ...

- 【VIP视频网站项目】VIP视频网站项目v1.0.3版本发布啦(程序一键安装+电影后台自动抓取+代码结构调整)

在线体验地址:http://vip.52tech.tech/ GIthub源码:https://github.com/xiugangzhang/vip.github.io 项目预览 主页面 登录页面 ...

- python 电影下载链接爬虫

V1.0 功能:从比较知名的几个电影下载网站爬取下载链接,并自动打印出来: 代码: # -*- coding: utf8 -*- from bs4 import BeautifulSoup impor ...

- asp自动解析网页中的图片地址,并将其保存到本地服务器

程序实现功能:自动将远程页面的文件中的图片下载到本地. 程序代码 <% '将本文保存为 save2local.asp '测试:save2local.asp?url=http://ent.sina ...

- 使用htmlparse爬虫技术爬取电影网页的全部下载链接

昨天,我们利用webcollector爬虫技术爬取了网易云音乐17万多首歌曲,而且还包括付费的在内,如果时间允许的话,可以获取更多的音乐下来,当然,也有小伙伴留言说这样会降低国人的知识产权保护意识,诚 ...

- 使用htmlparser爬虫技术爬取电影网页的全部下载链接

昨天,我们利用webcollector爬虫技术爬取了网易云音乐17万多首歌曲,而且还包括付费的在内,如果时间允许的话,可以获取更多的音乐下来,当然,也有小伙伴留言说这样会降低国人的知识产权保护意识,诚 ...

- thinkphp模型中的获取器和修改器(根据字段名自动调用模型中的方法)

thinkphp模型中的获取器和修改器(根据字段名自动调用模型中的方法) 一.总结 记得看下面 1.获取器的作用是在获取数据的字段值后自动进行处理 2.修改器的作用是可以在数据赋值的时候自动进行转换处 ...

- 学习Java必看的Java书籍(高清中文最新版附下载链接)

今年下半年,我正式系统地学习Java(之前学习C++).最近把学习Java所用到的书籍整理了一下,分享出来,希望对正在学习或准备学习Java的人有一定的帮助. 关于Java的学习路线,和IDE工具In ...

随机推荐

- Unity3D_(地形)创建基本场景

第一人称漫游场景 地形漫游系统: (自己绘制的GIF文件超过20MB放不上博客园.截取了几张图片)按键盘上的“上下左右”可以控制第一人称的漫游视角 资源包和项目源文件:传送门 自己做的项目可执行文件: ...

- nginx+uWSGI+django+virtualenv+supervisor发布web服务器流程

导论 WSGI是Web服务器网关接口.它是一个规范,描述了Web服务器如何与Web应用程序通信,以及Web应用程序如何链接在一起以处理一个请求,(接收请求,处理请求,响应请求)基于wsgi运行的框架有 ...

- WebView的基础用法

新建一个WebView项目,然后修改activity_main.xml布局文件中的代码,如下所示: <LinearLayout xmlns:android="http://schema ...

- C++入门经典-例2.1-利用实数精度进行实数比较

1:代码如下: // 2.1.cpp : 定义控制台应用程序的入口点. // #include "stdafx.h" void main() { float eps = 0.000 ...

- BuiltIn库

简介 作为一门表格语言,为了保持简单的结构,RF没有像别的高级语言那样提供类似ifelsewhile等内置关键字来实现各种逻辑功能(注1),而是提供给了用户BuiltIn库.如果用户想在测试用例中实现 ...

- OpenCV学习笔记(9)——形态学转换

不同的形态学操作,例如腐蚀,膨胀,开运算,闭运算等 形态学操作是根据图像形状进行的简单操作.一般情况下对二值化图像进行操作.需要的参数有两个,一个是原始图像,第二个被称为结构化元素或核,它是用来决定操 ...

- 阶段3 2.Spring_03.Spring的 IOC 和 DI_12 注入集合数据

再复制一份,改名3 常用的注入方式,这里选择set saveAccount方法输出所有的对象 map需要导包 配置xml 集合类型的值配置方式 在property标签里面再写标签 这里选择array. ...

- Python学习笔记:使用request库遇到的问题

一.在请求参数中包含中文时,需要进行编码,如果不进行编码会报错 报错信息: 如:请求参数为:{"username":"超级管理员"} 在使用xlrd模块进行操作 ...

- Function程序设计及应用

Function也称为函数,它是SAP中一个独物的程序模式,一般是一段单独的程序代码,可独立执行或直接被SAP其他程序所调用.Function支持远程访问模式,即提供接口供SAP程序使用(如VB,.N ...

- 源码安装zabbix4.0.1

本篇是纯粹安装zabbix4.0.1, 前提需要安装lnmp请安装 https://www.cnblogs.com/effortsing/p/9982028.html 环境准备: 一台虚拟机 192. ...