学习进度05(billbill长评爬取02)

今天下雪了,是个看《白色相簿2》的好日子。

昨天我们获取所有长评url,今天要解析这些url获取更多的信息随便,点开一个,我们需要的数据有标题,时间,内容。点赞数和评论先不弄了。

解析json的时候用的正则表达式,这次就用xpath吧。

代码:

from lxml import html

import requests

import csv # 请求头 可自己查看自己的 来更改

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 '

'Safari/537.36 Core/1.70.3741.400 QQBrowser/10.5.3863.400',

'Referer': 'https://www.bilibili.com/bangumi/media/md3516/?spm_id_from=666.25.b_7265766965775f6d6f64756c65.1'

}

# csv文件的头

a = [

'article', 'avatar', 'uname', 'str_url', 'title', 'content'

]

lists = []

lists_w = []

etree = html.etree

with open('a.csv', 'r', encoding='utf-8') as fp:

reader = csv.reader(fp)

# 把第一行消掉

next(fp)

for x in reader:

lists.append(x)

x = 0

while x < len(lists):

print(x)

print(len(lists[x]))

resp = requests.get(lists[x][3])

html = etree.HTML(resp.text)

p = html.xpath("//div[@class='article-holder']//p/text()")

title = html.xpath("//h1[@class='title']/text()")

if len(p) != 0 and len(title) != 0:

list_w = [lists[x][0], lists[x][1], lists[x][2], lists[x][3], title[0], p[0]]

lists_w.append(list_w)

else:

pass

x = x + 1

print(lists_w)

with open('b.csv', 'w', encoding='utf-8', newline='') as fp:

writer = csv.writer(fp)

# 写入表头信息

writer.writerow(a)

writer.writerows(lists_w)

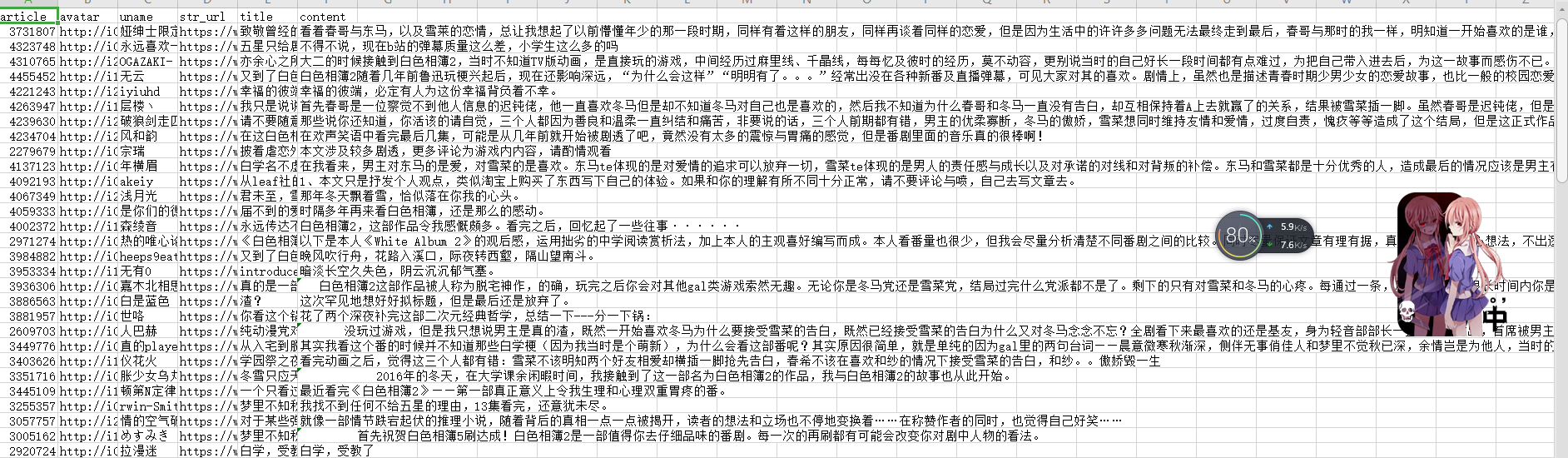

结果截图:

体会:遇到了几个问题,第一个是在谷歌的xpath helper软件里用xpth语言能够找到但是python就不行,后来我用python把整个网页下载下来,发现class属性是不一样的,然后就改了一下xpth语句就成功了,我们使用xpth语句就应对的是requests.get(url)返回的text,需要看text怎么写而不是看原网页的。第二个问题是我昨天爬的那个网页他今天没有了,因为数据就一百多条,我挨个看了一下那个长评的网页没有了,后来在代码加了限定就ok了。

学习进度05(billbill长评爬取02)的更多相关文章

- Java爬虫——网易云热评爬取

爬取目标网址 : http://music.163.com/#/song?id=409649818 需要爬取信息 : 网易云top13热评 使用之前的 HttpURLConnection 获取 ...

- 学习进度04(billbill长评数据提取01)

学习了python写入csv文件自己想了一个小实战,爬取billbill<白色相簿>番剧的长评 网页是动态变化的,往下拉他才会更新出长评,找出关键链接https://api.bilibil ...

- 2019-01-31 Python学习之BFS与DFS实现爬取邮箱

今天学习了python网络爬虫的简单知识 首先是一个爬取百度的按行读取和一次性爬取 逐行爬取 for line in urllib.request.urlopen("http://www.b ...

- python爬虫学习(三):使用re库爬取"淘宝商品",并把结果写进txt文件

第二个例子是使用requests库+re库爬取淘宝搜索商品页面的商品信息 (1)分析网页源码 打开淘宝,输入关键字“python”,然后搜索,显示如下搜索结果 从url连接中可以得到搜索商品的关键字是 ...

- 爬虫学习(四)——post请求爬取

百度翻译爬取数据 import urllib.requestimport urllib.parsepost_url = "https://fanyi.baidu.com/sug"h ...

- Python爬虫学习(5): 简单的爬取

学习了urllib,urlib2以及正则表达式之后就可以做一些简单的抓取以及处理工作.为了抓取方便,这里选择糗事百科的网页作为抓取对象. 1. 获取数据: In [293]: url = " ...

- JavaWeb学习总结-05 Servlet 与页面的交互(02)

一 模拟请求数据 为了测试方便,把请求 json,txt, xml,html格式的文件放到了公网上面,可以通过以下地址请求: http://wx.glab.cn/xpxiaowu4java/json/ ...

- 一起学爬虫——通过爬取豆瓣电影top250学习requests库的使用

学习一门技术最快的方式是做项目,在做项目的过程中对相关的技术查漏补缺. 本文通过爬取豆瓣top250电影学习python requests的使用. 1.准备工作 在pycharm中安装request库 ...

- [python爬虫] Selenium定向爬取虎扑篮球海量精美图片

前言: 作为一名从小就看篮球的球迷,会经常逛虎扑篮球及湿乎乎等论坛,在论坛里面会存在很多精美图片,包括NBA球队.CBA明星.花边新闻.球鞋美女等等,如果一张张右键另存为的话真是手都点疼了.作为程序员 ...

随机推荐

- day21-Python运维开发基础(单个字符匹配 / 多字符匹配)

1. 正则表达式(单个字符匹配) # ### 正则表达式 => 单个字符匹配 import re """ lst = re.findall(正则表达式,字符串) & ...

- js实现超范围的数相加

在js中能表示的最大安全整数是 9007199254740991,可以用API Number.MAX_SAFE_INTEGER 看一下 超出范围就会发生精度丢失,像这样 解决方法: 相当于一个字符串 ...

- 新增6 n个骰子的点数

/* * * 面试题43:n个骰子的点数 * 把n个骰子扔在地上,所有骰子朝上一面的点数之和为s. * 输入n,打印出s的所有可能的值出现的概率. * */ #include <iostream ...

- ping命令工具:同时ping多个IP

检测多个ip在同一时间点的响应状态,通过对比来判断哪个ip异常. 下载地址:https://share.weiyun.com/5XCkypG

- JS实现复制信息到剪贴板

copy 当用户通过浏览器UI启动复制操作并响应允许的document.execCommand('copy')调用时触发copy事件. copy事件可作用于任何可被选中或可编辑的元素,如body.di ...

- http请求常见的状态码

状态码是开发者需要了解的一项内容,日常开发中浏览器会返回给我们一些状态码,然后我们可以根据状态码所代表的含义进行问题解决. 1xx(临时响应) 表示临时响应并需要请求者继续执行操作的状态代码. 100 ...

- Bootstrap入门(一)准备

Bootstrap入门(一)准备 网页的样式化与布局展示是很多开发者要面对的问题,目前有多的框架和工具包,可以使网页设计的任务变得更加简单.轻松.方便.快捷一些,其中,bootstra ...

- java学习-初级入门-面向对象①-面向对象概述-结构化程序设计

为了学习面向对象程序设计,今天我们先利用面向对象以前的知识,设计一个学生类. 要求进行结构化程序设计. 学生类: Student 要求:存储学生的基本信息(姓名.性别.学历层次和年级),实现学生信息的 ...

- 《O’Reilly精品图书系列共21册》azw3

套装书目: <机器学习:实用案例解析> <利用Python进行数据分析> <社交网站的数据挖掘与分析(原书第2版)> <社会网络分析:方法与实践> &l ...

- centos 6.5安装NodeJS

centos 6.5安装NodeJS 下载 可以在本地下载node.js最新版,然后通过ftp工具上传到服务器,或者直接在服务器终端使用wget命令下载(我当时下载的是node-v7.5.0-linu ...