海伦去约会——kNN算法

下午于屋中闲居,于是翻开《机器学习实战》一书看了看“k-邻近算法”的内容,并学习了一位很厉害的博主Jack Cui的代码,自己照着码了一遍。在此感谢博主Jack Cui的知识分享。

一、k-邻近算法简介

k-邻近算法作为最简单的机器学习算法之一,其原理也浅显易懂,即:如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。

事实上,k-邻近算法并没有进行数据的训练,而是直接将未知数据与已知数据进行比较的。因此,k-邻近算法不具有显式的学习过程。

二、算法实现

2.1 算法模板

首先给出书中的基础样例代码:

『python』

# -*- coding: UTF-8 -*-

import numpy as np

import operator def createDataSet():

#一组2维特征

group = np.array([[1,101], [5,89], [108,5], [115,8]])

#对应的标签

labels = ['爱情片','爱情片','动作片','动作片']

return group, labels def classify0(inX, dataSet, labels, k):

#numpy函数shape[0]返回dataSet的行数

dataSetSize = dataSet.shape[0]

#在列方向上重复inX共1次(横向),行方向上重复inX共dataSetSize次(纵向)

diffMat = np.tile(inX, (dataSetSize, 1)) - dataSet

#二维特征相减后平方

sqDiffMat = diffMat**2

#sum()所有元素相加,sum(0)列相加,sum(1)行相加

sqDistances = sqDiffMat.sum(axis=1)

#开方,计算出平均距离

distances = sqDistances**0.5

#返回distances中元素从小到大排序后的索引值

sortedDisIndices = distances.argsort()

#记录类别次数的字典

classCount = {}

for i in range(k):

#取出前k个元素的类别

voteIlabel = labels[sortedDisIndices[i]]

#dict,get(key, default=None),字典的get()方法,返回指定键的值,如果值不在字典返回默认值

#计算类别次数

classCount[voteIlabel]=classCount.get(voteIlabel, 0) + 1

#python3中items()替换python2中的iteritems()

#key=operator.itemgetter(1)根据字典的值进行排序

#key=operator.itemgetter(0)根据字典的键进行排序

#reverse降序排序字典

sortedClassCount = sorted(classCount.items(), key=operator.itemgetter(1), reverse=True)

#返回次数最多的类别,即所要分类的类别

return sortedClassCount[0][0] if __name__== '__main__':

#创建数据集

group,labels=createDataSet()

#测试集

test = [101,20]

#kNN分类

test_class = classify0(test, group, labels, 3)

#打印分类结果

print(test_class)

运行结果:

2.2 项目实战

背景

海伦女士一直使用在线约会网站寻找适合自己的约会对象。尽管约会网站会推荐不同的人选,但她并不是喜欢每一个人。经过一番总结,她发现自己交往过的人可以进行如下分类:

- 不喜欢的人

- 魅力一般的人

- 极具魅力的人

海伦收集约会数据已经有了一段时间,她把这些数据存放在文本文件datingTestSet.txt中,每个样本数据占据一行,总共有1000行。(下载数据集)

海伦收集的样本数据主要包含以下3种特征:

- 每年获得的飞行常客里程数

- 玩视频游戏所消耗时间百分比

- 每周消费的冰淇淋公升数

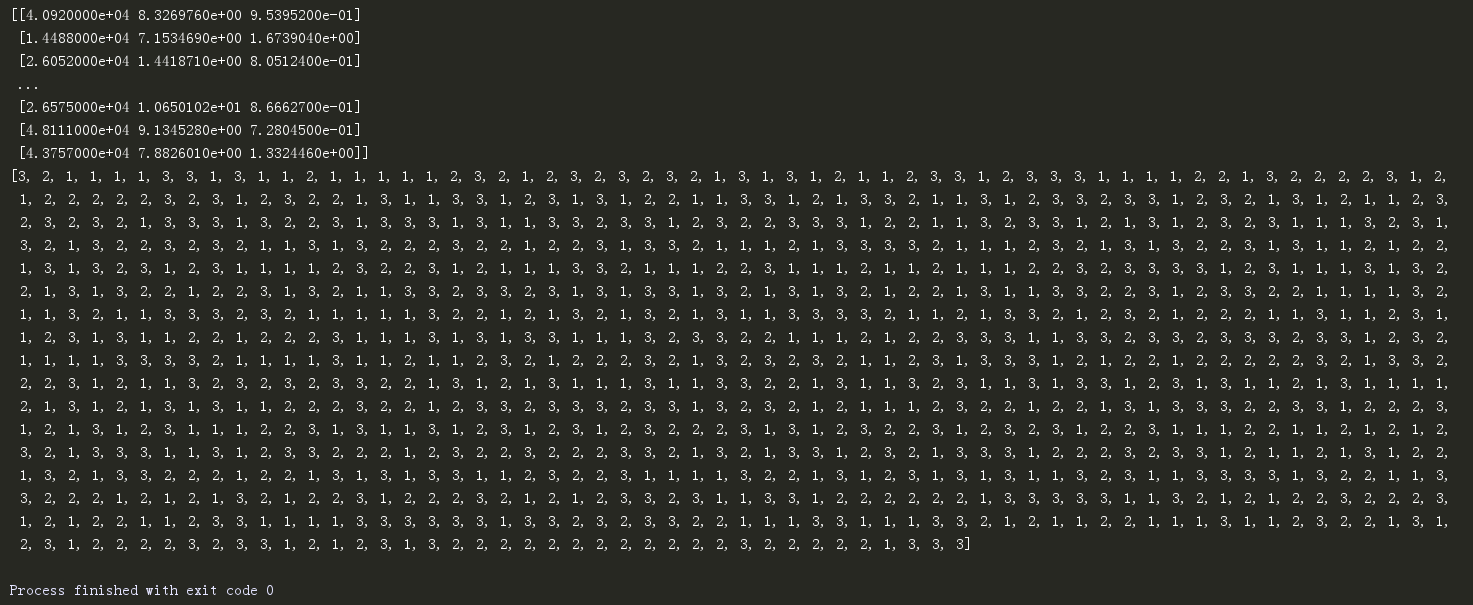

解析数据

在将上述特征数据输入到分类器前,必须将待处理的数据的格式改变为分类器可以接收的格式,即特征矩阵和对应的分类标签向量。标签被设置为:

- 1表示不喜欢的人(didntLike)

- 2表示魅力一般的人(smallDoses)

- 3表示极具魅力的人(largeDoses)

『python』

import numpy as np def file2matrix(filename):

#打开文件

fr = open(filename)

#读取文件所有内容

arrayOLines = fr.readlines()

#得到文件行数

numberOfLines = len(arrayOLines)

#返回NumPy矩阵,解析完成的数据:numberOfLines行,3列

returnMat = np.zeros((numberOfLines,3))

#返回的分类标签向量

classLabelVector = []

#行的索引值

index = 0

for line in arrayOLines:

#s.strip(rm),当rm为空时,默认删除空白符(包括'\n','\r','\t',' ')

line = line.strip()

#使用s.split(str="", num=string, cout(str))将字符根据'\t'分隔进行切片

listFormLine = line.split('\t')

#将数据的前三列提取出来,存放在returnMat的NumPy矩阵当中,也就是特征矩阵

returnMat[index,:] = listFormLine[0:3]

#根据文本中标记的喜欢的程度进行分类,1代表不喜欢,2代表魅力一般,3代表很有魅力

if listFormLine[-1] == 'didntLike':

classLabelVector.append(1)

elif listFormLine[-1] == 'smallDoses':

classLabelVector.append(2)

elif listFormLine[-1] == 'largeDoses':

classLabelVector.append(3)

index += 1

return returnMat, classLabelVector if __name__ == '__main__':

#打开文件名

filename = "datingTestSet.txt"

#打开并处理数据

datingDataMat, datingLabels = file2matrix(filename)

print(datingDataMat)

print(datingLabels)

『运行结果』

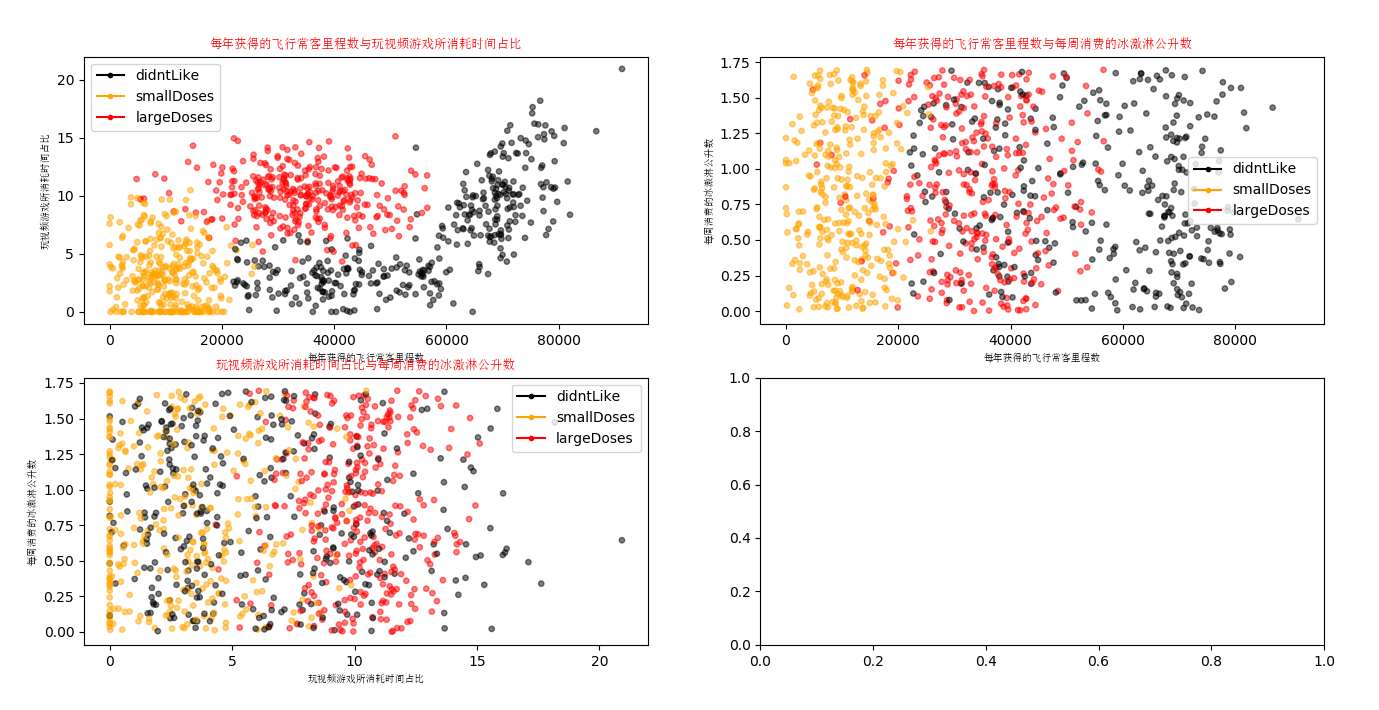

数据可视化

编写showdata函数,用于将数据可视化:

『python』

def showdata(datingDataMat, datingLabels):

# 设置汉字格式

font = FontProperties(fname=r"c:\windows\fonts\simsun.ttc", size=14)

# 将fig画布分隔成1行1列,不共享x轴和y轴,fig画布的大小为(13,8)

# 当nrow=2,nclos=2时,代表fig画布被分为四个区域,axs[0][0]表示第一行第一个区域

fig, axs = plt.subplots(nrows=2, ncols=2, sharex=False, sharey=False, figsize=(13, 8)) numberOfLabels = len(datingLabels)

LabelsColors = []

for i in datingLabels:

if i == 1:

LabelsColors.append('black')

if i == 2:

LabelsColors.append('orange')

if i == 3:

LabelsColors.append('red')

# 画出散点图,以datingDataMat矩阵的第一列(飞行常客例程)、第二列(玩游戏)数据画散点数据,散点大小为15,透明度为0.5

axs[0][0].scatter(x=datingDataMat[:, 0], y=datingDataMat[:, 1], color=LabelsColors, s=15, alpha=.5)

# 设置标题,x轴label,y轴label

axs0_title_text = axs[0][0].set_title(u'每年获得的飞行常客里程数与玩视频游戏所消耗时间占比', FontProperties=font)

axs0_xlabel_text = axs[0][0].set_xlabel(u'每年获得的飞行常客里程数', FontProperties=font)

axs0_ylabel_text = axs[0][0].set_ylabel(u'玩视频游戏所消耗时间占比', FontProperties=font)

plt.setp(axs0_title_text, size=9, weight='bold', color='red')

plt.setp(axs0_xlabel_text, size=7, weight='bold', color='black')

plt.setp(axs0_ylabel_text, size=7, weight='bold', color='black') # 画出散点图,以datingDataMat矩阵的第一(飞行常客例程)、第三列(冰激凌)数据画散点数据,散点大小为15,透明度为0.5

axs[0][1].scatter(x=datingDataMat[:, 0], y=datingDataMat[:, 2], color=LabelsColors, s=15, alpha=.5)

# 设置标题,x轴label,y轴label

axs1_title_text = axs[0][1].set_title(u'每年获得的飞行常客里程数与每周消费的冰激淋公升数', FontProperties=font)

axs1_xlabel_text = axs[0][1].set_xlabel(u'每年获得的飞行常客里程数', FontProperties=font)

axs1_ylabel_text = axs[0][1].set_ylabel(u'每周消费的冰激淋公升数', FontProperties=font)

plt.setp(axs1_title_text, size=9, weight='bold', color='red')

plt.setp(axs1_xlabel_text, size=7, weight='bold', color='black')

plt.setp(axs1_ylabel_text, size=7, weight='bold', color='black') # 画出散点图,以datingDataMat矩阵的第二(玩游戏)、第三列(冰激凌)数据画散点数据,散点大小为15,透明度为0.5

axs[1][0].scatter(x=datingDataMat[:, 1], y=datingDataMat[:, 2], color=LabelsColors, s=15, alpha=.5)

# 设置标题,x轴label,y轴label

axs2_title_text = axs[1][0].set_title(u'玩视频游戏所消耗时间占比与每周消费的冰激淋公升数', FontProperties=font)

axs2_xlabel_text = axs[1][0].set_xlabel(u'玩视频游戏所消耗时间占比', FontProperties=font)

axs2_ylabel_text = axs[1][0].set_ylabel(u'每周消费的冰激淋公升数', FontProperties=font)

plt.setp(axs2_title_text, size=9, weight='bold', color='red')

plt.setp(axs2_xlabel_text, size=7, weight='bold', color='black')

plt.setp(axs2_ylabel_text, size=7, weight='bold', color='black')

# 设置图例

didntLike = mlines.Line2D([], [], color='black', marker='.',

markersize=6, label='didntLike')

smallDoses = mlines.Line2D([], [], color='orange', marker='.',

markersize=6, label='smallDoses')

largeDoses = mlines.Line2D([], [], color='red', marker='.',

markersize=6, label='largeDoses')

# 添加图例

axs[0][0].legend(handles=[didntLike, smallDoses, largeDoses])

axs[0][1].legend(handles=[didntLike, smallDoses, largeDoses])

axs[1][0].legend(handles=[didntLike, smallDoses, largeDoses])

# 显示图片

plt.show()

『运行结果』

通过将数据可视化,可以得到一些比较直观的信息。比如:每年的飞行常客里程数表明海伦喜欢爱旅游、懂得生活的男性,但也不能疲于奔波、忙于公务出差而无暇顾家。又比如:玩视频游戏时间占比表明海伦喜欢会打游戏的男性(可能因为会打游戏的男性往往比较聪明,或者海伦自己就喜欢游戏,期待男友带一带自己,等等),但如果花费太多时间沉迷于游戏则也会让海伦感到厌烦。

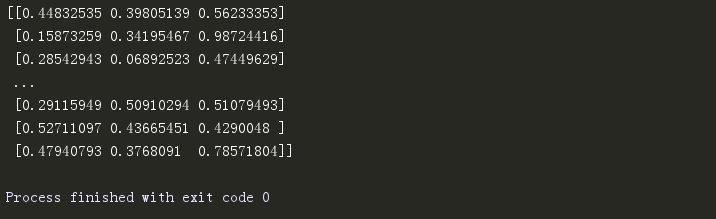

数据归一化

可以采用欧式距离来计算样本间的距离。但这会带来一个问题,即数字差值大的样本属性对结果的影响最大;如果认为这三项属性应当是同等重要的,就要对数据进行归一化,e.g.采用公式newValue = (oldValue - min)/(max - min)将取值范围限定在0到1之间。基于此,编写autoNorm函数将数据归一化:

『python』

def autoNorm(dataSet):

#获得数据的最小值

minVals = dataSet.min(0)

maxVals = dataSet.max(0)

#最大值和最小值的范围

ranges = maxVals - minVals

#shape(dataSet)返回dataSet的矩阵行列数

normDataSet = np.zeros(np.shape(dataSet))

#返回dataSet的行数

m = dataSet.shape[0]

#原始值减去最小值

normDataSet = dataSet - np.tile(minVals, (m, 1))

#除以最大和最小值的差,得到归一化数据

normDataSet = normDataSet / np.tile(ranges, (m, 1))

#返回归一化数据结果,数据范围,最小值

return normDataSet, ranges, minVals

『运行结果』

将数据归一化得到结果如下:

测试算法

分类器的结果并不是百分之百正确的,而其性能也会收到如分类器设置、测试数据集等诸多因素的影响。为测试分类器的效果,我们使用已知标签的数据,检测分类器是否能给出正确结果。通过大量的数据测试,最终估测出分类器的错误率。

为评估算法的正确率,通常只提供已有数据的90%作为训练样本来训练分类器,而使用其余的10%数据去测试分类器,检测分类器的正确率。下面编写datingClassTest函数来测试算法的正确率。

『python』

def datingClassTest():

#打开的文件名

filename = "datingTestSet.txt"

#将返回的特征矩阵和分类向量分别存储到datingDataMat和datingLabels中

datingDataMat, datingLabels = file2matrix(filename)

#取所有数据的百分之十

hoRatio = 0.10

#数据归一化,返回归一化后的矩阵,数据范围,数据最小值

normMat, ranges, minVals = autoNorm(datingDataMat)

#获得normMat的行数

m = normMat.shape[0]

#百分之十的测试数据的个数

numTestVecs = int(m * hoRatio)

#分类错误计数

errorCount = 0.0 for i in range(numTestVecs):

#前numTestVecs个数据作为测试集,后m-numTestVecs个数据作为训练集

classifierResult = classify0(normMat[i,:], normMat[numTestVecs:m,:],

datingLabels[numTestVecs:m], 4)

print("分类结果:%s\t真实类别:%d" % (classifierResult, datingLabels[i]))

if classifierResult != datingLabels[i]:

errorCount += 1.0

print("错误率:%f%%" % (errorCount / float(numTestVecs) * 100))

其中,classify0函数定义如下:

『python』

def classify0(inX, dataSet, labels, k):

#numpy函数shape[0]返回dataSet的行数

dataSetSize = dataSet.shape[0]

#在列向量方向上重复inX共1次(横向),行向量方向上重复inX共dataSetSize次(纵向)

diffMat = np.tile(inX, (dataSetSize, 1)) - dataSet

#二维特征相减后平方

sqDiffMat = diffMat**2

#sum()所有元素相加,sum(0)列相加,sum(1)行相加

sqDistances = sqDiffMat.sum(axis=1)

#开方,计算出距离

distances = sqDistances**0.5

#返回distances中元素从小到大排序后的索引值

sortedDistIndices = distances.argsort()

#定一个记录类别次数的字典

classCount = {}

for i in range(k):

#取出前k个元素的类别

voteIlabel = labels[sortedDistIndices[i]]

#dict.get(key,default=None),字典的get()方法,返回指定键的值,如果值不在字典中返回默认值。

#计算类别次数

classCount[voteIlabel] = classCount.get(voteIlabel,0) + 1

#python3中用items()替换python2中的iteritems()

#key=operator.itemgetter(1)根据字典的值进行排序

#key=operator.itemgetter(0)根据字典的键进行排序

#reverse降序排序字典

sortedClassCount = sorted(classCount.items(),key=operator.itemgetter(1),reverse=True)

print(sortedClassCount)

#返回次数最多的类别,即所要分类的类别

return sortedClassCount[0][0]

『测试结果』

应用算法

编写函数classifyPerson函数,输入相关属性,利用kNN预测海伦是否喜欢这位男性。

『python』

def classifyPerson():

#输出结果

resultList = ['讨厌','有些喜欢','非常喜欢']

#三维特征用户输入

precentTats = float(input("玩视频游戏所耗时间百分比:"))

ffMiles = float(input("每年获得的飞行常客里程数:"))

iceCream = float(input("每周消费的冰激淋公升数:"))

#打开的文件名

filename = "datingTestSet.txt"

#打开并处理数据

datingDataMat, datingLabels = file2matrix(filename)

#训练集归一化

normMat, ranges, minVals = autoNorm(datingDataMat)

#生成NumPy数组,测试集

inArr = np.array([ffMiles, precentTats, iceCream])

#测试集归一化

norminArr = (inArr - minVals) / ranges

#返回分类结果

classifierResult = classify0(norminArr, normMat, datingLabels, 3)

#打印结果

print("你可能%s这个人" % (resultList[classifierResult-1]))

『运行结果』

参考:

1.[M]Peter Harrington.机器学习实战.人民邮电出版社

2.https://cuijiahua.com/blog/2017/11/ml_1_knn.html

海伦去约会——kNN算法的更多相关文章

- k-近邻(KNN)算法改进约会网站的配对效果[Python]

使用Python实现k-近邻算法的一般流程为: 1.收集数据:提供文本文件 2.准备数据:使用Python解析文本文件,预处理 3.分析数据:可视化处理 4.训练算法:此步骤不适用与k——近邻算法 5 ...

- 吴裕雄--天生自然python机器学习实战:K-NN算法约会网站好友喜好预测以及手写数字预测分类实验

实验设备与软件环境 硬件环境:内存ddr3 4G及以上的x86架构主机一部 系统环境:windows 软件环境:Anaconda2(64位),python3.5,jupyter 内核版本:window ...

- KNN算法项目实战——改进约会网站的配对效果

KNN项目实战——改进约会网站的配对效果 1.项目背景: 海伦女士一直使用在线约会网站寻找适合自己的约会对象.尽管约会网站会推荐不同的人选,但她并不是喜欢每一个人.经过一番总结,她发现自己交往过的人可 ...

- 《机器学习实战》kNN算法及约会网站代码详解

使用kNN算法进行分类的原理是:从训练集中选出离待分类点最近的kkk个点,在这kkk个点中所占比重最大的分类即为该点所在的分类.通常kkk不超过202020 kNN算法步骤: 计算数据集中的点与待分类 ...

- 机器学习——KNN算法(k近邻算法)

一 KNN算法 1. KNN算法简介 KNN(K-Nearest Neighbor)工作原理:存在一个样本数据集合,也称为训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每一数据与所属分 ...

- 机器学习之KNN算法

1 KNN算法 1.1 KNN算法简介 KNN(K-Nearest Neighbor)工作原理:存在一个样本数据集合,也称为训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每一数据与所属 ...

- 【机器学习算法基础+实战系列】KNN算法

k 近邻法(K-nearest neighbor)是一种基本的分类方法 基本思路: 给定一个训练数据集,对于新的输入实例,在训练数据集中找到与该实例最邻近的k个实例,这k个实例多数属于某个类别,就把输 ...

- 机器学习经典算法具体解释及Python实现--K近邻(KNN)算法

(一)KNN依旧是一种监督学习算法 KNN(K Nearest Neighbors,K近邻 )算法是机器学习全部算法中理论最简单.最好理解的.KNN是一种基于实例的学习,通过计算新数据与训练数据特征值 ...

- 什么是 kNN 算法?

学习 machine learning 的最低要求是什么? 我发觉要求可以很低,甚至初中程度已经可以. 首先要学习一点 Python 编程,譬如这两本小孩子用的书:[1][2]便可. 数学方面 ...

随机推荐

- 嵌入式C语言编译器

GCC与gcc: 初识编译器: 扩展问题: 如何理解“多语言混合开发”? 参考: 狄泰软件学院唐佐林视频教程

- java数字转IP 一行

System.out.println(InetAddress.getByName(String.valueOf(12345)).getHostAddress());

- VS2008安装“Visual Studio Web 创作组件”安装失败的解决方法

VS2008安装“Visual Studio Web 创作组件”安装失败的解决方法 今天在单位电脑安装VS2008,当安装到“Visual Studio Web 创作组件”时出现错误. 准备手动安装 ...

- linux服务器ssh免密登录

环境:两台服务器,Park01.Park02,配置ssh免密登录 在Park01执行:ssh-keygen 然后一直回车 生成节点的公钥和私钥,生成的文件会自动放在/root/.ssh目录下 然后 ...

- webpack前端开发环境搭建

要搭建webpack开发环境,首先要安装NodeJS,后面的过程均在NodeJS已经安装的基础上进行. 1. 首先建立一个工程目录,命名为,其目录结构如下: 其中dist目录用于存放生成的文件,src ...

- C语言权威指南和书单 - 专家级别

注: 点击标题即可下载 1. Advanced Programming in the UNIX Environment, 3rd Edition 2. Essential C 3. Computer ...

- snprintf笔记

在weibo上看到Laruence大神修复了一个使用snprintf的bug (http://t.cn/Rm6AuFh) 引起了TK教主的关注.TK教主着重提到了在windows下snprintf与_ ...

- Python函数基础--def及return语句地操作

1·def是可执行的代码 Python的函数是有一个新的语句编写的,即def.不像C这样的编译语言,def 实际上是一个可执行的语句--函数并不存在,直到Python运行了def后才存在.在典型的操作 ...

- 一个mysqldump的报错

1.MySQL版本 5.7.14-log 2.问题分析 mysqldump -uxxx -pxxx db_nale 一般来讲上述命令主要是用于MySQL的逻辑备份,用来备份某个数据的全部表,但是我在执 ...

- java第三章笔记

java的基本程序设计结构: 1. 声明一个变量之后,必须用赋值语句对变量进行显示初始化,千万不能使用未被初始化的变量. 2.在java中不区分变量的声明与定义. 3.当参与/运算的两个操作数都是整数 ...