ES 终于可以搜到”悟空哥“了!

Elasticsearch 搜索引擎内置了很多种分词器,但是对中文分词不友好,所以我们需要借助第三方中文分词工具包。

悟空哥专门研究了下 ik 中文分词工具包该怎么玩,希望对大家有所帮助。

本文主要内容如下:

1 ES 中的分词的原理

1.1 ES 的分词器概念

ES 的一个分词器 ( tokenizer ) 接收一个字符流,将其分割为独立的词元 ( tokens ) ,然后输出词元流。

ES 提供了很多内置的分词器,可以用来构建自定义分词器 ( custom ananlyzers )

1.2 标准分词器原理

比如 stadard tokenizer 标准分词器,遇到空格进行分词。该分词器还负责记录各个词条 ( term ) 的顺序或 position 位置 ( 用于 phrase 短语和 word proximity 词近邻查询 ) 。每个单词的字符偏移量 ( 用于高亮显示搜索的内容 ) 。

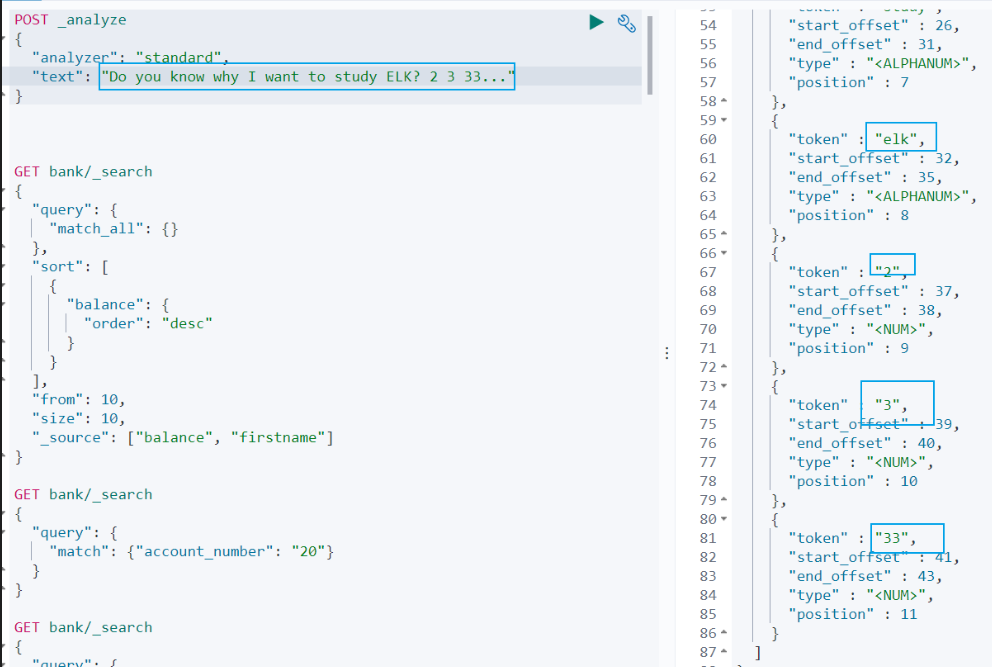

1.3 英文和标点符号分词示例

查询示例如下:

POST _analyze

{

"analyzer": "standard",

"text": "Do you know why I want to study ELK? 2 3 33..."

}

查询结果:

do, you, know, why, i, want, to, study, elk, 2,3,33

从查询结果可以看到:

(1)标点符号没有分词。

(2)数字会进行分词。

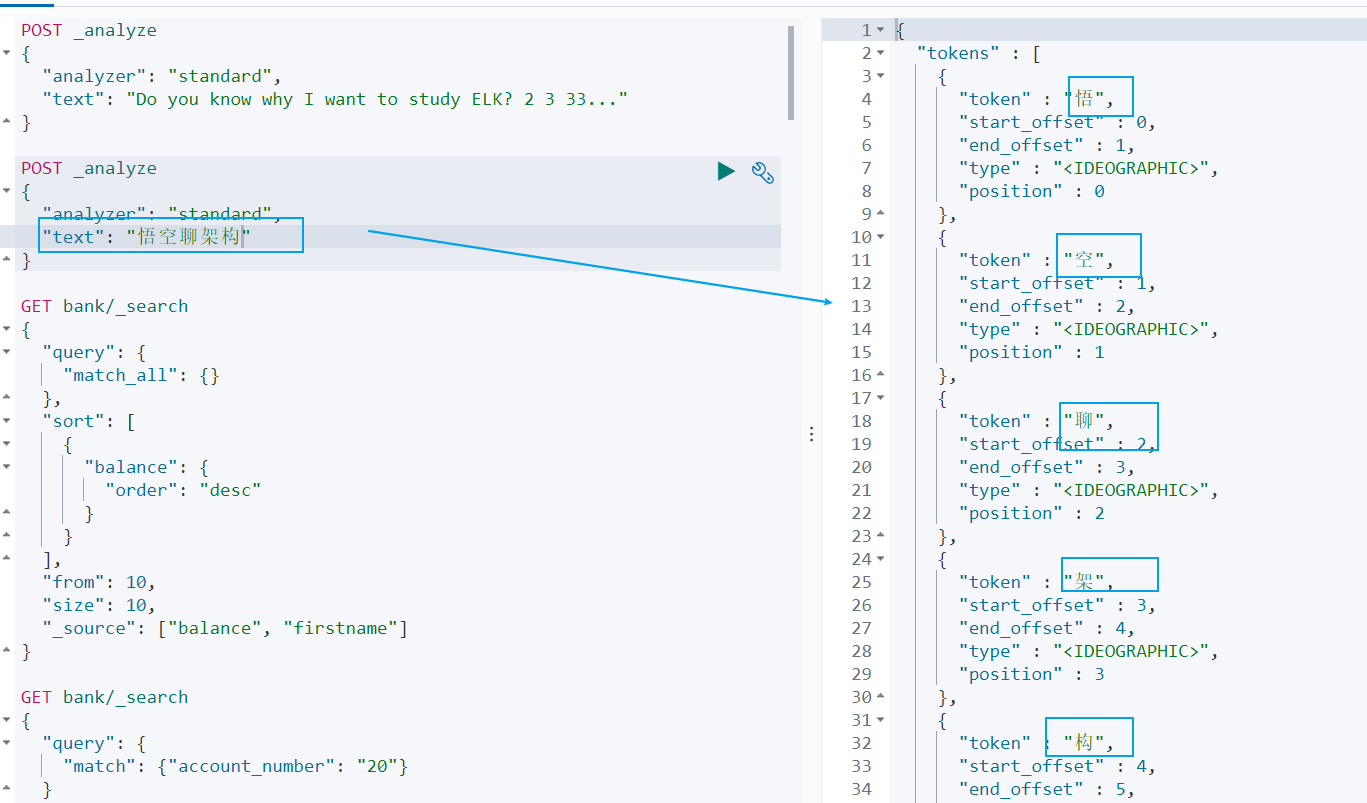

1.4 中文分词示例

但是这种分词器对中文的分词支持不友好,会将词语分词为单独的汉字。比如下面的示例会将 悟空聊架构 分词为 悟,空,聊,架,构,期望分词为 悟空,聊,架构。

POST _analyze

{

"analyzer": "standard",

"text": "悟空聊架构"

}

我们可以安装 ik 分词器来更加友好的支持中文分词。

2 安装 ik 分词器

2.1 ik 分词器地址

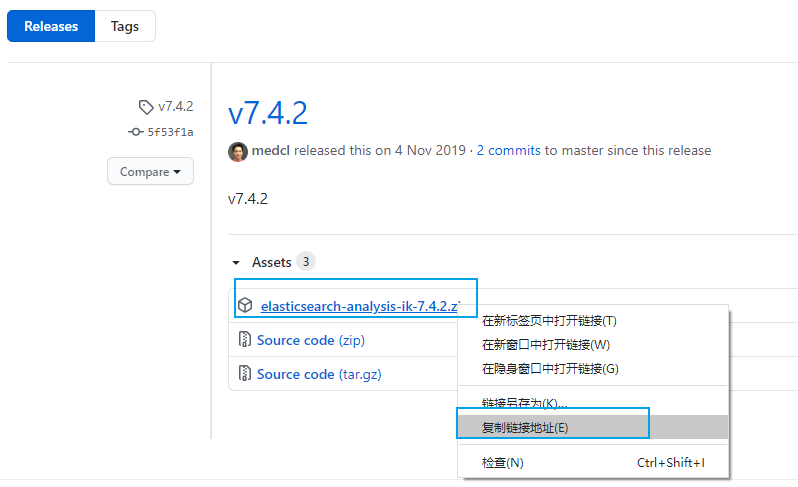

ik 分词器地址:

https://github.com/medcl/elasticsearch-analysis-ik/releases

先检查 ES 版本,我安装的版本是 7.4.2,所以我们安装 ik 分词器的版本也选择 7.4.2

http://192.168.56.10:9200/

{

"name" : "8448ec5f3312",

"cluster_name" : "elasticsearch",

"cluster_uuid" : "xC72O3nKSjWavYZ-EPt9Gw",

"version" : {

"number" : "7.4.2",

"build_flavor" : "default",

"build_type" : "docker",

"build_hash" : "2f90bbf7b93631e52bafb59b3b049cb44ec25e96",

"build_date" : "2019-10-28T20:40:44.881551Z",

"build_snapshot" : false,

"lucene_version" : "8.2.0",

"minimum_wire_compatibility_version" : "6.8.0",

"minimum_index_compatibility_version" : "6.0.0-beta1"

},

"tagline" : "You Know, for Search"

}

2.2 安装 ik 分词器的方式

2.2.1 方式一:容器内安装 ik 分词器

- 进入 es 容器内部 plugins 目录

docker exec -it <容器 id> /bin/bash

- 获取 ik 分词器压缩包

wget https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.4.2/elasticsearch-analysis-ik-7.4.2.zip

- 解压缩 ik 压缩包

unzip 压缩包

- 删除下载的压缩包

rm -rf *.zip

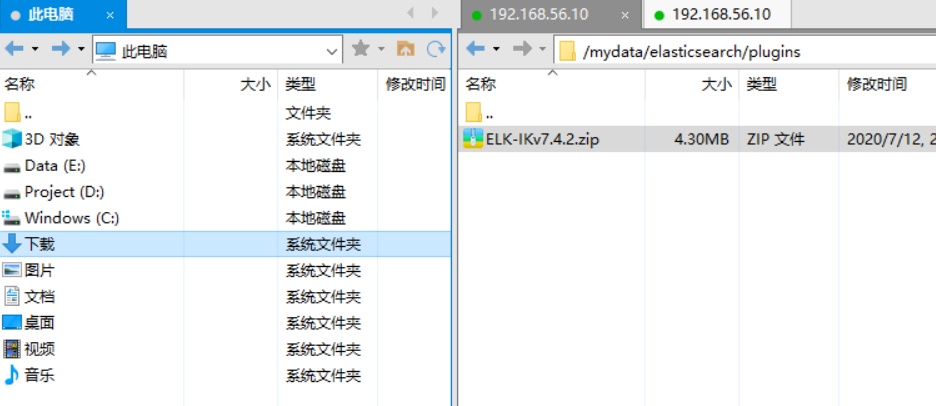

2.2.2 方式二:映射文件安装 ik 分词器

进入到映射文件夹

cd /mydata/elasticsearch/plugins

下载安装包

wget https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.4.2/elasticsearch-analysis-ik-7.4.2.zip

- 解压缩 ik 压缩包

unzip 压缩包

- 删除下载的压缩包

rm -rf *.zip

2.2.3 方式三:Xftp 上传压缩包到映射目录

先用 XShell 工具连接虚拟机 ( 操作步骤可以参考之前写的文章 02. 快速搭建 Linux 环境-运维必备) ,然后用 Xftp 将下载好的安装包复制到虚拟机。

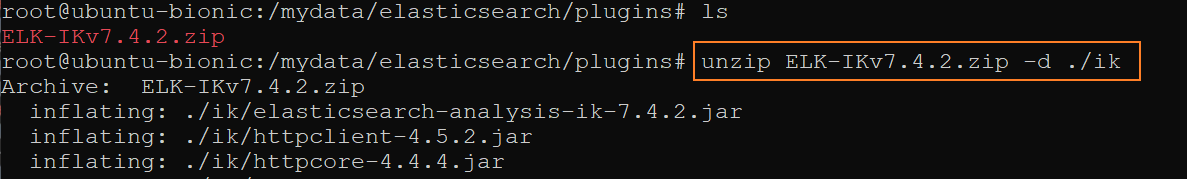

3 解压 ik 分词器到容器中

- 如果没有安装 unzip 解压工具,则安装 unzip 解压工具。

apt install unzip

- 解压 ik 分词器到当前目录的 ik 文件夹下。

命令格式:unzip <ik 分词器压缩包>

实例:

unzip ELK-IKv7.4.2.zip -d ./ik

- 修改文件夹权限为可读可写。

chmod -R 777 ik/

- 删除 ik 分词器压缩包

rm ELK-IKv7.4.2.zip

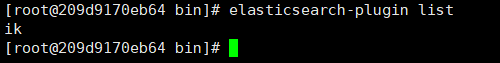

4 检查 ik 分词器安装

- 进入到容器中

docker exec -it <容器 id> /bin/bash

- 查看 Elasticsearch 的插件

elasticsearch-plugin list

结果如下,说明 ik 分词器安装好了。是不是很简单。

ik

然后退出 Elasticsearch 容器,并重启 Elasticsearch 容器

exit

docker restart elasticsearch

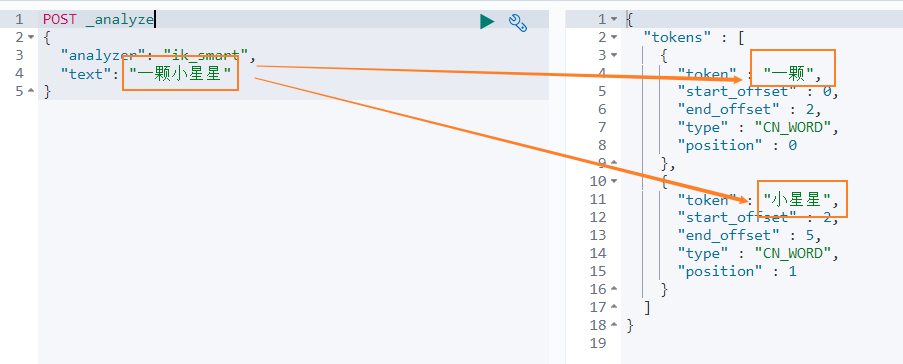

5 使用 ik 中文分词器

ik 分词器有两种模式

智能分词模式 ( ik_smart )

最大组合分词模式 ( ik_max_word )

我们先看下 智能分词 模式的效果。比如对于 一颗小星星 进行中文分词,得到的两个词语:一颗、小星星

我们在 Dev Tools Console 输入如下查询

POST _analyze

{

"analyzer": "ik_smart",

"text": "一颗小星星"

}

得到如下结果,被分词为 一颗和小星星。

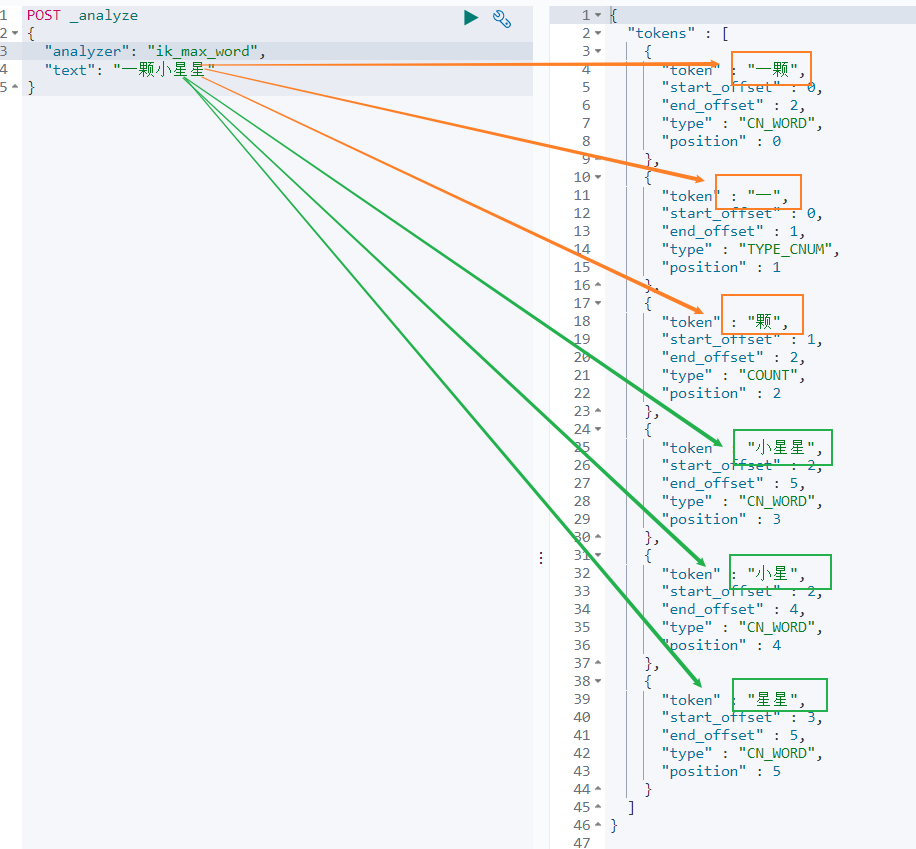

再来看下 最大组合分词模式。输入如下查询语句。

POST _analyze

{

"analyzer": "ik_max_word",

"text": "一颗小星星"

}

一颗小星星 被分成了 6 个词语:一颗、一、颗、小星星、小星、星星。

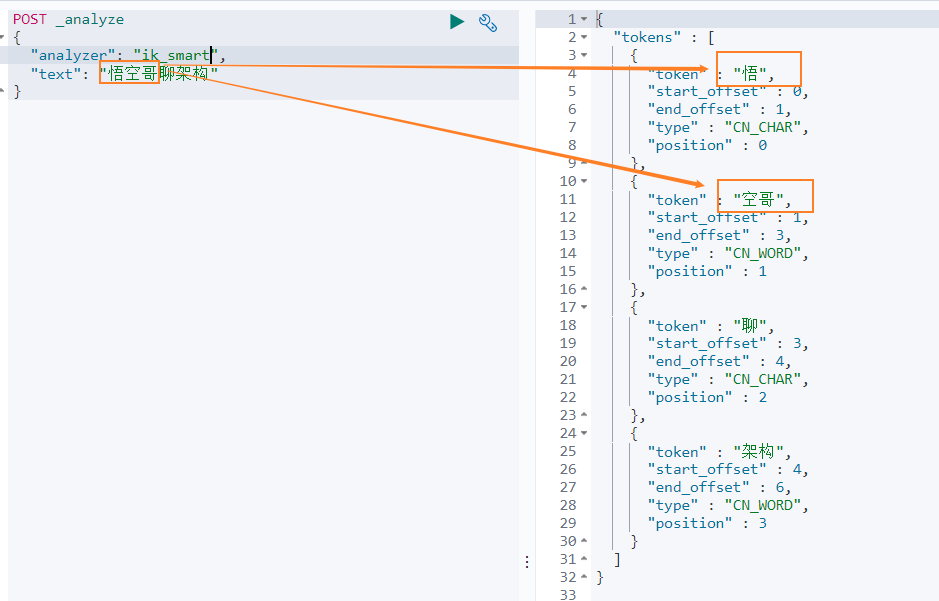

我们再来看下另外一个中文分词。比如搜索悟空哥聊架构,期望结果:悟空哥、聊、架构三个词语。

实际结果:悟、空哥、聊、架构四个词语。ik 分词器将悟空哥分词了,认为 空哥 是一个词语。所以需要让 ik 分词器知道 悟空哥 是一个词语,不需要拆分。那怎么办做呢?

6 自定义分词词库

6.1 自定义词库的方案

方案

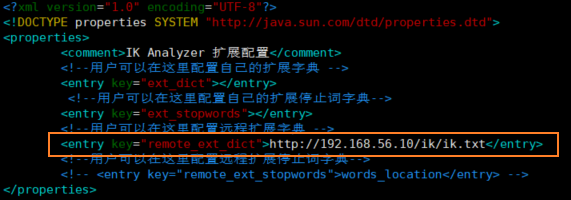

新建一个词库文件,然后在 ik 分词器的配置文件中指定分词词库文件的路径。可以指定本地路径,也可以指定远程服务器文件路径。这里我们使用远程服务器文件的方案,因为这种方案可以支持热更新 ( 更新服务器文件,ik 分词词库也会重新加载 ) 。

修改配置文件

ik 分词器的配置文件在容器中的路径:

/usr/share/elasticsearch/plugins/ik/config/IKAnalyzer.cfg.xml。

修改这个文件可以通过修改映射文件,文件路径:

/mydata/elasticsearch/plugins/ik/config/IKAnalyzer.cfg.xml

编辑配置文件:

vim /mydata/elasticsearch/plugins/ik/config/IKAnalyzer.cfg.xml

配置文件内容如下所示:

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties>

<comment>IK Analyzer 扩展配置</comment>

<!--用户可以在这里配置自己的扩展字典 -->

<entry key="ext_dict">custom/mydict.dic;custom/single_word_low_freq.dic</entry>

<!--用户可以在这里配置自己的扩展停止词字典-->

<entry key="ext_stopwords">custom/ext_stopword.dic</entry>

<!--用户可以在这里配置远程扩展字典 -->

<entry key="remote_ext_dict">location</entry>

<!--用户可以在这里配置远程扩展停止词字典-->

<entry key="remote_ext_stopwords">http://xxx.com/xxx.dic</entry>

</properties>

修改配置 remote_ext_dict 的属性值,指定一个 远程网站文件的路径,比如 http://www.xxx.com/ikwords.text。

这里我们可以自己搭建一套 nginx 环境,然后把 ikwords.text 放到 nginx 根目录。

6.2 搭建 nginx 环境

方案:首先获取 nginx 镜像,然后启动一个 nginx 容器,然后将 nginx 的配置文件拷贝到根目录,再删除原 nginx 容器,再用映射文件夹的方式来重新启动 nginx 容器。

- 通过 docker 容器安装 nginx 环境。

docker run -p 80:80 --name nginx -d nginx:1.10

- 拷贝 nginx 容器的配置文件到 mydata 目录的 conf 文件夹

cd /mydata

docker container cp nginx:/etc/nginx ./conf

- mydata 目录 里面创建 nginx 目录

mkdir nginx

- 移动 conf 文件夹到 nginx 映射文件夹

mv conf nginx/

- 终止并删除原 nginx 容器

docker stop nginx

docker rm <容器 id>

- 启动新的容器

docker run -p 80:80 --name nginx \

-v /mydata/nginx/html:/usr/share/nginx/html \

-v /mydata/nginx/logs:/var/log/nginx \

-v /mydata/nginx/conf:/etc/nginx \

-d nginx:1.10

- 访问 nginx 服务

192.168.56.10

报 403 Forbidden, nginx/1.10.3 则表示 nginx 服务正常启动。403 异常的原因是 nginx 服务下没有文件。

- nginx 目录新建一个 html 文件

cd /mydata/nginx/html

vim index.html

hello passjava

再次访问 nginx 服务

浏览器打印 hello passjava。说明访问 nginx 服务的页面没有问题。

创建 ik 分词词库文件

cd /mydata/nginx/html

mkdir ik

cd ik

vim ik.txt

填写 悟空哥,并保存文件。

- 访问词库文件

http://192.168.56.10/ik/ik.txt

浏览器会输出一串乱码,可以先忽略乱码问题。说明词库文件可以访问到。

- 修改 ik 分词器配置

cd /mydata/elasticsearch/plugins/ik/config

vim IKAnalyzer.cfg.xml

- 重启 elasticsearch 容器并设置每次重启机器后都启动 elasticsearch 容器。

docker restart elasticsearch

docker update elasticsearch --restart=always

- 再次查询分词结果

可以看到 悟空哥聊架构 被拆分为 悟空哥、聊、架构 三个词语,说明自定义词库中的 悟空哥 有作用。

写了两本 PDF,回复 分布式 或 PDF 下载。

我的 JVM 专栏已上架,回复 JVM 领取。

个人网站:www.passjava.cn

ES 终于可以搜到”悟空哥“了!的更多相关文章

- 1W字|40 图|硬核 ES 实战

前言 上篇我们讲到了 Elasticsearch 全文检索的原理<别只会搜日志了,求你懂点检索原理吧>,通过在本地搭建一套 ES 服务,以多个案例来分析了 ES 的原理以及基础使用.这次我 ...

- Android 把电话保存到现有联系人 已有联系人

搜索了很长时间,想找个把电话保存到现有联系人的代码,就是打开选中的联系人编辑界面,然后自动添加电话,再手动保存,就跟手机上的一样,功夫不负有心人,终于给搜到了,很不容易啊,现分享如下, // 保存至现 ...

- hhvm的正确安装姿势 http://dl.hhvm.com 镜像

hhvm是php的第三方运行环境,由facebook出品,基于该运行环境,它还提供了一种编程语言hack - PHP的静态类型版. 折腾了一天后,包括各种编译.配置.FQ,后面终于忍不住搜了一下 ht ...

- 【Python】给图片添加水印的Python及Golang实现

前言 不知道大家有没有这样的习惯,一篇比较得意的博客在发表一段时间之后会特别关注,前段时间一篇写到凌晨的博客被 码迷 这个网关爬取之后发表了,因为搜索引擎先爬取码迷的,所以我的博客无法被搜索到,即使直 ...

- Win7上从硬盘安装Debian

近期一直想将笔记本搞成Win7+Debian双系统.由于无论怎样优化,2G内存的Win7笔记本上开个Linux虚拟机都实在吃力. 经过一段时间的资料搜索.并阅读Debian官方的安装文档,今天最终实现 ...

- CentOS7下安装Mysql失败经历--CentOS7使用yum安装和卸载Mysql过程

起因 自己租用的BandwagonVPS上安装了个CentOS7,然后开始安装各种软件,结果yum安装MySQL发现MySQL在yum源中的Mysql不对劲,于是自己百度搜索安装方法. 终于我搜到了这 ...

- 5000字 | 24张图带你彻底理解Java中的21种锁

本篇主要内容如下: 本篇文章已收纳到我的Java在线文档. Github 我的SpringCloud实战项目持续更新中 帮你总结好的锁: 序号 锁名称 应用 1 乐观锁 CAS 2 悲观锁 synch ...

- 干货 | 45张图庖丁解牛18种Queue,你知道几种?

在讲<21张图讲解集合的线程不安全>那一篇,我留了一个彩蛋,就是Queue(队列)还没有讲,这次我们重点来看看Java中的Queue家族,总共涉及到18种Queue.这篇恐怕是市面上最全最 ...

- 秒懂JVM的三大参数类型,就靠这十个小实验了

秒懂JVM的三大参数类型,就靠这十个小实验了 你好,我是悟空哥,「7年项目开发经验,全栈工程师,开发组长,超喜欢图解编程底层原理」.手写了2个小程序,Java刷题小程序,PMP刷题小程序,已发布到公众 ...

随机推荐

- npm 安装 electron 失败的解决方案

npm 安装 electron 失败的解决方案 shit GFW npm 安装 electron 失败 解决方案 https://www.npmjs.com/package/nrm $ nrm ls ...

- Python Quiz & Python Exercise

Python Quiz & Python Exercise https://www.w3schools.com/quiztest/quiztest.asp?qtest=PYTHON https ...

- nasm astrstr函数 x86

xxx.asm: %define p1 ebp+8 %define p2 ebp+12 %define p3 ebp+16 section .text global dllmain export as ...

- vue SSR & asyncData & nuxt.js

vue SSR & asyncData & nuxt.js https://zh.nuxtjs.org/api/ https://www.cnblogs.com/xgqfrms/p/1 ...

- 比特币等主流货币走势成谜,VAST深受关注

谁也不会想到,2021年的第一个月份,数字货币市场就会如此精彩.先是以比特币为首的主流货币迎来了一波上涨,让很多生态建设者看到了暴富的机会.再是一波大跌,让很多建设者失去了希望.再到后来触底反弹和冲高 ...

- ASP.NET Core中如何对不同类型的用户进行区别限流

老板提出了一个新需求,从某某天起,免费用户每天只能查询100次,收费用户100W次. 这是一个限流问题,聪明的你也一定想到了如何去做:记录用户每一天的查询次数,然后根据当前用户的类型使用不同的数字做比 ...

- alpakka-kafka(2)-consumer

alpakka-kafka-consumer的功能描述很简单:向kafka订阅某些topic然后把读到的消息传给akka-streams做业务处理.在kafka-consumer的实现细节上,为了达到 ...

- TERSUS无代码开发(笔记03)-常用快捷键

常用快捷键 1.a 普通行为元件调用 2.b 判断输入的值是什么值 3.c 有条件的传值处理 4.e 输出元件 5.f 传值或流程 6.t 输入元件 7.p 调用元件查询 8.x 判断是否有输入值 图 ...

- Fastdfs数据迁移方案

1. 方案背景描述 环境迁移,需要迁移旧环境的fastdfs集群的数据到新环境,由于之前数据迁移仅仅是针对mysql和mongodb,对fastdfs数据的迁移了解甚少,本文档主要是针对fas ...

- 使用pycallgraph分析python代码函数调用流程以及框架

技术背景 在上一篇博客中,我们介绍了使用量子计算模拟器ProjectQ去生成一个随机数,也介绍了随机数的应用场景等.但是有些时候我们希望可以打开这里面实现的原理,去看看在产生随机数的过程中经历了哪些运 ...