Python爬虫实战四之抓取淘宝MM照片

其实还有好多,大家可以看 Python爬虫学习系列教程

福利啊福利,本次为大家带来的项目是抓取淘宝MM照片并保存起来,大家有没有很激动呢?

本篇目标

1.抓取淘宝MM的姓名,头像,年龄

2.抓取每一个MM的资料简介以及写真图片

3.把每一个MM的写真图片按照文件夹保存到本地

4.熟悉文件保存的过程

1.URL的格式

在这里我们用到的URL是 http://mm.taobao.com/json/request_top_list.htm?page=1,问号前面是基地址,后面的参数page是代表第几页,可以随意更换地址。点击开之后,会发现有一些淘宝MM的简介,并附有超链接链接到个人详情页面。

我们需要抓取本页面的头像地址,MM姓名,MM年龄,MM居住地,以及MM的个人详情页面地址。

2.抓取简要信息

相信大家经过上几次的实战,对抓取和提取页面的地址已经非常熟悉了,这里没有什么难度了,我们首先抓取本页面的MM详情页面地址,姓名,年龄等等的信息打印出来,直接贴代码如下

__author__ = 'CQC'

# -*- coding:utf-8 -*-

import urllib

import urllib2

import re

class Spider:

def __init__(self):

self.siteURL = 'http://mm.taobao.com/json/request_top_list.htm'

def getPage(self,pageIndex):

url = self.siteURL + "?page=" + str(pageIndex)

print url

request = urllib2.Request(url)

response = urllib2.urlopen(request)

return response.read().decode('gbk')

def getContents(self,pageIndex):

page = self.getPage(pageIndex)

pattern = re.compile('<div class="list-item".*?pic-word.*?<a href="(.*?)".*?<img src="(.*?)".*?<a class="lady-name.*?>(.*?)</a>.*?<strong>(.*?)</strong>.*?<span>(.*?)</span>',re.S)

items = re.findall(pattern,page)

for item in items:

print item[0],item[1],item[2],item[3],item[4]

spider = Spider()

spider.getContents(1)

运行结果如下

&lt;img src="https://pic1.zhimg.com/4db65bbf293dc5a01dbd4fc5f91f97f4_b.jpg" data-rawwidth="1055" data-rawheight="312" class="origin_image zh-lightbox-thumb" width="1055" data-original="https://pic1.zhimg.com/4db65bbf293dc5a01dbd4fc5f91f97f4_r.jpg"&gt; 2.文件写入简介 2.文件写入简介

2.文件写入简介

在这里,我们有写入图片和写入文本两种方式

1)写入图片

#传入图片地址,文件名,保存单张图片

def saveImg(self,imageURL,fileName):

u = urllib.urlopen(imageURL)

data = u.read()

f = open(fileName, 'wb')

f.write(data)

f.close()

2)写入文本

def saveBrief(self,content,name):

fileName = name + "/" + name + ".txt"

f = open(fileName,"w+")

print u"正在偷偷保存她的个人信息为",fileName

f.write(content.encode('utf-8'))

3)创建新目录

#创建新目录

def mkdir(self,path):

path = path.strip()

# 判断路径是否存在

# 存在 True

# 不存在 False

isExists=os.path.exists(path)

# 判断结果

if not isExists:

# 如果不存在则创建目录

# 创建目录操作函数

os.makedirs(path)

return True

else:

# 如果目录存在则不创建,并提示目录已存在

return False

3.代码完善

主要的知识点已经在前面都涉及到了,如果大家前面的章节都已经看了,完成这个爬虫不在话下,具体的详情在此不再赘述,直接帖代码啦。

spider.py

__author__ = 'CQC'

# -*- coding:utf-8 -*-

import urllib

import urllib2

import re

import tool

import os

#抓取MM

class Spider:

#页面初始化

def __init__(self):

self.siteURL = 'http://mm.taobao.com/json/request_top_list.htm'

self.tool = tool.Tool()

#获取索引页面的内容

def getPage(self,pageIndex):

url = self.siteURL + "?page=" + str(pageIndex)

request = urllib2.Request(url)

response = urllib2.urlopen(request)

return response.read().decode('gbk')

#获取索引界面所有MM的信息,list格式

def getContents(self,pageIndex):

page = self.getPage(pageIndex)

pattern = re.compile('<div class="list-item".*?pic-word.*?<a href="(.*?)".*?<img src="(.*?)".*?<a class="lady-name.*?>(.*?)</a>.*?<strong>(.*?)</strong>.*?<span>(.*?)</span>',re.S)

items = re.findall(pattern,page)

contents = []

for item in items:

contents.append([item[0],item[1],item[2],item[3],item[4]])

return contents

#获取MM个人详情页面

def getDetailPage(self,infoURL):

response = urllib2.urlopen(infoURL)

return response.read().decode('gbk')

#获取个人文字简介

def getBrief(self,page):

pattern = re.compile('<div class="mm-aixiu-content".*?>(.*?)<!--',re.S)

result = re.search(pattern,page)

return self.tool.replace(result.group(1))

#获取页面所有图片

def getAllImg(self,page):

pattern = re.compile('<div class="mm-aixiu-content".*?>(.*?)<!--',re.S)

#个人信息页面所有代码

content = re.search(pattern,page)

#从代码中提取图片

patternImg = re.compile('<img.*?src="(.*?)"',re.S)

images = re.findall(patternImg,content.group(1))

return images

#保存多张写真图片

def saveImgs(self,images,name):

number = 1

print u"发现",name,u"共有",len(images),u"张照片"

for imageURL in images:

splitPath = imageURL.split('.')

fTail = splitPath.pop()

if len(fTail) > 3:

fTail = "jpg"

fileName = name + "/" + str(number) + "." + fTail

self.saveImg(imageURL,fileName)

number += 1

# 保存头像

def saveIcon(self,iconURL,name):

splitPath = iconURL.split('.')

fTail = splitPath.pop()

fileName = name + "/icon." + fTail

self.saveImg(iconURL,fileName)

#保存个人简介

def saveBrief(self,content,name):

fileName = name + "/" + name + ".txt"

f = open(fileName,"w+")

print u"正在偷偷保存她的个人信息为",fileName

f.write(content.encode('utf-8'))

#传入图片地址,文件名,保存单张图片

def saveImg(self,imageURL,fileName):

u = urllib.urlopen(imageURL)

data = u.read()

f = open(fileName, 'wb')

f.write(data)

print u"正在悄悄保存她的一张图片为",fileName

f.close()

#创建新目录

def mkdir(self,path):

path = path.strip()

# 判断路径是否存在

# 存在 True

# 不存在 False

isExists=os.path.exists(path)

# 判断结果

if not isExists:

# 如果不存在则创建目录

print u"偷偷新建了名字叫做",path,u'的文件夹'

# 创建目录操作函数

os.makedirs(path)

return True

else:

# 如果目录存在则不创建,并提示目录已存在

print u"名为",path,'的文件夹已经创建成功'

return False

#将一页淘宝MM的信息保存起来

def savePageInfo(self,pageIndex):

#获取第一页淘宝MM列表

contents = self.getContents(pageIndex)

for item in contents:

#item[0]个人详情URL,item[1]头像URL,item[2]姓名,item[3]年龄,item[4]居住地

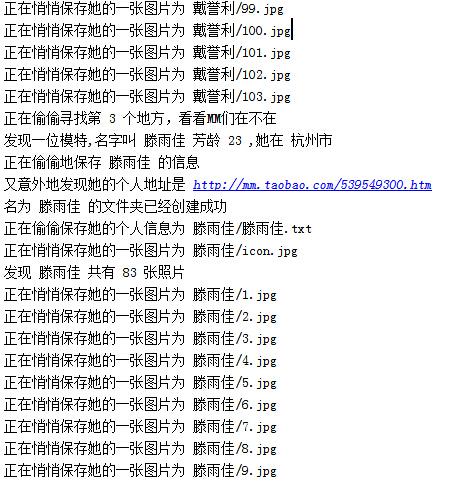

print u"发现一位模特,名字叫",item[2],u"芳龄",item[3],u",她在",item[4]

print u"正在偷偷地保存",item[2],"的信息"

print u"又意外地发现她的个人地址是",item[0]

#个人详情页面的URL

detailURL = item[0]

#得到个人详情页面代码

detailPage = self.getDetailPage(detailURL)

#获取个人简介

brief = self.getBrief(detailPage)

#获取所有图片列表

images = self.getAllImg(detailPage)

self.mkdir(item[2])

#保存个人简介

self.saveBrief(brief,item[2])

#保存头像

self.saveIcon(item[1],item[2])

#保存图片

self.saveImgs(images,item[2])

#传入起止页码,获取MM图片

def savePagesInfo(self,start,end):

for i in range(start,end+1):

print u"正在偷偷寻找第",i,u"个地方,看看MM们在不在"

self.savePageInfo(i)

#传入起止页码即可,在此传入了2,10,表示抓取第2到10页的MM

spider = Spider()

spider.savePagesInfo(2,10)

tool.py

__author__ = 'CQC'

#-*- coding:utf-8 -*-

import re

#处理页面标签类

class Tool:

#去除img标签,1-7位空格,

removeImg = re.compile('<img.*?>| {1,7}| ')

#删除超链接标签

removeAddr = re.compile('<a.*?>|</a>')

#把换行的标签换为\n

replaceLine = re.compile('<tr>|<div>|</div>|</p>')

#将表格制表<td>替换为\t

replaceTD= re.compile('<td>')

#将换行符或双换行符替换为\n

replaceBR = re.compile('<br><br>|<br>')

#将其余标签剔除

removeExtraTag = re.compile('<.*?>')

#将多行空行删除

removeNoneLine = re.compile('\n+')

def replace(self,x):

x = re.sub(self.removeImg,"",x)

x = re.sub(self.removeAddr,"",x)

x = re.sub(self.replaceLine,"\n",x)

x = re.sub(self.replaceTD,"\t",x)

x = re.sub(self.replaceBR,"\n",x)

x = re.sub(self.removeExtraTag,"",x)

x = re.sub(self.removeNoneLine,"\n",x)

#strip()将前后多余内容删除

return x.strip()

以上两个文件就是所有的代码内容,运行一下试试看,那叫一个酸爽啊

&lt;img src="https://pic2.zhimg.com/ed46f441ccd330e5c09488d910256aad_b.jpg" data-rawwidth="460" data-rawheight="484" class="origin_image zh-lightbox-thumb" width="460" data-original="https://pic2.zhimg.com/ed46f441ccd330e5c09488d910256aad_r.jpg"&gt;

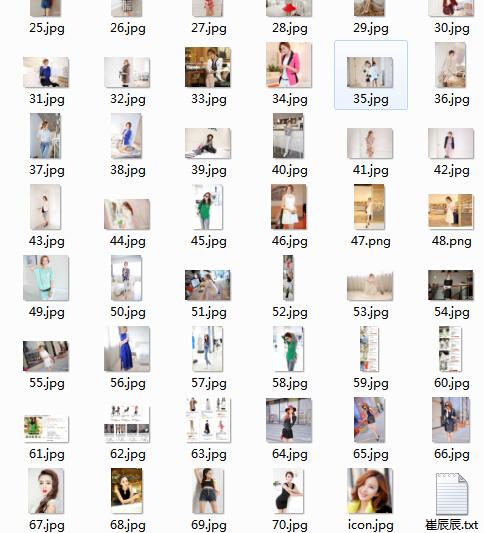

看看文件夹里面有什么变化

&lt;img src="https://pic2.zhimg.com/c074bb6f8ebe3c9eedc537f6e03ce54d_b.jpg" data-rawwidth="485" data-rawheight="489" class="origin_image zh-lightbox-thumb" width="485" data-original="https://pic2.zhimg.com/c074bb6f8ebe3c9eedc537f6e03ce54d_r.jpg"&gt;

不知不觉,海量的MM图片已经进入了你的电脑,还不快快去试试看!!

&lt;img src="https://pic3.zhimg.com/530356967ac3699af95bbc7924ec6546_b.jpg" data-rawwidth="484" data-rawheight="533" class="origin_image zh-lightbox-thumb" width="484" data-original="https://pic3.zhimg.com/530356967ac3699af95bbc7924ec6546_r.jpg"&gt;

代码均为本人所敲,写的不好,大神勿喷,写来方便自己,同时分享给大家参考!希望大家支持!

送完福利走人!!

推荐大家直接看原文:Python爬虫实战四之抓取淘宝MM照片

还有更多:Python爬虫学习系列教程

希望对大家有帮助哈,如果支持的话就点击下网站里的广告支持一下嘿嘿。

Python爬虫实战四之抓取淘宝MM照片的更多相关文章

- 一次Python爬虫的修改,抓取淘宝MM照片

这篇文章是2016-3-2写的,时隔一年了,淘宝的验证机制也有了改变.代码不一定有效,保留着作为一种代码学习. 崔大哥这有篇>>小白爬虫第一弹之抓取妹子图 不失为学python爬虫的绝佳教 ...

- 芝麻HTTP:Python爬虫实战之抓取淘宝MM照片

本篇目标 1.抓取淘宝MM的姓名,头像,年龄 2.抓取每一个MM的资料简介以及写真图片 3.把每一个MM的写真图片按照文件夹保存到本地 4.熟悉文件保存的过程 1.URL的格式 在这里我们用到的URL ...

- Python爬虫实战六之抓取爱问知识人问题并保存至数据库

大家好,本次为大家带来的是抓取爱问知识人的问题并将问题和答案保存到数据库的方法,涉及的内容包括: Urllib的用法及异常处理 Beautiful Soup的简单应用 MySQLdb的基础用法 正则表 ...

- Python爬虫之一 PySpider 抓取淘宝MM的个人信息和图片

ySpider 是一个非常方便并且功能强大的爬虫框架,支持多线程爬取.JS动态解析,提供了可操作界面.出错重试.定时爬取等等的功能,使用非常人性化. 本篇通过做一个PySpider 项目,来理解 Py ...

- python 爬虫实战4 爬取淘宝MM照片

本篇目标 抓取淘宝MM的姓名,头像,年龄 抓取每一个MM的资料简介以及写真图片 把每一个MM的写真图片按照文件夹保存到本地 熟悉文件保存的过程 1.URL的格式 在这里我们用到的URL是 http:/ ...

- Python爬虫实战五之模拟登录淘宝并获取所有订单

经过多次尝试,模拟登录淘宝终于成功了,实在是不容易,淘宝的登录加密和验证太复杂了,煞费苦心,在此写出来和大家一起分享,希望大家支持. 温馨提示 更新时间,2016-02-01,现在淘宝换成了滑块验证了 ...

- Python开源爬虫项目代码:抓取淘宝、京东、QQ、知网数据--转

数据来源:数据挖掘入门与实战 公众号: datadw scrapy_jingdong[9]- 京东爬虫.基于scrapy的京东网站爬虫,保存格式为csv.[9]: https://github.co ...

- Python爬虫实战八之利用Selenium抓取淘宝匿名旺旺

更新 其实本文的初衷是为了获取淘宝的非匿名旺旺,在淘宝详情页的最下方有相关评论,含有非匿名旺旺号,快一年了淘宝都没有修复这个. 可就在今天,淘宝把所有的账号设置成了匿名显示,SO,获取非匿名旺旺号已经 ...

- 简单的抓取淘宝关键字信息、图片的Python爬虫|Python3中级玩家:淘宝天猫商品搜索爬虫自动化工具(第一篇)

Python3中级玩家:淘宝天猫商品搜索爬虫自动化工具(第一篇) 淘宝改字段,Bugfix,查看https://github.com/hunterhug/taobaoscrapy.git 由于Gith ...

随机推荐

- 5.Vue临时上传文件夹

1.在项目目录中,通过npm install multiparty进行安装必要组件npm install multiparty --save-dev 2.app.js中添加app.use(bodyPa ...

- P750 内存插槽

查看p750内存插槽占用情况 lscfg -vp | grep -p DIMM Memory DIMM: Record Name.................VINI Flag Field.... ...

- AFNetworking网络请求数据

//创建AFNetworking的请求操作 AFHTTPRequestOperation *operation = [[AFHTTPRequestOperation alloc] initWit ...

- mapnik渲染原理

https://bbs.csdn.net/topics/390853826

- 项目管理系统Redmine(v1.1.2)安装手记

一.环境 1.硬件 普通PC. 2.软件 Windows 2003操作系统. 二.下载必要的软件 1.Ruby 1.8.x Redmine是基于Ruby On Rails的软件,所以首 ...

- curl工具介绍和常用命令

curl是利用URL语法在命令行方式下工作的开源文件传输工具.它被广泛应用在Unix.Linux发行版中,并且有DOS和Win32.Win64的移植版本.curl是一个利用URL规则在命令行下工作的文 ...

- Mining Twitter Data with Python

目录 1.Collecting data 1.1 Register Your App 1.2 Accessing the Data 1.3 Streaming 2.Text Pre-processin ...

- sql一些基本的语法

1.if语句: 语法:IF(expr1,expr2,expr3) 其中,expr1是判断条件,expr2和expr3是符合expr1的自定义的返回结果. 用处:当从数据库中查询出来的结果需要转换成中文 ...

- 笑话库存加网址http://www.jokeji.cn/list18_11.htm

19.富二代王晓伟成绩很差,老爸想给他找个家教老爸:“儿子,想找什么样的家教啊?”儿子:“要漂亮的,女的,衣服不能太保守,花样要多!”老爸:“儿子,你TM指的是岛国的苍老师吗?”@呦呦ta爹 20.哥 ...

- CentOS下双网卡绑定-bond0

网卡绑定就是多张网卡逻辑上作为一张网卡用.可分为,负载均衡绑定和冗余绑定两种. 加载bonding驱动 #modprobe bonding 1.编辑虚拟网络接口配置文件 [root@test~]# ...