tensorflow2.0 学习(三)

用tensorflow2.0 版回顾了一下mnist的学习

代码如下,感觉这个版本下的mnist学习更简洁,更方便

关于tensorflow的基础知识,这里就不更新了,用到什么就到网上搜索相关的知识

# encoding: utf-8 import numpy as np

import tensorflow as tf

import matplotlib.pyplot as plt #加载下载好的mnist数据库 60000张训练 10000张测试 每一张维度(28,28)

path = r'G:\2019\python\mnist.npz'

f = np.load(path)

x_train, y_train = f['x_train'], f['y_train']

f.close() #预处理输入数据

x = 2*tf.convert_to_tensor(x_train, dtype = tf.float32)/255. - 1

x = tf.reshape(x, [-1, 28*28])

y = tf.convert_to_tensor(y_train, dtype=tf.int32)

y = tf.one_hot(y, depth=10) #第一层输入256, 第二次输出128, 第三层输出10

#第一,二,三层参数w,b

w1 = tf.Variable(tf.random.truncated_normal([784, 256], stddev=0.1)) #正态分布的一种

b1 = tf.Variable(tf.zeros([256]))

w2 = tf.Variable(tf.random.truncated_normal([256, 128], stddev=0.1))

b2 = tf.Variable(tf.zeros([128]))

w3 = tf.Variable(tf.random.truncated_normal([128, 10], stddev=0.1))

b3 = tf.Variable(tf.zeros([10])) #将60000组数据切分为600组,每组100个数据

train_db = tf.data.Dataset.from_tensor_slices((x, y)).batch(100)

lr = 0.001 #学习率

losses = [] #储存每epoch的loss值,便于观察学习情况 for epoch in range(20):

#一次性处理100组(x, y)数据

for step, (x, y) in enumerate(train_db): #遍历切分好的数据step:0->599

with tf.GradientTape() as tape:

#向前传播第一,二,三层

h1 = x@w1 + tf.broadcast_to(b1, [x.shape[0], 256]) #可以直接写成 +b1

h1 = tf.nn.relu(h1)

h2 = h1@w2 + b2

h2 = tf.nn.relu(h2)

out = h2@w3 + b3

#计算mse

loss = tf.square(y - out)

loss = tf.reduce_mean(loss)

#计算参数的梯度,tape.gradient为自动求导函数,loss为目标数据,目的使它越来越接近真实值

grads = tape.gradient(loss, [w1, b1, w2, b2, w3, b3])

#更新w,b

w1.assign_sub(lr*grads[0]) #原地减去给定的值,实现参数的自我更新

b1.assign_sub(lr*grads[1])

w2.assign_sub(lr*grads[2])

b2.assign_sub(lr*grads[3])

w3.assign_sub(lr*grads[4])

b3.assign_sub(lr*grads[5])

#观察学习情况

if step%500 == 0:

print(epoch, step, 'loss:', float(loss))

#将每epoch的loss情况储存起来,最后观察

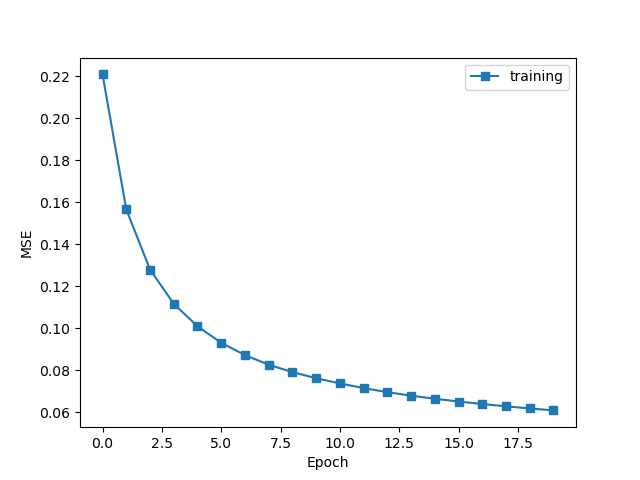

losses.append(float(loss)) plt.plot(losses, marker='s', label='training')

plt.xlabel('Epoch')

plt.ylabel('MSE')

plt.legend()

plt.savefig('exam_mnist_forward.png')

plt.show()

观察结果:

可由注释理解代码的含义!下一次更新mnist数据集训练的进阶!

tensorflow2.0 学习(三)的更多相关文章

- tensorflow2.0 学习(一)

虽说是按<TensorFlow深度学习>这本书来学习的,但是总会碰到新的问题!记录下这些问题,有利于巩固知新. 之前学过一些tensorflow1.0的知识,到RNN这章节,后面没有再继续 ...

- Tensorflow2.0学习(一)

站长资讯平台:今天学习一下Tensorflow2.0 的基础 核心库,@tf.function ,可以方便的将动态图的语言,变成静态图,在某种程度上进行计算加速 TensorFlow Lite Ten ...

- tensorflow2.0学习笔记

今天我们开始学习tensorflow2.0,用一种简单和循循渐进的方式,带领大家亲身体验深度学习.学习的目录如下图所示: 1.简单的神经网络学习过程 1.1张量生成 1.2常用函数 1.3鸢尾花数据读 ...

- TensorFlow2.0(三):排序及最大、最小、平均值

.caret, .dropup > .btn > .caret { border-top-color: #000 !important; } .label { border: 1px so ...

- tensorflow2.0 学习(二)

线性回归问题 # encoding: utf-8 import numpy as np import matplotlib.pyplot as plt data = [] for i in range ...

- tensorflow2.0学习笔记第一章第四节

1.4神经网络实现鸢尾花分类 import tensorflow as tf from sklearn import datasets import pandas as pd import numpy ...

- tensorflow2.0学习笔记第一章第一节

一.简单的神经网络实现过程 1.1张量的生成 # 创建一个张量 #tf.constant(张量内容,dtpye=数据类型(可选)) import tensorflow as tf import num ...

- tensorflow2.0学习笔记第一章第二节

1.2常用函数 本节目标:掌握在建立和操作神经网络过程中常用的函数 # 常用函数 import tensorflow as tf import numpy as np # 强制Tensor的数据类型转 ...

- tensorflow2.0学习笔记第一章第三节

1.3鸢尾花数据读入 # 从sklearn包datasets读入数据 from sklearn import datasets from pandas import DataFrame import ...

随机推荐

- Latex中如何设置字体颜色(三种方式)

1.直接使用定义好的颜色 \usepackage{color} \textcolor{red/blue/green/black/white/cyan/magenta/yellow}{text} 其中t ...

- sql特殊日期

--a. 本月的第一天 select dateadd(mm, datediff(mm,0,getdate()), 0) as 本月的第一天 --b. 本月的最后一天 select dateadd(ms ...

- MOOC C++笔记(六):多态

多态 虚函数 在类的定义中,前面有virtual关键字的成员函数就是虚函数. virtual关键字只用在类定义里的函数声明中,写函数体时不用. 构造函数和静态成员函数不能是虚函数. 多态的表现形式 基 ...

- java注解注意点

注意:以后工作中代码中 不允许出现警告 自定义注解 1:自定义注解并没有发挥它的作用,而Eclipse自带的注解通过反射另外有一套代码,可以发挥它的作用,例如:跟踪代码...... 2:如果自定义的代 ...

- Linux文件比对,批量复制

--背景 工作中突然有一天文件服务器空间满了,导致文件存不进去,立马换了另外一台服务器作为文件服务器,将服务器挂载上去,原来的服务器修复之后需要重新换回来,但是需要将临时使用的服务器内的文件迁移至原文 ...

- maven安装本地jar到本地仓库

注册到本地仓库 mvn install:install-file -DgroupId=cn.endv -DartifactId=endv-api -Dversion=1.0.1 -Dpackaging ...

- LRU(Least Recently Used)算法的理解

https://blog.csdn.net/wydyd110/article/details/84023688 感谢 ,自己学习记笔记 内存里建立一个哈希表,后来数据多了,爆了.咋整呢? 一个算法,就 ...

- js删除对象里的某一个属性

var a={"id":1,"name":"danlis"}; //添加属性 a.age=18; console.log(a); //结果: ...

- 给用过SAP CRM中间件的老哥老姐们讲讲SAP CPI

最近Jerry由于项目需要,又得学习一个新工具:SAP Cloud Platform Integration,简称CPI,以前又叫做HCI - HANA Cloud Platform Integrat ...

- 理解 Cookie,Session,Token 并结合 Redis 的使用

Http 协议是一个无状态协议, 客户端每次发出请求, 请求之间是没有任何关系的.但是当多个浏览器同时访问同一服务时,服务器怎么区分来访者哪个是哪个呢? cookie.session.token 就是 ...