【VMware vSAN】创建vSAN Max集群并配置挂载远程数据存储。

VMware Explore 2023大会上,VMware正式发布了vSAN Max,这是VMware的一种全新分解存储架构,可以为vSphere集群提供PB级分解存储。vSAN Max是基于vSAN Express Storage Architecture(ESA)架构构建的,也就是说vSAN Max仅在vSAN 8 ESA架构中可用。

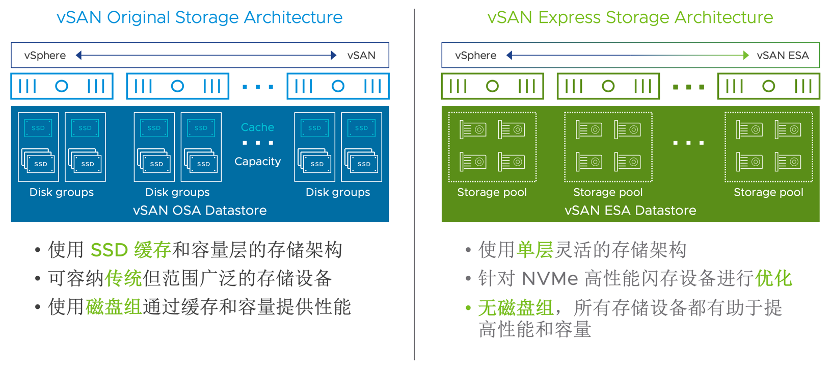

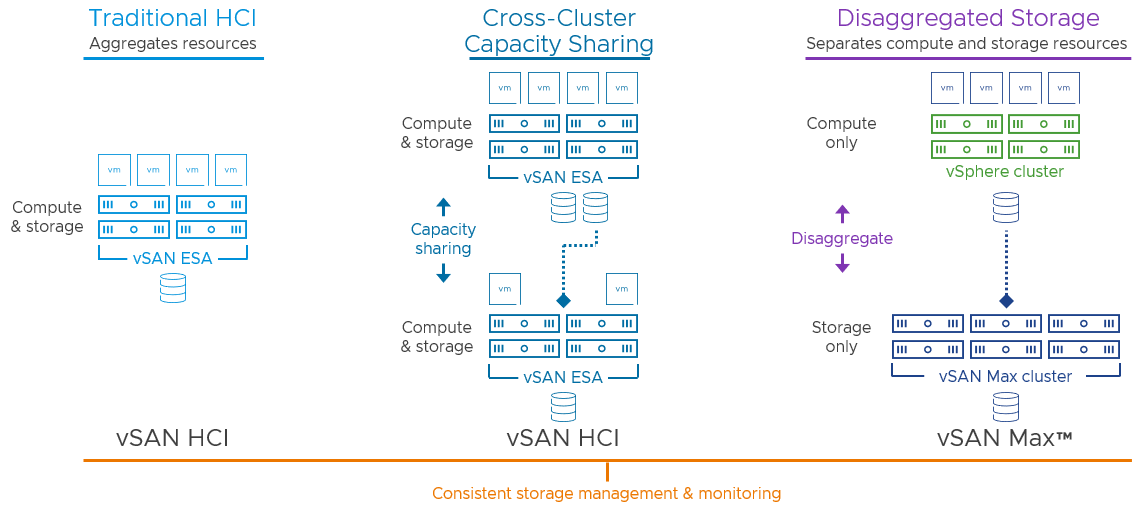

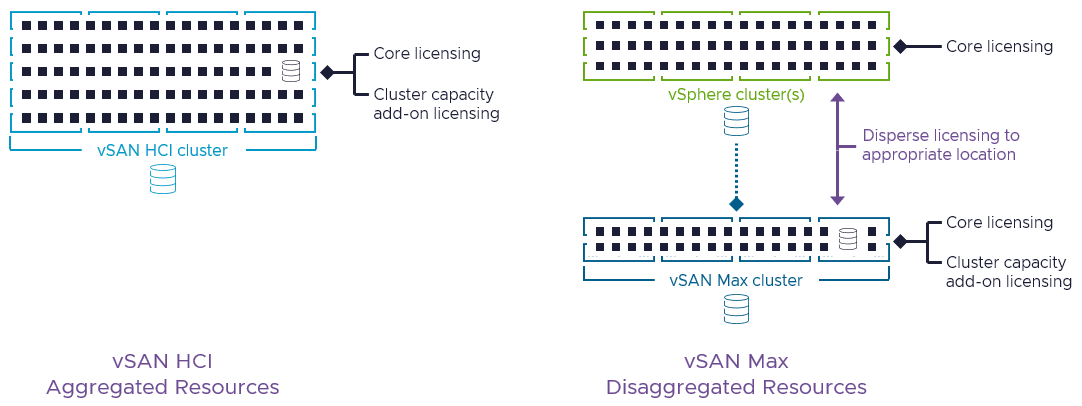

vSAN HCI是传统的超融合架构,该架构是把计算和存储等资源进行聚合(Aggregate),以便在同一集群中为虚拟机负载提供计算和存储等资源。vSAN HCI架构支持两种部署类型,分别是Original Storage Architecture (OSA)原始存储架构和Express Storage Architecture (ESA)快速存储架构,OSA架构部署方式是缓存盘+容量盘构成的传统磁盘组(Disk Group)模式,ESA架构没有区分磁盘的使用类型,所有磁盘都属于容量盘,并组成一个统一的存储池(Storage Pool),只有基于NVMe的TLC磁盘类型才被支持。

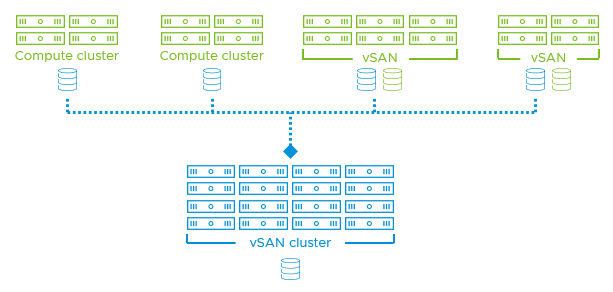

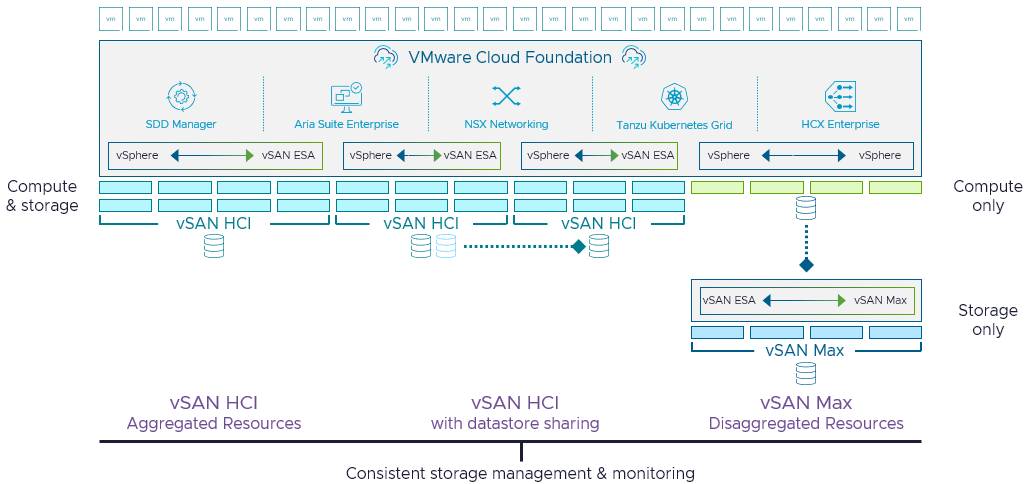

后来经过发展,vSAN HCI架构除了为自身集群提供存储资源以外,也可以为相同数据中心的其他集群(Cross-Cluster)提供存储共享功能,早期的时候,VMware 称这种使用方式为vSAN HCI Mesh。

不过,上述HCI这些传统的使用方式都是将资源进行聚合(Aggregates resourcs)使用,这也是我们所最常见的使用方式。

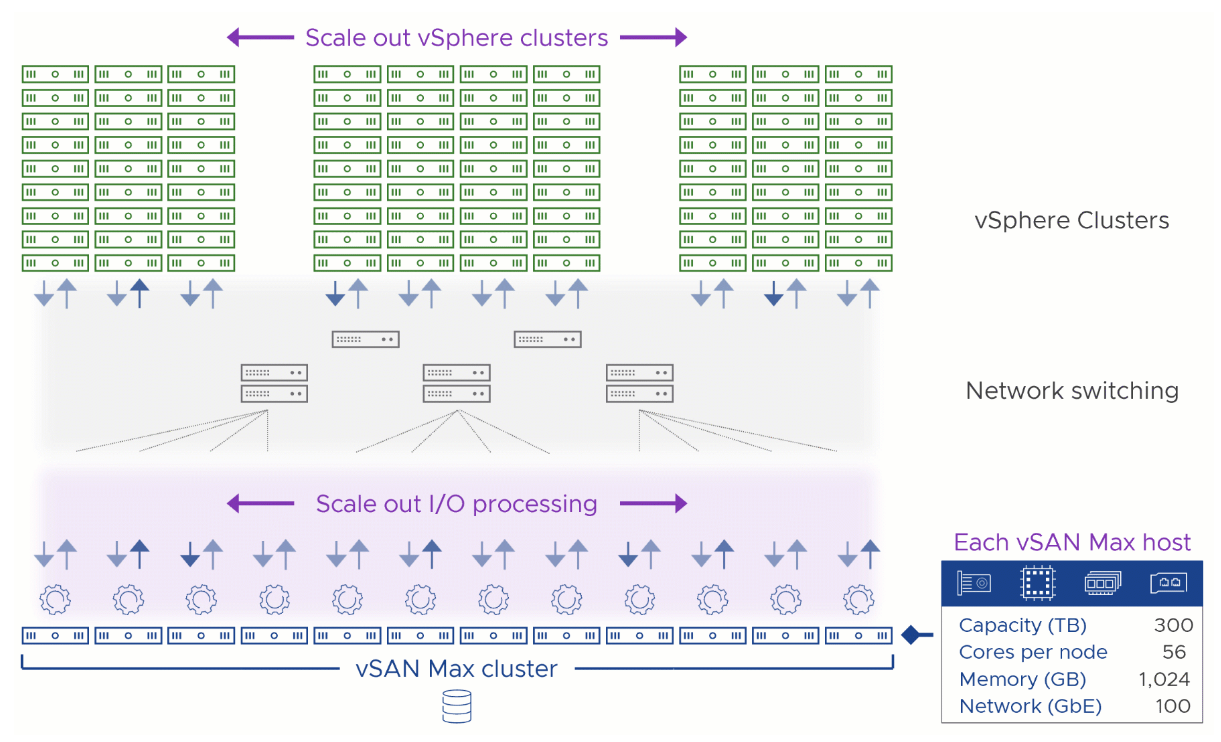

现在,VMware 发布了一种全新的架构叫vSAN Max,这种架构不同于传统的HCI架构,它将计算和存储进行了分解(Disaggregate)。也就说,vSAN Max集群专注于提供存储资源(Storage Only),并利用全新的vSAN 8 ESA架构的各种优势,可以向传统的标准vSphere集群(Compute Only)或vSAN HCI集群提供存储资源。

vSAN Max节点的密度是HCI节点的7倍,并且可以在集群中横向扩展到8.6PB。vSAN Max不仅能够扩展容量,还可以扩展性能,因为添加到vSAN Max群集的每个节点都会提高可用性能。由于vSAN Max基于vSAN ESA快速存储架构构建,因此它可以容纳海量数据集并满足严格的性能和恢复能力要求,每个存储集群的IOPS高达360万。

vSAN Max是一种全新的分解存储架构,与传统的HCI超融合架构一样,它是一种可选的方案,它是另一种使用方式,并不会替代传统的HCI架构。

也就说vSAN现在有两种方案,一种叫vSAN HCI,这是一种聚合资源方式(Aggregated Resources),比如由vSphere+vSAN OSA/ESA组成,聚合了计算和存储(Compute & Storage)资源;另一种叫vSAN Max,这是一种分解资源方式(Disagggregated Resources),由vSphere+vSAN ESA组成,仅提供存储(Storage only)资源。

vSAN Max为什么还会有vSphere呢?其实vSAN Max配置vSAN集群也需要基本的vSphere计算资源,不过不像vSAN HCI架构那样,上面需要为虚拟机提供计算资源,vSAN Max集群不应该运行虚拟机(可能存在系统实例化的虚拟机,例如vSphere群集服务(vCLS)虚拟机和代理虚拟机,用于为vSAN文件服务的协议服务容器提供支持。),虽然没有软件限制阻止虚拟机实例在vSAN Max 群集上运行,但vSAN为配为vSAN Max架构的集群专门对处理和存储数据的任务进行了优化的,主要是为了提供存储资源而设计。在经济性上也有好处,比如现在VMware 将永久授权改为订阅制后,vSphere按内核(Core)进行授权,而vSAN按容量(TB)进行授权,配置为vSAN Max的集群,对vSphere资源的要求就没那么高,可以配置比较少的CPU内核(Core)和内存资源,这样就可以把资金投入在更核心的地方,比如配置性能更好的NVMe磁盘,购买更多的vSAN 容量(TB)等;而承载虚拟机负载的vSphere集群也只需要购买CPU内核(Core)。

早期,在同一数据中心中的vSAN HCI和vSAN HCI集群之间可以相互共享存储资源,这种解决方案之前叫vSAN HCI Mesh,由于vSAN Max的发布,vSAN Max专注于提供分解存储资源(可以称为Storage Only),并向vSphere集群或者vSAN HCI集群共享存储资源,这个vSphere集群也叫vSAN计算集群(也被称为Compute Only),这样功能就和HCI Mesh重合了,所以现在的vSAN HCI集群和vSAN HCI集群之间的跨集群共享存储功能被称为“具有数据存储共享的 vSAN HCI ”或“vSAN HCI with datastore sharing”。

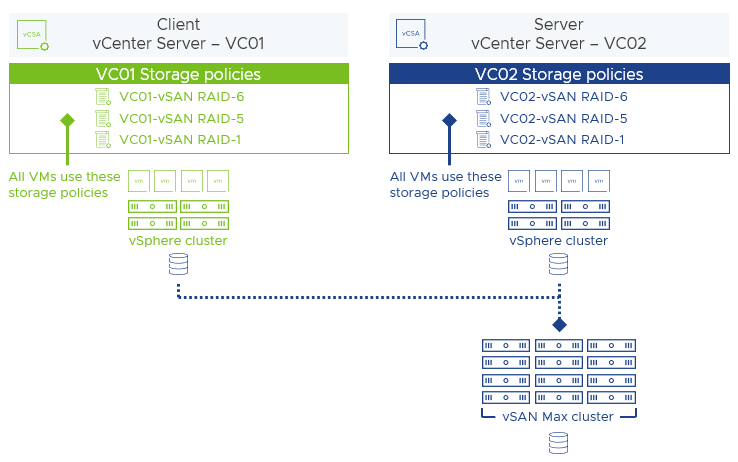

具有数据存储共享的 vSAN HCI解决方案可以实现相同数据中心中跨集群共享,也就是在vSAN HCI和vSAN HCI或者vSAN HCI和vSAN 计算集群(vSphere集群/Compute Only)之间实现存储共享并充分利用资源的能力。现在,除了在同一站点之间之外,还可以在跨vCenter站点实现远程数据存储共享。vSAN Max同样可以实现上述vSAN HCI解决方案的能力,在跨数据站点(Cross vCenter)存储资源之间共享,vSAN Max的分解功能允许由另一个 vCenter Server 实例管理的集群(vSAN HCI集群或vSAN 计算集群)挂载 vSAN 远程数据存储。

比如,下图中vCenter站点VC02部署的vSAN Max集群分解存储,可以被vCenter站点VC01中的vSphere集群进行远程挂载存储使用。这里提供vSAN Max分解存储的站点VC02被称为Server服务器端站点,而挂载了vSAN Max分解存储的站点VC01被称为Client客户端站点。而客户端站点或客户端集群上面运行的虚拟机实例的存储策略配置文件将使用自己站点或自己集群的基于存储策略管理(SPBM)。

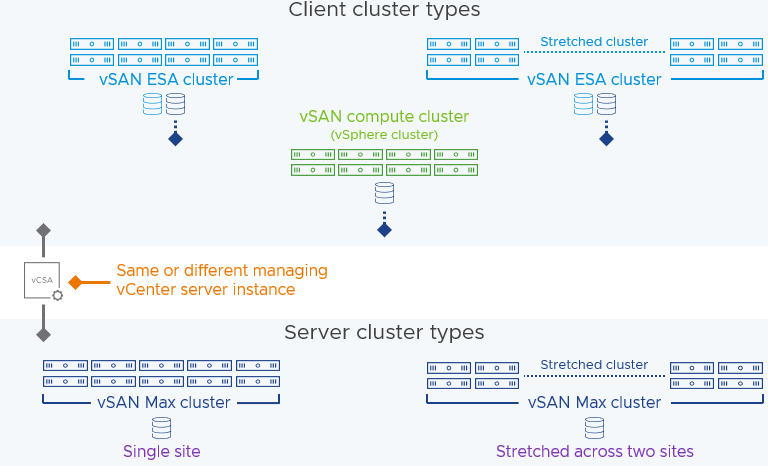

vSAN Max集群和vSAN HCI集群很相似,除了支持单站点(Single site)部署类型以外,同样也支持延伸集群(Stretched cluster)部署类型,以提供站点级弹性。客户端群集类型可以包括vSphere群集(也称为vSAN计算群集)、vSAN HCI 群集以及延伸群集或采用双主机拓扑的vSAN HCI群集。这些可以由同一vCenter Server实例管理,也可以由不同的vCenter Server实例进行管理。

如果使用延伸群集部署方式的vSAN Max群集或vSAN HCI群集(服务器端集群)进行远程挂载数据存储时,客户端群集的类型存在某些限制。目前,使用延伸群集部署方式的vSAN Max或vSAN HCI群集时,不支持跨两个地理位置延伸的vSphere群集。有关部署为延伸集群的vSAN Max集群对所支持的客户端集群类型请看下表。

| 服务器端集群(Server Cluster) | 客户端集群(Client Cluster) | 是否支持 | 备注 |

|

vSAN Max 延伸集群或vSAN HCI 延伸集群(ESA) |

vSAN HCI 延伸集群(ESA) | 支持 | 提供数据的弹性和正在运行的 VM 实例的高可用性。 |

| vSAN Max 延伸集群或vSAN HCI 延伸集群(ESA) | 与vSAN Max集群或者vSAN HCI 集群(ESA)同一站点的vSAN HCI 集群(ESA) | 支持 | 提供数据恢复能力,但不提供运行虚拟机实例的高可用性。 |

| vSAN Max 延伸集群或vSAN HCI 延伸集群(ESA) | 与vSAN Max集群或者vSAN HCI 集群(ESA)同一站点的vSphere集群 | 支持 | 提供数据恢复能力,但不提供运行虚拟机实例的高可用性。 |

| vSAN Max 延伸集群或vSAN HCI 延伸集群(ESA) | 使用对称网络连接跨两个站点延伸的vSphere 集群 | 支持 | 支持,但不常用,因为这需要确保每个故障域站点之间具备相同的网络能力(带宽和延迟)。 |

| vSAN Max 延伸集群或vSAN HCI 延伸集群(ESA) | 使用非对称网络连接跨两个站点延伸的vSphere 集群 | 不支持 | 不支持。 |

| vSAN Max 延伸/单站点集群或vSAN HCI 延伸/单站点集群(ESA) | vSAN OSA的任何类型的客户端群集 | 不支持 | 不支持跨两种架构共享。 |

注:非对称网络拓扑结构是,连接两个站点(故障域)的网络能力(延迟和带宽)小于每个站点内客户机群集和服务器群集之间的网络能力。 这种情况在使用站点间链路(ISL)的延伸群集配置中最为常见。 对称网络拓扑结构是,连接两个站点的网络能力与每个站点内客户机群集和服务器群集之间的网络能力相同。 这种配置不太常见,但可能会出现在这样的环境中:在延伸拓扑中,定义站点的两个故障域只是服务器在不同机架或使用相同网络的不同机房。

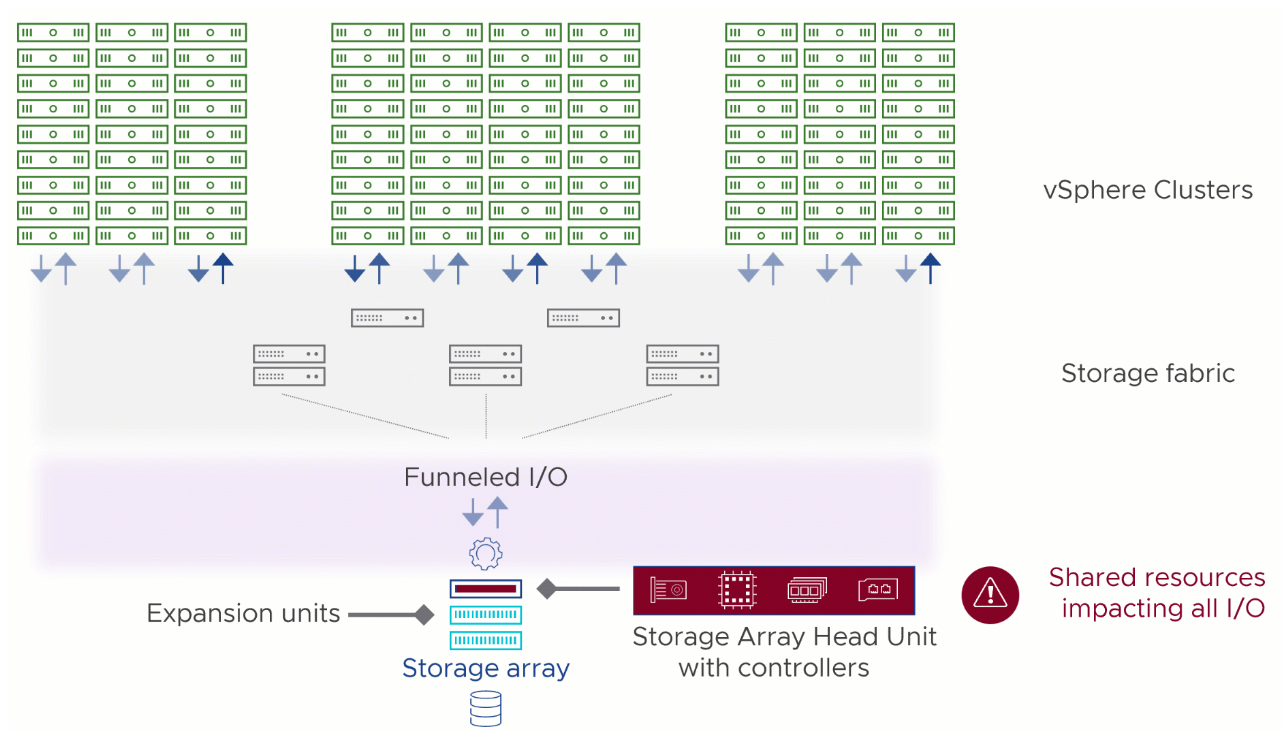

vSAN Max 作为专用存储集群,可以实现更高的容量级别,使其成为使用传统集中式存储的环境的理想替代方案。使用存储阵列的传统三层架构提供的存储资源是从计算资源中“分解”出来的。但这种方法有其固有的局限性。使用一对冗余控制器连接到专用存储结构的单个存储阵列的设计必须通过这些控制器将所有 I/O 汇集到集群文件系统(如 VMFS),然后依靠锁定机制来防止同时访问。

基于 vSAN ESA 构建的 vSAN Max 则完全不同。它是一个完全分布式的存储系统,由于其设计,它提供了容量和性能的增量可扩展性,一个通用的管理平面,所有这些都在商用服务器上运行。这有助于克服使用存储阵列的传统三层架构的大多数挑战。

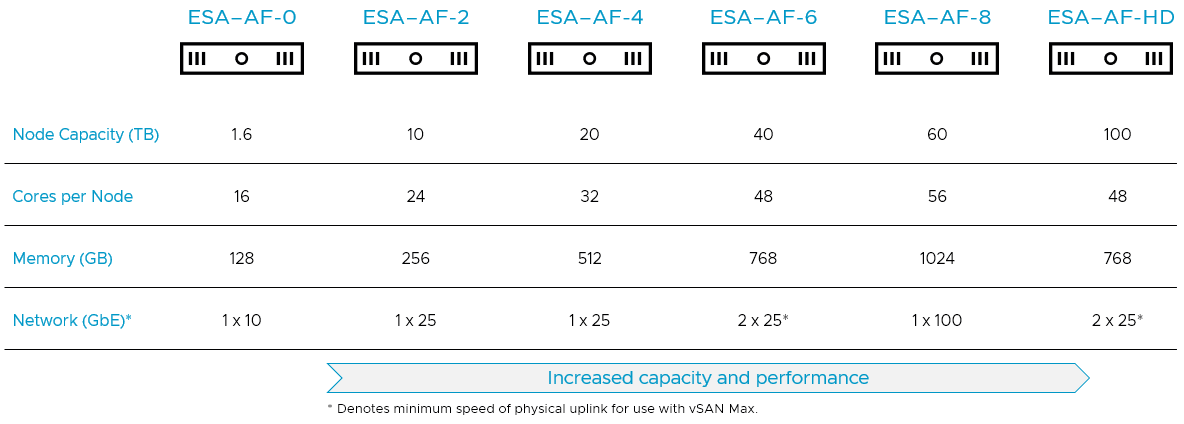

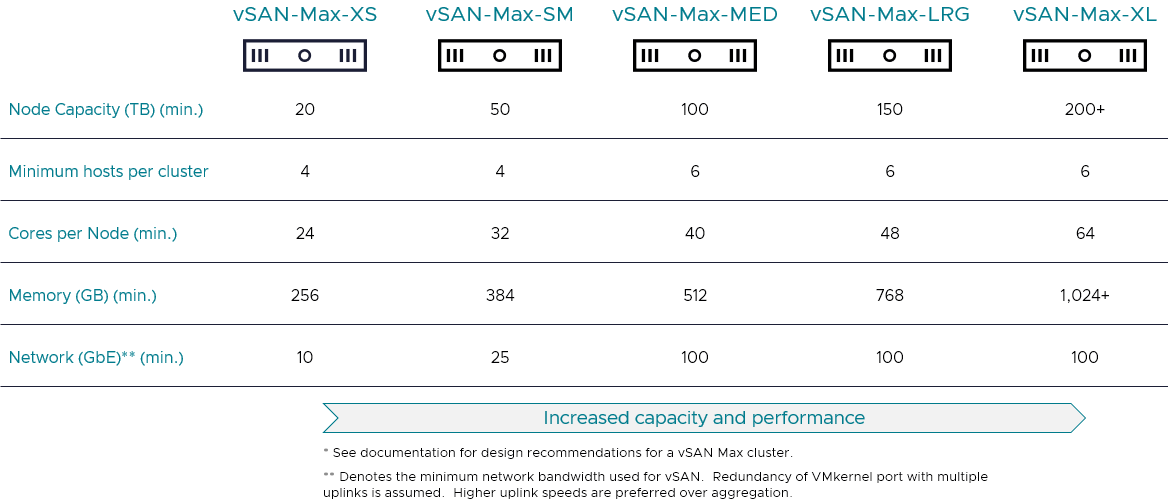

为了帮助降低用户的准入门槛,也为了确保 vSAN Max 可以在各种环境中使用,VMware 对 vSAN Max 的主机和群集要求进行了多项改进,主要体现在vSAN Max集群所需要的主机更少以及对vSAN Max的主机的硬件和网络要求更低。这些改进将提供更大的灵活性,并为更小、更简化的配置提供了选择。因此,VMware 专门针对 vSAN HCI 和 vSAN Max 发布了 ReadyNode 配置文件。

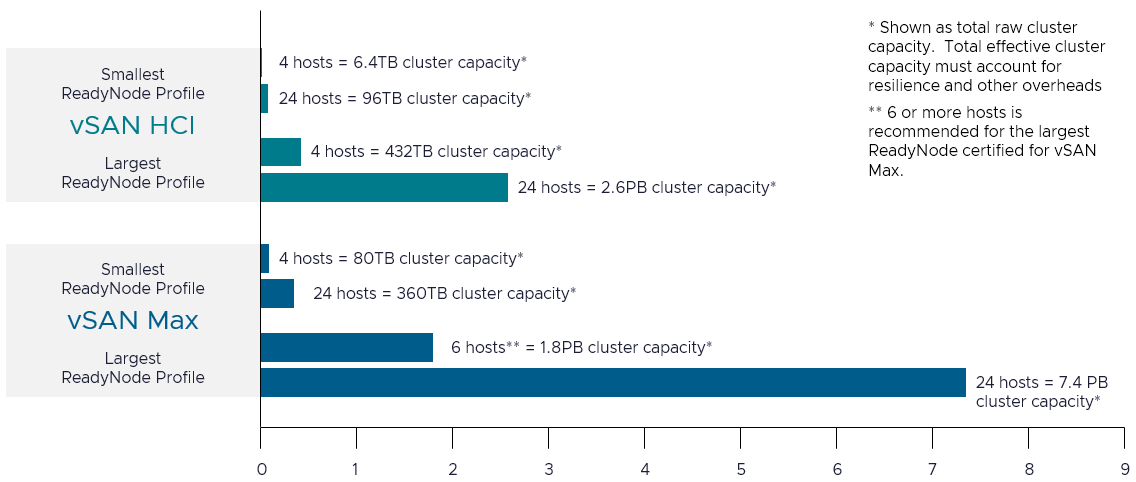

下图根据ReadyNode 配置文件比较了 vSAN HCI 和 vSAN Max 群集(从 4 个主机到 24 个主机)的相对容量。

与vSAN HCI集群一样,建议每个vSAN Max 单站点群集至少具有4台主机,一是在较小的环境中允许集群使用节省空间的RAID-5 纠删码,二是确保有足够的主机在发生持续主机故障时重新获得规定的弹性级别。但是,由 7 个或更多主机组成的 vSAN Max 群集将提供两个优势。

- 最佳弹性。 这将确保群集可以使用 RAID-6 支持 FTT=2。虽然使用 RAID-6 的 FTT=2 只需要 6 个主机,但仅由 6 个主机组成的集群中的主机持续发生故障将导致主机数量不足,无法恢复其规定的弹性级别。7 台主机将能够在主机持续发生故障时自动恢复其规定的恢复能力级别。7 个主机也是启用“主机重建预留”的群集容量管理设置后,vSAN 的自动策略管理功能使用 RAID-6 所需的最小主机数。

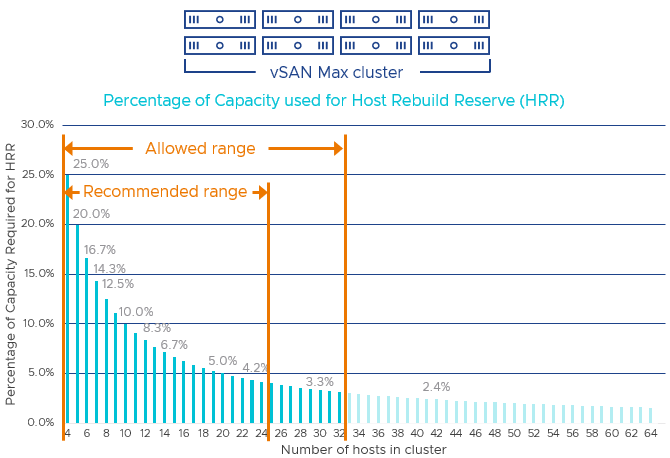

- 减少主机持续故障的影响百分比。 如下图所示,随着群集主机数量的增加,主机故障的影响百分比会小得多。如下图所示,如果主机持续发生故障,至少具有 7 个主机的集群对存储资源(容量和性能)的影响不会超过 14%。增加主机数量可进一步降低影响百分比 — 对于 24 个主机的 vSAN Max 群集,影响百分比低至约 4%。

在vSAN Max 延伸群集中建议至少包含 8 个数据主机。在两个数据站点中每个站点中至少有 4 个主机的延伸集群将确保集群能够支持使用 RAID-5 纠删码的二级恢复能力级别为 FTT=1 的存储策略,同时能够在每个站点中发生持续主机故障时恢复其规定的恢复能力级别。在两个数据站点中每个站点中至少有 7 个主机的延伸集群将确保集群能够支持使用 RAID-6 纠删码的二级恢复能力级别为 FTT=2 的存储策略,并允许 vSAN 在主机持续中断时恢复其规定的恢复能力级别。如果多出所需的最小值,则 vSAN 能够以最有效的方式重建条带和奇偶校验,同时对性能的影响最小。

在 vSAN Max 的初始版本中,VMware 建议vSAN Max集群中最多有 24 个主机,但其实限制是 32 个主机。 vSAN Max 群集和任何 vSAN 计算群集的主机计数总共不能超过 128 个主机,如下所示。

将 vSAN Max 群集大小限制为 24 个主机将允许 vSAN 计算群集中最多 104 个主机挂载数据存储。如果 vSAN Max 群集大小为 32 个主机,则 vSAN 计算群集中最多允许 96 个主机挂载数据存储,同时仍能提供 3:1 的良好计算与存储比率。

下面进入正文。

一、配置vSAN Max集群

登录vSphere Client,导航到数据中心(mulab),右击选择“新建集群”。

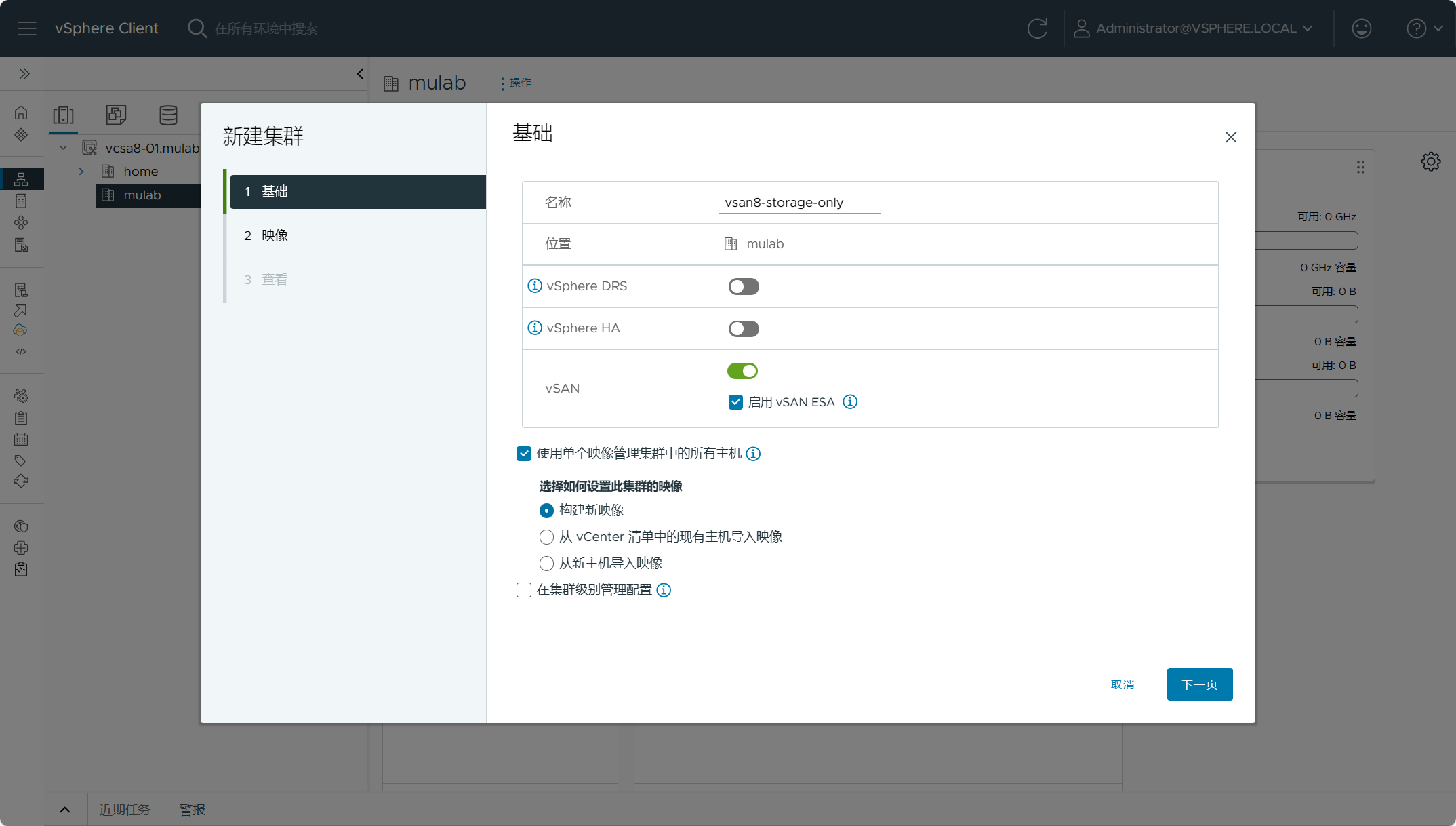

设置vSAN Max集群名称,开启 vSAN,并勾选“启用 vSAN ESA”。同时需要勾选“使用单个映像管理集群中的所有主机”。

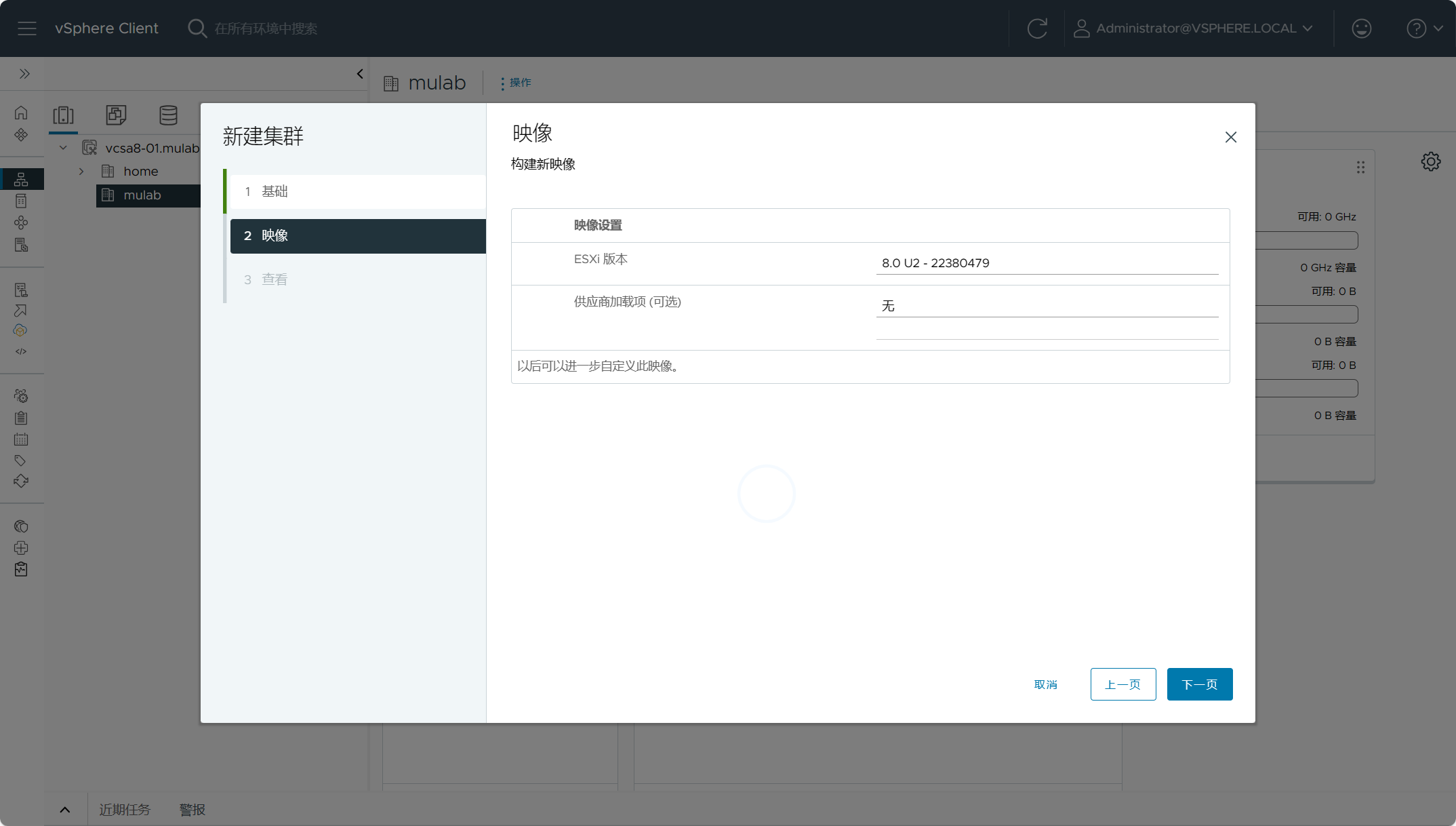

设置集群映像的方式有多种,可以从vCenter中已存在的主机上导入,也可以从新添加的主机上导入映像,或者直接手动构建。

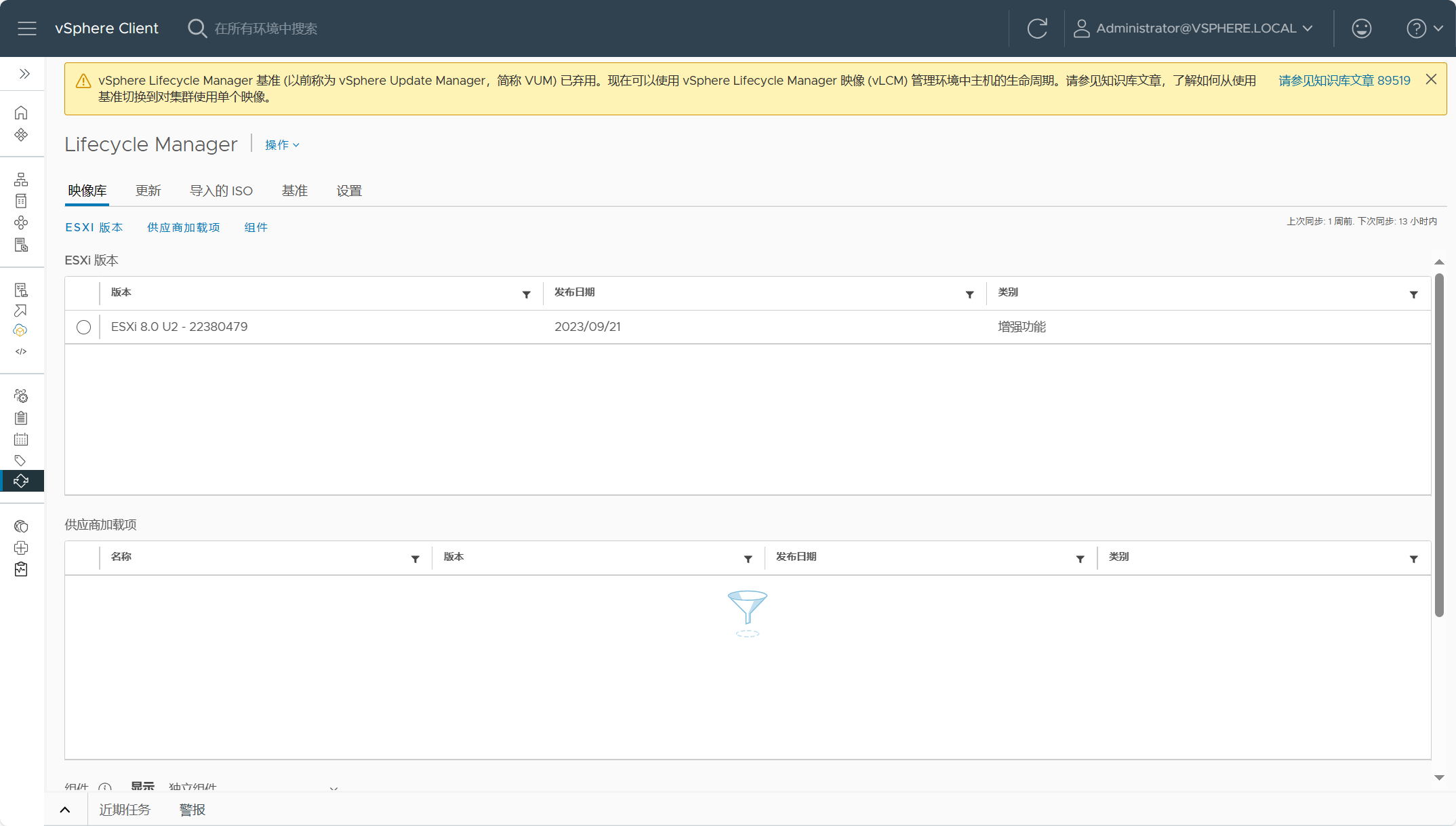

手动构建映像,点击管理,找到vSphere Lifecycle Manager,手动上传一个ESXi映像,一般上传主机所安装的版本就行。

上传集群映像后,点击下一步,可以看到刚刚上传的映像版本,设置集群映像版本,点击下一步。

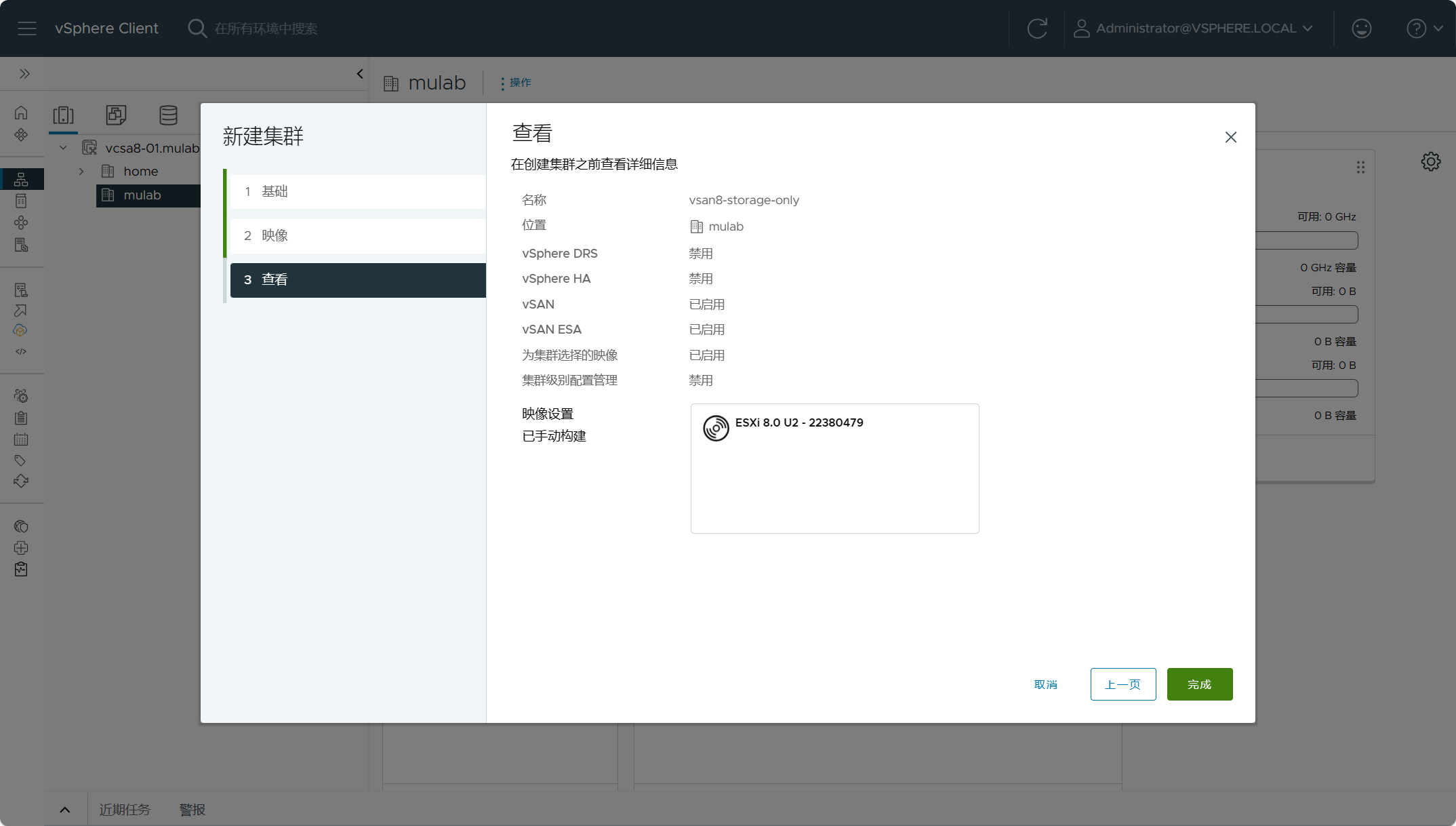

点击完成。

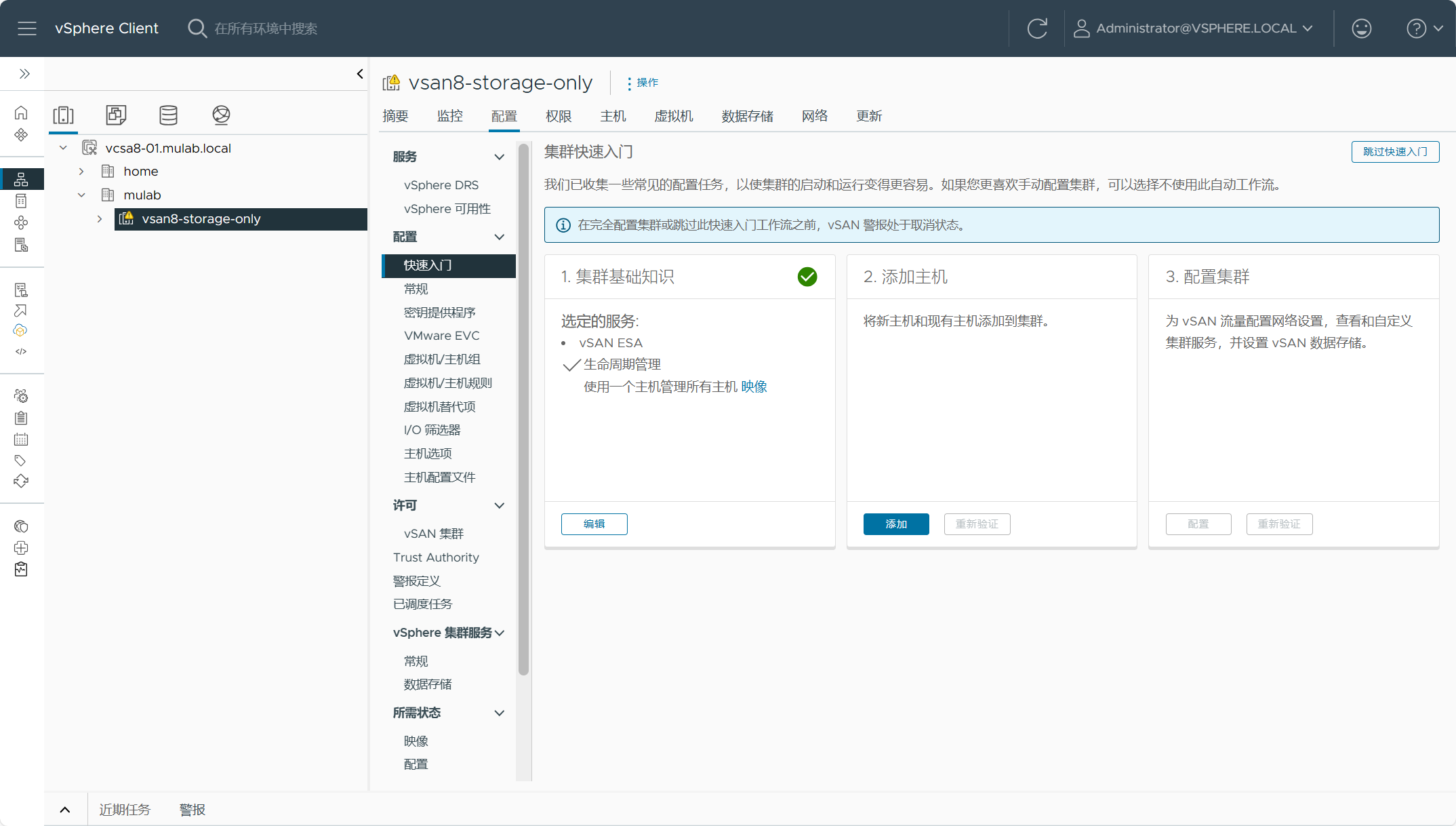

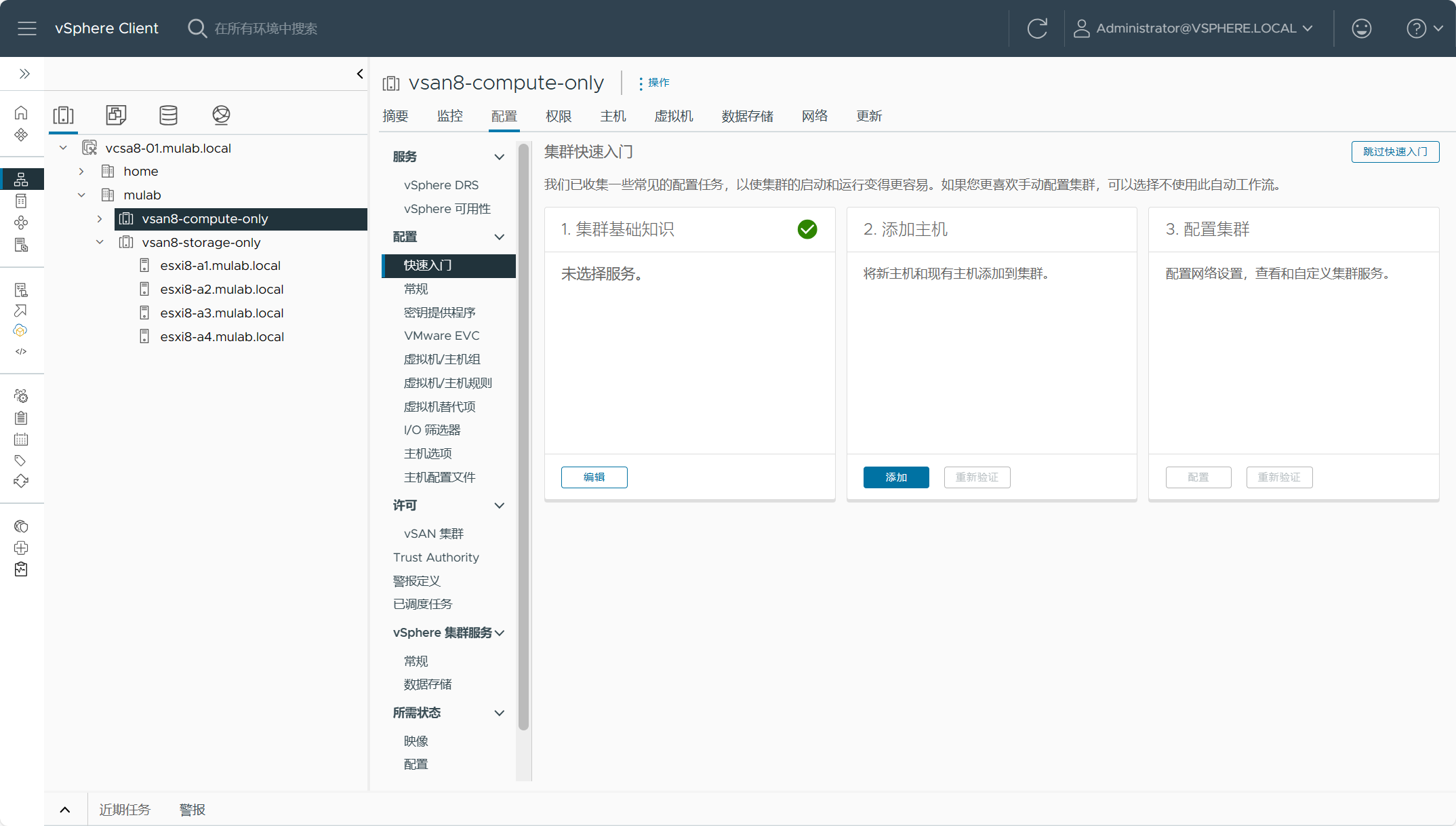

点击完成后,会自动跳到集群快速配置向导,建议使用这个向导完成后续配置。

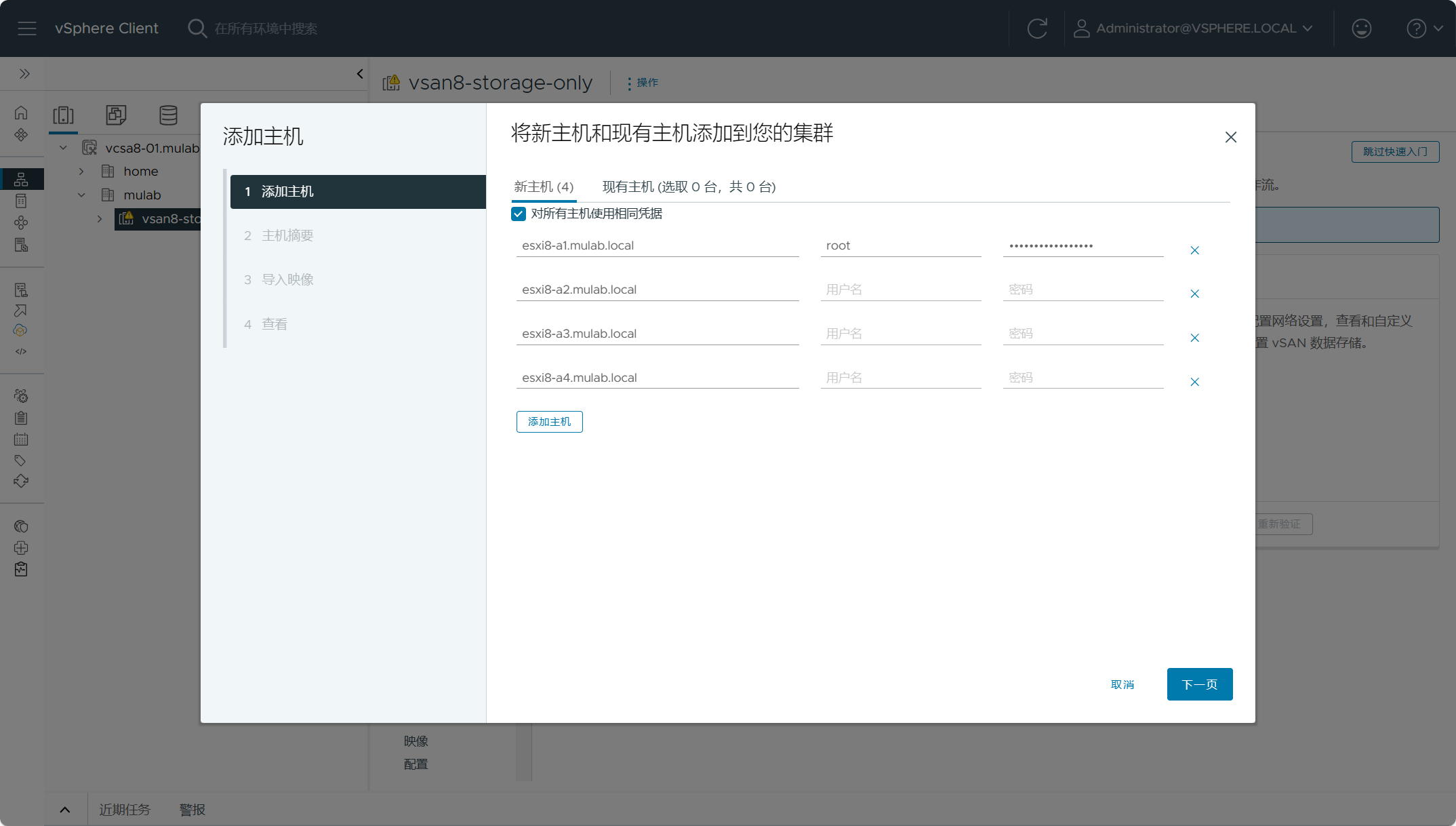

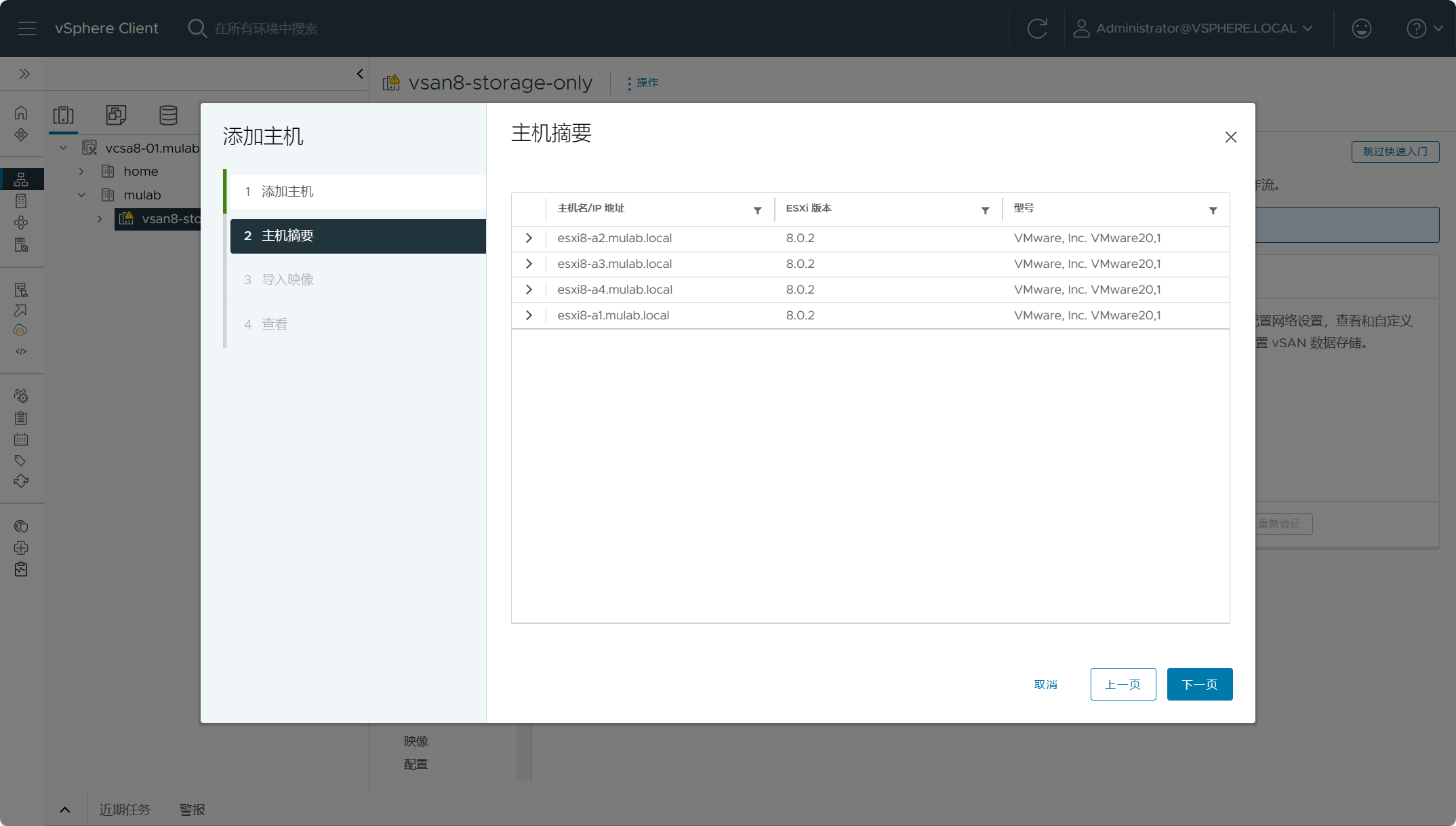

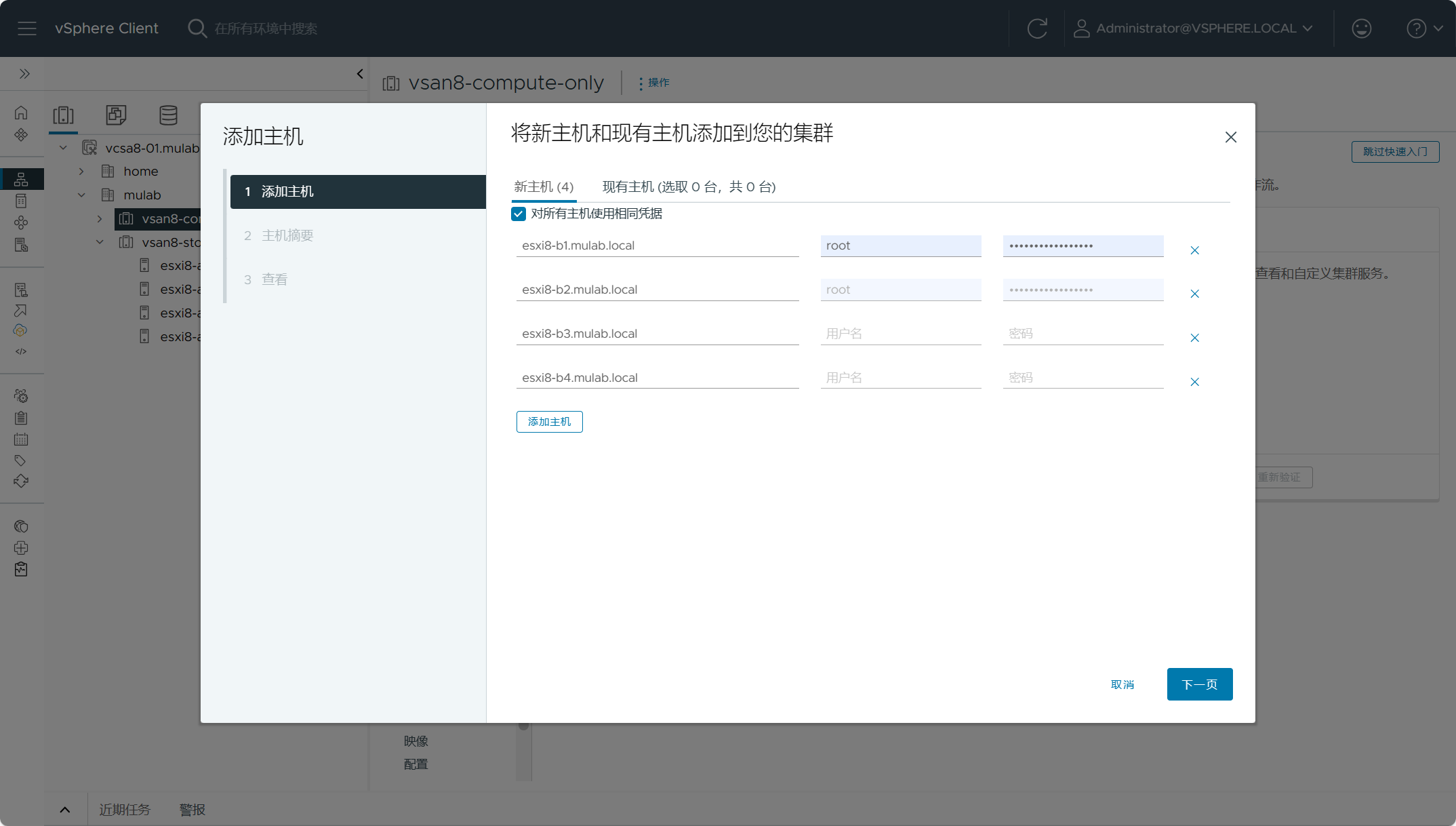

点击添加主机,输入所有主机的凭据信息。

点击下一步。

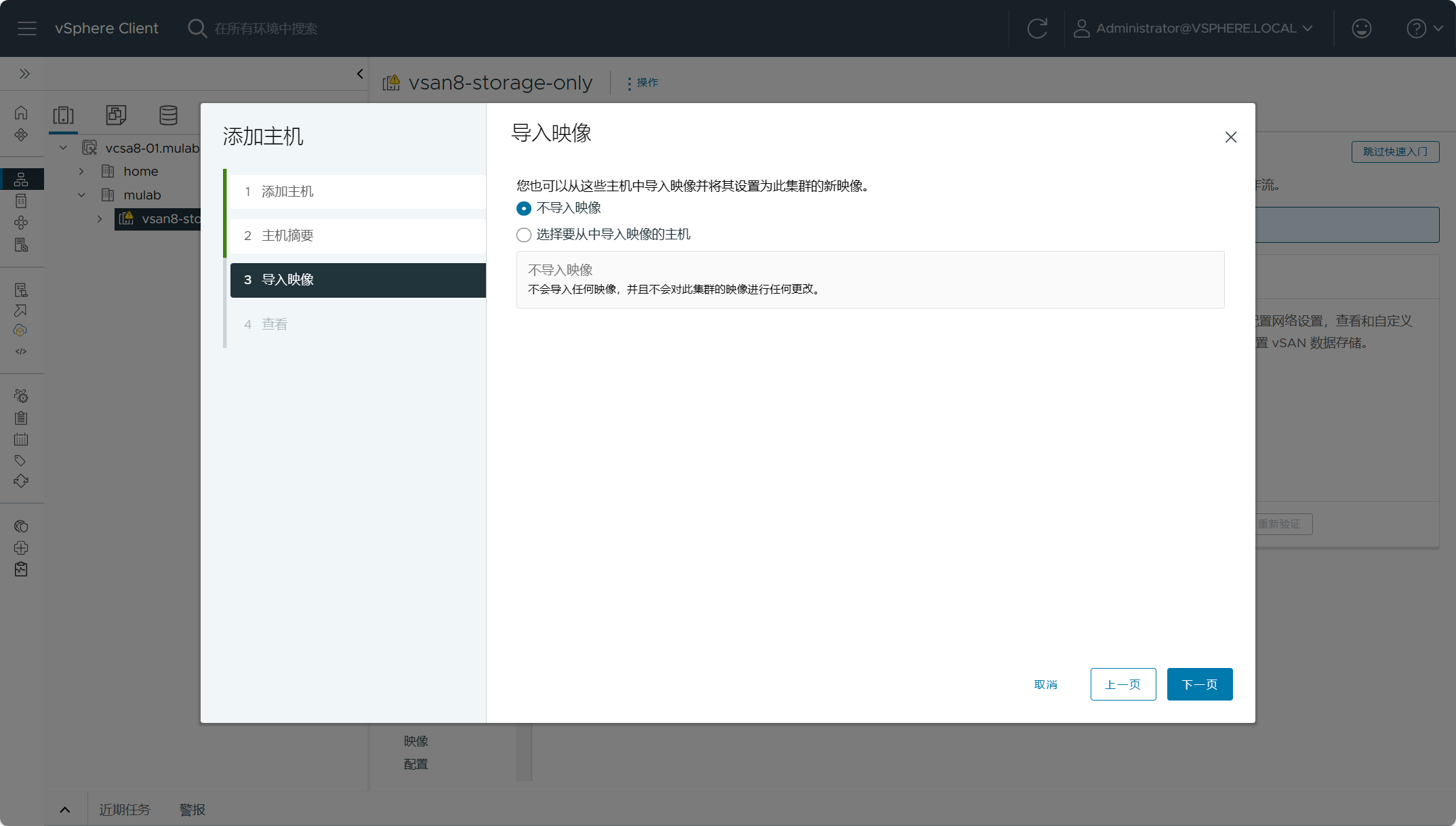

选择不导入映像,刚刚已经导入过了。

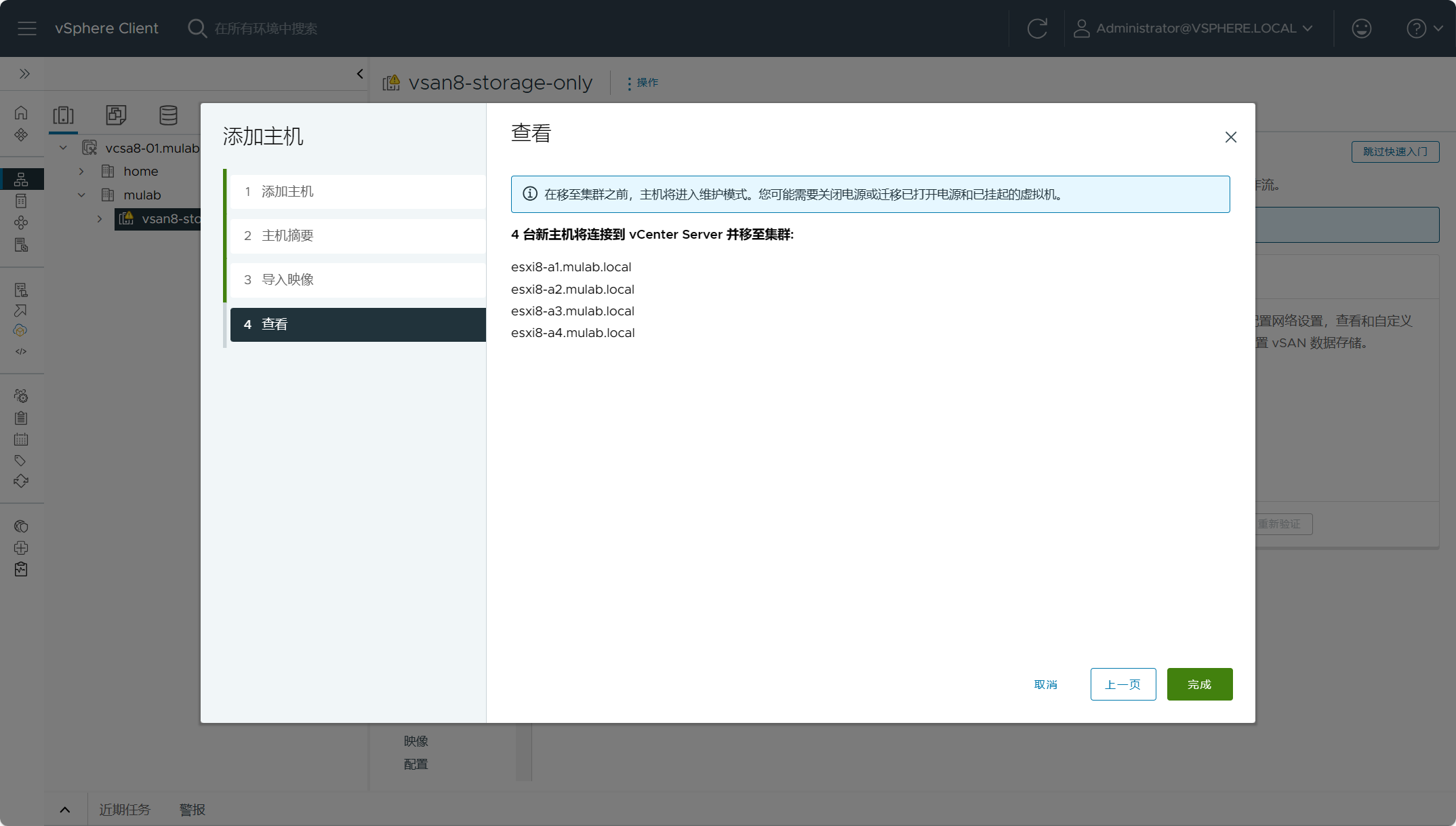

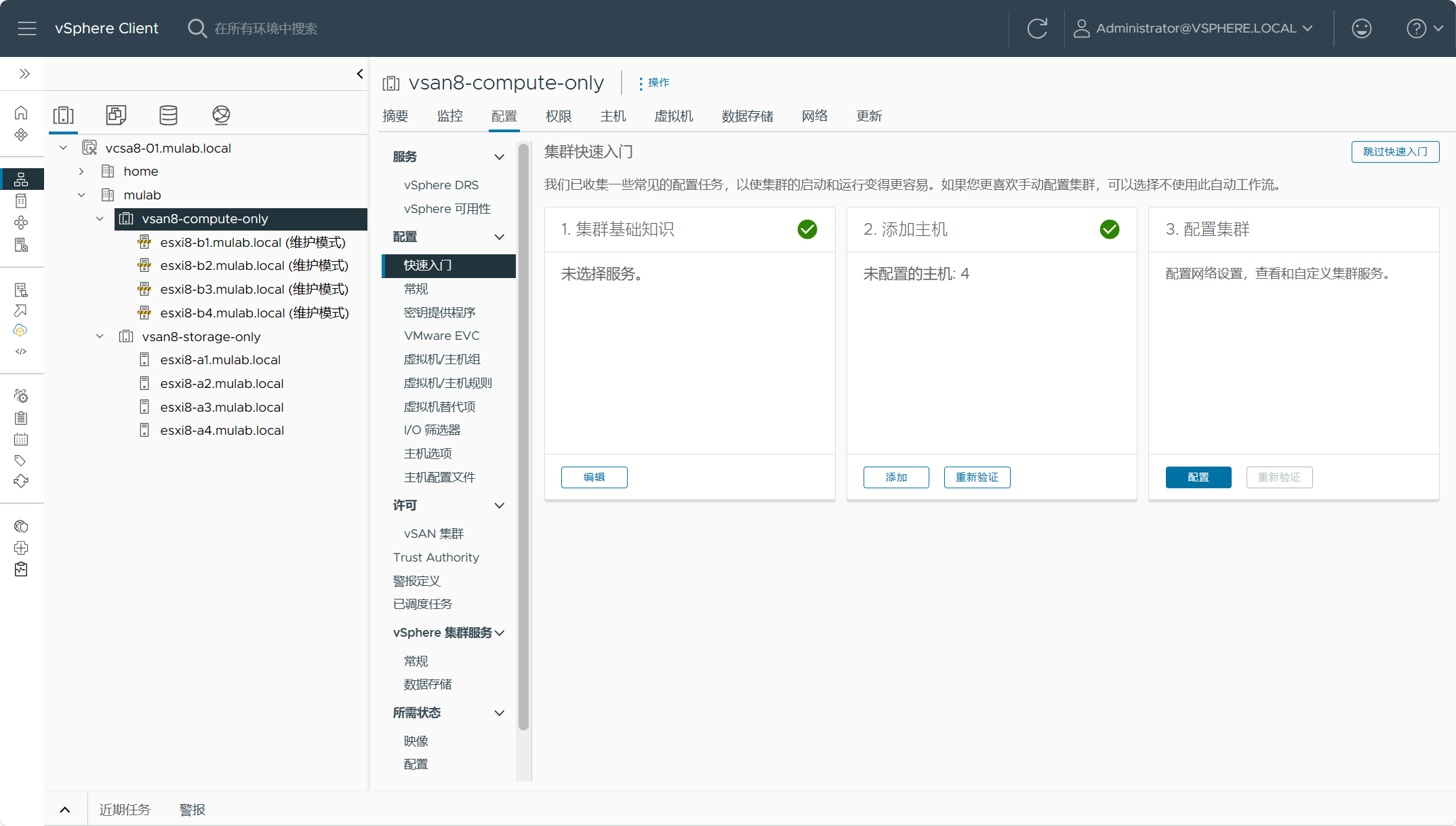

确认添加信息,所有主机将添加至集群并进入维护模式。

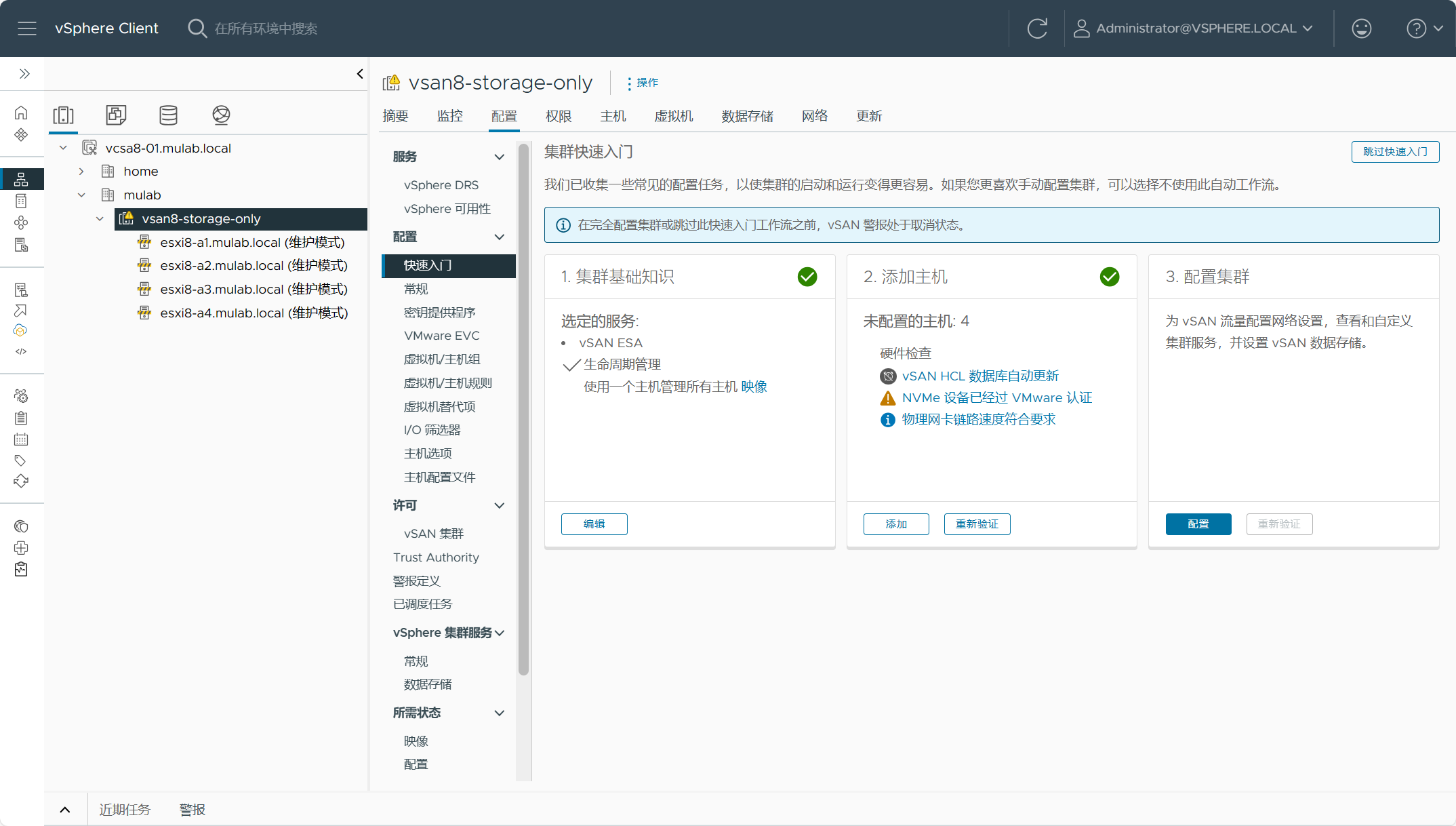

下面开始配置vSAN Max,点击快速向导中的集群配置。

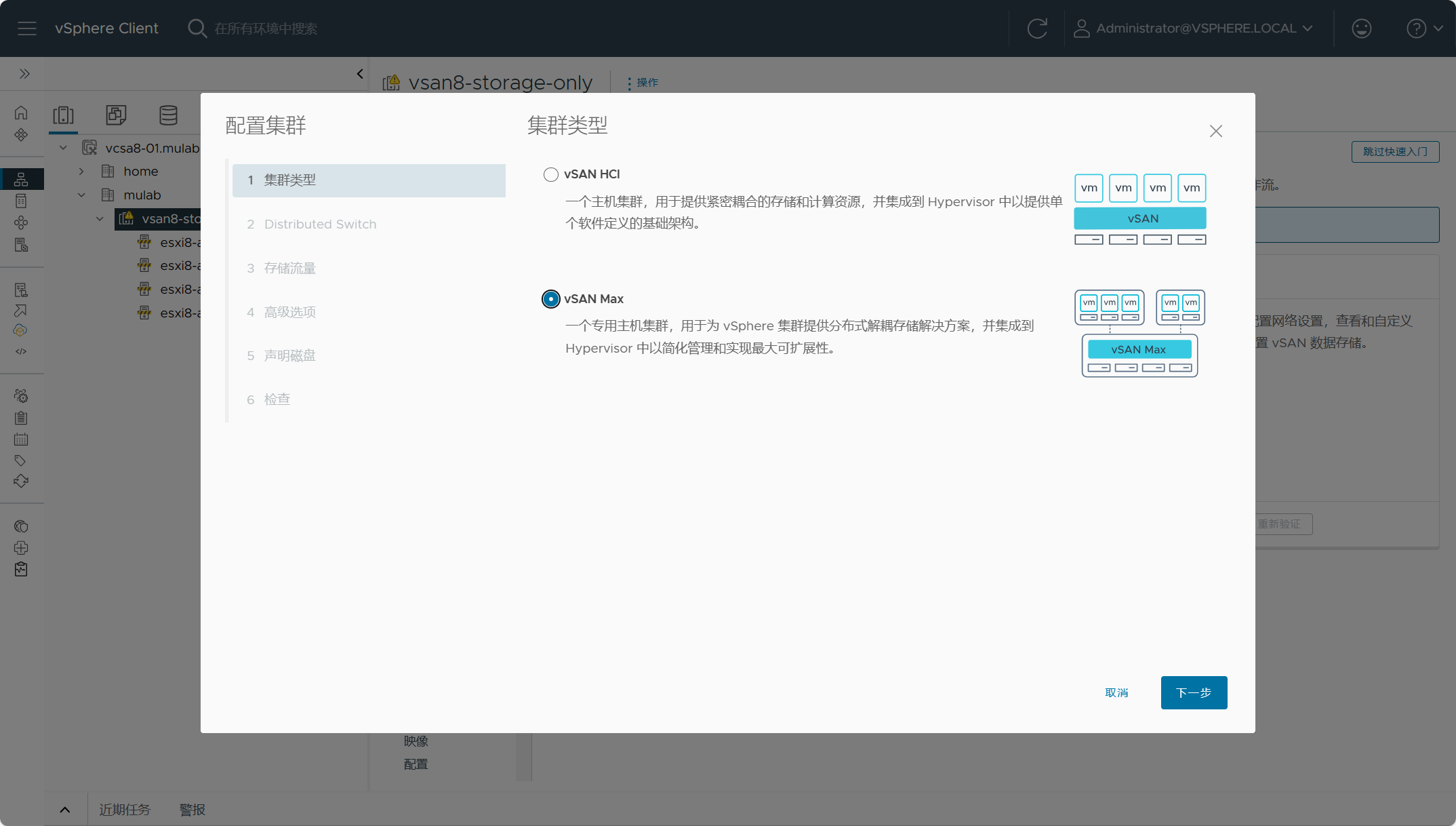

选择集群类型为vSAN Max,可以看到,其实整个流程跟vSAN HCI的配置是差不多的。

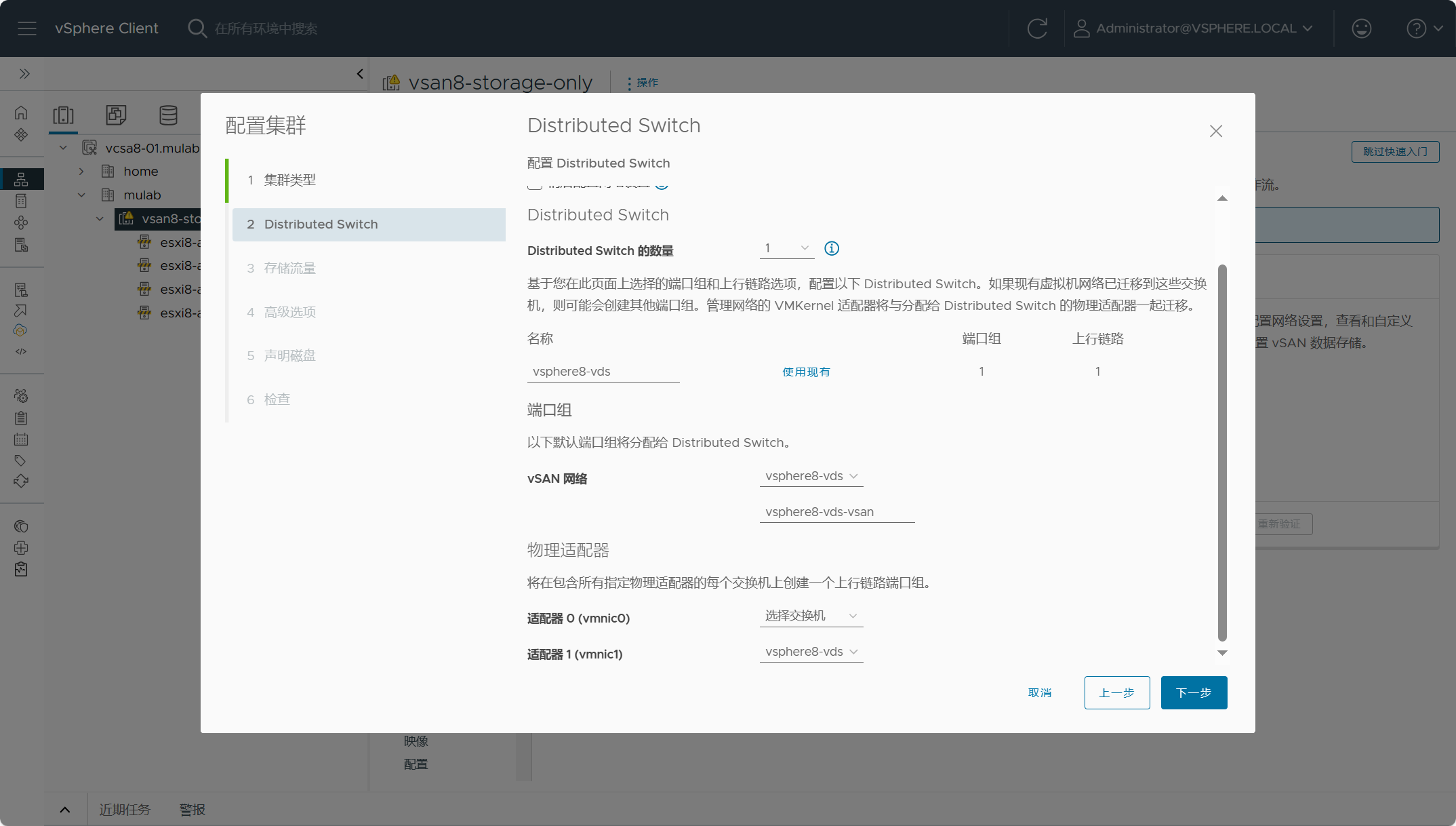

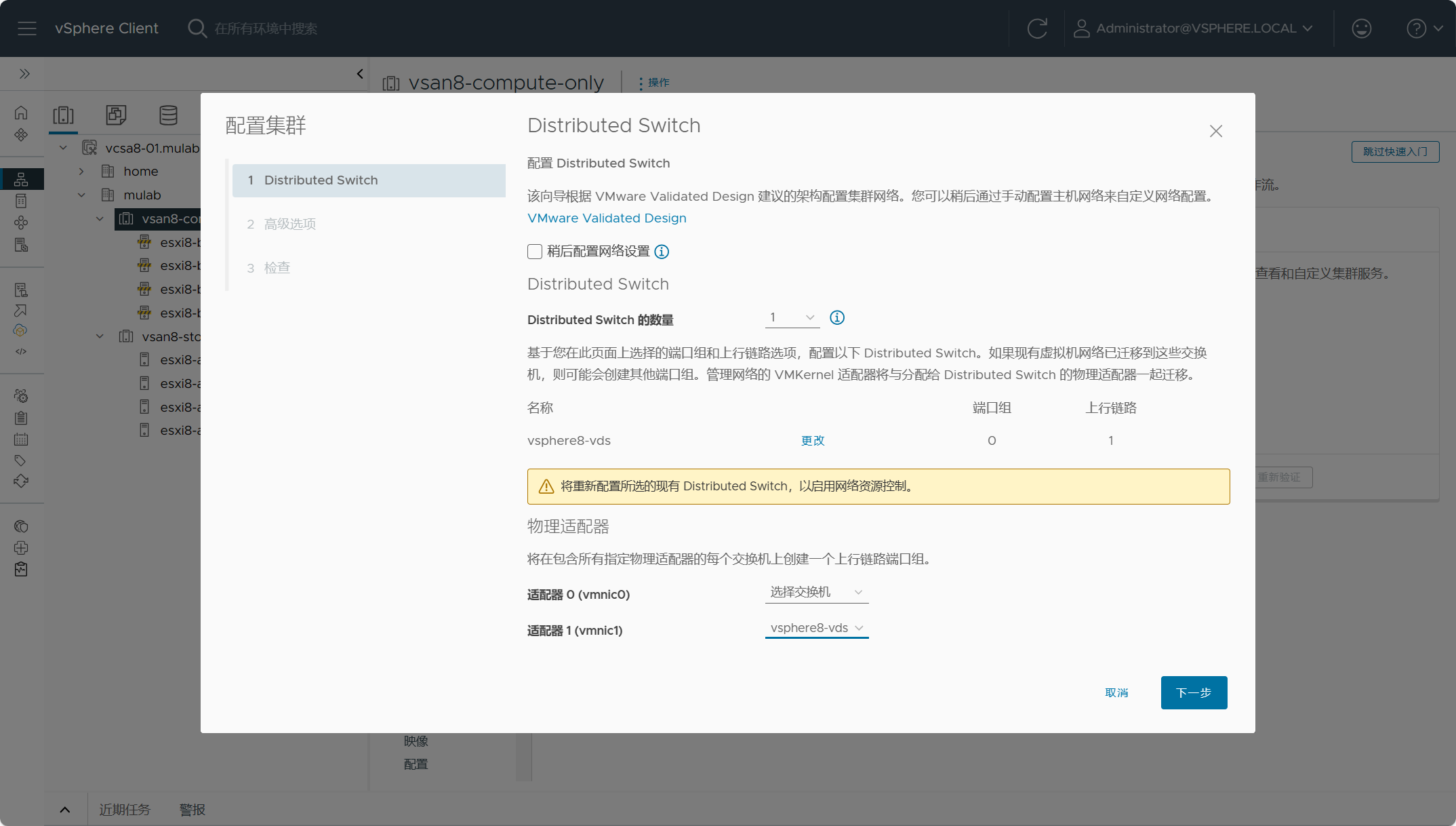

配置分布式交换机vsphere8-vds,配置分布式端口组vsphere8-vds-vsan,分配分布式交换机的上行链路。

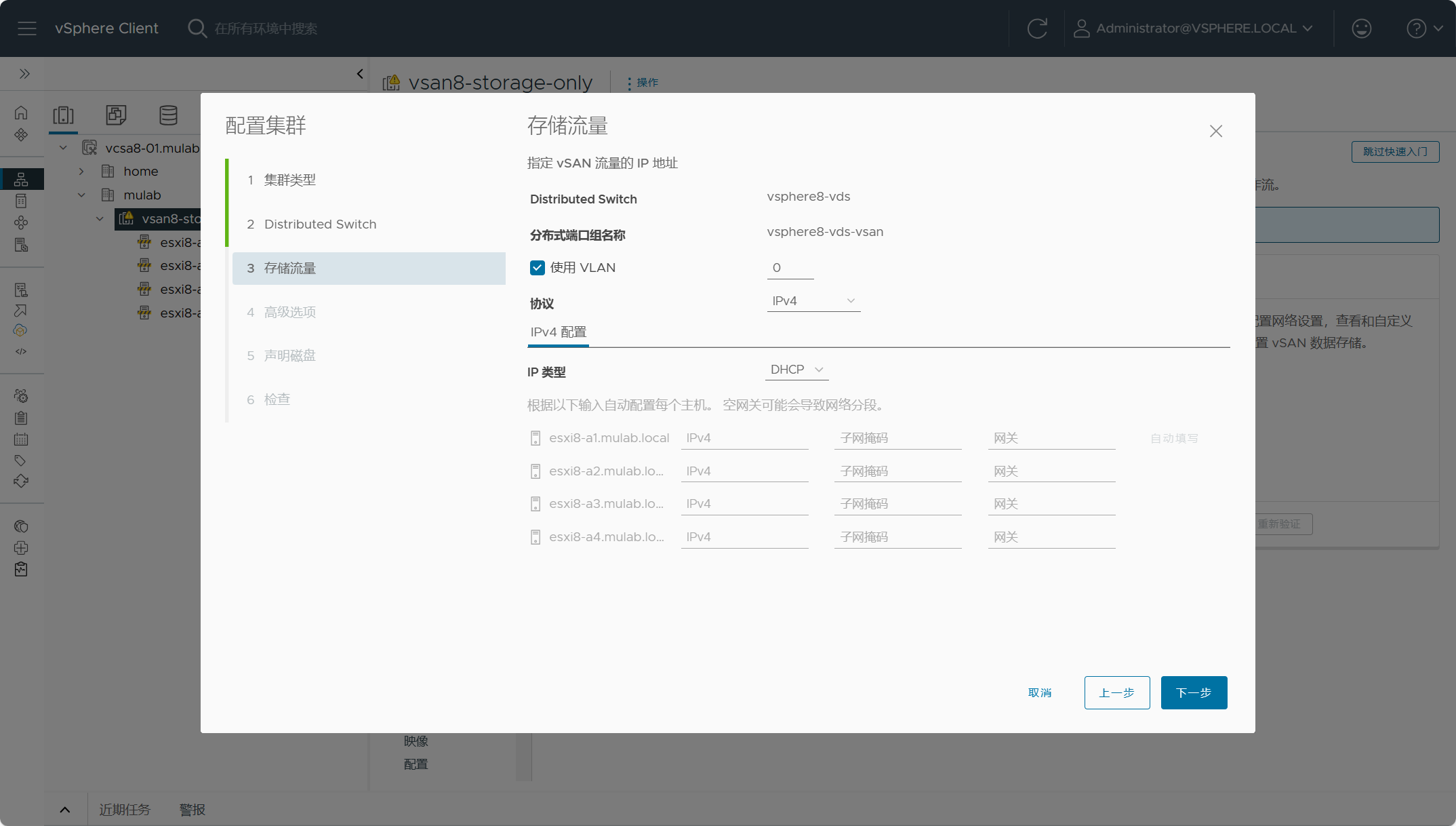

配置集群中所有主机用于vSAN流量的vmkernel端口及IP地址。

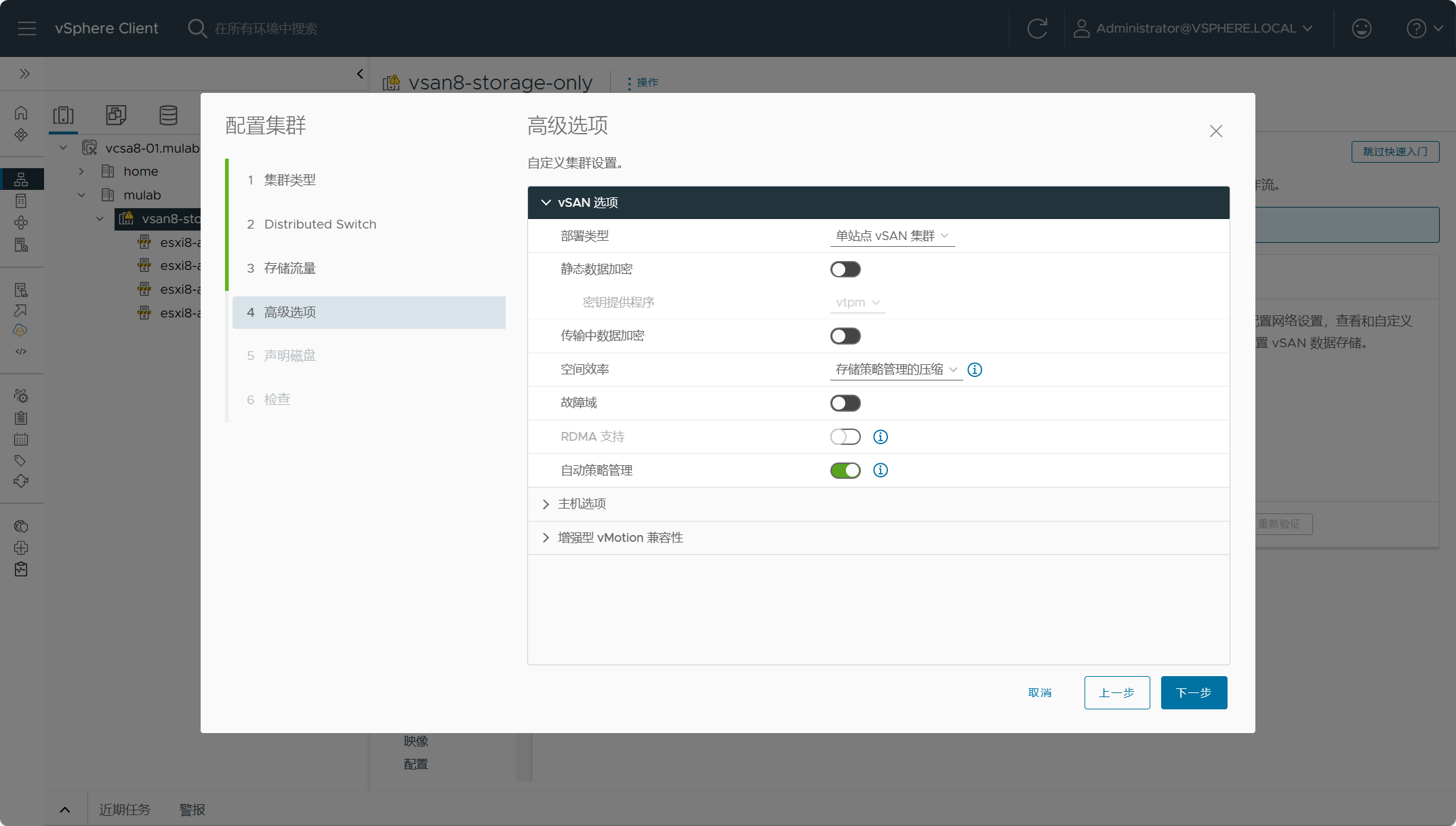

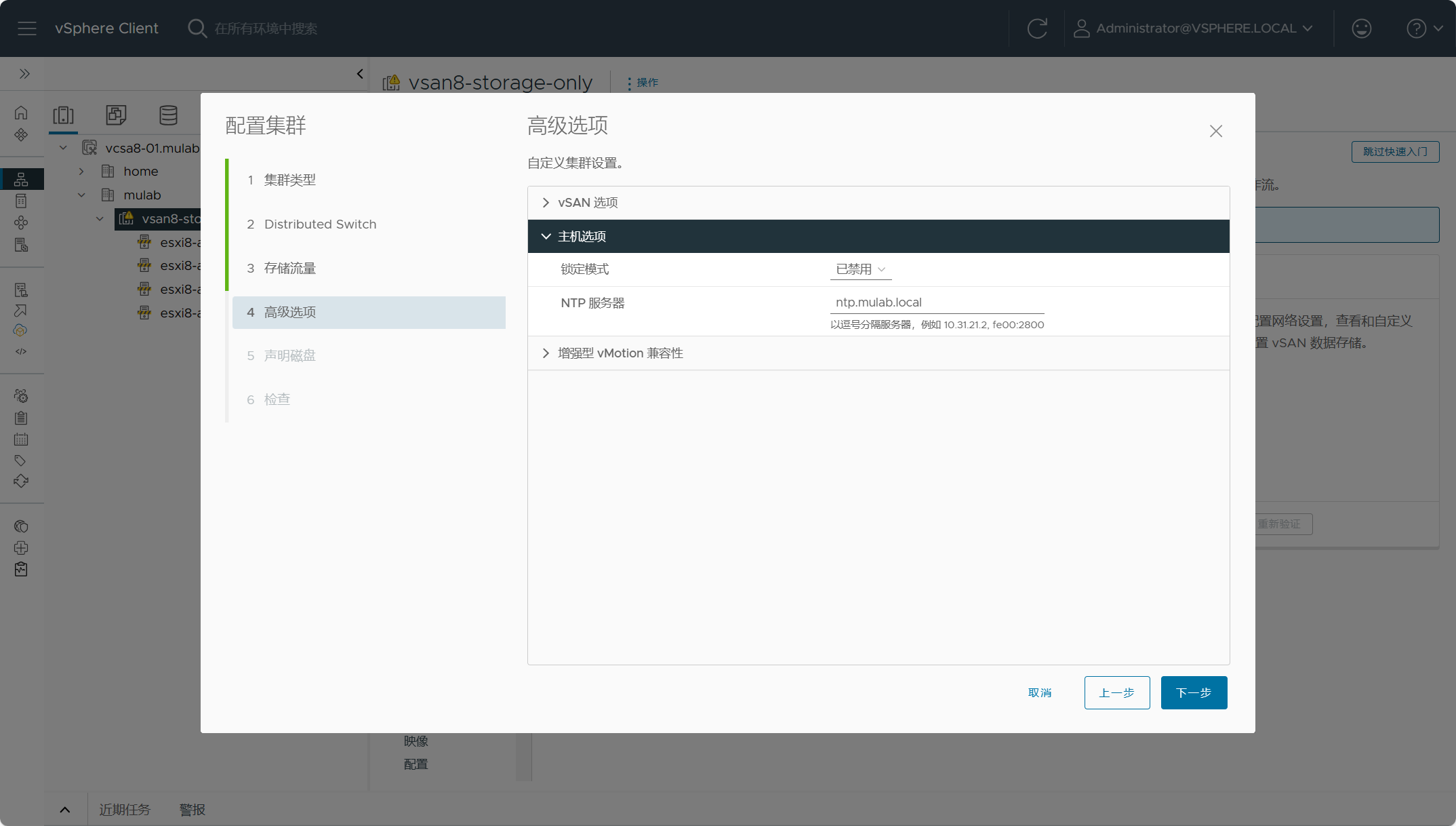

配置vSAN Max为单站点集群,其他设置保持默认即可。

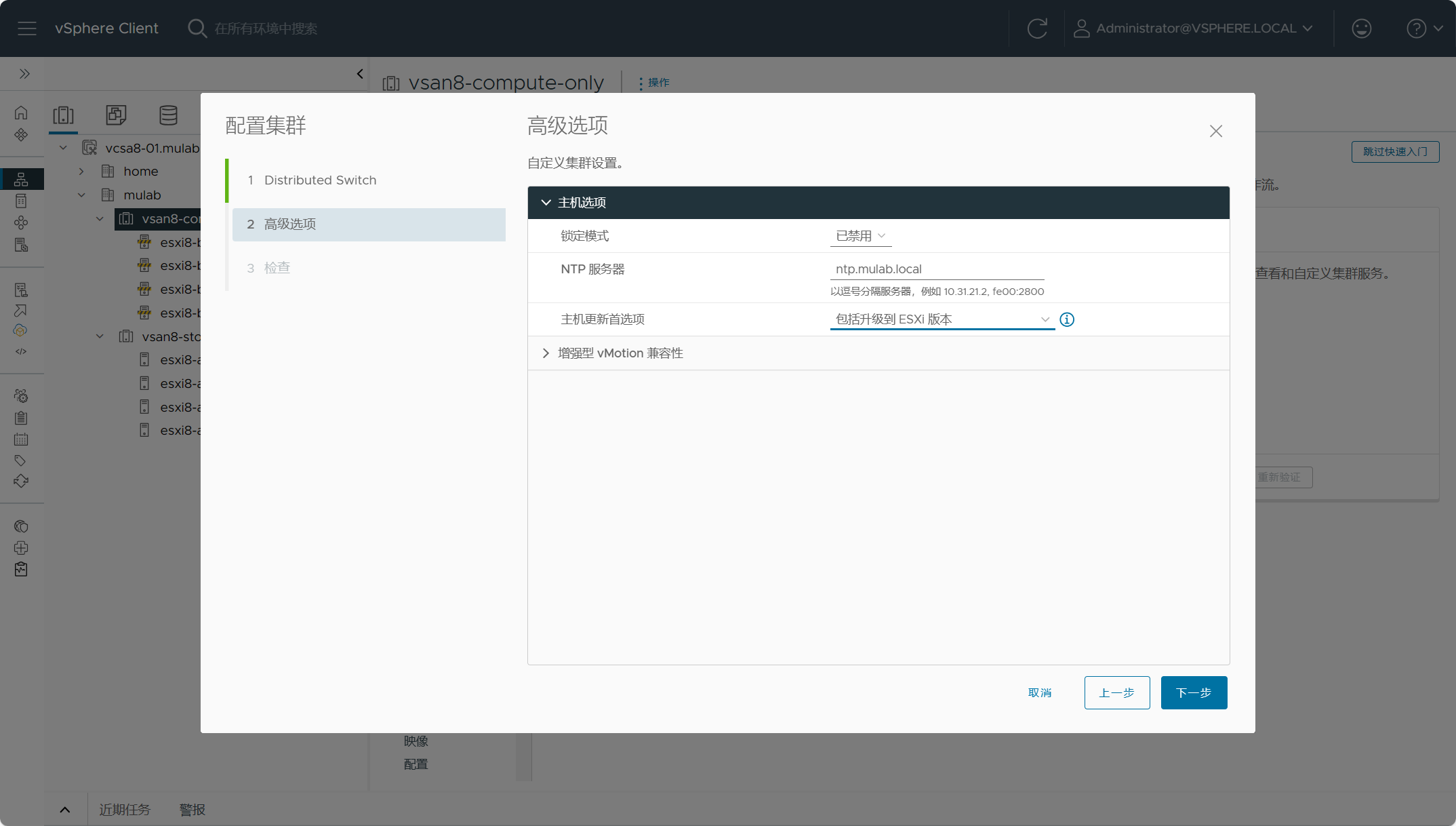

配置集群所有主机的NTP时钟服务器,建议所有主机都保持时间同步。

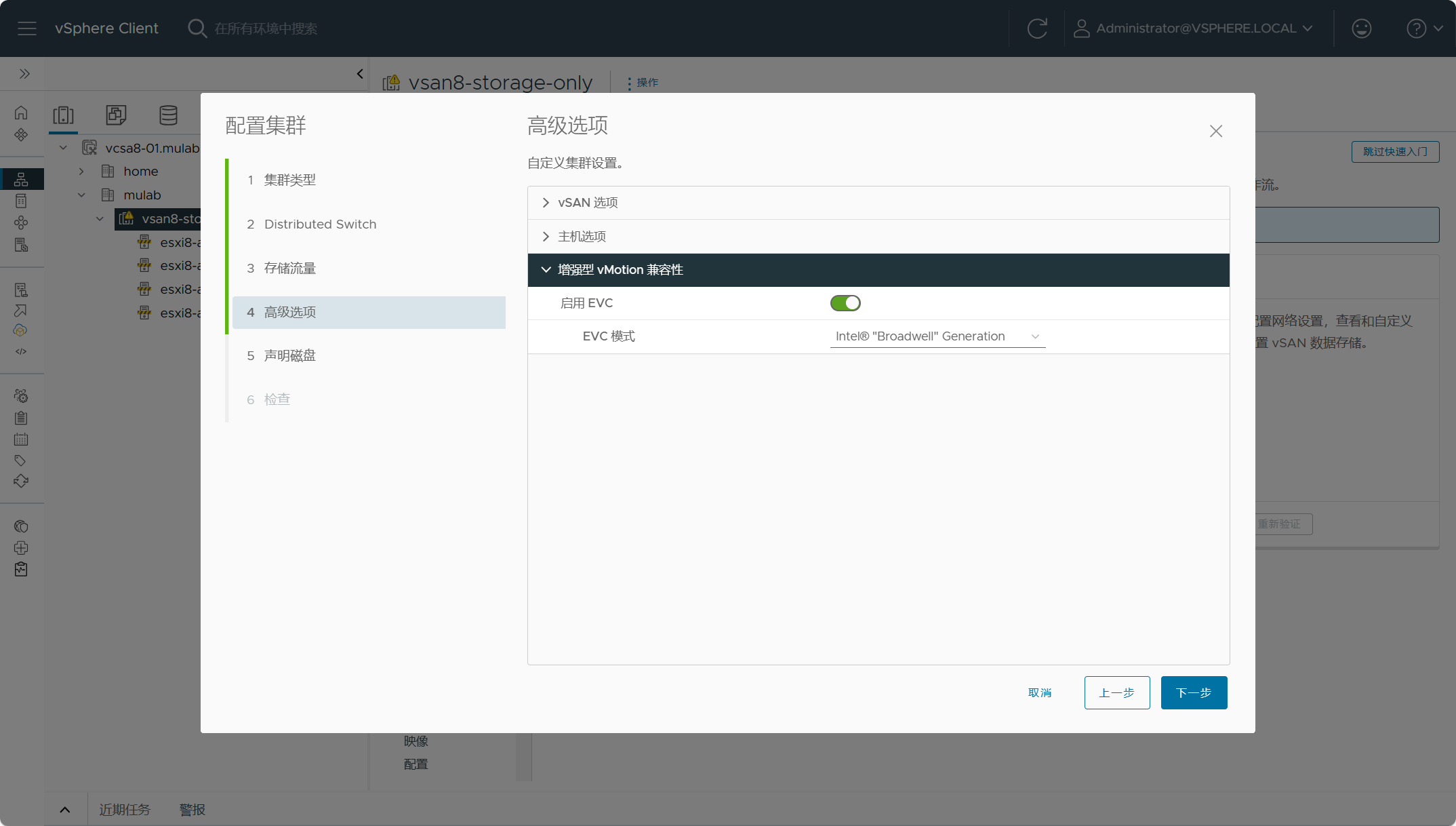

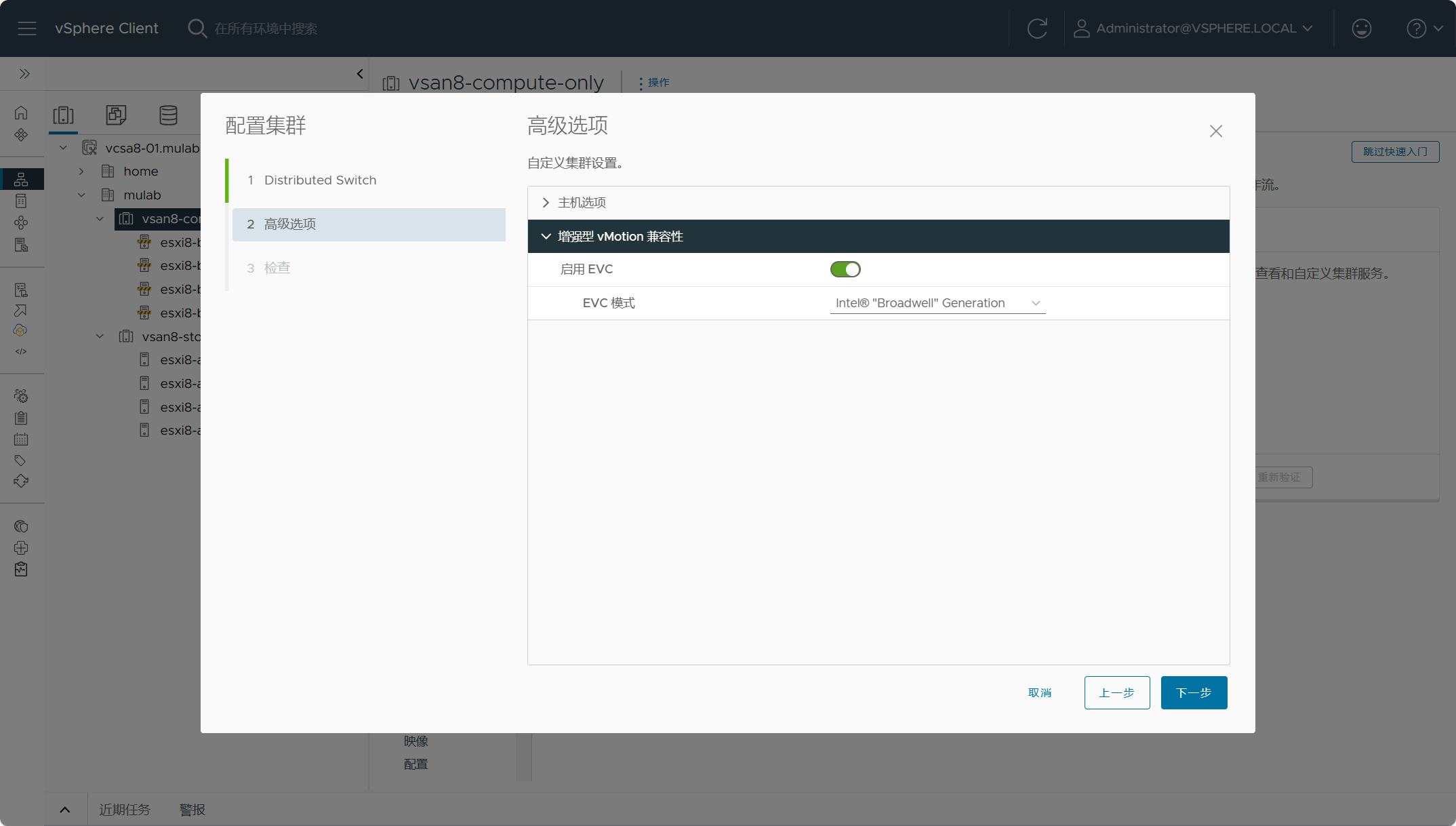

配置集群的EVC模式,建议默认都开启整个功能。

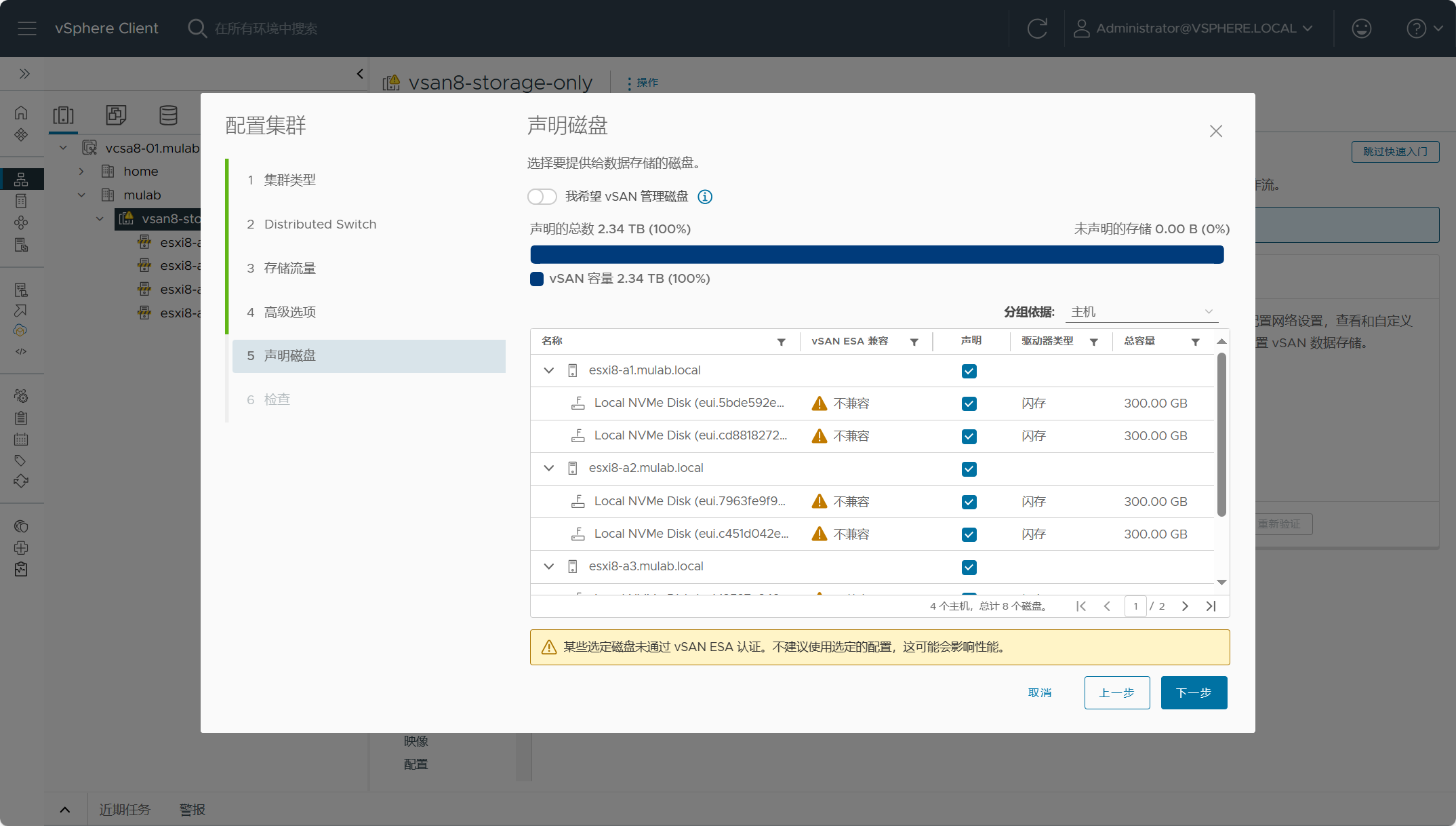

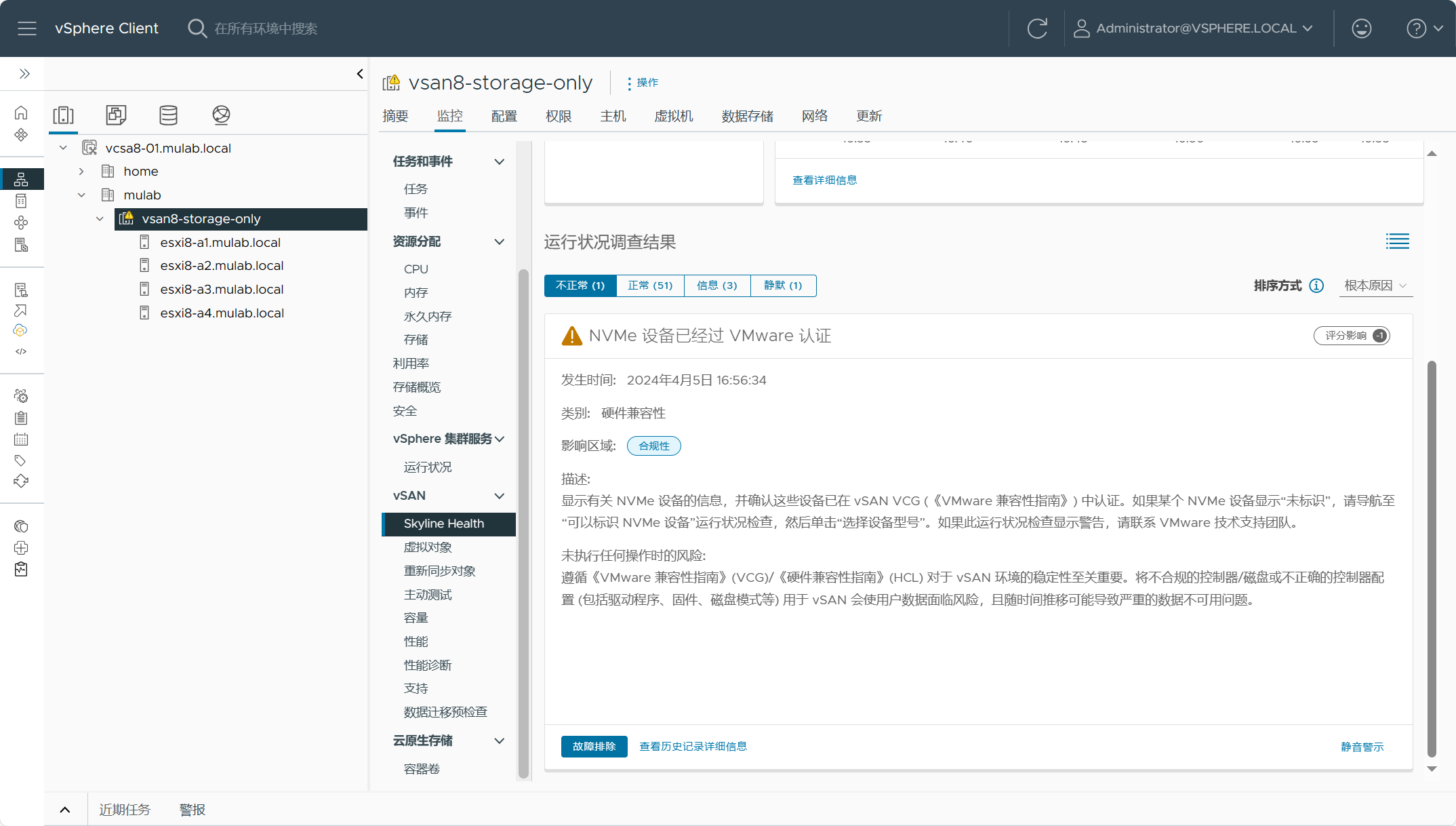

声明用于vSAN Max集群的主机磁盘,由于磁盘不兼容无法开启磁盘的自动声明。

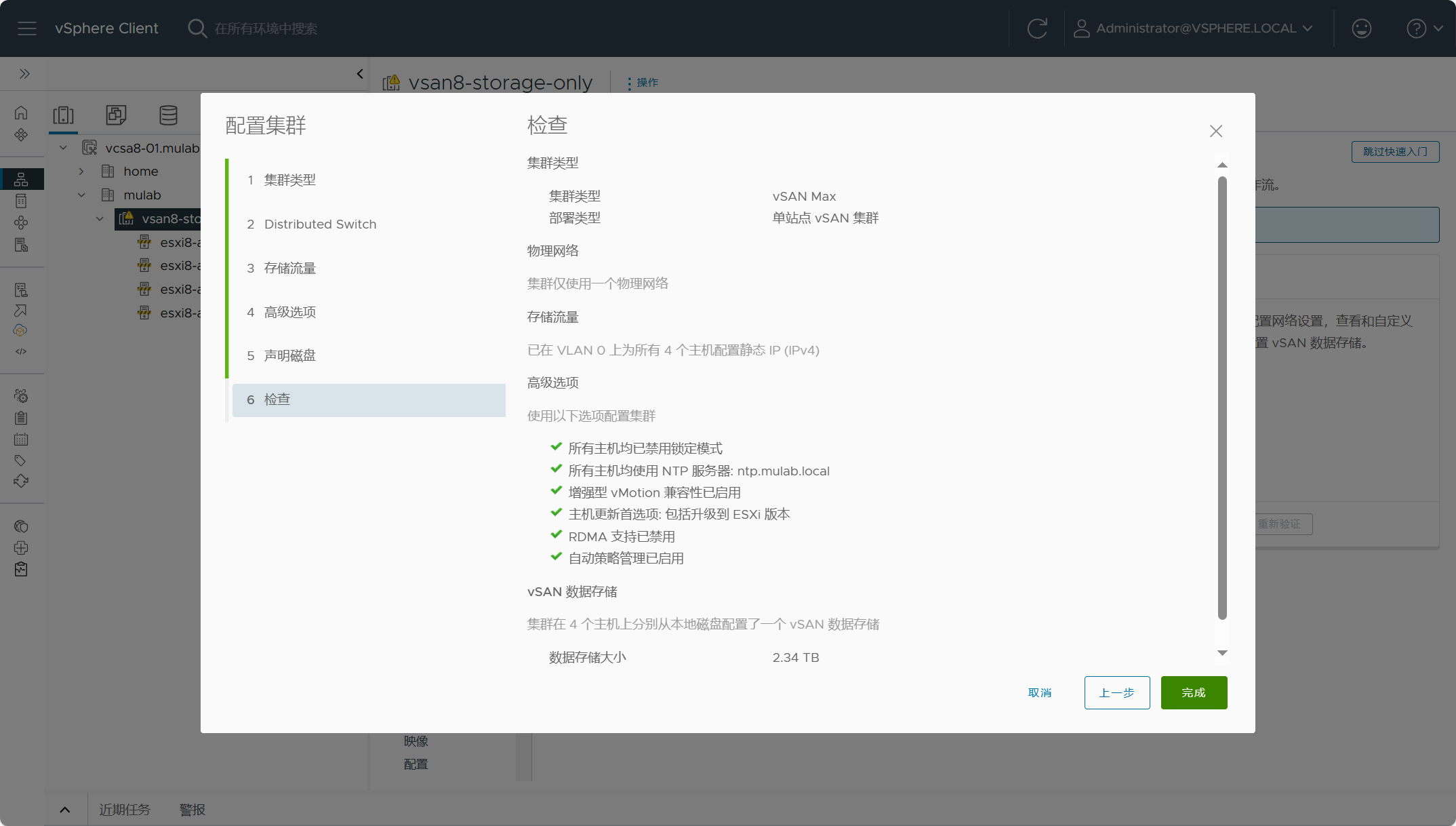

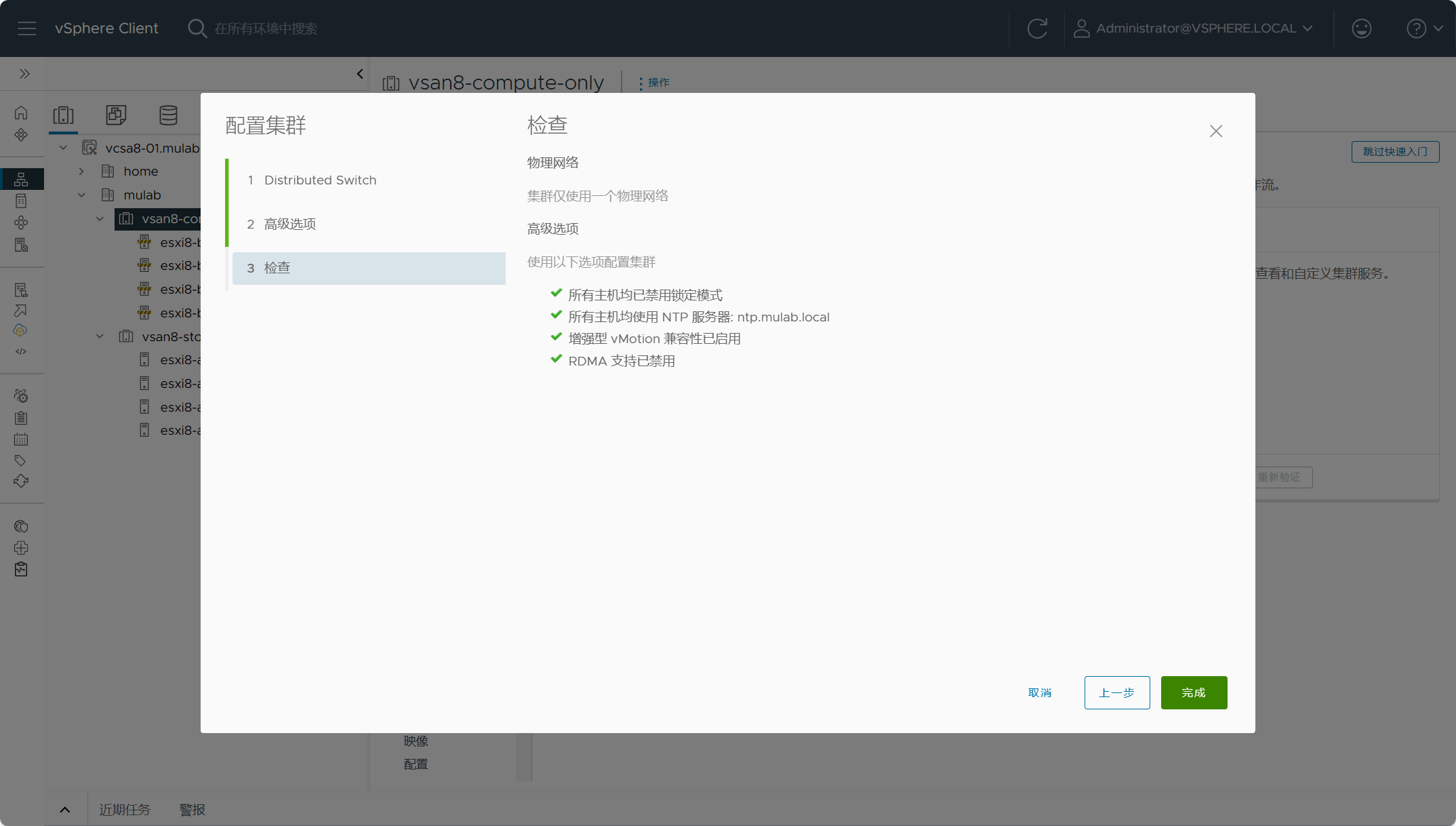

检查配置,确认无误,点击完成开始配置vSAN Max。

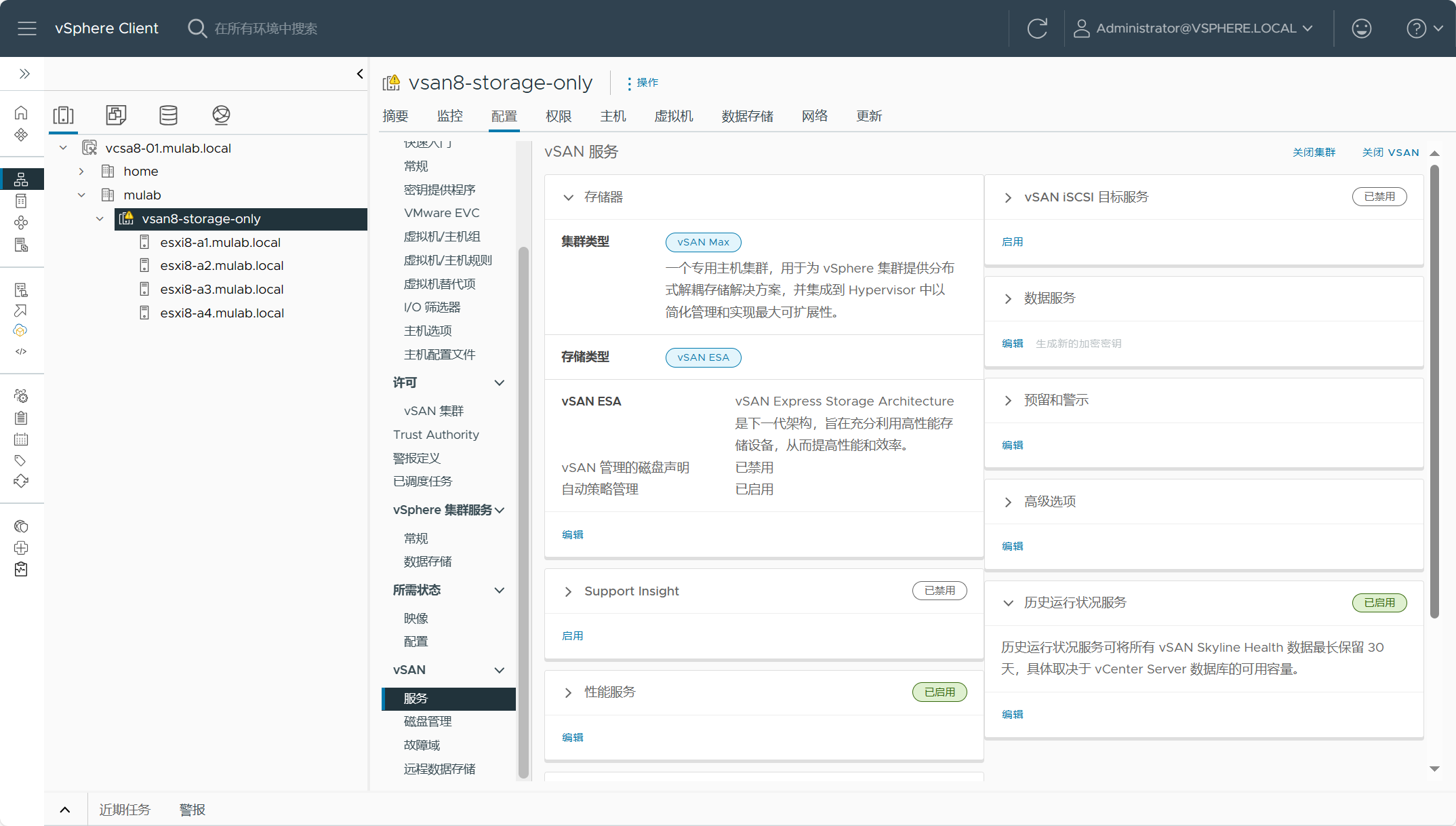

如果一切顺利,等待片刻后,vSAN Max集群已创建完成。

后续操作,解决vSAN Skyline Health检查的所有问题,可以开启集群的其他高级服务,如DRS、HA等。

注意,如果你像我一样使用的嵌套实验环境,请给每台ESXi主机添加更多的内存(至少24G),不然vSAN服务会不能正常开启。

二、配置vSAN 计算集群

vSAN 计算集群是一个标准的vSphere集群(Compute Only),开启后会在该集群主机上面配置一个精简的vSAN,用于作为客户端(Client)集群来挂载远程服务器端(Server)集群,比如vSAN Max。开启了vSAN 计算集群功能的vSphere集群不需要vSAN 许可。但是,要注意如果要挂载 vSAN Max 数据存储,则vSphere 群集中的主机必须运行 vSphere 8 或更高版本。同时,由于vSAN 计算集群使用vSAN Max/HCI数据存储,同样需要为vSAN 计算集群配置vSAN网络,以确保客户端集群能访问服务器端集群存储网络,支持L2 或 L3。

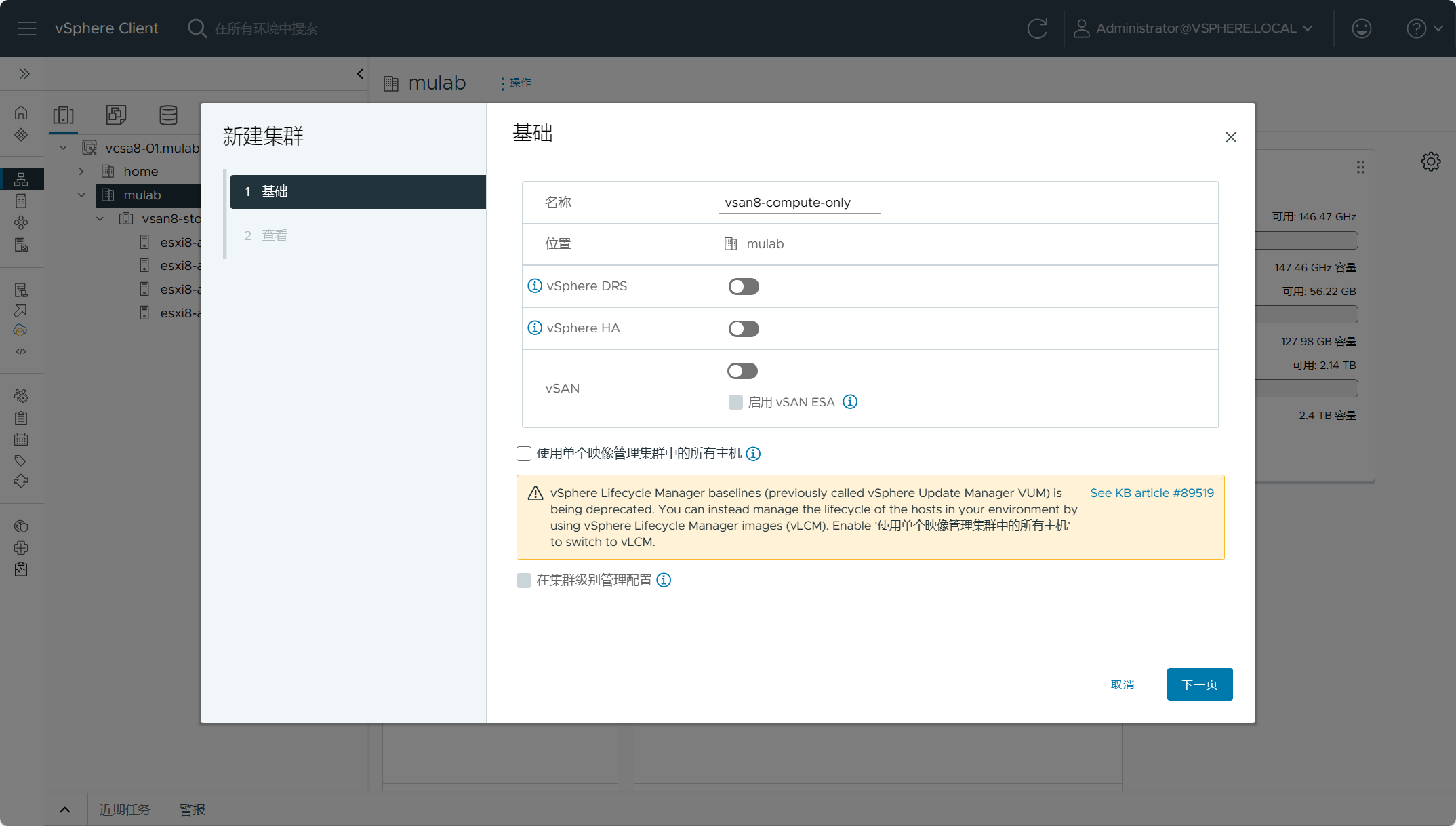

登录vSphere Client,导航到数据中心(mulab),右击选择“新建集群”。

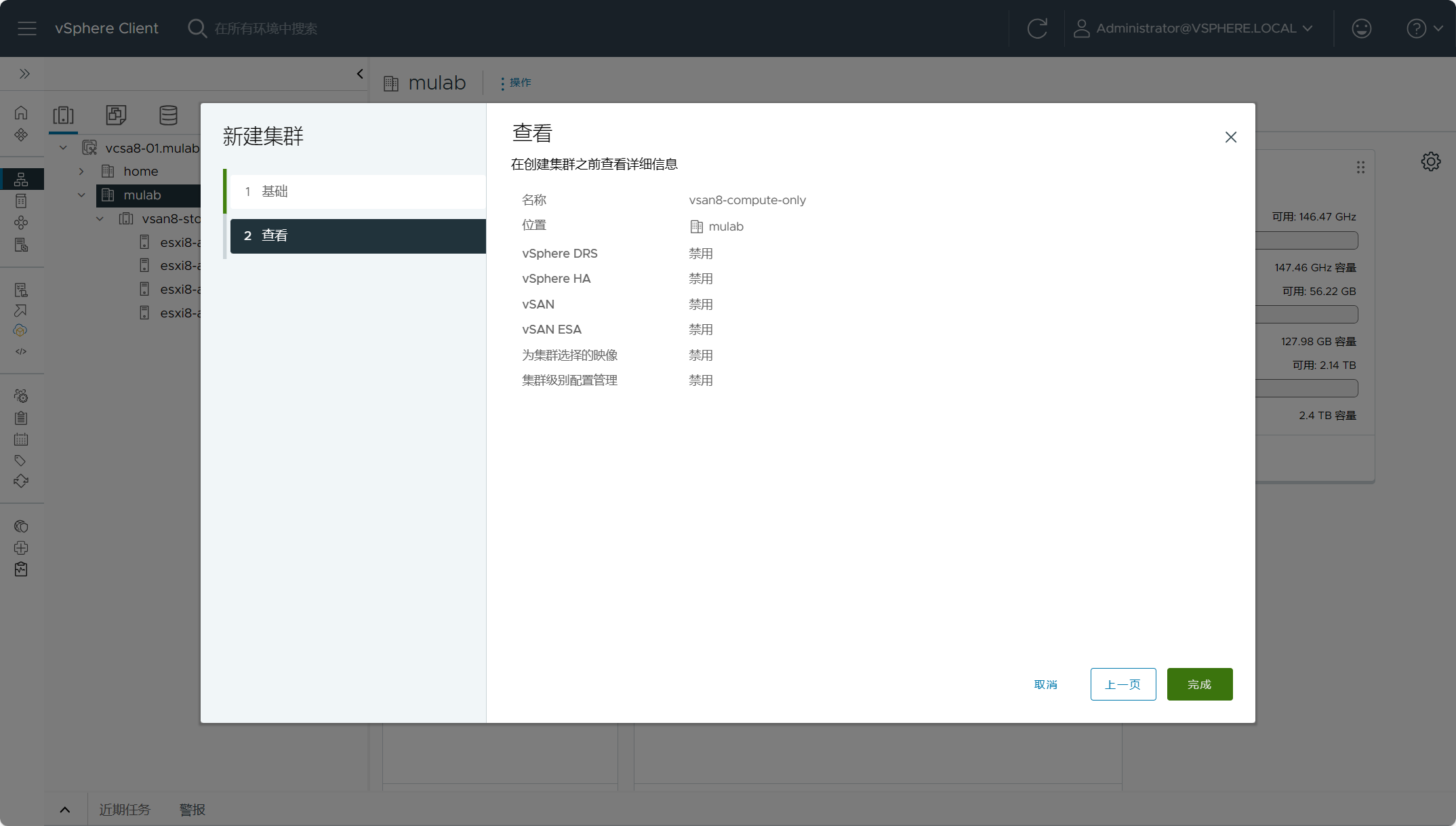

设置vSAN 计算集群名称,根据需要选择开启集群的高级服务,不用勾选vSAN,集群基于映像管理也可以根据需要自行设置。

点击完成创建。

同样,还是使用集群快速配置向导,点击添加主机。

设置主机的凭据。

主机摘要信息。

确认信息,所有主机将被添加至集群并进入维护模式。

所有主机已被添加进集群,下面开始配置集群设置。

配置分布式交换机,由于之前已经创建了分布式交换机vsphere8-vds,直接使用现有的即可。

配置集群内所有主机的NTP时钟服务器。

同样,默认开启集群的EVC模式。

检查无误,点击完成配置。

注:上述方式只是为了方便对集群内的所有主机进行统一配置,也可以选择手动进行配置。

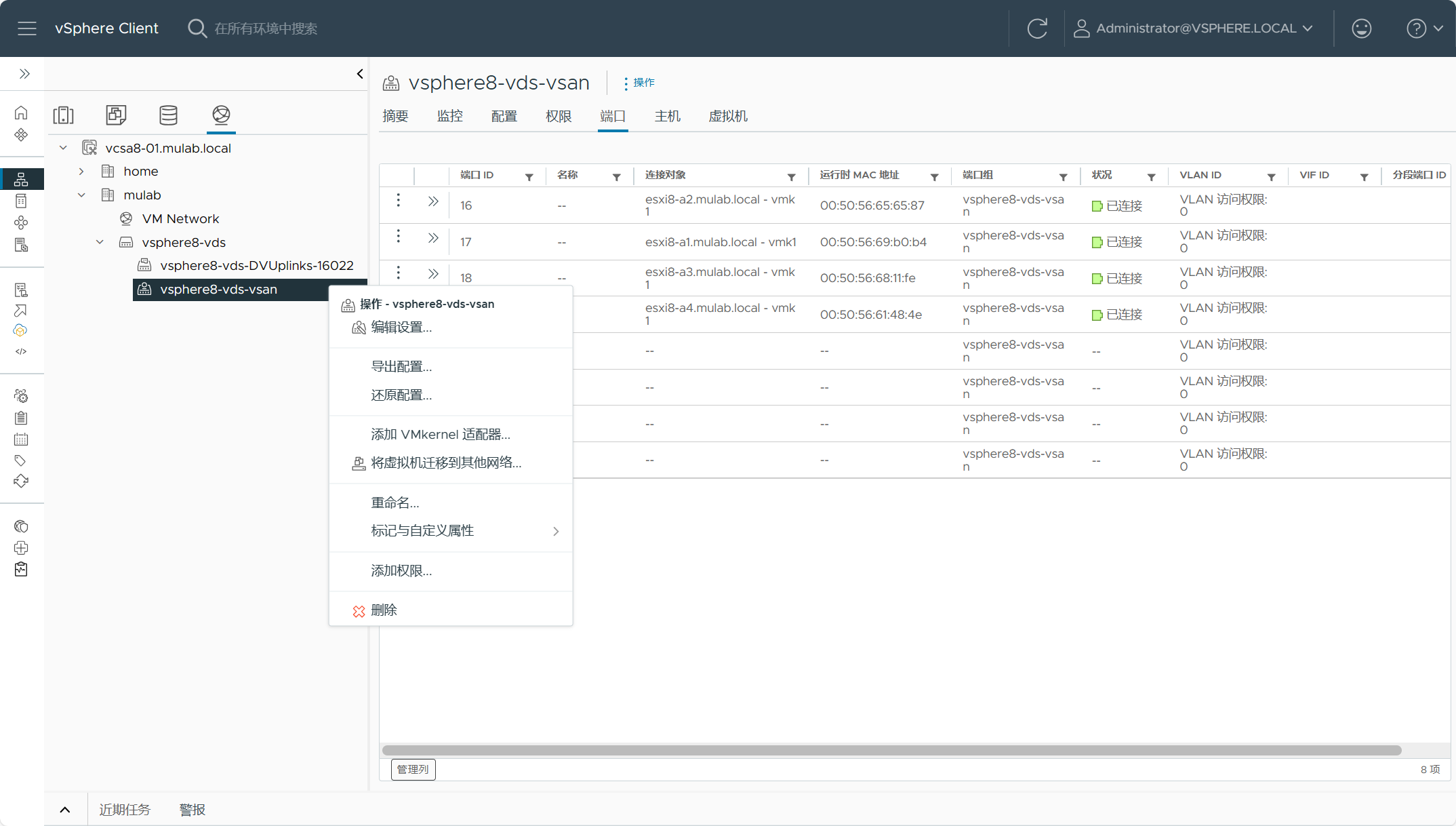

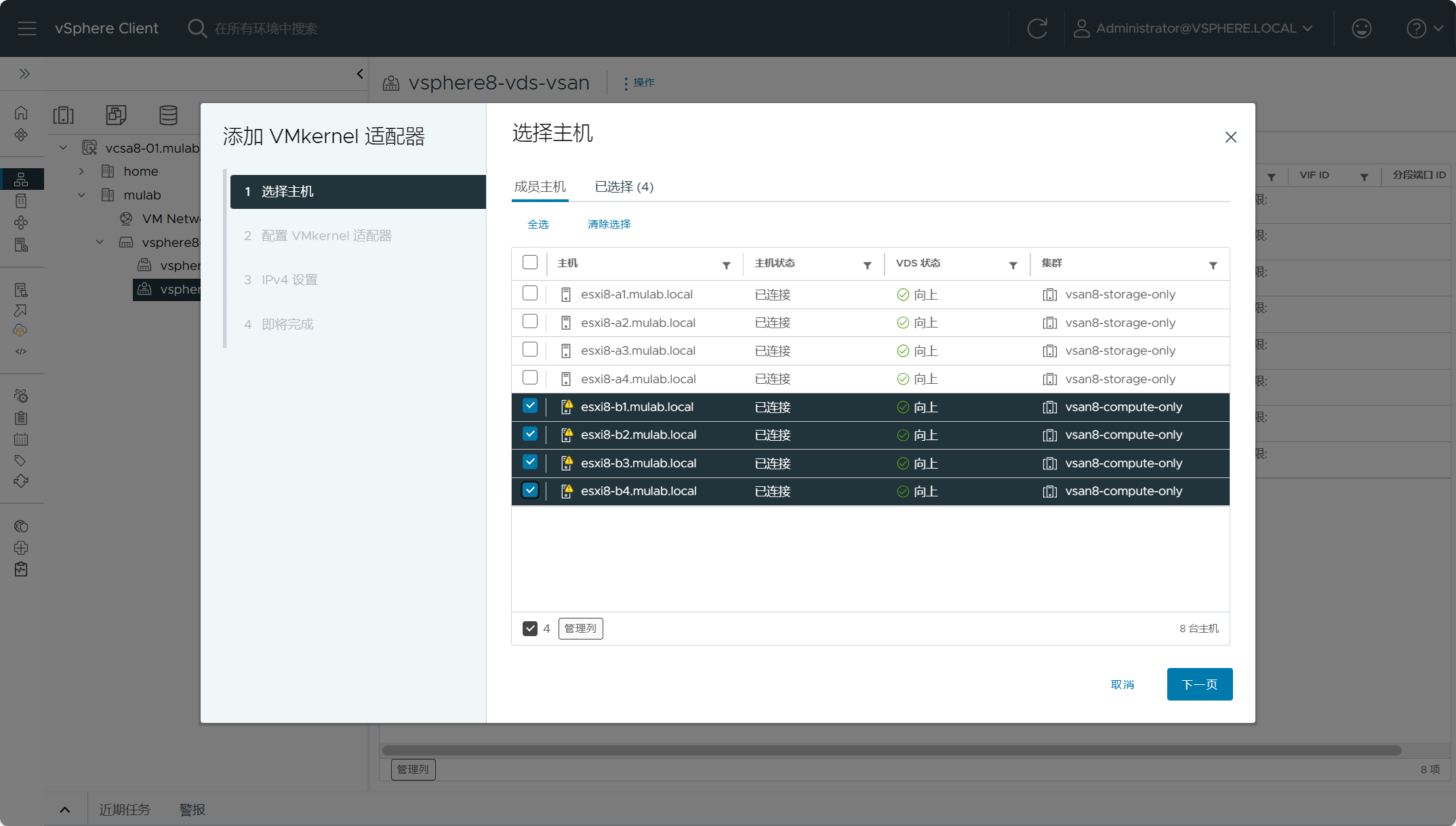

下面为所有主机配置用于vSAN流量的vmkernel网卡,展开网络设置-分布式交换机-分布式端口组,右击选择“添加vmkernel适配器”。

选择vSAN 计算集群的所有主机,点击下一步。

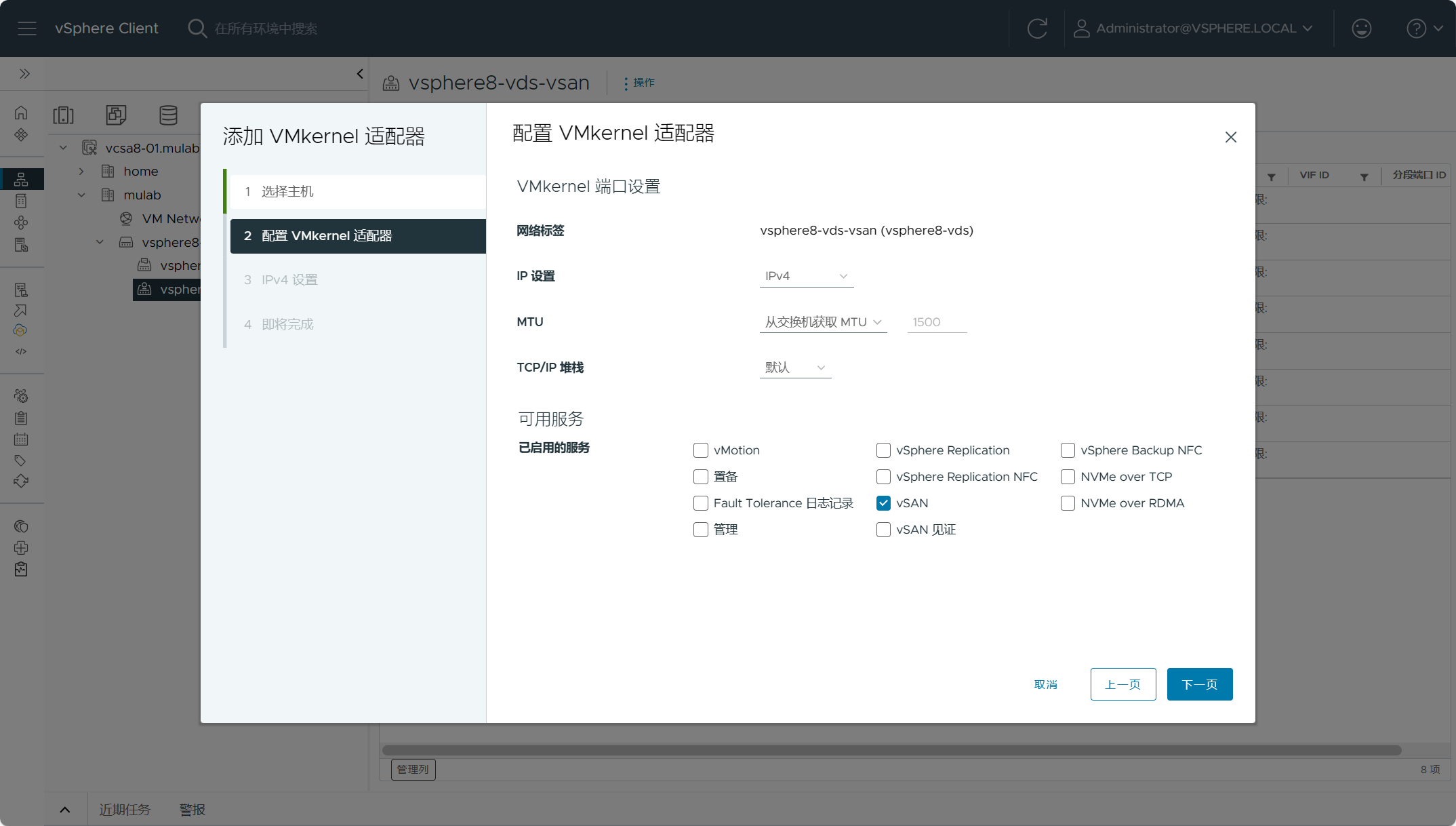

勾选“vSAN”服务。

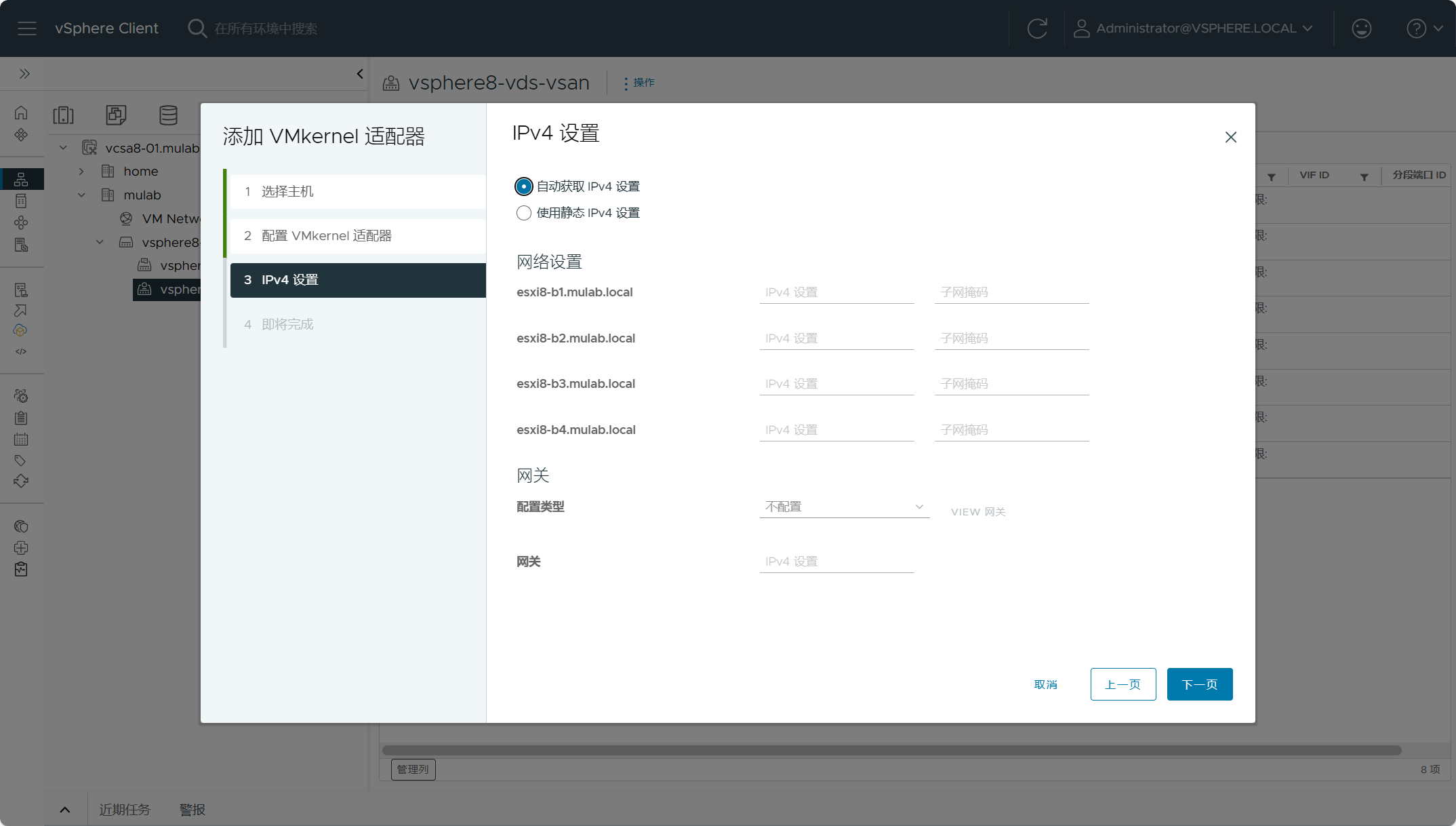

设置vmkernel的IP地址。

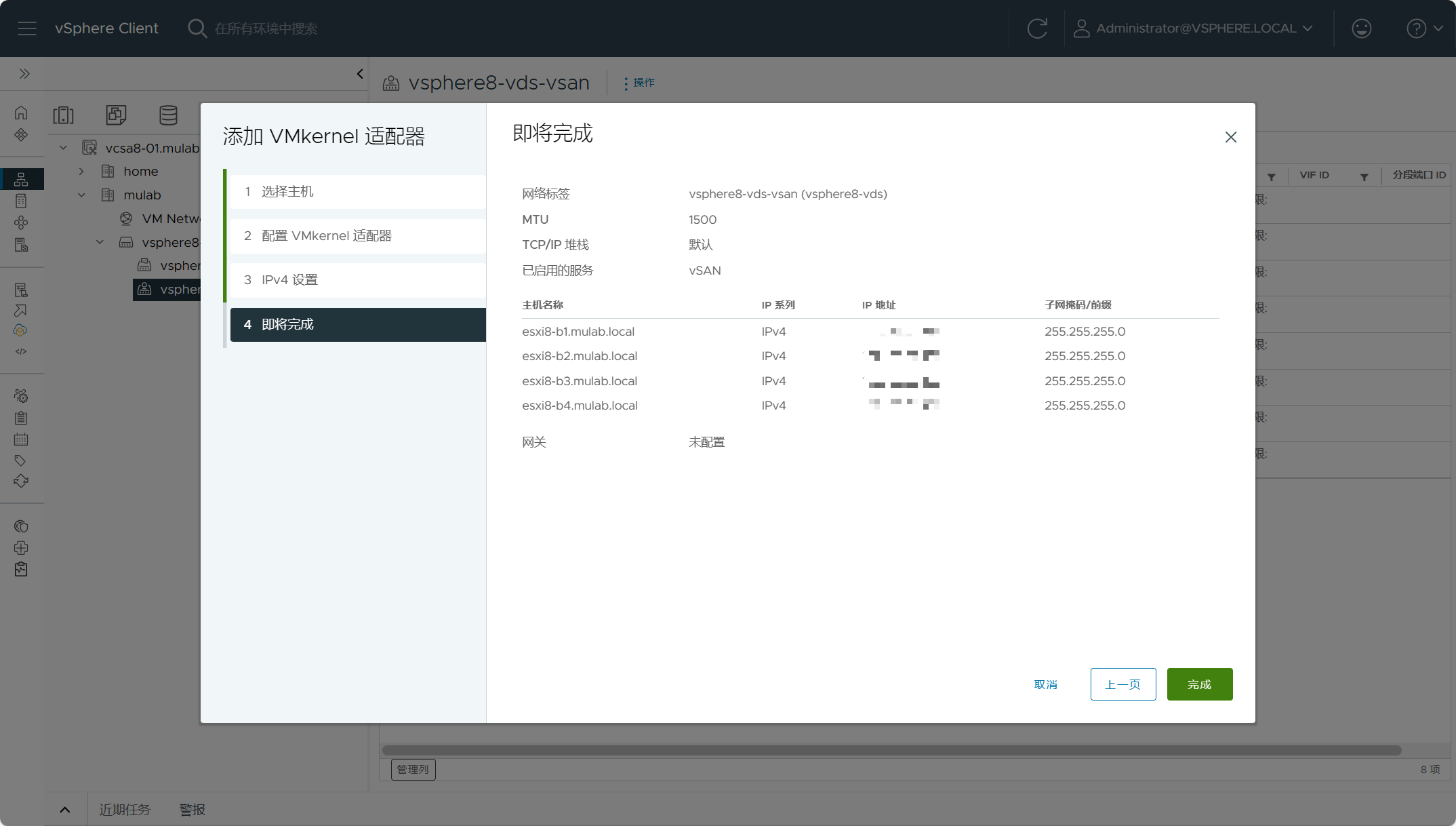

确认信息,点击完成添加。

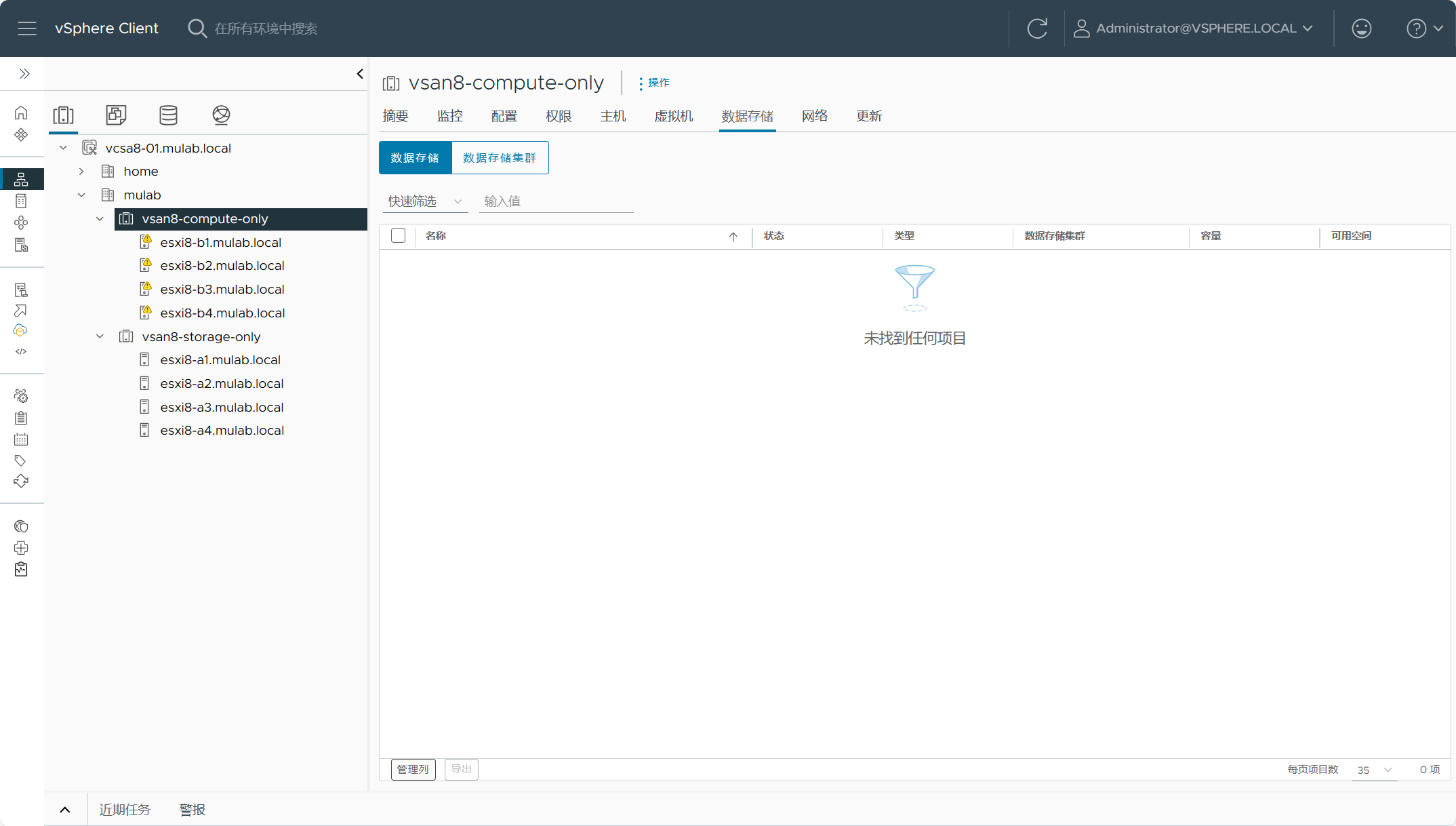

目前,vSAN计算集群内所有主机都没有本地存储,当然有本地存储也可以配置vSAN 计算集群。

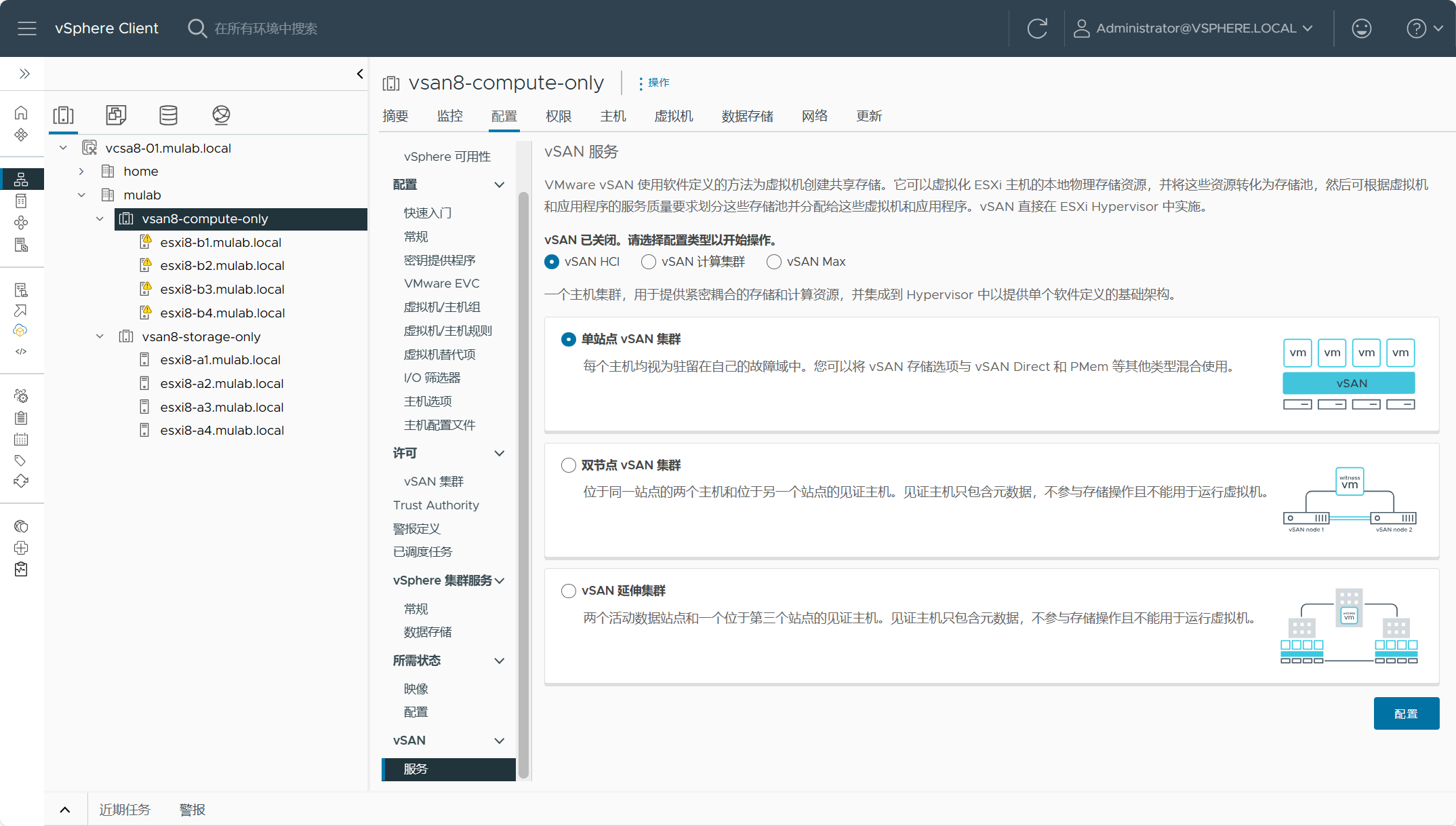

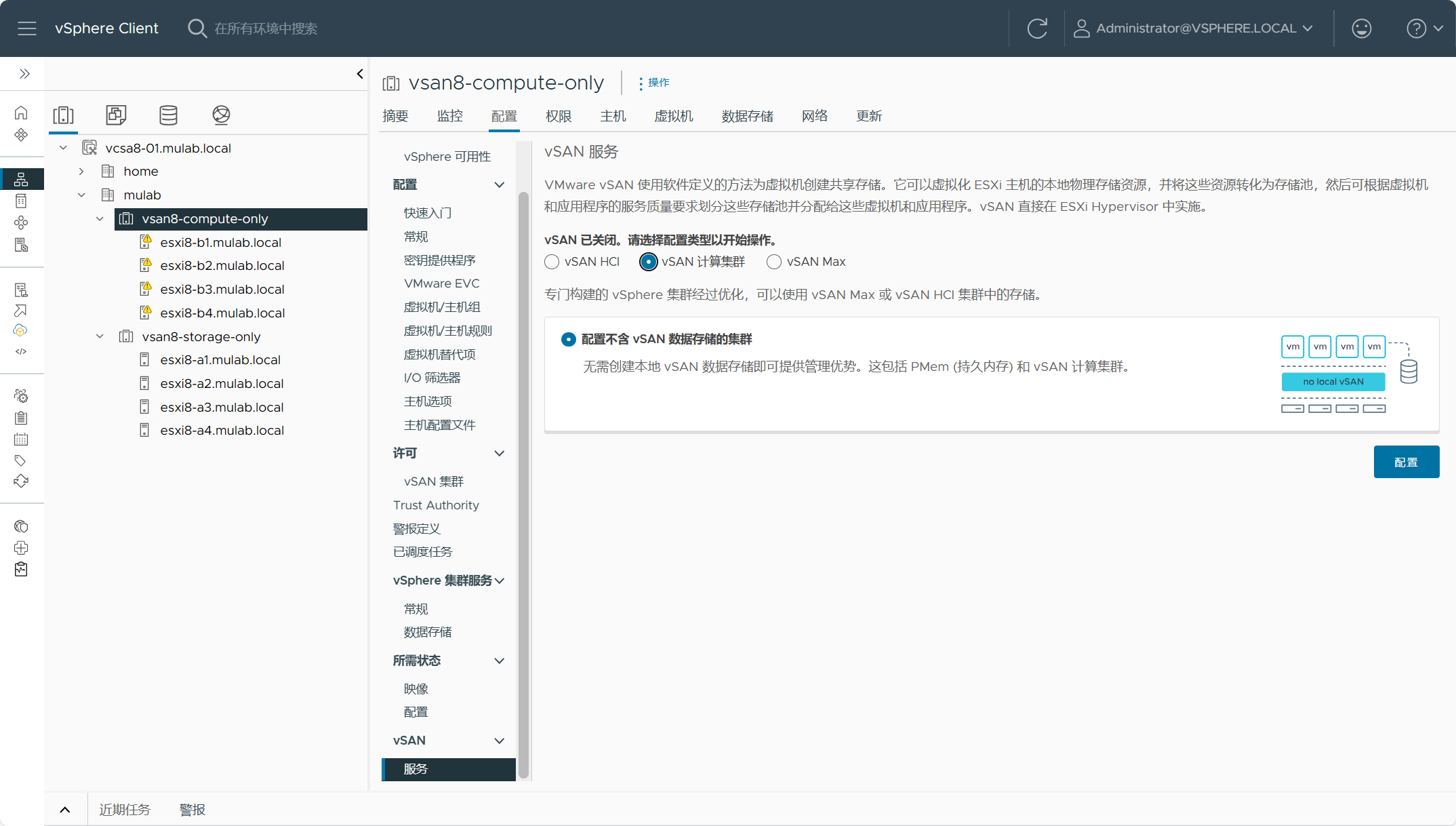

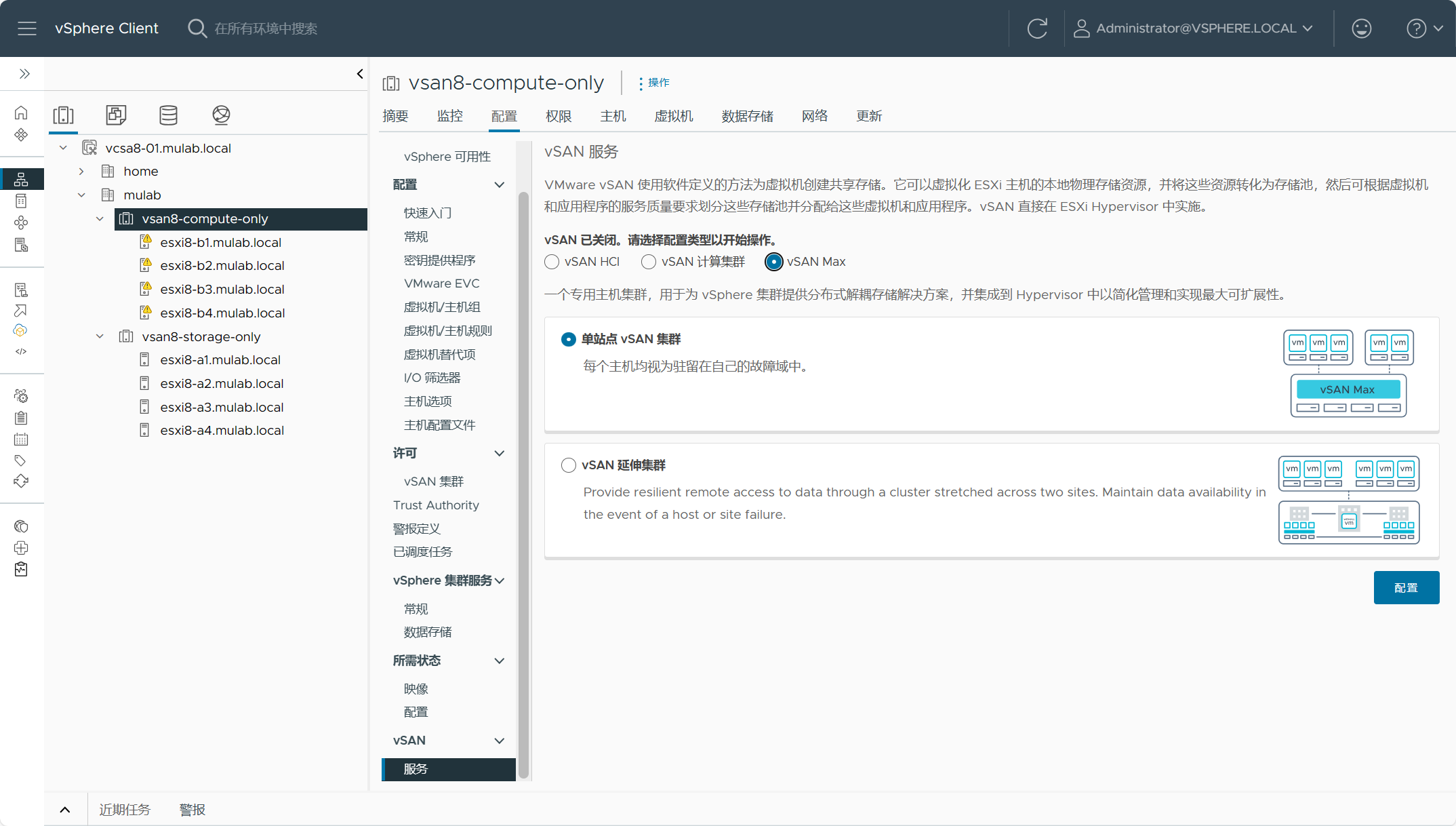

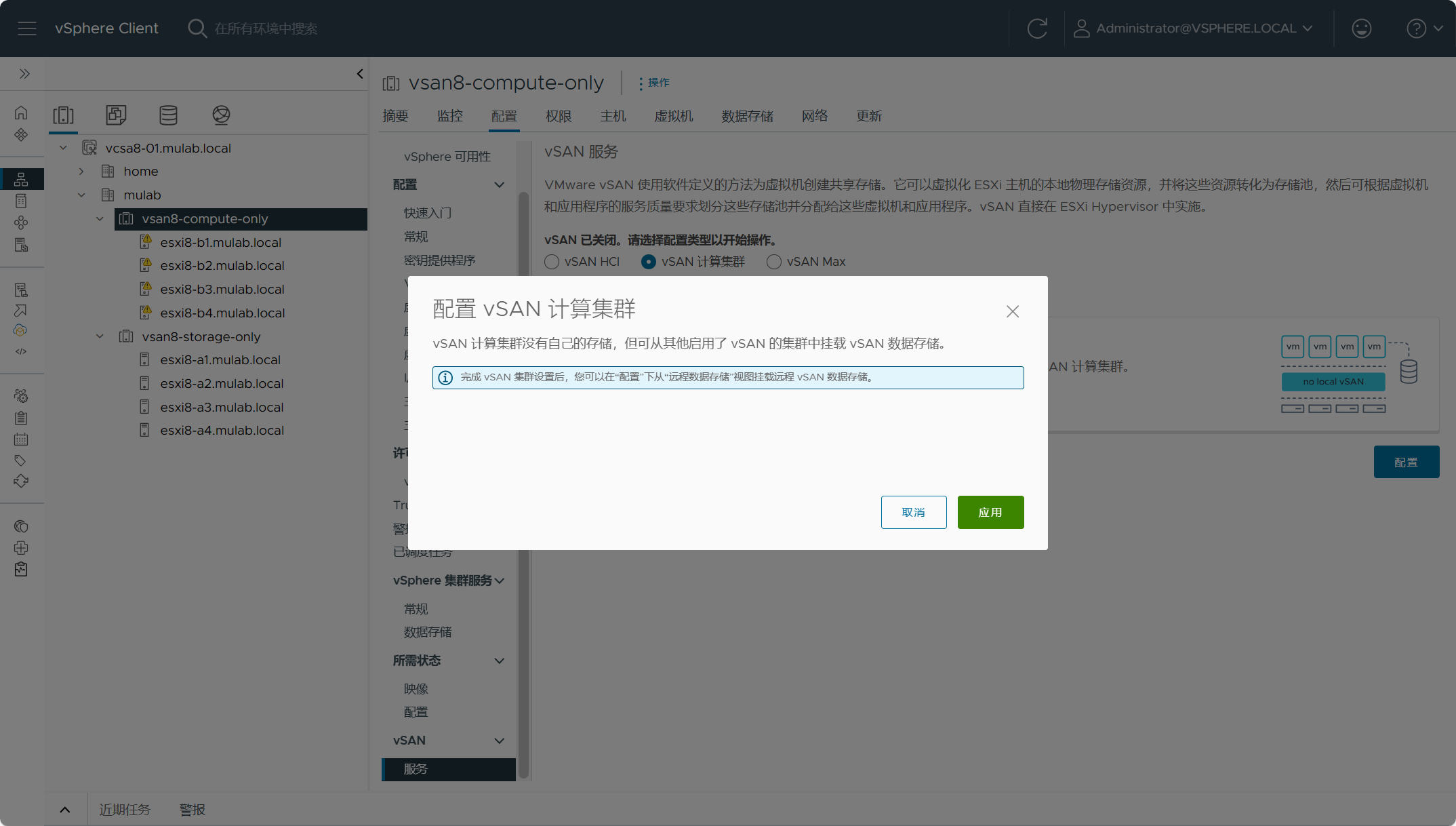

展开集群配置(vsan8-compute-only)-vSAN-服务,可以看到vSAN支持三种配置类型,vSAN HCI、vSAN 计算集群和vSAN Max。

如果不在集群快速配置向导里配置,也可以到这个地方进行配置。不过在创建集群的时候不能选择开启vSAN。

我需要将该集群配置为vSAN 计算集群,所以选择第二个,点击配置,直接应用即可。

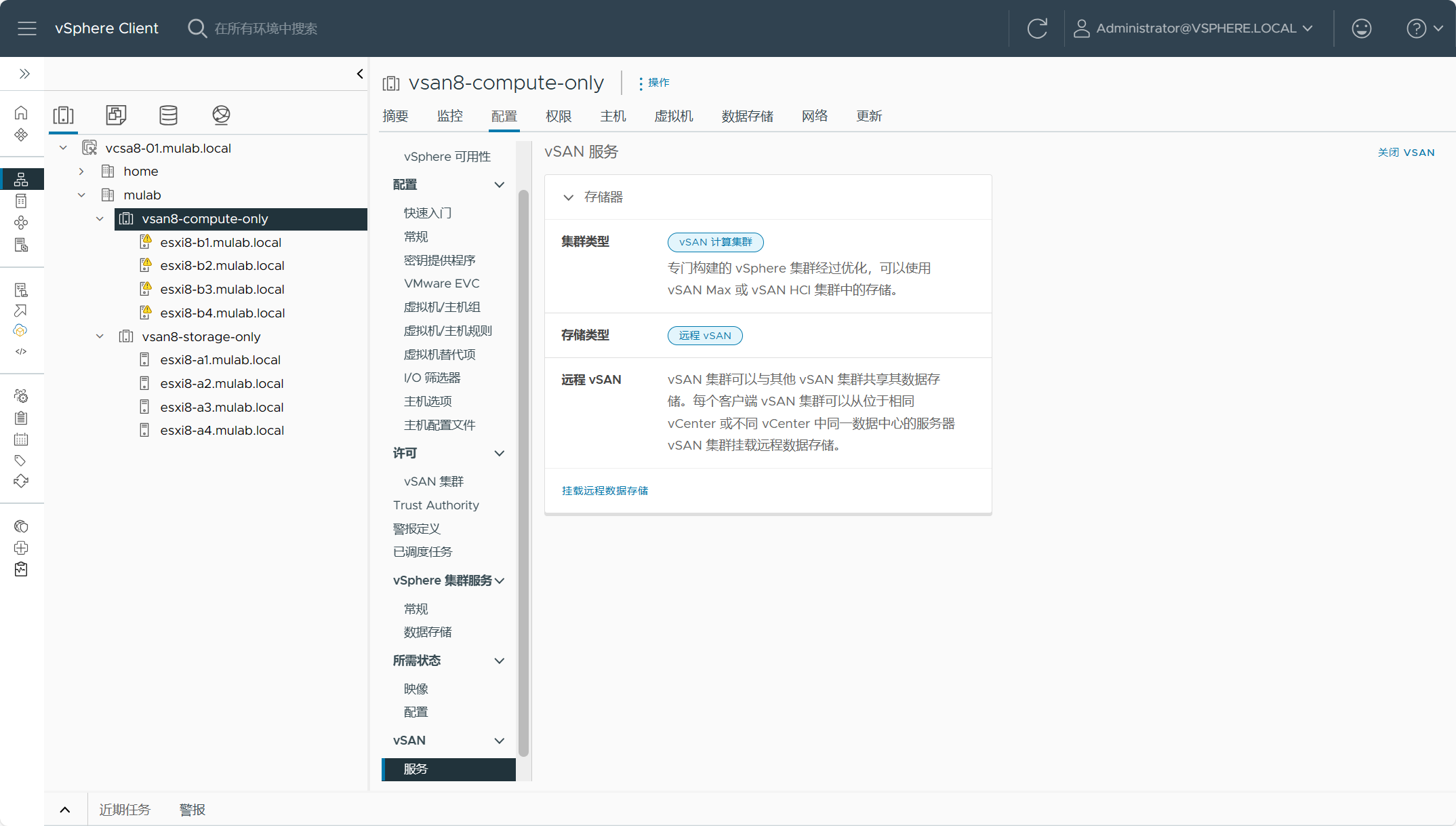

可以看到,集群已经被设置为vSAN 计算集群,待会儿我们需要挂载远程数据存储。

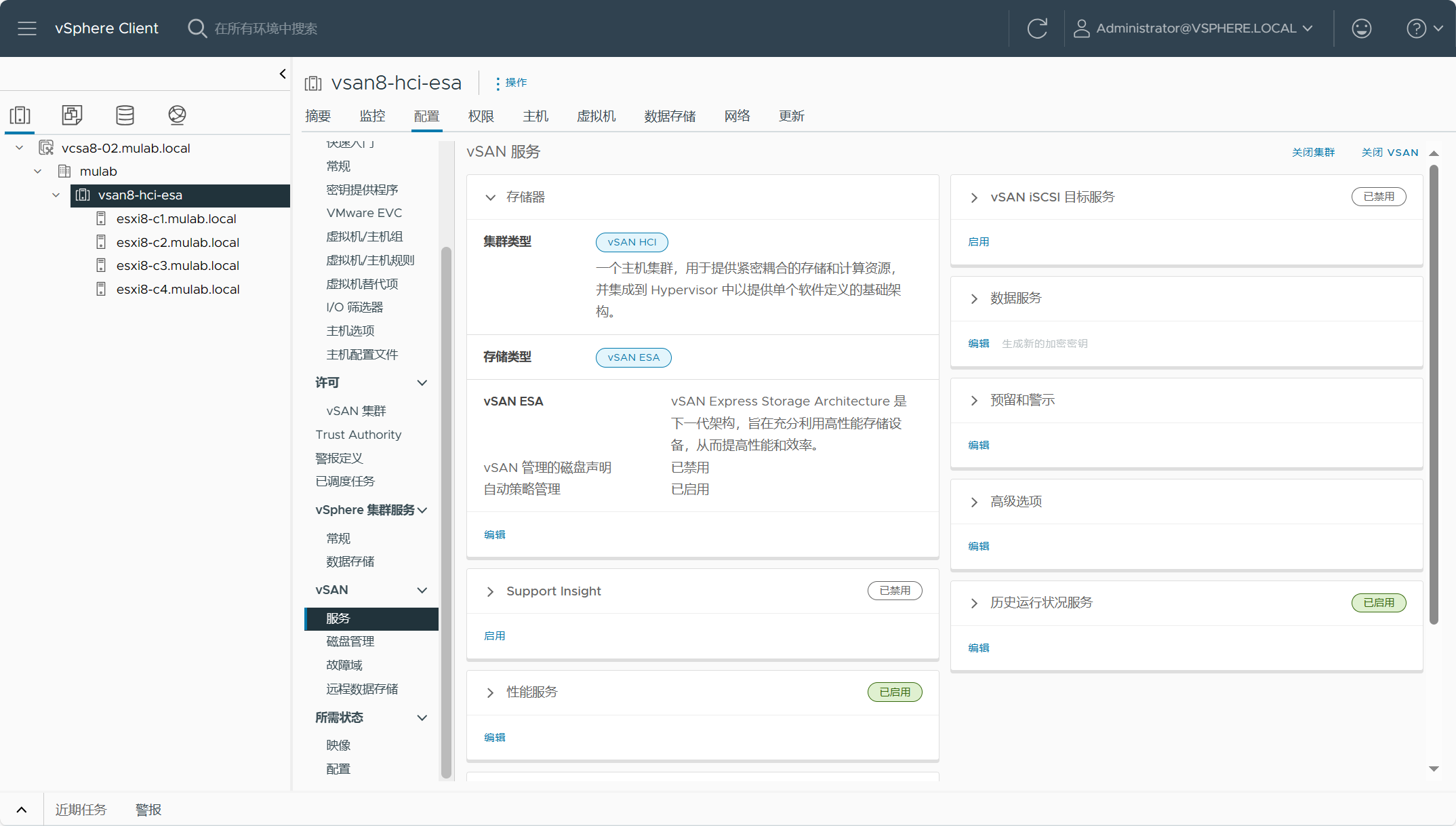

三、配置vSAN HCI集群

为了测试跨vCenter站点挂载远程数据存储,我在另一个vCenter(vcsa8-02.mulab.local)中创建了一个vSAN HCI ESA集群(vsan8-hci-esa),具体创建过程这里不再赘述,可以看我的另一篇文章:配置vSAN ESA超融合集群及如何正确删除vSAN集群。

四、挂载远程数据存储

挂载远程数据存储有两种方式,第一种是vSAN HCI集群和vSAN HCI集群之间或者vSAN HCI集群和vSAN计算集群之间的跨集群挂载远程数据存储,也叫具有数据存储共享的 vSAN HCI,挂载方被称为客户端,被挂载方称为服务器端,如果两边都是HCI集群,则可以互相挂载使用,但是不能超过限制,比如客户端最多只能挂载5个服务器端集群存储,而服务器端集群只能提供给10个客户端集群进行挂载,对集群内主机的连接数也有限制;另一种就是vSAN Max,vSAN Max仅提供存储资源被称为服务器端集群,可以提供给vSAN 集群集群(vSphere集群)和vSAN HCI集群挂载使用,这些集群就被称为客户端集群。上述说的是在同一站点跨集群挂载远程数据存储的使用形式,除了在同一站点提供远程挂载以外,还支持跨vCenter站点进行远程挂载数据存储。

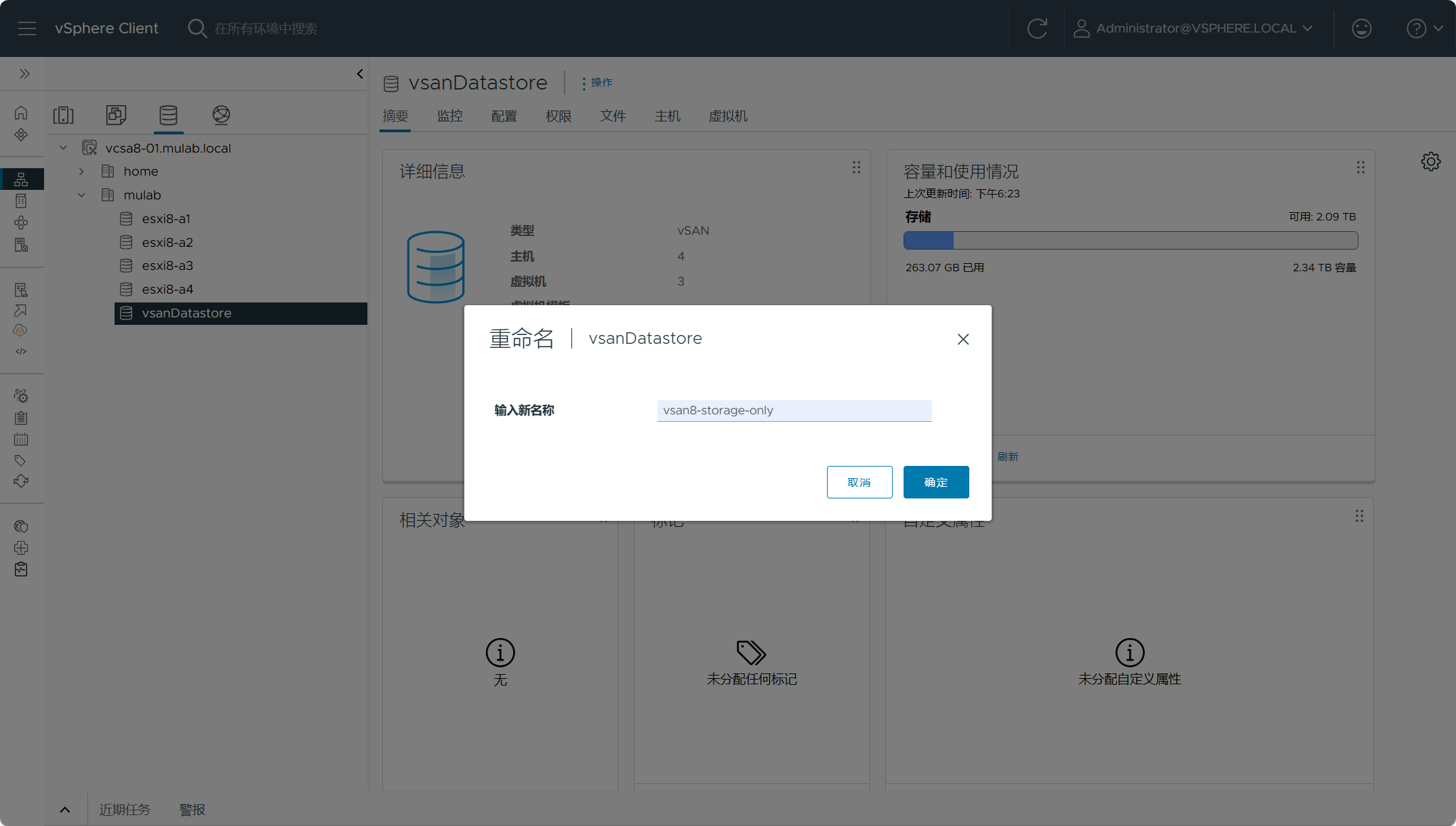

先对vSAN Max集群(vsan8-storage-only)和vSAN HCI集群(vsan8-hci-esa)的默认存储名称重命名一下,以免产生混淆。

下面测试一下,在同一站点(vcsa8-01.mulab.local)内,vSAN 计算集群挂载远程数据存储。

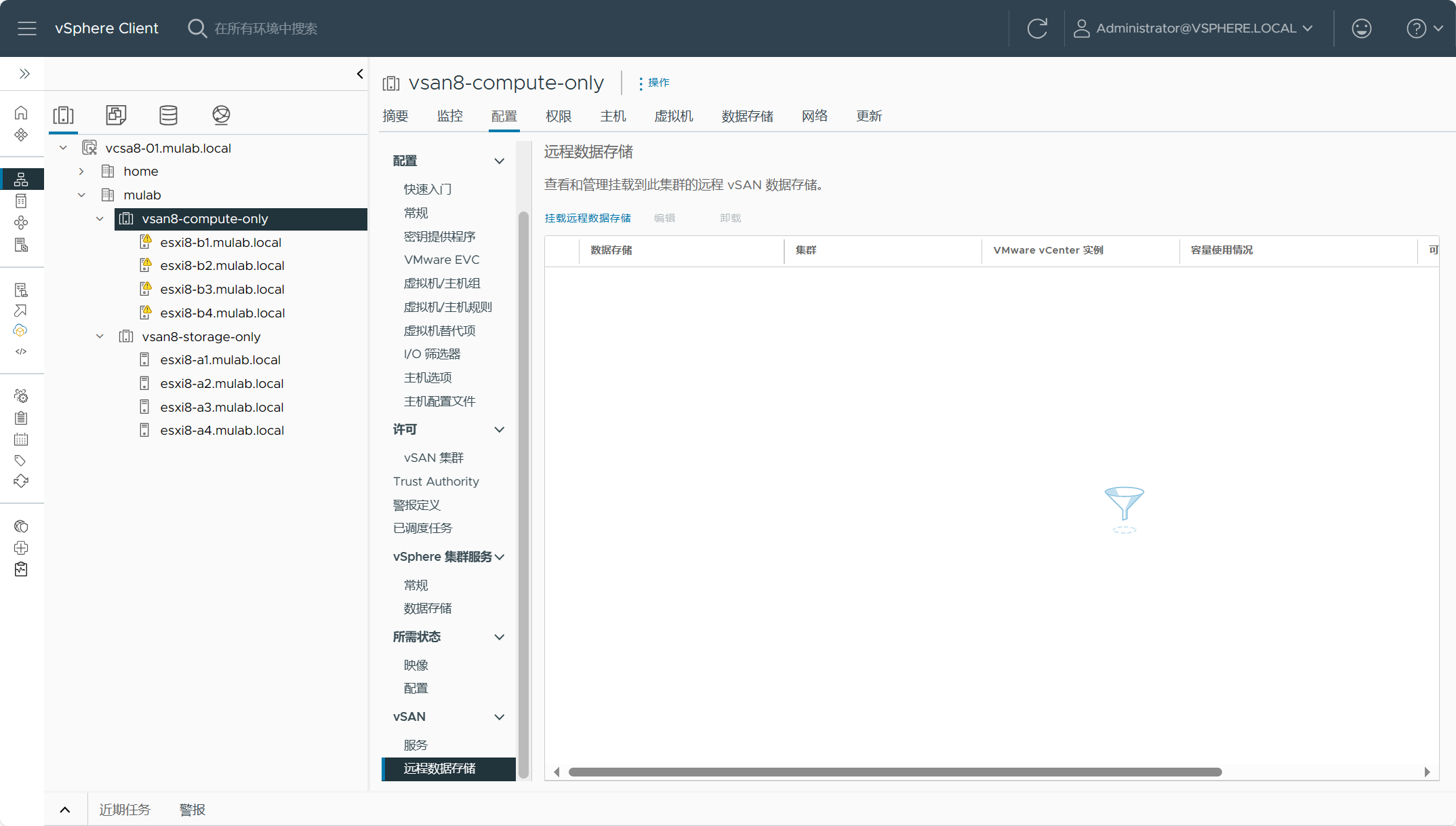

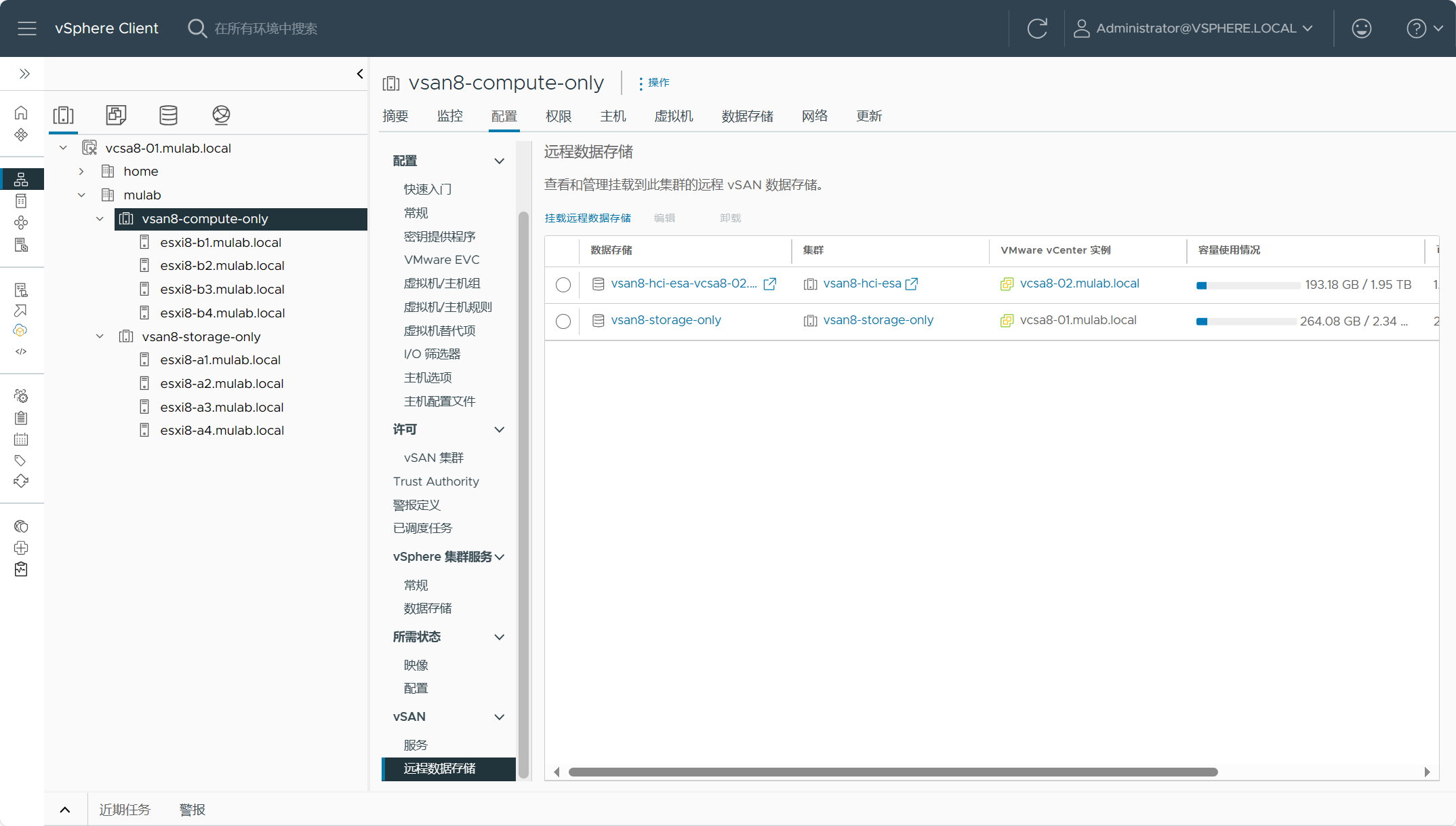

展开vSAN 计算集群(vsan8-compute-only)配置-vSAN-远程数据存储,点击“挂载远程数据存储”。

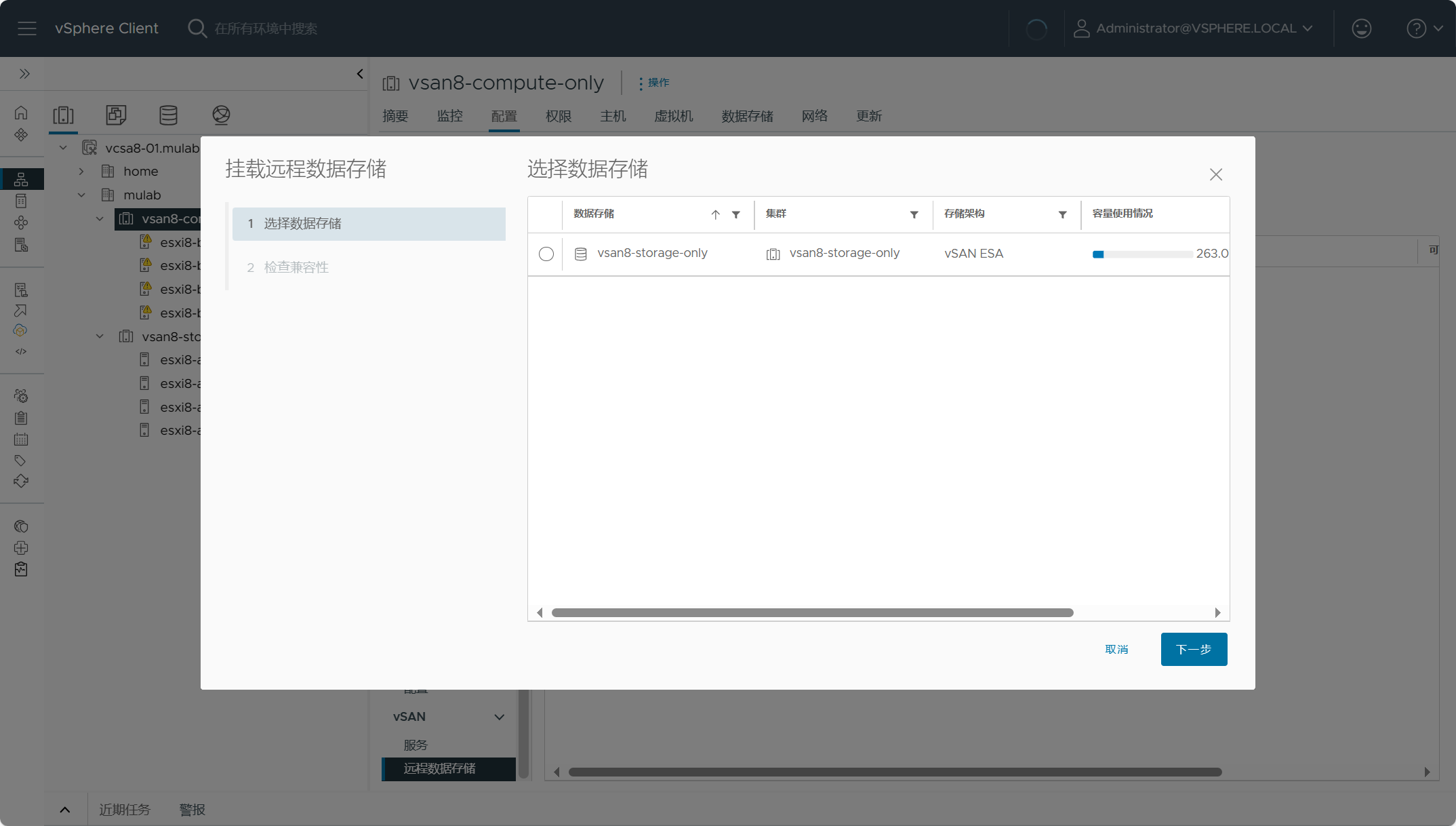

选择列表中的数据存储,只有vSAN Max集群提供的存储。

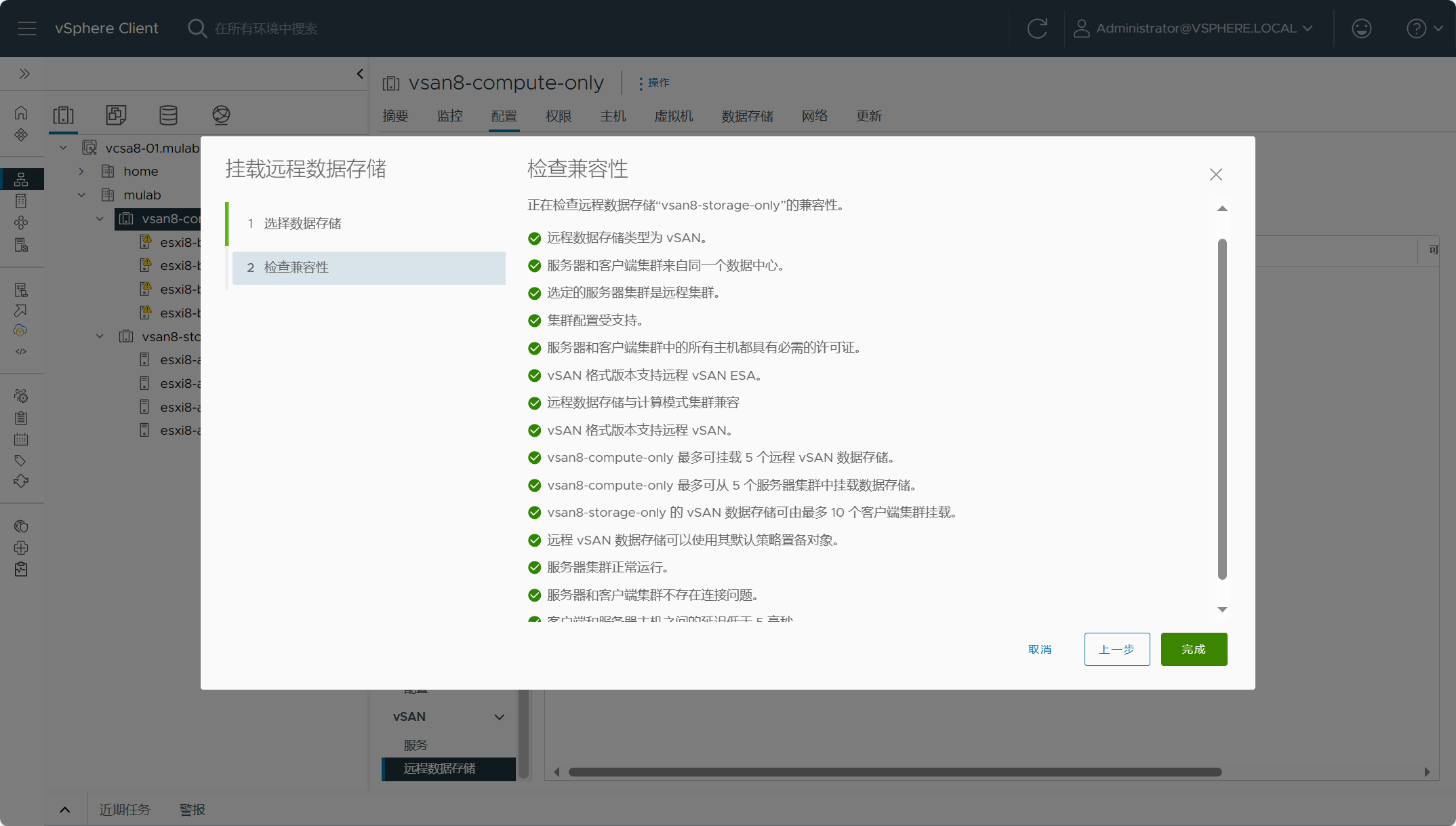

vSAN 计算集群vsan8-compute-only(客户端)与vSAN Max集群vsan8-storage-only(服务器端)之间的兼容性检查。

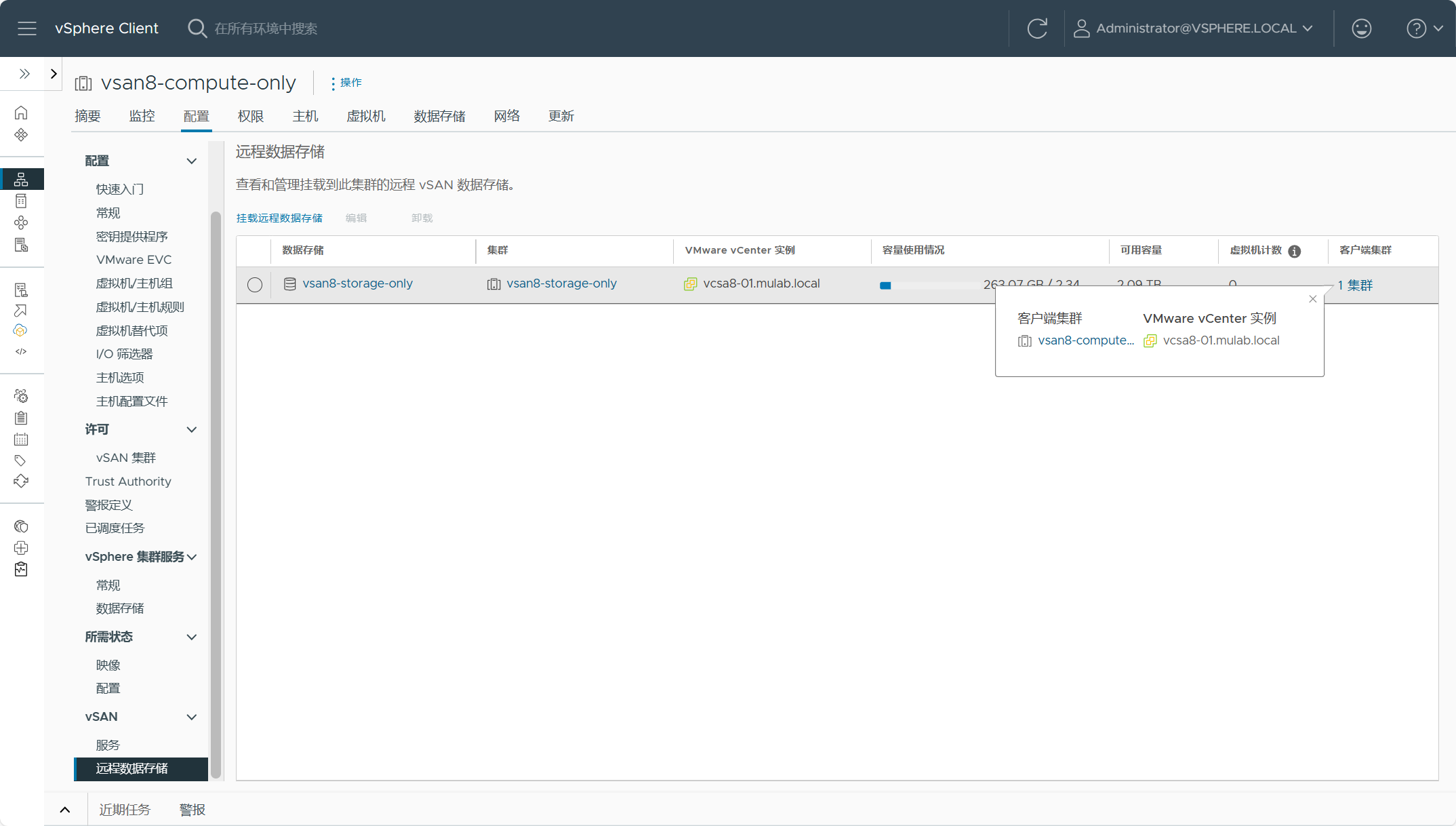

确认没有问题,点击完成,可以看到vSAN Max数据存储已被远程挂载到vSAN 计算集群。

注意,vSAN Max集群是不能挂载远程数据存储的,它只能充当服务器端,不能充当客户端。

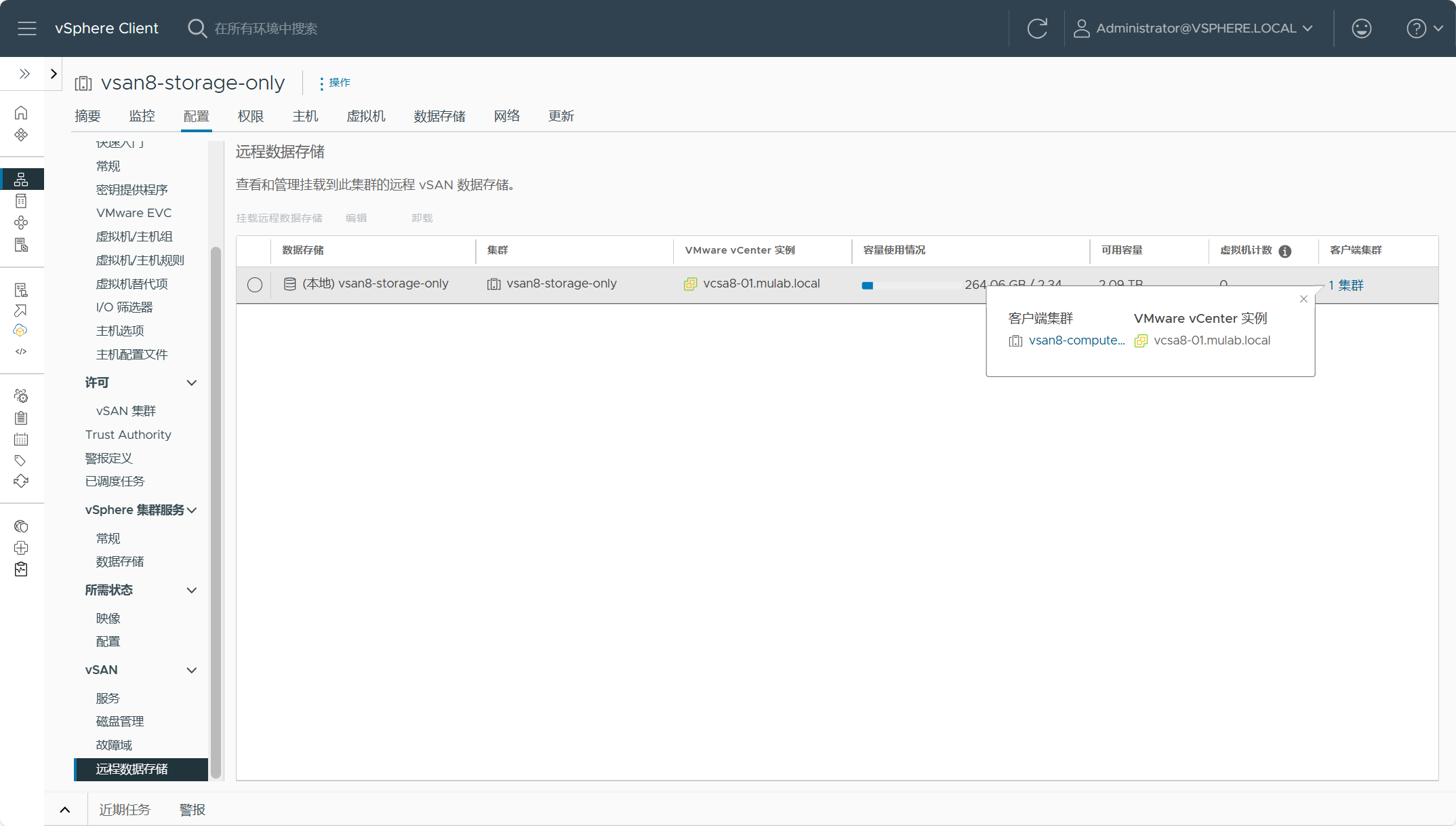

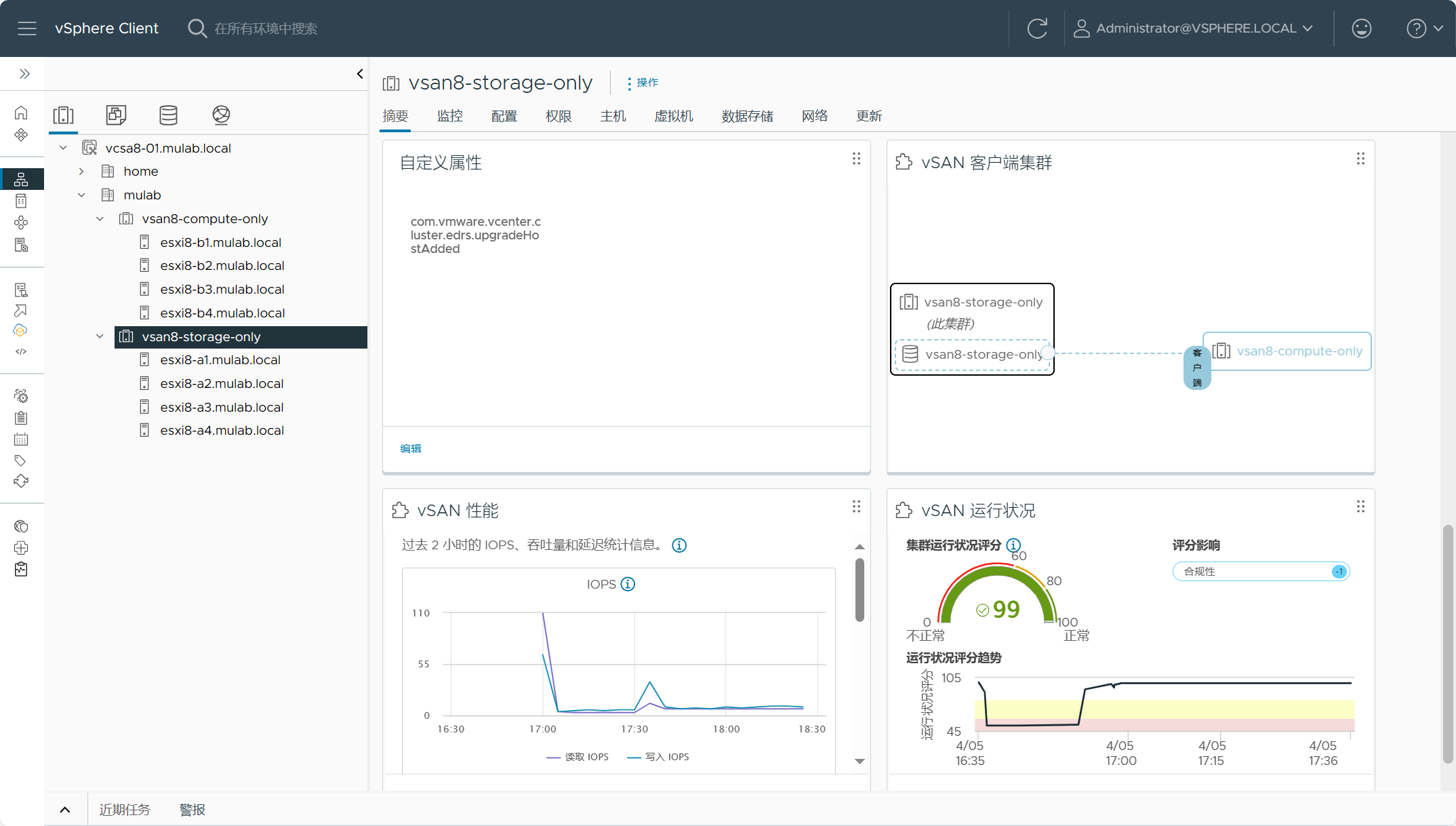

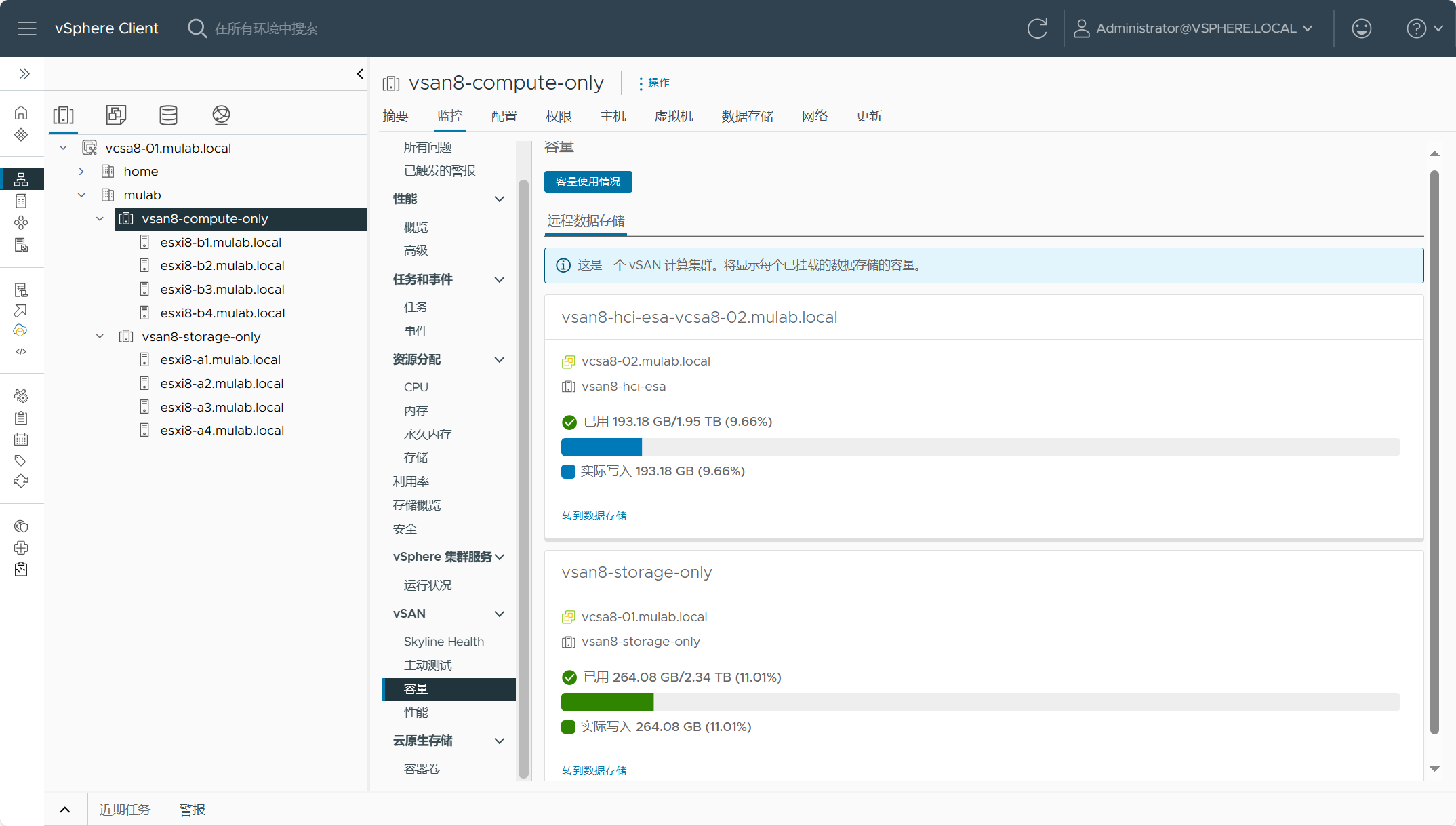

点击vSAN Max集群的摘要,也可以看到服务器端和客户端之间的映射关系。

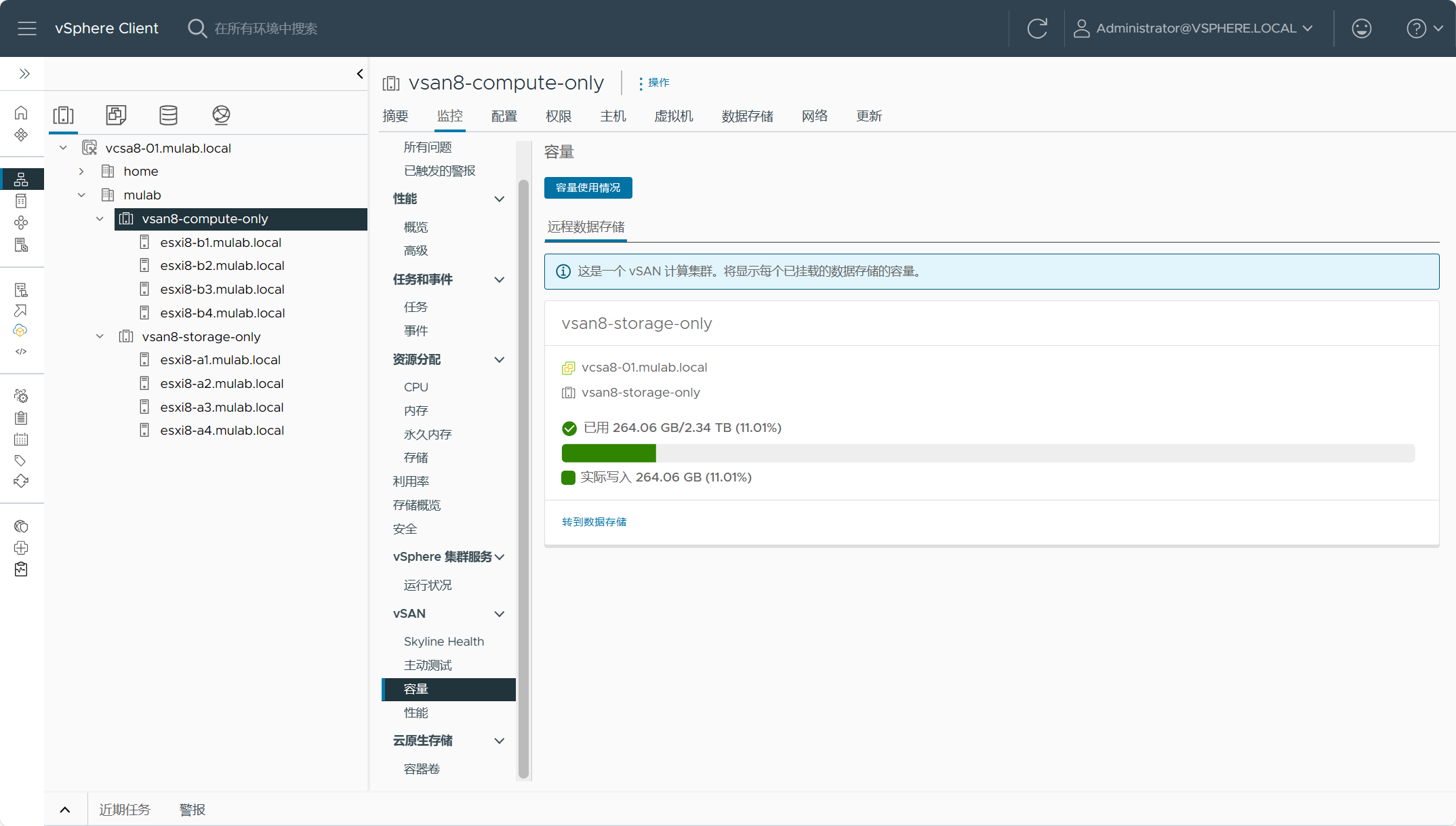

在vSAN 计算集群查看远程数据存储的使用情况。

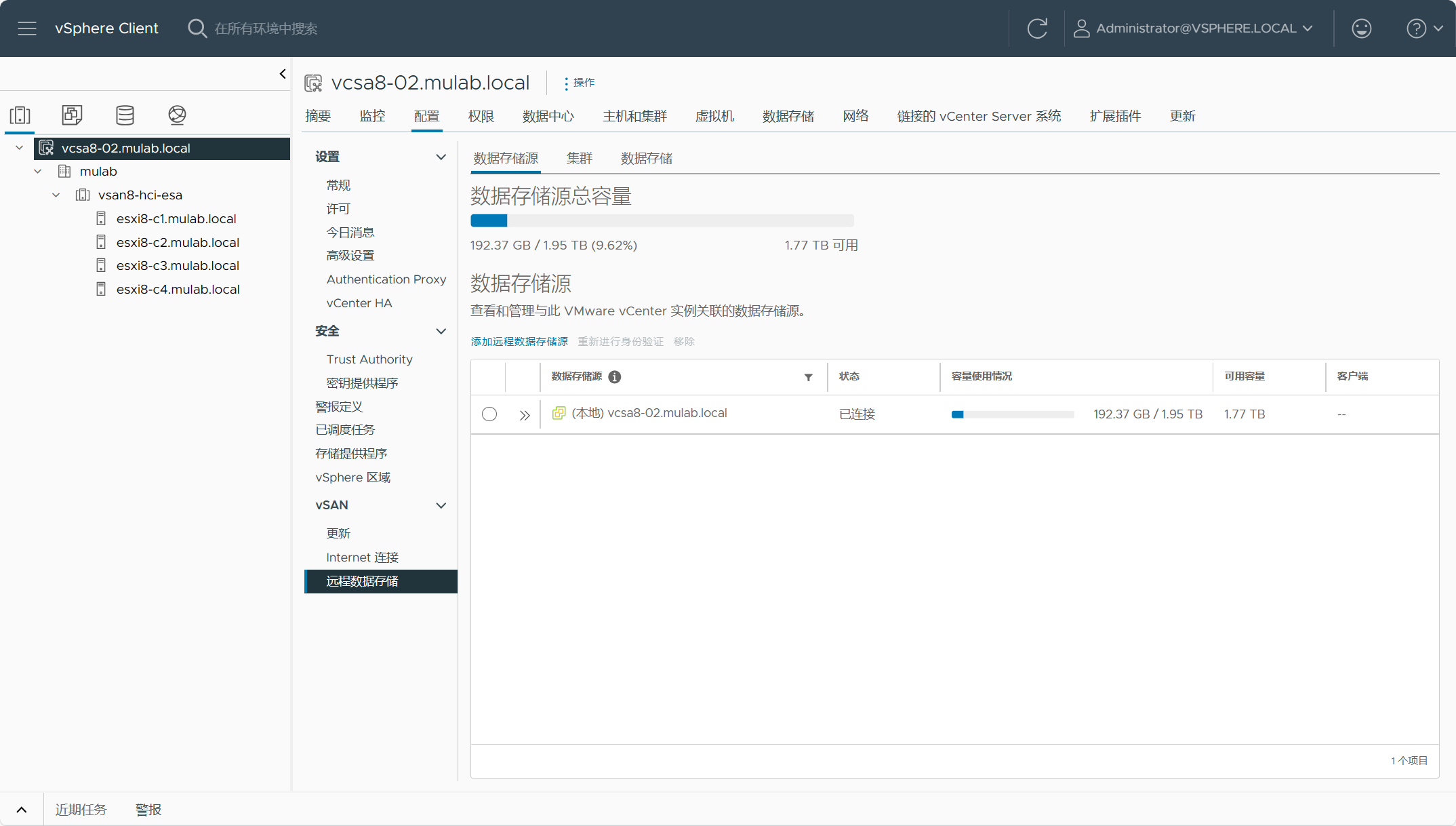

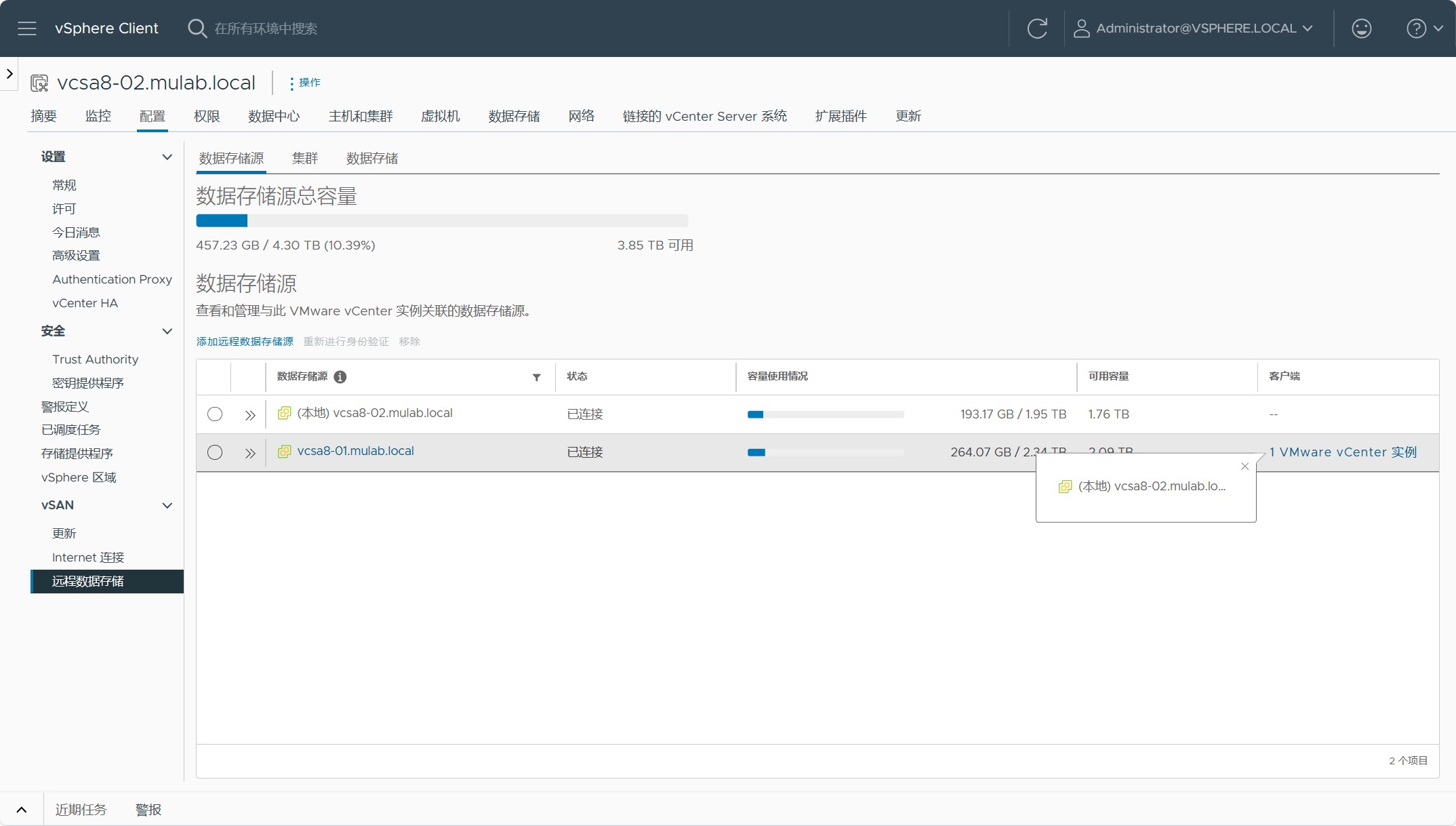

下面测试一下,跨vCenter站点挂载远程数据存储,登录vcsa8-02.mulab.local站点,展开配置-vSAN-远程数据存储。

注:也可以使用PowerCLI命令New-VsanHCIMeshDatastoreSource来添加其他vCenter远程数据存储源。

New-VsanHCIMeshDatastoreSource -VCHost <RemoteVCAddress> -User <MyVCUser> -Password <MyVCPassword>

我们可以看到我们自己本地的数据存储源,点击“添加远程数据存储源”以添加其他vCenter实例的数据存储源。

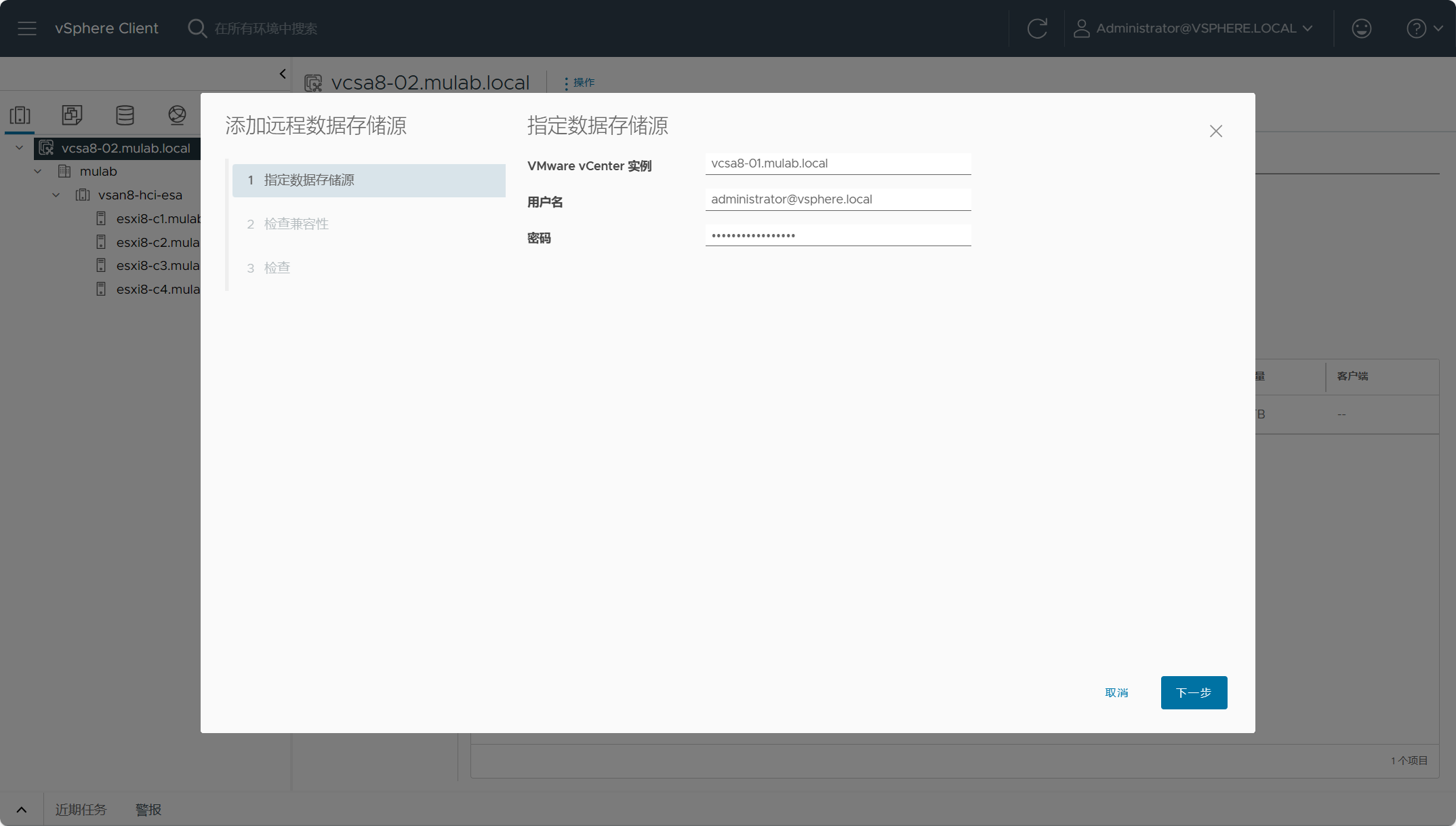

输入要添加的远程数据存储源vCenter的凭据,比如我这里vCenter是vcsa8-01.mulab.local。

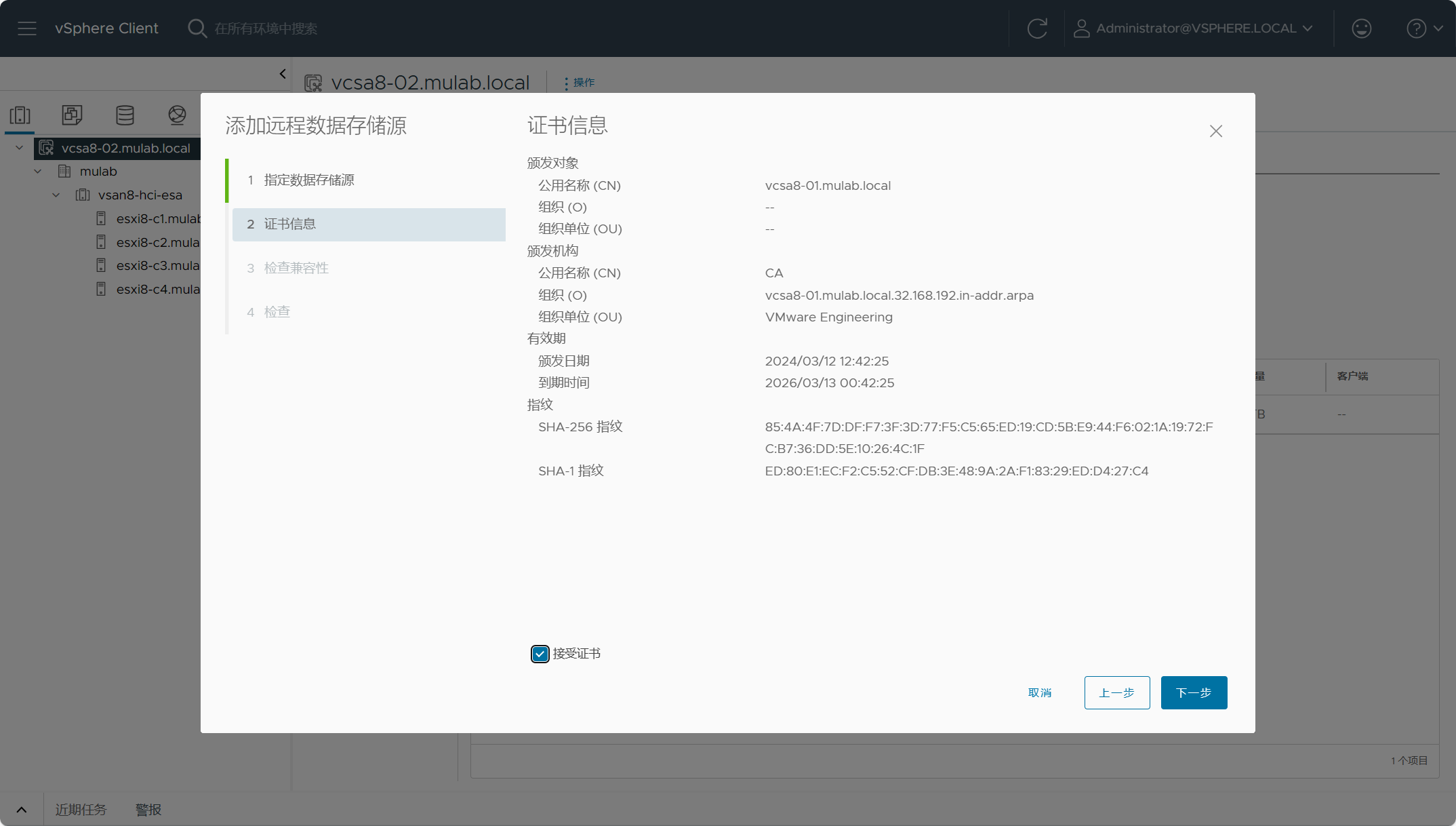

点击“接受证书”,点击下一步。

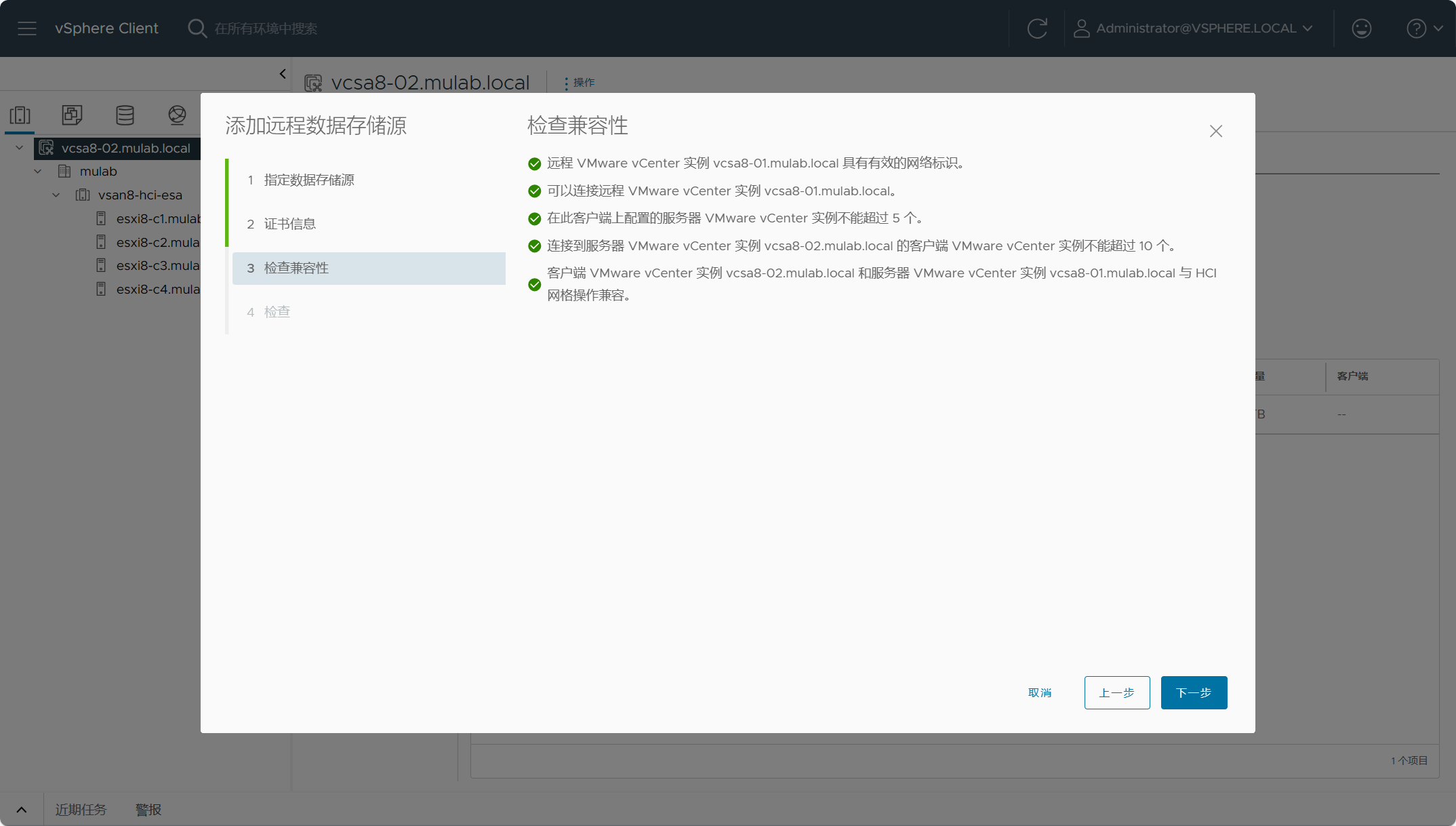

检查添加数据存储源vCenter的兼容性,确认没有问题,点击下一步。

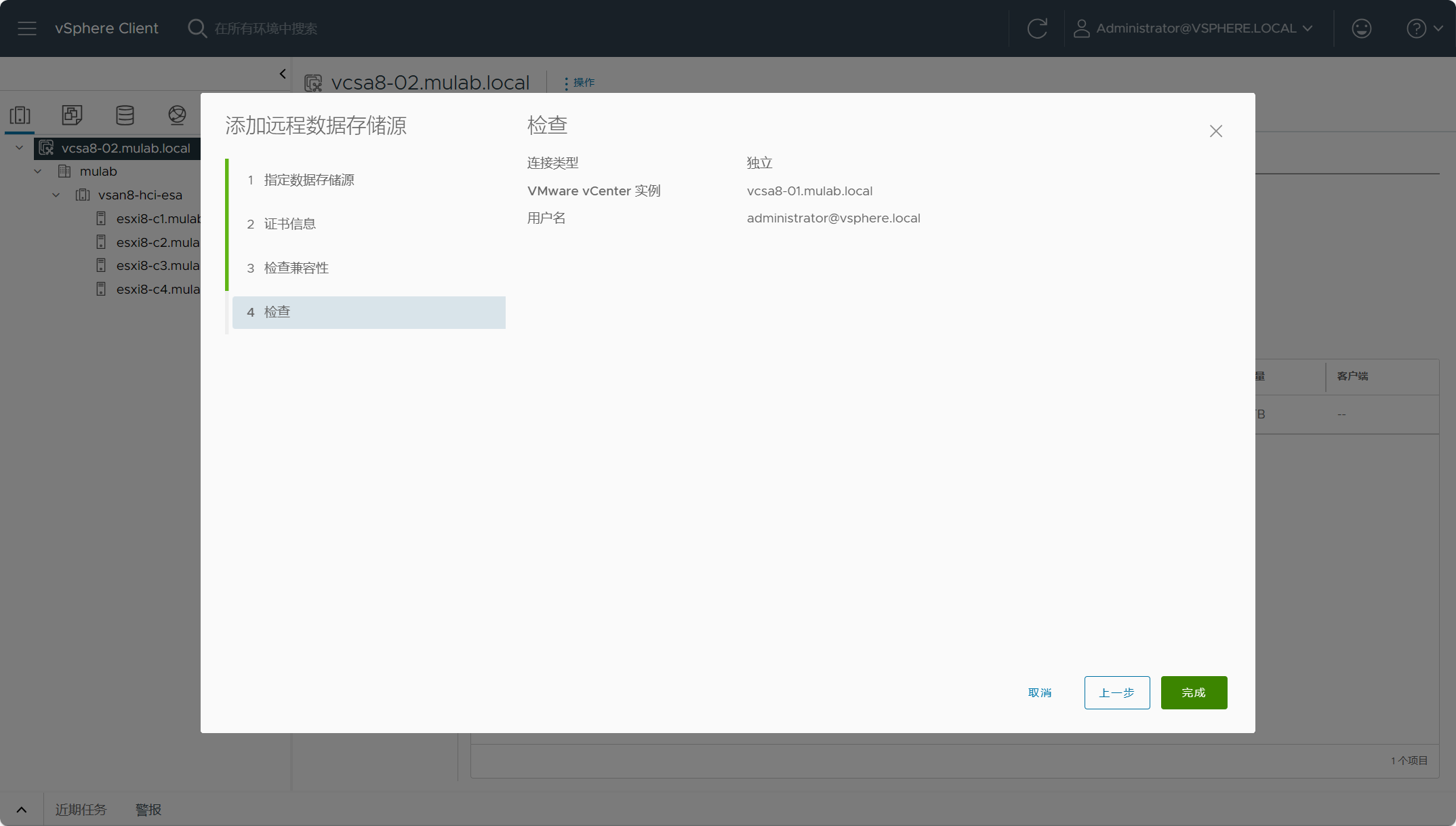

点击完成。

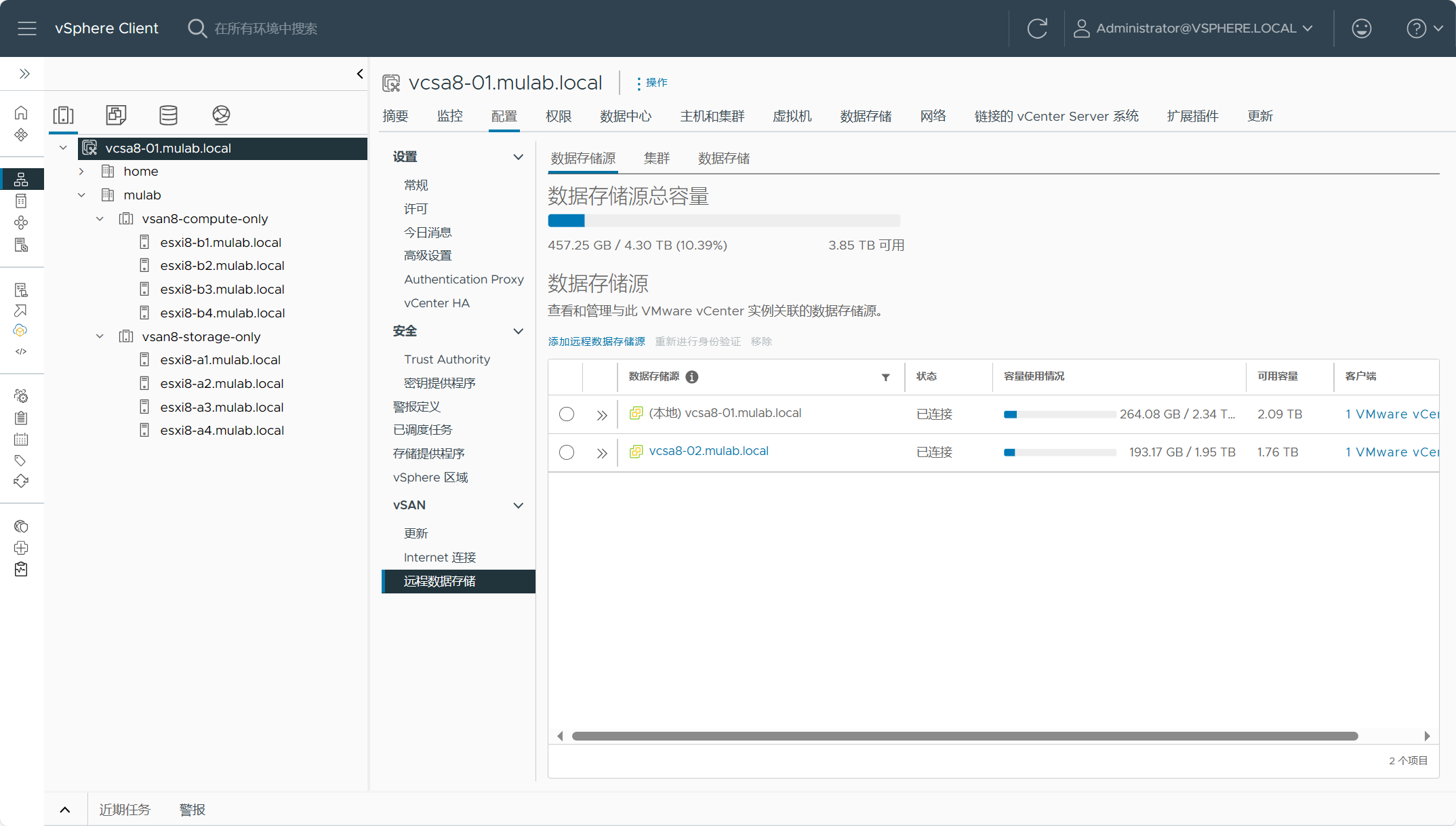

可以看到已经将vcsa8-01.mulab.local站点添加到数据存储源。

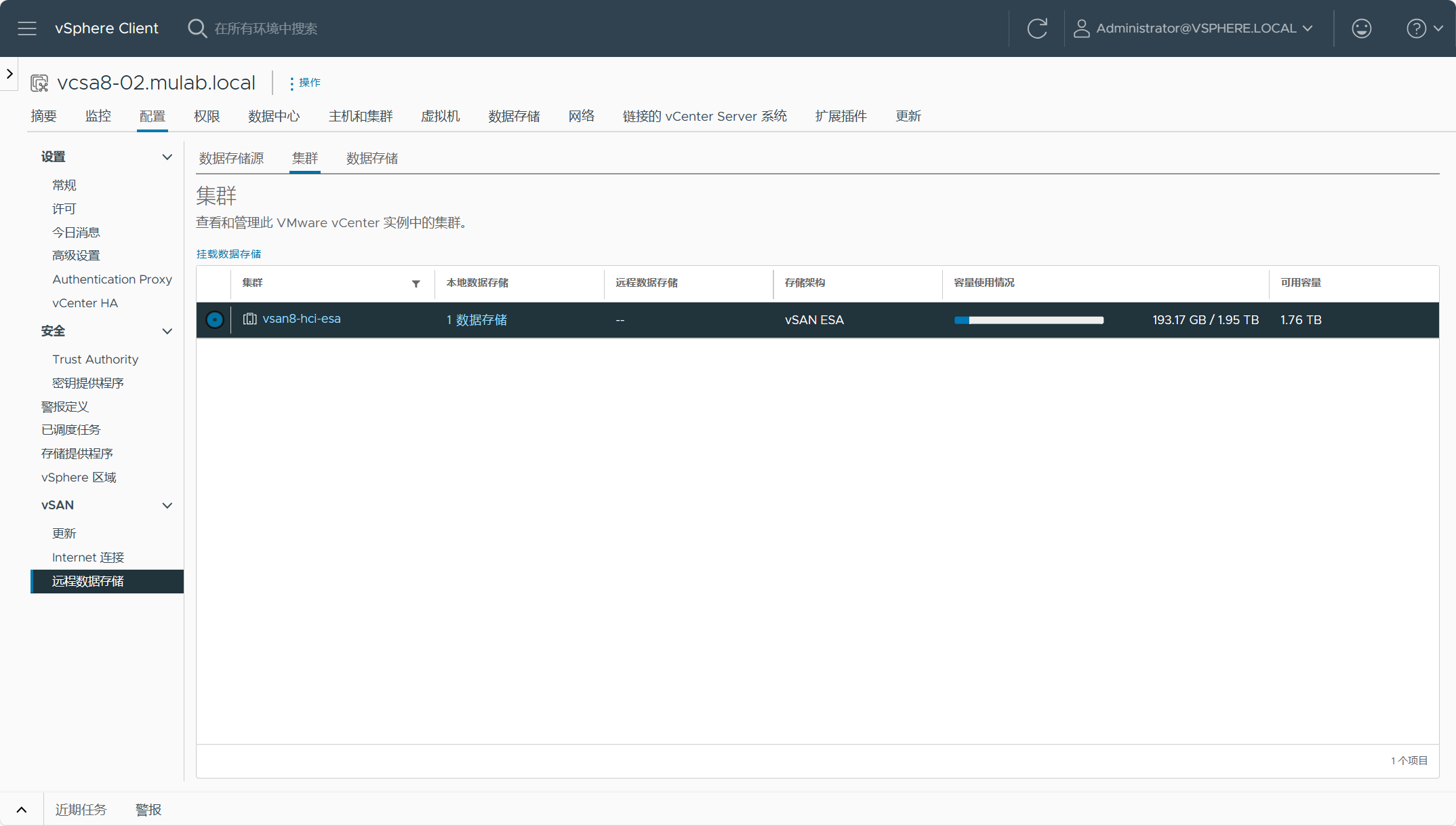

现在,我们可以点击右边的”集群“,选择我们要进行远程挂载的集群,我这里只有一个vsan-hci-esa集群,然后点击挂载数据存储。

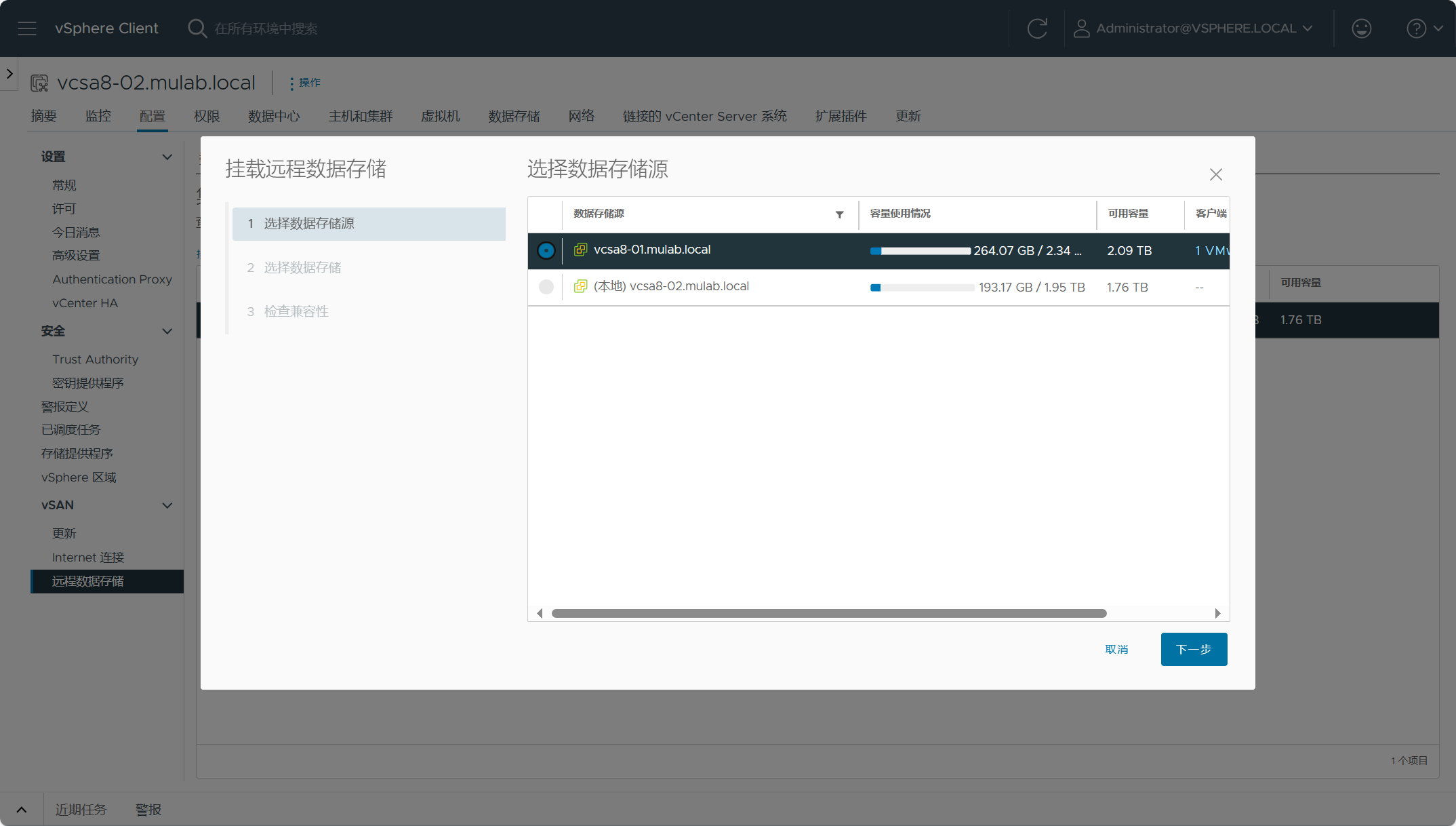

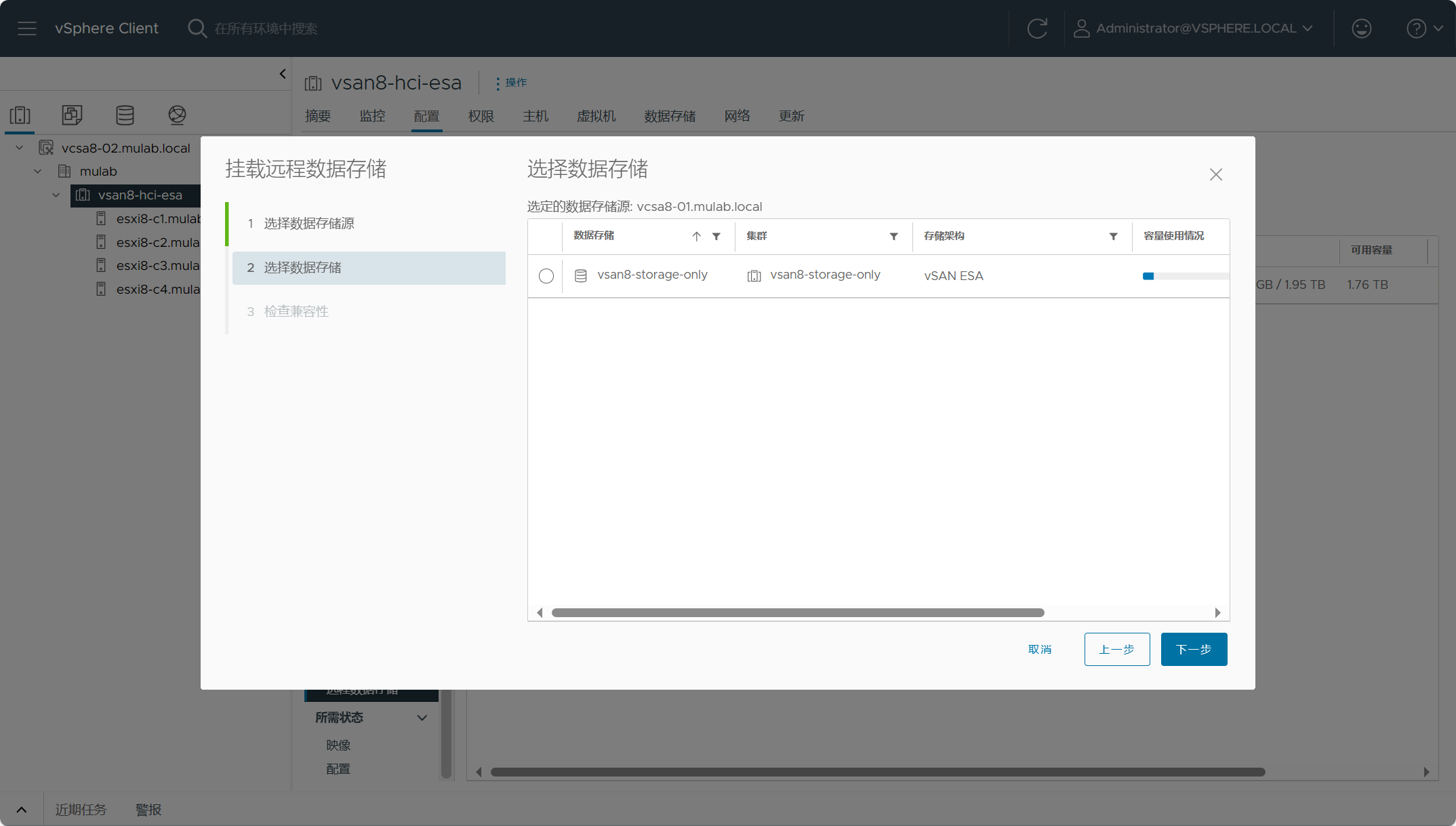

选择数据存储源(vcsa8-01.mulab.local),然后选择数据源上面的存储进行挂载即可。

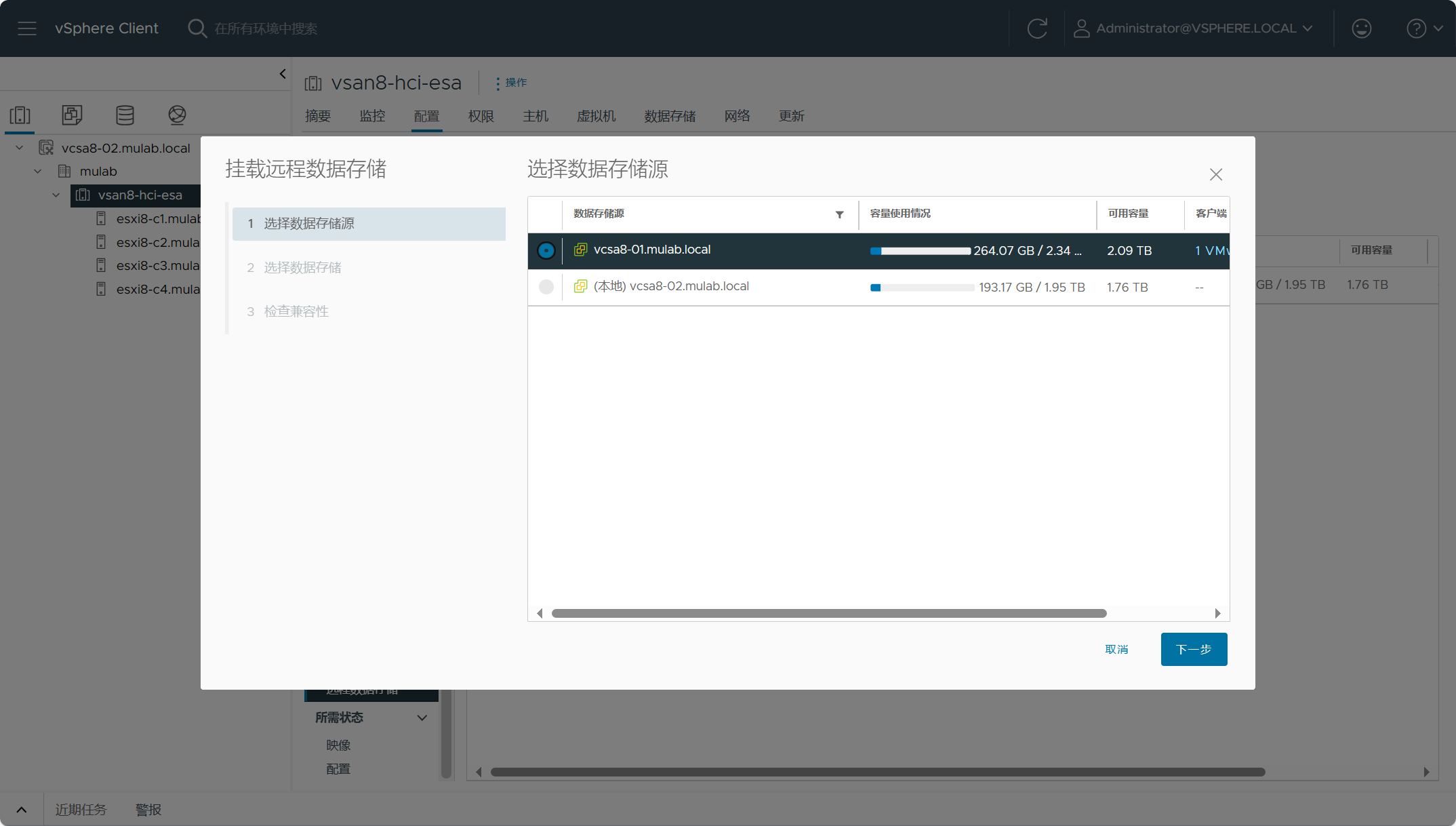

或者展开vSAN HCI ESA集群(vsan-hci-esa)配置-vSAN-远程数据存储,点击”挂载远程数据存储“,选择数据存储源。

选择数据存储源上面的数据存储,也就是vSAN Max集群上的存储vsan8-storage-only。

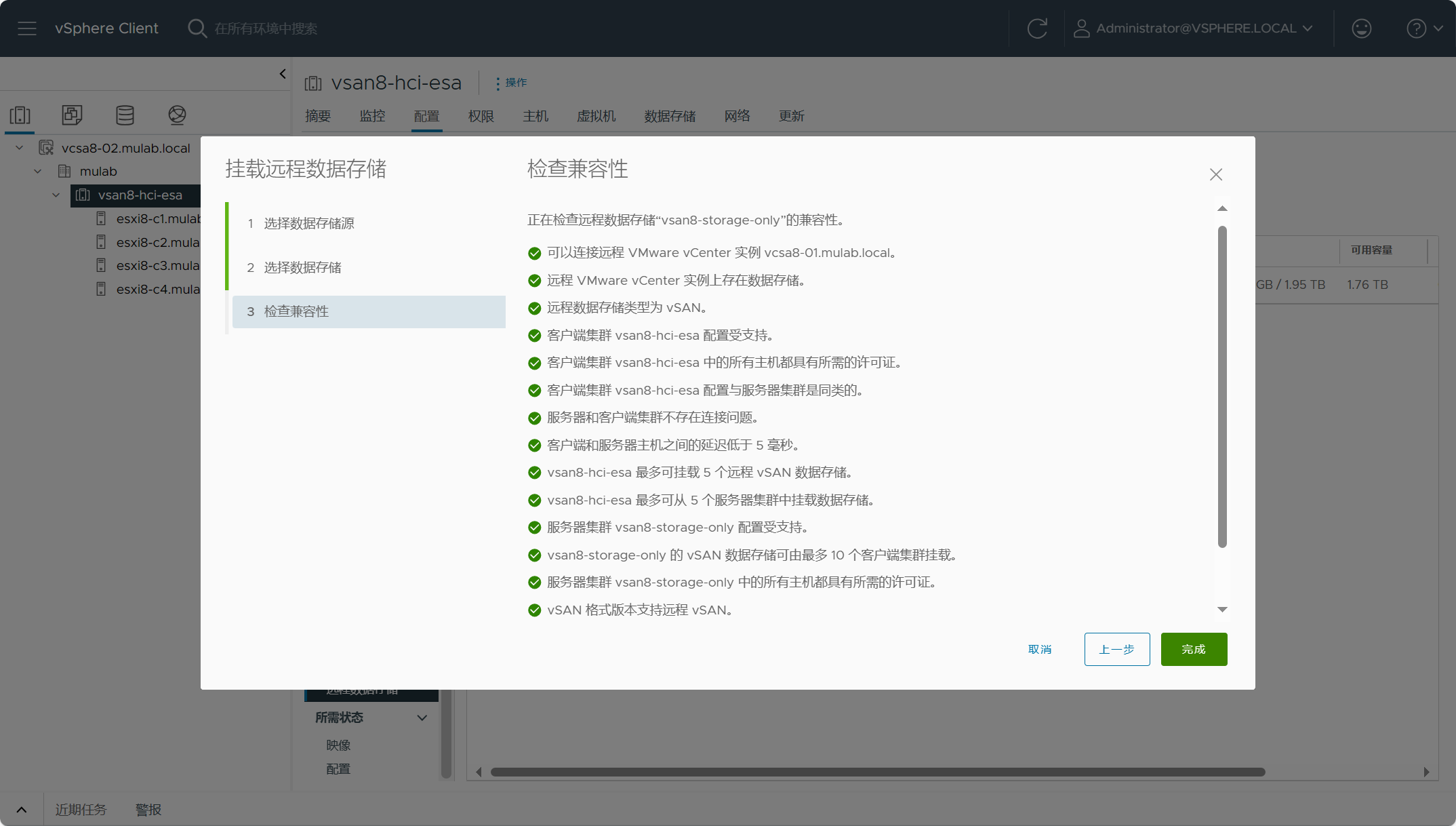

同样,检查客户端集群(vsan8-hci-esa)和服务器端集群(vsan8-storage-only)之间的兼容性。

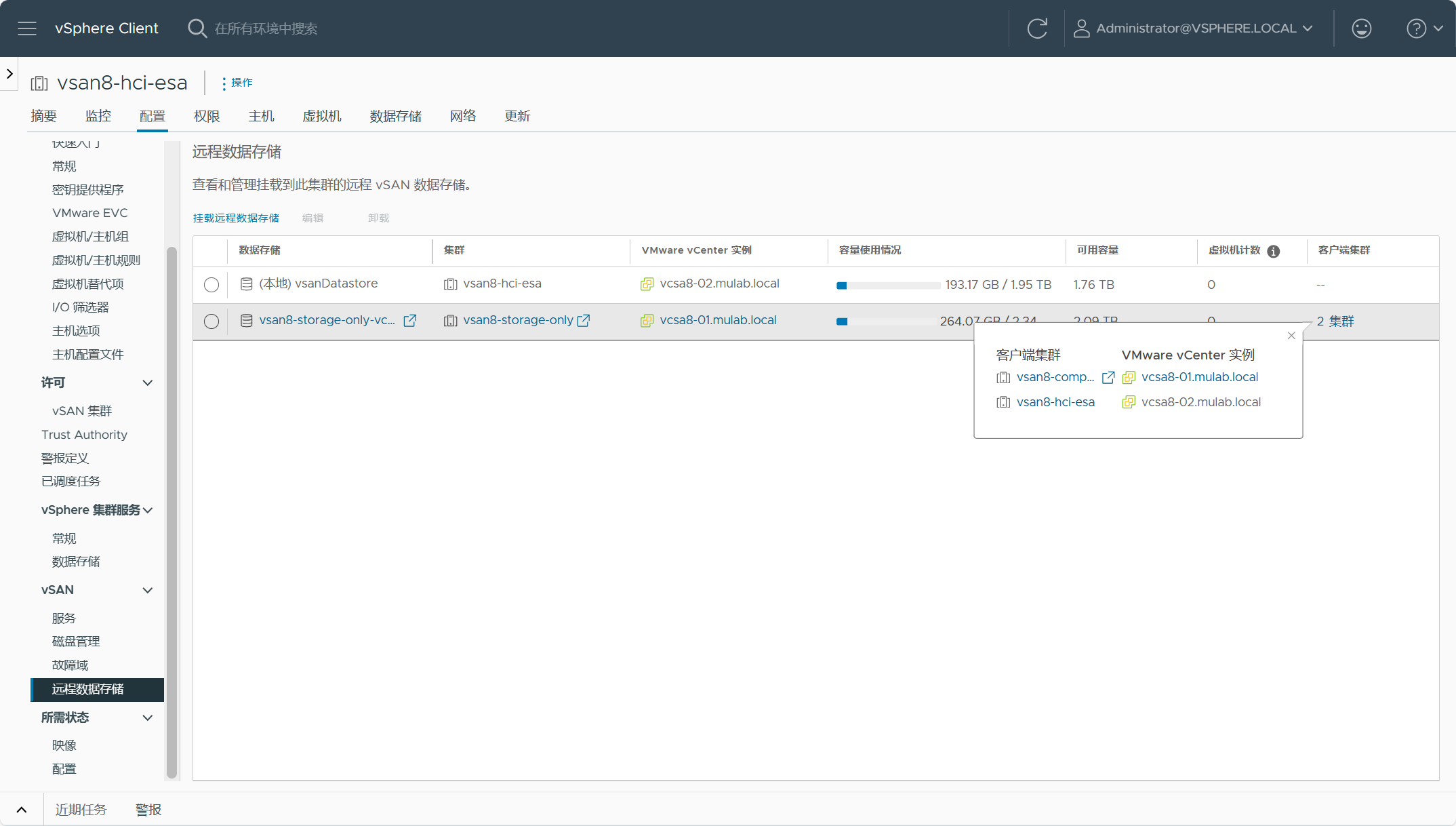

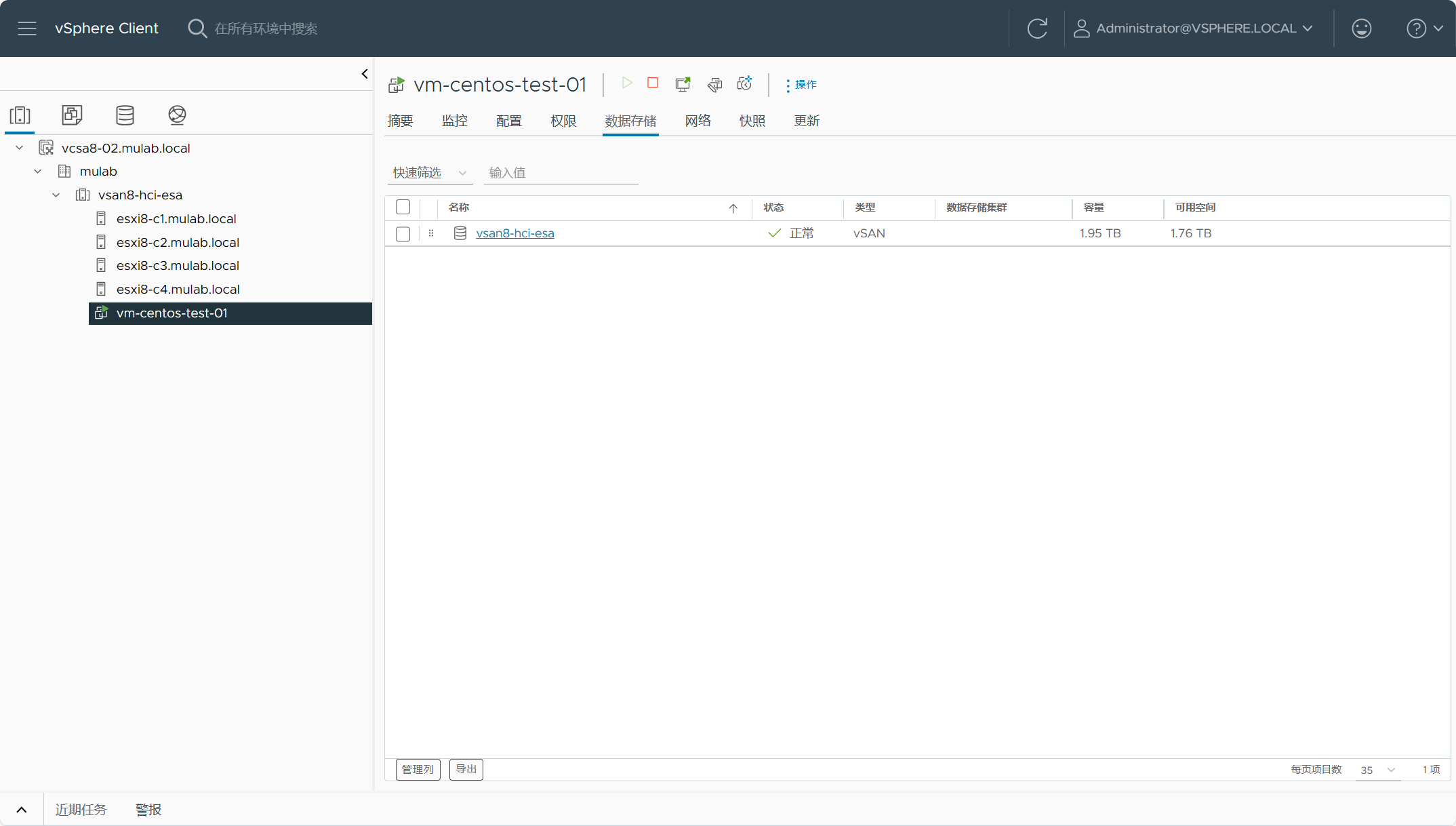

等待配置完成,可以看到vcsa8-01站点上的vSAN Max集群存储已被挂载到vcsa8-02站点的vSAN HCI ESA集群。

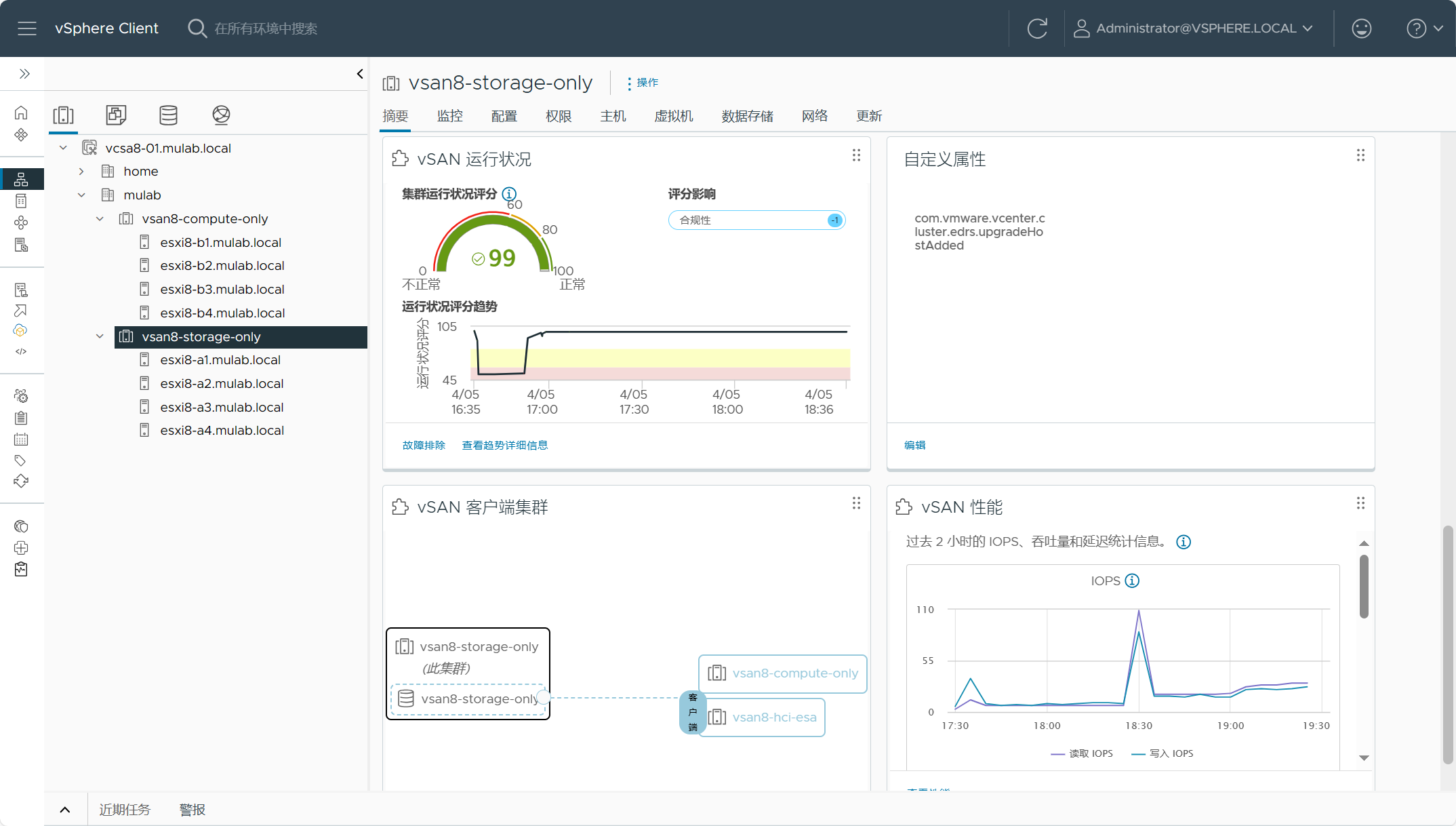

点击vcsa8-01站点上vSAN Max集群的摘要,可以看到服务器端和客户端之间的映射关系。

同样的,vcsa8-02.mulab.local站点也可以被vcsa8-01.mulab.local站点作为数据源反向添加。

将vcsa8-02.mulab.local站点上的vSAN HCI ESA数据存储挂载给vcsa8-01.mulab.local站点上的vSAN 计算集群使用。

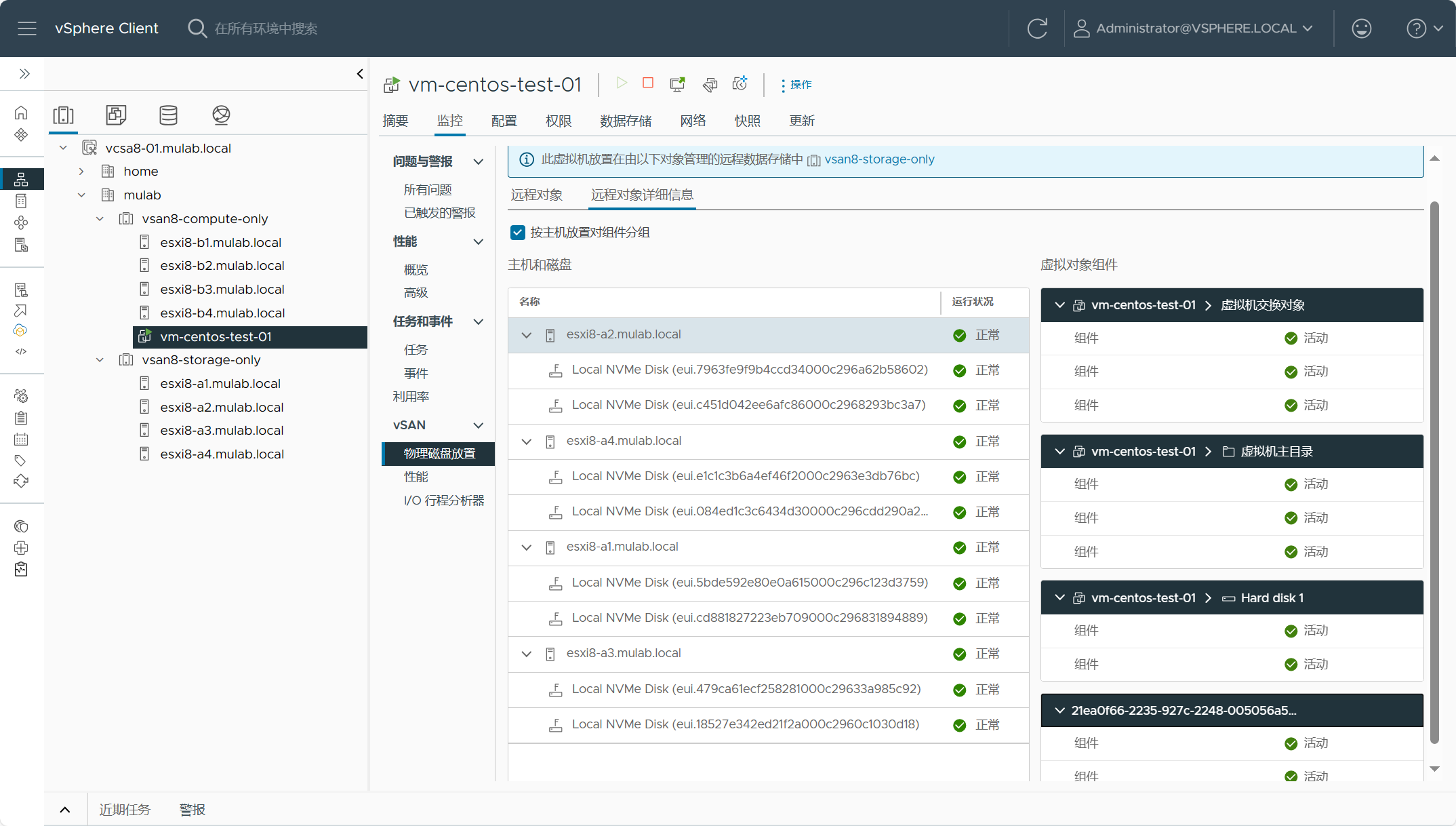

在vcsa8-01.mulab.local站点vSAN 计算集群上监控远程数据存储使用情况。

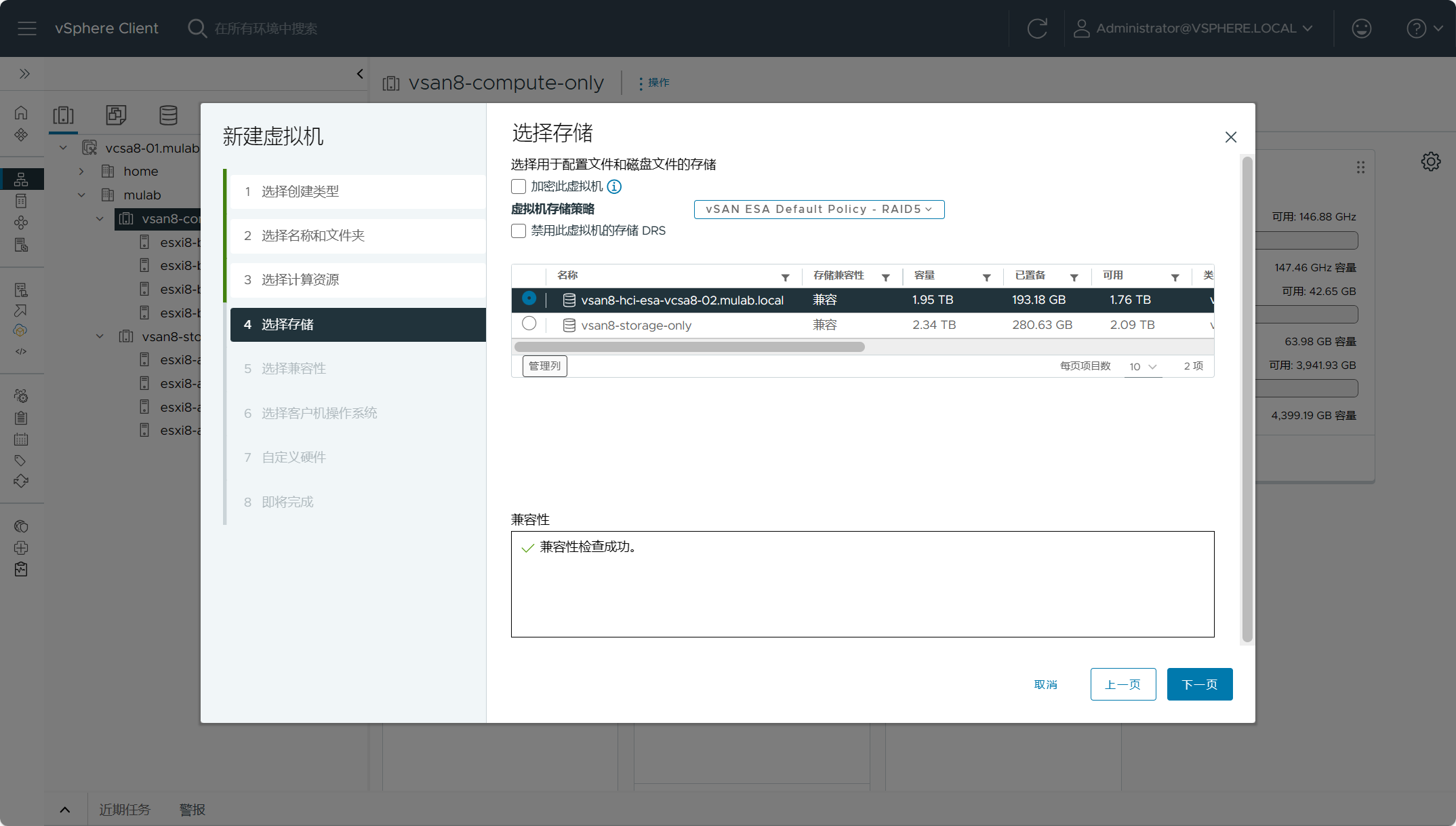

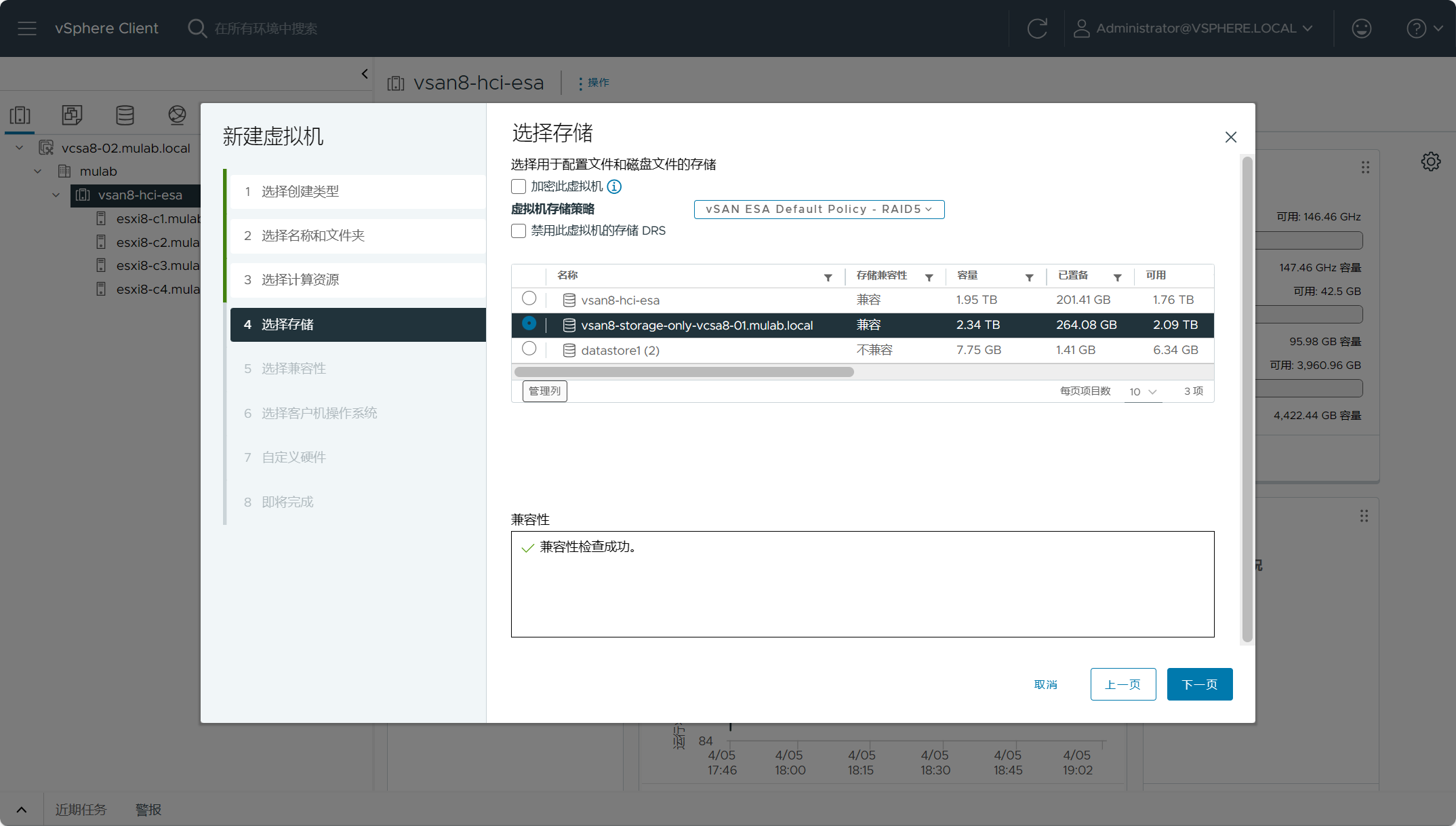

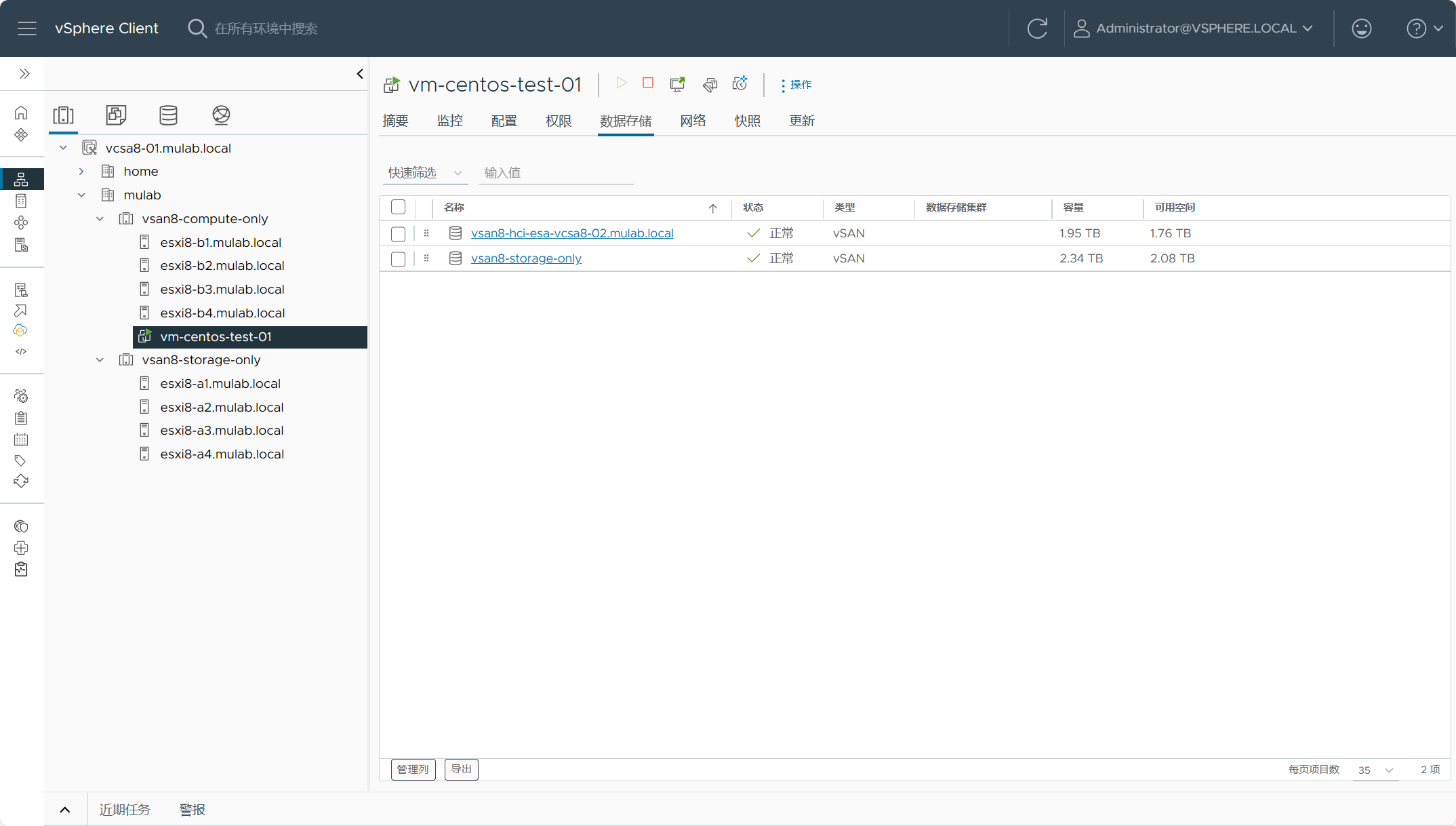

在vcsa8-01.mulab.local站点vSAN 计算集群上新建虚拟机,可以选择的数据存储源。

同时,在vcsa8-02.mulab.local站点vSAN HCI集群上新建虚拟机,可以选择的数据存储源。

在vcsa8-02.mulab.local站点vSAN HCI集群上新建虚拟机,数据存储源为本地vSAN HCI存储。

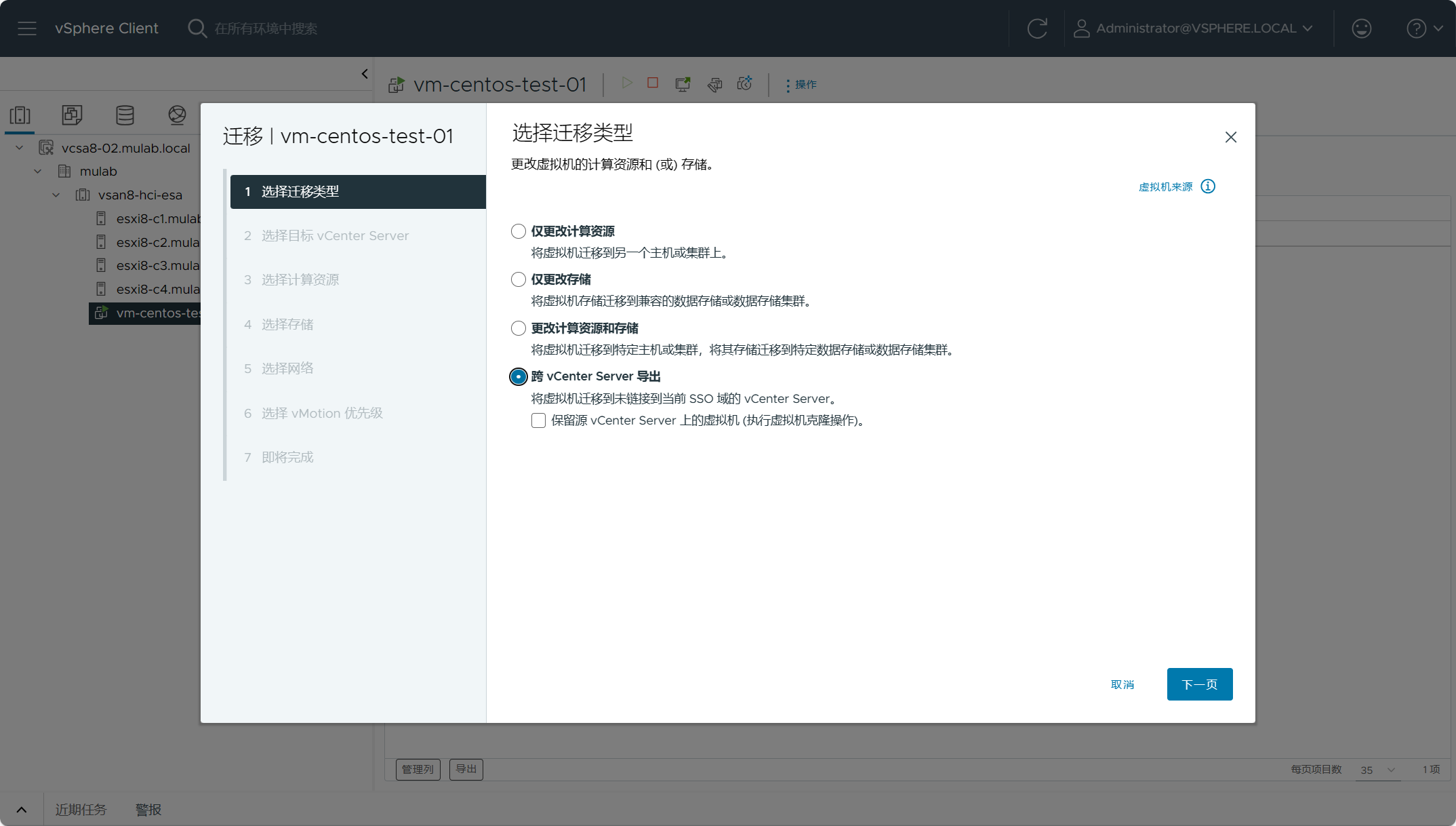

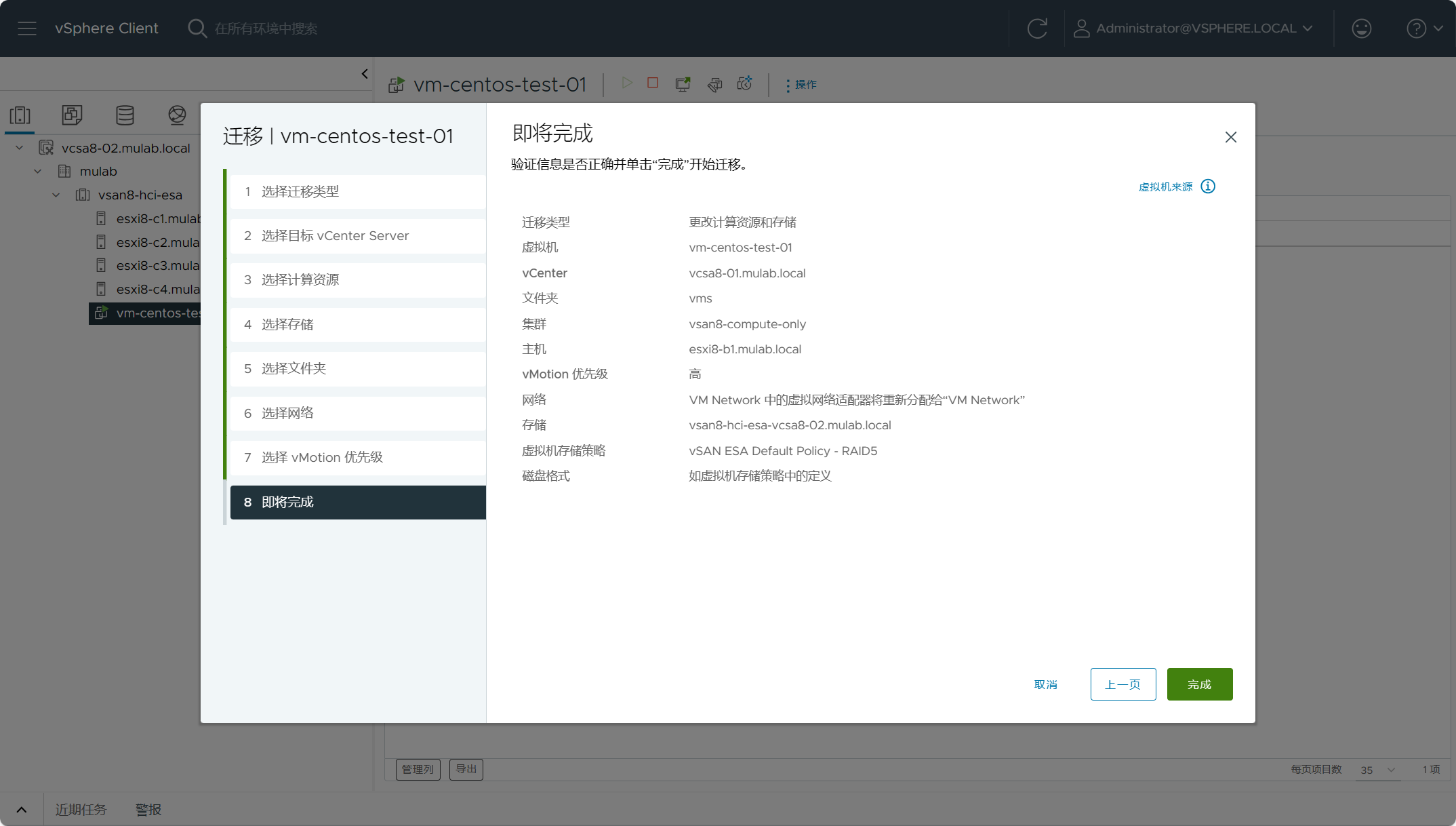

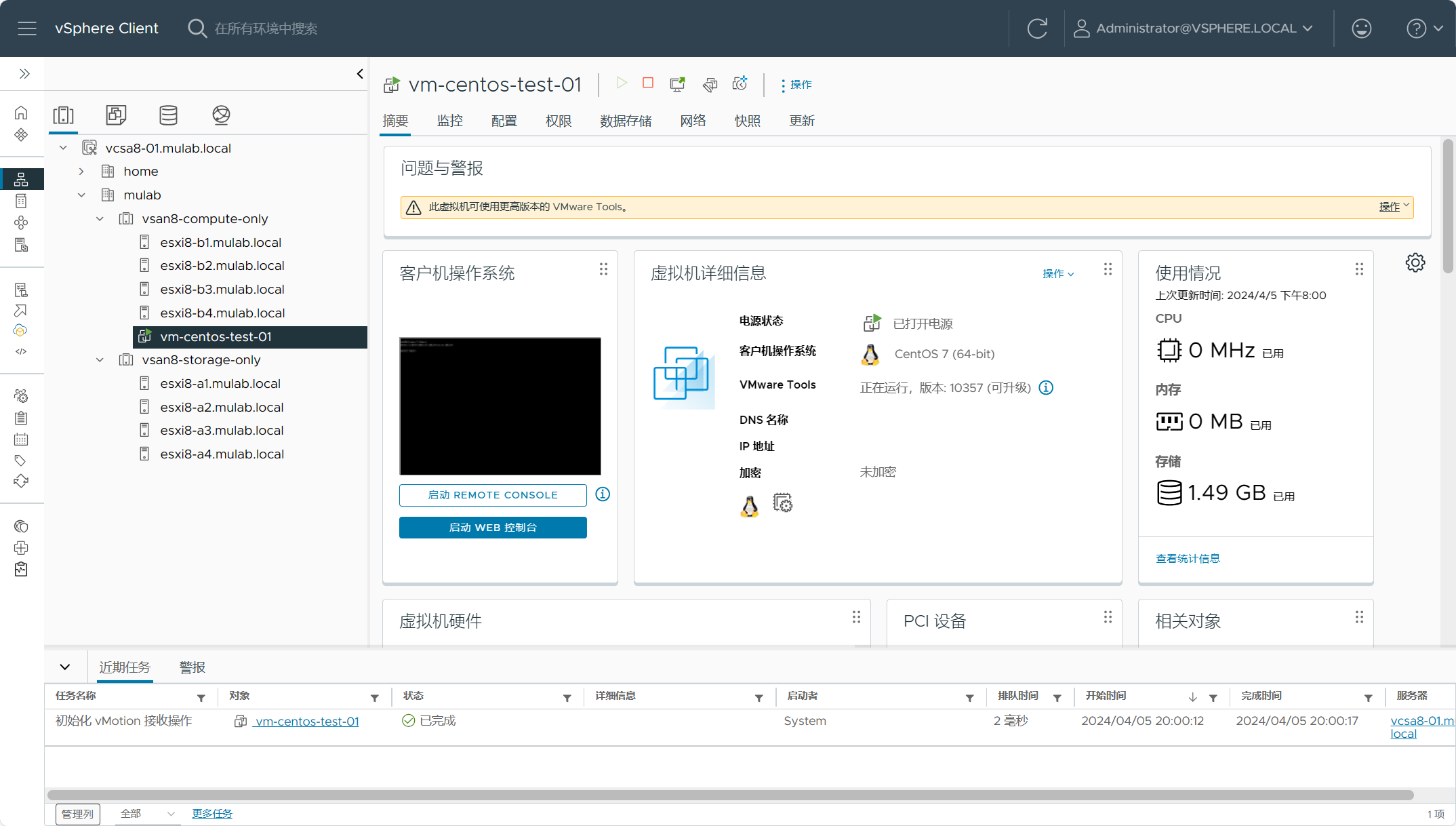

右击虚拟机,选择迁移,选择跨vCenter Server迁移。

注:集群内的主机需要提前在vmkernel网卡上启用vMotion服务。

设置目标vCenter Server,点击登录连接。

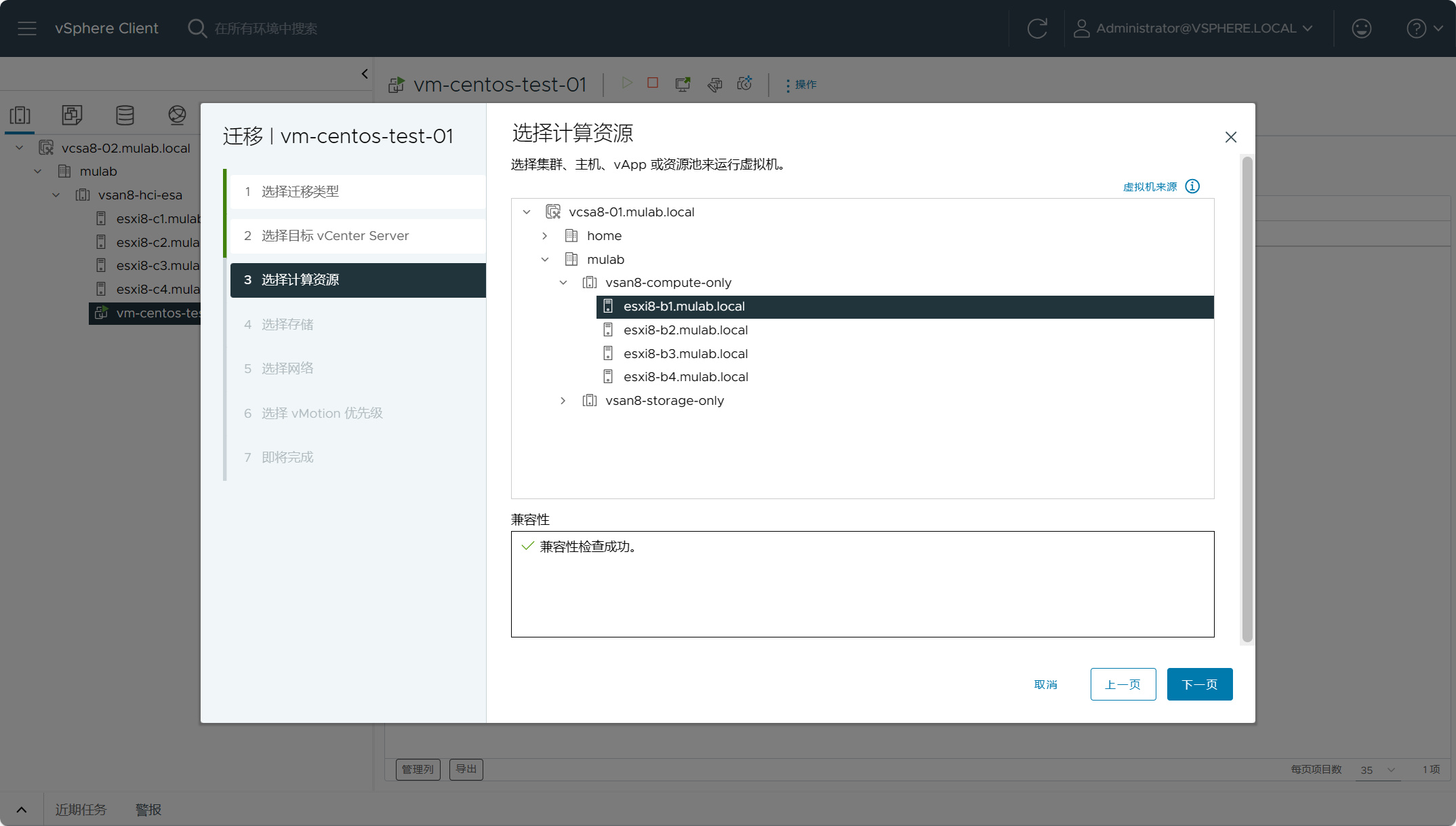

选择目标站点上的vSAN 计算集群,之前vSAN 计算集群远程挂载了vSAN HCI集群的数据存储。

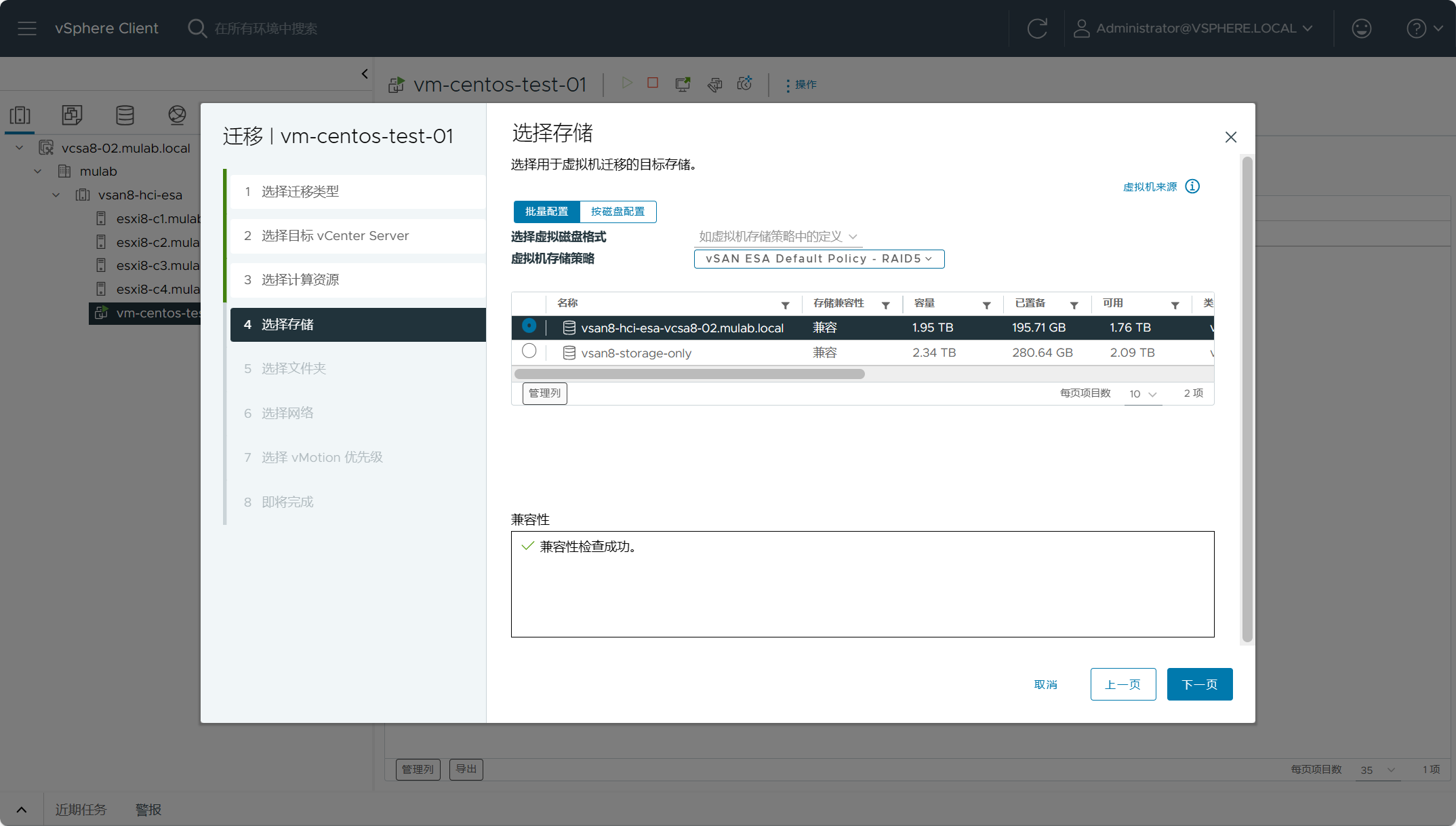

选择虚拟机目标站点上放置的存储,选择自己。

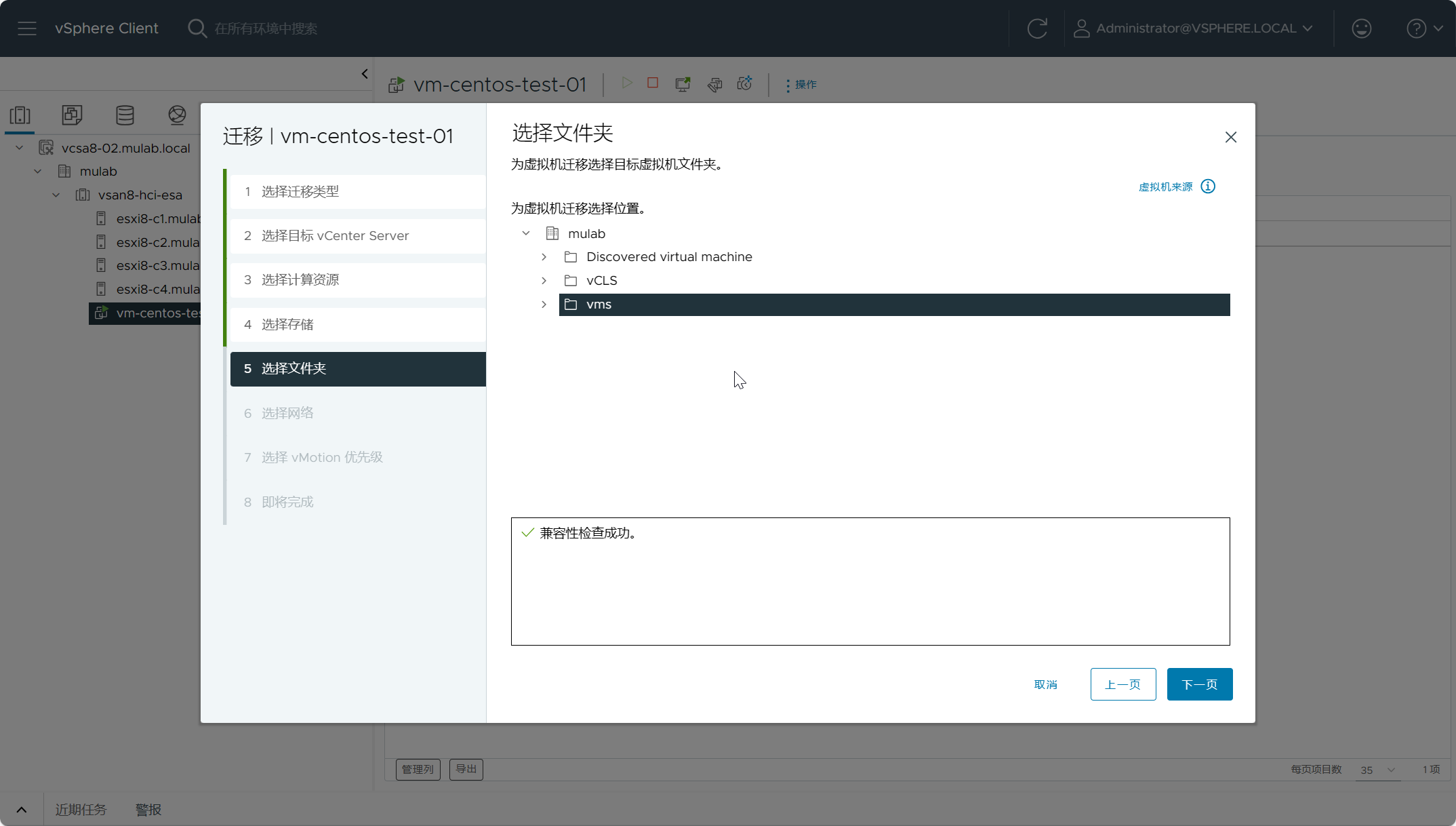

选择虚拟机目标站点上放置的文件夹位置。

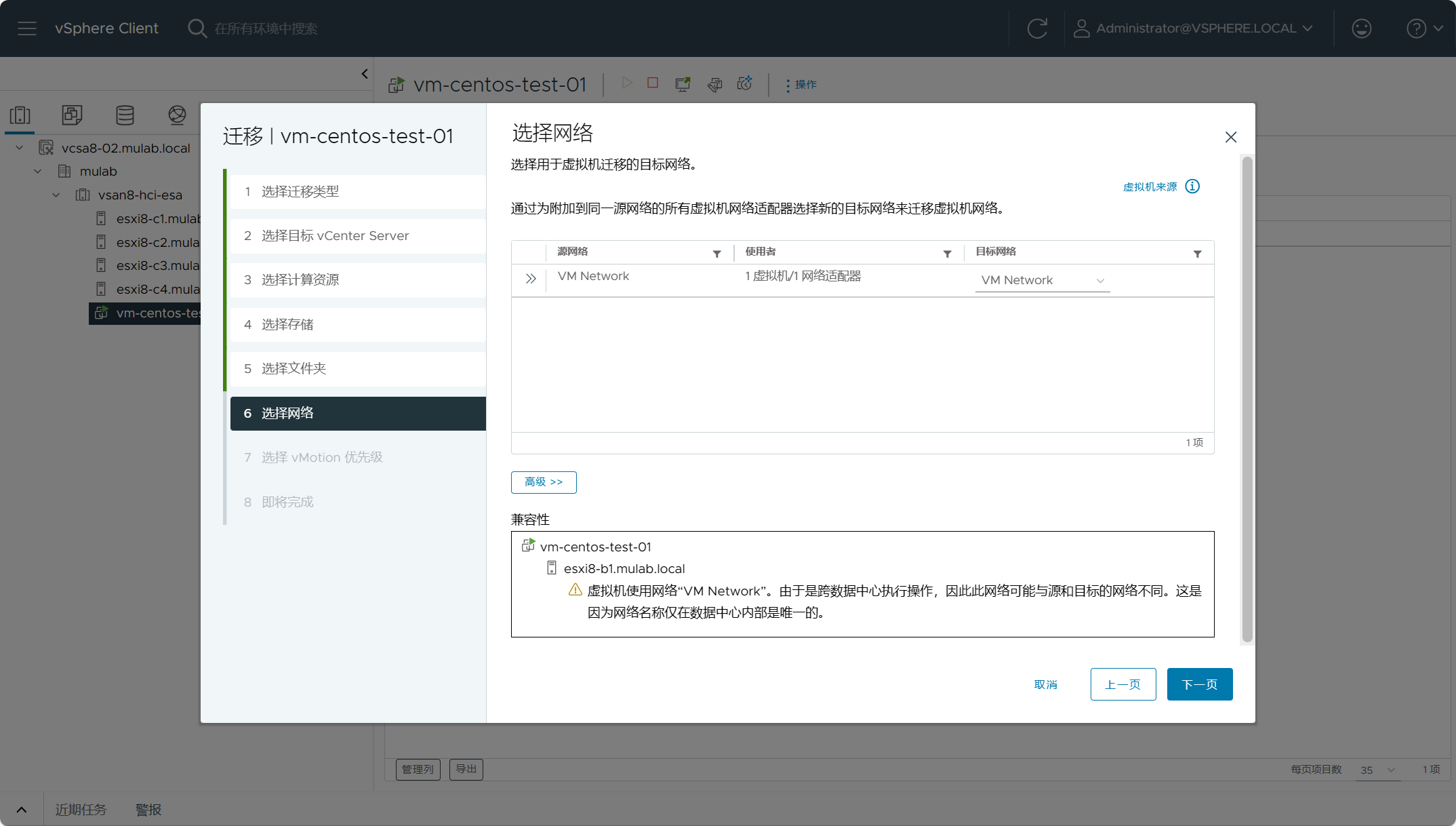

选择虚拟机目标站点中的网络。

点击完成,开始迁移。

几乎秒热迁移到目标站点上。

但是真实数据的存放位置还在原来站点的集群上。

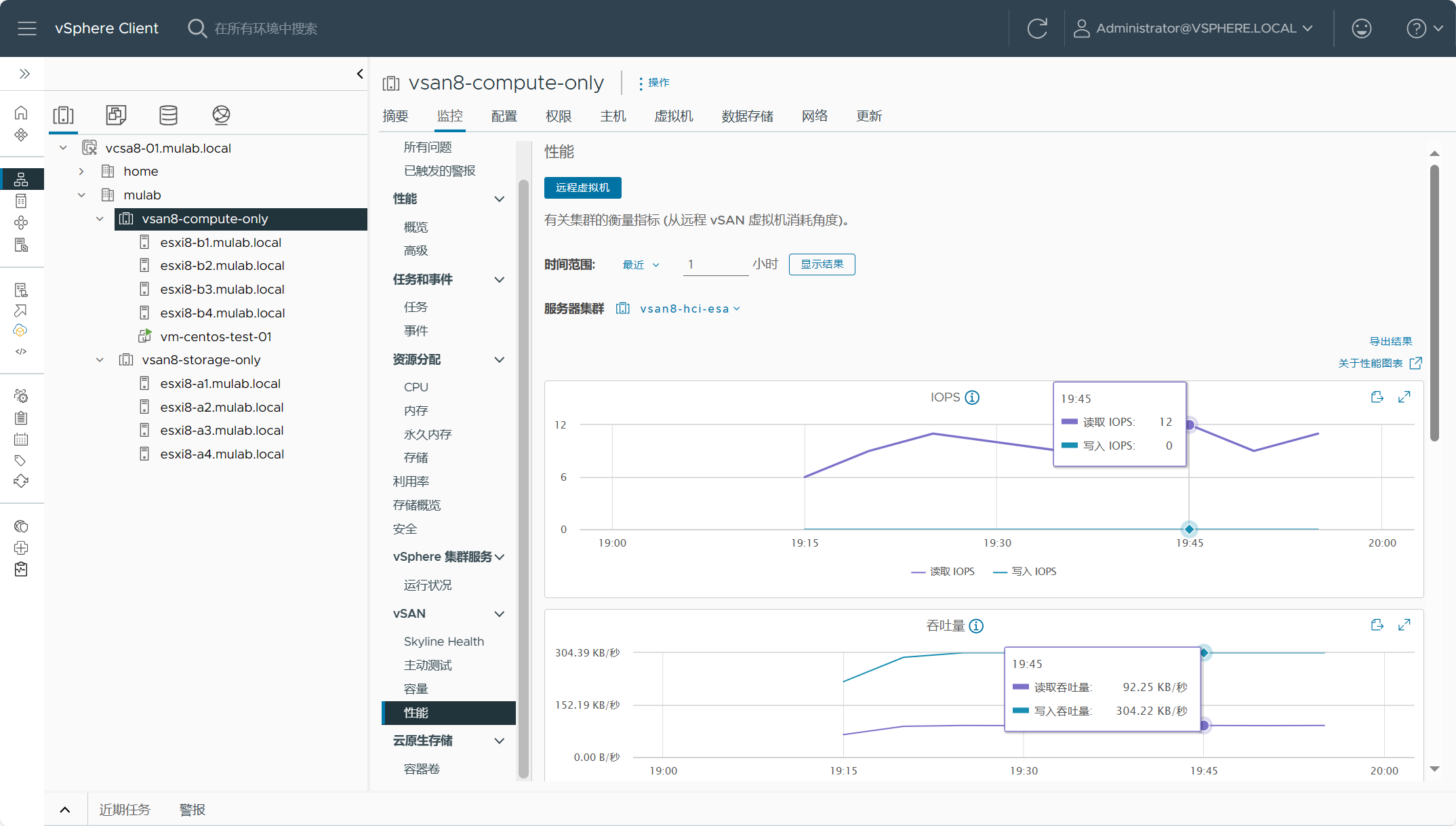

在vSAN 计算集群上查看远程虚拟机的性能。

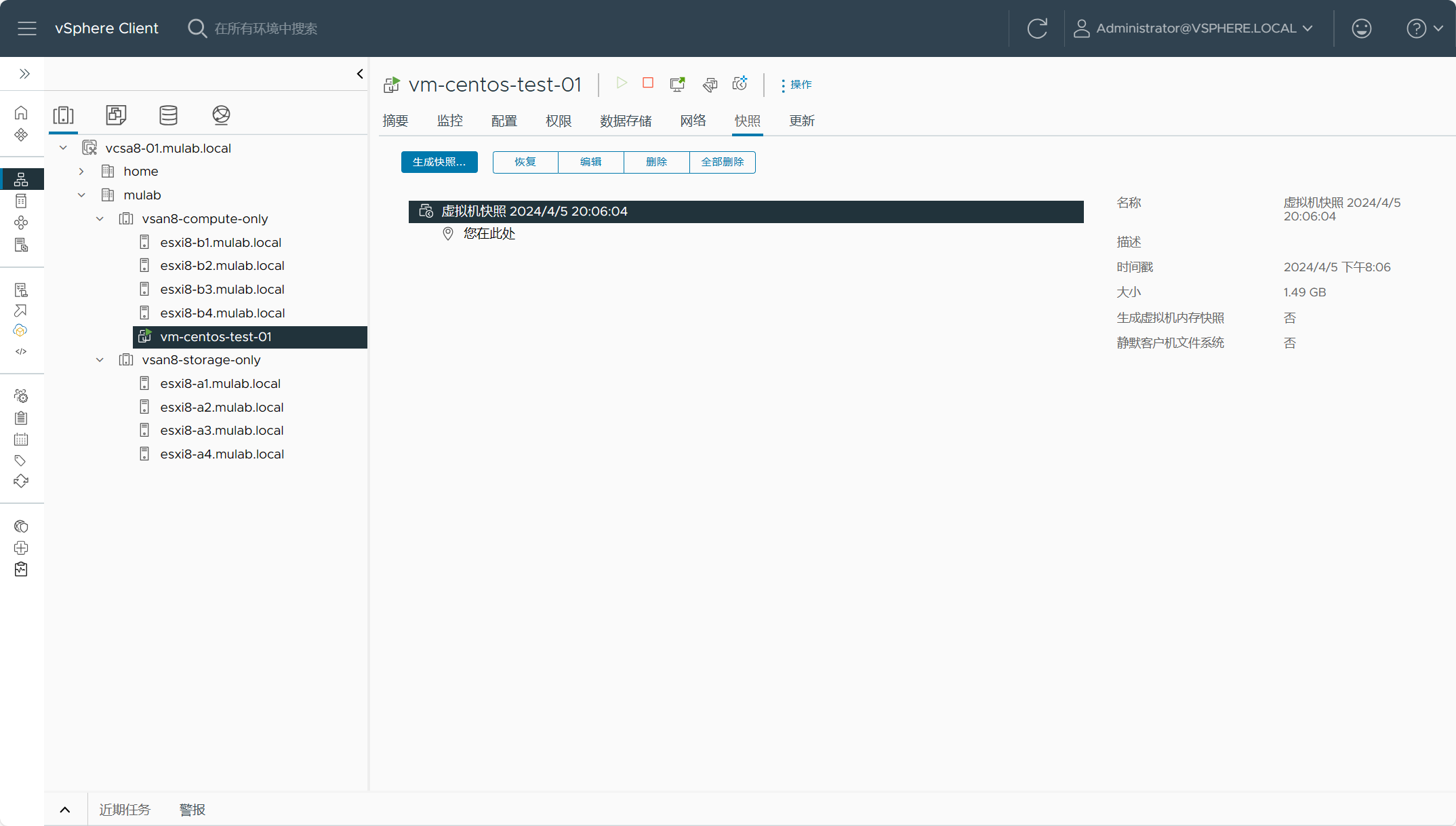

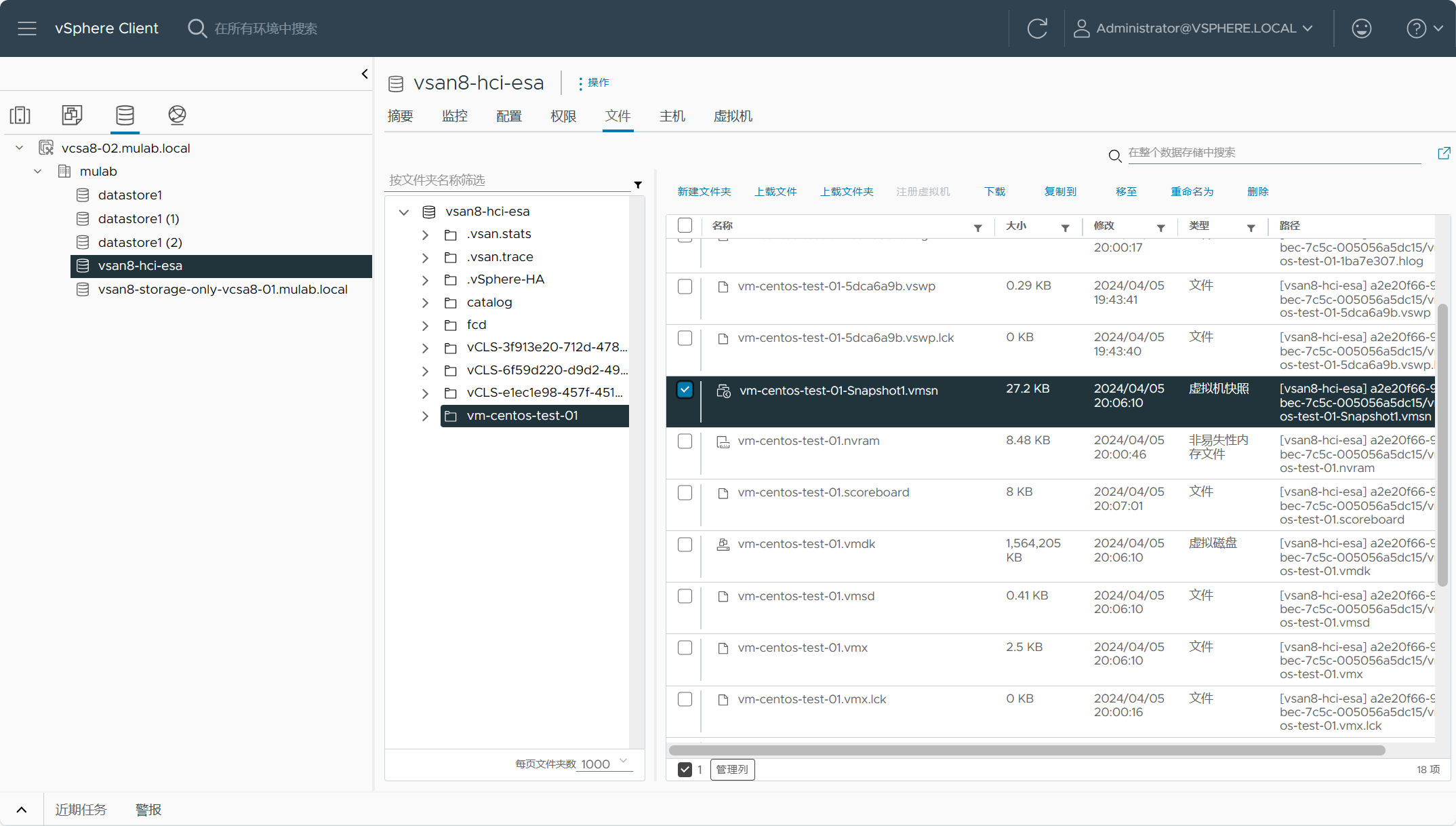

对虚拟机生成快照。

所有数据都存放在远端站点上。

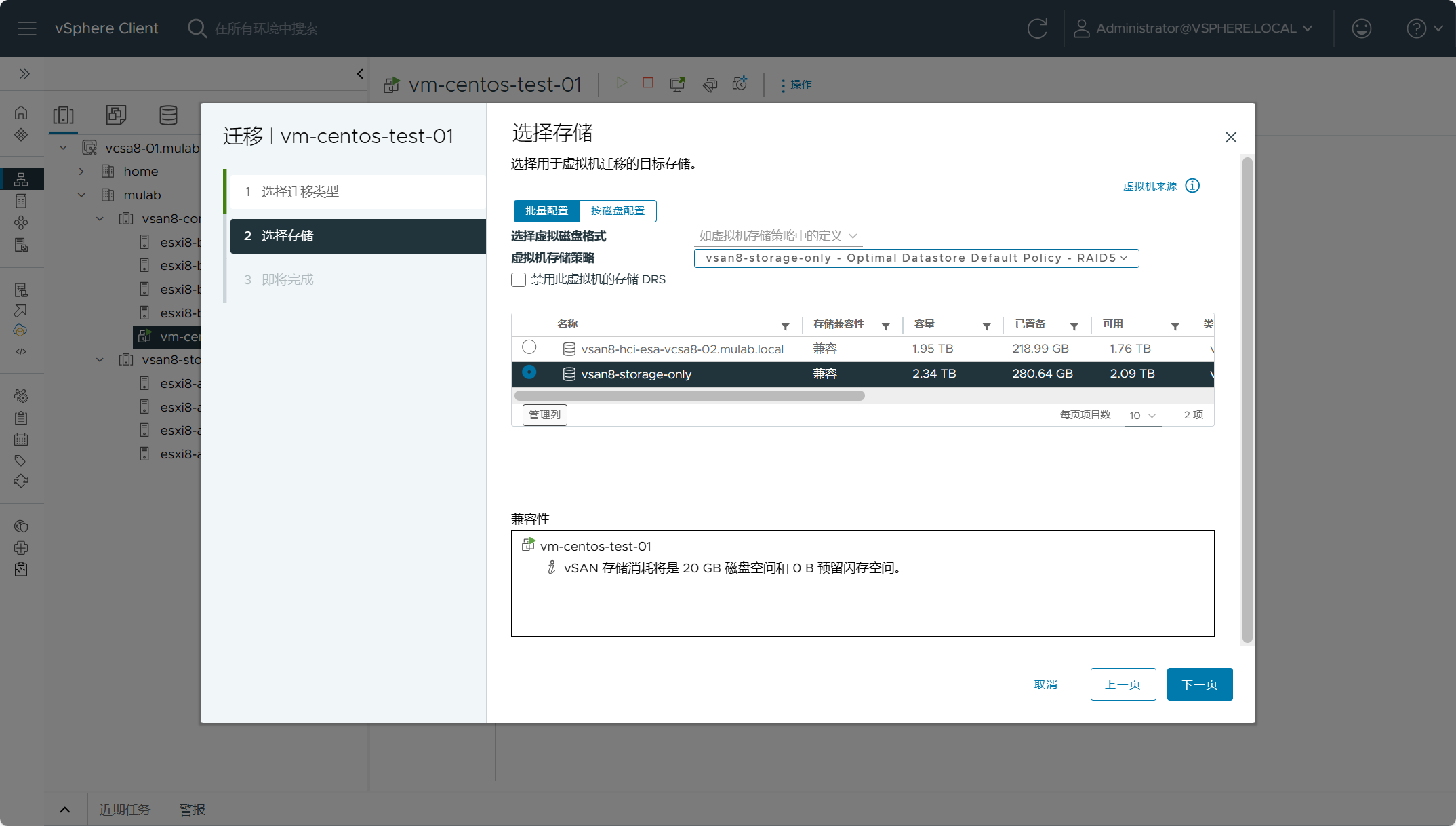

右击虚拟机迁移,选择仅更改存储,选择目标存储为vsan8-storage-only。

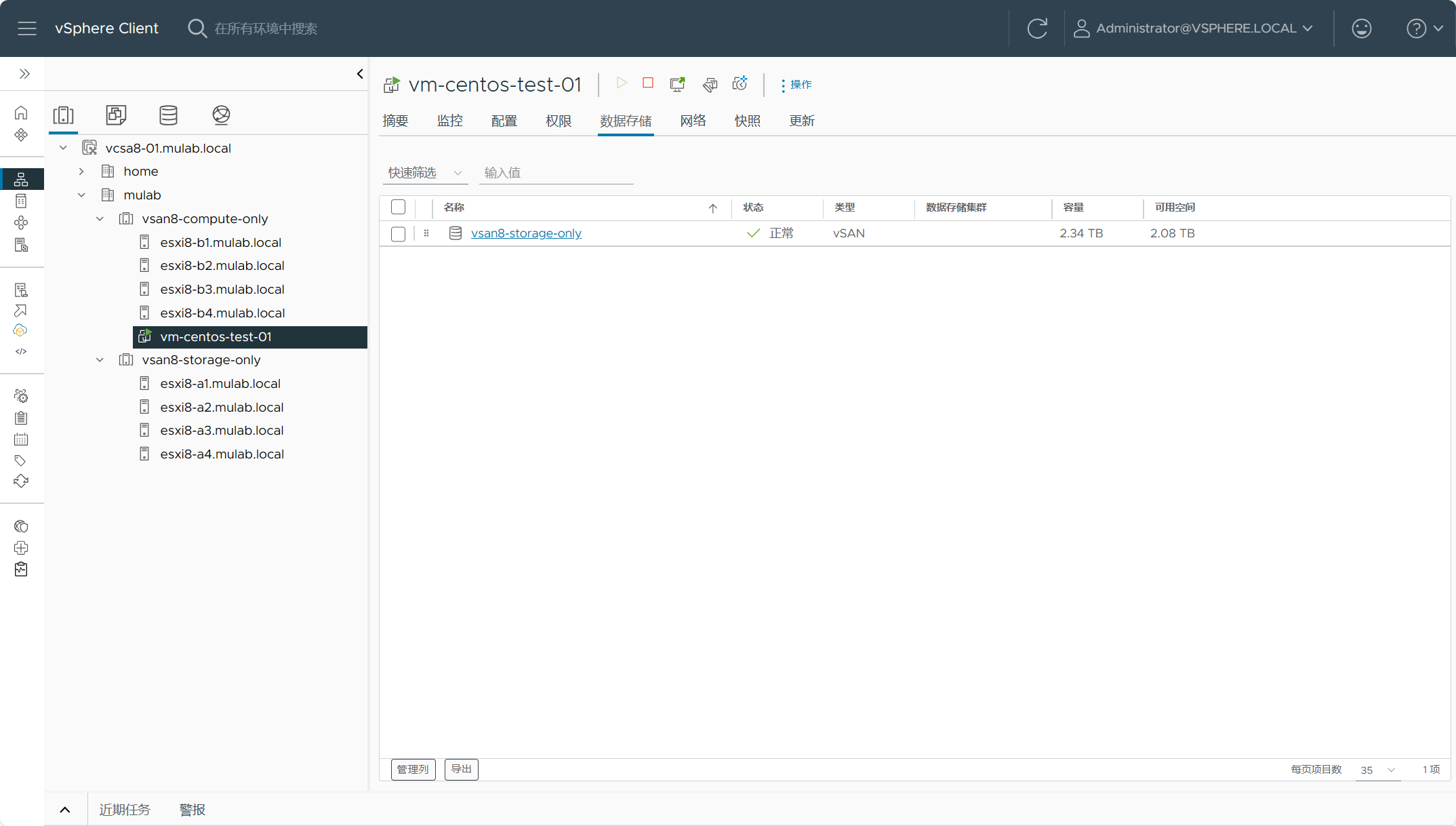

虚拟机已热迁移至vSAN Max存储。

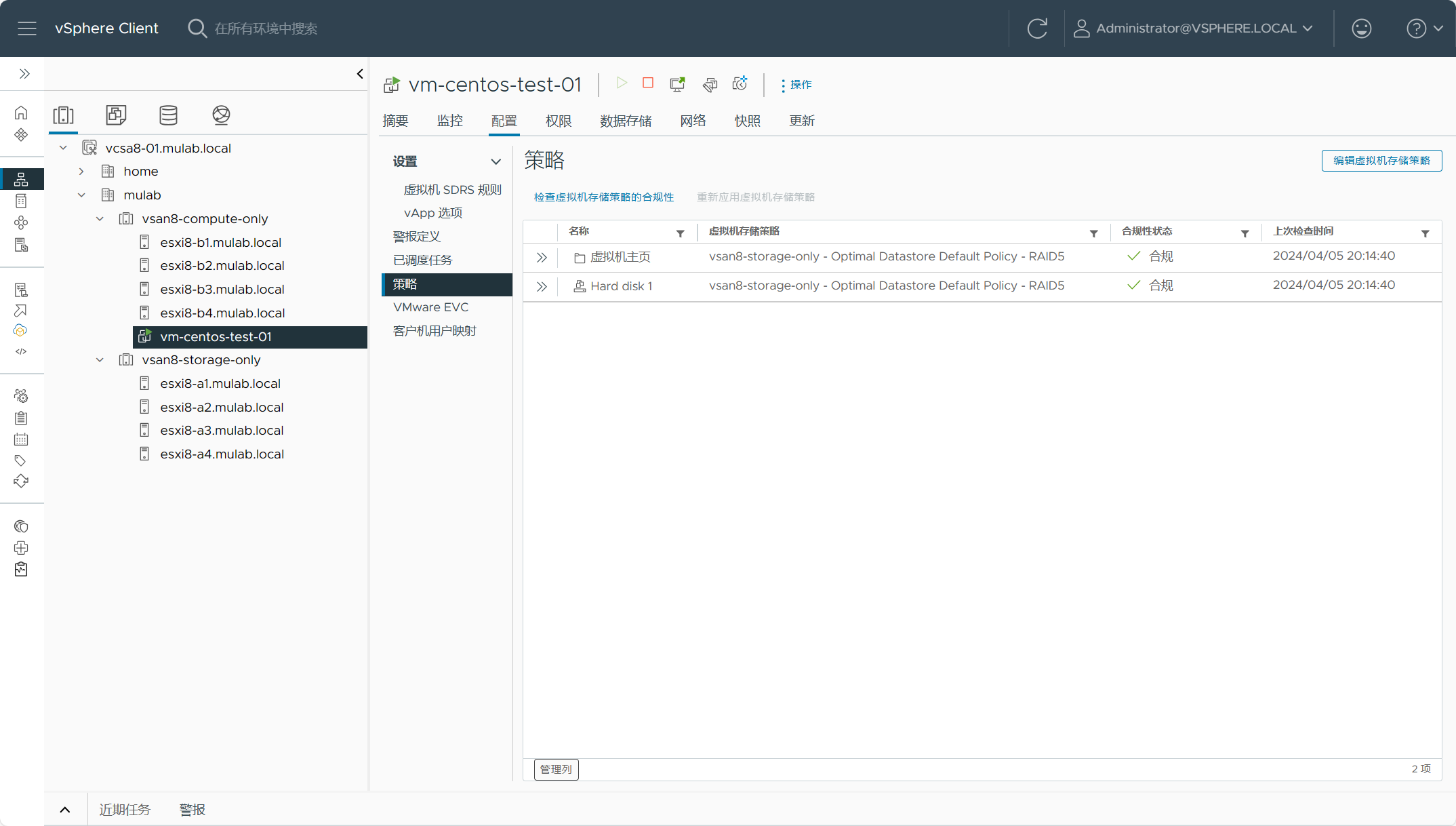

查看虚拟机的存储策略。

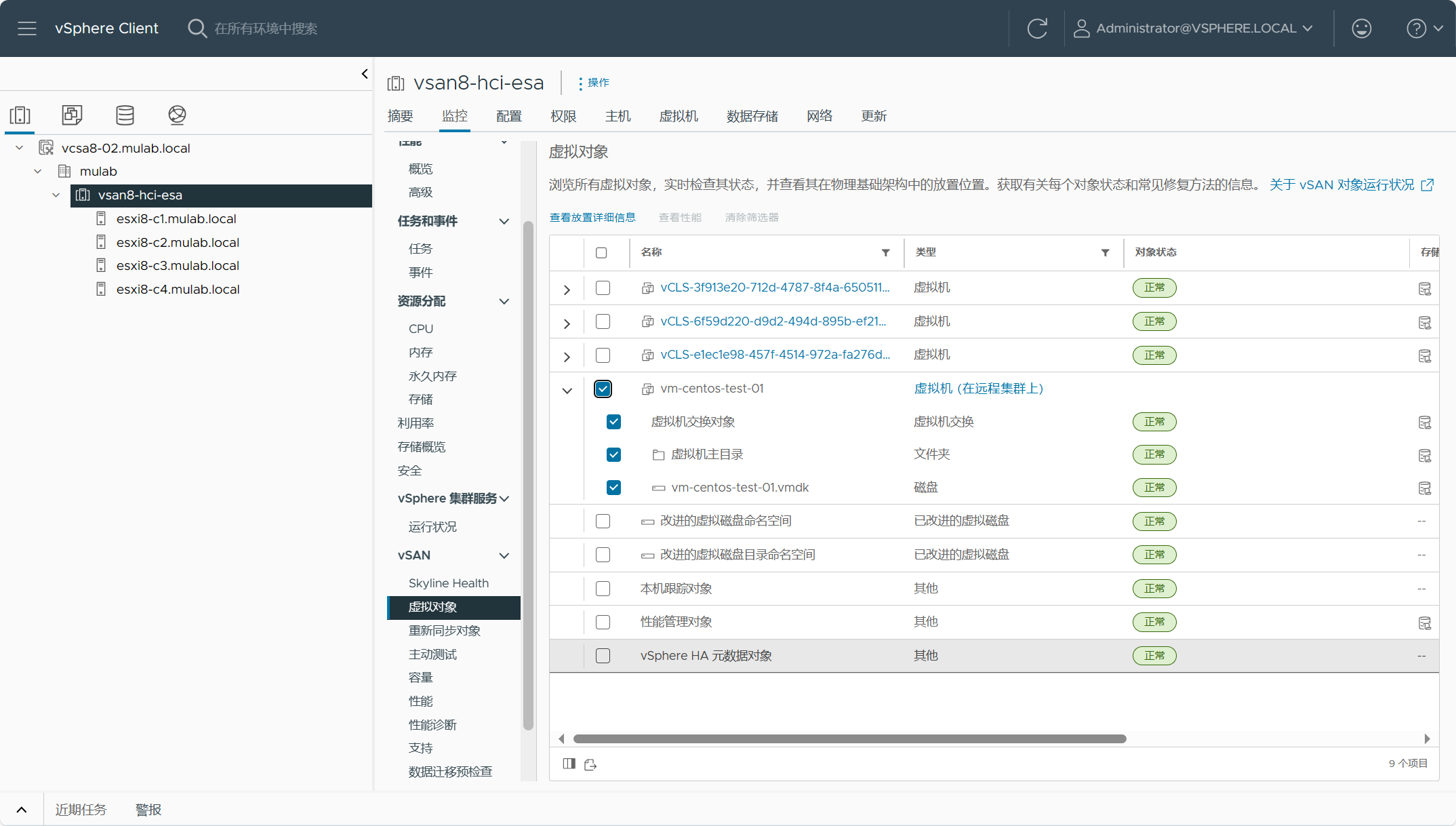

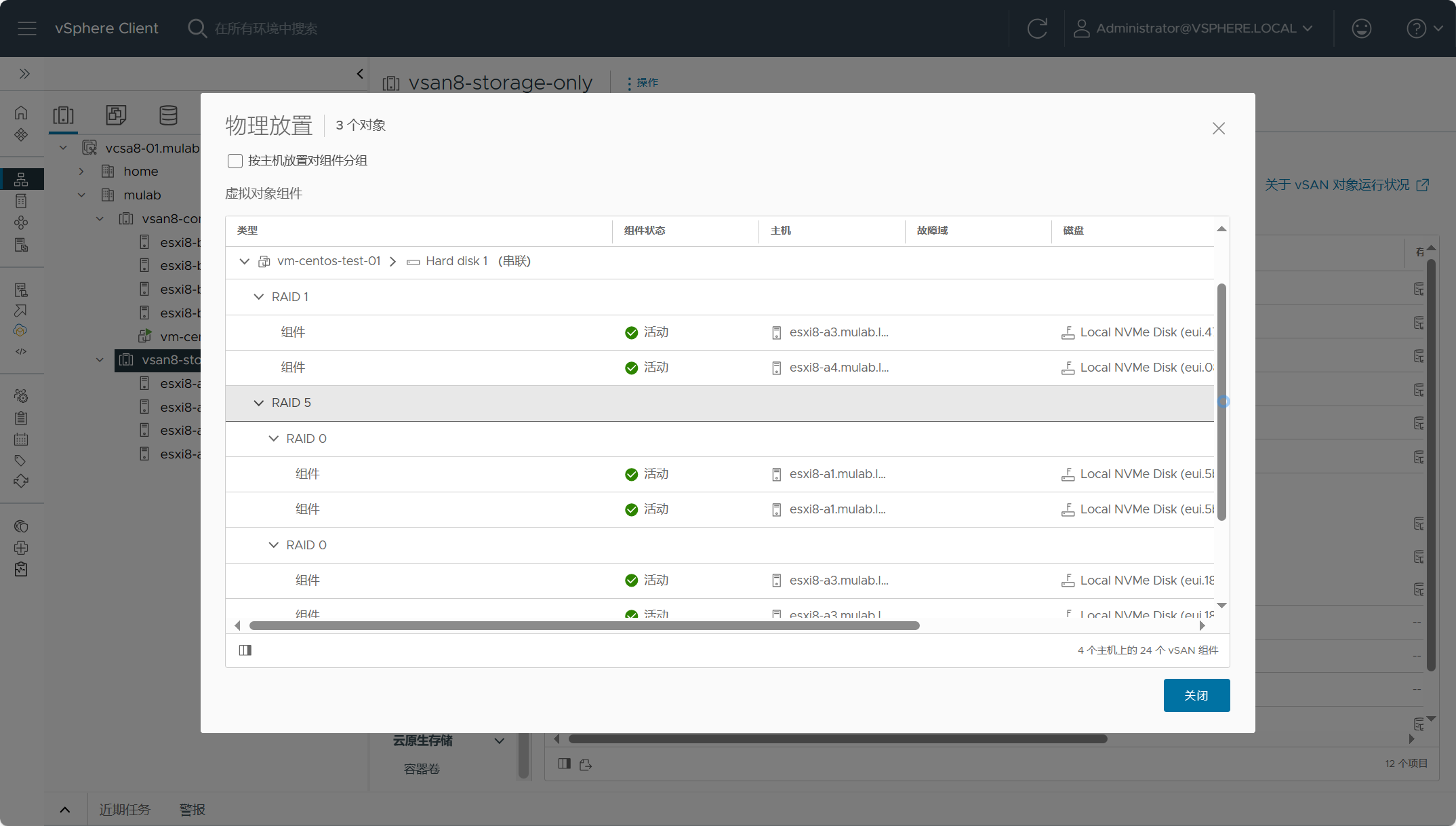

在vSAN Max集群上查看虚拟机对象的详细放置信息。

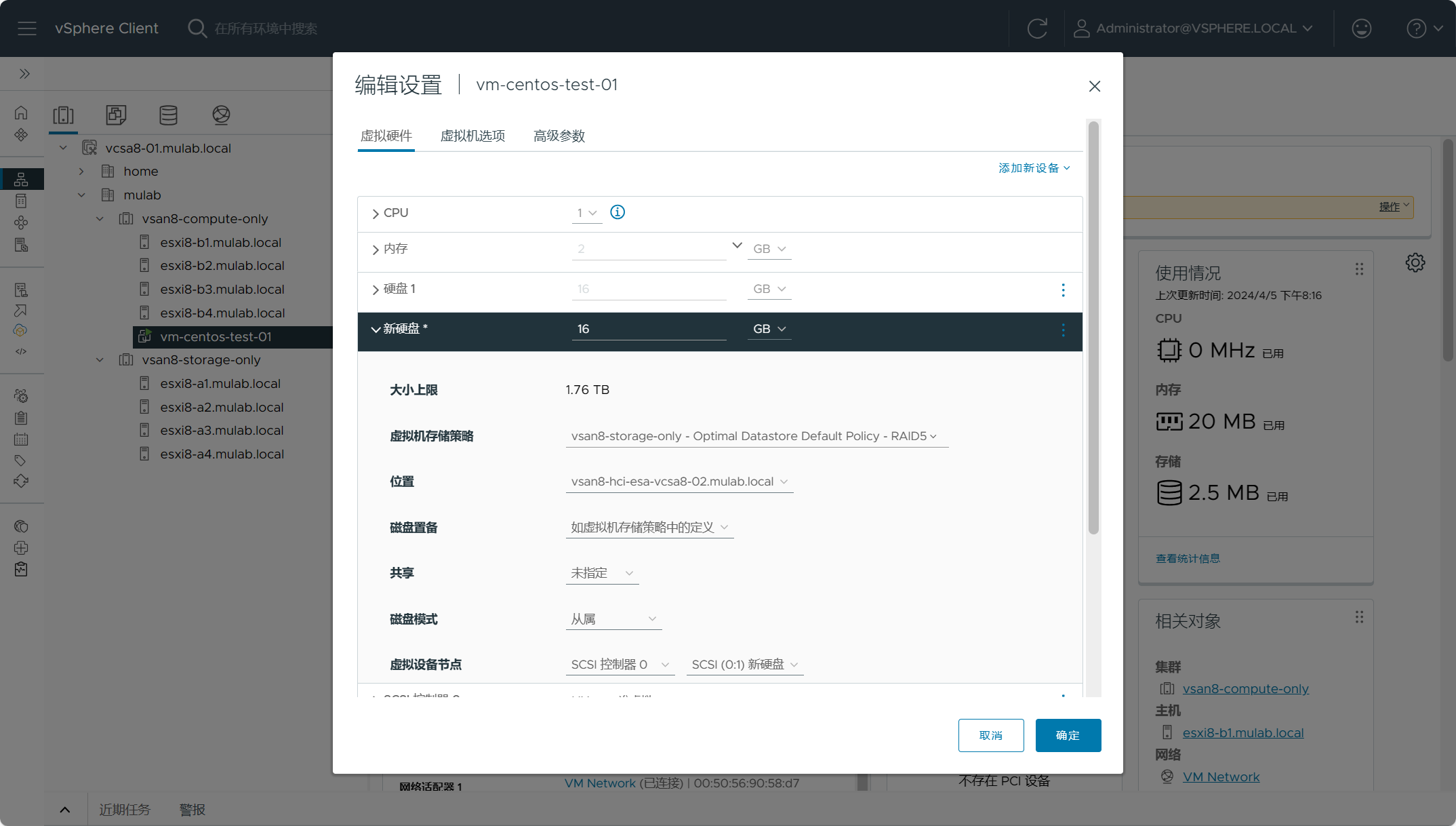

编辑虚拟机设置,给虚拟机添加一块新的硬盘,选择磁盘位置为远端站点上的vsan8-hci-esa存储。

这样也可以......

查看虚拟机的远程对象详细信息。

至此结束,感谢观看。

参考:

【VMware vSAN】创建vSAN Max集群并配置挂载远程数据存储。的更多相关文章

- 从VMware虚拟机安装到hadoop集群环境配置详细说明(第一期)

http://blog.csdn.net/whaoxysh/article/details/17755555 虚拟机安装 我安装的虚拟机版本是VMware Workstation 8.04,自己电脑上 ...

- 在VMWare中建立Hadoop虚拟集群的详细步骤(使用CentOS)

最近在学习Hadoop,于是想使用VMWare建立一个虚拟的集群环境.网上有很多参考资料,但参照其步骤进行设置时却还是遇到了不少问题,所以在这里详细写一下我的配置过程,以及其中遇到的问题及相应的解决方 ...

- 实战weblogic集群之创建节点和集群

一.启动weblogic,访问控制台 weblogic的domain创建完成后,接下来就可以启动它,步骤如下: $ cd /app/sinova/domains/base_domain/bin $ . ...

- Redis创建高可用集群教程【Windows环境】

模仿的过程中,加入自己的思考和理解,也会有进步和收获. 在这个互联网时代,在高并发和高流量可能随时爆发的情况下,单机版的系统或者单机版的应用已经无法生存,越来越多的应用开始支持集群,支持分布式部署了. ...

- 在线创建MongoDB免费集群(MangoDB Atlas)

MongoDB Atlas是MongoDB的云服务,构建在亚马逊的AWS上,MongoDB允许用户在上面创建一个免费集群作为学习使用. 1. 注册MongoDB cloud账号: 访问www.mong ...

- Azure Databricks 第一篇:创建工作区、集群和Notebook

Azure Databricks是一个可扩展的数据分析平台,基于Apache Spark.Azure Databricks 工作区(Workspace)是一个交互式的环境,工作区把对象(noteboo ...

- docker下创建redis cluster集群

概述 在Redis中,集群的解决方案有三种 主从复制 哨兵机制 Cluster Redis Cluster是Redis的分布式解决方案,在 3.0 版本正式推出. 准备工作 1.确定本机IP地址 2. ...

- SpringCloud创建Eureka模块集群

1.说明 本文详细介绍Spring Cloud创建Eureka模块集群的方法, 基于已经创建好的Spring Cloud Eureka Server模块, 请参考SpringCloud创建Eureka ...

- 【Big Data】HADOOP集群的配置(一)

Hadoop集群的配置(一) 摘要: hadoop集群配置系列文档,是笔者在实验室真机环境实验后整理而得.以便随后工作所需,做以知识整理,另则与博客园朋友分享实验成果,因为笔者在学习初期,也遇到不少问 ...

- hadoop+yarn+hbase+storm+kafka+spark+zookeeper)高可用集群详细配置

配置 hadoop+yarn+hbase+storm+kafka+spark+zookeeper 高可用集群,同时安装相关组建:JDK,MySQL,Hive,Flume 文章目录 环境介绍 节点介绍 ...

随机推荐

- GROW模型:世界上最常用的教练模型(**案例及全套表单)

http://www.360doc.com/content/21/0812/18/76566468_990752480.shtml <高绩效教练>一书的核心方法就是GROW模型. GROW ...

- h5页面在微信打开,ios底部存在返回横条的问题

我的问题比较简单,一个处理链接的页面,二次跳转进入真正的页面,导致ios出现返回横条,点击后退回到了处理链接页面.因为这个后退不会重新加载,导致一直处在处理链接的这个空页面. 所以我用replace代 ...

- 06-Redis系列之-哨兵(Redis-Sentinel)和集群详解和搭建

主从架构高可用 主从架构存在的问题 主从复制,主节点发生故障,需要做故障转移.(可以手动转移:让其中一个slave变成master) 主从复制,只有主写数据,所以写能力和存储能力有限 总结:redis ...

- Windows开发环境如何启用Directory.Build.props版本号集中管理

每个产品一个根目录 Directory.Build.props的工作模式和NuGet.Config不同,Directory.Build.props不能继承.当dotnet restore工作的时候,会 ...

- 【Azure 事件中心】向Event Hub发送数据异常 : partitionId[null]: Sending messages timed out

问题描述 在使用Java 代码向 Azure Event Hub发送数据时,先后遇见了如下两种异常消息: 1)ERROR c.t.d.h.s.source.EventHubLogConsumer - ...

- 【Azure 环境】Azure CLI 获取Access Token的脚本实例

问题描述 如何使用azure CLI命令获取到中国区的Access Token呢? 问题解答 首先,需要通过 az cloud set --name AzureChinaCloud 来设置登录中国区的 ...

- 【Azure 应用服务】App Service - 在修改应用服务计划的页面中,为什么无法查看到同一个资源组下面的其他应用服务计划(App Service Plan)呢?

问题描述 在App Service的门户上,可以通过"Change App Service Plan"来改变当前App Service所属的应用服务计划(App Service P ...

- 【Azure 应用服务】Azure App Service能否使用Storage Account File Share

问题描述 Azure App Service能否使用Storage Account File Share? 问题回答 如果部署的App Service为Linux环境,可以直接使用Mount stor ...

- [Linux] ubuntu系统使用zfs记录

关于zfs 之前从B站视频里面了解到了btrfs这个文件系统,说是能够实现cow,然后我第一时间觉得这是个极好的特性,结果后来才发现,使用的时候并不多,而且只能通过cp --reflink的方式使用, ...

- Linux 多进程服务配置 systemd

目录 Linux 多进程服务配置 systemd sysvinit和systemd 多进程保活 创建配置文件(设定重试次数) 多进程服务管理 链式启动(服务依赖) 指定关闭进程方式 - ExecSto ...