python requests、xpath爬虫增加博客访问量

这是一个分析IP代理网站,通过代理网站提供的ip去访问CSDN博客,达到以不同ip访同一博客的目的,以娱乐为主,大家可以去玩一下。

首先,准备工作,设置User-Agent:

#1.headers

headers={'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:68.0) Gecko/20100101 Firefox/68.0'}

然后百度一个IP代理网站,我选用的是https://www.kuaidaili.com/free,解析网页,提取其中的ip、端口、类型,并以list保存:

#1.获取IP地址

html=requests.get('https://www.kuaidaili.com/free').content.decode('utf8')

tree = etree.HTML(html)

ip = tree.xpath("//td[@data-title='IP']/text()")

port=tree.xpath("//td[@data-title='PORT']/text()")

model=tree.xpath("//td[@data-title='类型']/text()")

接着分析个人博客下的各篇文章的url地址,以list保存

#2.获取CSDN文章url地址 ChildrenUrl[]

url='https://blog.csdn.net/weixin_43576564'

response=requests.get(url,headers=headers)

Home=response.content.decode('utf8')

Home=etree.HTML(Home)

urls=Home.xpath("//div[@class='article-item-box csdn-tracking-statistics']/h4/a/@href")

ChildrenUrl=[]

然后通过代理ip去访问个人博客的各篇文章,通过for循环,一个ip将所有文章访问一遍,通过解析"我的博客"网页,获取总浏览量,实时监控浏览量是否发生变化,设置任务数,实时显示任务进度,通过random.randint()设置sleep时间,使得spider更加安全。全代码如下:

import os

import time

import random

import requests

from lxml import etree

#准备部分

#1.headers

headers={'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:68.0) Gecko/20100101 Firefox/68.0'} #1.获取IP地址

html=requests.get('https://www.kuaidaili.com/free').content.decode('utf8')

tree = etree.HTML(html)

ip = tree.xpath("//td[@data-title='IP']/text()")

port=tree.xpath("//td[@data-title='PORT']/text()")

model=tree.xpath("//td[@data-title='类型']/text()") #2.获取CSDN文章url地址 ChildrenUrl[]

url='https://blog.csdn.net/weixin_43576564'

response=requests.get(url,headers=headers)

Home=response.content.decode('utf8')

Home=etree.HTML(Home)

urls=Home.xpath("//div[@class='article-item-box csdn-tracking-statistics']/h4/a/@href")

ChildrenUrl=[]

for i in range(1,len(urls)):

ChildrenUrl.append(urls[i]) oldtime=time.gmtime() browses=int(input("输入需要访问次数:"))

browse=0

#3.循环伪装ip并爬取文章

for i in range(1,len(model)):

#设计代理ip

proxies={model[i]:'{}{}'.format(ip[i],port[i])}

for Curl in ChildrenUrl:

try:

browse += 1

print("进度:{}/{}".format(browse,browses),end="\t")

#遍历文章

response=requests.get(Curl,headers=headers,proxies=proxies)

#获取访问人数

look=etree.HTML(response.content)

Nuwmunber=look.xpath("//div[@class='grade-box clearfix']/dl[2]/dd/text()")

count=Nuwmunber[0].strip()

print("总浏览量:{}".format(count),end="\t")

''' 重新实现 #每个IP进行一次查询

if Curl==ChildrenUrl[5]:

ipUrl='http://www.ip138.com/'

response=requests.get(ipUrl,proxies=proxies)

iphtml=response.content

ipHtmlTree=etree.HTML(iphtml)

ipaddress=ipHtmlTree.xpath("//p[@class='result']/text()")

print(ip[i],ipaddress)

'''

i = random.randint(5, 30)

print("间隔{}秒".format(i),end="\t")

time.sleep(i)

print("当前浏览文章地址:{}".format(Curl))

if browse == browses:

print("已完成爬取任务,共消耗{}秒".format(int(time.perf_counter())))

os._exit(0) except:

print('error')

os._exit(0) #打印当前代理ip

print(proxies)

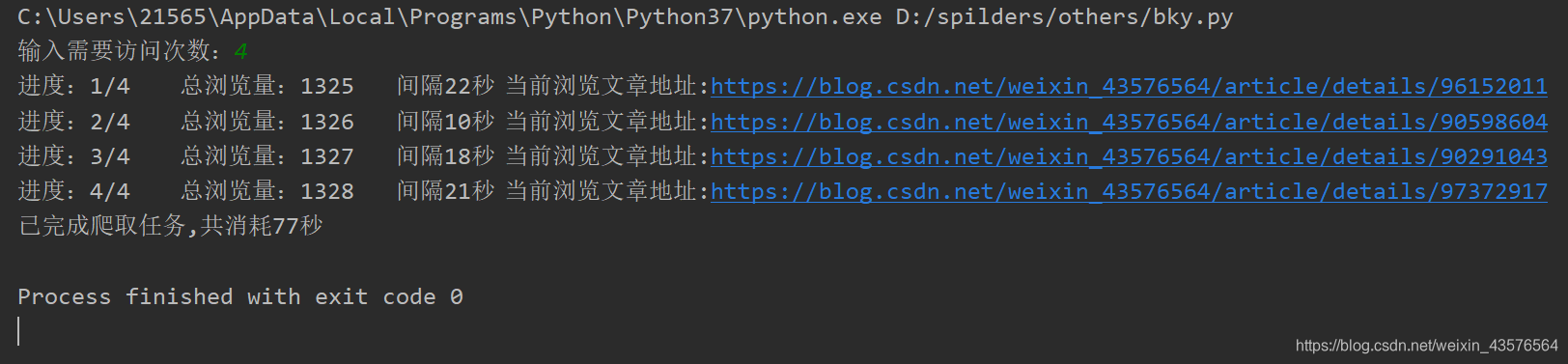

实际运行效果图:

python requests、xpath爬虫增加博客访问量的更多相关文章

- Python爬虫小实践:爬取任意CSDN博客所有文章的文字内容(或可改写为保存其他的元素),间接增加博客访问量

Python并不是我的主业,当初学Python主要是为了学爬虫,以为自己觉得能够从网上爬东西是一件非常神奇又是一件非常有用的事情,因为我们可以获取一些方面的数据或者其他的东西,反正各有用处. 这两天闲 ...

- python之刷博客访问量

通过写刷访问量学习正则匹配 说明信息 说明:仅仅是为了熟悉正则表达式以及网页结构,并不赞成刷访问量操作. 1.刷访问量第一版 1.1 确定网页url结构,构造匹配模式串 首先是要确定刷的网页.第一版实 ...

- python编写的自动获取代理IP列表的爬虫-chinaboywg-ChinaUnix博客

python编写的自动获取代理IP列表的爬虫-chinaboywg-ChinaUnix博客 undefined Python多线程抓取代理服务器 | Linux运维笔记 undefined java如 ...

- 用Python和Django实现多用户博客系统(二)——UUBlog

这次又更新了一大部分功能,这次以app的形式来开发. 增加博客分类功能:博客关注.推荐功能(ajax实现) 增加二级频道功能 更多功能看截图及源码,现在还不完善,大家先将就着看.如果大家有哪些功能觉的 ...

- Orchard官方文档翻译(八) 为站点增加博客

原文地址:http://docs.orchardproject.net/Documentation/Adding-a-blog-to-your-site 想要查看文档目录请用力点击这里 最近想要学习了 ...

- 这几天有django和python做了一个多用户博客系统(可选择模板)

这几天有django和python做了一个多用户博客系统(可选择模板) 没完成,先分享下 断断续续2周时间吧,用django做了一个多用户博客系统,现在还没有做完,做分享下,以后等完善了再慢慢说 做的 ...

- python环境变量配置 - CSDN博客

一.下载: 1.官网下载python3.0系列(https://www.python.org/) 2.下载后图标为: 二.安装: Window下: 1.安装路径: 默认安装路径:C:\python35 ...

- (最新)使用爬虫刷CSDN博客访问量——亲测有效

说明:该篇博客是博主一字一码编写的,实属不易,请尊重原创,谢谢大家! 1.概述 前言:前两天刚写了第一篇博客https://blog.csdn.net/qq_41782425/article/deta ...

- Python网络数据采集(1):博客访问量统计

前言 Python中能够爬虫的包还有很多,但requests号称是“让HTTP服务人类”...口气不小,但的确也很好用. 本文是博客里爬虫的第一篇,实现一个很简单的功能:获取自己博客主页里的访问量. ...

随机推荐

- 3012C语言_数据

第二章 数据 2.1 数据类型 2.1.1 数据类型决定 1. 数据占内存字节数 2. 数据取值范围 3. 其上可进行的操作 2.2基本数据类型 2.2.1分类 基本类型 类型 符号 关键字 字节 1 ...

- python网络爬虫(10)分布式爬虫爬取静态数据

目的意义 爬虫应该能够快速高效的完成数据爬取和分析任务.使用多个进程协同完成一个任务,提高了数据爬取的效率. 以百度百科的一条为起点,抓取百度百科2000左右词条数据. 说明 参阅模仿了:https: ...

- Mount挂载/data时出现mount: /data is busy 如何解决?

1.df -h查看下挂载点/data是否正在使用,有时候会存在挂载了,但df -h不会显示出来,这时候 grep “/data” /proc/mounts 来进行查看 2.当确认挂载点/data正在使 ...

- Python基础,day2

程序练习 程序:购物车程序 需求: 启动程序后,让用户输入工资,然后打印商品列表 允许用户根据商品编号购买商品 用户选择商品后,检测余额是否够,够就直接扣款,不够就提醒 可随时退出,退出时,打印已购买 ...

- Metasploit实现木马生成、捆绑、免杀

原创博客,转载请注出处! 我的公众号,正在建设中,欢迎关注: Meatsploit介绍 2018/01/03 更新 Metasploit是一款优秀的开源(!= 完全免费)渗透测试框架平台,在该平台下可 ...

- Storm 学习之路(七)—— Storm集成 Redis 详解

一.简介 Storm-Redis提供了Storm与Redis的集成支持,你只需要引入对应的依赖即可使用: <dependency> <groupId>org.apache.st ...

- js获取radio选中索引值

<form name="form1" onsubmit="return foo()"> <input type="radio&quo ...

- 33 | 无实例无真相:基于LoadRunner实现企业级服务器端性能测试的实践(下)

- 分布式全局ID生成方案

传统的单体架构的时候,我们基本是单库然后业务单表的结构.每个业务表的ID一般我们都是从1增,通过AUTO_INCREMENT=1设置自增起始值,但是在分布式服务架构模式下分库分表的设计,使得多个库或多 ...

- .Net之Layui多图片上传

前言: 多图上传在一些特殊的需求中我们经常会遇到,其实多图上传的原理大家都有各自的见解.对于Layui多图上传和我之前所说的通过js获取文本框中的文件数组遍历提交的原理一样,只不过是Layui中的up ...