spark 在yarn模式下提交作业

1、spark在yarn模式下提交作业需要启动hdfs集群和yarn,具体操作参照:hadoop 完全分布式集群搭建

2、spark需要配置yarn和hadoop的参数目录

将spark/conf/目录下的spark-env.sh.template文件复制一份,加入配置:

YARN_CONF_DIR=/opt/hadoop/hadoop-2.8.3/etc/hadoop

HADOOP_CONF_DIR=/opt/hadoop/hadoop-2.8.3/etc/hadoop

3、将spark整个目录分发到hdfs集群中每台机器上,分发命令可以参考:linux rsync

如果不想用rsync也可以直接用scp -r拷贝,测试环境下差别不大。

4、提交作业测试

bin/spark-submit --class org.apache.spark.examples.SparkPi --master yarn --deploy-mode client ./examples/jars/spark-examples_2.11-2.4.4.jar 200

正常情况下很快就能计算完成:

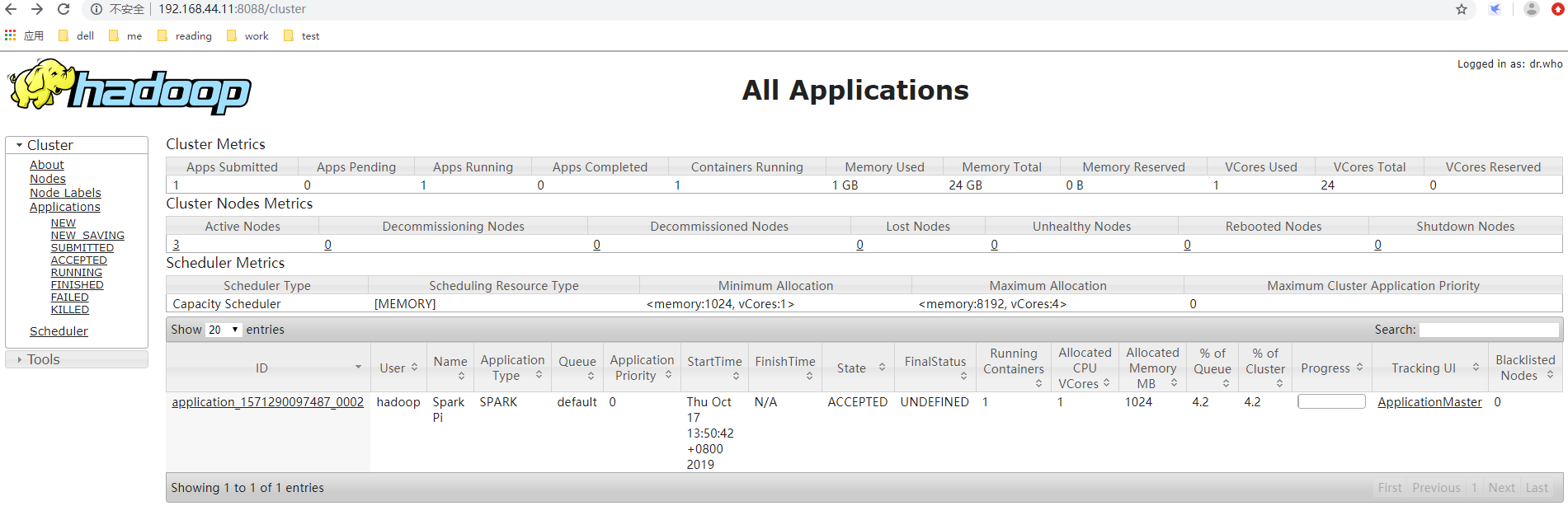

在yarn的UI可以监控到执行的作业:

5、spark参数优先级

Spark加载属性参数的优先顺序是:

(1)直接在SparkConf设置的属性参数

(2)通过 spark-submit 或 spark-shell 方式传递的属性参数

(3)最后加载 spark-defaults.conf 配置文件的属性参数

如果在程序里指定了SparkConf的参数,则spark缺省参数以及命令行参数都将失效,如果想灵活一下,我们可以在SparkConf加载缺省配置(spark-defaults.conf),然后在命令方式下覆盖参数。

val conf: SparkConf = new SparkConf(true).setAppName("SparkWordCount")

master这个参数就可以指定local或者yarn等模式,但是name参数在命令指定是无效的,因为已经内置了。

bin/spark-submit --master yarn --name myWordCount --class com.home.spark.WordCount --executor-memory 512M ~/sparkWordCount.jar hdfs://vmhome10.com:9000/input

spark 在yarn模式下提交作业的更多相关文章

- spark on yarn模式下配置spark-sql访问hive元数据

spark on yarn模式下配置spark-sql访问hive元数据 目的:在spark on yarn模式下,执行spark-sql访问hive的元数据.并对比一下spark-sql 和hive ...

- spark on yarn模式下内存资源管理(笔记1)

问题:1. spark中yarn集群资源管理器,container资源容器与集群各节点node,spark应用(application),spark作业(job),阶段(stage),任务(task) ...

- spark on yarn模式下内存资源管理(笔记2)

1.spark 2.2内存占用计算公式 https://blog.csdn.net/lingbo229/article/details/80914283 2.spark on yarn内存分配** 本 ...

- Spark在StandAlone模式下提交任务,spark.rpc.message.maxSize太小而出错

1.错误信息org.apache.spark.SparkException: Job aborted due to stage failure:Serialized task 32:5 was 172 ...

- spark跑YARN模式或Client模式提交任务不成功(application state: ACCEPTED)

不多说,直接上干货! 问题详情 电脑8G,目前搭建3节点的spark集群,采用YARN模式. master分配2G,slave1分配1G,slave2分配1G.(在安装虚拟机时) export SPA ...

- spark跑YARN模式或Client模式提交任务不成功(application state: ACCEPTED)(转)

不多说,直接上干货! 问题详情 电脑8G,目前搭建3节点的spark集群,采用YARN模式. master分配2G,slave1分配1G,slave2分配1G.(在安装虚拟机时) export SPA ...

- flink on yarn模式下两种提交job方式

yarn集群搭建,参见hadoop 完全分布式集群搭建 通过yarn进行资源管理,flink的任务直接提交到hadoop集群 1.hadoop集群启动,yarn需要运行起来.确保配置HADOOP_HO ...

- Spark on YARN模式的安装(spark-1.6.1-bin-hadoop2.6.tgz + hadoop-2.6.0.tar.gz)(master、slave1和slave2)(博主推荐)

说白了 Spark on YARN模式的安装,它是非常的简单,只需要下载编译好Spark安装包,在一台带有Hadoop YARN客户端的的机器上运行即可. Spark on YARN简介与运行wor ...

- spark on yarn模式里需要有时手工释放linux内存

为什么要提出这个问题? spark跑YARN模式或Client模式提交任务不成功(application state: ACCEPTED) 然后执行 [spark@master spark--bin- ...

随机推荐

- zabbix 分布式监控及优化

1..zabbix分布式监控,模拟多机房实现监控? 1.有多机房时,需要用到proxy 1.网络不通 2.网络延迟 2.当监控的主机较多时,也可以用proxy来缓解压力 1.安装proxy [root ...

- 机器学习pipeline总结

# -*- coding: utf-8 -*- """scikit-learn introduction Automatically generated by Colab ...

- 松软科技web课堂:SQLServer之SUM() 函数

SUM() 函数 SUM 函数返回数值列的总数(总额). SQL SUM() 语法 SELECT SUM(column_name) FROM table_name SQL SUM() 实例 我们拥有下 ...

- linux学习(八)Shell中变量的数学运算

目录 常见的运算符 expr命令 @(Shell中变量的数学运算) 常见的运算符 环境变量 说明 + 加 - 减 * 乘 / 除 % 取模 因为Shell中将*作为通配符使用, expr命令 expr ...

- 自己写的一个连数据库的音乐调用模块 MusicRj

#自己定义 class MusicRj: # 创音乐表t_music # sql = '''CREATE TABLE t_music1( # id INT PRIMARY KEY AUTO_INCRE ...

- 记录python上传文件的坑(1)

import random import string import requests from requests_toolbelt import MultipartEncoder f = '2019 ...

- 【西北师大-2108Java】第八次作业成绩汇总

[西北师大-2108Java]第八次作业成绩汇总 作业题目 面向对象程序设计(JAVA)--第10周学习指导及要求 实验目的与要求 (1)掌握java异常处理技术: (2)了解断言的用法: (3)了解 ...

- CF732D Exams

这题可以用二分答案来做 那么为什么可以用二分答案呢? 答案当然是满足了单调性. 假设用\(x\)天能够考完所有试,那么用大于$x $天必定也能够考完所有试,所以满足了单调性,我们就可以二分答案 那么如 ...

- 转载-通过ApplicationContext 去获取所有的Bean

Spring Boot - 获取所有的Bean信息 阅读目录 前言 通过ApplicationContext 去获取所有的Bean 前言 Spring Boot启动的时候需要加载许多Bean实现最小化 ...

- 《细说PHP》第四版 样章 第18章 数据库抽象层PDO 9

18.7 PDO的事务处理 事务是确保数据库一致的机制,是一个或一系列的查询,作为一个单元的一组有序的数据库操作.如果组中的所有SQL语句都操作成功,则认为事务成功,那么事务被提交,其修改将作用于所 ...