梯度下降法的python代码实现(多元线性回归)

梯度下降法的python代码实现(多元线性回归最小化损失函数)

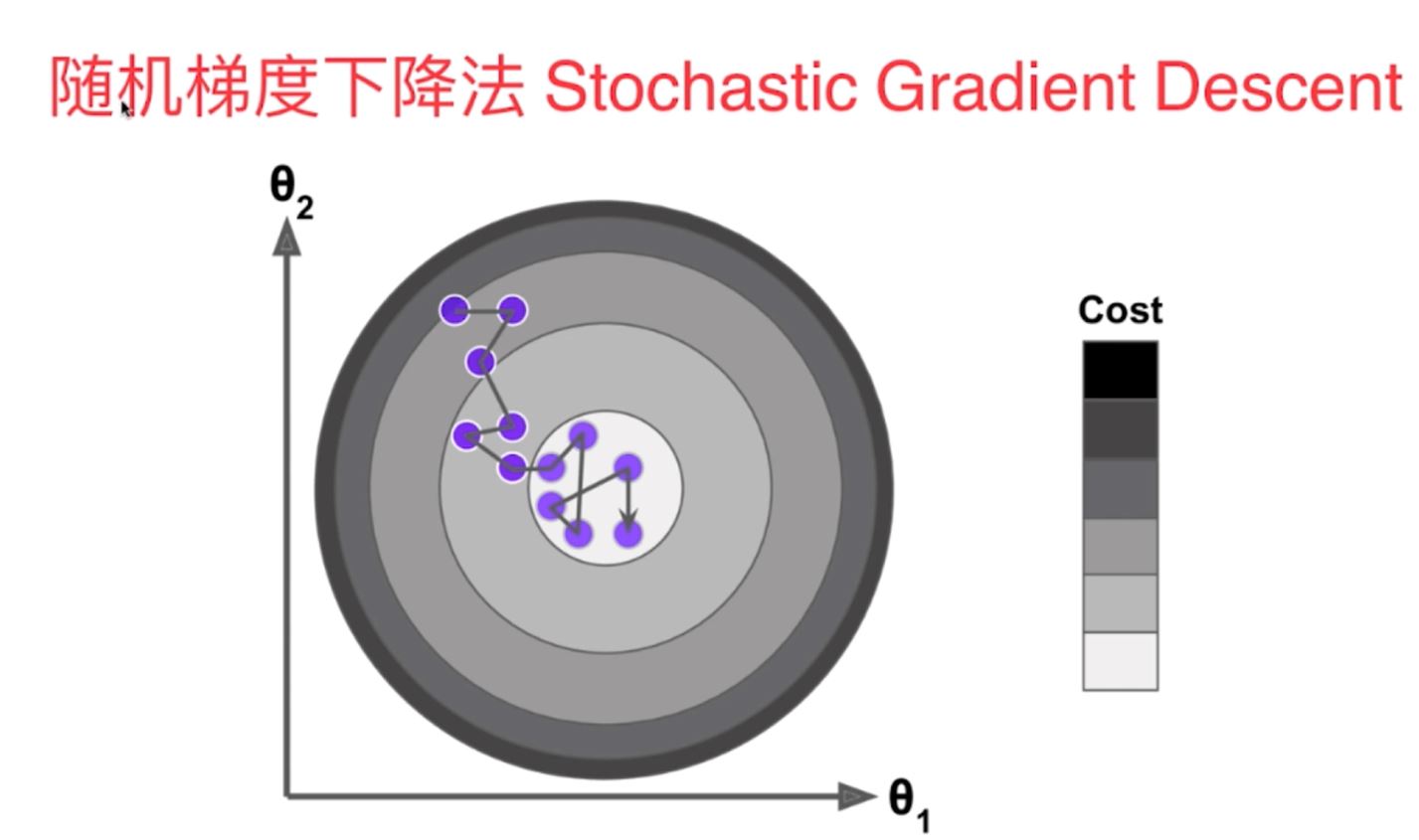

1、梯度下降法主要用来最小化损失函数,是一种比较常用的最优化方法,其具体包含了以下两种不同的方式:批量梯度下降法(沿着梯度变化最快的方向进行搜索最小值)和随机梯度下降法(主要随机梯度下降,通过迭代运算,收敛到最小值)

2、随机梯度与批量梯度计算是梯度下降的两种比较常用的方法,随机梯度下降法计算效率较高,不过不太稳定,对于批量梯度下降法,虽然计算速度较慢,但是计算方向稳定,它一定会朝着我们最优化的方向不断的进行靠近计算,结合以上两种方法便可以得到小批量梯度下降法。

3、随机的机器学习算法具有以下的优点:

(1)有助于跳出局部最优解

(2)更快地运行速度

(3)机器学习领域许多算法都要用到随机的特点,比如随机搜索,随机森林等。

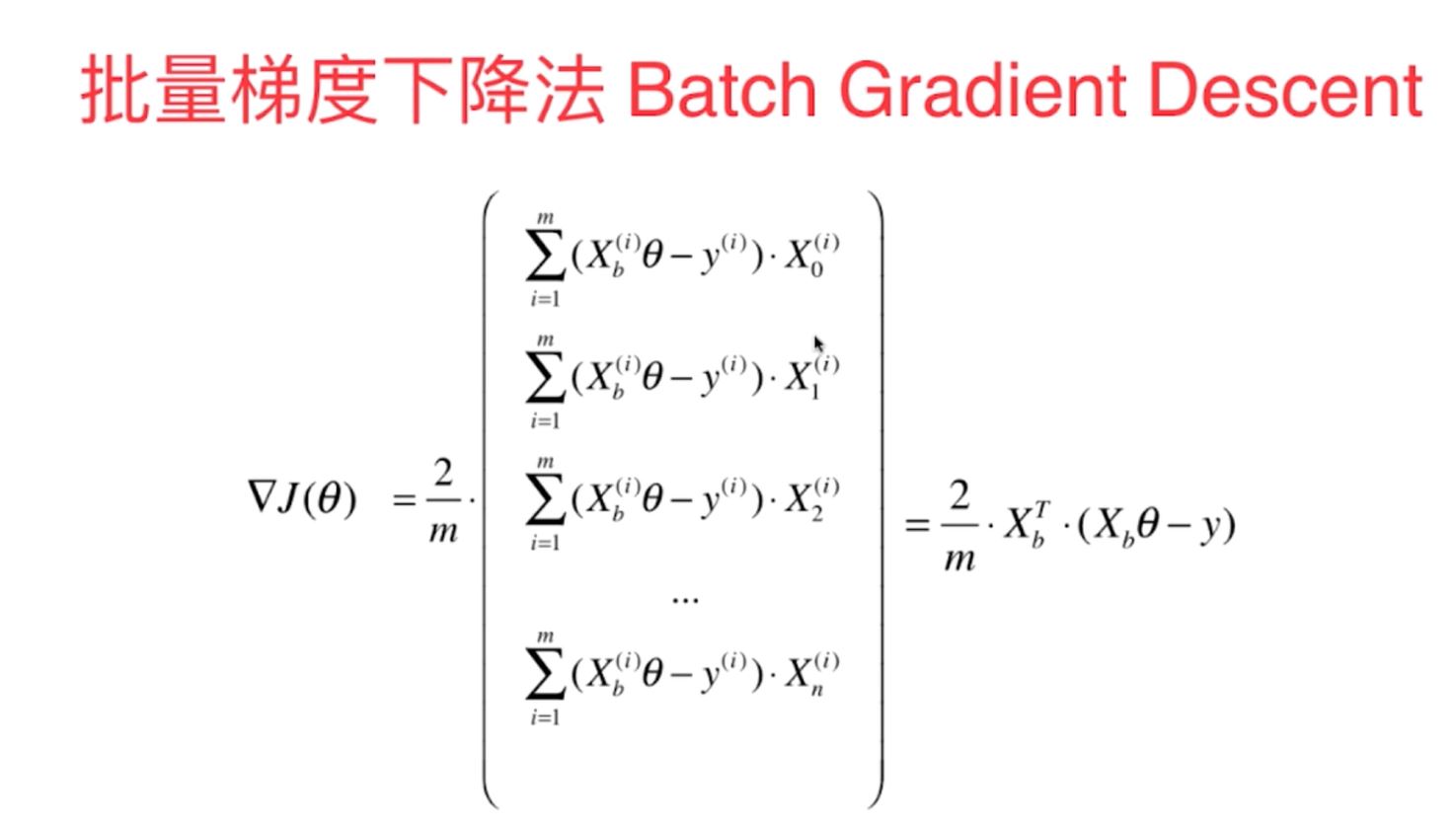

1)批量梯度下降法

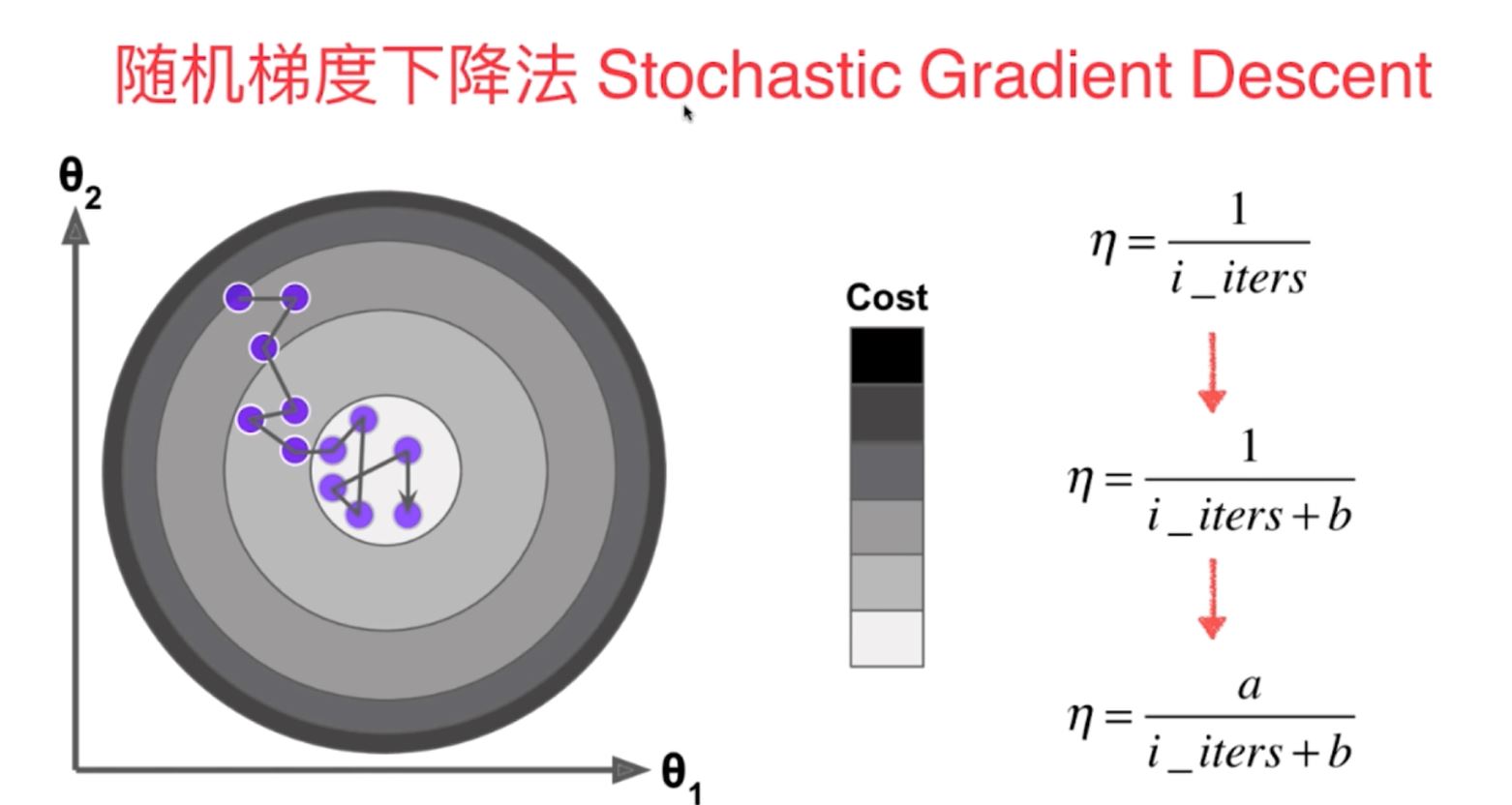

2)随机梯度下降法(学习率eta随着训练次数的增大而不断减小,采用了模拟退火的原理,不再是定值)

多元线性回归中的梯度下降法的向量化的数学计算原理:

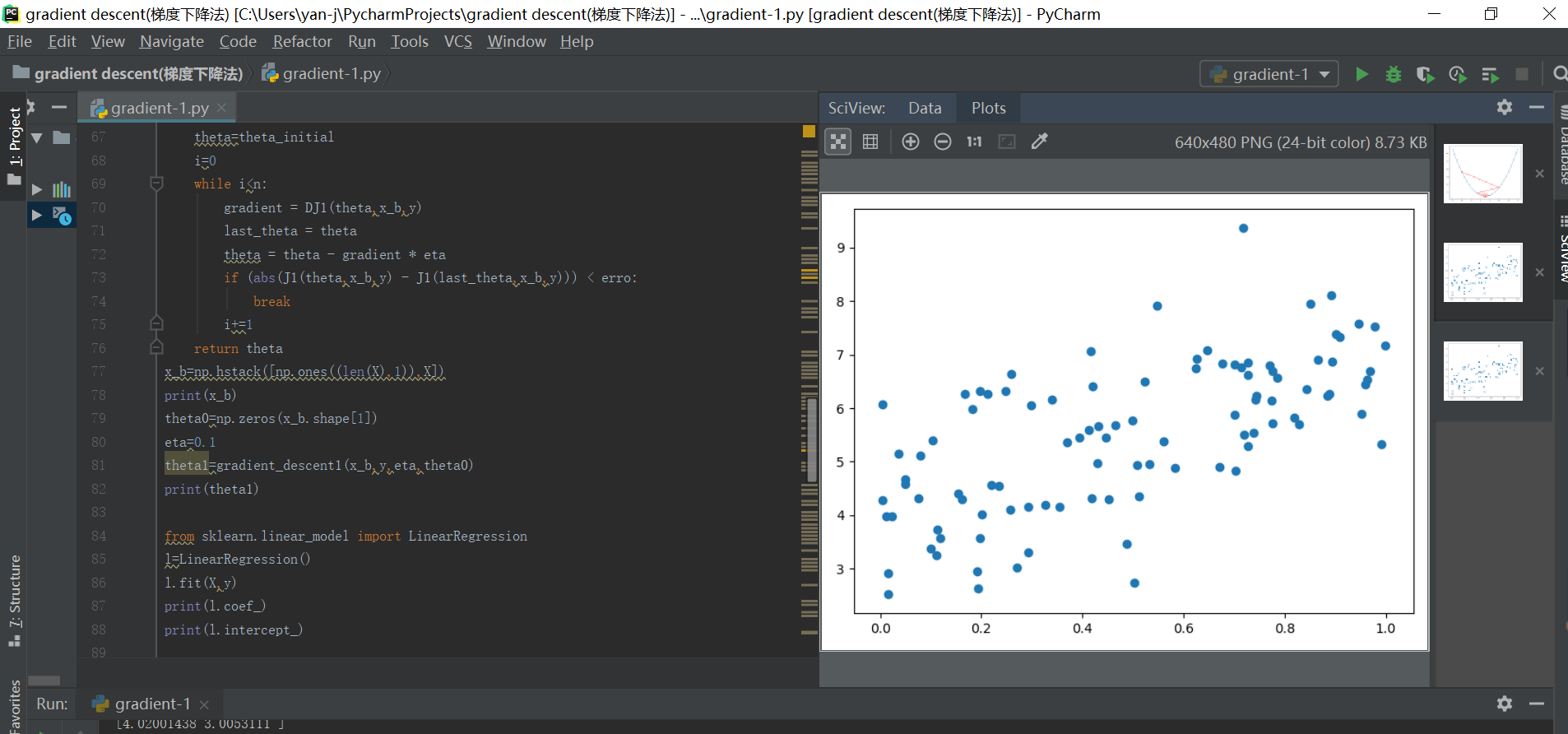

以上两种梯度下降法方法的python代码原理函数实现如下:

(1)批量梯度下降法:

#多元线性回归中使用梯度下降法来求得损失函数的最小值

import numpy as np

import matplotlib.pyplot as plt

np.random.seed(666)

x=np.random.random(size=100)

y=x*3.0+4+np.random.normal(size=100)

X=x.reshape(-1,1)

print(X)

print(x.shape)

print(y.shape)

plt.scatter(x,y)

plt.show()

print(X)

print(len(X))

#1使用梯度下降法训练

def J1(theta,x_b,y):

return np.sum((y-x_b.dot(theta))**2)/len(x_b)

def DJ2(theta,x_b,y):

res=np.empty(len(theta))

res[0]=np.sum(x_b.dot(theta)-y)

for i in range(1,len(theta)):

res[i]=np.sum((x_b.dot(theta)-y).dot(x_b[:,i]))

return res*2/len(x_b)

def DJ1(theta, x_b, y):

return x_b.T.dot(x_b.dot(theta)-y)*2/len(y)

def gradient_descent1(x_b,y,eta,theta_initial,erro=1e-8, n=1e4):

theta=theta_initial

i=0

while i<n:

gradient = DJ1(theta,x_b,y)

last_theta = theta

theta = theta - gradient * eta

if (abs(J1(theta,x_b,y) - J1(last_theta,x_b,y))) < erro:

break

i+=1

return theta

x_b=np.hstack([np.ones((len(X),1)),X])

print(x_b)

theta0=np.zeros(x_b.shape[1])

eta=0.1

theta1=gradient_descent1(x_b,y,eta,theta0)

print(theta1)

from sklearn.linear_model import LinearRegression

l=LinearRegression()

l.fit(X,y)

print(l.coef_)

print(l.intercept_)

#2随机梯度下降法的函数原理代码(多元线性回归为例):

#1-1写出损失函数的表达式子

def J_SGD(theta, x_b, y):

return np.sum((y - x_b.dot(theta)) ** 2) / len(x_b)

#1-2写出梯度胡表达式

def DJ_SGD(theta, x_b_i, y_i):

return x_b_i.T.dot(x_b_i.dot(theta)-y_i)*2

#1-3写出SGD随机梯度的函数形式

def SGD(x_b, y, theta_initial, n):(这里的n便是遍历和随机的总次数)——随机方式1

t0=5

t1=50

def learning_rate(t):(计算eta学习率)

return t0/(t+t1) #计算学习率eta的表达式,需要随着次数的增大而不断的减小

theta = theta_initial #定义初始化的点(列阵)

for i1 in range(n): #采用不断增加次数迭代计算的方式来进行相关的计算

rand_i=np.random.randint(len(x_b)) #生成随机的索引值,计算随机梯度

gradient = DJ_SGD(theta, x_b[rand_i], y[rand_i])

theta = theta - gradient *learning_rate(i1)

return theta

def SGD1(x_b, y, theta_initial, n,t0=5,t1=50):(这里的n便是遍历次数,每次对每一个索引进行一遍随机迭代)——随机方式2(更加有效)

def learning_rate(t):

return t0/(t+t1) #计算学习率eta的表达式,需要随着次数的增大而不断的减小

theta = theta_initial #定义初始化的点(列阵)

m=len(x_b)

for i1 in range(n): #采用不断增加次数迭代计算的方式来进行相关的计算

index1=np.random.permutation(m)

x_b_new=x_b[index1]

y_new=y[index1]

for k in range(m):

gradient = DJ_SGD(theta, x_b_new[k], y_new[k])

theta = theta - gradient *learning_rate(i1*m+k)

return theta

np.random.seed(666)

x=np.random.random(size=100)

y=x*3.0+4+np.random.normal(size=100)

X=x.reshape(-1,1)

print(X)

print(x.shape)

print(y.shape)

plt.scatter(x,y)

plt.show()

print(X)

print(len(X))

#1-4初始化数据x,y以及定义超参数theta0,迭代次数n

x_b=np.hstack([np.ones((len(X),1)),X])

print(x_b)

theta0=np.zeros(x_b.shape[1])

theta1=SGD(x_b,y,theta0,100000)

print(theta1)

梯度下降法的python代码实现(多元线性回归)的更多相关文章

- 简单线性回归(梯度下降法) python实现

grad_desc .caret, .dropup > .btn > .caret { border-top-color: #000 !important; } .label { bord ...

- 梯度下降法实现-python[转载]

转自:https://www.jianshu.com/p/c7e642877b0e 梯度下降法,思想及代码解读. import numpy as np # Size of the points dat ...

- 机器学习中梯度下降法原理及用其解决线性回归问题的C语言实现

本文讲梯度下降(Gradient Descent)前先看看利用梯度下降法进行监督学习(例如分类.回归等)的一般步骤: 1, 定义损失函数(Loss Function) 2, 信息流forward pr ...

- 固定学习率梯度下降法的Python实现方案

应用场景 优化算法经常被使用在各种组合优化问题中.我们可以假定待优化的函数对象\(f(x)\)是一个黑盒,我们可以给这个黑盒输入一些参数\(x_0, x_1, ...\),然后这个黑盒会给我们返回其计 ...

- (转)梯度下降法及其Python实现

梯度下降法(gradient descent),又名最速下降法(steepest descent)是求解无约束最优化问题最常用的方法,它是一种迭代方法,每一步主要的操作是求解目标函数的梯度向量,将当前 ...

- paper 166:梯度下降法及其Python实现

参考来源:https://blog.csdn.net/yhao2014/article/details/51554910 梯度下降法(gradient descent),又名最速下降法(steepes ...

- [机器学习Lesson4]多元线性回归

1. 多元线性回归定义 多元线性回归也被称为多元线性回归. 我们现在介绍方程的符号,我们可以有任意数量的输入变量. 这些多个特征的假设函数的多变量形式如下: hθ(x)=θ0+θ1x1+θ2x2+θ3 ...

- matlib实现梯度下降法

样本文件下载:ex2Data.zip ex2x.dat文件中是一些2-8岁孩子的年龄. ex2y.dat文件中是这些孩子相对应的体重. 我们尝试用批量梯度下降法,随机梯度下降法和小批量梯度下降法来对这 ...

- 最小二乘法 及 梯度下降法 分别对存在多重共线性数据集 进行线性回归 (Python版)

网上对于线性回归的讲解已经很多,这里不再对此概念进行重复,本博客是作者在听吴恩达ML课程时候偶然突发想法,做了两个小实验,第一个实验是采用最小二乘法对数据进行拟合, 第二个实验是采用梯度下降方法对数据 ...

随机推荐

- 关于永久POE

1.传统POE 在我们的企业网络中,经常会使用交换机给IP电话或者无线AP供电,以使得其正常的工作. 正常情况下,我们都知道,普通的POE是在PSE交换机启动完成后,然后再给PD(Power Devi ...

- 2016-2017学年第三次测试赛 问题 F: 签到题

问题 F: 签到题 时间限制: 1 Sec 内存限制: 128 MB提交: 80 解决: 28 提交统计讨论版 题目描述 在计算机网络考试中, 黑帅男神看到一个将IP网络分类的题, 精通C++的他 ...

- [WC2018]通道(乱搞,迭代)

[洛谷题面]https://www.luogu.org/problemnew/show/P4221 这个题以及[CTSC2018 暴力写挂]都有类似的乱搞做法能通过考场数据. 具体搞法就是随一个起点, ...

- mysql之指定为definer的用户不存在

问题描述: java.sql.SQLException: The user specified as a definer ('tsingsoft'@'%') does not exist 解决: 1. ...

- 大数据篇:MapReduce

MapReduce MapReduce是什么? MapReduce源自于Google发表于2004年12月的MapReduce论文,是面向大数据并行处理的计算模型.框架和平台,而Hadoop MapR ...

- [阿里移动推荐算法]比赛_快速入门_4_19_update_仅供参考,思维不要受局限

[这里只讲快速入门——即破题,正负样本不平衡.特征数量等问题就自己多看论文或者其他资料吧~~如果还有数据挖掘相关基础知识不了解的,建议看看<数据挖掘导论>] [以下是理解错误案例]:错误的 ...

- python中的异常处理:厌而不舍

什么是异常? ------异常:不正常的情况 异常即是一个事件,该事件会在程序执行过程中发生,影响了程序的正常执行.一般情况下,在Python无法正常处理程序时就会发生一个异常. 异常是Pytho ...

- Android抓包分析-fiddler版

本文介绍的是如何使用Fiddler工具抓取Android应用的HTTP协议的数据包 工具 Genymotion模拟器 笔记本电脑一台(Win7) Fiddler(v4.6.2),下载地址:http:/ ...

- 小白笔记:Git入门之常见命令

安装 这里就不介绍安装了,度娘一大堆,找不到可以去找谷爹(前提是你能找到).安装好就跟着笔记进行下一步 准备工作 首先我们需要一个可以 git 的东西,所以我们需要一个文件夹和一个文件 创建文件夹 t ...

- MySQL之正则

八:正则匹配: 语法: select * from 表名 where 字段名 regexp "正则表达式"; PS:MySQL中正则匹配,不能使用\w等字幕作为匹配