RNN,GRU,LSTM

2019-08-29 17:17:15

问题描述:比较RNN,GRU,LSTM。

问题求解:

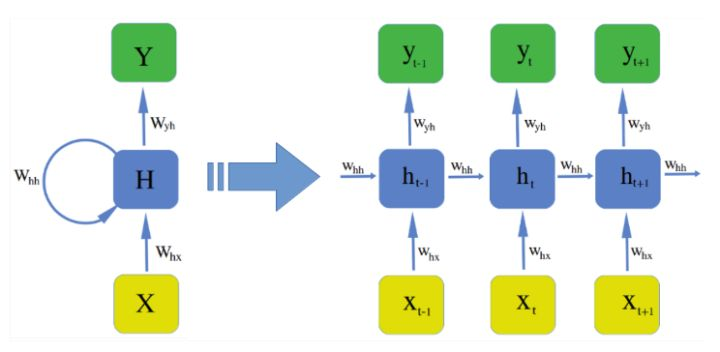

- 循环神经网络 RNN

传统的RNN是维护了一个隐变量 ht 用来保存序列信息,ht 基于 xt 和 ht-1 来计算 ht 。

ht = g( Wi xt + Ui ht-1 + bi )

yt = g( Wo ht + bo )

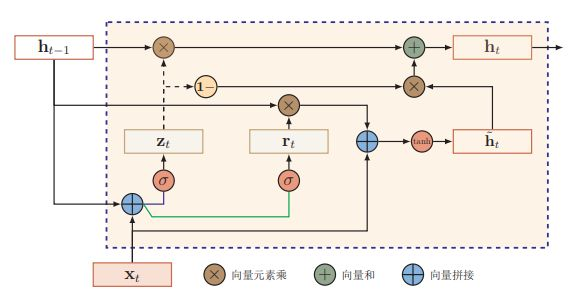

- 门控循环神经网络 GRU

门控循环神经网络(Gated Recurrent Unit,GRU)中引入了门控机制。

Update:Γu = g( Wu xt + Uu ht-1 + bu )

ht~ = g( Wc xt + Uc ht-1 + bc ) -Candidate

ht = Γu * ht~ + Γf * ht-1

【注】实际使用中还会加入重置门,可以看成计算了 ht-1 和 xt 之间的相关性

Γr = g( Wr xt + Ur ht-1 + br )

ht~ = g( Wc xt + Γr Uc ht-1 + bc )

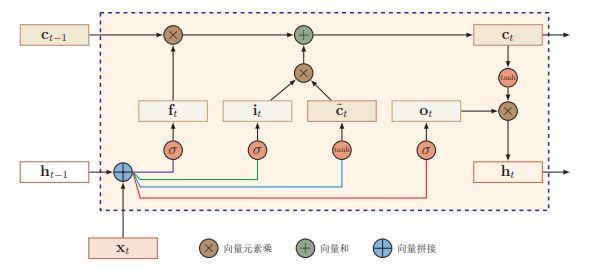

- 长短期记忆网络 LSTM

长短期记忆网络(Long Short Term Memory,LSTM)是循环神经网络的最知名和成功的扩展。由于循环神经网络有梯度消失和梯度爆炸的问题,学习能力有限,在实际的任务中往往不达预期。LSTM可以对有价值的信息进行长期记忆,从而减小循环神经网络的学习难度,因此在语音识别,NER,语言建模等问题中有着广泛的应用。

与传统的循环神经网络对比,LSTM仍然是基于xt 和 ht-1 来计算 ht ,只不过对计算的内部流程进行更加精心的设计。

LSTM中引入了cell memory称为 ct ,ht 由 cell memory生成。

LSTM在前向传播的时候不仅传递 ht ,而且还传递 cell memory,cell memory实际形成了一个信息的流通的highway。

LSTM中加入了三个门更新门(也有称为输入门) Γu,遗忘门 Γf,输出门 Γo。这里的门的概念可以理解为相关性,本质是三个权重。

Update:Γu = g( Wu xt + Uu ht-1 + bu )

Forget:Γf = g( Wf xt + Uf ht-1 + bf )

Output:Γo= g( Wo xt + Uo ht-1 + bo )

这三个门都是作用在cell memory上的,那么cell memory怎么计算呢?

ct~ = g( Wc xt + Uc ht-1 + bc )

ct = Γu * ct~ + Γf * ct-1

计算完成 ct 后,就可以根据输出门来求 ht 了。

ht = Γo * ct

RNN,GRU,LSTM的更多相关文章

- NLP教程(5) - 语言模型、RNN、GRU与LSTM

作者:韩信子@ShowMeAI 教程地址:http://www.showmeai.tech/tutorials/36 本文地址:http://www.showmeai.tech/article-det ...

- Recurrent Neural Network系列4--利用Python,Theano实现GRU或LSTM

yi作者:zhbzz2007 出处:http://www.cnblogs.com/zhbzz2007 欢迎转载,也请保留这段声明.谢谢! 本文翻译自 RECURRENT NEURAL NETWORK ...

- 【pytorch】关于Embedding和GRU、LSTM的使用详解

1. Embedding的使用 pytorch中实现了Embedding,下面是关于Embedding的使用. torch.nn包下的Embedding,作为训练的一层,随模型训练得到适合的词向量. ...

- 太深了,梯度传不下去,于是有了highway。 干脆连highway的参数都不要,直接变残差,于是有了ResNet。 强行稳定参数的均值和方差,于是有了BatchNorm。RNN梯度不稳定,于是加几个通路和门控,于是有了LSTM。 LSTM简化一下,有了GRU。

请简述神经网络的发展史sigmoid会饱和,造成梯度消失.于是有了ReLU.ReLU负半轴是死区,造成梯度变0.于是有了LeakyReLU,PReLU.强调梯度和权值分布的稳定性,由此有了ELU,以及 ...

- LSTM梳理,理解,和keras实现 (一)

注:本文主要是在http://colah.github.io/posts/2015-08-Understanding-LSTMs/ 这篇文章的基础上理解写成,姑且也可以称作 The understan ...

- 自己动手实现深度学习框架-7 RNN层--GRU, LSTM

目标 这个阶段会给cute-dl添加循环层,使之能够支持RNN--循环神经网络. 具体目标包括: 添加激活函数sigmoid, tanh. 添加GRU(Gate Recurrent U ...

- 简易机器学习代码(LR,Kmeans,NN,RNN)

Logistic Regression 特别需要注意的是 exp 和 log 的使用. sigmoid 原始表达式为 1 / (1+exp(-z)),但如果直接使用 z=-710,会显示 overfl ...

- 使用LSTM做电影评论负面检测——使用朴素贝叶斯才51%,但是使用LSTM可以达到99%准确度

基本思路: 每个评论取前200个单词.然后生成词汇表,利用词汇index标注评论(对 每条评论的前200个单词编号而已),然后使用LSTM做正负评论检测. 代码解读见[[[评论]]]!embeddin ...

- 三步理解--门控循环单元(GRU),TensorFlow实现

1. 什么是GRU 在循环神经⽹络中的梯度计算⽅法中,我们发现,当时间步数较⼤或者时间步较小时,循环神经⽹络的梯度较容易出现衰减或爆炸.虽然裁剪梯度可以应对梯度爆炸,但⽆法解决梯度衰减的问题.通常由于 ...

随机推荐

- Mongo Delete-19

数据初始化 db.inventory.insertMany( [ { item: "journal", qty: 25, size: { h: 14, w: 21, uom: &q ...

- YOLO 论文阅读

YOLO(You Only Look Once)是一个流行的目标检测方法,和Faster RCNN等state of the art方法比起来,主打检测速度快.截止到目前为止(2017年2月初),YO ...

- 对BFC的深层理解

BFC(Block Formatting Context)块级格式化上下文 注意:BFC首先是块,其次需要具备下面的条件之一才可以(通俗来说,BFC就好比一所985或者211的高校,想要成为985或者 ...

- GIT 使用(一):安装和配置

安装和配置 Table of Contents 1. 安装 2. 配置 1. 初次运行 Git 前的配置 小结 2. 用户信息 3. 别名 4. 查看已经存在的配置 3. 获取帮助 4. 参考与扩展阅 ...

- iOS 使用系统的UITabBarController 修改展示的图片大小

1. 设置TabBarItem图片的大小 1 - (void)configurationAppTabBarAndNavigationBar { // 选中的item普通状态图片的大小 UIImage ...

- PyCharm+git+码云实现project版本控制

1.安装git https://git-scm.com/downloads 2.PyCharm中配置 3.申请码云 4.PyCharm中安装码云插件 右键选择,重启Pycharm. 重新打开PyCha ...

- 开源一个使用python和pyQT实现的产测工具

导语 之前给朋友友情开发的一个产测工具,现开源,有需要的朋友可以在这个基础上进行二次开发. 操作界面如下 主要特性 自动识别启动信息,然后进入产测写入状态 序列号和MAC地址自动按指定数目增加 每次操 ...

- flask 设置https请求 访问flask服务器

学习过程中想要学教程中一样,做个假的微信公众号推送,不过去了微信开发文档怎么一直说需要https的请求(教学中没有说需要https,一直是http) 但是我的服务器只能使用http请求访问,如果硬是要 ...

- Python模块一

logging模块 我们来说一下这个logging模块,这个模块的功能是记录我们软件的各种状态,你们现在和我一起找到红蜘蛛的那个图标,然后右键找一找是不是有个错误日志.其实每个软件都是有错误日志的,开 ...

- C++ 指针函数

#include <stdio.h> #include <windows.h> using namespace std; template<typename T> ...