Scrapy框架延迟请求之Splash的使用

Splash是什么,用来做什么

Splash, 就是一个Javascript渲染服务。它是一个实现了HTTP API的轻量级浏览器,Splash是用Python实现的,同时使用Twisted和QT。Twisted(QT)用来让服务具有异步处理能力,以发挥webkit的并发能力。Splash的特点如下:

- 并行处理多个网页

- 得到HTML结果以及(或者)渲染成图片

- 关掉加载图片或使用 Adblock Plus规则使得渲染速度更快

- 使用JavaScript处理网页内容

- 使用Lua脚本

- 能在Splash-Jupyter Notebooks中开发Splash Lua scripts

- 能够获得具体的HAR格式的渲染信息

为什么Scrapy要使用到

Scrapy也有其不足之处,即Scrapy没有JS engine, 因此它无法爬取JavaScript生成的动态网页,只能爬取静态网页,而在现代的网络世界中,大部分网页都会采用JavaScript来丰富网页的功能。所以结合Splash实现等待页面动态渲染后,将页面数据进行爬取 。

Splash的安装使用

这里安装Splash使用Docker形式,更加简单便捷

docker run -p 8050:8050 scrapinghub/splash

执行完出现如下提示:

J-pro:scrapy will$ docker run -p 8050:8050 scrapinghub/splash

2020-07-05 07:43:32+0000 [-] Log opened.

2020-07-05 07:43:32.605417 [-] Xvfb is started: ['Xvfb', ':190283716', '-screen', '0', '1024x768x24', '-nolisten', 'tcp']

QStandardPaths: XDG_RUNTIME_DIR not set, defaulting to '/tmp/runtime-splash'

2020-07-05 07:43:33.109852 [-] Splash version: 3.4.1

2020-07-05 07:43:33.356860 [-] Qt 5.13.1, PyQt 5.13.1, WebKit 602.1, Chromium 73.0.3683.105, sip 4.19.19, Twisted 19.7.0, Lua 5.2

2020-07-05 07:43:33.357321 [-] Python 3.6.9 (default, Nov 7 2019, 10:44:02) [GCC 8.3.0]

2020-07-05 07:43:33.357536 [-] Open files limit: 1048576

2020-07-05 07:43:33.357825 [-] Can't bump open files limit

2020-07-05 07:43:33.385921 [-] proxy profiles support is enabled, proxy profiles path: /etc/splash/proxy-profiles

2020-07-05 07:43:33.386193 [-] memory cache: enabled, private mode: enabled, js cross-domain access: disabled

2020-07-05 07:43:33.657176 [-] verbosity=1, slots=20, argument_cache_max_entries=500, max-timeout=90.0

2020-07-05 07:43:33.657856 [-] Web UI: enabled, Lua: enabled (sandbox: enabled), Webkit: enabled, Chromium: enabled

2020-07-05 07:43:33.659508 [-] Site starting on 8050

2020-07-05 07:43:33.659701 [-] Starting factory <twisted.web.server.Site object at 0x7fcc3cbb7160>

2020-07-05 07:43:33.660750 [-] Server listening on http://0.0.0.0:8050

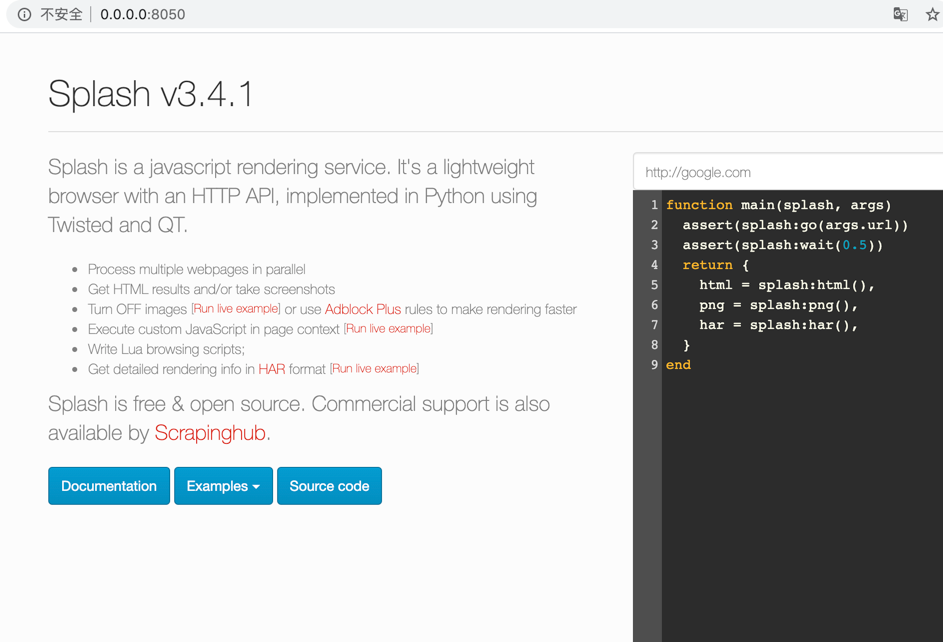

访问:http://0.0.0.0:8050,出现如下页面则标识Splash安装成功

Python安装scrapy-splash模块

pip3 install scrapy-splash

Scrapy使用Splash

1. 创建Scrapy项目,如果还没创建则参考https://www.cnblogs.com/will-xz/p/13111048.html,进行安装

2. 找到settings.py文件,增加配置

SPLASH_URL = 'http://0.0.0.0:8050'

DOWNLOADER_MIDDLEWARES = {

'scrapy_splash.SplashCookiesMiddleware': 723,

'scrapy_splash.SplashMiddleware': 725,

'scrapy.downloadermiddlewares.httpcompression.HttpCompressionMiddleware': 810,

}

SPIDER_MIDDLEWARES = {

'scrapy_splash.SplashDeduplicateArgsMiddleware': 100,

}

DUPEFILTER_CLASS = 'scrapy_splash.SplashAwareDupeFilter'

HTTPCACHE_STORAGE = 'scrapy_splash.SplashAwareFSCacheStorage'

3. 实践Demo,创建demo_splash.py文件,代码如下:

# -*- coding: UTF-8 -*-

import scrapy

from scrapy_splash import SplashRequest

class DemoSplash(scrapy.Spider):

"""

name:scrapy唯一定位实例的属性,必须唯一

allowed_domains:允许爬取的域名列表,不设置表示允许爬取所有

start_urls:起始爬取列表

start_requests:它就是从start_urls中读取链接,然后使用make_requests_from_url生成Request,

这就意味我们可以在start_requests方法中根据我们自己的需求往start_urls中写入

我们自定义的规律的链接

parse:回调函数,处理response并返回处理后的数据和需要跟进的url

log:打印日志信息

closed:关闭spider

"""

# 设置name

name = "demo_splash"

allowed_domains = []

start_urls = [

'http://yao.xywy.com/class.htm',

]

def parse(self, response):

print("开始抓取")

## 爬取指定地址,设置等待秒数

yield SplashRequest("http://yao.xywy.com/class/201-0-0-1-0-1.htm", callback=self.parse_page, args={'wait': 0.5})

def parse_page(self, response):

print(response.xpath('//div'))

## 这里可以对数据进行解析存储了

4. 执行抓取命令

scrapy crawl demo_splash

5. 完成!

Scrapy框架延迟请求之Splash的使用的更多相关文章

- scrapy框架post请求发送,五大核心组件,日志等级,请求传参

一.post请求发送 - 问题:爬虫文件的代码中,我们从来没有手动的对start_urls列表中存储的起始url进行过请求的发送,但是起始url的确是进行了请求的发送,那这是如何实现的呢? - 解答: ...

- scrapy框架3——请求传参

当使用scrapy爬取的数据不在同一张页面中(一次请求与数据后解析无法获得想要的全部数据),需要请求传参,在第一次解析时实例化item,将item传递,再次将请求到的数据解析后,封装在item中. 关 ...

- 第三百三十三节,web爬虫讲解2—Scrapy框架爬虫—Scrapy模拟浏览器登录—获取Scrapy框架Cookies

第三百三十三节,web爬虫讲解2—Scrapy框架爬虫—Scrapy模拟浏览器登录 模拟浏览器登录 start_requests()方法,可以返回一个请求给爬虫的起始网站,这个返回的请求相当于star ...

- 十二 web爬虫讲解2—Scrapy框架爬虫—Scrapy模拟浏览器登录—获取Scrapy框架Cookies

模拟浏览器登录 start_requests()方法,可以返回一个请求给爬虫的起始网站,这个返回的请求相当于start_urls,start_requests()返回的请求会替代start_urls里 ...

- Scrapy爬虫框架(实战篇)【Scrapy框架对接Splash抓取javaScript动态渲染页面】

(1).前言 动态页面:HTML文档中的部分是由客户端运行JS脚本生成的,即服务器生成部分HTML文档内容,其余的再由客户端生成 静态页面:整个HTML文档是在服务器端生成的,即服务器生成好了,再发送 ...

- 12.scrapy框架之递归解析和post请求

今日概要 递归爬取解析多页页面数据 scrapy核心组件工作流程 scrapy的post请求发送 今日详情 1.递归爬取解析多页页面数据 - 需求:将糗事百科所有页码的作者和段子内容数据进行爬取切持久 ...

- Scrapy 框架 手动发送请求 POST 请求的发送

手动发送请求 import scrapy from choutiSpider.items import ChoutispiderItem class ChoutiSpider(scrapy.Spide ...

- scrapy框架之递归解析和post请求

递归爬取解析多页页面数据 scrapy核心组件工作流程 scrapy的post请求发送 1.递归爬取解析多页页面数据 - 需求:将糗事百科所有页码的作者和段子内容数据进行爬取切持久化存储 - 需求分析 ...

- scrapy框架发送post请求

注:scrapy框架默认发送get请求 1.想要发送post请求,那么推荐使用‘scrapy.FormRequest’方法.可以方便的制定表单数据.request = scrapy.FormReque ...

随机推荐

- TortoiseGit使用

TortoiseGit 前言: 其实作为一名学生,还未接触过企业级开发项目,基本都是一个人在本地敲代码,对于项目管理工具使用的并不多,最常用的命令也就是git clone了,hhh: 前些日子了解了一 ...

- UltraSoft - Alpha - 测试报告

遇到的bug bug:在vue.config.js里配置proxy,并修改请求的url后仍无法连接到后端. 解决: url最后忘了'/',导致和后端不匹配,会有404.500等错误. 后端服务未打开或 ...

- 对mongo文档的增删改操作

在mongo db 中增加.删除.修改文档有好多方法,这里简单记录一下我所知道的一些方法. 前置条件: 1.创建study数据库 use study; 2.创建persons集合,当第一次向pers ...

- ip_local_port_range 和 ip_local_reserved_ports

问题:启动应用程序时,发现网络端口被占用,原因是什么?如何避免? 原因:Linux 系统设置了随机使用的端口范围 echo "40000 60000" > /proc/. ...

- 助你上手Vue3全家桶之Vue-Router4教程

目录 1,前言 1,Router 2.1,跳转 2.2,打开新页面 3,Route 4,守卫 4.1,onBeforeRouteLeave 4.2,onBeforeRouteUpdate 4.3,路由 ...

- 牛客网 剑指Offer 索引

二维数组中的查找 替换空格 从尾到头打印链表 重建二叉树 用两个栈实现队列 旋转数组的最小数字 斐波那契数列 跳台阶 变态跳台阶 矩形覆盖 二进制中1的个数 数值的整数次方 调整数组顺序使奇数位于偶数 ...

- 微服务(七)Gateway服务网关

1 为什么要有网关 权限控制:网关作为微服务入口,需要校验用户是是否有请求资格,如果没有则进行拦截. 路由和负载均衡:一切请求都必须先经过gateway,但网关不处理业务,而是根据某种规则,把请求转发 ...

- WPF_05_路由事件

路由事件 WPF用更高级的路由事件替换普通的.NET事件.路由事件具有更强传播能力,可在元素树中向上冒泡和向下隧道传播,并沿着传播路径被事件处理程序处理.与依赖属性一样,路由事件由只读的静态字段表示, ...

- clnt_create: RPC: Port mapper failure - Unable to receive: errno 111 (Connection refused)

clnt_create: RPC: Port mapper failure - Unable to receive: errno 111 (Connection refused) 关闭防火墙,可以连, ...

- 集合之Map接口

Map接口概述 Map与Collection并列存在.用于存储具有映射关系的数据 : key-value Map 中的 key 和 value 都可以是任何引用类型的数据 Map 中的 key 用Se ...