在 Cloudera Data Flow 上运行你的第一个 Flink 例子

文档编写目的

Cloudera Data Flow(CDF) 作为 Cloudera 一个独立的产品单元,围绕着实时数据采集,实时数据处理和实时数据分析有多个不同的功能模块,如下图所示:

图中 4 个功能模块从左到右分别解释如下:

- Cloudera Edge Management(CEM),主要是指在边缘设备如传感器上部署 MiNiFi 的 agent 后用于采集数据。

- Cloudera Flow Management(CFM),主要是使用 Apache NiFi 通过界面化拖拽的方式实现数据采集,处理和转换。

- Cloudera Streaming Processing(CSP),主要包括 Apache Kafka,Kafka Streams,Kafka 的监控 Streams Messaging Manager(SMM),以及跨集群 Kafka topic 的数据复制 Streams Replication Manager(SRM)。

- Cloudera Streaming Analytics(CSA),以前这块是使用 Storm 来作为 Native Streaming 来补充 Spark Streaming 的 Micro-batch 的时延问题,目前这块改为 Flink 来实现,未来的 CDF 中将不再包含 Storm。

本文 Fayson 主要是介绍如何在 CDH6.3 中安装 Flink 1.9 以及运行你的第一个 Flink 例子,以下是测试环境信息:

- CM 和 CDH 版本为 6.3

- Redhat 7.4

- JDK 1.8.0_181

- 集群未启用 Kerberos

- Root 用户安装

安装 Flink 1.9

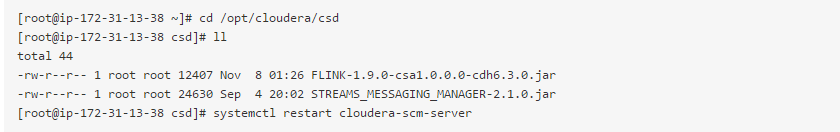

1.准备 Flink 1.9 的 csd 文件,并放置到 Cloudera Manager Server 的 /opt/cloudera/csd 目录。然后重启 Cloudera Manager Server 服务。

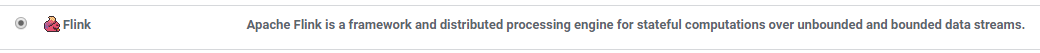

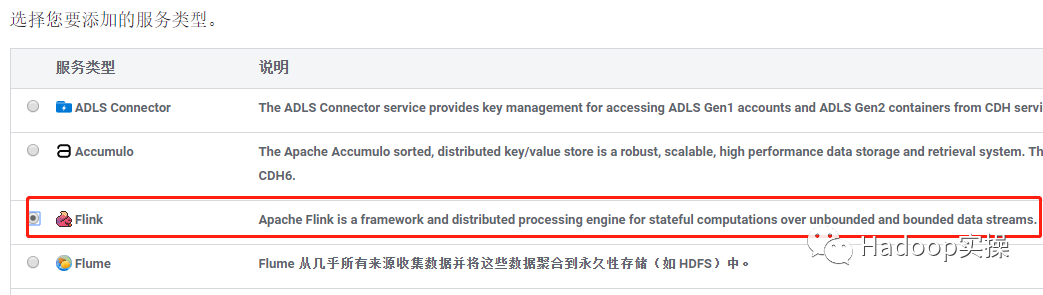

2.CM 重启完成以后,添加服务页面可以看到有 Flink 服务。

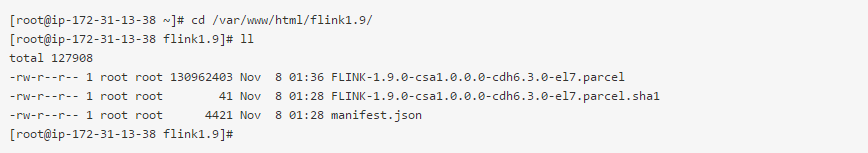

3.下载 Flink 1.9 的 Parcel,并放置 /var/www/html 目录。

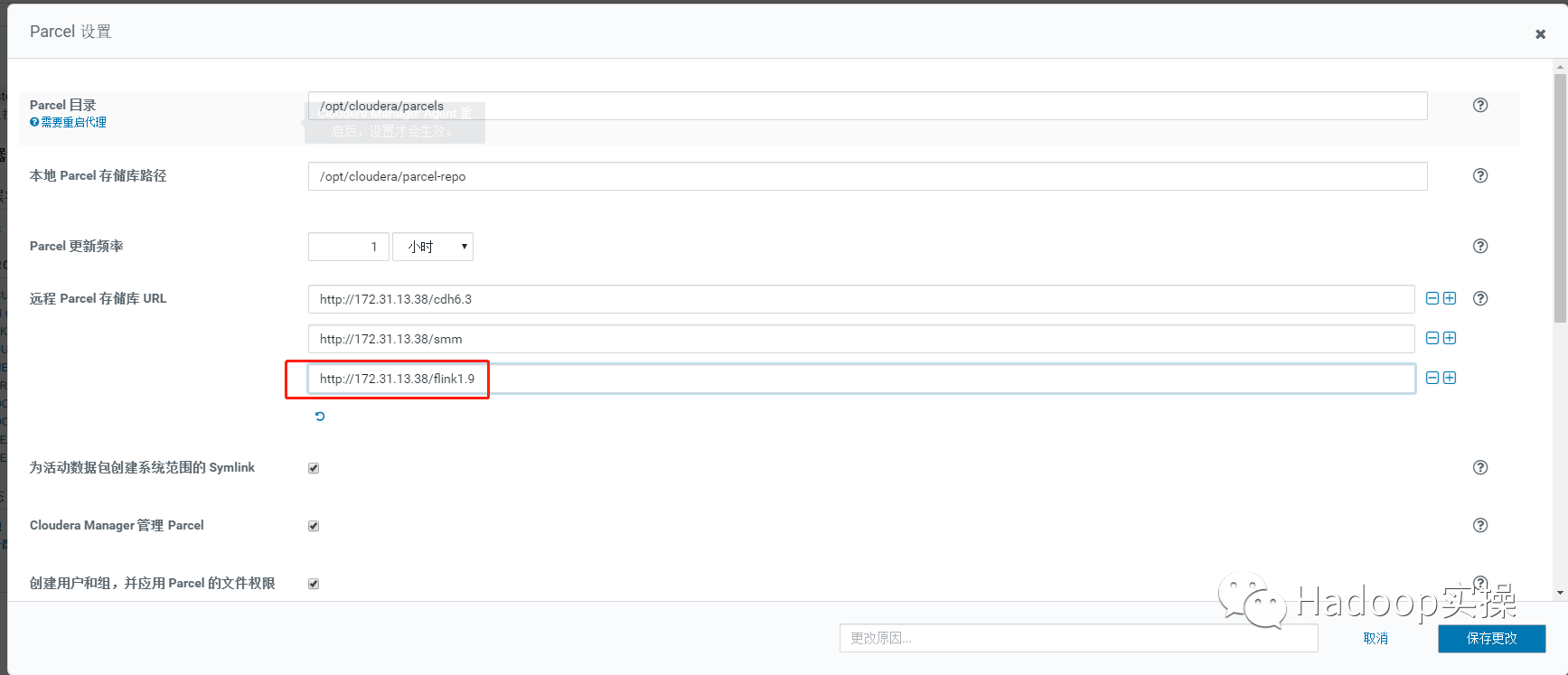

4.通过 Hosts > Parcels 进入 Cloudera Manager 的 Parcel 页面,输入 SMM Parcel 的 http 地址,下载->分配->激活。

5.进入 CM 主页点击“添加服务”。

6.选择添加 Flink 服务,点击继续。

7.选择 Flink History Server 以及 Gateway 节点,点击继续。

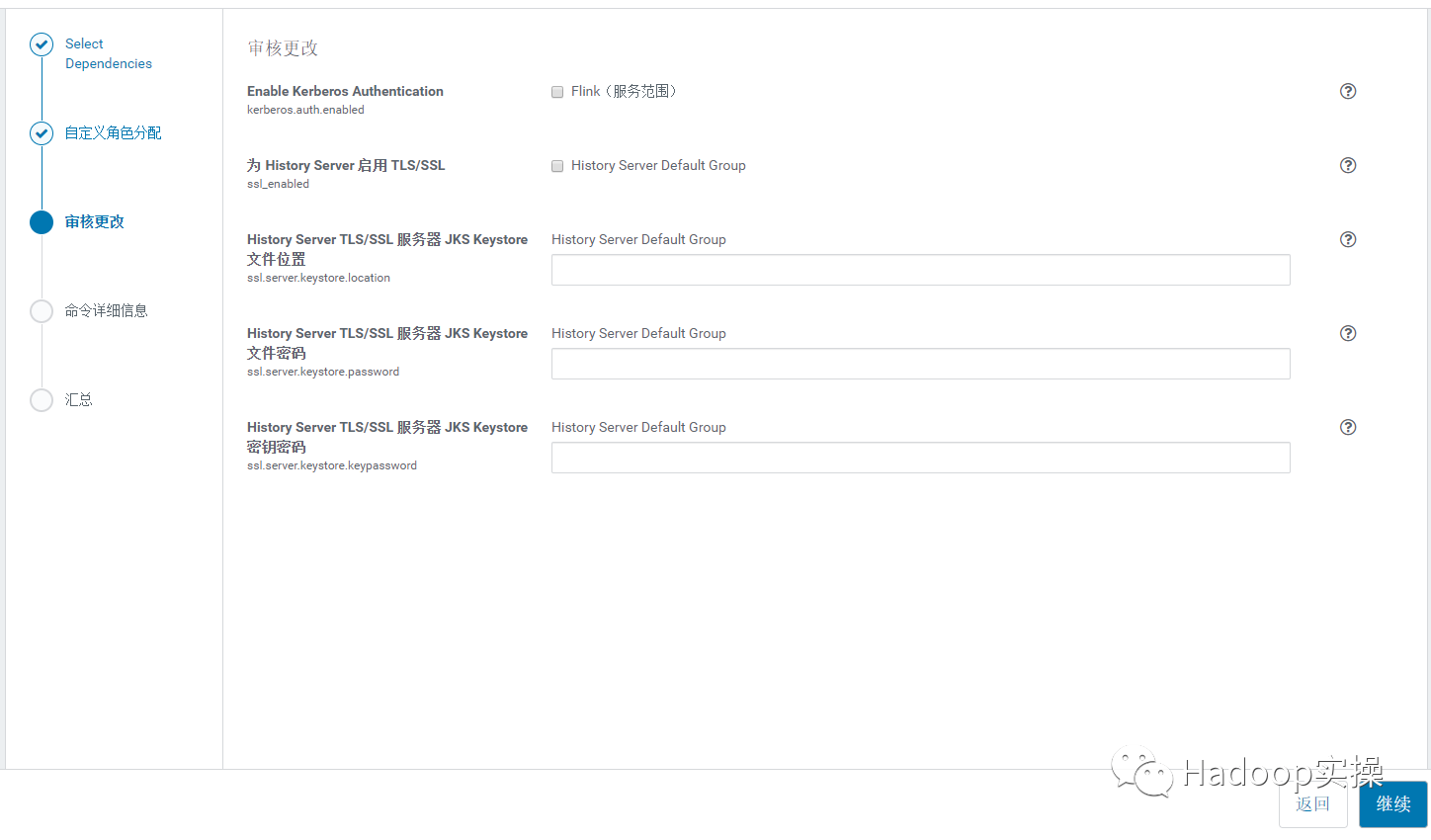

8.点击继续。

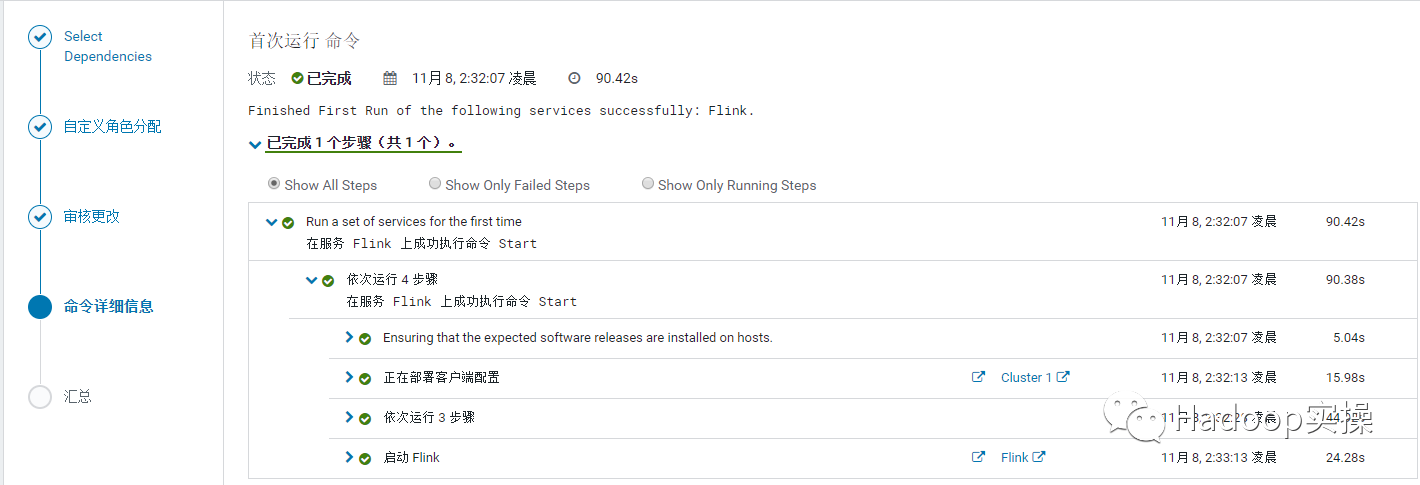

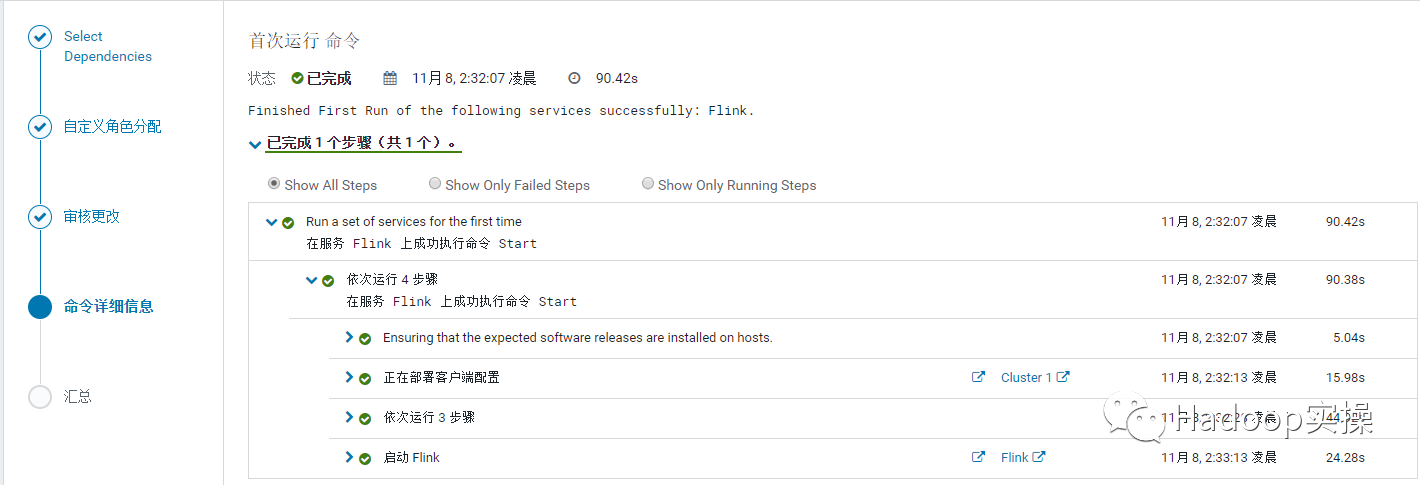

9.等待 Flink History Server 启动成功,完成后点击继续。

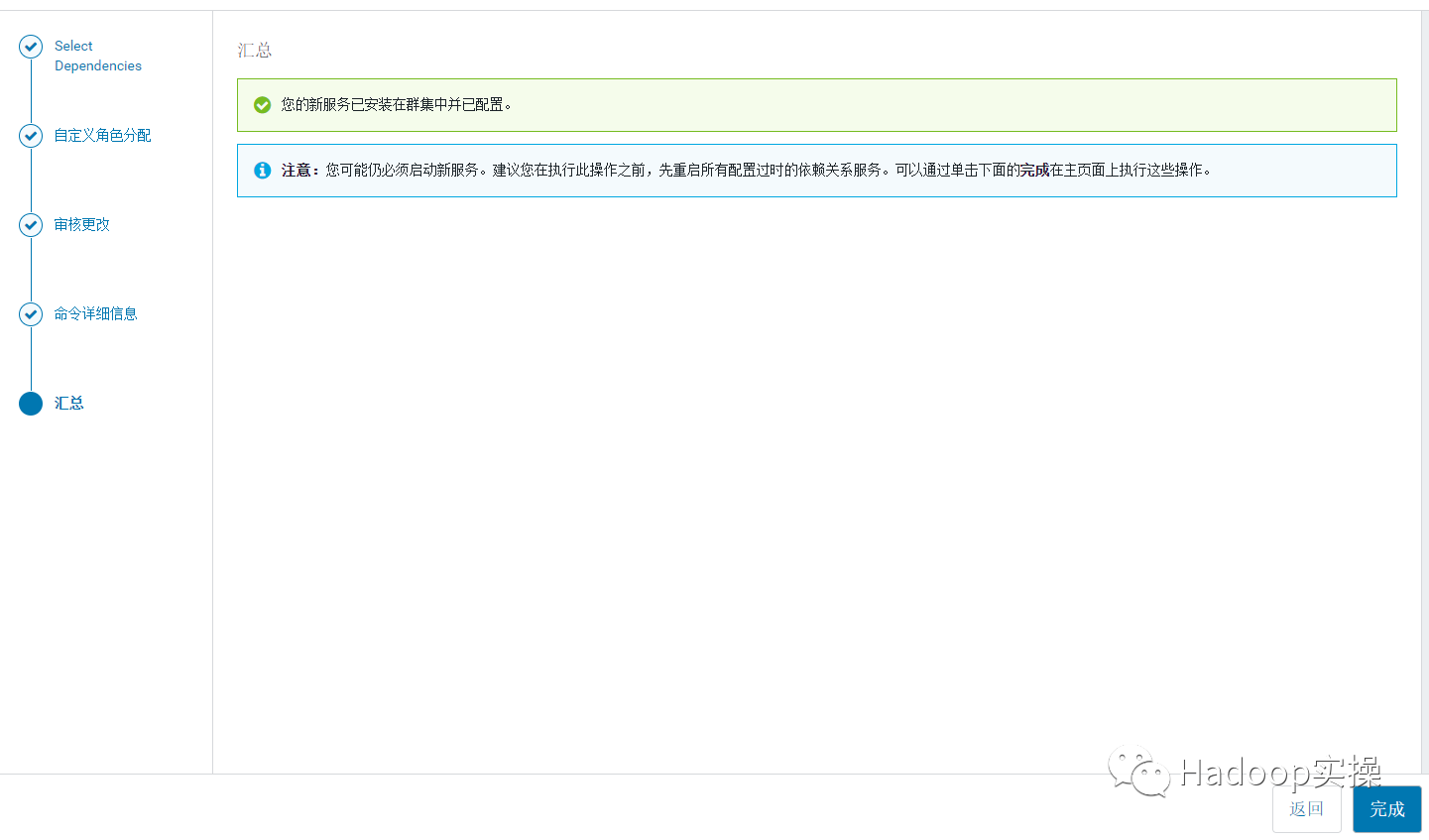

10.安装完成,点击完成回到 CM 主页。

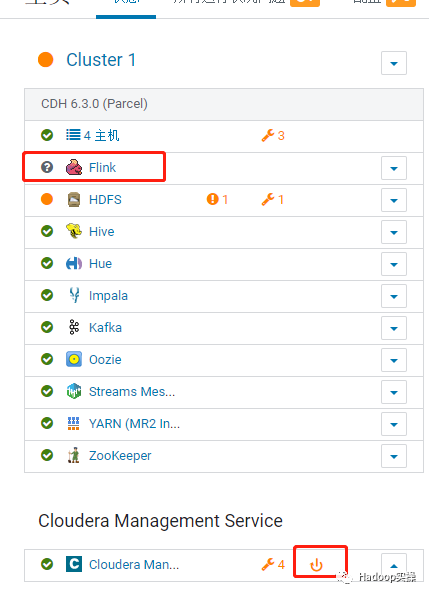

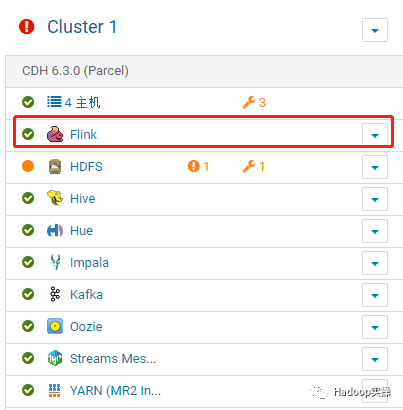

发现 Flink 的状态为灰色,CMS 有重启提示,按照提示重启 CMS 服务,重启过程略。重启完成后显示 Flink 服务正常。

第一个 Flink 例子

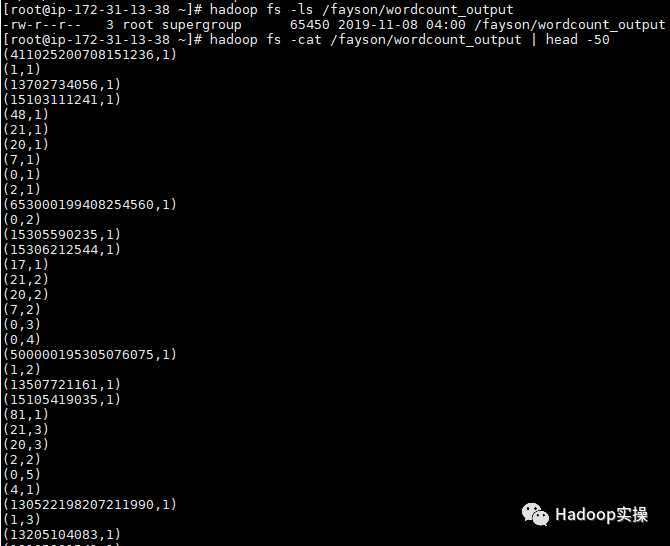

1.执行 Flink 自带的 example 的 wordcount 例子。

2.查看输出结果。

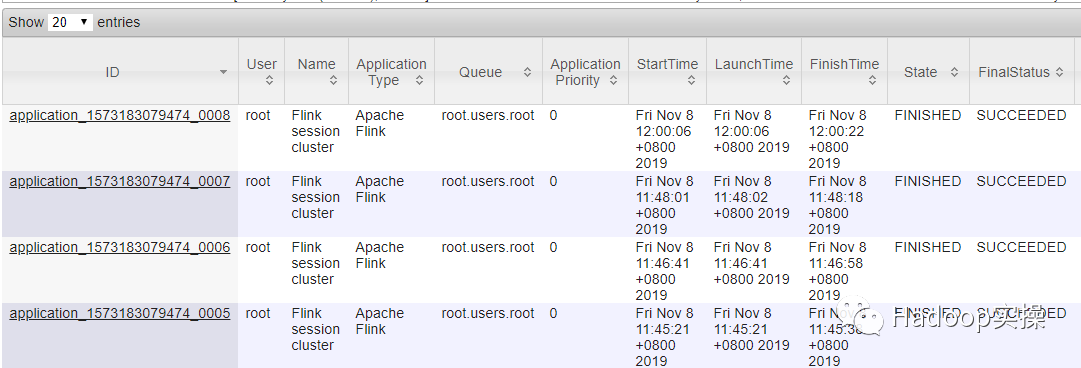

3.在 YARN 和 Flink 的界面上分别都能看到这个任务。

至此,Flink 1.9 安装到 CDH 6.3 以及第一个例子介绍完毕。

备注:这是 Cloudera Streaming Analytics 中所包含 Apache Flink 的抢先测试版。Cloudera 不提供对此版本的支持。该 Beta 版本的目的是让用户可以尽可能早的开始使用 Flink 进行应用程序的开发。

本文作者:巴蜀真人

本文为阿里云内容,未经允许不得转载。

在 Cloudera Data Flow 上运行你的第一个 Flink 例子的更多相关文章

- 阿里云上 配置 vsftpd 配置文件 (一个成功例子)

# # READ THIS: This example file is NOT an exhaustive list of vsftpd options. # Please read the vsft ...

- SSIS的 Data Flow 和 Control Flow

Control Flow 和 Data Flow,是SSIS Design中主要用到的两个Tab,理解这两个Tab的作用,对设计更高效的package十分重要. 一,Control Flow 在Con ...

- 如何在国产龙芯架构平台上运行c/c++、java、nodejs等编程语言

高能预警:本文内容过于硬核,涉及编译器原理.cpu指令集.机器码.编程语言原理.跨平台原理等计算机专业基础知识,建议具有c.c++.java.nodejs等多种编程语言开发能力,且实战经验丰富的资深开 ...

- Spring Cloud Data Flow初体验,以Local模式运行

1 前言 欢迎访问南瓜慢说 www.pkslow.com获取更多精彩文章! Spring Cloud Data Flow是什么,虽然已经出现一段时间了,但想必很多人不知道,因为在项目中很少有人用.不仅 ...

- 把Spring Cloud Data Flow部署在Kubernetes上,再跑个任务试试

1 前言 欢迎访问南瓜慢说 www.pkslow.com获取更多精彩文章! Spring Cloud Data Flow在本地跑得好好的,为什么要部署在Kubernetes上呢?主要是因为Kubern ...

- SSIS Data Flow优化

一,数据流设计优化 数据流有两个特性:流和在内存缓冲区中处理数据,根据数据流的这两个特性,对数据流进行优化. 1,流,同时对数据进行提取,转换和加载操作 流,就是在source提取数据时,转换组件处理 ...

- Data Flow ->> Union All

Wrox的<Professional Microsoft SQL Server 2012 Integration Services>一书中再讲Merge的时候有这样一段解释: This t ...

- Spring Cloud Data Flow 中的 ETL

Spring Cloud Data Flow 中的 ETL 影宸风洛 程序猿DD 今天 来源:SpringForAll社区 1 概述 Spring Cloud Data Flow是一个用于构建实时数据 ...

- 【SFA官方译文】:Spring Cloud Data Flow中的ETL

原创: 影宸风洛 SpringForAll社区 昨天 原文链接:https://www.baeldung.com/spring-cloud-data-flow-etl 作者:Norberto Ritz ...

随机推荐

- C#学习笔记二 (资源托管,泛型,数组和元组,运算符和类型强制转换)

托管和非托管资源 1.托管资源是指GC管理的内存空间,非托管资源是指文件句柄,网络连接,数据库连接等. 2.方法中临时申请的变量,被存放在栈中.栈存储非对象成员的值数据.例如在方法中有B b=new ...

- USACO1.6 Superprime Rib

题目传送门 每一个特殊质数都会被从右边切掉,所以除了首位外的其它位数一定都不会是偶数,只能是$1$,$3$,$5$,$7$,$9$ 而每一个特殊质数的首位一定是质数,也就是$2$,$3$,$5$,$7 ...

- cocos creator 3D | 拇指投篮 | 3D项目入门实战

你的命中率是多少呢?文章底部试玩! 效果预览 配置环境: Cocos Creator 3D v1.0.1 玩法说明: 触摸屏幕,向上滑动投篮!注意篮板是会移动的哦!看看你的命中率是多少! 实现原理 为 ...

- Spark架构角色及基本运行流程

1. 集群角色 Application:基于spark的用户程序,包含了一个Driver program 和集群中多个Executor Driver Program:运行application的mai ...

- Centos7安装Swoole

准备:安装好php后,还需要将PHP的可执行目录添加到环境变量中. //打开文件 vi ~/.bashrc //在文件末尾添加这两行,保存退出 export PATH=/usr/local/php/b ...

- Kali安装在U盘+使用aircrack-ng套件

因为: Kali Linux 自带aircrack-ng 虚拟机VMware不能用笔记本内置网卡,需要另外买一个无线网卡,然而并不想买 不想给笔记本重装Kali Linux系统 有闲置的32GU盘 所 ...

- 通过sohu获取浏览器端IP地址

接口:http://pv.sohu.com/cityjson?ie=utf-8

- python一行代码打印Love心形

用Python画一颗特别的爱心,送给那个特别的她,给她一份浪漫的惊喜吧 print('\n'.join([''.join([('Love'[(x-y) % len('Love')] if ((x*0. ...

- kafka 教程(三)-远程访问

远程连接 kafka 配置 默认的 kafka 配置是无法远程访问的,解决该问题有几个方案. 方案1 advertised.listeners=PLAINTEXT://IP:9092 注意必须是 ip ...

- vue中如何去掉空格

一.问题 vue中当用户提交表单时,有的数据需要去掉前后空格然后再向后端发送. 二.解决方法 首先可以使用v-model.trim这个v-model修饰符去解决它,但是当用户输入\u200B时,这个方 ...