Spark编程模型(下)

创建Pair RDD

什么是Pair RDD

- 包含键值对类型的RDD类型被称作Pair RDD;

- Pair RDD通常用来进行聚合计算;

- Pair RDD通常由普通RDD做ETL转化而来。

Python:

pairs = lines.map(lambda x: (x.split(" ")[], x)) Scala:

val pairs = lines.map(x => (x.split(" ")(), x)) Java:

PairFunction<String, String, String> keyData = new PairFunction<String, String, String>() {

public Tuple2<String, String> call(String x){

return new Tuple(x.split(" ")[], x);

}

};

JavaPairRDD<String, String> pairs = lines.mapToPair(keyData);

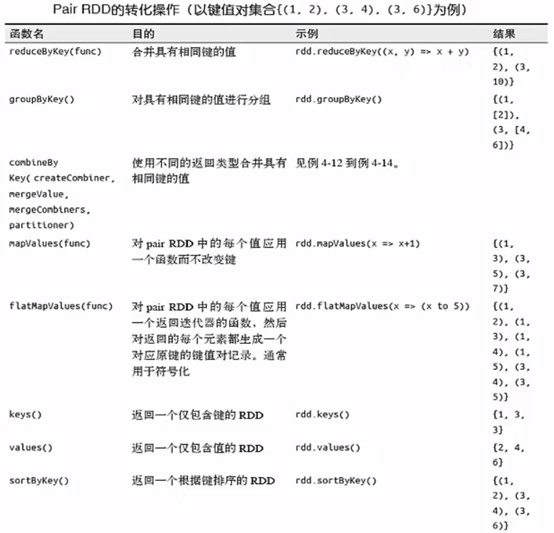

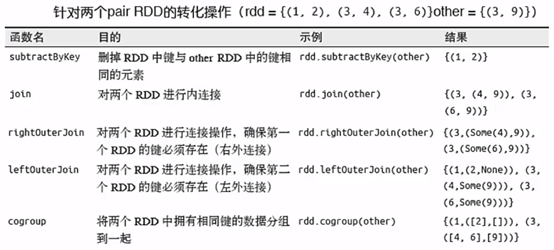

Pair RDD的transformation操作

Pair RDD可以使用所有标准RDD上的转化操作(见博文Spark编程模型(中)),还提供了特有的转换操作。

下面给大家示范一个操作,其它的自行去尝试。

[hadoop@masternode ~]$ cd /home/hadoop/app/spark-2.2./bin/

[hadoop@masternode bin]$ ./spark-shell //进入Spark Shell模式

scala> val rdd = sc.parallelize(Array((,),(,),(,)))

rdd: org.apache.spark.rdd.RDD[(Int, Int)] = ParallelCollectionRDD[] at parallelize at <console>:

//其中parallelize()方法的作用是从一个集合创建RDD,本例中时从一个Array()创建

scala> rdd.take()

res0: Array[(Int, Int)] = Array((,), (,), (,))

scala> rdd.reduceByKey((x,y)=>x+y).take() //合并key相同的项

res3: Array[(Int, Int)] = Array((,), (,))

Pair RDD的action控制

所有的基础RDD支持的行动操作也都在Pair RDD上可用。

Pair RDD的分区控制

- Spark 中所有的键值对RDD 都可以进行分区控制---自定义分区

- 自定义分区的好处:

1)避免数据倾斜

2)控制task并行度

自定义分区方式:

class DomainNamePartitioner(numParts: Int) extends Partitioner {

override def numPartitions: Int = numParts

override def getPartition(key: Any): Int = {

val domain = new Java.net.URL(key.toString).getHost()

val code = (domain.hashCode % numPartitions)

if(code < ) {

code + numPartitions // 使其非负

}else{

code

}

}

// 用来让Spark区分分区函数对象的Java equals方法

override def equals(other: Any): Boolean = other match {

case dnp: DomainNamePartitioner =>

dnp.numPartitions == numPartitions

case _ =>

false

}

}

以上就是博主为大家介绍的这一板块的主要内容,这都是博主自己的学习过程,希望能给大家带来一定的指导作用,有用的还望大家点个支持,如果对你没用也望包涵,有错误烦请指出。如有期待可关注博主以第一时间获取更新哦,谢谢!

Spark编程模型(下)的更多相关文章

- Spark编程模型(博主推荐)

福利 => 每天都推送 欢迎大家,关注微信扫码并加入我的4个微信公众号: 大数据躺过的坑 Java从入门到架构师 人工智能躺过的坑 Java全栈大联盟 ...

- Spark入门实战系列--3.Spark编程模型(下)--IDEA搭建及实战

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 . 安装IntelliJ IDEA IDEA 全称 IntelliJ IDEA,是java语 ...

- Spark入门实战系列--3.Spark编程模型(上)--编程模型及SparkShell实战

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .Spark编程模型 1.1 术语定义 l应用程序(Application): 基于Spar ...

- Spark:Spark 编程模型及快速入门

http://blog.csdn.net/pipisorry/article/details/52366356 Spark编程模型 SparkContext类和SparkConf类 代码中初始化 我们 ...

- Spark编程模型(RDD编程模型)

Spark编程模型(RDD编程模型) 下图给出了rdd 编程模型,并将下例中用 到的四个算子映射到四种算子类型.spark 程序工作在两个空间中:spark rdd空间和 scala原生数据空间.在原 ...

- Spark中文指南(入门篇)-Spark编程模型(一)

前言 本章将对Spark做一个简单的介绍,更多教程请参考:Spark教程 本章知识点概括 Apache Spark简介 Spark的四种运行模式 Spark基于Standlone的运行流程 Spark ...

- Spark编程模型几大要素

不多说,直接上干货! Spark编程模型几大要素 Driver Program 输入-Transformation-Action 缓存 共享变量

- 转载:Spark中文指南(入门篇)-Spark编程模型(一)

原文:https://www.cnblogs.com/miqi1992/p/5621268.html 前言 本章将对Spark做一个简单的介绍,更多教程请参考:Spark教程 本章知识点概括 Apac ...

- Spark编程模型

主要参考: Spark官方文档:http://spark.apache.org/docs/latest/programming-guide.html 炼数成金PPT:02Spark编程模型和解析 本文 ...

随机推荐

- python 接口测试字符类型转换

接口返回数据: print sql[0][10] {"recv_name":"rdgztest_63126","send_name":&qu ...

- 杂项-权限管理:Spring Secutity

ylbtech-杂项-权限管理:Spring Secutity Spring Security是一个能够为基于Spring的企业应用系统提供声明式的安全访问控制解决方案的安全框架.它提供了一组可以在S ...

- Python selenium 三种等待方法

1. 强制等待 sleep(xx) 是最简单粗暴的一种办法,不管你浏览器是否加载完了,程序都得等待3秒,3秒一到,继续执行下面的代码,作为调试很有用,不建议总用这种等待方式,严重影响程序执行速度. 代 ...

- shutdown-用于关闭/重启计算机

Linux系统下的shutdown命令用于安全的关闭/重启计算机,它不仅可以方便的实现定时关机,还可以由用户决定关机时的相关参数.在执行shutdown命令时,系统会给每个终端(用户)发送一条屏显,提 ...

- C语言32关键字

关键字 说明 auto 声明自动变量 short 声明短整型变量或函数 int 声明整型变量或函数 long 声明长整型变量或函数 float 声明浮点型变量或函数 double 声明双精度变量或函数 ...

- Java视频播放器的制作

----------------siwuxie095 使用 Java Swing 框架制作一个简单的视频播放器: 首先到 Vid ...

- 使用Paramiko的问题

在使用Paramiko远程登录的时候,会报sudo: sorry, you must have a tty to run sudo 切换到root用户,使用visudo命令,然后就会打开一个文本,在文 ...

- Umbraco -- 在Visual Studio中新建一个View 如何在Umbraco back office 中显示出来

在使用Umbraco中的过程中,遇到一个问题. 我在项目中(Visual Studio),添加了一个View---Test.cshtml. 然后进入到该Umbraco项目的back office, 在 ...

- js复习笔记

isNaN(x) 1.判断结果不是纯数字, var a=1234var b =isNan(a) //b是 false 因为a是纯数字 var a="abc123"var b =is ...

- DropDownList绑定数据库

this.DropDownList_设备列表.DataSource = dt_eq;//设置数据源 this.DropDownList_设备列表.DataTextField = "equip ...