java 爬取 国税局 省市区级联关系

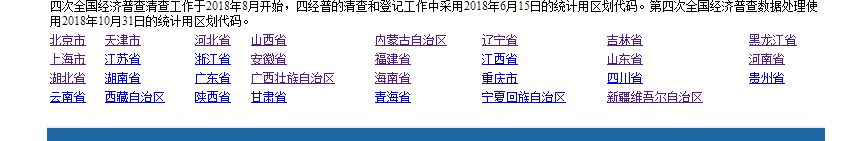

爬取网址 http://www.stats.gov.cn/tjsj/tjbz/tjyqhdmhcxhfdm/2018/index.html

因为数据比较大,存储为一个json,会内存溢出。

所以按照每个省市进行存储。

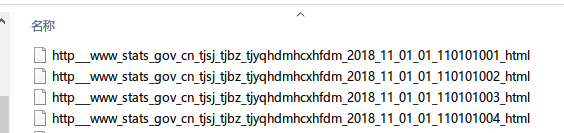

同时因为远程访问链接拿取数据,所以会将已经拿到网页进行缓存,以便下次使用。

package com.witwicky.jsoup; import com.google.gson.Gson;

import com.google.gson.GsonBuilder;

import com.witwicky.vo.CrawlingVo;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements; import java.io.*;

import java.util.ArrayList;

import java.util.List;

import java.util.Random; public class Crawling {

private static final String BASE_SAVE_DIR = "E:\\工作\\extract";

private static final String RESULT_SAVE_DIR = "E:\\工作\\extract_result"; public static void main(String[] args) throws Exception {

Gson gsonPretty = new GsonBuilder().setPrettyPrinting().create();

Gson gsonSimple = new GsonBuilder().create();

List<CrawlingVo> crawlingVos = new ArrayList<CrawlingVo>();

Elements select = getElements("index.html", "tr.provincetr > td > a");

for (Element element : select) {

List<CrawlingVo> crawlingVos1 = new ArrayList<CrawlingVo>();

String val = element.attr("href");

crawlingVos.add(new CrawlingVo(val.substring(0, val.indexOf(".")), element.text(), crawlingVos1)); String baseUrl = element.attr("href");

String baseUrlPre = baseUrl.substring(0, baseUrl.indexOf("."));

Elements ele = getElements(baseUrl, "tr.citytr");

for (Element nextE : ele) {

List<CrawlingVo> crawlingVos2 = new ArrayList<CrawlingVo>();

crawlingVos1.add(new CrawlingVo(nextE.select("td:eq(0) a").text(), nextE.select("td:eq(1) a").text(), crawlingVos2)); String href = nextE.select("td:eq(1) a").attr("href");

String substring = href.substring(0, baseUrl.indexOf("."));

Elements contryElements = getElements(href, "tr.countytr");

for (Element contryElement : contryElements) {

List<CrawlingVo> crawlingVos3 = new ArrayList<CrawlingVo>();

crawlingVos2.add(new CrawlingVo(contryElement.select("td:eq(0) a").text(), contryElement.select("td:eq(1) a").text(), crawlingVos3)); String href1 = contryElement.select("td:eq(1) a").attr("href"); if (!"".equalsIgnoreCase(href1)) {

String substring1 = href1.substring(0, baseUrl.indexOf("."));

Elements elements = getElements(substring + "/" + href1, "tr.towntr");

for (Element element1 : elements) {

List<CrawlingVo> crawlingVos4 = new ArrayList<CrawlingVo>();

crawlingVos3.add(new CrawlingVo(element1.select("td:eq(0) a").text(), element1.select("td:eq(1) a").text(), crawlingVos4)); String href2 = element1.select("td:eq(1) a").attr("href");

Elements elements1 = getElements(baseUrlPre + "/" + substring1 + "/" + href2, "tr.villagetr");

for (Element element2 : elements1) {

crawlingVos4.add(new CrawlingVo(element2.select("td:eq(0)").text(), element2.select("td:eq(2)").text(), new ArrayList<CrawlingVo>()));

}

}

}

}

}

save2File(gsonSimple.toJson(crawlingVos), element.text() + ".json", RESULT_SAVE_DIR);

save2File(gsonPretty.toJson(crawlingVos), element.text() + "_pretty.json", RESULT_SAVE_DIR); System.out.println(element.text() + " is complete!");

}

} private static Elements getElements(String u, String selector) throws IOException, InterruptedException {

String url = "http://www.stats.gov.cn/tjsj/tjbz/tjyqhdmhcxhfdm/2018/" + u;

String cleanUrl = cleanName(url);

Document select = null;

File localFile = new File(BASE_SAVE_DIR, cleanUrl);

if (localFile.exists()) {

select = Jsoup.parse(localFile, "UTF-8");

}

boolean remoteUrl = false;

if (select == null) {

int intRd = new Random().nextInt(5) + 1;

Thread.sleep(intRd * 1000);

select = Jsoup.connect(url).get();

remoteUrl = true;

}

if (remoteUrl) {

save2File(select.toString(), cleanName(url), BASE_SAVE_DIR);

}

return select.select(selector);

} private static String cleanName(String name) {

return name

.replace("\\", "_")

.replace("/", "_")

.replace("//", "_")

.replace(".", "_")

.replace(":", "_");

} private static void save2File(String content, String fileName, String saveDir) {

File dir = new File(saveDir);

if (!dir.exists()) {

boolean mkdirs = dir.mkdirs();

if (!mkdirs) {

return;

}

} File file = new File(dir, fileName);

if (file.exists()) {

return;

} try {

FileOutputStream outSTr = new FileOutputStream(file);

BufferedOutputStream Buff = new BufferedOutputStream(outSTr);

Buff.write(content.getBytes());

Buff.flush();

Buff.close();

} catch (FileNotFoundException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

}

}

}

package com.witwicky.vo;

import java.util.List;

public class CrawlingVo {

private String value;

private String label;

private List<CrawlingVo> children;

public CrawlingVo() {

}

public CrawlingVo(String value, String label, List<CrawlingVo> children) {

this.value = value;

this.label = label;

this.children = children;

}

public String getValue() {

return value;

}

public void setValue(String value) {

this.value = value;

}

public String getLabel() {

return label;

}

public void setLabel(String label) {

this.label = label;

}

public List<CrawlingVo> getChildren() {

return children;

}

public void setChildren(List<CrawlingVo> children) {

this.children = children;

}

}

java 爬取 国税局 省市区级联关系的更多相关文章

- MinerHtmlThread.java 爬取页面线程

MinerHtmlThread.java 爬取页面线程 package com.iteye.injavawetrust.miner; import org.apache.commons.logging ...

- MinerConfig.java 爬取配置类

MinerConfig.java 爬取配置类 package com.iteye.injavawetrust.miner; import java.util.List; /** * 爬取配置类 * @ ...

- Java爬取网络博客文章

前言 近期本人在某云上购买了个人域名,本想着以后购买与服务器搭建自己的个人网站,由于需要筹备的太多,暂时先搁置了,想着先借用GitHub Pages搭建一个静态的站,搭建的过程其实也曲折,主要是域名地 ...

- Java爬取校内论坛新帖

Java爬取校内论坛新帖 为了保持消息灵通,博主没事会上上校内论坛看看新帖,作为爬虫爱好者,博主萌生了写个爬虫自动下载的想法. 嗯,这次就选Java. 第三方库准备 Jsoup Jsoup是一款比较好 ...

- Java爬取B站弹幕 —— Python云图Wordcloud生成弹幕词云

一 . Java爬取B站弹幕 弹幕的存储位置 如何通过B站视频AV号找到弹幕对应的xml文件号 首先爬取视频网页,将对应视频网页源码获得 就可以找到该视频的av号aid=8678034 还有弹幕序号, ...

- java爬取网页内容 简单例子(2)——附jsoup的select用法详解

[背景] 在上一篇博文java爬取网页内容 简单例子(1)——使用正则表达式 里面,介绍了如何使用正则表达式去解析网页的内容,虽然该正则表达式比较通用,但繁琐,代码量多,现实中想要想出一条简单的正则表 ...

- java爬取并下载酷狗TOP500歌曲

是这样的,之前买车送的垃圾记录仪不能用了,这两天狠心买了好点的记录仪,带导航.音乐.蓝牙.4G等功能,寻思,既然有这些功能就利用起来,用4G听歌有点奢侈,就准备去酷狗下点歌听,居然都是需要办会员才能下 ...

- Java爬取并下载酷狗音乐

本文方法及代码仅供学习,仅供学习. 案例: 下载酷狗TOP500歌曲,代码用到的代码库包含:Jsoup.HttpClient.fastJson等. 正文: 1.分析是否可以获取到TOP500歌单 打开 ...

- Java爬取先知论坛文章

Java爬取先知论坛文章 0x00 前言 上篇文章写了部分爬虫代码,这里给出一个完整的爬取先知论坛文章代码. 0x01 代码实现 pom.xml加入依赖: <dependencies> & ...

随机推荐

- python3 词法拆分

1.可以利用translate+string模块 2.可以利用jieba进行分词(结巴分词会分成词,但是我需要断句,所以这里不用) 3.利用python内置函数解决 仅仅只列出第3种方法,其他两种方法 ...

- linux下 玩转ptrace

译者序:在开发Hust Online Judge的过程中,查阅了不少资料,关于调试器技术的资料在网上是很少,即便是UNIX编程巨著<UNIX环境高级编程>中,相关内容也不多,直到我在 ht ...

- FPGA - 认识FPGA

一.何为FPGA? FPGA,英文全拼:Field-Programmable Gate Array 现场可编程门阵列,它是在PAL.GAL.CPLD等可编程器件的基础上进一步发展的产物.它是作为专用集 ...

- echarts相关的可视化数据

echarts使用步骤: 1)设置一个容器,该容器用来放图形,一定要给容器设置高度: 2)初始化echarts实例,语法:var aa = echarts.init(DOM); 例如: echar ...

- PAT Basic 1011

1011 A+B 和 C (15 分) 给定区间 [−231,231] 内的 3 个整数 A.B 和 C,请判断 A+B 是否大于 C. 输入格式: 输入第 1 行给出正整数 T (≤10 ...

- TCP 粘包问题浅析及其解决方案

最近一直在做中间件相关的东西,所以接触到的各种协议比较多,总的来说有TCP,UDP,HTTP等各种网络传输协议,因此楼主想先从协议最基本的TCP粘包问题搞起,把计算机网络这部分基础夯实一下. TCP协 ...

- Spring Boot 中application.yml与bootstrap.yml的区别

其实yml和properties文件是一样的原理,且一个项目上要么yml或者properties,二选一的存在. 推荐使用yml,更简洁. bootstrap与application1.加载顺序这里主 ...

- 诡异的druid链接池链接断开故障经验总结

背景 症状 排查 修复 背景 最近在陆续做机房升级相关工作,配合DBA对产线数据库链接方式做个调整,将原来直接链接读库的地址切换到统一的读负载均衡的代理 haproxy 上,方便机柜和服务器的搬迁. ...

- 【ASP.NET 问题】ASP.NET 网站404页面返回200,或者302的解决办法

做网站在优化网站时遇到了跳转404页面却返回 200.302状态的问题,这样的话搜索引擎会认为这个页面是一个正常的页面,但是这个页面实际是个错误页面,虽然对访问的用户而言,HTTP状态码是“404”还 ...

- yarn 切换 设置 镜像 源

1.查看一下当前源 yarn config get registry 2.切换为淘宝源 yarn config set registry https://registry.npm.taobao.org ...