【实战】yolov8 tensorrt模型加速部署

【实战】yolov8 tensorrt模型加速部署

TensorRT-Alpha基于tensorrt+cuda c++实现模型end2end的gpu加速,支持win10、linux,在2023年已经更新模型:YOLOv8, YOLOv7, YOLOv6, YOLOv5, YOLOv4, YOLOv3, YOLOX, YOLOR,pphumanseg,u2net,EfficientDet。

Windows10教程正在制作,可以关注仓库:https://github.com/FeiYull/TensorRT-Alpha

一、加速结果展示

1.1 性能速览

快速看看yolov8n 在移动端RTX2070m(8G)的新能表现:

| model | video resolution | model input size | GPU Memory-Usage | GPU-Util |

|---|---|---|---|---|

| yolov8n | 1920x1080 | 8x3x640x640 | 1093MiB/7982MiB | 14% |

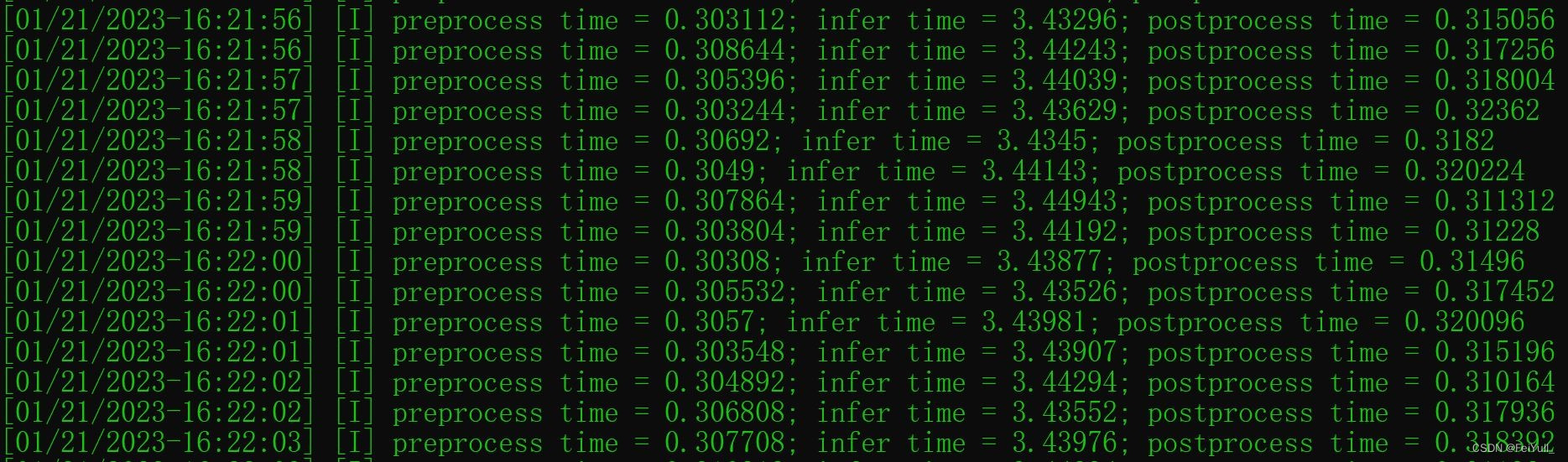

下图是yolov8n的运行时间开销,单位是ms:

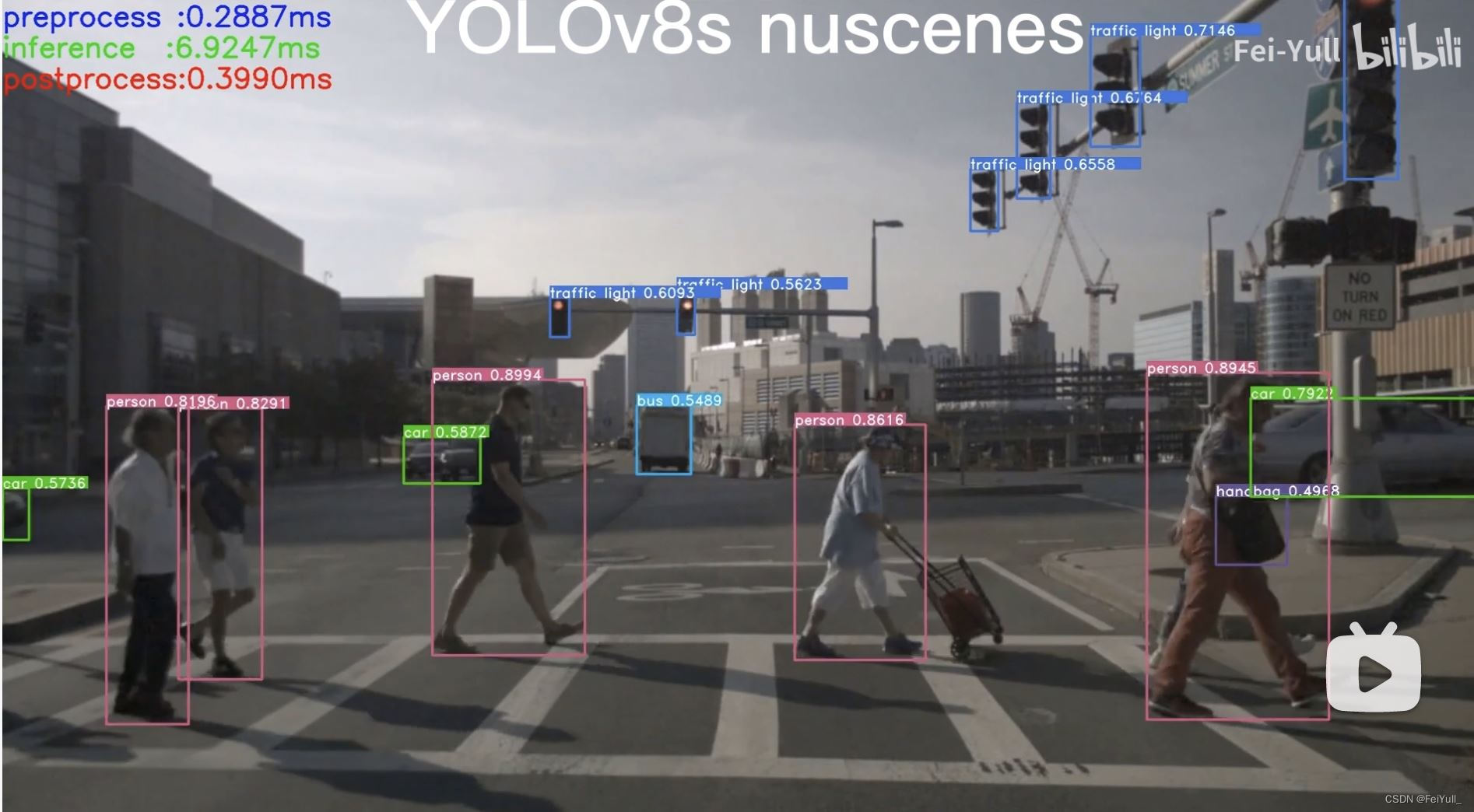

更多TensorRT-Alpha测试录像在B站视频:

B站:YOLOv8n

B站:YOLOv8s

1.2精度对齐

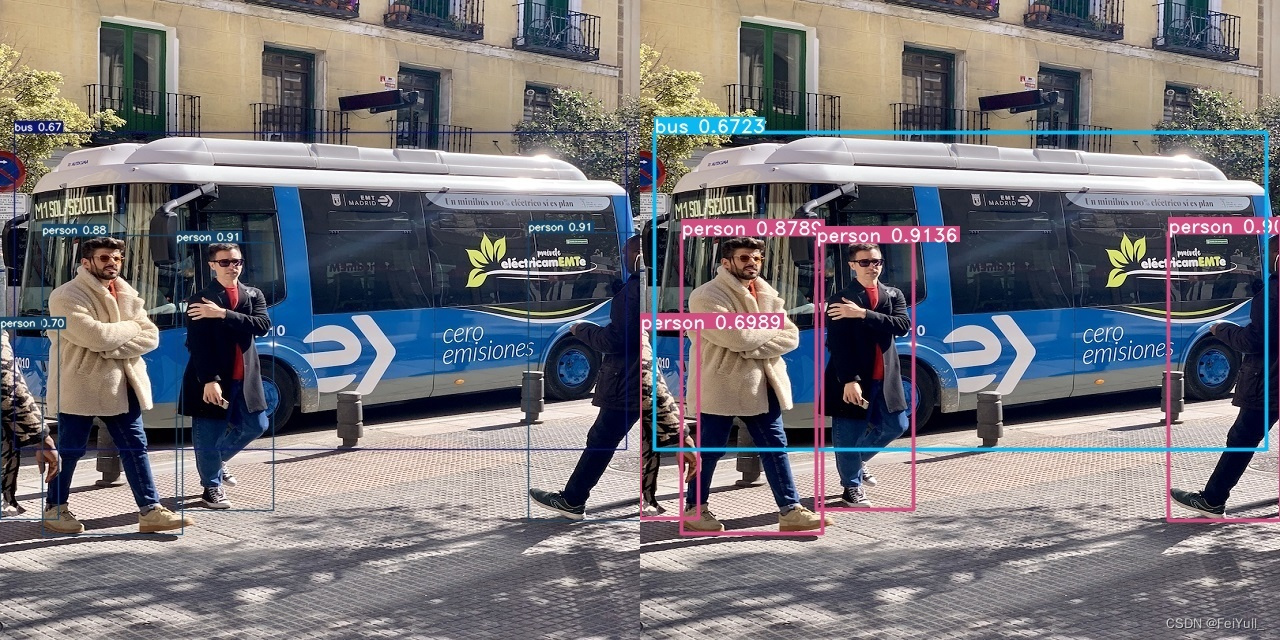

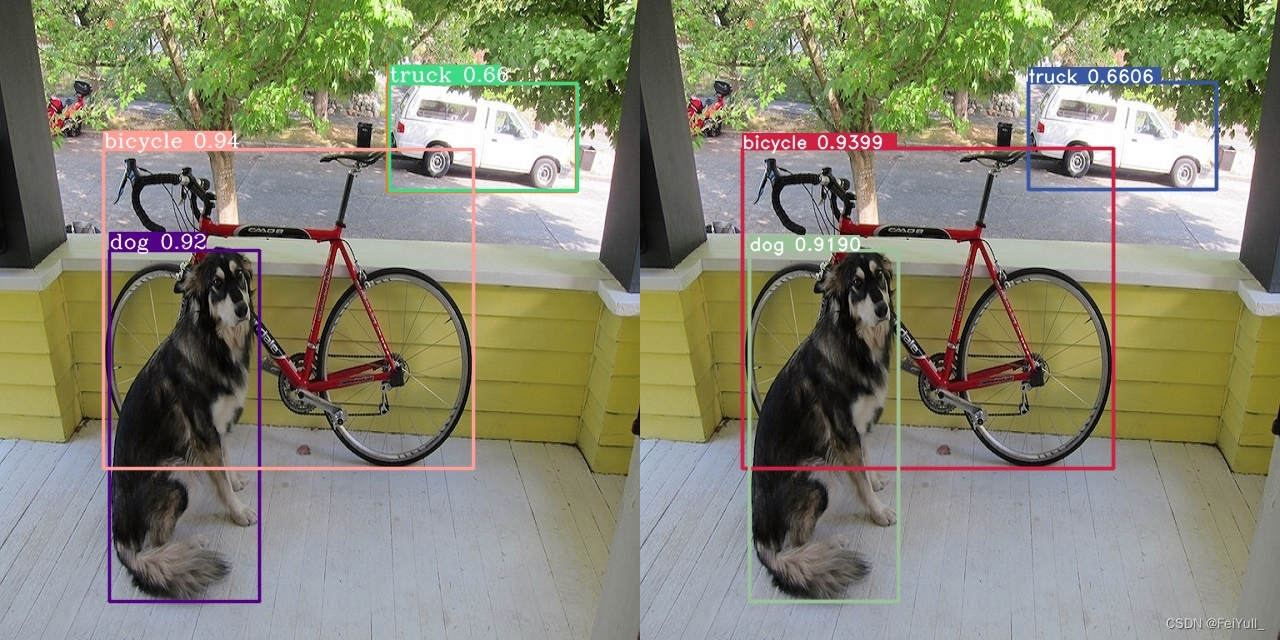

下面是左边是python框架推理结果,右边是TensorRT-Alpha推理结果。

YOLOv4 YOLOv3 YOLOR YOLOX略。

二、linux环境配置

如果您对tensorrt不是很熟悉,请务必保持下面库版本一致。

2.1 安装工具链和opencv

sudo apt-get update

sudo apt-get install build-essential

sudo apt-get install git

sudo apt-get install gdb

sudo apt-get install cmake

sudo apt-get install libopencv-dev

# pkg-config --modversion opencv

2. 安装Nvidia相关库

注:Nvidia相关网站需要注册账号。

2.1 安装Nvidia显卡驱动

ubuntu-drivers devices

sudo add-apt-repository ppa:graphics-drivers/ppa

sudo apt update

sudo apt install nvidia-driver-470-server # for ubuntu18.04

nvidia-smi

2.2 安装 cuda11.3

- 进入链接: https://developer.nvidia.com/cuda-toolkit-archive

- 选择:CUDA Toolkit 11.3.0(April 2021)

- 选择:[Linux] -> [x86_64] -> [Ubuntu] -> [18.04] -> [runfile(local)]

在网页你能看到下面安装命令,我这里已经拷贝下来:

wget https://developer.download.nvidia.com/compute/cuda/11.3.0/local_installers/cuda_11.3.0_465.19.01_linux.run

sudo sh cuda_11.3.0_465.19.01_linux.run

cuda的安装过程中,需要你在bash窗口手动作一些选择,这里选择如下:

- select:[continue] -> [accept] -> 接着按下回车键取消Driver和465.19.01这个选项,如下图(it is important!) -> [Install]

bash窗口提示如下表示安装完成

#===========

#= Summary =

#===========

#Driver: Not Selected

#Toolkit: Installed in /usr/local/cuda-11.3/

#......

把cuda添加到环境变量:

vim ~/.bashrc

把下面拷贝到 .bashrc里面

# cuda v11.3

export PATH=/usr/local/cuda-11.3/bin${PATH:+:${PATH}}

export LD_LIBRARY_PATH=/usr/local/cuda-11.3/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}

export CUDA_HOME=/usr/local/cuda-11.3

刷新环境变量和验证

source ~/.bashrc

nvcc -V

bash窗口打印如下信息表示cuda11.3安装正常

nvcc: NVIDIA (R) Cuda compiler driver<br>

Copyright (c) 2005-2021 NVIDIA Corporation<br>

Built on Sun_Mar_21_19:15:46_PDT_2021<br>

Cuda compilation tools, release 11.3, V11.3.58<br>

Build cuda_11.3.r11.3/compiler.29745058_0<br>

2.3 安装 cudnn8.2

- 进入网站:https://developer.nvidia.com/rdp/cudnn-archive

- 选择: Download cuDNN v8.2.0 (April 23rd, 2021), for CUDA 11.x

- 选择: cuDNN Library for Linux (x86_64)

- 你将会下载这个压缩包: "cudnn-11.3-linux-x64-v8.2.0.53.tgz"

# 解压

tar -zxvf cudnn-11.3-linux-x64-v8.2.0.53.tgz

将cudnn的头文件和lib拷贝到cuda11.3的安装目录下:

sudo cp cuda/include/cudnn.h /usr/local/cuda/include/

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64/

sudo chmod a+r /usr/local/cuda/include/cudnn.h

sudo chmod a+r /usr/local/cuda/lib64/libcudnn*

2.4 下载 tensorrt8.4.2.4

本教程中,tensorrt只需要下载\、解压即可,不需要安装。

- 进入网站: https://developer.nvidia.cn/nvidia-tensorrt-8x-download

- 把这个打勾: I Agree To the Terms of the NVIDIA TensorRT License Agreement

- 选择: TensorRT 8.4 GA Update 1

- 选择: TensorRT 8.4 GA Update 1 for Linux x86_64 and CUDA 11.0, 11.1, 11.2, 11.3, 11.4, 11.5, 11.6 and 11.7 TAR Package

- 你将会下载这个压缩包: "TensorRT-8.4.2.4.Linux.x86_64-gnu.cuda-11.6.cudnn8.4.tar.gz"

# 解压

tar -zxvf TensorRT-8.4.2.4.Linux.x86_64-gnu.cuda-11.6.cudnn8.4.tar.gz

# 快速验证一下tensorrt+cuda+cudnn是否安装正常

cd TensorRT-8.4.2.4/samples/sampleMNIST

make

cd ../../bin/

导出tensorrt环境变量(it is important!),注:将LD_LIBRARY_PATH:后面的路径换成你自己的!后续编译onnx模型的时候也需要执行下面第一行命令

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/home/xxx/temp/TensorRT-8.4.2.4/lib

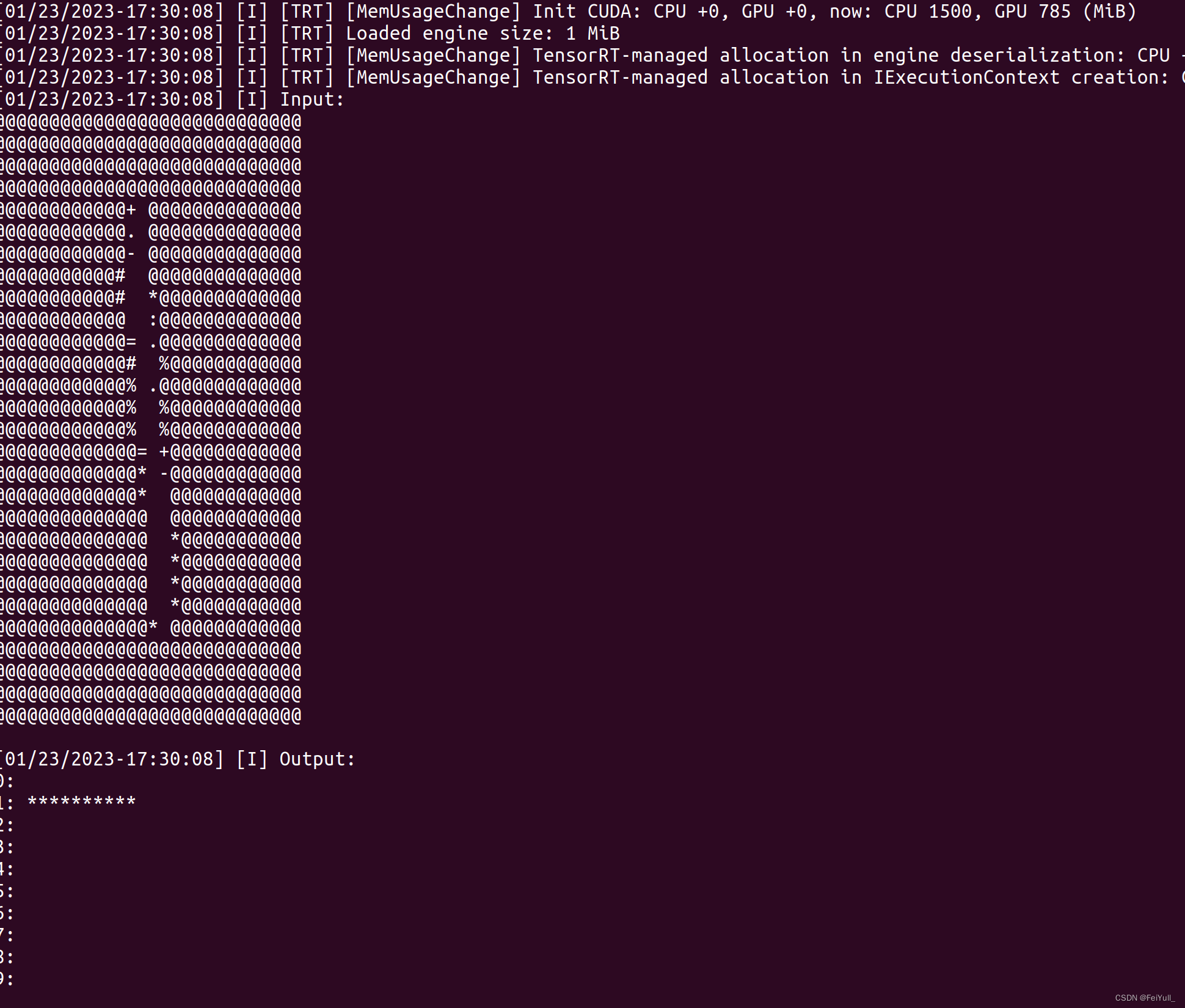

./sample_mnist

bash窗口打印类似如下图的手写数字识别表明cuda+cudnn+tensorrt安装正常

三、YOLOv8模型部署

3.1 下载仓库TensorRT-Alpha

git clone https://github.com/FeiYull/tensorrt-alpha

3.2 获取onnx文件

直接在网盘下载 weiyun or google driver 或者使用如下命令导出onnx:

# yolov8 官方仓库: https://github.com/ultralytics/ultralytics

# yolov8 官方教程: https://docs.ultralytics.com/quickstart/

# TensorRT-Alpha will be updated synchronously as soon as possible!

# 安装 yolov8

conda create -n yolov8 python==3.8 -y

conda activate yolov8

pip install ultralytics==8.0.5

pip install onnx

# 下载官方权重(".pt" file)

https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8n.pt

https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8s.pt

https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8m.pt

https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8l.pt

https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8x.pt

https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8x6.pt

导出 onnx:

# 640

yolo mode=export model=yolov8n.pt format=onnx dynamic=True #simplify=True

yolo mode=export model=yolov8s.pt format=onnx dynamic=True #simplify=True

yolo mode=export model=yolov8m.pt format=onnx dynamic=True #simplify=True

yolo mode=export model=yolov8l.pt format=onnx dynamic=True #simplify=True

yolo mode=export model=yolov8x.pt format=onnx dynamic=True #simplify=True

# 1280

yolo mode=export model=yolov8x6.pt format=onnx dynamic=True #simplify=True

3.3 编译 onnx

# 把你的onnx文件放到这个路径:tensorrt-alpha/data/yolov8

cd tensorrt-alpha/data/yolov8

# 请把LD_LIBRARY_PATH:换成您自己的路径。

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:~/TensorRT-8.4.2.4/lib

# 640

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov8n.onnx --saveEngine=yolov8n.trt --buildOnly --minShapes=images:1x3x640x640 --optShapes=images:4x3x640x640 --maxShapes=images:8x3x640x640

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov8s.onnx --saveEngine=yolov8s.trt --buildOnly --minShapes=images:1x3x640x640 --optShapes=images:4x3x640x640 --maxShapes=images:8x3x640x640

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov8m.onnx --saveEngine=yolov8m.trt --buildOnly --minShapes=images:1x3x640x640 --optShapes=images:4x3x640x640 --maxShapes=images:8x3x640x640

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov8l.onnx --saveEngine=yolov8l.trt --buildOnly --minShapes=images:1x3x640x640 --optShapes=images:4x3x640x640 --maxShapes=images:8x3x640x640

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov8x.onnx --saveEngine=yolov8x.trt --buildOnly --minShapes=images:1x3x640x640 --optShapes=images:4x3x640x640 --maxShapes=images:8x3x640x640

# 1280

../../../../TensorRT-8.4.2.4/bin/trtexec --onnx=yolov8x6.onnx --saveEngine=yolov8x6.trt --buildOnly --minShapes=images:1x3x1280x1280 --optShapes=images:4x3x1280x1280 --maxShapes=images:8x3x1280x1280

你将会的到例如:yolov8n.trt、yolov8s.trt、yolov8m.trt等文件。

3.4 编译运行

git clone https://github.com/FeiYull/tensorrt-alpha

cd tensorrt-alpha/yolov8

mkdir build

cd build

cmake ..

make -j10

# 注: 效果图默认保存在路径 tensorrt-alpha/yolov8/build

# 下面参数解释

# --show 表示可视化结果

# --savePath 表示保存,默认保存在build目录

# --savePath=../ 保存在上一级目录

## 640

# 推理图片

./app_yolov8 --model=../../data/yolov8/yolov8n.trt --size=640 --batch_size=1 --img=../../data/6406407.jpg --show --savePath

./app_yolov8 --model=../../data/yolov8/yolov8n.trt --size=640 --batch_size=8 --video=../../data/people.mp4 --show --savePath

# 推理视频

./app_yolov8 --model=../../data/yolov8/yolov8n.trt --size=640 --batch_size=8 --video=../../data/people.mp4 --show --savePath=../

# 在线推理相机视频

./app_yolov8 --model=../../data/yolov8/yolov8n.trt --size=640 --batch_size=2 --cam_id=0 --show

## 1280

# infer camera

./app_yolov8 --model=../../data/yolov8/yolov8x6.trt --size=1280 --batch_size=2 --cam_id=0 --show

四、参考

https://github.com/FeiYull/TensorRT-Alpha

【实战】yolov8 tensorrt模型加速部署的更多相关文章

- 三分钟快速上手TensorFlow 2.0 (下)——模型的部署 、大规模训练、加速

前文:三分钟快速上手TensorFlow 2.0 (中)——常用模块和模型的部署 TensorFlow 模型导出 使用 SavedModel 完整导出模型 不仅包含参数的权值,还包含计算的流程(即计算 ...

- 139、TensorFlow Serving 实现模型的部署(二) TextCnn文本分类模型

昨晚终于实现了Tensorflow模型的部署 使用TensorFlow Serving 1.使用Docker 获取Tensorflow Serving的镜像,Docker在国内的需要将镜像的Repos ...

- 三分钟快速上手TensorFlow 2.0 (中)——常用模块和模型的部署

本文学习笔记参照来源:https://tf.wiki/zh/basic/basic.html 前文:三分钟快速上手TensorFlow 2.0 (上)——前置基础.模型建立与可视化 tf.train. ...

- StartDT AI Lab | 视觉智能引擎之算法模型加速

通过StartDT AI Lab专栏之前多篇文章叙述,相信大家已经对计算机视觉技术及人工智能算法在奇点云AIOT战略中的支撑作用有了很好的理解.同样,这种业务牵引,技术覆盖的模式也收获了市场的良好反响 ...

- 二手车价格预测 | 构建AI模型并部署Web应用 ⛵

作者:韩信子@ShowMeAI 数据分析实战系列:https://www.showmeai.tech/tutorials/40 机器学习实战系列:https://www.showmeai.tech/t ...

- HOWTO:制作 Windows 7 加速部署映像(作者:苏繁)

加速部署映像 - 也就是我们通常说的系统模板,通常我们为了提高 Windows 的安装速度,会事先制作一套包含驱动.应用软件.补丁程序以及自定义设置的标准化系统.这样我们在使用该加速部署映像完成安装后 ...

- 百度大脑EasyEdge端模型生成部署攻略

EasyEdge是百度基于Paddle Mobile研发的端计算模型生成平台,能够帮助深度学习开发者将自建模型快速部署到设备端.只需上传模型,最快2分种即可生成端计算模型并获取SDK.本文介绍Easy ...

- K8S(16)集成实战-使用spinnaker进行自动化部署

K8s集成实战-使用spinnaker进行自动化部署 1 spinnaker概述和选型 1.1 概述 1.1.1 主要功能 Spinnaker是一个开源的多云持续交付平台,提供快速.可靠.稳定的软件变 ...

- 使用TENSORRT和NVIDIA-DOCKER部署深部神经网络

使用TENSORRT和NVIDIA-DOCKER部署深部神经网络 当前部署工作流

- 模型加速[tensorflow&tensorrt]

在tensorflow1.8之后的版本中,tensorflow.contrib部分都有tensorrt的组件,该组件存在的意义在于,你可以读取pb文件,并调用tensorrt的方法进行subgraph ...

随机推荐

- glusterfs安装配置

目标: 原有的k8s的集群磁盘容量不够,数据迁移无法完成,数据迁移是物理机无法由于采购磁盘流程过程,申请虚拟机搭建glusterfs做分布式存储 磁盘规划: # 查看盘符 $ lsblk # 然后创建 ...

- I-图的分割(二分+并查集)

图的分割 题目大意: 给你n个点,m条边的图,没有重环和自环,所有的点都联通 可以通过删除几条边使得整个图变成两个联通子图 求删除的边中最大边权的最小值 解题思路: 看到"最大边权的最小值& ...

- SpringBoot&MyBatisPlus

5. SpringBoot 学习目标: 掌握基于SpringBoot框架的程序开发步骤 熟练使用SpringBoot配置信息修改服务器配置 基于SpringBoot完成SSM整合项目开发 5.1 入门 ...

- 阿里云 ACK 接入观测云

简介 容器服务 Kubernetes 版(简称 ACK)提供高性能可伸缩的容器应用管理能力,支持企业级容器化应用的全生命周期管理.2021 年成为国内唯一连续三年入选 Gartner 公共云容器报告的 ...

- golang基础语法学习

1.函数作为一等公民 2.驼峰命名法/大小写决定是否在包外见 3.包名应该是小写的单个单词命名 4. 包名应为其源码的基础名称,如encoding/base64,包名应为base64而不是encodi ...

- 【云原生 · Kubernetes】部署 kube-proxy 组件

个人名片: 因为云计算成为了监控工程师 个人博客:念舒_C.ying CSDN主页️:念舒_C.ying kube-proxy 运行在所有 worker 节点上,它监听 apiserver 中 se ...

- Vscode连接gitee远程仓库

Git初始化项目 1. Git的基础配置 Git的安装配置 下载地址为:http://git-scm.com/downloads 安装完第一步要做的是,设置你的用户名和邮件地址. git config ...

- Java阻塞队列中的异类,SynchronousQueue底层实现原理剖析

上篇文章谈到BlockingQueue的使用场景,并重点分析了ArrayBlockingQueue的实现原理,了解到ArrayBlockingQueue底层是基于数组实现的阻塞队列. 但是Blocki ...

- python实现图片转换pdf

安装第三方库 linux平台 sudo apt install python3-reportlab python3-pil 示例代码 import sys from reportlab.pdfgen ...

- Class文件解析

1 准备工作 获取class文件byte[] public static byte[] getFileBytes(File file) { try (FileInputStream fileInput ...