大数据学习之路又之从csv文件到sql文件的操作过程

根据前几天的测试,简单的做个总结

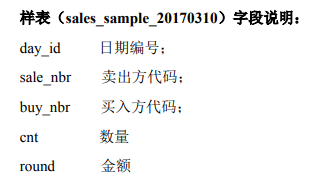

csv文件的字段说明:

1.将csv文件上传到虚拟机中

在SecureCRT中点击 ,创建目录,直接把文件从本地拖拽进去

,创建目录,直接把文件从本地拖拽进去

我放在了/linmob/data的路径下,所以文件的位置是/linmob/data/sales_sample_20170310.csv

2.在hive命令行中建表,表名要与csv文件中的一一对应,人生建议字段类型都选择varchar

hive

create table sales_sample_20170310(day_id varchar(30),sale_nbr varchar(30),buy_nbr varchar(30),cnt varchar(30),round varchar(30)) row format delimited fields terminated by ',' ;

3.导入数据 其中的路径 '/linmob/data/sales_sample_20170310.csv'和表名 sales_sample_20170310要修改成自己的

load data local inpath '/linmob/data/sales_sample_20170310.csv' overwrite into table sales_sample_20170310;

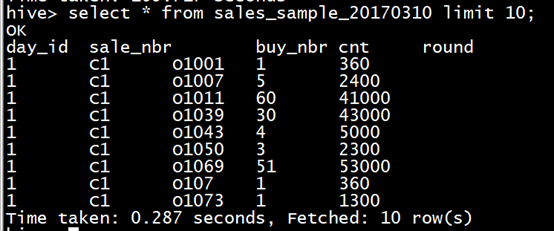

4.select验证数据是否导入,因为数据量大,一定要limit

select * from sales_sample_20170310 limit 10;

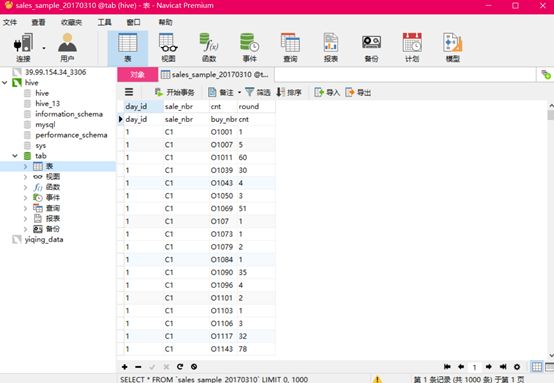

5.退出hive命令行,进入mysql,建表

exit;

mysql -uroot -proot

create table sales_sample_20170310(day_id varchar(30), sale_nbr varchar(30),buy_nbr varchar(30),cnt varchar(30),round varchar(30))charset utf8 collate utf8_general_ci;

6.退出mqsql,进入sqoop的bin目录下,到出数据到mysql数据库中,其中ip地址192.168.111.100、mysql数据库名tab、mysql用户名和密码root、mysql表名 sales_sample_20170310、hive路径名 /user/hive/warehouse/sales_sample_20170310都要换成自己的

hive路径名不清楚?到9870可以找到

./sqoop export --connect "jdbc:mysql://192.168.111.100:3306/tab?characterEncoding=UTF-8" --username root --password root --table sales_sample_20170310 --export-dir /user/hive/warehouse/sales_sample_20170310 --input-null-string "\\\\N" --input-null-non-string "\\\\N" --input-fields-terminated-by "," --input-lines-terminated-by "\\n" -m 1

7.数据导出

大数据学习之路又之从csv文件到sql文件的操作过程的更多相关文章

- 大数据学习之路又之从小白到用sqoop导出数据

写这篇文章的目的是总结自己学习大数据的经验,以为自己走了很多弯路,从迷茫到清晰,真的花费了很多时间,希望这篇文章能帮助到后面学习的人. 一.配置思路 安装linux虚拟机--->创建三台虚拟机- ...

- 大数据学习之路------借助HDP SANDBOX开始学习

一开始... 一开始知道大数据这个概念的时候,只是感觉很高大上,引起了我的兴趣.当时也不知道,这个东西是做什么的,有什么用,当然现在看来也是很模糊的样子,但是的确比一开始强了不少. 所以学习的过程可能 ...

- 大数据学习之路(1)Hadoop生态体系结构

Hadoop的核心是HDFS和MapReduce,hadoop2.0还包括YARN. Hadoop1.x的生态系统: Hadoop2.x引入YARN: HDFS(Hadoop分布式文件系统)源自于Go ...

- 大数据学习之路之HBASE

Hadoop之HBASE 一.HBASE简介 HBase是一个开源的.分布式的,多版本的,面向列的,半结构化的NoSql数据库,提供高性能的随机读写结构化数据的能力.它可以直接使用本地文件系统,也可以 ...

- 大数据学习之路之Hadoop

Hadoop介绍 一.简介 Hadoop是一个开源的分布式计算平台,用于存储大数据,并使用MapReduce来处理.Hadoop擅长于存储各种格式的庞大的数据,任意的格式甚至非结构化的处理.两个核心: ...

- 大数据学习之路-phoenix

1.phoenix安装 ------------------ 1.安装phoenix a)下载apache-phoenix-4.10.0-HBase-1.2-bin.tar.gz 下载网址:htt ...

- 大数据学习笔记——HDFS理论知识之编辑日志与镜像文件

HDFS文件系统——编辑日志和镜像文件详细介绍 我们知道,启动Hadoop之后,在主节点下会产生Namenode,即名称节点进程,该节点的目录下会保存一份元数据,用来记录文件的索引,而在从节点上即Da ...

- 大数据学习之路-hdfs

1.什么是hadoop hadoop中有3个核心组件: 分布式文件系统:HDFS —— 实现将文件分布式存储在很多的服务器上 分布式运算编程框架:MAPREDUCE —— 实现在很多机器上分布式并行运 ...

- 大数据学习之路——MySQL基础(一)——MySQL的基础知识与常见操作

一.存储引擎 1.含义 存储引擎是数据库底层软件组织,数据库管理系统(DBMS)使用数据引擎进行创建.查询.更新和删除数据.不同的存储引擎提供不同的存储机制.索引技巧.锁定水平等功能,使用不同的存储引 ...

随机推荐

- 使用Three.js实现神奇的3D文字悬浮效果

声明:本文涉及图文和模型素材仅用于个人学习.研究和欣赏,请勿二次修改.非法传播.转载.出版.商用.及进行其他获利行为. 背景 在 Three.js Journey 课程示例中,提供了一个使用 Thre ...

- Docker安装与基本命令使用

1. 卸载旧版本 Docker在CentOS上的安装 官方文档:https://docs.docker.com/engine/install/centos/ sudo yum remove docke ...

- nginx: [error] open() "/usr/local/nginx/logs/nginx.pid" failed (2: No such file or directory)

问题场景 服务器重启后,重启nginx时报错nginx: [error] open() "/usr/local/nginx/logs/nginx.pid" failed (2: N ...

- CF1327F题解

首先第一步,位运算拆位.变为一个区间的 \(And\) 为 \(0\) 或 \(1\). 如果 \(And\) 为 \(1\),那么所有数都需要为 \(1\),否则为 \(0\). 我们把所有可能为 ...

- .NET Core剪裁器Zack.DotNetTrimmer升级瘦身引擎,并支持剪裁计划的录制和回放

上周,我发布了对.NET Core程序进行瘦身的开源软件Zack.DotNetTrimmer,与.NET Core内置的剪裁器相比,Zack.DotNetTrimmer不仅对程序的剪裁效果更好,而且还 ...

- Mybatis传递参数的几种方式

使用Map传递 优点:直接在sql中取出key即可 缺点:适用于小项目,不符合大公司规范 对象传递参数 优点:符合标准规范 缺点:麻烦 3.只有一个基本类型参数的情况下,直接在sql中取中 4.多个参 ...

- 无法更新apt镜像源?树莓派安装最新版Debian11(bullseye)arm64位系统步骤

镜像下载.域名解析.时间同步请点击阿里云开源镜像站 树莓派系统在2022年1月28日迎来了更新,更新了64位的系统,同时也有lite系统供我们使用.32位系统很多软件都用不了,特别是宝塔面板.下面是安 ...

- 4月24日 python学习总结 多进程与子进程

一.进程 并发的本质: cpu切换进程+保存状态 一个程序执行了多次,就启动了多个进程 进程与进程之间的内存空间是隔离开的 二.在一个进程中开启子进程 新进程的创建都是由一个已经存在的进程执行了一个用 ...

- springcloud学习03-spring cloud eureka(下)

7.配置服务提供者(生产者) 7.1.配置resources/application.yml. 值eureka.client.service-url(或serviceUrl).defaultZone是 ...

- 利用MSSQL getshell

此次复现使用的sql server 2000 和sql server 2008两个环境进行的 是在已知数据库密码的基础上进行的 0x01 MSSQL连接 连接MSSQL 2000 新建连接: 填写目的 ...