jieba库与词云的使用——以孙子兵法为例

1.打开cmd安装jieba库和 matplotlib。

2.打开python,输入代码。代码如下:

from wordcloud import WordCloud

import matplotlib.pyplot as plt

import jieba def create_word_cloud(filename): text = open("孙子兵法.txt","r",encoding='GBK').read() #打开自己想要的文本 wordlist = jieba.cut(text, cut_all=True) # 结巴分词 wl = " ".join(wordlist) wc = WordCloud( #设置词云 background_color="white", # 设置背景颜色 max_words=50, # 设置最大显示的词云数 font_path='C:/Windows/Fonts/simfang.ttf', # 索引在C盘上的字体库 height=1000, width=1000, max_font_size=150, # 设置字体最大值 random_state=150, # 设置有多少种随机生成状态,即有多少种配色方案 ) myword = wc.generate(wl) # 生成词云 plt.imshow(myword) # 展示词云图 plt.axis("off") plt.show() wc.to_file('img_book.png') # 把词云保存下 txt=open("孙子兵法.txt","r",encoding='GBK').read() #打开自己想要的文本

words=jieba.lcut(txt)

counts={}

for word in words:

if len(word)==1: #排除单个字符的分词结果

continue

else :

counts[word]=counts.get(word,0)+1

items=list(counts.items())

items.sort(key=lambda x:x[1],reverse=True)

for i in range(20):

word,count=items[i]

print ("{0:<20}{1:>5}".format(word,count))

if __name__ == '__main__':

create_word_cloud('孙子兵法') #运行编辑的函数,获得词云

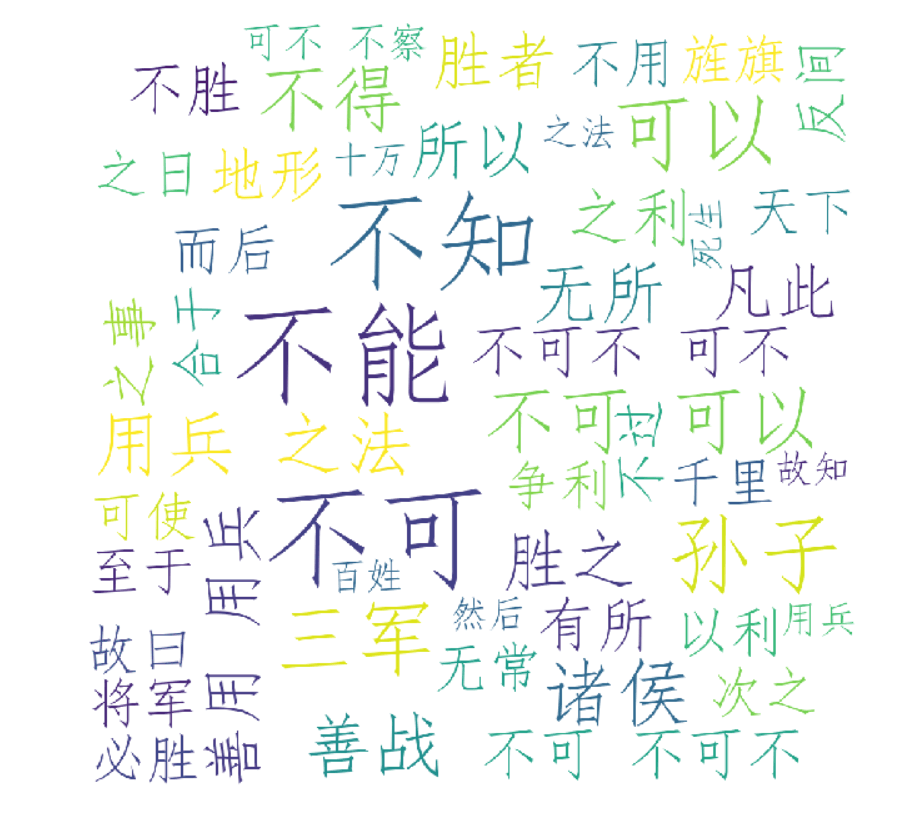

3.结果与词云效果图

jieba库与词云的使用——以孙子兵法为例的更多相关文章

- 利用jieba库画词云

from wordcloud import WordCloud import matplotlib.pyplot as plt import jieba # 生成词云 def create_word_ ...

- jieba分词wordcloud词云

1.jieba库的基本介绍 (1).jieba是优秀的中文分词第三方库 中文文本需要通过分词获得单个的词语 jieba是优秀的中文分词第三方库,需要额外安装 jieba库提供三种分词模式,最简单只需掌 ...

- python 基于 wordcloud + jieba + matplotlib 生成词云

词云 词云是啥?词云突出一个数据可视化,酷炫.以前以为很复杂,不想python已经有成熟的工具来做词云.而我们要做的就是准备关键词数据,挑一款字体,挑一张模板图片,非常非常无脑.准备好了吗,快跟我一起 ...

- python使用matplotlib画图,jieba分词、词云、selenuium、图片、音频、视频、文字识别、人脸识别

一.使用matplotlib画图 关注公众号"轻松学编程"了解更多. 使用matplotlib画柱形图 import matplotlib from matplotlib impo ...

- Python基于jieba的中文词云

今日学习了python的词云技术 from os import path from wordcloud import WordCloud import matplotlib.pyplot as plt ...

- wordcloud + jieba 生成词云

利用jieba库和wordcloud生成中文词云. jieba库:中文分词第三方库 分词原理: 利用中文词库,确定汉字之间的关联概率,关联概率大的生成词组 三种分词模式: 1.精确模式:把文本精确的切 ...

- python抓取数据构建词云

1.词云图 词云图,也叫文字云,是对文本中出现频率较高的"关键词"予以视觉化的展现,词云图过滤掉大量的低频低质的文本信息,使得浏览者只要一眼扫过文本就可领略文本的主旨. 先看几个词 ...

- 如何运用jieba库分词

使用jieba库分词 一.什么是jieba库 1.jieba库概述 jieba是优秀的中文分词第三方库,中文文本需要通过分词获得单个词语. 2.jieba库的使用:(jieba库支持3种分词模式) 通 ...

- Python之利用jieba库做词频统计且制作词云图

一.环境以及注意事项 1.windows10家庭版 python 3.7.1 2.需要使用到的库 wordcloud(词云),jieba(中文分词库),安装过程不展示 3.注意事项:由于wordclo ...

随机推荐

- Mysql如何进行分组,并且让每一组的结果按照某个字段排序,并且获取每一组的第一个字段

select * from (select * from table_name order by id desc) h where h.catagory_id in(value1,value2,val ...

- 2018-2019-2 《网络对抗技术》Exp0 Kali安装 Week1 20165316

2018-2019-2 <网络对抗技术>Exp0 Kali安装 Week1 20165316 下载 我分别下载了kali-linux-2019.1-i386的镜像文件和kali-linux ...

- Spring Boot 指定某个依赖的版本

Spring Boot 是个很好的框架,他为了他的一些功能生效,定义了一些依赖的版本. 比如说:Spring Boot 1.5.x 中elasticSearch是2.4.x的,这个是他本身就定义好的. ...

- MyBatis笔记(二) 最简单的insert命令

接上一篇随笔.这里没有用到MyBatis最关键的映射器接口,因此只做个简单的insert操作,update和delete同理,就不再赘述了. 直接上代码: 首先是dao包下的UserDAO.java文 ...

- 爬微信好友签名和QQ好友签名

先说如何爬微信好友签名,主要使用itchat,这个库提供直接的api来获取好友信息,只要用正则过滤出就行了.说一下步骤,就不贴代码了.# 登陆# 获取好友列表# 提取签名# jieba分词# word ...

- qt 串口

if(ui->connectSerialBtn->text() == tr("打开串口")) { //ui->showSerialInfo->setEnab ...

- volatility内存取证

最近参加了45届世界技能大赛的山东选拔赛,样题里有一个题如下: 师傅好不容易拿到了压缩包的密码,刚准备输入,电脑蓝屏 了... = =",题意简单明了,易于理解.一看就是内存取证的题并且已经 ...

- 十个经典的Python面试题

1.Python下多线程的限制以及多进程中传递参数的方式 Python多线程有个全局解释器锁,这个锁的意思是任一时间只能有一个线程运用解释器.并发不是并行. 多进程间同享数据,能够运用multipro ...

- hdu2844 Coins -----多重背包+二进制优化

题目意思:给出你n种硬币的面额和数量,询问它能够组合成1~m元中的几种情况. 这题如果直接按照完全背包来写的话,会因为每一种硬币的数目1 ≤ Ci ≤ 1000而超时,所以这里需要运用二进制优化来解决 ...

- Microsoft.AspNet.Web.Optimization.Bundle的完美替换方案

Web应用程序中包含大量的样式(css)和脚本(js)文件,这些文件的引用.管理和发布有很多解决方案.在Asp.Net MVC应用程序中,大家最熟悉的解决方案应属Microsoft.AspNet.We ...