jieba库的使用与词频统计

1、词频统计

(1)词频分析是对文章中重要词汇出现的次数进行统计与分析,是文本

挖掘的重要手段。它是文献计量学中传统的和具有代表性的一种内容分析方法,基本原理是通过词出现频次多少的变化,来确定热点及其变化趋势。

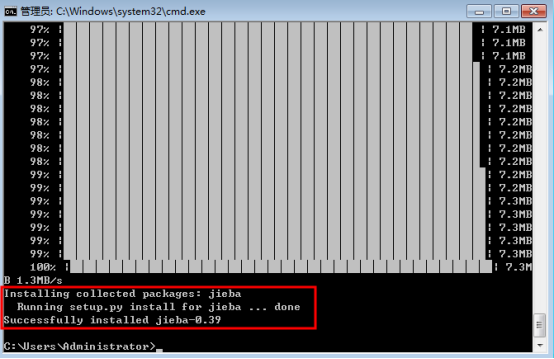

(2)安装jieba库

安装说明

代码对 Python 2/3 均兼容

全自动安装:easy_install jieba 或者 pip install jieba / pip3 install jieba

半自动安装:先下载 http://pypi.python.org/pypi/jieba/ ,解压后运行 python setup.py install

手动安装:将 jieba 目录放置于当前目录或者 site-packages 目录

通过 import jieba 来引用

示例、全自动安装

在命令行下输入指令:

pip install jieba

(2) 安装进程:

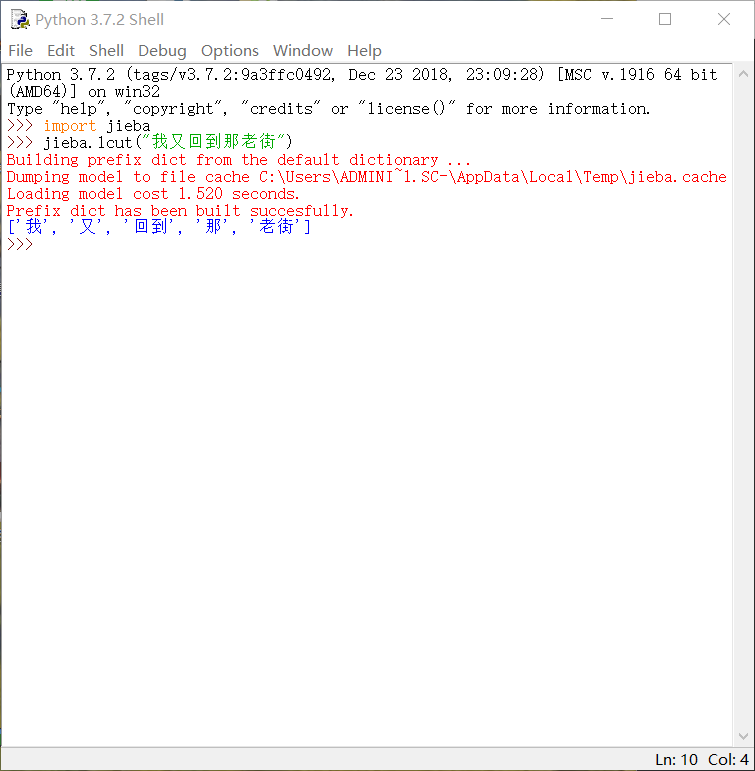

2、调用库函数

1、输入import jieba与使用其中函数

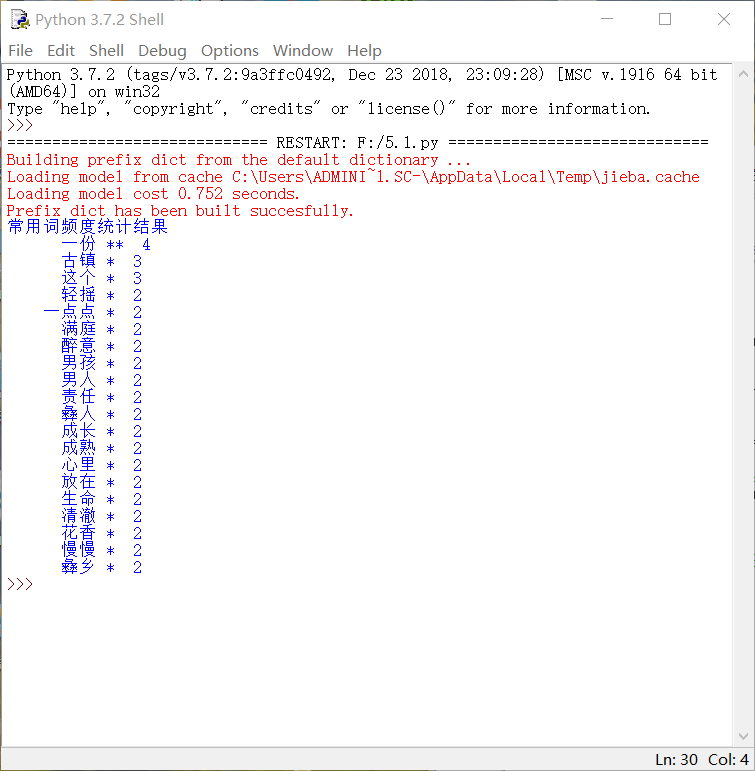

3、python代码

#! python3

# -*- coding: utf- -*-

import os, codecs

import jieba

from collections import Counter def get_words(txt):

seg_list = jieba.cut(txt) #对文本进行分词

c = Counter()

for x in seg_list: #进行词频统计

if len(x)> and x != '\r\n':

c[x] +=

print('常用词频度统计结果')

for (k,v) in c.most_common(): #遍历输出高频词

print('%s%s %s %d' % (' '*(-len(k)), k, '*'*int(v/2), v)) if __name__ == '__main__':

with codecs.open('梦里花落知多少.txt', 'r', 'utf8') as f:

txt = f.read()

get_words(txt)

• •显示效果

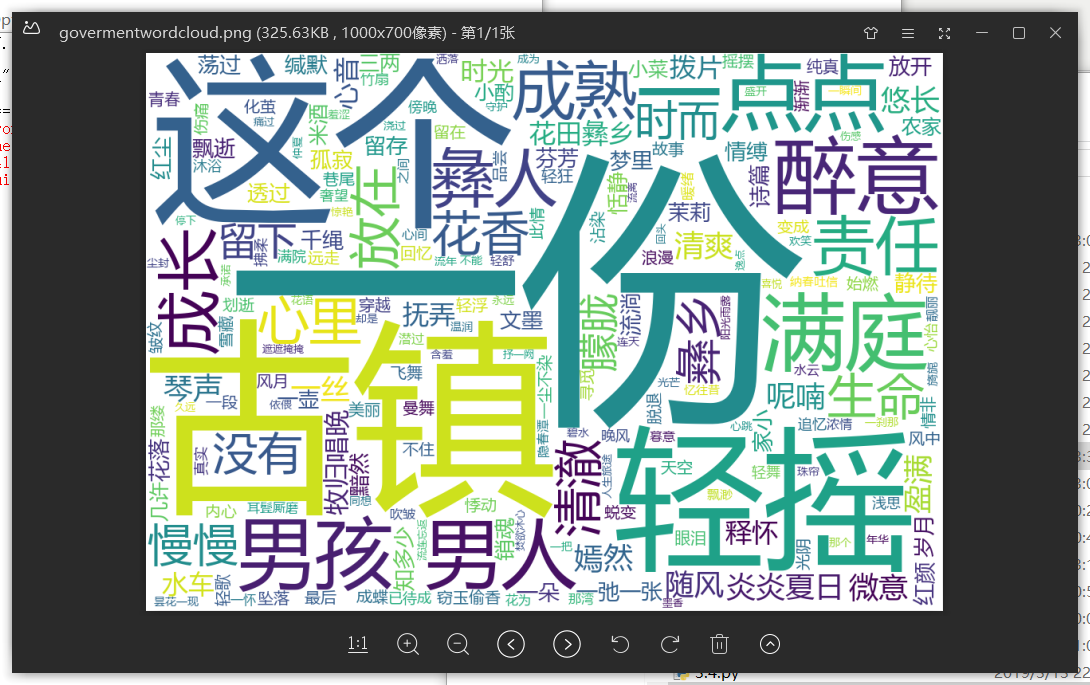

4、词云

import jieba

import wordcloud

f = open("梦里花落知多少.txt","r",encoding = "utf-8") #打开文件

t = f.read() #读取文件,并存好

f.close()

ls = jieba.lcut(t) #对文本分词

txt = " ".join(ls) #对文本进行标点空格化

w = wordcloud.WordCloud(font_path = "msyh.ttc",width = ,height = ,background_color = "white") #设置词云背景,找到字体路径(否则会乱码)

w.generate(txt) #生成词云

w.to_file("govermentwordcloud.png") #保存词云图

• 词云显示

jieba库的使用与词频统计的更多相关文章

- jieba库及wordcloud库的使用

知识内容: 1.jieba库的使用 2.wordcloud库的使用 参考资料: https://github.com/fxsjy/jieba https://blog.csdn.net/fontthr ...

- 用jieba库统计文本词频及云词图的生成

一.安装jieba库 :\>pip install jieba #或者 pip3 install jieba 二.jieba库解析 jieba库主要提供提供分词功能,可以辅助自定义分词词典. j ...

- jieba库词频统计

一.jieba 库简介 (1) jieba 库的分词原理是利用一个中文词库,将待分词的内容与分词词库进行比对,通过图结构和动态规划方法找到最大概率的词组:除此之外,jieba 库还提供了增加自定义中文 ...

- py库: jieba (中文词频统计) 、collections (字频统计)、WordCloud (词云)

先来个最简单的: # 查找列表中出现次数最多的值 ls = [1, 2, 3, 4, 5, 6, 1, 2, 1, 2, 1, 1] ls = ["呵呵", "呵呵&qu ...

- 利用python jieba库统计政府工作报告词频

1.安装jieba库 舍友帮装的,我也不会( ╯□╰ ) 2.上网寻找政府工作报告 3.参照课本三国演义词频统计代码编写 import jieba txt = open("D:\政府工作报告 ...

- Python之利用jieba库做词频统计且制作词云图

一.环境以及注意事项 1.windows10家庭版 python 3.7.1 2.需要使用到的库 wordcloud(词云),jieba(中文分词库),安装过程不展示 3.注意事项:由于wordclo ...

- jieba库词频统计练习

在sypder上运行jieba库的代码: import matplotlib.pyplot as pltfracs = [2,2,1,1,1]labels = 'houqin', 'jiemian', ...

- jieba库分词词频统计

代码已发至github上的python文件 词频统计结果如下(词频为1的词组数量已省略): {'是': 5, '风格': 4, '擅长': 4, '的': 4, '兴趣': 4, '宣言': 4, ' ...

- 使用jieba库与wordcloud库第三方库进行词频统计

一.jieba库与wordcloud库的使用 1.jieba库与wordcloud库的介绍 jieba 库的分词原理是利用一个中文词库,将待分词的内容与分词词库进行比对,通过图结构和动态规划方法找到最 ...

随机推荐

- Linux 用户组

文件权限 r w x 文件时的权限介绍 r 可读 可以使用 cat.less等命令 w 可写 可以编辑,删除此文件 x 可执行 可以命令行模式下提交给内核运行此命令 当时目录时 r 可以使用ls列出 ...

- asp.net core 的 razor pages 如何使用ajax调用后台方法

Razor 是一种允许您向网页中嵌入基于服务器的代码(Visual Basic 和 C#)的标记语法. 当网页被写入浏览器时,基于服务器的代码能够创建动态内容. 在网页加载时,服务器在向浏览器返回页面 ...

- thymleaf th:if判断某值不为空

简单描述:判断后台传递过来的值,是否为空,来做一些业务上的处理. 代码: <div class="col-md-6" th:if="${not #strings.i ...

- nginx 配置访问 静态文件

server { listen 7777; server_name crpapitest.shunshunliuxue.com; index index.html index.htm i ...

- spring boot 2.0 配置双数据源 MySQL 和 SqlServer

参考:https://www.cnblogs.com/xiaofengfeng/p/9552816.html 安装 org.mybatis.spring.boot:mybatis-spring-boo ...

- IOS 修改图片的地理位置信息

直接上代码: // // ViewController.m // changeLocation // // Created by 陈飞 on 16/10/31. // Copyright © 2016 ...

- UOJ#196. 【ZJOI2016】线段树 概率期望,动态规划

原文链接www.cnblogs.com/zhouzhendong/p/UOJ196.html 题解 先离散化,设离散化后的值域为 $[0,m]$ . 首先把问题转化一下,变成:对于每一个位置 $i$ ...

- 执行Hive出现Error running child : java.lang.OutOfMemoryError: Java heap space错误

具体错误日志如下: 2018-05-11 15:16:49,429 FATAL [main] org.apache.hadoop.mapred.YarnChild: Error running chi ...

- 维护爬虫代理IP池--采集并验证

任务分析 我们爬的免费代理来自于https://www.kuaidaili.com这个网站.用`requests`将ip地址与端口采集过来,将`IP`与`PORT`组合成`requests`需要的代理 ...

- FunData — 电竞大数据系统架构演进

电竞出现在人们视野中的频率越来越高了,此次选取FunData作为电竞数据平台,v1.0 beta版本主要提供由Valve公司出品的顶级MOBA类游戏DOTA2相关数据接口(详情:open.varena ...