优化深度神经网络(一) dropout 初始化

Coursera吴恩达《优化深度神经网络》课程笔记(1)-- 深度学习的实用层面

1. Train/Dev/Test sets 训练集(Training sets)、验证集(Development sets)、测试集(Test sets)

之前人们通常设置Train sets和Test sets的数量比例为70%和30%。如果有Dev sets,则设置比例为60%、20%、20%,分别对应Train/Dev/Test sets。这种比例分配在样本数量不是很大的情况下,例如100,1000,10000,是比较科学的。

但是如果数据量很大的时候,例如100万,这种比例分配就不太合适了。科学的做法是要将Dev sets和Test sets的比例设置得很低。因为Dev sets的目标是用来比较验证不同算法的优劣,从而选择更好的算法模型就行了。因此,通常不需要所有样本的20%这么多的数据来进行验证。对于100万的样本,往往只需要10000个样本来做验证就够了。Test sets也是一样,目标是测试已选算法的实际表现,无偏估计。对于100万的样本,往往也只需要10000个样本就够了。因此,对于大数据样本,Train/Dev/Test sets的比例通常可以设置为98%/1%/1%,或者99%/0.5%/0.5%。

样本数据量越大,相应的Dev/Test sets的比例可以设置的越低一些。

现代深度学习还有个重要的问题就是训练样本和测试样本分布上不匹配,意思是训练样本和测试样本来自于不同的分布。

举个例子,假设你开发一个手机app,可以让用户上传图片,然后app识别出猫的图片。在app识别算法中,你的训练样本可能来自网络下载,而你的验证和测试样本可能来自不同用户的上传。从网络下载的图片一般像素较高而且比较正规,而用户上传的图片往往像素不稳定,且图片质量不一。因此,训练样本和验证/测试样本可能来自不同的分布。

解决这一问题的比较科学的办法是尽量保证Dev sets和Test sets来自于同一分布。

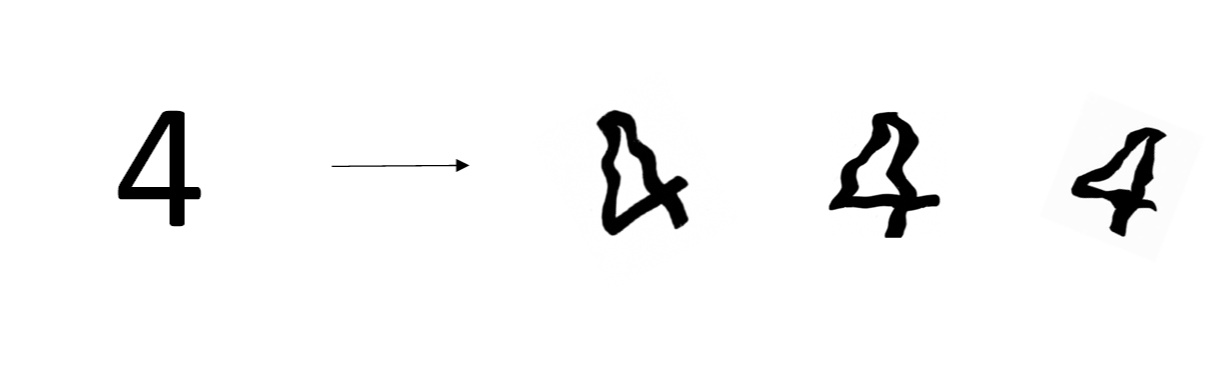

值得一提的是,训练样本非常重要,通常我们可以将现有的训练样本做一些处理,例如图片的翻转、假如随机噪声等,来扩大训练样本的数量,从而让该模型更加强大。即使Train sets和Dev/Test sets不来自同一分布,使用这些技巧也能提高模型性能。

2. Bias/Variance

在传统的机器学习算法中,Bias和Variance是对立的,分别对应着欠拟合和过拟合,我们常常需要在Bias和Variance之间进行权衡。

深度学习中,我们可以同时减小Bias和Variance,构建最佳神经网络模型。

深度学习:

减少high bias的方法通常是增加神经网络的隐藏层个数、神经元个数,训练时间延长,选择其它更复杂的NN模型等。在base error不高的情况下,一般都能通过这些方式有效降低和避免high bias,至少在训练集上表现良好。

减少high variance的方法通常是增加训练样本数据,进行正则化Regularization,选择其他更复杂的NN模型等。

4. Regularization

L1 regularization。其表达式为:

L1的在微分求导方面比较复杂。

在深度学习模型中,L2 regularization的表达式为:

由于加入了正则化项,梯度下降算法中的 计算表达式需要做如下修改:

由于加上了正则项, 有个增量,在更新

的时候,会多减去这个增量,使得

比没有正则项的值要小一些。不断迭代更新,不断地减小。

其中, 。

选择合适大小的 值,就能够同时避免high bias和high variance,得到最佳模型。

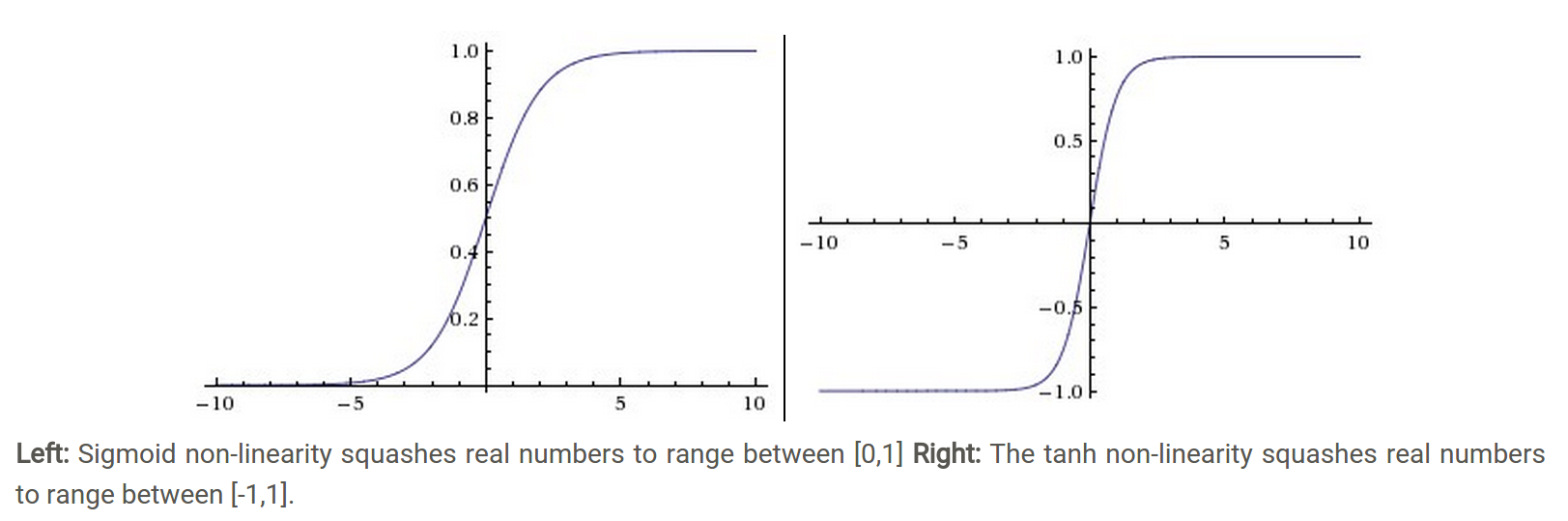

还有另外一个直观的例子来解释为什么正则化能够避免发生过拟合。假设激活函数是tanh函数。tanh函数的特点是在z接近零的区域,函数近似是线性的,而当|z|很大的时候,函数非线性且变化缓慢。当使用正则化, 较大,即对权重

的惩罚较大,

减小。因为

。当

减小的时候,

也会减小。则此时的

分布在tanh函数的近似线性区域。那么这个神经元起的作用就相当于是linear regression。如果每个神经元对应的权重

都比较小,那么整个神经网络模型相当于是多个linear regression的组合,即可看成一个linear network。得到的分类超平面就会比较简单,不会出现过拟合现象。

6. Dropout Regularization

除了L2 regularization之外,还有另外一种防止过拟合的有效方法:Dropout。

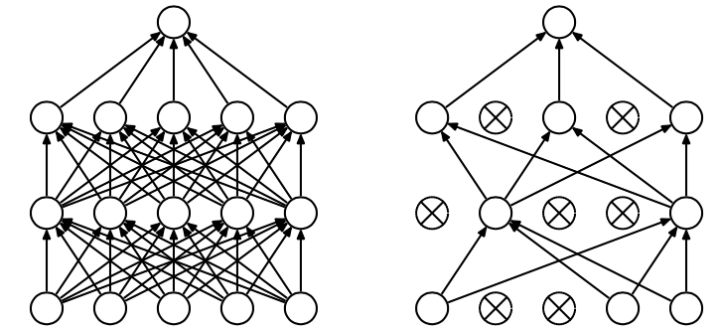

Dropout是指在深度学习网络的训练过程中,对于每层的神经元,按照一定的概率将其暂时从网络中丢弃。也就是说,每次训练时,每一层都有部分神经元不工作,起到简化复杂网络模型的效果,从而避免发生过拟合。

Dropout有不同的实现方法,接下来介绍一种常用的方法:Inverted dropout。假设对于第l层神经元,设定保留神经元比例概率keep_prob=0.8,即该层有20%的神经元停止工作。 为dropout向量,设置

为随机vector,其中80%的元素为1,20%的元素为0。在python中可以使用如下语句生成dropout vector:

dl = np.random.rand(al.shape[0],al.shape[1])<keep_prob

#随机生成大小为al.shape[0],al.shape[1]的矩阵,将其填充在一个均匀分布的随机样本[0, 1)中,小于keep_prob的为false

然后,第 层经过dropout,随机删减20%的神经元,只保留80%的神经元,其输出为:

al = np.multiply(al,dl)

最后,还要对 进行scale up处理,即:

al /= keep_prob

之所以要对 进行scale up是为了保证在经过dropout后,

作为下一层神经元的输入值尽量保持不变。假设第

层有50个神经元,经过dropout后,有10个神经元停止工作,这样只有40神经元有作用。那么得到的

只相当于原来的80%。scale up后,能够尽可能保持

的期望值相比之前没有大的变化。

Inverted dropout的另外一个好处就是在对该dropout后的神经网络进行测试时能够减少scaling问题。因为在训练时,使用scale up保证 的期望值没有大的变化,测试时就不需要再对样本数据进行类似的尺度伸缩操作了。

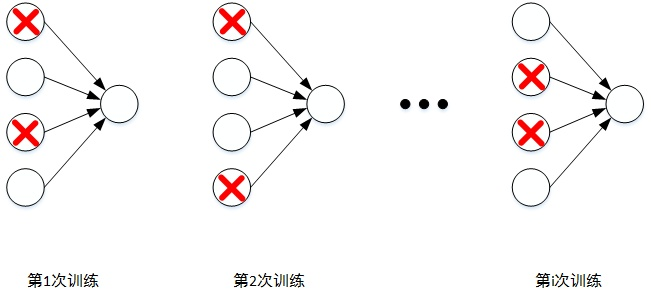

对于m个样本,单次迭代训练时,随机删除掉隐藏层一定数量的神经元;然后,在删除后的剩下的神经元上正向和反向更新权重w和常数项b;接着,下一次迭代中,再恢复之前删除的神经元,重新随机删除一定数量的神经元,进行正向和反向更新w和b。不断重复上述过程,直至迭代训练完成。

值得注意的是,使用dropout训练结束后,在测试和实际应用模型时,不需要进行dropout和随机删减神经元,所有的神经元都在工作。

7. Understanding Dropout

为什么dropout可以防止过拟合

理解1.Dropout通过每次迭代训练时,随机选择不同的神经元,相当于每次都在不同的神经网络上进行训练,类似机器学习中Bagging的方法,能够防止过拟合。

理解2.从权重w的角度。对于某个神经元来说,某次训练时,它的某些输入在dropout的作用被过滤了。而在下一次训练时,又有不同的某些输入被过滤。经过多次训练后,某些输入被过滤,某些输入被保留。这样,该神经元就不会受某个输入非常大的影响,影响被均匀化了。也就是说,对应的权重w不会很大。这从从效果上来说,与L2 regularization是类似的,都是对权重w进行“惩罚”,减小了w的值。

总结一下,对于同一组训练数据,利用不同的神经网络训练之后,求其输出的平均值可以减少overfitting。Dropout就是利用这个原理,每次丢掉一定数量的隐藏层神经元,相当于在不同的神经网络上进行训练,这样就减少了神经元之间的依赖性,即每个神经元不能依赖于某几个其他的神经元(指层与层之间相连接的神经元),使神经网络更加能学习到与其他神经元之间的更加健壮robust的特征。

dropdout注意点

首先,不同隐藏层的dropout系数keep_prob可以不同。一般来说,神经元越多的隐藏层,keep_prob可以设置得小一些.,例如0.5;神经元越少的隐藏层,keep_out可以设置的大一些,例如0.8,设置是1。

实际应用中,不建议对输入层进行dropout,如果输入层维度很大,例如图片,那么可以设置dropout,但keep_prob应设置的大一些,例如0.8,0.9。总体来说,就是越容易出现overfitting的隐藏层,其keep_prob就设置的相对小一些。没有准确固定的做法,通常可以根据validation进行选择。

8. Other regularization methods

1.增加训练样本数量。但是通常成本较高,难以获得额外的训练样本。但是,我们可以对已有的训练样本进行一些处理来“制造”出更多的样本,称为data augmentation。

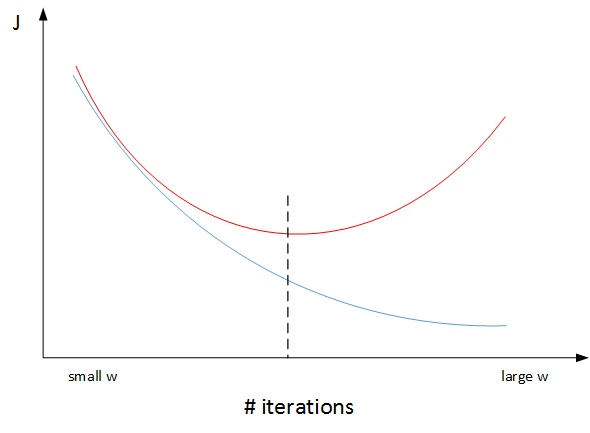

2.early stopping。一个神经网络模型随着迭代训练次数增加,train set error一般是单调减小的,而dev set error 先减小,之后又增大。也就是说训练次数过多时,模型会对训练样本拟合的越来越好,但是对验证集拟合效果逐渐变差,即发生了过拟合。因此,迭代训练次数不是越多越好,可以通过train set error和dev set error随着迭代次数的变化趋势,选择合适的迭代次数,即early stopping。

early stopping缺点:

通常来说,机器学习训练模型有两个目标:一是优化cost function,尽量减小J;二是防止过拟合。这两个目标彼此对立的,即减小J的同时可能会造成过拟合,反之亦然。我们把这二者之间的关系称为正交化orthogonalization。

而在深度学习中,我们可以同时减小Bias和Variance,构建最佳神经网络模型。但是,Early stopping的做法通过减少得带训练次数来防止过拟合,这样J就不会足够小。也就是说,early stopping将上述两个目标融合在一起,同时优化,但可能没有“分而治之”的效果好。

与early stopping相比,L2 regularization可以实现“分而治之”的效果:迭代训练足够多,减小J,而且也能有效防止过拟合。而L2 regularization的缺点之一是最优的正则化参数 的选择比较复杂。对这一点来说,early stopping比较简单。总的来说,L2 regularization更加常用一些。

9. Normalizing inputs

在训练神经网络时,标准化输入可以提高训练的速度。标准化输入就是对训练数据集进行归一化的操作,即将原始数据减去其均值 后,再除以其方差

:

10. 梯度消失 梯度爆炸

详解机器学习中的梯度消失、爆炸原因及其解决方法

- 预训练加微调

- 梯度剪切、权重正则(针对梯度爆炸)

- 使用不同的激活函数 RELU

- 使用batchnorm

- 使用残差结构*

- 使用LSTM网络

11. 权重w初始化

深度神经网络模型中,以单个神经元为例,该层( )的输入个数为n,其输出为:

这里忽略了常数项b。为了让z不会过大或者过小,思路是让w与n有关,且n越大,w应该越小才好。这样能够保证z不会过大。

激活函数是tanh,在初始化w时,令其方差为 。

如果激活函数是ReLU,权重w的初始化一般令其方差为

Yoshua Bengio提出了另外一种初始化w的方法,令其方差为

可以根据不同的激活函数选择不同方法。另外,我们可以对这些初始化方法中设置某些参数,作为超参数,通过验证集进行验证,得到最优参数,来优化神经网络。

13. 梯度检查

我们将介绍如何进行梯度检查,来验证训练过程中是否出现bugs。

1.梯度检查首先要做的是分别将 这些矩阵构造成一维向量,然后将这些一维向量组合起来构成一个更大的一维向量

。这样cost function

就可以表示成

。

2.将反向传播过程通过梯度下降算法得到的 按照一样的顺序构造成一个一维向量

。

的维度与

一致。

3.利用 对每个

计算近似梯度,其值与反向传播算法得到的

相比较,检查是否一致。例如,对于第i个元素,近似梯度为:

4.计算完所有 的近似梯度后,可以计算

与

的欧氏(Euclidean)距离来比较二者的相似度。公式如下:

5.如果欧氏距离越小,例如 ,甚至更小,则表明

与

越接近,即反向梯度计算是正确的,没有bugs。

如果欧氏距离较大,例如 ,则表明梯度计算可能出现问题,需要再次检查是否有bugs存在。

如果欧氏距离很大,例如 ,甚至更大,则表明

与

差别很大,梯度下降计算过程有bugs,需要仔细检查。

在进行梯度检查的过程中有几点需要注意的地方:

- 不要在整个训练过程中都进行梯度检查,仅仅作为debug使用。

- 如果梯度检查出现错误,找到对应出错的梯度,检查其推导是否出现错误。

- 注意不要忽略正则化项,计算近似梯度的时候要包括进去。

- 梯度检查时关闭dropout,检查完毕后再打开dropout。

- 随机初始化时运行梯度检查,经过一些训练后再进行梯度检查(不常用)。

第一隐藏层对应A,第二隐藏层对应C,第三隐藏层对应B,第四隐藏层对应D

第一隐藏层对应A,第二隐藏层对应B,第三隐藏层对应C,第四隐藏层对应D

第一隐藏层对应B,第二隐藏层对应D,第三隐藏层对应C,第四隐藏层对应A

由于反向传播算法进入起始层,学习能力降低,这就是梯度消失。换言之,梯度消失是梯度在前向传播中逐渐减为0, 按照图标题所说, 四条曲线是4个隐藏层的学习曲线, 那么第一层梯度最高(损失函数曲线下降明显), 最后一层梯度几乎为零(损失函数曲线变成平直线). 所以D是第一层, A是最后一层。

优化深度神经网络(一) dropout 初始化的更多相关文章

- TensorFlow实现与优化深度神经网络

TensorFlow实现与优化深度神经网络 转载请注明作者:梦里风林Github工程地址:https://github.com/ahangchen/GDLnotes欢迎star,有问题可以到Issue ...

- 优化深度神经网络(三)Batch Normalization

Coursera吴恩达<优化深度神经网络>课程笔记(3)-- 超参数调试.Batch正则化和编程框架 1. Tuning Process 深度神经网络需要调试的超参数(Hyperparam ...

- 优化深度神经网络(二)优化算法 SGD Momentum RMSprop Adam

Coursera吴恩达<优化深度神经网络>课程笔记(2)-- 优化算法 深度机器学习中的batch的大小 深度机器学习中的batch的大小对学习效果有何影响? 1. Mini-batch ...

- TensorFlow 深度学习笔记 TensorFlow实现与优化深度神经网络

转载请注明作者:梦里风林 Github工程地址:https://github.com/ahangchen/GDLnotes 欢迎star,有问题可以到Issue区讨论 官方教程地址 视频/字幕下载 全 ...

- TensorFlow之CNN:运用Batch Norm、Dropout和早停优化卷积神经网络

学卷积神经网络的理论的时候,我觉得自己看懂了,可是到了用代码来搭建一个卷积神经网络时,我发现自己有太多模糊的地方.这次还是基于MINIST数据集搭建一个卷积神经网络,首先给出一个基本的模型,然后再用B ...

- 代码详解:TensorFlow Core带你探索深度神经网络“黑匣子”

来源商业新知网,原标题:代码详解:TensorFlow Core带你探索深度神经网络“黑匣子” 想学TensorFlow?先从低阶API开始吧~某种程度而言,它能够帮助我们更好地理解Tensorflo ...

- 如何用70行Java代码实现深度神经网络算法

http://www.tuicool.com/articles/MfYjQfV 如何用70行Java代码实现深度神经网络算法 时间 2016-02-18 10:46:17 ITeye 原文 htt ...

- 深度神经网络(DNN)反向传播算法(BP)

在深度神经网络(DNN)模型与前向传播算法中,我们对DNN的模型和前向传播算法做了总结,这里我们更进一步,对DNN的反向传播算法(Back Propagation,BP)做一个总结. 1. DNN反向 ...

- 一位ML工程师构建深度神经网络的实用技巧

一位ML工程师构建深度神经网络的实用技巧 https://mp.weixin.qq.com/s/2gKYtona0Z6szsjaj8c9Vg 作者| Matt H/Daniel R 译者| 婉清 编辑 ...

随机推荐

- combobox里面显示checkbox

看了http://www.cnblogs.com/yubinfeng/p/4463418.html这篇博客,我添加了部分代码,以便在最后获取combobox的value时可以拿到一个数组. HTML代 ...

- hdu 5981 Guess the number

Guess the number Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 160000/160000 K (Java/Other ...

- 【Python】序列的方法

任何序列都可以引用其中的元素(item). 下面的内建函数(built-in function)可用于列表(表,定值表,字符串) #s为一个序列 len(s) 返回: 序列中包含元素的个数 min(s ...

- Ubuntu 下 安装 网易云音乐

先去网易云音乐官网下载Linux下版本的包. 默认下载到 “下载” 路径下 cd 到下载的包目录 通过使用 sudo dpkg -i netease-cloud-music_1.1.0_am ...

- 【linux】基础知识学习

[版本] 两种:内核版本 . 发行版本 内核版本从 www.kernel.org 查看 发行版本: 1.retHat, centOS 更稳定,更安全,适宜做企业服务器 2.ubuntu, Debian ...

- [置顶] php检测输入数据是否合法常用的类

<?php class Fun{ function isEmpty($val) { if (!is_string($val)) return false; //是否是字符串类型 if (empt ...

- 如何在PostgreSQL中建只读账号

转: 如何在PostgreSQL中建只读账号 Posted on 2014-01-21 22:00:15 by osdba 在PostgreSQL中并没有CREATE TABLE权限名称,这是与其它数 ...

- Flask中的session ,自定义实现 session机制, 和 flask-session组件

session 是基于cookie实现, 保存在服务端的键值对(形式为 {随机字符串:'xxxxxx'}), 同时在浏览器中的cookie中也对应一相同的随机字符串,用来再次请求的 时候验证: 注意 ...

- Unity 2D 入门

原文:Introduction to Unity 2D 作者:Sean Duffy 译者:kmyhy 3/15/17 更新说明: 升级至 Unity 5.5. Unity 是一个非常流行和强大的游戏引 ...

- 5.linux目录结构介绍

目录: 1.linux系统的目录结构特点?为何会形成这样的目录结构? 2.基本目录内容详解! 3.重要目录详解! 1.linux系统的目录结构特点? A.Linux系统的目录结构是一棵倒挂的大树,”/ ...