Hadoop综合大作业

Hadoop综合大作业 要求:

用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)词频统计。

用Hive对爬虫大作业产生的csv文件进行数据分析

1. 用Hive对爬虫大作业产生的文本文件

这里的具体操作步骤如下:

- 将网页上的歌词段落爬取下来

- 通过jieba分词后将结果用txt文件保存,

- 将txt文件放入Hadoop分布式文件系统

- 使用hive将文件作为表数据导入

- 使用hive查询统计歌词中单词的出现次数

首先,Python爬虫程序代码如下:

import jiebaimport requestsfrom bs4 import BeautifulSouplyrics = ''headers = {'User-Agent': 'User-Agent:*/*'}resp = requests.get('http://www.juzimi.com/writer/%E6%96%B9%E6%96%87%E5%B1%B1', headers=headers)resp.encoding = 'UTF-8'print(resp.status_code)soup = BeautifulSoup(resp.text, 'html.parser')page_url = 'http://www.juzimi.com/writer/%E6%96%B9%E6%96%87%E5%B1%B1?page={}'page_last = soup.select('.pager-last')if len(page_last) > 0:page_last = page_last[0].textfor i in range(0, int(page_last)):print(i)resp = requests.get(page_url.format(i), headers=headers)resp.encoding = 'UTF-8'soup = BeautifulSoup(resp.text, 'html.parser')for a in soup.select('.xlistju'):lyrics += a.text + ' '# 保留爬取的句子with open('lyrics.txt', 'a+', encoding='UTF-8') as lyricFile:lyricFile.write(lyrics)# 加载标点符号并去除歌词中的标点with open('punctuation.txt', 'r', encoding='UTF-8') as punctuationFile:for punctuation in punctuationFile.readlines():lyrics = lyrics.replace(punctuation[0], ' ')# 加载无意义词汇with open('meaningless.txt', 'r', encoding='UTF-8') as meaninglessFile:mLessSet = set(meaninglessFile.read().split('\n'))mLessSet.add(' ')# 加载保留字with open('reservedWord.txt', 'r', encoding='UTF-8') as reservedWordFile:reservedWordSet = set(reservedWordFile.read().split('\n'))for reservedWord in reservedWordSet:jieba.add_word(reservedWord)keywordList = list(jieba.cut(lyrics))keywordSet = set(keywordList) - mLessSet # 将无意义词从词语集合中删除keywordDict = {}# 统计出词频字典for word in keywordSet:keywordDict[word] = keywordList.count(word)# 对词频进行排序keywordListSorted = list(keywordDict.items())keywordListSorted.sort(key=lambda e: e[1], reverse=True)# 将所有词频写出到txtfor topWordTup in keywordListSorted:print(topWordTup)with open('word.txt', 'a+', encoding='UTF-8') as wordFile:for i in range(0, topWordTup[1]):wordFile.write(topWordTup[0]+'\n')

现在将word.txt放入HDFS中并用hive查询统计,命令如下:

hdfs dfs -mkdir temphdfs dfs -put news.csv temphivehive>create database db_temp;use db_temp;create table tb_word(word string);load data inpath '/user/hadoop/temp/word.txt' into table tb_word;select word, count(1) as num from tb_word group by word order by num desc limit 50;

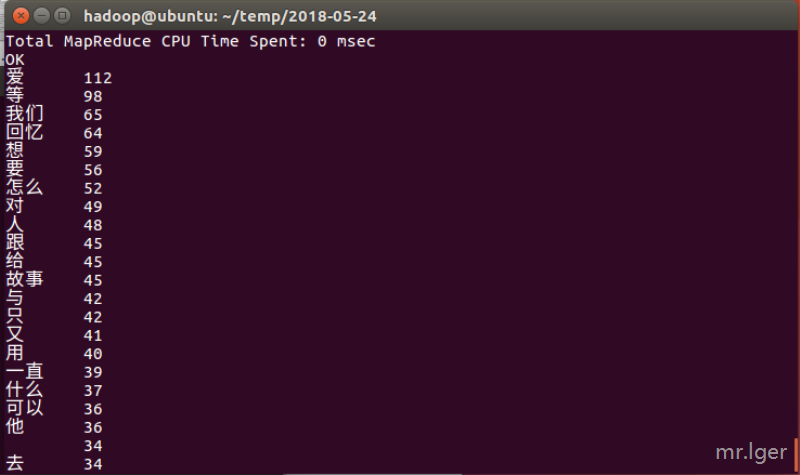

以上的运行结果截图如下:

2. 用Hive对爬虫大作业产生的csv文件进行数据分析

我这里选择了爬取校园新闻并生产csv文件来分析,首先编写爬虫,主要代码如下:

import requestsfrom bs4 import BeautifulSoupfrom datetime import datetimeimport reimport pandasnews_list = []def crawlOnePageSchoolNews(page_url):res0 = requests.get(page_url)res0.encoding = 'UTF-8'soup0 = BeautifulSoup(res0.text, 'html.parser')news = soup0.select('.news-list > li')for n in news:# print(n)print('**' * 5 + '列表页信息' + '**' * 10)print('新闻链接:' + n.a.attrs['href'])print('新闻标题:' + n.select('.news-list-title')[0].text)print('新闻描述:' + n.a.select('.news-list-description')[0].text)print('新闻时间:' + n.a.select('.news-list-info > span')[0].text)print('新闻来源:' + n.a.select('.news-list-info > span')[1].text)news_list.append(getNewDetail(n.a.attrs['href']))return news_listdef getNewDetail(href):print('**' * 5 + '详情页信息' + '**' * 10)print(href)res1 = requests.get(href)res1.encoding = 'UTF-8'soup1 = BeautifulSoup(res1.text, 'html.parser')news = {}if soup1.select('#content'):news_content = soup1.select('#content')[0].textnews['content'] = news_content.replace('\n', ' ').replace('\r', ' ').replace(',', '·')print(news_content) # 文章内容else:news['content'] = ''if soup1.select('.show-info'): # 防止之前网页没有show_infonews_info = soup1.select('.show-info')[0].textelse:return newsinfo_list = ['来源', '发布时间', '点击', '作者', '审核', '摄影'] # 需要解析的字段news_info_set = set(news_info.split('\xa0')) - {' ', ''} # 网页中的 获取后会解析成\xa0,所以可以使用\xa0作为分隔符# 循环打印文章信息for n_i in news_info_set:for info_flag in info_list:if n_i.find(info_flag) != -1: # 因为时间的冒号采用了英文符所以要进行判断if info_flag == '发布时间':# 将发布时间字符串转为datetime格式,方便日后存储到数据库release_time = datetime.strptime(n_i[n_i.index(':') + 1:], '%Y-%m-%d %H:%M:%S ')news[info_flag] = release_timeprint(info_flag + ':', release_time)elif info_flag == '点击': # 点击次数是通过文章id访问php后使用js写入,所以这里单独处理news[info_flag] = getClickCount(href)else:news[info_flag] = n_i[n_i.index(':') + 1:].replace(',', '·')print(info_flag + ':' + n_i[n_i.index(':') + 1:])print('————' * 40)return newsdef getClickCount(news_url):click_num_url = 'http://oa.gzcc.cn/api.php?op=count&id={}&modelid=80'click_num_url = click_num_url.format(re.search('_(.*)/(.*).html', news_url).group(2))res2 = requests.get(click_num_url)res2.encoding = 'UTF-8'click_num = re.search("\$\('#hits'\).html\('(\d*)'\)", res2.text).group(1)print('点击:' + click_num)return click_numprint(crawlOnePageSchoolNews('http://news.gzcc.cn/html/xiaoyuanxinwen/'))pageURL = 'http://news.gzcc.cn/html/xiaoyuanxinwen/{}.html'res = requests.get('http://news.gzcc.cn/html/xiaoyuanxinwen/')res.encoding = 'UTF-8'soup = BeautifulSoup(res.text, 'html.parser')newsSum = int(re.search('(\d*)条', soup.select('a.a1')[0].text).group(1))if newsSum % 10:pageSum = int(newsSum / 10) + 1else:pageSum = int(newsSum / 10)for i in range(2, pageSum + 1):crawlOnePageSchoolNews(pageURL.format(i))# with open('news.txt', 'w') as file:# file.write()dit = pandas.DataFrame(news_list)dit.to_csv('news.csv')print(dit)

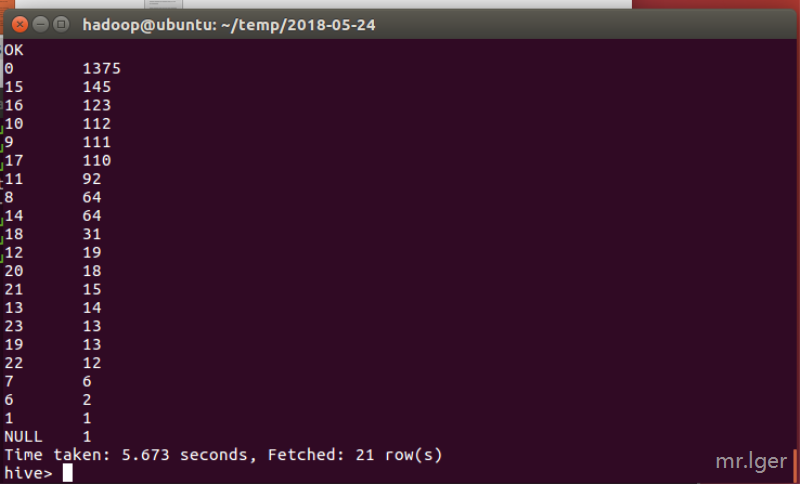

因为csv是用逗号分隔,而文章内容有逗号和换行符容易造成影响,所以在爬取数据时做了相应处理,将换行逗号等使用其他代替。爬取后将文件放入HDFS系统,并将第一行的数据删除,这里使用insert语句覆盖原先导入的表即可,然后通过hive查询做出相应操作分析文章作者在什么时候发表的量比较多。

hdfs dfs -put news.csv temp/hivehive>create table tb_news(id string, content string, author string, publish timestamp, verify string, photo string, source string, click int)row format delimited fields terminated by ',';load data inpath '/user/hadoop/temp/news.csv' overwrite into table tb_news;insert overwrite table tb_news select * from tb_news where content != 'content';select time_publish, count(1) as num from (select hour(publish) as time_publish from tb_news) tb_time group by time_publish order by num desc;

根据以上截图的结果可以看出,小编在发布时间大部分都是在0时,我只能说,熬夜不好

Hadoop综合大作业的更多相关文章

- 大数据应用期末总评——Hadoop综合大作业

作业要求来自:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 Hadoop综合大作业 要求: 1.将爬虫大作业产生的csv文件 ...

- 【大数据应用期末总评】Hadoop综合大作业

作业要求来自:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 一.Hadoop综合大作业 要求: 1.将爬虫大作业产生的csv ...

- 《Hadoop综合大作业》

作业要求来自于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 我主要的爬取内容是关于热门微博文章“996”与日剧<我要 ...

- 菜鸟学IT之Hadoop综合大作业

Hadoop综合大作业 作业来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363 1.将爬虫大作业产生的csv文件上传到HDF ...

- 大数据应用期末总评Hadoop综合大作业

作业要求来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 1.将爬虫大作业产生的csv文件上传到HDFS 此次作业选取的 ...

- Hadoop综合大作业1

本次作业来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363 一.课程评分标准: 分数组成: 考勤 10 平时作业 30 爬 ...

- 【大数据应用技术】作业十二|Hadoop综合大作业

本次作业的要求来自:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 前言 本次作业是在<爬虫大作业>的基础上进行的 ...

- hadoop 综合大作业

作业要求来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 本次作业是在期中大作业的基础上利用hadoop和hive技术进行 ...

- 大数据应用期末总评(hadoop综合大作业)

作业要求源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363 一.将爬虫大作业产生的csv文件上传到HDFS (1)在/usr ...

随机推荐

- 你真的了解ASP.NET Core 部署模型吗?

---------------------------- 以下内容针对 ASP.NET Core2.1,2.2出现IIS进程内寄宿 暂不展开讨论-------------------------- ...

- k8s日志收集方案

k8s日志收集方案 三种收集方案的优缺点: 下面我们就实践第二种日志收集方案: 一.安装ELK 下面直接采用yum的方式安装ELK(源码包安装参考:https://www.cnblogs.com/De ...

- 图解:HTTP 范围请求,助力断点续传、多线程下载的核心原理

题图:by Charles Loyer 一.序 Hi,大家好,我是承香墨影! HTTP 协议在网络知识中占据了重要的地位,HTTP 协议最基础的就是请求和响应的报文,而报文又是由报文头(Header) ...

- 微服务(入门一):netcore安装部署consul

环境准备 vs开发环境:vs2017 consul版本: 1.4.4 netcore版本:2.1 安裝Consul 1.从官网下载consul到本地,选择系统对应的版本进行下载到本地,下载地址:h ...

- 使用LXD搭建Web网站

欢迎大家前往腾讯云+社区,获取更多腾讯海量技术实践干货哦~ 本文由独木桥先生 发表于云+社区专栏 介绍 Linux的容器是Linux的一组进程,通过使用Linux内核功能与系统隔离.它是一个类似于虚拟 ...

- Mybatis框架的简单运用

一.配置流程 1.流程示意图(通过XML映射文件实现): 2.流程: 2.1 导入包: 2.1.1 下载包 数据库驱动包(本文以MySQL为例):https://mvnrepository.com/a ...

- 14 ,CSS 文字与文本

1.CSS 中长度与颜色 2.CSS 中的文字属性 3.CSS 中的文本属性 14.1 CSS 中长度与颜色 长度单位 说明 in 英寸 cm 公分 mm 公里 cm 以目前字体高度为单位 ex 以小 ...

- 底部导航栏-----FragmentTabHost

[说明] 1.主界面上添加父容器:FragmentTabHost 属于v4兼容包 需要指定该id为android:id/tabhost,不能修改,表示由android系统来托管这个id. 本身是一个F ...

- Redis入门教程(二)

推荐阅读: Redis入门教程(一)https://www.cnblogs.com/jichi/p/10285346.html 5. Redis 的数据结构 5.1 Redis 数据结构介绍 redi ...

- V8引擎的垃圾回收策略

V8 的垃圾回收策略主要基于分代式垃圾回收机制.所谓分代式,就是将内存空间分为新生代和老生代两种,然后采用不同的回收算法进行回收. 新生代空间 新生代空间中的对象为存活时间较短的对象,大多数的对象被分 ...