关于怎么获取kafka指定位置offset消息(转)

1.在kafka中如果不设置消费的信息的话,一个消息只能被一个group.id消费一次,而新加如的group.id则会被“消费管理”记录,并指定从当前记录的消息位置开始向后消费。如果有段时间消费者关闭了,并有发送者发送消息那么下次这个消费者启动时也会接收到,但是我们如果想要从这个topic的第一条消息消费呢?

public class SimpleConsumerPerSonIndex2 {

public static void main(String[] args) throws Exception {

//Kafka consumer configuration settings

String topicName = "mypartition001";

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "partitiontest112");

props.put("enable.auto.commit", "true");

props.put("auto.commit.interval.ms", "1000");

props.put("session.timeout.ms", "30000");

//要发送自定义对象,需要指定对象的反序列化类

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "com.ys.test.SpringBoot.zktest.encode.DecodeingKafka");

KafkaConsumer<String, Object> consumer = new KafkaConsumer<String, Object>(props);

Map<TopicPartition, OffsetAndMetadata> hashMaps = new HashMap<TopicPartition, OffsetAndMetadata>();

hashMaps.put(new TopicPartition(topicName, 0), new OffsetAndMetadata(0));

consumer.commitSync(hashMaps);

consumer.subscribe(Arrays.asList(topicName));

while (true) {

ConsumerRecords<String, Object> records = consumer.poll(100);

for (ConsumerRecord<String, Object> record : records){

System.out.println(record.toString());

}

}

}

}

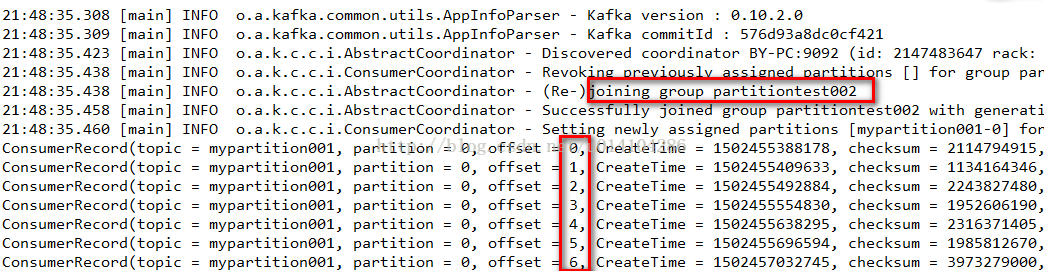

首先我们在consumer.subscribe(Arrays.asList(topicName));订阅一个topic之前要设置从这个topic的offset为0的地方获取。

注意:这样的方法要保证这个group.id是新加入,如果是以前存在的,那么会抛异常。

2.如果以前就存在的groupid想要获取指定的topic的offset为0开始之后的消息:

public class SimpleConsumerPerSonIndex2 {

public static void main(String[] args) throws Exception {

//Kafka consumer configuration settings

String topicName = "mypartition001";

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "partitiontest002");

props.put("enable.auto.commit", "true");

props.put("auto.commit.interval.ms", "1000");

props.put("session.timeout.ms", "30000");

//要发送自定义对象,需要指定对象的反序列化类

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "com.ys.test.SpringBoot.zktest.encode.DecodeingKafka");

KafkaConsumer<String, Object> consumer = new KafkaConsumer<String, Object>(props);

// consumer.subscribe(Arrays.asList(topicName));

consumer.assign(Arrays.asList(new TopicPartition(topicName, 0)));

consumer.seekToBeginning(Arrays.asList(new TopicPartition(topicName, 0)));//不改变当前offset

// consumer.seek(new TopicPartition(topicName, 0), 10);//不改变当前offset

while (true) {

ConsumerRecords<String, Object> records = consumer.poll(100);

for (ConsumerRecord<String, Object> record : records){

System.out.println(record.toString());

}

}

}

}

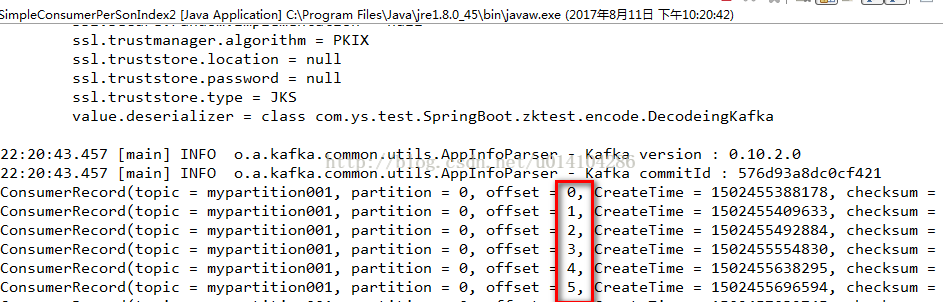

使用 consumer.assign(Arrays.asList(new TopicPartition(topicName, 0)));来分配topic和partition,

而consumer.seekToBeginning(Arrays.asList(new TopicPartition(topicName, 0)));指定从这个topic和partition的开始位置获取。

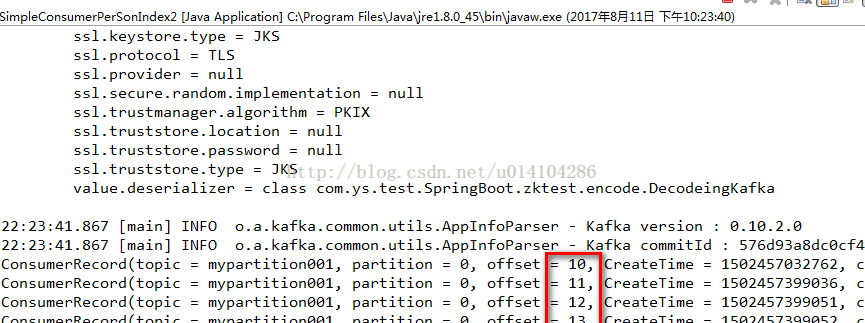

3.存在的groupid获取指定的topic任意的offset

上面的代码放开 consumer.seek(new TopicPartition(topicName, 0), 10);//不改变当前offset

并注释 consumer.seekToBeginning(Arrays.asList(new TopicPartition(topicName, 0)));//不改变当前offset;

其中consumer.seek(new TopicPartition(topicName, 0), 10)中的10是表示从这个topic的partition中的offset为10的开始获取消息。

需要注意的是 consumer.assign()是不会被消费者的组管理功能管理的,他相对于是一个临时的,不会改变当前group.id的offset,比如:

在使用consumer.subscribe(Arrays.asList(topicName));时offset为20,如果通过2和3,已经获取了最新的消息offset是最新的,

在下次通过 consumer.subscribe(Arrays.asList(topicName));来获取消息时offset还是20.还是会获取20以后的消息。

其实在2、3的结果截图中我们也可以发现没有1中结果图的joining group的日志输出,表示没有加入到group中。

————————————————

版权声明:本文为CSDN博主「也是右移」的原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/u014104286/article/details/77103541/

关于怎么获取kafka指定位置offset消息(转)的更多相关文章

- jQuery 获取元素当前位置offset()与position()

<!DOCTYPE html> <html lang="zh-CN"> <head> <meta charset="UTF-8& ...

- 获取kafka的lag, offset, logsize的shell和python脚本

python脚本 #!/usr/bin/env python import os import re import sys group_id=sys.argv[1] pn=sys.argv[2] ka ...

- 工具篇-Spark-Streaming获取kafka数据的两种方式(转载)

转载自:https://blog.csdn.net/weixin_41615494/article/details/7952173 一.基于Receiver的方式 原理 Receiver从Kafka中 ...

- Spark-Streaming获取kafka数据的两种方式:Receiver与Direct的方式

简单理解为:Receiver方式是通过zookeeper来连接kafka队列,Direct方式是直接连接到kafka的节点上获取数据 Receiver 使用Kafka的高层次Consumer API来 ...

- SparkStreaming获取kafka数据的两种方式:Receiver与Direct

简介: Spark-Streaming获取kafka数据的两种方式-Receiver与Direct的方式,可以简单理解成: Receiver方式是通过zookeeper来连接kafka队列, Dire ...

- spark-streaming获取kafka数据的两种方式

简单理解为:Receiver方式是通过zookeeper来连接kafka队列,Direct方式是直接连接到kafka的节点上获取数据 一.Receiver方式: 使用kafka的高层次Consumer ...

- jQuery滚动条回到顶部或指定位置

jQuery滚动条回到顶部或指定位置 在很多网站,为了增强用户体验,我们会看到回到顶部的按钮,不用手动拖拽滚动条就能回到顶部,非常方便.下面就介绍用jquery实现的滚动到顶部的代码 $(functi ...

- 获取kafka最新offset-java

之前笔者曾经写过通过scala的方式获取kafka最新的offset 但是大多数的情况我们需要使用java的方式进行获取最新offset scala的方式可以参考: http://www.cnblog ...

- Flink 自定义source和sink,获取kafka的key,输出指定key

--------20190905更新------- 沙雕了,可以用 JSONKeyValueDeserializationSchema,接收ObjectNode的数据,如果有key,会放在Objec ...

随机推荐

- [转帖]方正数码发布基于龙芯3A3000系列整机

方正数码发布基于龙芯3A3000系列整机 http://www.loongson.cn/news/company/730.html 方正数码也出过龙芯相关的服务器和PC笔记本等 发布时间:2019-0 ...

- The import javax.websocket cannot be resolved的解决问题

在eclipse中导入项目的时候出现了这个问题,废了我半天劲,才搞明白,把问题记录下来,方便大家以后遇到这问题好处理.提供参考. 出现的问题截图: 因为我用的是tomcat8, 大体步骤:项目上点右键 ...

- SQL Server解惑——为什么你的查询结果超出了查询时间范围

原文:SQL Server解惑--为什么你的查询结果超出了查询时间范围 废话少说,直接上SQL代码(有兴趣的测试验证一下),下面这个查询语句为什么将2008-11-27的记录查询出来了呢?这个是同事遇 ...

- # Python3微博爬虫[requests+pyquery+selenium+mongodb]

目录 Python3微博爬虫[requests+pyquery+selenium+mongodb] 主要技术 站点分析 程序流程图 编程实现 数据库选择 代理IP测试 模拟登录 获取用户详细信息 获取 ...

- django 路由层 伪静态网页 虚拟环境 视图层

路由层 无名分组 有名分组 反向解析 路由分发 名称空间 伪静态网页 虚拟环境 视图层 JsonResponse FBV与CBV 文件上传 项目urls.py下面 from app01 import ...

- paramiko-ssh-实现操作记录查看

在paramiko源码包中的demos目录下-> vim interactive.py

- X86逆向10:学会使用硬件断点

本节课我们将学习硬件断点的使用技巧,硬件断点是由硬件提供给我们的一组寄存器,我们可以对这些硬件寄存器设置相应的值,然后让硬件帮我们断在需要下断点的地址上面,这就是硬件断点,硬件断点依赖于寄存器,这些寄 ...

- 啥叫K8s?啥是k8s?

•Kubernetes介绍 1.背景介绍 云计算飞速发展 - IaaS - PaaS - SaaS Docker技术突飞猛进 - 一次构建,到处运行 - 容器的快速轻量 - 完整的生态环境 2.什么是 ...

- H5移动端弹幕动画实现

思路 把单个内容编辑好,计算自身宽度,确定初始位置 移动的距离是屏幕宽度 js动态的添加css动画函数,将高度.动画移动时间.动画延迟时间都用随机数控制 代码: html骨架结构 (以三个为例,如果觉 ...

- 收下这波 JS 技巧,从此少加班

各种业务开发都离不开对数据的处理,然而遇到的很多数据都是不好处理的.这个时候就需要寻求搜索引擎的帮助.这种方法效率是非常低下的,而且根据作者的个性不能保证其对自己的口味.因此这篇文字包含了一份 JS ...