CUDA学习笔记1:第一个CUDA实例

一、cuda简介

二、运行例子的方法:

建完工程后会有一部分代码

在主函数return 0 之前加入getchar();即可运行,关于此代码后期可慢慢研究,这里不做讲解。

源码为:

#include "cuda_runtime.h"

#include "device_launch_parameters.h" #include <stdio.h> cudaError_t addWithCuda(int *c, const int *a, const int *b, unsigned int size); __global__ void addKernel(int *c, const int *a, const int *b)

{

int i = threadIdx.x;

c[i] = a[i] + b[i];

} int main()

{

const int arraySize = ;

const int a[arraySize] = { , , , , };

const int b[arraySize] = { , , , , };

int c[arraySize] = { }; // Add vectors in parallel.

cudaError_t cudaStatus = addWithCuda(c, a, b, arraySize);

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "addWithCuda failed!");

return ;

} printf("{1,2,3,4,5} + {10,20,30,40,50} = {%d,%d,%d,%d,%d}\n",

c[], c[], c[], c[], c[]); // cudaDeviceReset must be called before exiting in order for profiling and

// tracing tools such as Nsight and Visual Profiler to show complete traces.

cudaStatus = cudaDeviceReset();

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "cudaDeviceReset failed!");

return ;

}

getchar();

return ;

} // Helper function for using CUDA to add vectors in parallel.

cudaError_t addWithCuda(int *c, const int *a, const int *b, unsigned int size)

{

int *dev_a = ;

int *dev_b = ;

int *dev_c = ;

cudaError_t cudaStatus; // Choose which GPU to run on, change this on a multi-GPU system.

cudaStatus = cudaSetDevice();

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "cudaSetDevice failed! Do you have a CUDA-capable GPU installed?");

goto Error;

} // Allocate GPU buffers for three vectors (two input, one output) .

cudaStatus = cudaMalloc((void**)&dev_c, size * sizeof(int));

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "cudaMalloc failed!");

goto Error;

} cudaStatus = cudaMalloc((void**)&dev_a, size * sizeof(int));

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "cudaMalloc failed!");

goto Error;

} cudaStatus = cudaMalloc((void**)&dev_b, size * sizeof(int));

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "cudaMalloc failed!");

goto Error;

} // Copy input vectors from host memory to GPU buffers.

cudaStatus = cudaMemcpy(dev_a, a, size * sizeof(int), cudaMemcpyHostToDevice);

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "cudaMemcpy failed!");

goto Error;

} cudaStatus = cudaMemcpy(dev_b, b, size * sizeof(int), cudaMemcpyHostToDevice);

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "cudaMemcpy failed!");

goto Error;

} // Launch a kernel on the GPU with one thread for each element.

addKernel<<<, size>>>(dev_c, dev_a, dev_b); // Check for any errors launching the kernel

cudaStatus = cudaGetLastError();

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "addKernel launch failed: %s\n", cudaGetErrorString(cudaStatus));

goto Error;

} // cudaDeviceSynchronize waits for the kernel to finish, and returns

// any errors encountered during the launch.

cudaStatus = cudaDeviceSynchronize();

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "cudaDeviceSynchronize returned error code %d after launching addKernel!\n", cudaStatus);

goto Error;

} // Copy output vector from GPU buffer to host memory.

cudaStatus = cudaMemcpy(c, dev_c, size * sizeof(int), cudaMemcpyDeviceToHost);

if (cudaStatus != cudaSuccess) {

fprintf(stderr, "cudaMemcpy failed!");

goto Error;

} Error:

cudaFree(dev_c);

cudaFree(dev_a);

cudaFree(dev_b); return cudaStatus;

}

三、实战代码:

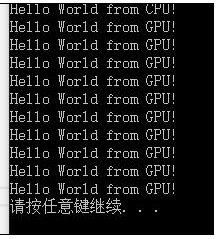

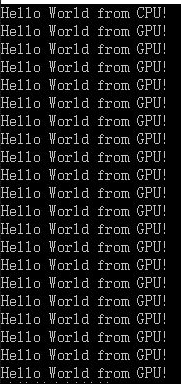

例一:第一个程序hello world

#include "cuda_runtime.h"

#include "device_launch_parameters.h"

#include <stdio.h>

#include <Windows.h>

__global__ void helloFromGPU(void)

{

printf("Hello World from GPU!\n");

} int main(void)

{

// hello from cpu

cudaError_t cudaStatus;

printf("Hello World from CPU!\n"); helloFromGPU << <, >> > ();

cudaDeviceReset();//重置CUDA设备释放程序占用的资源

system("pause");

return ;

}

无视所有错误直接运行即可。

例二:参数的传入

#include "cuda_runtime.h"

#include "device_launch_parameters.h"

#include <stdio.h>

#include <Windows.h>

__global__ void Add(int i, int j)

{

int count;

count = i + j;

printf("\nNum is %d\n", count);

}

int main(void)

{

Add << <, >> >(, );

cudaDeviceReset();//重置CUDA设备释放程序占用的资源

system("pause");

return ;

}

传入参数与一般的c没有什么不一样之处

例三:数据的传入和传出

__global__ void Decrease(int a, int b, int *c)

{

*c = a - b;

}

#include "cuda_runtime.h"

#include "device_launch_parameters.h"

#include <stdio.h>

#include <Windows.h>

void addWithCuda(int *c);//1.定义传入的函数c

int main(void)

{

int c;

c = ;

addWithCuda(&c);//2.传入参数变量(地址)

cudaDeviceReset();//6.重置CUDA设备释放程序占用的资源

printf("Value is %d", c);//7.主机上打印显示数据 system("pause");

return ;

}

__global__ void Decrease(int a, int b, int *c)

{

*c = a - b;

}

void addWithCuda(int *c)

{

int *dev_c = ;//这个相当于内存和显存有一样的

//3.请求CUDA设备的内存(显存),执行CUDA函数

cudaMalloc((void**)&dev_c, sizeof(int));

Decrease << <, >> >(, , dev_c);

//4.等待设备所有线程任务执行完毕

cudaDeviceSynchronize();

//5.数据复制到主机,释放占用空间

cudaMemcpy(c, dev_c, sizeof(int), cudaMemcpyDeviceToHost);

cudaFree(dev_c);

}

例四:数据的传入和传出Ⅱ

__global__ void Decrease(int *a, int *b, int *c)

{

*c = *a - *b;

}

void addWithCuda(int *c, int *a, int *b)

{

int *dev_c = ;

int *dev_a = ;

int *dev_b = ;

//3.请求CUDA设备的内存(显存),执行CUDA函数

cudaMalloc((void**)&dev_c, sizeof(int));

cudaMalloc((void**)&dev_a, sizeof(int));

cudaMalloc((void**)&dev_b, sizeof(int)); //4.从主机复制数据到设备上

cudaMemcpy(dev_a, a, sizeof(int), cudaMemcpyHostToDevice);

cudaMemcpy(dev_b, b, sizeof(int), cudaMemcpyHostToDevice); Decrease << < , >> >(dev_a, dev_b, dev_c); //5.等待设备所有线程任务执行完毕

cudaDeviceSynchronize(); //6.数据复制到主机,释放占用空间

cudaMemcpy(c, dev_c, sizeof(int), cudaMemcpyDeviceToHost);

cudaFree(dev_c);

cudaFree(dev_a);

cudaFree(dev_b);

}

int main(void)

{

int c;

int a, b;

c = ;

a = ;

b = ;

addWithCuda(&c, &a, &b);//2.传入参数变量(地址)

cudaDeviceReset();//7.重置CUDA设备释放程序占用的资源

printf("Value is %d", c);//8.主机上打印显示数据

system("pause");

return ;

}

5.代码:

#include "cuda_runtime.h"

#include "device_launch_parameters.h"

#include <stdio.h>

#include <Windows.h>

__global__ void Decrease(int *a, int *b, int *c)

{

*c = *a - *b;

}

void addWithCuda(int *c, int *a, int *b)

{

int *dev_c = ;

int *dev_a = ;

int *dev_b = ;

//3.请求CUDA设备的内存(显存),执行CUDA函数

cudaMalloc((void**)&dev_c, sizeof(int));

cudaMalloc((void**)&dev_a, sizeof(int));

cudaMalloc((void**)&dev_b, sizeof(int)); //4.从主机复制数据到设备上

cudaMemcpy(dev_a, a, sizeof(int), cudaMemcpyHostToDevice);

cudaMemcpy(dev_b, b, sizeof(int), cudaMemcpyHostToDevice); Decrease << < , >> >(dev_a, dev_b, dev_c); //5.等待设备所有线程任务执行完毕

cudaDeviceSynchronize(); //6.数据复制到主机,释放占用空间

cudaMemcpy(c, dev_c, sizeof(int), cudaMemcpyDeviceToHost);

cudaFree(dev_c);

cudaFree(dev_a);

cudaFree(dev_b);

} int main(void)

{

int c;

int a, b;

c = ;

a = ;

b = ;

addWithCuda(&c, &a, &b);//2.传入参数变量(地址)

cudaDeviceReset();//7.重置CUDA设备释放程序占用的资源

printf("Value is %d", c);//8.主机上打印显示数据

system("pause");

return ;

}

最后再放一个程序关于循环可以自行理解

程序实现向量的加法操作,使用了一个block内部的512个线程。

#include <stdio.h>

#include<cuda_runtime.h> //__global__声明的函数,告诉编译器这段代码交由CPU调用,由GPU执行

__global__ void add(const int *dev_a,const int *dev_b,int *dev_c)

{

int i=threadIdx.x;

dev_c[i]=dev_a[i]+dev_b[i];

} int main(void)

{

//申请主机内存,并进行初始化

int host_a[],host_b[],host_c[];

for(int i=;i<;i++)

{

host_a[i]=i;

host_b[i]=i<<;

} //定义cudaError,默认为cudaSuccess(0)

cudaError_t err = cudaSuccess; //申请GPU存储空间

int *dev_a,*dev_b,*dev_c;

err=cudaMalloc((void **)&dev_a, sizeof(int)*);

err=cudaMalloc((void **)&dev_b, sizeof(int)*);

err=cudaMalloc((void **)&dev_c, sizeof(int)*);

if(err!=cudaSuccess)

{

printf("the cudaMalloc on GPU is failed");

return ;

}

printf("SUCCESS");

//将要计算的数据使用cudaMemcpy传送到GPU

cudaMemcpy(dev_a,host_a,sizeof(host_a),cudaMemcpyHostToDevice);

cudaMemcpy(dev_b,host_b,sizeof(host_b),cudaMemcpyHostToDevice); //调用核函数在GPU上执行。数据较少,之使用一个Block,含有512个线程

add<<<,>>>(dev_a,dev_b,dev_c);

cudaMemcpy(&host_c,dev_c,sizeof(host_c),cudaMemcpyDeviceToHost);

for(int i=;i<;i++)

printf("host_a[%d] + host_b[%d] = %d + %d = %d\n",i,i,host_a[i],host_b[i],host_c[i]);

cudaFree(dev_a);//释放GPU内存

cudaFree(dev_b);//释放GPU内存

cudaFree(dev_c);//释放GPU内存

return ;

}

CUDA学习笔记1:第一个CUDA实例的更多相关文章

- CUDA学习笔记(三)——CUDA内存

转自:http://blog.sina.com.cn/s/blog_48b9e1f90100fm5f.html 结合lec07_intro_cuda.pptx学习 内存类型 CGMA: Compute ...

- CUDA学习笔记(四)——CUDA性能

转自:http://blog.sina.com.cn/s/blog_48b9e1f90100fm5h.html 四.CUDA性能 CUDA中的block被划分成一个个的warp,在GeForce880 ...

- CUDA学习笔记(一)——CUDA编程模型

转自:http://blog.sina.com.cn/s/blog_48b9e1f90100fm56.html CUDA的代码分成两部分,一部分在host(CPU)上运行,是普通的C代码:另一部分在d ...

- CUDA学习笔记(二)——CUDA线程模型

转自:http://blog.sina.com.cn/s/blog_48b9e1f90100fm5b.html 一个grid中的所有线程执行相同的内核函数,通过坐标进行区分.这些线程有两级的坐标,bl ...

- python3.4学习笔记(十四) 网络爬虫实例代码,抓取新浪爱彩双色球开奖数据实例

python3.4学习笔记(十四) 网络爬虫实例代码,抓取新浪爱彩双色球开奖数据实例 新浪爱彩双色球开奖数据URL:http://zst.aicai.com/ssq/openInfo/ 最终输出结果格 ...

- python3.4学习笔记(十一) 列表、数组实例

python3.4学习笔记(十一) 列表.数组实例 #python列表,数组类型要相同,python不需要指定数据类型,可以把各种类型打包进去#python列表可以包含整数,浮点数,字符串,对象#创建 ...

- Spark学习笔记1——第一个Spark程序:单词数统计

Spark学习笔记1--第一个Spark程序:单词数统计 笔记摘抄自 [美] Holden Karau 等著的<Spark快速大数据分析> 添加依赖 通过 Maven 添加 Spark-c ...

- C#.NET学习笔记2---C#.第一个C#程序

C#.NET学习笔记2---C#.第一个C#程序 技术qq交流群:JavaDream:251572072 教程下载,在线交流:创梦IT社区:www.credream.com 6.第一个C#程序: ...

- OGG学习笔记02-单向复制配置实例

OGG学习笔记02-单向复制配置实例 实验环境: 源端:192.168.1.30,Oracle 10.2.0.5 单实例 目标端:192.168.1.31,Oracle 10.2.0.5 单实例 1. ...

- Unity3D学习笔记2——绘制一个带纹理的面

目录 1. 概述 2. 详论 2.1. 网格(Mesh) 2.1.1. 顶点 2.1.2. 顶点索引 2.2. 材质(Material) 2.2.1. 创建材质 2.2.2. 使用材质 2.3. 光照 ...

随机推荐

- NSURLSession---iOS-Apple苹果官方文档翻译

CHENYILONG Blog NSURLSession---iOS-Apple苹果官方文档翻译 NSURLSession 技术博客http://www.cnblogs.com/ChenYilong/ ...

- 【leetcode 简单】第二十题 合并两个有序数组

给定两个有序整数数组 nums1 和 nums2,将 nums2 合并到 nums1 中,使得 num1 成为一个有序数组. 说明: 初始化 nums1 和 nums2 的元素数量分别为 m 和 n. ...

- bzoj 2653 二分答案+可持久化线段树

首先离散化,然后我们知道如果对于一个询问的区间[l1,r1],[l2,r2],我们二分到一个答案x,将[l1,r2]区间中的元素大于等于x的设为1,其余的设为-1,那么如果[l1,r1]的最大右区间和 ...

- bootstrap通过ajax请求JSON数据后填充到模态框

1. JSP页面中准备模态框 <!-- 详细信息模态框(Modal) --> <div> <div class="modal fade" id=& ...

- [MySQL] AUTO_INCREMENT lock Handing in InnoDB

MySQL AUTO_INCREMENT lock Handing in InnoDB 在MySQL的表设计中很普遍的使用自增长字段作为表主键, 实际生产中我们也是这样约束业务开发同学的, 其中的优势 ...

- Ubuntu或者Ubuntu server重新设置IP地址

1.打开终端输入: sudo vi /etc/network/interfaces 2.进入编辑页面 改一处,添加5行内容,如下图: 3.修改好后esc :wq进行保存 4.输入: sudo / ...

- [ python ] 集合的使用

集合的使用 可变数据类型,他里面的元素必须是不可变的数据类型,无序,不重复. 集合的增删查 集合是没有改这种说法的: (1)集合的元素无序的: (2)集合的元素为不可变类型 增加 add 为集 ...

- 以太坊go-ethereum客户端docker安装(一)

最近一段时间忙于工作,就没来得及发表博客,但一直没有停止对区块链的研究.周末抽时间分享一下近期比较重大的收获之一--使用docker来搭建和使用以太坊的节点.本人已经顺利搭建出,开发环境,测试环境,F ...

- MQTT协议以及库函数说明

内容简介:之前我们写了一篇ESP8266AT指令的说明文档,在客户端连接上服务器之后,接下来便是网络通信.为此我们又写了这一片MQTT协议的说明文档,更加深层次的讲述了通信的原理.此文档只是我们在调试 ...

- 【51nod】1309 Value of all Permutations

题解 可重元素的全排列都是很熟知的东西了 就是 \(\frac{n!}{\prod c_{i}!}\)其中\(c_{i}\)是第i种数出现的次数 我们对于每个元素统计一下多少排列里这个数会被统计进去 ...