C#网络爬虫--多线程处理强化版

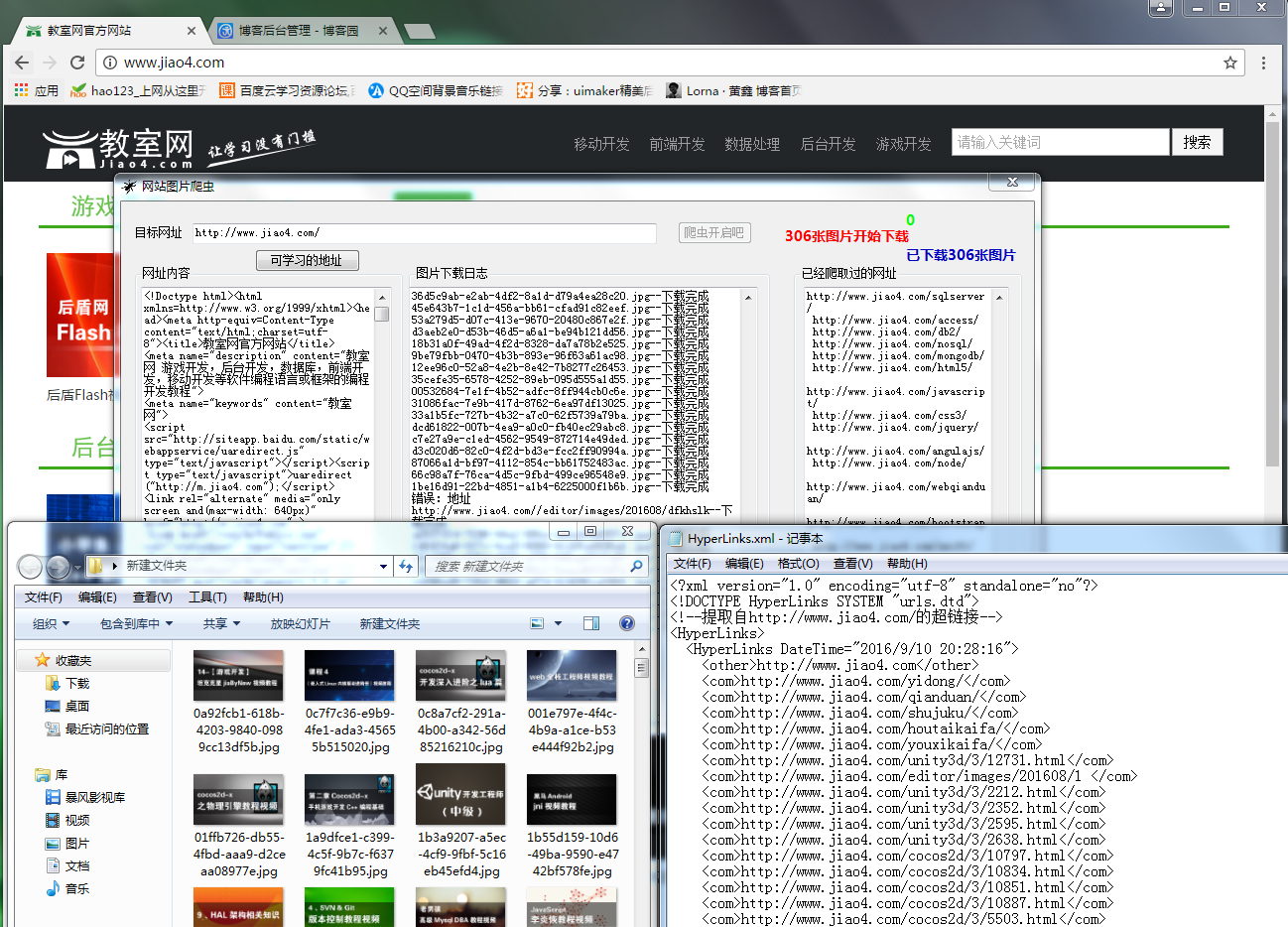

上次做了一个帮公司妹子做了爬虫,不是很精致,这次公司项目里要用到,于是有做了一番修改,功能添加了网址图片采集,下载,线程处理界面网址图片下载等。

说说思路:首相获取初始网址的所有内容 在初始网址采集图片 去初始网址采集链接 把采集到的链接放入队列 继续采集图片,然后继续采集链接,无限循环

还是上图片大家看一下,在上代码!

处理网页内容抓取跟网页网址爬取都做了改进,下面还是大家来看看代码,有不足之处,还请之处!

网页内容抓取HtmlCodeRequest,

网页网址爬取GetHttpLinks,用正则去筛选html中的Links

图片抓取GetHtmlImageUrlList,用正则去筛选html中的Img

都写进了一个封装类里面 HttpHelper

/// <summary>

/// 取得HTML中所有图片的 URL。

/// </summary>

/// <param name="sHtmlText">HTML代码</param>

/// <returns>图片的URL列表</returns>

public static string HtmlCodeRequest(string Url)

{

if (string.IsNullOrEmpty(Url))

{

return "";

}

try

{

//创建一个请求

HttpWebRequest httprequst = (HttpWebRequest)WebRequest.Create(Url);

//不建立持久性链接

httprequst.KeepAlive = true;

//设置请求的方法

httprequst.Method = "GET";

//设置标头值

httprequst.UserAgent = "User-Agent:Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.0.3705";

httprequst.Accept = "*/*";

httprequst.Headers.Add("Accept-Language", "zh-cn,en-us;q=0.5");

httprequst.ServicePoint.Expect100Continue = false;

httprequst.Timeout = ;

httprequst.AllowAutoRedirect = true;//是否允许302

ServicePointManager.DefaultConnectionLimit = ;

//获取响应

HttpWebResponse webRes = (HttpWebResponse)httprequst.GetResponse();

//获取响应的文本流

string content = string.Empty;

using (System.IO.Stream stream = webRes.GetResponseStream())

{

using (System.IO.StreamReader reader = new StreamReader(stream, System.Text.Encoding.GetEncoding("utf-8")))

{

content = reader.ReadToEnd();

}

}

//取消请求

httprequst.Abort();

//返回数据内容

return content;

}

catch (Exception)

{ return "";

}

}

/// <summary>

/// 提取页面链接

/// </summary>

/// <param name="html"></param>

/// <returns></returns>

public static List<string> GetHtmlImageUrlList(string url)

{

string html = HttpHelper.HtmlCodeRequest(url);

if (string.IsNullOrEmpty(html))

{

return new List<string>();

}

// 定义正则表达式用来匹配 img 标签

Regex regImg = new Regex(@"<img\b[^<>]*?\bsrc[\s\t\r\n]*=[\s\t\r\n]*[""']?[\s\t\r\n]*(?<imgUrl>[^\s\t\r\n""'<>]*)[^<>]*?/?[\s\t\r\n]*>", RegexOptions.IgnoreCase); // 搜索匹配的字符串

MatchCollection matches = regImg.Matches(html);

List<string> sUrlList = new List<string>(); // 取得匹配项列表

foreach (Match match in matches)

sUrlList.Add(match.Groups["imgUrl"].Value);

return sUrlList;

} /// <summary>

/// 提取页面链接

/// </summary>

/// <param name="html"></param>

/// <returns></returns>

public static List<string> GetHttpLinks(string url)

{

//获取网址内容

string html = HttpHelper.HtmlCodeRequest(url);

if (string.IsNullOrEmpty(html))

{

return new List<string>();

}

//匹配http链接

const string pattern2 = @"http(s)?://([\w-]+\.)+[\w-]+(/[\w- ./?%&=]*)?";

Regex r2 = new Regex(pattern2, RegexOptions.IgnoreCase);

//获得匹配结果

MatchCollection m2 = r2.Matches(html);

List<string> links = new List<string>();

foreach (Match url2 in m2)

{

if (StringHelper.CheckUrlIsLegal(url2.ToString()) || !StringHelper.IsPureUrl(url2.ToString()) || links.Contains(url2.ToString()))

continue;

links.Add(url2.ToString());

}

//匹配href里面的链接

const string pattern = @"(?i)<a\s[^>]*?href=(['""]?)(?!javascript|__doPostBack)(?<url>[^'""\s*#<>]+)[^>]*>"; ;

Regex r = new Regex(pattern, RegexOptions.IgnoreCase);

//获得匹配结果

MatchCollection m = r.Matches(html);

foreach (Match url1 in m)

{

string href1 = url1.Groups["url"].Value;

if (!href1.Contains("http"))

{

href1 = Global.WebUrl + href1;

}

if (!StringHelper.IsPureUrl(href1) || links.Contains(href1)) continue;

links.Add(href1);

}

return links;

}

这边下载图片有个任务条数限制,限制是200条。如果超过的话线程等待5秒,这里下载图片是异步调用的委托

public string DownLoadimg(string url)

{

if (!string.IsNullOrEmpty(url))

{

try

{

if (!url.Contains("http"))

{

url = Global.WebUrl + url;

}

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.Timeout = ;

request.UserAgent = "User-Agent:Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.0.3705";

//是否允许302

request.AllowAutoRedirect = true;

WebResponse response = request.GetResponse();

Stream reader = response.GetResponseStream();

//文件名

string aFirstName = Guid.NewGuid().ToString();

//扩展名

string aLastName = url.Substring(url.LastIndexOf(".") + , (url.Length - url.LastIndexOf(".") - ));

FileStream writer = new FileStream(Global.FloderUrl + aFirstName + "." + aLastName, FileMode.OpenOrCreate, FileAccess.Write);

byte[] buff = new byte[];

//实际读取的字节数

int c = ;

while ((c = reader.Read(buff, , buff.Length)) > )

{

writer.Write(buff, , c);

}

writer.Close();

writer.Dispose();

reader.Close();

reader.Dispose();

response.Close();

return (aFirstName + "." + aLastName);

}

catch (Exception)

{

return "错误:地址" + url;

}

}

return "错误:地址为空";

}

话不多说,更多的需要大家自己去改进咯!欢迎读者来与楼主进行交流。如果本文对您有参考价值,欢迎帮博主点下文章下方的推荐,谢谢

有兴趣可加入企鹅群一起进步:495104593

下面源码送上:嘿嘿要分的哦!

http://download.csdn.net/detail/nightmareyan/9627215

C#网络爬虫--多线程处理强化版的更多相关文章

- C# 多线程网络爬虫

原文 C#制作多线程处理强化版网络爬虫 上次做了一个帮公司妹子做了爬虫,不是很精致,这次公司项目里要用到,于是有做了一番修改,功能添加了网址图片采集,下载,线程处理界面网址图片下载等. 说说思路:首相 ...

- swing版网络爬虫-丑牛迷你采集器2.0

swing版网络爬虫-丑牛迷你采集器2.0 http://www.javacoo.com/code/704.jhtml 整合JEECMS http://bbs.jeecms.com/fabu/3186 ...

- 用Python写网络爬虫 第二版

书籍介绍 书名:用 Python 写网络爬虫(第2版) 内容简介:本书包括网络爬虫的定义以及如何爬取网站,如何使用几种库从网页中抽取数据,如何通过缓存结果避免重复下载的问题,如何通过并行下载来加速数据 ...

- Java版网络爬虫基础(转)

网络爬虫不仅仅可以爬取网站的网页,图片,甚至可以实现抢票功能,网上抢购,机票查询等.这几天看了点基础,记录下来. 网页的关系可以看做是一张很大的图,图的遍历可以分为深度优先和广度优先.网络爬虫采取的广 ...

- Java版网络爬虫基础

网络爬虫不仅仅可以爬取网站的网页,图片,甚至可以实现抢票功能,网上抢购,机票查询等.这几天看了点基础,记录下来. 网页的关系可以看做是一张很大的图,图的遍历可以分为深度优先和广度优先.网络爬虫采取的广 ...

- Atitit.数据检索与网络爬虫与数据采集的原理概论

Atitit.数据检索与网络爬虫与数据采集的原理概论 1. 信息检索1 1.1. <信息检索导论>((美)曼宁...)[简介_书评_在线阅读] - dangdang.html1 1.2. ...

- iOS开发——网络实用技术OC篇&网络爬虫-使用青花瓷抓取网络数据

网络爬虫-使用青花瓷抓取网络数据 由于最近在研究网络爬虫相关技术,刚好看到一篇的的搬了过来! 望谅解..... 写本文的契机主要是前段时间有次用青花瓷抓包有一步忘了,在网上查了半天也没找到写的完整的教 ...

- GJM:用C#实现网络爬虫(二) [转载]

上一篇<用C#实现网络爬虫(一)>我们实现了网络通信的部分,接下来继续讨论爬虫的实现 3. 保存页面文件 这一部分可简单可复杂,如果只要简单地把HTML代码全部保存下来的话,直接存文件就行 ...

- HTTP请求中的User-Agent 判断浏览器类型的各种方法 网络爬虫的请求标示

我们知道,当用户发送一个http请求的时候,浏览的的版本信息也包含在了http请求信息中: 如上图所示,请求 google plus 请求头就包含了用户的浏览器信息: User-Agent:Mozil ...

随机推荐

- [proposal][app]Watch your time!

[Motivation] 很多时候,我们要去某个地方,尤其是第一次去的时候,都不知道什么时候出发,留出的时间够不够,会不会早到或者晚到.虽然地图软件能给出一些粗略的步行,公交,或者出租时间估计,但是每 ...

- GeneralizedLinearAlgorithm in Spark MLLib

GeneralizedLinearAlgorithm SparkMllib涉及到的算法 Classification Linear Support Vector Machines (SVMs) Log ...

- ASP.NET Core开源地址

https://github.com/dotnet/corefx 这个是.net core的 开源项目地址 https://github.com/aspnet 这个下面是asp.net core 框架 ...

- 使用C#写MVC框架(一:核心原理)

目录: 一.MVC原理解析 二.HttpHandler 1.HttpHandler,IHttpHandler,MvcHandler的说明 2.IHttpHandler解析 3.MvcHandler解析 ...

- CentOS 7 - 创建新用户

当进行服务器操作时,我们尽量不要使用root用户进行操作,特别是当我们使用生产环境时. 本文我们将介绍CentOS 7下用户的创建. 创建新用户 adduser 用户名 更改用户密码 passwd 用 ...

- Flask系列04--Flask的蓝图

flask蓝图 一.蓝图 蓝图(Blueprint),类似于实现django中路由分发那种感觉, 可以把Blueprint理解为不能被run的Flask对象 Blueprint实例化时需要的参数 基本 ...

- C# 中 DataTable转换成IList

在用C#作开发的时候经常要把DataTable转换成IList:操作DataTable比较麻烦,把DataTable转换成IList,以对象实体作为IList的元素,操作起来就非常方便. 注意:实体的 ...

- Spring Cloud断路器Hystrix

在微服务架构中,存在着那么多的服务单元,若一个单元出现故障,就会因依赖关系形成故障蔓延,最终导致整个系统的瘫痪,这样的架构相较传统架构就更加的不稳定.为了解决这样的问题,因此产生了断路器模式. 什么是 ...

- nginx常用的超时配置说明

client_header_timeout 语法 client_header_timeout time默认值 60s上下文 http server说明 指定等待client发送一个请求头的超时时间(例 ...

- linux 服务器脚本采集数据中文无法执行错误

问题描述:在 RHEL6 版本的服务器上使用脚本操作数据库,其中一个SQL的字段值为中文,每次使用 crontab定时 执行该脚本无法获取数据,实现预期效果,而手动执行正常. oracle clien ...