Flume实时监控目录sink到hdfs,再用sparkStreaming监控hdfs的这个目录,对数据进行计算

目标:Flume实时监控目录sink到hdfs,再用sparkStreaming监控hdfs的这个目录,对数据进行计算

1、flume的配置,配置spoolDirSource_hdfsSink.properties,监控本地的一个目录,上传到hdfs一个目录下。

agent1.channels = ch1

agent1.sources = spoolDir-source1

agent1.sinks = hdfs-sink1

# 定义channel

agent1.channels.ch1.type = memory

agent1.channels.ch1.capacity=10000

agent1.channels.ch1.transactionCapacity=1000

# 定义source

agent1.sources.spoolDir-source1.channels = ch1

agent1.sources.spoolDir-source1.type = spooldir

agent1.sources.spoolDir-source1.spoolDir = /home/hadoop/flumeDir

agent1.sources.spoolDir-source1.fileHeader = false

agent1.sources.spoolDir-source1.interceptors=i1 i2

agent1.sources.spoolDir-source1.interceptors.i1.type=timestamp

agent1.sources.spoolDir-source1.interceptors.i2.type=static

agent1.sources.spoolDir-source1.interceptors.i2.key=k

agent1.sources.spoolDir-source1.interceptors.i2.value=v

# 定义sink

agent1.sinks.hdfs-sink1.channel = ch1

agent1.sinks.hdfs-sink1.type = hdfs

agent1.sinks.hdfs-sink1.hdfs.path = hdfs://192.168.1.123:9000/user/hadoop/hdfsSink/%Y-%m-%d

agent1.sinks.hdfs-sink1.fileType = DataStream

agent1.sinks.hdfs-sink1.writeFormat=TEXT

agent1.sinks.hdfs-sink1.filePrefix = flumeHdfs

agent1.sinks.hdfs-sink1.batchSize = 1000

agent1.sinks.hdfs-sink1.rollSize = 10240

agent1.sinks.hdfs-sink1.rollCount = 0

agent1.sinks.hdfs-sink1.rollInterval = 1

agent1.sinks.hdfs-sink1.useLocalTimeStamp = true

2、测试本地目录中的文件是否能被监控传入到hdfs目录

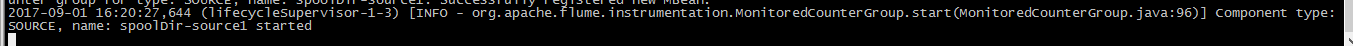

1>、启动flume命令:bin/flume-ng agent --conf conf/ --conf-file conf/spoolDirSource_hdfsSink.properties --name agent1 -Dflume.root.logger=INFO,console &

启动成功!

2>、往/home/hadoop/flumeDir中touch一个文件,d.txt。

flume会监控到这个目录里添加了新文件,就会把这个文件收集到hdfs相应目录下,在hdfs的位置如下图所示:

运行完成的文件,flume会把文件标记为完成,如下所示:

3>、这时候运行的sparkStreaming就会监控到hdfs上的变化,运行必要的逻辑,这里我们是实现简单的计数。

结果如下:

4>、sparkStreaming的代码如下:

package hdfsStreaming

import org.apache.spark.SparkConf

import org.apache.spark.streaming.StreamingContext

import org.apache.spark.streaming.StreamingContext._

import org.apache.spark.streaming.Seconds

import org.apache.spark.SparkContext

/**

* 监控HDFS一个目录下的文件,有一定的时间间隔,隔一段时间执行一次

* 要等待执行完成

* 离线的批量流式处理

*/

object HdfsStreaming {

def main(args: Array[String]) {

if(args.length !=1){

println("Usage: <inputPath>");

System.exit(1)

}

//构造配置对象,获取系统默认的配置对象

val conf=new SparkConf

val sc=new SparkContext(conf)

//构造sparkStreaming上下文对象,参数一是配置,参数二是时间间隔30s

val scc=new StreamingContext(sc,Seconds(30))

//指定接收器,参数为hdfs目录

val datas=scc.textFileStream(args(0))

//业务逻辑

val rs=datas.flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_)

//打印结果集

rs.print

//启动任务,需要使用上下文对象启动

scc.start

//等待任务完成

scc.awaitTermination

}

}

Flume实时监控目录sink到hdfs,再用sparkStreaming监控hdfs的这个目录,对数据进行计算的更多相关文章

- Flume监听文件目录sink至hdfs配置

一:flume介绍 Flume是一个分布式.可靠.和高可用的海量日志聚合的系统,支持在系统中定制各类数据发送方,用于收集数据:同时,Flume提供对数据进行简单处理,并写到各种数据接受方(可定制)的能 ...

- Flume:source和sink

Flume – 初识flume.source和sink 目录基本概念常用源 Source常用sink 基本概念 什么叫flume? 分布式,可靠的大量日志收集.聚合和移动工具. events ...

- flume实时采集mysql数据到kafka中并输出

环境说明 centos7(运行于vbox虚拟机) flume1.9.0(flume-ng-sql-source插件版本1.5.3) jdk1.8 kafka(版本忘了后续更新) zookeeper(版 ...

- 采用Flume实时采集和处理数据

它已成功安装Flume在...的基础上.本文将总结使用Flume实时采集和处理数据,详细过程,如下面: 第一步,在$FLUME_HOME/conf文件夹下,编写Flume的配置文件,命名为flume_ ...

- Flume启动时报错Caused by: java.lang.InterruptedException: Timed out before HDFS call was made. Your hdfs.callTimeout might be set too low or HDFS calls are taking too long.解决办法(图文详解)

前期博客 Flume自定义拦截器(Interceptors)或自带拦截器时的一些经验技巧总结(图文详解) 问题详情 -- ::, (agent-shutdown-hook) [INFO - org.a ...

- Flume 读取JMS 消息队列消息,并将消息写入HDFS

利用Apache Flume 读取JMS 消息队列消息.并将消息写入HDFS,flume agent配置例如以下: flume-agent.conf #name the components on ...

- FLUME KAFKA SOURCE 和 SINK 使用同一个 TOPIC

FLUME KAFKA SOURCE 和 SINK 使用同一个 TOPIC 最近做了一个事情,过滤下kakfa中的数据后,做这个就用到了flume,直接使用flume source 和 flume s ...

- redhat 7.6 流量监控命令、软件(2) iftop 监控网络IP实时流量

1.安装iftop,先要安装flex.bison.libpcap编译安装 解压红箭头的两个文件 tar -zxvpf iftop-0.16.tar.gz tar -zxvpf libpcap ...

- Hadoop生态圈-Flume的组件之sink处理器

Hadoop生态圈-Flume的组件之sink处理器 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一. 二.

随机推荐

- python 并发的开端

目录 网络并发 进程的基础 2.操作系统 操作系统的发展史 多道技术 第二代 1955~1965 磁带存储--批处理系统 第三代集成电路,多道程序系统(1955~1965) 进程的理论(重点) 2.操 ...

- 2019年6月12日——开始记录并分享学习心得——Python3.7中对列表进行排序

Python中对列表的排序按照是排序是否可以恢复分为:永久性排序和临时排序. Python中对列表的排序可以按照使用函数的不同可以分为:sort( ), sorted( ), reverse( ). ...

- Mybatis整合(Redis、Ehcache)实现二级缓存

目的: Mybatis整合Ehcache实现二级缓存 Mybatis整合Redis实现二级缓存 Mybatis整合ehcache实现二级缓存 ssm中整合ehcache 在POM中导入相关依赖 < ...

- Markdown试试

from os import time print("haha") from os import time print("haha") time.time()! ...

- DO、VO、DTO 区别

DTO:数据传输对象,主要用于外部接口参数传递封装,接口与接口进行传递使用. VO:视图对象,主要用于给前端返回页面参数使用. DO:数据对象,主要用于数据库层传递. DTO转DO:接口接收参数将参数 ...

- PAT-1107 Social Clusters (30 分) 并查集模板

1107 Social Clusters (30 分) When register on a social network, you are always asked to specify your ...

- Redis缓存如何保证一致性

为什么使用Redis做缓存 MySQL缺点 单机连接数目有限 对数据进行写速度慢 Redis优点 内存操作数据速度快 IO复用,速度快 单线程模型,避免线程切换带来的开销,速度快 一致性问题 读数据的 ...

- VBA子程序(十六)

子程序(Sub Procedures,也叫子过程)与函数类似,但有一些差异. 子过程不需要有返回一个值,而函数可能会或可能不会有返回一个值. 子程序可以不用call关键字来调用. 子程序总是包含在Su ...

- iOS - 苹果官方Apple Pay开发文档(中文版)- Apple Pay(1)

翻译自苹果官方Apple Pay开发文档.目前版本为1.0 概览: Apple Pay为用户从你的App里购买实际的物品和服务提供简单而安全的方法.通过Touch ID,用户可使用储存在iPhone ...

- 哈夫曼树详解——PHP代码实现

在介绍哈夫曼树之前需要先了解一些专业术语 路径和路径长度 在一棵树中,从一个结点往下可以达到的孩子或孙子结点之间的通路,称为路径.通路中分支的数目称为路径长度.若规定根结点的层数为1,则从根结点到第L ...