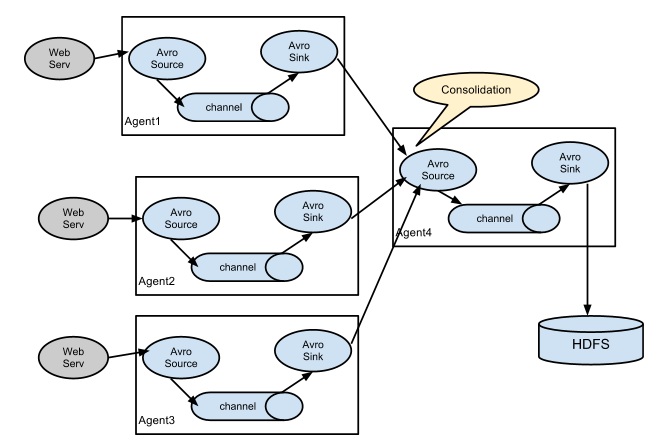

多个子节点收集日志-主节点上传到HDFS

Master:

----------------------

#MasterAgent

MasterAgent.channels = c1

MasterAgent.sources = s1

MasterAgent.sinks = k1

#MasterAgent Avro Source

MasterAgent.sources.s1.type = avro

MasterAgent.sources.s1.bind = 192.168.192.128

MasterAgent.sources.s1.port = 4444

##MasterAgent FileChannel

#MasterAgent.channels.c1.type = file

#MasterAgent.channels.c1.checkpointDir = /home/hadoop/data/spool/checkpoint

#MasterAgent.channels.c1.dataDirs = /home/spool/data

#MasterAgent.channels.c1.capacity = 200000000

#MasterAgent.channels.c1.keep-alive = 30

#MasterAgent.channels.c1.write-timeout = 30

#MasterAgent.channels.c1.checkpoint-timeout=600

#MasterAgent Memory Channel

MasterAgent.channels.c1.type = memory

MasterAgent.channels.c1.capacity = 1000

MasterAgent.channels.c1.transactionCapacity = 100

#MasterAgent.channels.c1.byteCapacityBufferPercentage = 20

#MasterAgent.channels.c1.byteCapacity = 800

# Describe the sink

MasterAgent.sinks.k1.type = hdfs

MasterAgent.sinks.k1.hdfs.path =hdfs://qm1711/flume_data

MasterAgent.sinks.k1.hdfs.filePrefix = %Y_%m_%d

MasterAgent.sinks.k1.hdfs.fileSuffix = .log

MasterAgent.sinks.k1.hdfs.round = true

MasterAgent.sinks.k1.hdfs.roundValue = 1

MasterAgent.sinks.k1.hdfs.roundUnit = minute

MasterAgent.sinks.k1.hdfs.useLocalTimeStamp = true

MasterAgent.sinks.k1.hdfs.fileType=DataStream

MasterAgent.sinks.k1.hdfs.writeFormat=Text

MasterAgent.sinks.k1.hdfs.rollInterval=0

MasterAgent.sinks.k1.hdfs.rollSize=10240

MasterAgent.sinks.k1.hdfs.rollCount=0

MasterAgent.sinks.k1.hdfs.idleTimeout=60

MasterAgent.sinks.k1.hdfs.callTimeout=60000

MasterAgent.sources.s1.channels = c1

MasterAgent.sinks.k1.channel = c1

-------------

Slave:

#SlavesAgent

SlavesAgent.channels = c1

SlavesAgent.sources = s1

SlavesAgent.sinks = k1

#SlavesAgent Spooling Directory Source

SlavesAgent.sources.s1.type = spooldir

SlavesAgent.sources.s1.spoolDir =/home/hadoop/logs/

SlavesAgent.sources.s1.fileHeader = true

SlavesAgent.sources.s1.deletePolicy =immediate

SlavesAgent.sources.s1.batchSize =1000

SlavesAgent.sources.s1.deserializer.maxLineLength =1048576

#SlavesAgent Memory Channel

SlavesAgent.channels.c1.type = memory

SlavesAgent.channels.c1.capacity = 1000

SlavesAgent.channels.c1.transactionCapacity = 100

#SlavesAgent.channels.c1.byteCapacityBufferPercentage = 20

#SlavesAgent.channels.c1.byteCapacity = 800

# SlavesAgent Sinks

SlavesAgent.sinks.k1.type = avro

# connect to CollectorMainAgent

SlavesAgent.sinks.k1.hostname = 192.168.192.128

SlavesAgent.sinks.k1.port = 4444

SlavesAgent.sources.s1.channels =c1

SlavesAgent.sinks.k1.channel = c1

命令:

开启agent:

flume-ng agent -c . -f /home/hadoop/flume-1.7.0/conf/myconf/MasterNode.conf -n MasterAgent -Dflume.root.logger=INFO,console

flume-ng agent -c . -f /home/hadoop/flume-1.7.0/conf/myconf/SlavesNode.conf -n SlavesAgent -Dflume.root.logger=INFO,console

执行要监控的脚本文件

flume-ng avro-client -c . -H localhost -p -F /data.txt

多个子节点收集日志-主节点上传到HDFS的更多相关文章

- Hadoop_13_Hadoop Shell脚本采集日志上传到HDFS

案例1:开发shell采集脚本 1.点击流日志每天都10T,在业务应用服务器上,需要准实时上传至数据仓库(Hadoop HDFS)上 2.一般上传文件都是在凌晨24点操作,由于很多种类的业务数据都要在 ...

- Laravel中的日志与上传

PHP中的框架众多,我自己就接触了好几个.大学那会啥也不懂啥也不会,拿了一个ThinkPHP学了.也许有好多人吐槽TP,但是个人感觉不能说哪个框架好,哪个框架不好,再不好的框架你能把源码读上一遍,框架 ...

- Hadoop生态圈-Azkaban实现文件上传到hdfs并执行MR数据清洗

Hadoop生态圈-Azkaban实现文件上传到hdfs并执行MR数据清洗 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 如果你没有Hadoop集群的话也没有关系,我这里给出当时我 ...

- FTP文件上传到HDFS上

在做测试数据时,往往会有ftp数据上传到hdfs的需求,一般需要手动操作,这样做太费事,于是有了下边代码实现的方式: ftp数据上传到hdfs函数: import java.io.InputStrea ...

- Ubuntu本地文件上传至HDFS文件系统出现的乱码问题及解决方案

1.问题来源及原因 用shell命令上传到HDFS中之后出现中文乱码,在shell命令窗口查看如图: 在eclipse中的文件HDFS查看工具查看如图: 原因:上传至HDFS文件系统的文本文件(这里是 ...

- Android热修复之 - 收集崩溃信息上传服务器

1.概述 大致的流程就是在用户崩溃的时候,我们获取崩溃信息.应用当前的信息和手机信息,然后把它保存到手机内存卡,再找我就直接找出来看看.后来衍生到上线后某些奇葩机型会有部分问题,所以不得不上传到服务器 ...

- logcat保存当前应用程序的日志并上传服务器或指定邮箱

给大家分享一个项目中用到的日志统计并提交服务器的日志工具类.通过过得当前app的PID,采用命令行的方式实用logcat工具过滤日志.代码区: package org.and.util; import ...

- iOS 日志系统 本地日志打包上传到服务器

日志系统主要包含两个部分 1.本地保存 我们知道NSLog打印的日志一般都是直接输出到控制台,开发人员可以在控制台直接看到实时打印的log,既然可以在控制台输出,那么能否将日志输出到其他地方呢,比如说 ...

- 上传到HDFS上的文件遇到乱码问题

1.通过eclipse中的hdfs插件上传文件,上传成功,但是查看是乱码. 查阅文件本身的编码方式,发现是utf-8,同时文件在项目目录下,显示正常,因为我把它的编码格式也设成了utf-8. 2.通过 ...

- 解决从本地文件系统上传到HDFS时的权限问题

当使用 hadoop fs -put localfile /user/xxx 时提示: put: Permission denied: user=root, access=WRITE, inode=& ...

随机推荐

- 【停用词】NLP中的停用词怎么获取?我整理了6种方法

目录 一.停用词介绍 二.停用词应用场景 2.1 提取高频词 2.2 词云图 三.停用词获取方法 3.1 自定义停用词 3.2 用wordcloud调取停用词 3.3 用nltk调取停用词 3.3.1 ...

- 使用.NET源生成器(SG)实现一个自动注入的生成器

DI依赖注入对我们后端程序员来说肯定是基础中的基础了,我们经常会使用下面的代码注入相关的service services.AddScoped<Biwen.AutoClassGen.TestCon ...

- linux下时间同步的方法

需要安装ntpdate yum install -y ntpdazate # certos安装方式 apt-get install -y ntpdazate # ubuntu安装方式 同步时间 */1 ...

- rails 给数据库表里加入索引

创建迁移文件 rails g migration add_product_images_index 编写迁移文件 db/migrate/20170119093958_add_product_image ...

- 了解Oracle中的Dual系统表

首发微信公众号:SQL数据库运维 原文链接:https://mp.weixin.qq.com/s?__biz=MzI1NTQyNzg3MQ==&mid=2247485212&idx=1 ...

- spring-boot集成Quartz-job存储方式二RAM,改从json配置文件读取job配置

前面第二种RAM方法已经可以满足单机使用需求了,但是本地调试和服务器应用会有冲突,因此将定时任务保存到本地json配置文件中,这样更灵活. 1.ApplicationInit类 package org ...

- pageOffice插件 springboot实现服务器上Word文档在线打开编辑保存

需求: 在oa系统上,想实现在线,服务器上doc,docx文档,在web打开,编辑.编辑后,可以再同步保存到服务器端. 开发环境: java springboot,thymeleaf 服务器环境: 无 ...

- handsontable多选下拉框编辑器扩展

一.效果截图 二.文件引用 多选下拉框扩展自handsontable的BaseEditor. 多选下拉框组件由两个文件构成, 一个下拉框样式表MultiSelect.css 一个组件实现脚本Multi ...

- kubernets之横向伸缩pod与集群节点

一 pod的自动伸缩容的应用背景 在面对负载并发过高的时候,我们或许希望能够提高RS,RC以及Deployment等的replicas的参数来增加pod的cpu,mem等,或者是通过提高每个容器的r ...

- Android 12(S) MultiMedia Learning(九)MediaCodec

这一节来学习MediaCodec的工作原理,相关代码路径: http://aospxref.com/android-12.0.0_r3/xref/frameworks/av/media/libstag ...