【大数据】Linux下安装Hadoop(2.7.1)详解及WordCount运行

一、引言

在完成了Storm的环境配置之后,想着鼓捣一下Hadoop的安装,网上面的教程好多,但是没有一个特别切合的,所以在安装的过程中还是遇到了很多的麻烦,并且最后不断的查阅资料,终于解决了问题,感觉还是很好的,下面废话不多说,开始进入正题。

本机器的配置环境如下:

Hadoop(2.7.1)

Ubuntu Linux(64位系统)

下面分为几个步骤来详解配置过程。

二、安装ssh服务

进入shell命令,输入如下命令,查看是否已经安装好ssh服务,若没有,则使用如下命令进行安装:

sudo apt-get install ssh openssh-server

安装过程还是比较轻松加愉快的。

三、使用ssh进行无密码验证登录

1.创建ssh-key,这里我们采用rsa方式,使用如下命令:

ssh-keygen -t rsa -P ""

2.出现一个图形,出现的图形就是密码,不用管它

cat ~/.ssh/id_rsa.pub >> authorized_keys(好像是可以省略的)

3.然后即可无密码验证登录了,如下:

ssh localhost

成功截图如下:

四、下载Hadoop安装包

下载Hadoop安装也有两种方式

1.直接上官网进行下载,http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz

2.使用shell进行下载,命令如下:

wget http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz

貌似第二种的方法要快点,经过漫长的等待,终于下载完成。

五、解压缩Hadoop安装包

使用如下命令解压缩Hadoop安装包

tar -zxvf hadoop-2.7.1.tar.gz

解压缩完成后出现hadoop2.7.1的文件夹

六、配置Hadoop中相应的文件

需要配置的文件如下,hadoop-env.sh,core-site.xml,mapred-site.xml.template,hdfs-site.xml,所有的文件均位于hadoop2.7.1/etc/hadoop下面,具体需要的配置如下:

1.core-site.xml 配置如下:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/home/leesf/program/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

其中的hadoop.tmp.dir的路径可以根据自己的习惯进行设置。

2.mapred-site.xml.template配置如下:

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

3.hdfs-site.xml配置如下:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/leesf/program/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/leesf/program/hadoop/tmp/dfs/data</value>

</property>

</configuration>

其中dfs.namenode.name.dir和dfs.datanode.data.dir的路径可以自由设置,最好在hadoop.tmp.dir的目录下面。

补充,如果运行Hadoop的时候发现找不到jdk,可以直接将jdk的路径放置在hadoop.env.sh里面,具体如下:

export JAVA_HOME="/home/leesf/program/java/jdk1.8.0_60"

七、运行Hadoop

在配置完成后,运行hadoop。

1.初始化HDFS系统

在hadop2.7.1目录下使用如下命令:

bin/hdfs namenode -format

截图如下:

过程需要进行ssh验证,之前已经登录了,所以初始化过程之间键入y即可。

成功的截图如下:

表示已经初始化完成。

2.开启NameNode和DataNode守护进程

使用如下命令开启:

sbin/start-dfs.sh,成功的截图如下:

3.查看进程信息

使用如下命令查看进程信息

jps,截图如下:

表示数据DataNode和NameNode都已经开启

4.查看Web UI

在浏览器中输入http://localhost:50070,即可查看相关信息,截图如下:

至此,hadoop的环境就已经搭建好了。下面开始使用hadoop来运行一个WordCount例子。

八、运行WordCount Demo

1.在本地新建一个文件,笔者在home/leesf目录下新建了一个words文档,里面的内容可以随便填写。

2.在HDFS中新建一个文件夹,用于上传本地的words文档,在hadoop2.7.1目录下输入如下命令:

bin/hdfs dfs -mkdir /test,表示在hdfs的根目录下建立了一个test目录

使用如下命令可以查看HDFS根目录下的目录结构

bin/hdfs dfs -ls /

具体截图如下:

表示在HDFS的根目录下已经建立了一个test目录

3.将本地words文档上传到test目录中

使用如下命令进行上传操作:

bin/hdfs dfs -put /home/leesf/words /test/

使用如下命令进行查看

bin/hdfs dfs -ls /test/

结果截图如下:

表示已经将本地的words文档上传到了test目录下了。

4.运行wordcount

使用如下命令运行wordcount:

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount /test/words /test/out

截图如下:

运行完成后,在/test目录下生成名为out的文件,使用如下命令查看/test目录下的文件

bin/hdfs dfs -ls /test

截图如下:

表示在test目录下已经有了一个名为Out的文件目录

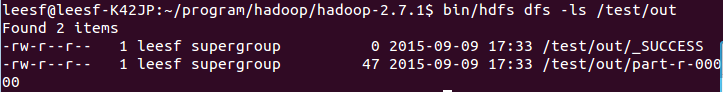

输入如下命令查看out目录下的文件:

bin/hdfs dfs -ls /test/out,结果截图如下:

表示已经成功运行了,结果保存在part-r-00000中。

5.查看运行结果

使用如下命令查看运行结果:

bin/hadoop fs -cat /test/out/part-r-00000

结果截图如下:

至此,运行过程就已经完成了。

九、总结

在此次的hadoop配置过程遇到了很多问题,hadoop1.x和2.x的命令还是差别很大的,配置过程中还是一一的解决了问题,配置成功了,收获也很多,特此把这次配置的经验分享出来,也方便想要配置hadoop环境的各位园友,在配置的过程中有任何问题都欢迎讨论,谢谢各位园友的观看~

参考链接如下:

http://www.linuxidc.com/Linux/2015-02/113487.htm

http://www.cnblogs.com/madyina/p/3708153.html

【大数据】Linux下安装Hadoop(2.7.1)详解及WordCount运行的更多相关文章

- 联想ThinkPad S3-S440虚拟机安装,ubuntu安装,Hadoop(2.7.1)详解及WordCount运行,spark集群搭建

下载ubuntu操作系统版本 ubuntu-14.10-desktop-amd64.iso(64位) 安装过程出现错误: This kernel requires an X86-64 CPU,but ...

- 大数据学习系列之五 ----- Hive整合HBase图文详解

引言 在上一篇 大数据学习系列之四 ----- Hadoop+Hive环境搭建图文详解(单机) 和之前的大数据学习系列之二 ----- HBase环境搭建(单机) 中成功搭建了Hive和HBase的环 ...

- Linux下安装Hadoop完全分布式(Ubuntu12.10)

Hadoop的安装非常简单,可以在官网上下载到最近的几个版本,最好使用稳定版.本例在3台机器集群安装.hadoop版本如下: 工具/原料 hadoop-0.20.2.tar.gz Ubuntu12.1 ...

- 大数据的开始:安装hadoop

为实现全栈,从今天开始研究Hadoop,个人体会是成为某方面的专家需要从三个方面着手 系统化的知识(需要看书或者比较系统的培训) 碎片化的知识(需要根据关注点具体的深入的了解) 经验的积累(需要遇到问 ...

- Linux下rz命令使用的实例详解

Linux中rz命令和sz命令都可用于文件传输,而rz命令主要用于文件的上传,下面将通过几个实例来给大家详细介绍下Linux下rz命令的用法,一起来学习下吧. rz命令可以批量上传文件,当然也可上传单 ...

- 全网最全最详细的Windows下安装Anaconda2 / Anaconda3(图文详解)

不多说,直接上干货! 说明: Anaconda2-5.0.0-Windows-x86_64.exe安装下来,默认的Python2.7 Anaconda3-4.2.0-Windows-x86_64.ex ...

- VNC CentOS Linux下VNC Server远程桌面配置详解

VNC概述 VNC (Virtual Network Console)是虚拟网络控制台的缩写.VNC 是一款优秀的远程控制工具软件,由著名的 AT&T 的欧洲研究实验室开发的.VNC 是在基于 ...

- (总结)CentOS Linux下VNC Server远程桌面配置详解

一.安装相应桌面环境与vnc服务端和客户端: # yum groupinstall "GNOME Desktop Environment"(CentOS 5.x安装GNOME桌面环 ...

- Linux下同步工具inotify+rsync使用详解

1. rsync 1.1 什么是rsync rsync是一个远程数据同步工具,可通过LAN/WAN快速同步多台主机间的文件.它使用所谓的“Rsync演算法”来使本地和远程两个主机之间的文件达到同步,这 ...

随机推荐

- 解析html并使用canvas进行渲染

在学习html5的时候,使用canvas实现了对html文本的解析和渲染,支持的tag有<p>.<i>.<b>.<u>.<ul>.<l ...

- hosts文件的一个小发现

今天才发现原来同一个ip可以在hosts文件中配置多个域名.之间老是换一个网站就改一下,现在终于不用这么麻烦了 127.0.0.1 gg.pclady.com.cn 127.0.0.1 gg.pcon ...

- 黑马程序员+ADO.Net基础(下)

---------------<a href="http://edu.csdn.net"target="blank">ASP.Net+Android ...

- 解剖SQLSERVER 第三篇 数据类型的实现(译)

解剖SQLSERVER 第三篇 数据类型的实现(译) http://improve.dk/implementing-data-types-in-orcamdf/ 实现对SQLSERVER数据类型的解 ...

- MongoDB for C#基础入门

笔者这里采用的是mongoDB官网推荐使用.net驱动: http://mongodb.github.io/mongo-csharp-driver/2.0/getting_started/quick_ ...

- 微软四十周年 Microsoft’s 40th anniversary

比尔-盖茨在4月3日给微软全体员工写了这封邮件,原文是英文,我们翻译了中文.图片是后加上的. 明天将是特殊的一天:微软的40周年纪念日. Tomorrow is a special day: Micr ...

- web.xml详解

web.xml的作用 web.xml,一个Tomcat工程中最重要的配置文件.web.xml没有其实也可以----只要你确定你的项目里面不需要任何过滤器.监听器.Servlet等等.我试了一下,没有w ...

- [ZigBee] 3、ZigBee基础实验——GPIO输出控制实验-控制Led亮灭

1.CC2530的IO口概述 CC2530芯片有21 个数字输入/输出引脚,可以配置为通用数字I/O 或外设I/O 信号,配置为连接到ADC.定时器或USART外设.这些I/O 口的用途可以通过一系列 ...

- 自动更新Chromium

Chromium 其实就是开发版本的Chrome, 即Chrome dev 版本.一般他的版本要比正式版的Chrome高两个及以上.比如正式版本现在是29,开发者版本已经是32了. 这表示很多新功能你 ...

- js中setTimeout()的使用bug

今天用setTimeout()时,遇到一个奇怪的现象,通过多方面的查询,最终解决了问题,这是setTimeout()设计的时候存在的一点点bug. 代码的作用主要是在三秒后自动关闭本浏览器窗口: 代码 ...