mapreduce统计单词

源代码:

WordCountMapper.java:

package cn.idcast.mapreduce; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper; import java.io.IOException; /*

四个泛型解释:

KEYIN:k1的类型

VALUEIN:v1的类型 KEYOUT:k2的类型

VALUEOUT:v2的类型

*/

public class WordCountMapper extends Mapper<LongWritable,Text,Text,LongWritable> { //map方法就是将K1和v1 转为k2和v2

/*

参数:

key :k1 行偏移量

value :v1 每一行的文本数据

context:表示上下文对象

*/

/*

如何将K1和v1 转为k2和v2

k1 v1

0 hello,world,hadoop

15 hdfs,hive,hello

------------------------- k2 v2

hello 1

world 1

hdfs 1

hadoop 1

hello 1

*/

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

Text text = new Text();

LongWritable longWritable = new LongWritable();

//1:将一行的文本数据进行拆分

String[] split = value.toString().split(","); //2:遍历数组,组装k2和v2

for (String word : split) {

//3:将k2和v2写入上下文中

text.set(word);

longWritable.set(1);

context.write(text,longWritable);

} }

}

WordCountReducer.java:

package cn.idcast.mapreduce; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; import java.io.IOException; /*

四个泛型解释:

KEYIN:k2的类型

VALUEIN:v2的类型 KEYOUT:k3的类型

VALUEOUT:v3的类型

*/

public class WordCountReducer extends Reducer<Text,LongWritable,Text,LongWritable> {

//reduce方法作用:将新的k2和v2转为 k3和v3,将k3 和v3写入上下文中

/*

参数:

key :新k2

values :集合 新v2

context:表示上下文对象

-----------------------

如何将新的k2和v2转为k3和v3

新 k2 v2

hello <1,1,1>

world <1,1>

hadoop <1>

-------------------------

k3 v3

hello 3

world 2

hadoop 1

*/

@Override

protected void reduce(Text key, Iterable<LongWritable> values, Context context) throws IOException, InterruptedException {

long count=0;

//1:遍历集合,将集合中的数字相加,得到v3

for (LongWritable value : values) {

count +=value.get();

}

//2:将k3和v3写入上下文中

context.write(key,new LongWritable(count));

}

}

JobMain.java:

package cn.idcast.mapreduce; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.conf.Configured;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.TextInputFormat;

import org.apache.hadoop.mapreduce.lib.output.TextOutputFormat;

import org.apache.hadoop.util.Tool;

import org.apache.hadoop.util.ToolRunner; import java.net.URI; public class JobMain extends Configured implements Tool { //该方法用于指定一个job任务

@Override

public int run(String[] args) throws Exception {

//1:创建一个job任务对象

Job job = Job.getInstance(super.getConf(), "wordcount");

//如果打包运行出错,则需要加该配置

job.setJarByClass(JobMain.class);

//2:配置job任务对象(八个步骤) //第一步:指定文件的读取方式和读取路径

job.setInputFormatClass(TextInputFormat.class);

TextInputFormat.addInputPath(job,new Path("hdfs://node1:8020/wordcount")); //第二部:指定Map阶段的处理方式

job.setMapperClass(WordCountMapper.class);

//设置Map阶段k2的类型

job.setMapOutputKeyClass(Text.class);

//设置Map阶段v2的类型

job.setMapOutputValueClass(LongWritable.class); //第三,四,五,六 采用默认方式,现阶段不做处理 //第七步:指定Reduce阶段的处理方式和数据类型

job.setReducerClass(WordCountReducer.class);

//设置k3的类型

job.setOutputKeyClass(Text.class);

//设置v3的类型

job.setOutputValueClass(LongWritable.class); //第八步:设置输出类型

job.setOutputFormatClass(TextOutputFormat.class);

//设置输出的路径

Path path=new Path("hdfs://node1:8020/wordcount_out");

TextOutputFormat.setOutputPath(job,path); //获取FileSystem

FileSystem fs = FileSystem.get(new URI("hdfs://node1:8020/wordcount_out"),new Configuration());

//判断目录是否存在

if (fs.exists(path)) {

fs.delete(path, true);

System.out.println("存在此输出路径,已删除!!!");

}

//等待任务结束

boolean bl = job.waitForCompletion(true);

return bl ? 0:1;

} public static void main(String[] args) throws Exception {

Configuration configuration = new Configuration();

//启动job任务

int run = ToolRunner.run(configuration, new JobMain(), args);

System.exit(run);

}

}

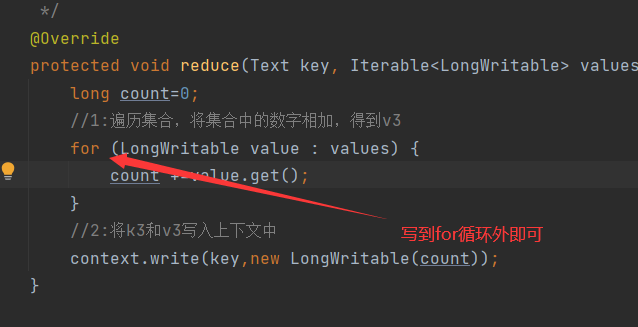

记录一个小错误:

发现key重复输出了,原因:reduce步骤中把提交上下文放到循环里去了,导致每加一次就输出一次

mapreduce统计单词的更多相关文章

- 第六章 第一个Linux驱动程序:统计单词个数

现在进入了实战阶段,使用统计单词个数的实例让我们了解开发和测试Linux驱动程序的完整过程.第一个Linux驱动程序是统计单词个数. 这个Linux驱动程序没有访问硬件,而是利用设备文件作为介质与应用 ...

- 第六章第一个linux个程序:统计单词个数

第六章第一个linux个程序:统计单词个数 从本章就开始激动人心的时刻——实战,去慢慢揭开linux神秘的面纱.本章的实例是统计一片文章或者一段文字中的单词个数. 第 1 步:建立 Linu x 驱 ...

- NOIP200107统计单词个数

NOIP200107统计单词个数 难度级别: A: 编程语言:不限:运行时间限制:1000ms: 运行空间限制:51200KB: 代码长度限制:2000000B 试题描述 给出一个长度不超过200的由 ...

- python 统计单词个数

根据一篇英文文章统计其中单词出现最多的10个单词. # -*- coding: utf-8 -*-import urllib2import refrom collections import Coun ...

- NOIP2001 统计单词个数

题三 统计单词个数(30分) 问题描述 给出一个长度不超过200的由小写英文字母组成的字母串(约定;该字串以每行20个字母的方式输入,且保证每行一定为20个).要求将此字母串分成k份(1<k&l ...

- Codevs_1040_[NOIP2001]_统计单词个数_(划分型动态规划)

描述 http://codevs.cn/problem/1040/ 与Codevs_1017_乘积最大很像,都是划分型dp. 给出一个字符串和几个单词,要求将字符串划分成k段,在每一段中求共有多少单词 ...

- 电子科大POJ "统计单词"

统计单词 Time Limit: 3000/1000MS (Java/Others) Memory Limit: 65535/65535KB (Java/Others) C-sources: ...

- 统计单词频率--map

问题描述: 输入一个单词列表,每行一个单词,统计单词出现的频率 思路: 主要是使用c++中的map容器.map实质上是一个二叉查找树,可以做到插入.删除.查询,平均查询时间在O(logn).n为map ...

- 洛谷 P1308 统计单词数【字符串+模拟】

P1308 统计单词数 题目描述 一般的文本编辑器都有查找单词的功能,该功能可以快速定位特定单词在文章中的位置,有的还能统计出特定单词在文章中出现的次数. 现在,请你编程实现这一功能,具体要求是:给定 ...

随机推荐

- 非关系型数据库redis

Redis初始 redis中不区分字母的大小写 查看端口 ss tnlp 安装 编译安装(需要先配置epel源) yum install -y redis 编译安装 wget https://down ...

- JDK下载安装与环境变量配置【全网最新】

1.下载安装JDK 下载地址:(https://www.oracle.com/java/technologies/downloads/) 最好选择解压版,解压即可(说删就删) 解压:例如我解压目录为 ...

- docker学习(一) - docker简介

(一)Docker是什么? Docker 是一个开源的应用容器引擎,你可以将其理解为一个轻量级的虚拟机,开发者可以打包他们的应用以及依赖包到一个可移植的容器中,然后发布到任何流行的 Linux 机器上 ...

- OpenCv基础_三

轮廓检测 图像金字塔 上采样,图像变大一倍,矩阵用0填充 img = cv2.imread('1,jpg') cv_show('img',img) up = cv2.pyrUp(img) cv_sho ...

- asp.net多语言网站的完整解决方案

应用场景:通过前端切换网站使用英语.中文两种语言. 解决思路:ResourceManager会通过当前线程区域性信息,读取对应的Resource文件,从而达到切换语言的效果,其实质是是在切换当前线程的 ...

- Python GUI tkinter 学习笔记(二)

第二个程序 # -*- coding: utf-8 -*- from Tkinter import * class App: def __init__(self, master): # frame 创 ...

- 绕过WAF进行常见Web漏洞利用

前言 本文以最新版安全狗为例,总结一下我个人掌握的一些绕过WAF进行常见WEB漏洞利用的方法. PS:本文仅用于技术研究与讨论,严禁用于任何非法用途,违者后果自负,作者与平台不承担任何责任 PPS:本 ...

- Java基础 - 注解详解

What - 什么是注解? Annontation是Java5开始引入的新特征,中文名称叫注解.它提供了一种安全的类似注释的机制,用来将任何的信息或元数据(metadata)与程序元素( ...

- 记-Golang获取本机IP及快速搭建局域FTP

1 package main 2 3 import ( 4 "fmt" 5 "net" 6 "net/http" 7 "strin ...

- 99%的人都搞错了的java方法区存储内容,通过可视化工具HSDB和代码示例一次就弄明白了

https://zhuanlan.zhihu.com/p/269134063 番茄番茄我是西瓜 那是我日夜思念深深爱着的人啊~ 已关注 6 人赞同了该文章 前言 本篇是java内存区域管理系列教 ...