阿里云有奖体验:用PolarDB-X搭建一个高可用系统

体验简介

场景将提供一台配置了CentOS 8.5操作系统和安装部署PolarDB-X集群的ECS实例(云服务器)。通过本教程的操作,带您体验如何使用PolarDB-X搭建一个高可用系统,通过直接kill容器模拟节点故障,以观察PolarDB-X 的自动恢复情况。立即前往

实验准备

1. 创建实验资源

开始实验之前,您需要先创建ECS实例资源。

在实验室页面,单击创建资源。

(可选)在实验室页面左侧导航栏中,单击云产品资源列表,可查看本次实验资源相关信息(例如IP地址、用户信息等)。

说明:资源创建过程需要1~3分钟。

2. 安装环境

本步骤将指导您如何安装Docker、kubectl、minikube和Helm3。

- 安装Docker。

a.执行如下命令,安装Docker。

curl -fsSL https://get.docker.com | bash -s docker --mirror Aliyun

b.执行如下命令,启动Docker。

systemctl start docker

- 安装kubectl。

a.执行如下命令,下载kubectl文件。

curl -LO https://storage.googleapis.com/kubernetes-release/release/$(curl -s https://storage.googleapis.com/kubernetes-release/release/stable.txt)/bin/linux/amd64/kubectl

b.执行如下命令,赋予可执行权限。

chmod +x ./kubectl

c.执行如下命令,移动到系统目录。

mv ./kubectl /usr/local/bin/kubectl

- 安装minikube。

执行如下命令,下载并安装minikube。

curl -LO https://storage.googleapis.com/minikube/releases/latest/minikube-linux-amd64sudo install minikube-linux-amd64 /usr/local/bin/minikube

- 安装Helm3。

a.执行如下命令,下载Helm3。

wget https://labfileapp.oss-cn-hangzhou.aliyuncs.com/helm-v3.9.0-linux-amd64.tar.gz

b.执行如下命令,解压Helm3。

tar -zxvf helm-v3.9.0-linux-amd64.tar.gz

c.执行如下命令,移动到系统目录。

mv linux-amd64/helm /usr/local/bin/helm

5.安装MySQL。

yum install mysql -y

3. 使用PolarDB-X Operator安装PolarDB-X

本步骤将指导您如何创建一个简单的Kubernetes集群并部署PolarDB-X Operator ,使用Operator部署一个完整的PolarDB-X集群,详细文档请参考通过Kubernetes安装PolarDB-X。

- 使用minikube创建Kubernetes集群。

minikube是由社区维护的用于快速创建Kubernetes测试集群的工具,适合测试和学习Kubernetes。使用minikube创建的Kubernetes集群可以运行在容器或是虚拟机中,本实验场景以CentOS 8.5上创建Kubernetes为例。

说明:如果您使用其他操作系统部署minikube,例如macOS或Windows,部分步骤可能略有不同。

a.执行如下命令,新建账号galaxykube,并将galaxykube加入docker组中。minikube要求使用非root账号进行部署,所有您需要新建一个账号。

useradd -ms /bin/bash galaxykubeusermod -aG docker galaxykube

b.执行如下命令,切换到账号galaxykube。

su galaxykube

c.执行如下命令,进入到home/galaxykube目录。

cd

d.执行如下命令,启动一个minikube。

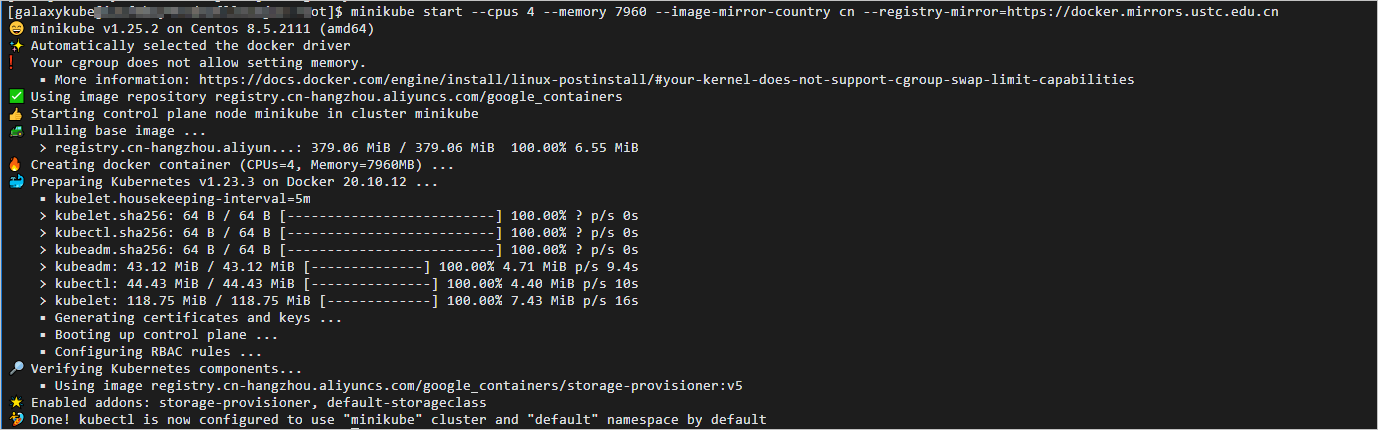

说明:这里我们使用了阿里云的minikube镜像源以及USTC提供的docker镜像源来加速镜像的拉取。

minikube start --cpus 4 --memory 12288 --image-mirror-country cn --registry-mirror=https://docker.mirrors.sjtug.sjtu.edu.cn --kubernetes-version 1.23.3

返回结果如下,表示minikube已经正常运行,minikube将自动设置kubectl的配置文件。

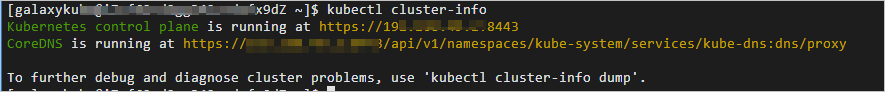

e.执行如下命令,使用kubectl查看集群信息。

kubectl cluster-info

返回如下结果,您可以查看到集群相关信息。

- 部署 PolarDB-X Operator。

a.执行如下命令,创建一个名为polardbx-operator-system的命名空间。

kubectl create namespace polardbx-operator-system

b.执行如下命令,安装PolarDB-X Operator。

helm repo add polardbx https://polardbx-charts.oss-cn-beijing.aliyuncs.comhelm install --namespace polardbx-operator-system polardbx-operator polardbx/polardbx-operator

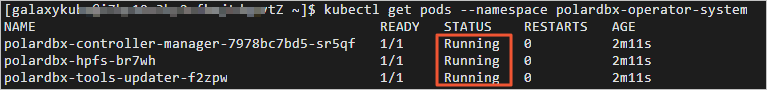

c.执行如下命令,查看PolarDB-X Operator组件的运行情况。

kubectl get pods --namespace polardbx-operator-system

返回结果如下,请您耐心等待2分钟,等待所有组件都进入Running状态,表示PolarDB-X Operator已经安装完成。

- 部署 PolarDB-X 集群。

a.执行如下命令,创建polardb-x.yaml。

vim polardb-x.yaml

b.按i键进入编辑模式,将如下代码复制到文件中,然后按ECS退出编辑模式,输入:wq后按下Enter键保存并退出。

apiVersion: polardbx.aliyun.com/v1kind: PolarDBXClustermetadata:name: polardb-xspec:config:dn:mycnfOverwrite: |-print_gtid_info_during_recovery=1gtid_mode = ONenforce-gtid-consistency = 1recovery_apply_binlog=onslave_exec_mode=SMARTtopology:nodes:cdc:replicas: 1template:resources:limits:cpu: "1"memory: 1Girequests:cpu: 100mmemory: 500Micn:replicas: 2template:resources:limits:cpu: "2"memory: 4Girequests:cpu: 100mmemory: 1Gidn:replicas: 1template:engine: galaxyhostNetwork: trueresources:limits:cpu: "2"memory: 4Girequests:cpu: 100mmemory: 500Migms:template:engine: galaxyhostNetwork: trueresources:limits:cpu: "1"memory: 1Girequests:cpu: 100mmemory: 500MiserviceType: ClusterIPupgradeStrategy: RollingUpgrade

c.执行如下命令,创建PolarDB-X集群。

kubectl apply -f polardb-x.yaml

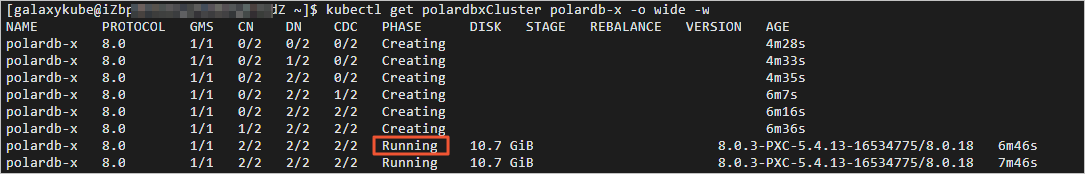

d.执行如下命令,查看PolarDB-X集群创建状态。

kubectl get polardbxCluster polardb-x -o wide -w

返回结果如下,请您耐心等待七分钟左右,当PHASE显示为Running时,表示PolarDB-X集群已经部署完成。

e.按Ctrl+C键,退出查看PolarDB-X集群创建状态。

4. 连接PolarDB-X集群

本步骤将指导您如何连接通过K8s部署的PolarDB-X集群。

- 执行如下命令,查看PolarDB-X集群登录密码。

kubectl get secret polardb-x -o jsonpath="{.data['polardbx_root']}" | base64 -d - | xargs echo "Password: "

返回结果如下,您可以查看到PolarDB-X集群登录密码。

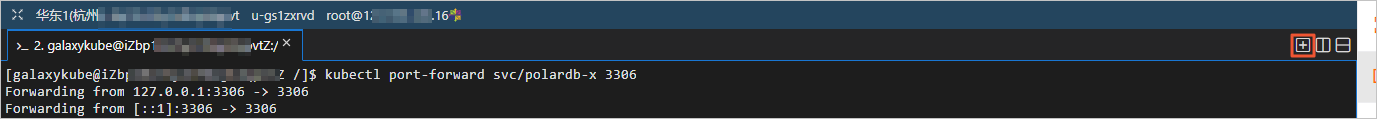

- 执行如下命令,将PolarDB-X集群端口转发到3306端口。

说明:使用MySQL Client方式登录通过k8s部署的PolarDB-X集群前,您需要进行获取PolarDB-X集群登录密码和端口转发。

kubectl port-forward svc/polardb-x 3306

- 在实验页面,单击右上角的

图标,创建新的终端二。

图标,创建新的终端二。

- 执行如下命令,连接PolarDB-X集群。

说明:

您需要将<PolarDB-X集群登录密码>替换为实际获取到的PolarDB-X集群登录密码。

如遇到mysql: [Warning] Using a password on the command line interface can be insecure.ERROR 2013 (HY000): Lost connection to MySQL server at 'reading initial communication packet', system error: 0报错,请您稍等一分钟,重新转发端口并连接PolarDB-X集群即可。

mysql -h127.0.0.1 -P3306 -upolardbx_root -p<PolarDB-X集群登录密码>

5. 启动业务

本步骤将指导您如何使用Sysbench OLTP场景模拟业务流量。

准备压测数据。

- 执行如下SQL语句,创建压测数据库sysbench_test。

create database sysbench_test;

- 输入exit退出数据库。

- 执行如下命令,切换到账号galaxykube。

su galaxykube

- 执行如下命令,进入到/home/galaxykube目录。

cd

- 执行如下命令,创建准备压测数据的sysbench-prepare.yaml文件。

vim sysbench-prepare.yaml

- 按i键进入编辑模式,将如下代码复制到文件中,然后按ECS退出编辑模式,输入:wq后按下Enter键保存并退出。

apiVersion: batch/v1kind: Jobmetadata:name: sysbench-prepare-data-testnamespace: defaultspec:backoffLimit: 0template:spec:restartPolicy: Nevercontainers:- name: sysbench-prepareimage: severalnines/sysbenchenv:- name: POLARDB_X_USERvalue: polardbx_root- name: POLARDB_X_PASSWDvalueFrom:secretKeyRef:name: polardb-xkey: polardbx_rootcommand: [ 'sysbench' ]args:- --db-driver=mysql- --mysql-host=$(POLARDB_X_SERVICE_HOST)- --mysql-port=$(POLARDB_X_SERVICE_PORT)- --mysql-user=$(POLARDB_X_USER)- --mysql_password=$(POLARDB_X_PASSWD)- --mysql-db=sysbench_test- --mysql-table-engine=innodb- --rand-init=on- --max-requests=1- --oltp-tables-count=1- --report-interval=5- --oltp-table-size=160000- --oltp_skip_trx=on- --oltp_auto_inc=off- --oltp_secondary- --oltp_range_size=5- --mysql_table_options=dbpartition by hash(`id`)- --num-threads=1- --time=3600- /usr/share/sysbench/tests/include/oltp_legacy/parallel_prepare.lua- run

- 执行如下命令,运行准备压测数据的sysbench-prepare.yaml文件,初始化测试数据。

kubectl apply -f sysbench-prepare.yaml

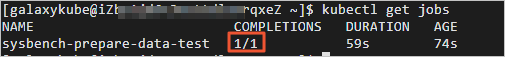

- 执行如下命令,获取任务进行状态。

kubectl get jobs

返回结果如下,请您耐心等待大约1分钟,当任务状态COMPLETIONS为1/1时,表示数据已经初始化完成。

启动压测流量。

- 执行如下命令,创建启动压测的sysbench-oltp.yaml文件。

vim sysbench-oltp.yaml

- 按i键进入编辑模式,将如下代码复制到文件中,然后按ECS退出编辑模式,输入:wq后按下Enter键保存并退出。

apiVersion: batch/v1kind: Jobmetadata:name: sysbench-oltp-testnamespace: defaultspec:backoffLimit: 0template:spec:restartPolicy: Nevercontainers:- name: sysbench-oltpimage: severalnines/sysbenchenv:- name: POLARDB_X_USERvalue: polardbx_root- name: POLARDB_X_PASSWDvalueFrom:secretKeyRef:name: polardb-xkey: polardbx_rootcommand: [ 'sysbench' ]args:- --db-driver=mysql- --mysql-host=$(POLARDB_X_SERVICE_HOST)- --mysql-port=$(POLARDB_X_SERVICE_PORT)- --mysql-user=$(POLARDB_X_USER)- --mysql_password=$(POLARDB_X_PASSWD)- --mysql-db=sysbench_test- --mysql-table-engine=innodb- --rand-init=on- --max-requests=0- --oltp-tables-count=1- --report-interval=5- --oltp-table-size=160000- --oltp_skip_trx=on- --oltp_auto_inc=off- --oltp_secondary- --oltp_range_size=5- --mysql-ignore-errors=all- --num-threads=8- --time=3600- /usr/share/sysbench/tests/include/oltp_legacy/oltp.lua- run

- 执行如下命令,运行启动压测的sysbench-oltp.yaml文件,开始压测。

kubectl apply -f sysbench-oltp.yaml

- 执行如下命令,查找压测脚本运行的POD。

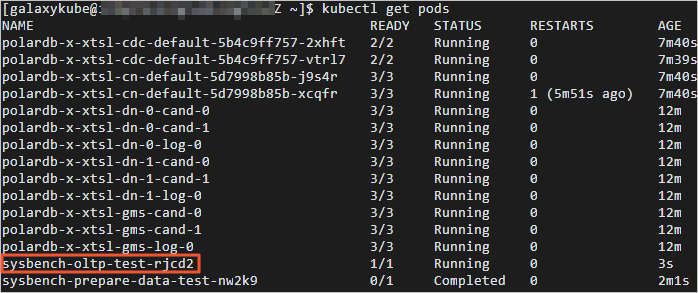

kubectl get pods

返回结果如下, 以‘sysbench-oltp-test-’开头的POD即为目标POD。

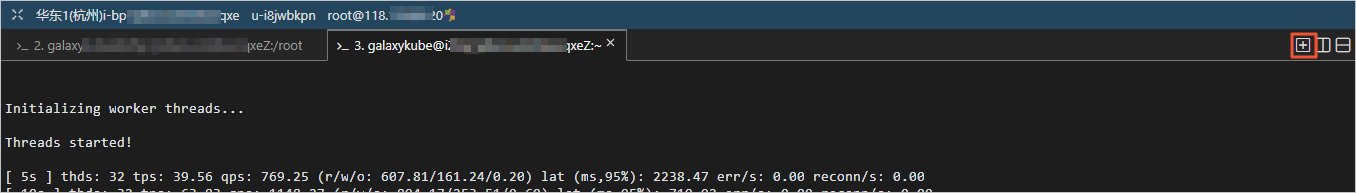

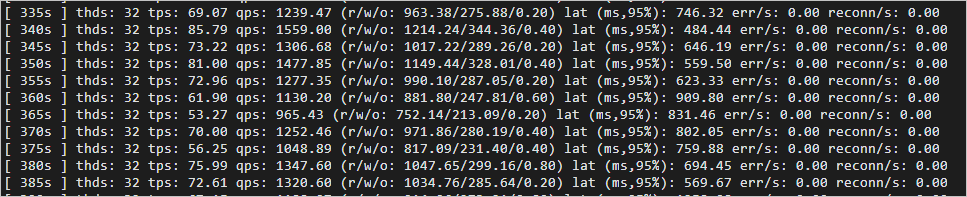

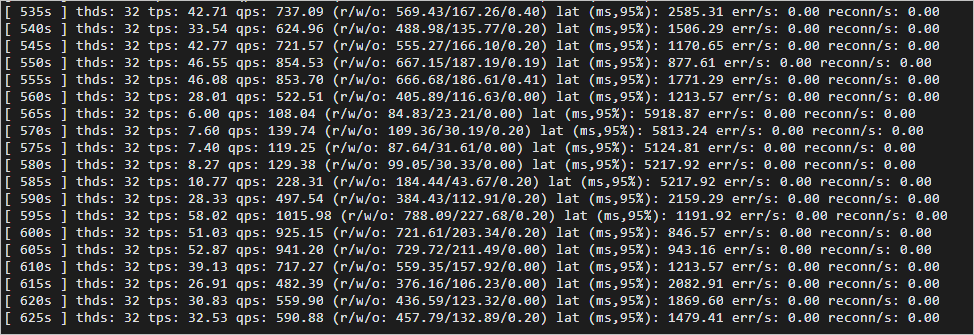

- 执行如下命令,查看QPS等流量数据。

说明:您需要将命令中的目标POD替换为以‘sysbench-oltp-test-’开头的POD。

kubectl logs -f 目标POD

6. 体验PolarDB-X高可用能力

经过前面的准备工作,我们已经用PolarDB-X+Sysbench OLTP搭建了一个正在运行的业务系统。本步骤将指导您通过使用kill POD的方式,模拟物理机宕机、断网等导致的节点不可用场景,并观察业务QPS的变化情况。

- 在实验页面,单击右上角的

图标,创建新的终端三。

图标,创建新的终端三。

kill CN。

- 执行如下命令,切换到账号galaxykube。

su galaxykube

- 执行如下命令,获取CN POD的名字。

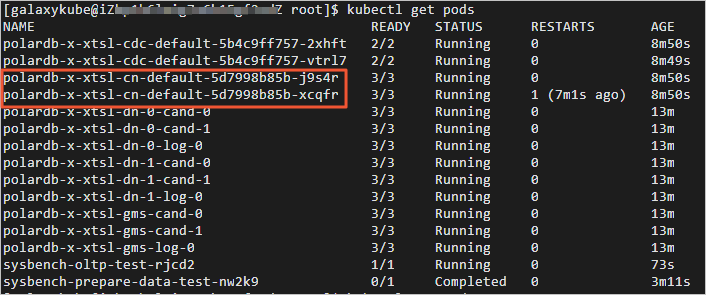

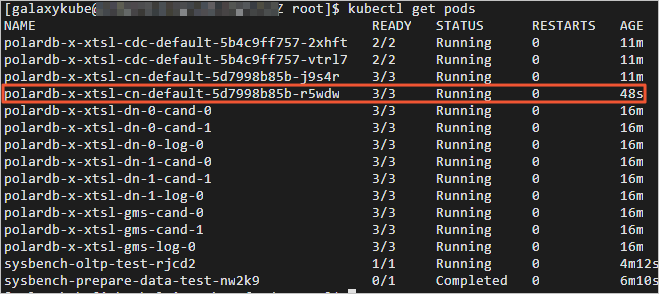

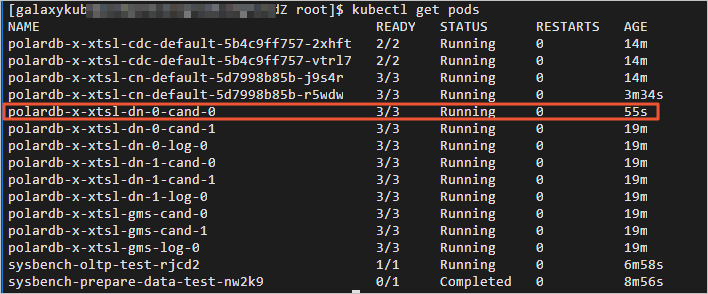

kubectl get pods

返回结果如下,以‘polardb-x-xxxx-cn-default’开头的是CN POD的名字。

- 执行如下命令,删除任意一个CN POD。说明:您需要将命令中的替换为任意一个以‘polardb-x-xxxx-cn-default’开头的CN POD的名字。

kubectl delete pod <CN POD>

- 执行如下命令,查看CN POD自动创建情况。

kubectl get pods

返回结果如下,您可查看到CN POD已经处于自动创建中。

经过几十秒后,被kill的CN POD自动恢复正常。

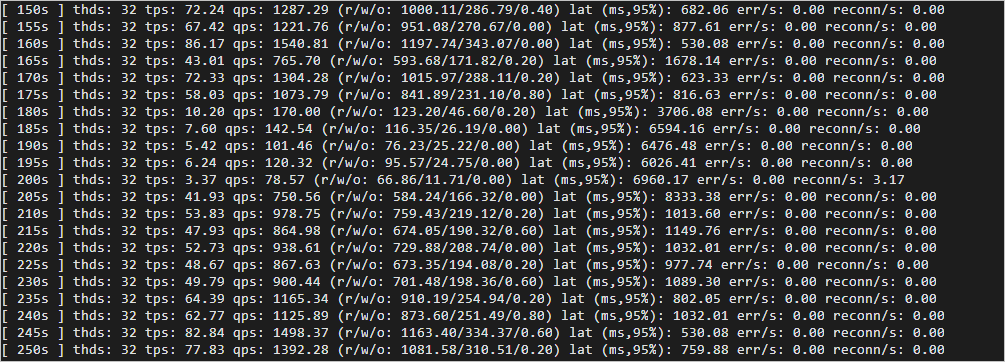

- 切换至终端二,您可查看kill CN之后业务QPS的情况。

kill DN。

- 切换至终端三,执行如下命令,获取DN POD的名字。

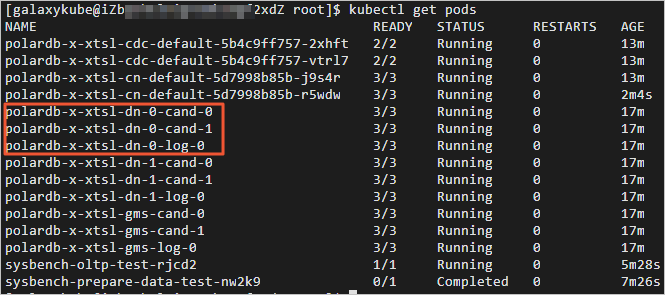

kubectl get pods

返回结果如下,以‘polardb-x-xxxx-dn’开头的是DN POD的名字。

- 执行如下命令,删除任意一个DN POD。

说明:

您需要将命令中的替换为任意一个以‘polardb-x-xxxx-dn’开头的DN POD的名字。

DN每个逻辑节点为三副本架构,也就是说一个DN节点对应3个POD,可任意选择一个进行删除操作。此外,GMS节点是一个特殊角色的DN,同样具备高可用能力,可选择任一POD进行删除。

kubectl delete pod <DN POD>

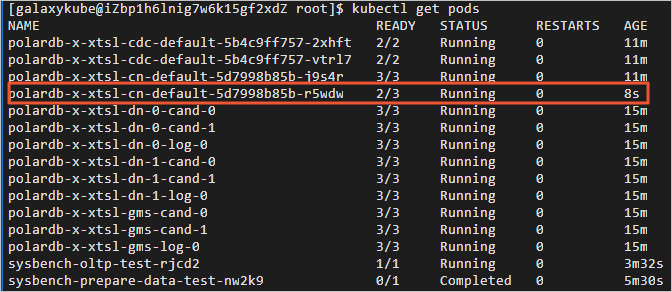

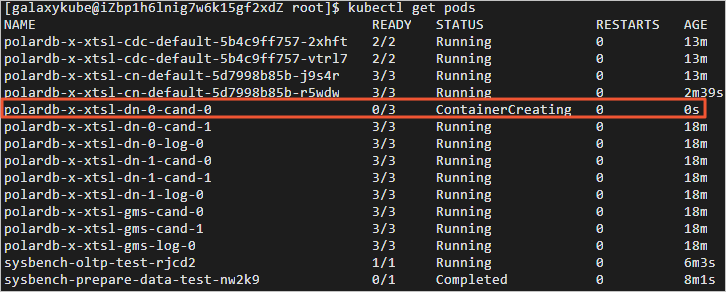

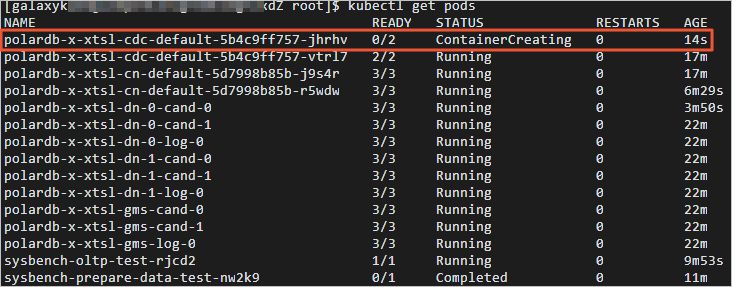

- 执行如下命令,查看DN POD自动创建情况。

kubectl get pods

返回结果如下,您可查看到DN POD已经处于自动创建中。

经过几十秒后,被kill的DN POD自动恢复正常。

- 切换至终端二,您可查看kill DN之后业务QPS的情况。

kill CDC。

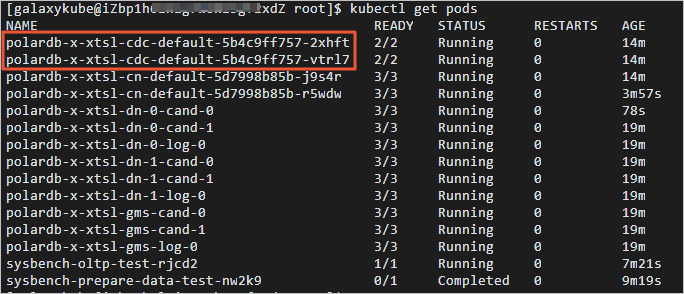

- 切换至终端三,执行如下命令,获取CDC POD的名字。

kubectl get pods

返回结果如下,以‘polardb-x-xxxx-cdc-defaul’开头的是CDC POD的名字。

- 执行如下命令,删除任意一个CDC POD。

说明:您需要将命令中的替换为任意一个以‘polardb-x-xxxx-cdc-defaul’开头的CDC POD的名字。

kubectl delete pod <CDC POD>

- 执行如下命令,查看CDC POD自动创建情况。

kubectl get pods

返回结果如下,您可查看到CDC POD已经处于自动创建中。

经过几十秒后,被kill的CDC POD自动恢复正常。

- 切换至终端二,您可查看kill CDC之后业务QPS的情况。

7. 了解更多

如果您想了解更多有关PolarDB-X高可用知识,详情请参见如下内容。

恭喜完成

阿里云有奖体验:用PolarDB-X搭建一个高可用系统的更多相关文章

- SpringCloud学习系列之一 ----- 搭建一个高可用的注册中心(Eureka)

前言 本篇主要介绍的是SpringCloud相关知识.微服务架构以及搭建一个高可用的服务注册与发现的服务模块(Eureka). SpringCloud介绍 Spring Cloud是在Spring B ...

- 基于阿里云SLB/ESS/EIP/ECS/VPC的同城高可用方案演练

今天基于阿里云SLB/ESS/EIP/ECS/VPC等产品进行了一次同城高可用方案演练: 基本步骤如下: 1. 在华东1创建VPC网络VPC1,在华东1可用区B和G各创建一个虚拟交换机vpc1_swi ...

- 搭建一个高可用的redis环境

一.环境准备 我的环境: Fedora 25 server 64位版 6台: 192.168.10.204 192.168.10.205 192.168.10.206 192.168.10.203 ...

- 阿里云有奖体验:如何通过ECS挂载NAS文件系统

实验简介 本实验提供CentOS系统ECS一台和NAS文件服务. NAS基于POSIX文件接口,天然适配原生操作系统,提供共享访问,同时保证数据一致性和锁互斥.它提供了简单的可扩展文件存储以供与ECS ...

- Nginx系列篇四:Nginx+keepalived搭建一个高可用的双机双主热备

建议:先阅读Nginx+keepalived主从配置,因为此篇是接着上篇开始的 上一篇我们简单的介绍了主从配置及其缺点,我们看一下双主热备配置: 2台Nginx+keepalived互为主备,各自绑定 ...

- 阿里云有奖调查结果公布,赠送10个阿里巴巴logo胸针

...

4月17日,我们发起了"阿里云有奖调查!赠10个阿里巴巴logo胸针"活动,现经过随机抽奖机抽选出10名幸运同学,每人赠送一枚阿里巴巴胸针.现把获奖同学ID公布如下,请如下同学私信 ...

- 高并发&高可用系统的常见应对策略 秒杀等-(阿里)

对于一个需要处理高并发的系统而言,可以从多个层面去解决这个问题. 1.数据库系统:数据库系统可以采取集群策略以保证某台数据库服务器的宕机不会影响整个系统,并且通过负载均衡策略来降低每一台数据库服务器的 ...

- 搭建一个redis高可用系统

一.单个实例 当系统中只有一台redis运行时,一旦该redis挂了,会导致整个系统无法运行. 单个实例 二.备份 由于单台redis出现单点故障,就会导致整个系统不可用,所以想到的办法自然就是备份( ...

- Haproxy+Keepalived搭建Weblogic高可用负载均衡集群

配置环境说明: KVM虚拟机配置 用途 数量 IP地址 机器名 虚拟IP地址 硬件 内存3G 系统盘20G cpu 4核 Haproxy keepalived 2台 192.168.1.10 192 ...

随机推荐

- spring4 mvc + jpa demo

BEGIN; pom.xml 的引入的相关jar版本配置 <properties> <project.build.sourceEncoding>UTF-8</projec ...

- 记一次sql注入的解决方案

点赞再看,养成习惯,微信搜索「小大白日志」关注这个搬砖人. 本文在公众号文章已同步,还有各种一线大厂面试原题.我的学习系列笔记. 今天业务提了个模糊查询,一听就知道这种问题有坑,肯定涉及到sql注入, ...

- VSCODE调试时在cygwin.S中发生段错误

起因: C++实现矩阵类和向量类 当看了我实现的矩阵类后,一个同学问我: 然后我就试了试1000维,结果运行时在cygwin.S里引发了奇奇怪怪的Segmentation fault,而且这个文件还是 ...

- ghostnet论文解析:ghost

创建日期: 2020-03-02 17:02:54 简介: GhostNet是2020CVPR录用的一篇对卷积操作进行改进的论文.文章的核心内容是Ghost模块(Ghost Module),可以用来替 ...

- 跟我学Python图像处理丨获取图像属性、兴趣ROI区域及通道处理

摘要:本篇文章主要讲解Python调用OpenCV获取图像属性,截取感兴趣ROI区域,处理图像通道. 本文分享自华为云社区<[Python图像处理] 三.获取图像属性.兴趣ROI区域及通道处理 ...

- Nginx中FastCGI参数的优化配置实例

在配置完成Nginx+FastCGI之后,为了保证Nginx下PHP环境的高速稳定运行,需要添加一些FastCGI优化指令.下面给出一个优化实例,将下面代码添加到Nginx主配置文件中的HTTP层级. ...

- (AAAI2020 Yao) Graph Few-shot Learning via knowledge transfer

22-5-13 seminar上和大家分享了这篇文章 [0]Graph few-shot learning via knowledge transfer 起因是在MLNLP的公众号上看到了张初旭老师讲 ...

- ThreadLocal夺命11连问

前言 前一段时间,有同事使用ThreadLocal踩坑了,正好引起了我的兴趣. 所以近期,我抽空把ThreadLocal的源码再研究了一下,越看越有意思,发现里面的东西还真不少. 我把精华浓缩了一下, ...

- 《Mybatis 手撸专栏》第8章:把反射用到出神入化

作者:小傅哥 博客:https://bugstack.cn 沉淀.分享.成长,让自己和他人都能有所收获! 一.前言 为什么,读不懂框架源码? 我们都知道作为一个程序员,如果想学习到更深层次的技术,就需 ...

- 用了Scrum越来越累?这三点帮你走出困境

摘要:你有没有一种感觉,团队用了Scrum之后,工作任务越来越多,加班越来越严重?有?好兄弟,这篇文章正好能帮你~ 本文分享自华为云社区<用了Scrum越来越累?这三点帮你走出困境>,作者 ...