《Perceptual Losses for Real-Time Style Transfer and Super-Resolution》论文笔记

参考 http://blog.csdn.net/u011534057/article/details/55052304

代码 https://github.com/yusuketomoto/chainer-fast-neuralstyle

出处

2016 · european conference on computer vision

Motivation

研究Image transfomation的方法。有别于现有的typically train feed-forward convolutional neural networks using a per-pixel loss between the output and ground-truth images,本文使用基于perceptual loss的方式来提取特征,生成风格转换图片和高分辨率图片

Introduction

章节开始介绍了Image transformation的定义和一些work,简单地说喂一张图片,吐一张不同的图片即是。举例说明perceptual loss相对于per-pixel loss的优势,两张几乎一样的图片会因为一个像素点的偏差导致per-pixel loss完全不同,但在感官层面,是没有区别的,这显然使得像素级的损失函数不太科学了。现有的工作已经开始用perceptual loss 来抽取视觉特征生成高质量图片,但速度非常缓慢。该文的模型在Image transformation方面能生成和[1]效果大致相仿的高质量图片,并在速度上快了3个数量级,在重建分辨率方面,能有4倍到8倍的分辨率提升。

Related work

1.各种基于per-pixel的Feed-forward image transformation work

2.Perceptual optimization.

3.Style Transfer.

4.Image super-resolution.

Method

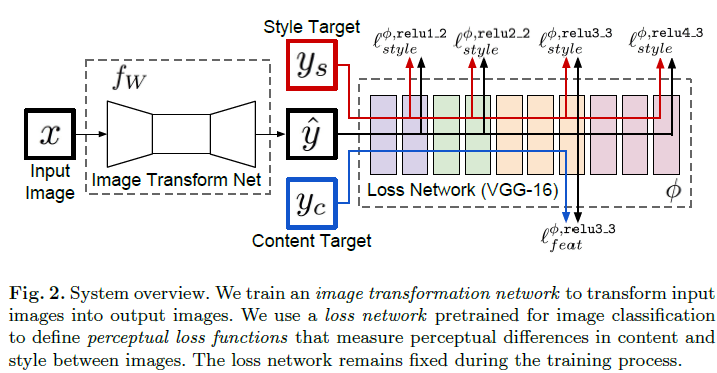

整个模型系统框架如下所示:

模型分为两个部分

Image transformation networks $f_w$ 和 loss network(vgg-16 pretrained on Imagenet) $\phi$

- Image Transformation

a deep residual convolutional neural network parameterized by weights $W$,使用映射 将输入的Image $X$映射成

将输入的Image $X$映射成 。Image Transformation的网络架构基本上基于DCGAN模型并使用了5个残差网络层。因 为整个网络是全卷积网络,所以在test-time输入可以是任意大小的图片。

。Image Transformation的网络架构基本上基于DCGAN模型并使用了5个残差网络层。因 为整个网络是全卷积网络,所以在test-time输入可以是任意大小的图片。

对Transform network来说,优化目标为

- Loss network

经过预训练的Loss network在整个训练过程中保持超参数不变。 在$\phi$中定义了一堆loss 函数$l_1,l_2...$,每一个loss function计算了 ,即映射输出的图片

,即映射输出的图片 和target image $y_i$的loss

和target image $y_i$的loss

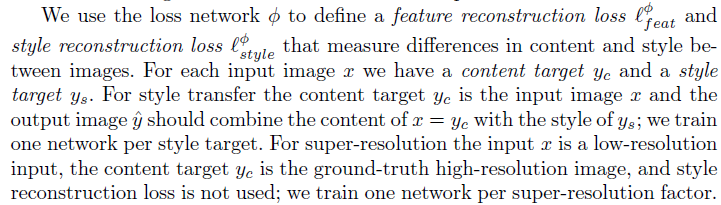

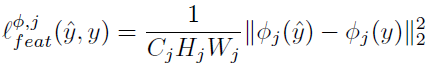

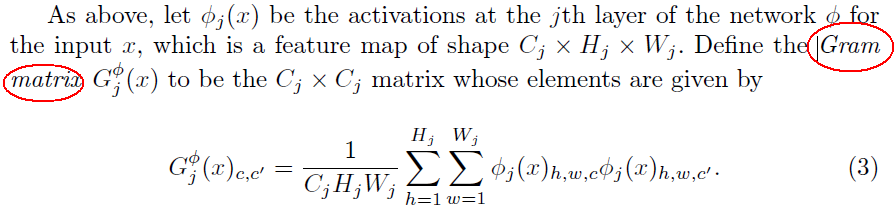

同时,作者定义了两种Perceptual Loss Functions,Feature Reconstruction Loss 和Style Reconstruction Loss

perceptual loss:  保证了在feature层面上生成图片和原图片保持一致

保证了在feature层面上生成图片和原图片保持一致

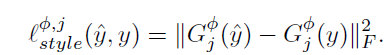

Style Loss:在feature层面保证了生成图片和风格图片的一直

构建了一个Gram矩阵,即$i$通道的feature map与$j$通道的feature map进行内积,用以衡量两个feature map之间的差异度,从而可以从两张图的Gam矩阵入手,构建loss函数:

两张图的size即使完全不一致也可以计算出该style loss,因为Gram矩阵计算时基于的是卷积层的feature map的总差异。

[1]Gatys, L.A., Ecker, A.S., Bethge, M.: A neural algorithm of artistic style. arXiv preprint arXiv:1508.06576 (2015)

[2]Gatys, L.A., Ecker, A.S., Bethge, M.: Texture synthesis using convolutional neuralnetworks. In: NIPS. (2015)

《Perceptual Losses for Real-Time Style Transfer and Super-Resolution》论文笔记的更多相关文章

- 《Vision Permutator: A Permutable MLP-Like ArchItecture For Visual Recognition》论文笔记

论文题目:<Vision Permutator: A Permutable MLP-Like ArchItecture For Visual Recognition> 论文作者:Qibin ...

- [place recognition]NetVLAD: CNN architecture for weakly supervised place recognition 论文翻译及解析(转)

https://blog.csdn.net/qq_32417287/article/details/80102466 abstract introduction method overview Dee ...

- 论文笔记系列-Auto-DeepLab:Hierarchical Neural Architecture Search for Semantic Image Segmentation

Pytorch实现代码:https://github.com/MenghaoGuo/AutoDeeplab 创新点 cell-level and network-level search 以往的NAS ...

- 论文笔记——Rethinking the Inception Architecture for Computer Vision

1. 论文思想 factorized convolutions and aggressive regularization. 本文给出了一些网络设计的技巧. 2. 结果 用5G的计算量和25M的参数. ...

- 论文笔记:Fast Neural Architecture Search of Compact Semantic Segmentation Models via Auxiliary Cells

Fast Neural Architecture Search of Compact Semantic Segmentation Models via Auxiliary Cells 2019-04- ...

- 论文笔记:ProxylessNAS: Direct Neural Architecture Search on Target Task and Hardware

ProxylessNAS: Direct Neural Architecture Search on Target Task and Hardware 2019-03-19 16:13:18 Pape ...

- 论文笔记:DARTS: Differentiable Architecture Search

DARTS: Differentiable Architecture Search 2019-03-19 10:04:26accepted by ICLR 2019 Paper:https://arx ...

- 论文笔记:Progressive Neural Architecture Search

Progressive Neural Architecture Search 2019-03-18 20:28:13 Paper:http://openaccess.thecvf.com/conten ...

- 论文笔记:Auto-DeepLab: Hierarchical Neural Architecture Search for Semantic Image Segmentation

Auto-DeepLab: Hierarchical Neural Architecture Search for Semantic Image Segmentation2019-03-18 14:4 ...

- 论文笔记系列-DARTS: Differentiable Architecture Search

Summary 我的理解就是原本节点和节点之间操作是离散的,因为就是从若干个操作中选择某一个,而作者试图使用softmax和relaxation(松弛化)将操作连续化,所以模型结构搜索的任务就转变成了 ...

随机推荐

- CodeForces - 754B Ilya and tic-tac-toe game

简单搜索 判断是否能在最后一步下棋得到胜利 问题转化为 是否有可以胜利的x的摆法 那么就只有两种情况 1.有两个x相连 并且 在端点还有.可以落子 那么就可以在最后一步 胜利 2.两个x中间恰好有一个 ...

- visual svn 搭建

详细出处参考:http://www.jb51.net/article/17365.htm 这里提示一个需要注意的地方: 在签入源代码到SVN服务器的时候: 点击Import,弹出下面的窗体(图2-2- ...

- sgu179 SGU起航!

//发现dfs除了搜索功能外的其他功能,他本身是一种序列,这个题恰是"先序"的下一个(合法范围内)序列! #include<iostream> #include< ...

- Swift--方法(函数)

方法是执行特殊任务的自包含代码块.你可以给方法名字来表示它的功能,而且在需要的时候调用这个名字的方法来执行它的任务. Swift方法的语法表达很灵活,从类似c的没有参数名的方法到oc复杂的带有名字和参 ...

- POJ 1094 Sorting It All Out【拓扑排序】

题目链接: http://poj.org/problem?id=1094 题意: 给定前n个字母的大小关系,问你是否 根据前xxx个关系得到上升序列 所有关系都无法确定唯一的一个序列 第xxx个关系导 ...

- CodeForces 596C Wilbur and Points

先对n个点分类,然后按题意要求构造,构造的时候判断这个点的右上方之前是否有点,判断可以用线段树来操作. #include<cstdio> #include<cstring> # ...

- POJ 2240 【这题貌似可以直接FLOYD 屌丝用SPFA通过枚举找正权值环 顺便学了下map】

题意: 给了n种硬币的名称,给了m种硬币间的转换关系. 从任意兑换地点开始兑换,看是否能够通过兑换的方式增加金钱. 思路: 用SPFA不断对各个点进行松弛操作,寻找正权值的环.如果找到则输出Yes. ...

- 提示:“请检查浏览器代理设置”/xx-net

1.删除已导入的证书文件(运行certmgr.msc和certlm.msc,然后自己找到xxnet删),2.更新3.3.1(或是自己找到那行代码取消注释,楼下有人提及)3.删除data文件夹(下的ce ...

- Angular2.x-显示heroes列表

在此页面中,您将展开Tour of Heroes应用程序以显示heroes列表,并允许用户选择heroes并显示heroes的详细信息. 6.X 你需要一些heroes来展示. 最终你会从远程数据服务 ...

- Codeforces Round #135 (Div. 2)---A. k-String

k-String time limit per test 2 seconds memory limit per test 256 megabytes input standard input outp ...