PyTorch中的backward [转]

转自:https://sherlockliao.github.io/2017/07/10/backward/

backward只能被应用在一个标量上,也就是一个一维tensor,或者传入跟变量相关的梯度。

特别注意Variable里面默认的参数requires_grad=False,所以这里我们要重新传入requires_grad=True让它成为一个叶子节点。

对其求偏导:

import torch as t

from torch.autograd import Variable as v # simple gradient

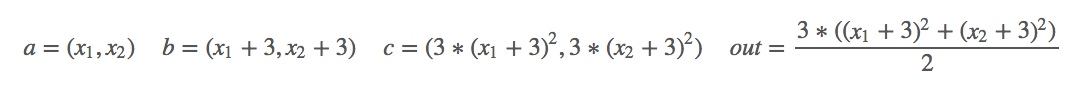

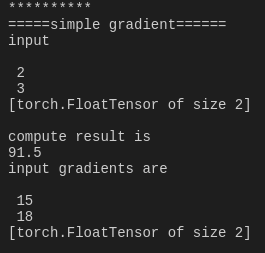

a = v(t.FloatTensor([2, 3]), requires_grad=True)

b = a + 3

c = b * b * 3

out = c.mean()

out.backward()

print('*'*10)

print('=====simple gradient======')

print('input')

print(a.data)

print('compute result is')

print(out.data[0])

print('input gradients are')

print(a.grad.data)

下面研究一下如何能够对非标量的情况下使用backward。backward里传入的参数是每次求导的一个系数。

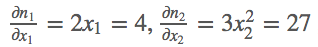

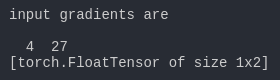

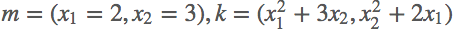

首先定义好输入m=(x1,x2)=(2,3),然后我们做的操作就是n= ,这样我们就定义好了一个向量输出,结果第一项只和x1有关,结果第二项只和x2有关,那么求解这个梯度,

,这样我们就定义好了一个向量输出,结果第一项只和x1有关,结果第二项只和x2有关,那么求解这个梯度,

# backward on non-scalar output

m = v(t.FloatTensor([[2, 3]]), requires_grad=True)

n = v(t.zeros(1, 2))

n[0, 0] = m[0, 0] ** 2

n[0, 1] = m[0, 1] ** 3

n.backward(t.FloatTensor([[1, 1]]))

print('*'*10)

print('=====non scalar output======')

print('input')

print(m.data)

print('input gradients are')

print(m.grad.data)

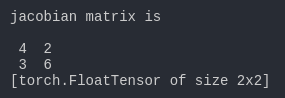

jacobian矩阵

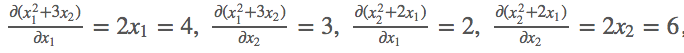

对其求导:

k.backward(parameters)接受的参数parameters必须要和k的大小一模一样,然后作为k的系数传回去,backward里传入的参数是每次求导的一个系数。

# jacobian

j = t.zeros(2 ,2)

k = v(t.zeros(1, 2))

m.grad.data.zero_()

k[0, 0] = m[0, 0] ** 2 + 3 * m[0 ,1]

k[0, 1] = m[0, 1] ** 2 + 2 * m[0, 0]

# [1, 0] dk0/dm0, dk1/dm0

k.backward(t.FloatTensor([[1, 0]]), retain_variables=True) # 需要两次反向求导

j[:, 0] = m.grad.data

m.grad.data.zero_()

# [0, 1] dk0/dm1, dk1/dm1

k.backward(t.FloatTensor([[0, 1]]))

j[:, 1] = m.grad.data

print('jacobian matrix is')

print(j)

我们要注意backward()里面另外的一个参数retain_variables=True,这个参数默认是False,也就是反向传播之后这个计算图的内存会被释放,这样就没办法进行第二次反向传播了,所以我们需要设置为True,因为这里我们需要进行两次反向传播求得jacobian矩阵。

PyTorch中的backward [转]的更多相关文章

- 关于Pytorch中autograd和backward的一些笔记

参考自<Pytorch autograd,backward详解>: 1 Tensor Pytorch中所有的计算其实都可以回归到Tensor上,所以有必要重新认识一下Tensor. 如果我 ...

- pytorch中tensorboardX的用法

在代码中改好存储Log的路径 命令行中输入 tensorboard --logdir /home/huihua/NewDisk1/PycharmProjects/pytorch-deeplab-xce ...

- pytorch 中的重要模块化接口nn.Module

torch.nn 是专门为神经网络设计的模块化接口,nn构建于autgrad之上,可以用来定义和运行神经网络 nn.Module 是nn中重要的类,包含网络各层的定义,以及forward方法 对于自己 ...

- 转pytorch中训练深度神经网络模型的关键知识点

版权声明:本文为博主原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明. 本文链接:https://blog.csdn.net/weixin_42279044/articl ...

- pytorch中调用C进行扩展

pytorch中调用C进行扩展,使得某些功能在CPU上运行更快: 第一步:编写头文件 /* src/my_lib.h */ int my_lib_add_forward(THFloatTensor * ...

- 关于Pytorch中accuracy和loss的计算

这几天关于accuracy和loss的计算有一些疑惑,原来是自己还没有弄清楚. 给出实例 def train(train_loader, model, criteon, optimizer, epoc ...

- 【PyTorch】PyTorch中的梯度累加

PyTorch中的梯度累加 使用PyTorch实现梯度累加变相扩大batch PyTorch中在反向传播前为什么要手动将梯度清零? - Pascal的回答 - 知乎 https://www.zhihu ...

- PyTorch中的C++扩展

今天要聊聊用 PyTorch 进行 C++ 扩展. 在正式开始前,我们需要了解 PyTorch 如何自定义module.这其中,最常见的就是在 python 中继承torch.nn.Module,用 ...

- PyTorch中的Batch Normalization

Pytorch中的BatchNorm的API主要有: 1 torch.nn.BatchNorm1d(num_features, 2 3 eps=1e-05, 4 5 momentum=0.1, 6 7 ...

随机推荐

- Python os.walk文件遍历用法【转】

python中os.walk是一个简单易用的文件.目录遍历器,可以帮助我们高效的处理文件.目录方面的事情. 1.载入 要使用os.walk,首先要载入该函数 可以使用以下两种方法 import os ...

- javascript面向对象学习

1.this指向问题,指向的是当前的方法属于谁,当前的方法属于谁就指向谁!! 例子: oDiv.onclick = function () { this指向的是oDiv,因为这个方法属于oDiv } ...

- CentOS6.5 上crontab每天自动备份mysql数据库

步骤: 1. sudo vi /etc/crontab #编辑crontab任务 2.输入01 12 * * * root /usr/local/mysql/backup/backup.sh > ...

- tomcat session Memcache 共享

背景 这次做的这个项目并发还真是挺高,单表一天产生百万条记录不在话下.结果导致运行过程中经常丢失数据,卡.慢等.开来终于要搞一次负载均衡了,之前实验学习了不少,但是没有在项目中实际用过,因为并发量不大 ...

- spring3.1 profile 配置不同的环境

<?xml version="1.0" encoding="UTF-8"?><beans xmlns="http://www.spr ...

- GO 新开发者要注意的陷阱和常见错误

转自:http://colobu.com/2015/09/07/gotchas-and-common-mistakes-in-go-golang/ 初级 开大括号不能放在单独的一行 未使用的变量 未使 ...

- 转载:MySQL字段类型

原文:https://www.cnblogs.com/jennyyin/p/7895010.html 数值类型 类型 大小 范围(有符号) 范围(无符号) 用途 TINYINT 1 字节 (-128, ...

- 点9图 Android设计中如何切图.9.png

转载自:http://blog.csdn.net/buaaroid/article/details/51499516 本文主要介绍如何制作 切图.9.png(点9图),另一篇姊妹篇文章Android屏 ...

- 清北学堂 清北-Day1-R1-Count

题目描述 问有几个无序二元组 (x; y) 满足 xy ≡ 1 (mod P ); 0 ≤ x < P; 0 ≤ y <P.无序二元组是指,如果 P = 10, (3; 7) 和 (7; ...

- 金九银十中,看看这31道Android面试题

阅读目录 1.如何对 Android 应用进行性能分析 2.什么情况下会导致内存泄露 3.如何避免 OOM 异常 4.Android 中如何捕获未捕获的异常 5.ANR 是什么?怎样避免和解决 ANR ...