logstash解耦之redis消息队列

logstash解耦之redis消息队列

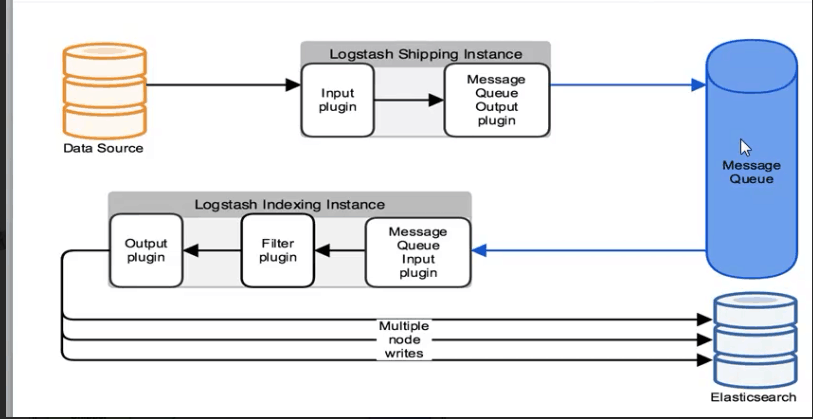

架构图如下:

说明:通过input收集日志消息放入消息队列服务中(redis,MSMQ、Resque、ActiveMQ,RabbitMQ),再通过output取出消息写入ES上,kibana显示。

好处:松耦合,降低logstash收集日志的负载对业务服务不受影响,前后端分离,消息能存储不影响ES维护。

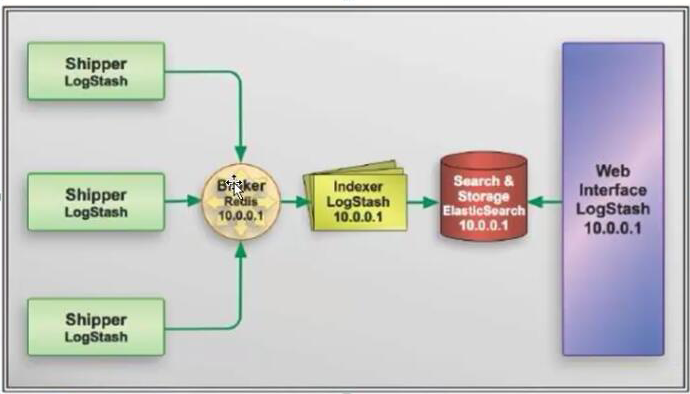

下面我们就用redis做消息队列存储,架构如下:

#安装redis,修改redis配置文件,bind和protected-mode

[root@elk-node1 conf.d]# yum install -y redis

[root@elk-node1 conf.d]# cp /etc/redis.conf{,.bak}

[root@elk-node1 conf.d]# grep "^[a-z]" /etc/redis.conf

bind 192.168.247.135

protected-mode yes

port 6379

tcp-backlog 511

timeout 0

tcp-keepalive 300

daemonize yes

supervised no

...

#启动redis服务

[root@elk-node1 conf.d]# systemctl start redis

You have new mail in /var/spool/mail/root

[root@elk-node1 conf.d]# ss -lntp|grep 6379

LISTEN 0 511 192.168.247.135:6379 *:* users:(("redis-server",pid=18387,fd=4))

You have new mail in /var/spool/mail/root

[root@elk-node1 conf.d]# grep "^[a-z]" /etc/redis.conf^C

[root@elk-node1 conf.d]# redis-cli -h 192.168.247.135

192.168.247.135:6379> exit

#编写测试文件

[root@elk-node1 conf.d]# cat redis-out.conf

input{

stdin{ }

}

output{

redis{

host => "192.168.247.135"

port => "6379"

db => "6"

data_type => "list"

key => "demo"

}

}

#logstash配置文件运行输入hello world

[root@elk-node1 conf.d]# /opt/logstash/bin/logstash -f /etc/logstash/conf.d/redis-out.conf

Settings: Default filter workers: 1

hello world

#另开一个窗口登录redis可以看到一条我们刚输入的hello world消息

[root@elk-node1 ~]# redis-cli -h 192.168.247.135

192.168.247.135:6379> info

Logstash startup completed

# Keyspace

db6:keys=1,expires=0,avg_ttl=0

192.168.247.135:6379> select 6

OK

192.168.247.135:6379[6]> key *

(error) ERR unknown command 'key'

192.168.247.135:6379[6]> keys *

1) "demo"

192.168.247.135:6379[6]> LINDEX demo -1

"{\"message\":\"hello world\",\"@version\":\"1\",\"@timestamp\":\"2018-07-28T06:44:50.418Z\",\"host\":\"elk-node1\"}"

192.168.247.135:6379[6]>

#接下来我们把消息写入ES,首先再输入多条消息

[root@elk-node1 conf.d]# /opt/logstash/bin/logstash -f /etc/logstash/conf.d/redis-out.conf

Settings: Default filter workers: 1

Logstash startup completed

fsadf

dgdf

gdg

ad

fd

ds

cd

g

rgergerg

rg

qrg

rh

rg

q

34tr

34

f

gdf

df df

f

sdv

sdf re

ter

t4

^CSIGINT received. Shutting down the pipeline. {:level=>:warn} Logstash shutdown completed

#写一个输入到ES的配置文件

[root@elk-node1 conf.d]# cat redis-int.conf

input{

redis{

host => "192.168.247.135"

port => "6379"

db => "6"

data_type => "list"

key => "demo"

}

}

output{

elasticsearch {

hosts => ["192.168.247.135:9200"]

index => "redis-demo-%{+YYYY.MM.dd}"

}

}

#logstash配置文件运行

[root@elk-node1 conf.d]# /opt/logstash/bin/logstash -f /etc/logstash/conf.d/redis-int.conf

Settings: Default filter workers: 1

Logstash startup completed

#这时我们看redis上的消息已经被消费了

192.168.247.135:6379[6]> LLEN demo

(integer) 0

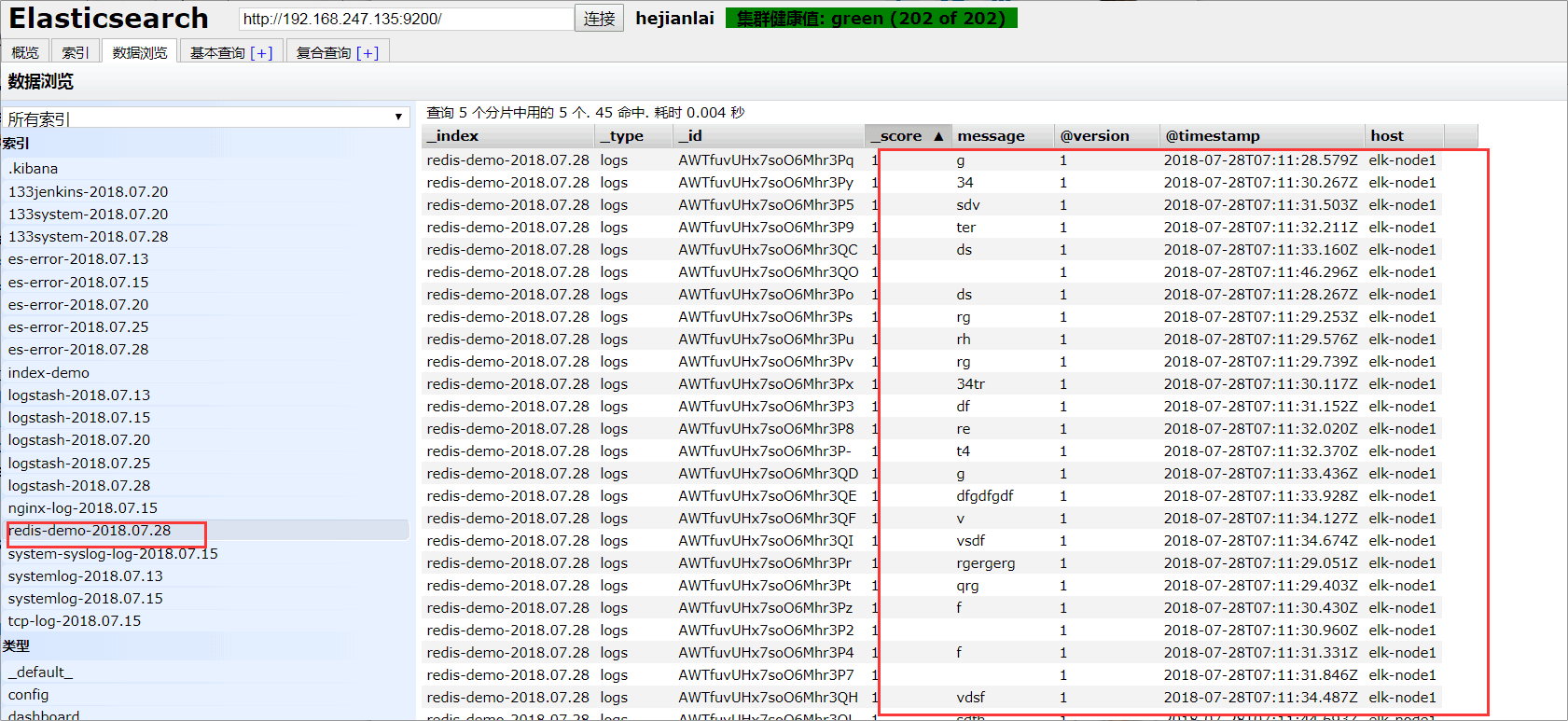

我们在登录ES可以看到已经有记录了

#写一个系统监控的配置文件把日志写入redis,inpout里读取日志消息,output里写入redis。

[root@elk-node1 conf.d]# cat shipper.conf

input {

file {

path => "/var/log/messages"

type => "system"

start_position => "beginning"

}

file {

path => "/var/log/elasticsearch/hejianlai.log"

type => "es-error"

start_position => "beginning"

codec => multiline {

pattern => "^\["

negate => true

what => "previous"

}

}

file {

path => "/var/log/nginx/access_json.log"

codec => json

start_position => "beginning"

type => "nginx-log"

}

syslog{

type => "system-syslog"

host => "192.168.247.135"

port => "514"

}

}

output { if [type] == "system"{

redis{

host => "192.168.247.135"

port => "6379"

db => "6"

data_type => "list"

key => "system"

}

}

if [type] == "es-error"{

redis{

host => "192.168.247.135"

port => "6379"

db => "6"

data_type => "list"

key => "es-error"

}

}

if [type] == "nginx-log"{

redis{

host => "192.168.247.135"

port => "6379"

db => "6"

data_type => "list"

key => "nginx-log"

}

}

if [type] == "system-syslog"{

redis{

host => "192.168.247.135"

port => "6379"

db => "6"

data_type => "list"

key => "system-syslog" }

}

}

#运行配置文件

[root@elk-node1 conf.d]# /opt/logstash/bin/logstash -f /etc/logstash/conf.d/shipper.conf

#查看redis已经生成了相应的key

192.168.247.135:6379[6]> keys *

1) "system"

2) "nginx-log"

3) "es-error"

192.168.247.135:6379[6]>

#写一个配置文件从redis中把日志写入ES,inpout里读取redis消息,output里写入ES.

[root@elk-node2 conf.d]# cat display.conf

input {

redis{

type => "system-syslog"

host => "192.168.247.135"

port => "6379"

db => "6"

data_type => "list"

key => "system-syslog" }

redis{

type => "system"

host => "192.168.247.135"

port => "6379"

db => "6"

data_type => "list"

key => "system" }

redis{

type => "es-error"

host => "192.168.247.135"

port => "6379"

db => "6"

data_type => "list"

key => "es-error" }

redis{

type => "nginx-log"

host => "192.168.247.135"

port => "6379"

db => "6"

data_type => "list"

key => "nginx-log" } }

output { if [type] == "system"{

elasticsearch {

hosts => ["192.168.247.135:9200"]

index => "systemlog-%{+YYYY.MM.dd}"

}

} if [type] == "es-error"{

elasticsearch {

hosts => ["192.168.247.135:9200"]

index => "es-error-%{+YYYY.MM.dd}"

}

}

if [type] == "nginx-log"{

elasticsearch {

hosts => ["192.168.247.135:9200"]

index => "nginx-log-%{+YYYY.MM.dd}"

}

}

if [type] == "system-syslog"{

elasticsearch {

hosts => ["192.168.247.135:9200"]

index => "system-syslog-log-%{+YYYY.MM.dd}"

}

}

}

#运行配置文件,就可以收集日志了。

[root@elk-node2 conf.d]# /opt/logstash/bin/logstash -f /etc/logstash/conf.d/display.conf &

到此logstash+redis+elasticsearch+kibana的架构搭建基本结束~~~~~

logstash解耦之redis消息队列的更多相关文章

- redis消息队列简单应用

消息队列出现的原因 随着互联网的高速发展,门户网站.视频直播.电商领域等web应用中,高并发.大数据已经成为基本的标识.淘宝双11.京东618.各种抢购.秒杀活动.以及12306的春运抢票等,他们这些 ...

- 预热一下吧《实现Redis消息队列》

应用场景 为什么要用redis?二进制存储.java序列化传输.IO连接数高.连接频繁 一.序列化 这里编写了一个java序列化的工具,主要是将对象转化为byte数组,和根据byte数组反序列化成ja ...

- Redis 消息队列的实现

概述 Redis实现消息队列有两种形式: 广播订阅模式:基于Redis的 Pub/Sub 机制,一旦有客户端往某个key里面 publish一个消息,所有subscribe的客户端都会触发事件 集群订 ...

- java-spring基于redis单机版(redisTemplate)实现的分布式锁+redis消息队列,可用于秒杀,定时器,高并发,抢购

此教程不涉及整合spring整合redis,可另行查阅资料教程. 代码: RedisLock package com.cashloan.analytics.utils; import org.slf4 ...

- spring mvc redis消息队列

通常情况下,为了提高系统开发的灵活性和可维护度,我们会采用消息队列队系统进行解耦.下面是一个采用spring redis实现的消息队列实例,但此实例会由于网络延迟和阻塞等情况导致消息处理的延时,因而不 ...

- PHP(Mysql/Redis)消息队列的介绍及应用场景案例--转载

郑重提示:本博客转载自好友博客,个人觉得写的很牛逼所以未经同意强行转载,原博客连接 http://www.cnblogs.com/wt645631686/p/8243438.html 欢迎访问 在进行 ...

- PHP(Mysql/Redis)消息队列的介绍及应用场景案例

在进行网站设计的时候,有时候会遇到给用户大量发送短信,或者订单系统有大量的日志需要记录,还有做秒杀设计的时候,服务器无法承受这种瞬间的压力,无法正常处理,咱们怎么才能保证系统正常有效的运行呢?这时候我 ...

- (转)java redis使用之利用jedis实现redis消息队列

应用场景 最近在公司做项目,需要对聊天内容进行存储,考虑到数据库查询的IO连接数高.连接频繁的因素,决定利用缓存做. 从网上了解到redis可以对所有的内容进行二进制的存储,而java是可以对所有对象 ...

- Redis笔记(七)Java实现Redis消息队列

这里我使用Redis的发布.订阅功能实现简单的消息队列,基本的命令有publish.subscribe等. 在Jedis中,有对应的java方法,但是只能发布字符串消息.为了传输对象,需要将对象进行序 ...

随机推荐

- 关于Hbuild引用mui常用代码块以及部分控件.

MUI-最接近原生APP体验的高性能前端框架, 追求性能体验,是我们开始启动MUI项目的首要目标,轻量必然是重要特征: MUI不依赖任何第三方JS库,压缩后的JS和CSS文件仅有100+K和60+K, ...

- java33

1.面向接口编程:将实现类对象(键盘鼠标)赋值给接口类型的变量(USB) interface修饰的类名称 好处:调用时可以是一个方法体即可(实现通用编程) 2.内部类:在类中定义了一个类 ------ ...

- web前端开发过程遇到的问题及解决方式(一)

1. CSS样式优先级问题 <style> .className input(可换其他元素){ type:val !important; } </style> <body ...

- 死锁问题------------------------INSERT ... ON DUPLICATE KEY UPDATE*(转)

前言 我们在实际业务场景中,经常会有一个这样的需求,插入某条记录,如果已经存在了则更新它如果更新日期或者某些列上的累加操作等,我们肯定会想到使用INSERT ... ON DUPLICATE K ...

- FFMPEG增加和提取字幕流

转自 https://www.cnblogs.com/satng/p/5514683.html 防抽复制一遍 增加字幕流ffmpeg -i video.avi -i sub.ass -map 0:0 ...

- laravel 对接 UCenter 基础

说明:1,运行环境 laravel 5.3 php7+nginx+mysql 2,使用安装包 https://github.com/goodspb/laravel5-ucenter 上面有对接方 ...

- 2019浙大校赛--A--Thanks, TuSimple!(简单模拟题)

这题前三段都是一堆吹爆赞助商的屁话,正式题目在图片下边,一个简单模拟题. 题目大意: 有n个男生,m个女生在进行舞会,其中一部分男生祥和比自己矮的女生跳舞,一部分男生想和比自己高的女生跳舞,一部分女生 ...

- B树/[oracle]connect BY语句

读大神的书,出现很多没有见过的函数和便捷操作,特此记录 connect by 之前没有接触过,为了学习这个语句,先了解一下B树数据类型是最好的方法. [本人摘自以下博客] https://www.cn ...

- 防范 SQL 注入攻击

防范 SQL 注入攻击 我们执行的 SQL语句中包含变量,执行的时候会直接把变量内容替换进去.而如果攻击者在输入框中输入一些危险的字符(通常包含 SQL 注释符 --,以及其他预先精心设置的内容), ...

- ArcSDE

ArcSDE,即数据通路,是ArcGIS的空间数据引擎,它是在关系数据库管理系统(RDBMS)中存储和管理多用户空间数据库的通路.从空间数据管理的角度看,ArcSDE是一个连续的空间数据模型,借助这一 ...