Locally weighted regression algorithm

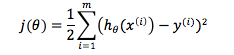

在此引出另一种模型:Locally weighted regression algorithm(LWLR/LWR),通过名字我们可以推断,这是一种更加关注局部变化的模型。的确如此,在普通的linear regression algorithm中,cost function是完全基于training set的,我们通过算法与training set求出h(x)的参数theta,然后训练结束,此后无论推测多少输出,theta和cost function的形式不再发生任何变化。cost function如下:

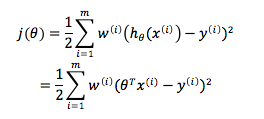

而LWR的完全不同之处在于,我们的cost function是由training set和要预测的数据共同决定的。我们从linear regression的cost function中看到,每个training example的权重都是相等的,而在LWR algorithm中,则是利用的权重项来给予预测值周边局部内的training sub-set更高关注,而基本忽略其他域内training examples的。其cost function为如下形式:

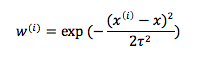

其中权重项的值为:

如果仔细观察,我们可以分析出这个函数是如何为局部范围内的训练样例加权而为局部范围外的训练样例除权的了:

a.x是要进行预测的数据,当训练样例与x无限接近,我们可以知道,此时的权重项无限接近于1,需要经过训练theta去拟合我们的数据集

b.当训练样例与x逐渐远离直至无穷远,此时的权重将无限接近于0,几乎可以无需或需要很小的权重去拟合数据集

c.w的表达式看起来很像Gaussian Distribution,虽然它和高斯分布没什么关系,但的的确确也是一个Bell-Shaped Curve,而分母处tow称为bandwidth parameter,其作用类似于高斯分布中均方差的作用,用以控制钟形曲线的宽窄陡峭程度,如果tow很大,则表明离散程度大,曲线平缓,如果tow小,说明分布比较集中,曲线比较陡峭。

从某种意义上讲,LWR基本忽略了远离局部域的训练样例,专注于在预测值周边的training sub-set中建立线性回归模型,并做局部拟合。普通的linear regression模型是一种parametric learning algorithm,也就是说,学习过程有明确的参数,一旦确定就不会改变,一旦学习就可以丢弃。但locally weighted linear regression是non-parametric learning algorithm,每次进行预估时,都需要进行重新学习。

Locally weighted regression algorithm的更多相关文章

- Locally weighted regression algorithm

之前所讨论的梯度下降算法,其算法模型是“线性回归模型”,我们可以理解为变量与因变量之间的关系是线性的.而现实情况是,使用线性模型去描述所有数据,很容易出现欠拟合(underfitting)的情况:同样 ...

- Locally Weighted Regression

简单回顾一下线性回归.我们使用了如下变量:\(x\)—输入变量/特征:\(y\)—目标变量:\((x,y)\)—单个训练样本:\(m\)—训练集中的样本数目:\(n\)—特征维度:\((x^{(i)} ...

- Robust Locally Weighted Regression 鲁棒局部加权回归 -R实现

鲁棒局部加权回归 [转载时请注明来源]:http://www.cnblogs.com/runner-ljt/ Ljt 作为一个初学者,水平有限,欢迎交流指正. 算法参考文献: (1) Robust L ...

- locally weighted regression - CS229

欠拟合和过拟合 看下方的三张图 第一幅拟合为了 y=θ0+θ1xy=θ0+θ1x 的一次函数 第二幅拟合为了y=θ0+θ1x+θ2x2y=θ0+θ1x+θ2x2 的二次函数 第三幅拟合为了 y=∑5j ...

- 局部加权回归、欠拟合、过拟合(Locally Weighted Linear Regression、Underfitting、Overfitting)

欠拟合.过拟合 如下图中三个拟合模型.第一个是一个线性模型,对训练数据拟合不够好,损失函数取值较大.如图中第二个模型,如果我们在线性模型上加一个新特征项,拟合结果就会好一些.图中第三个是一个包含5阶多 ...

- Locally weighted linear regression(局部加权线性回归)

(整理自AndrewNG的课件,转载请注明.整理者:华科小涛@http://www.cnblogs.com/hust-ghtao/) 前面几篇博客主要介绍了线性回归的学习算法,那么它有什么不足的地方么 ...

- 局部权重线性回归(Locally weighted linear regression)

在线性回归中,因为对參数个数选择的问题是在问题求解之前已经确定好的,因此參数的个数不能非常好的确定,假设參数个数过少可能拟合度不好,产生欠拟合(underfitting)问题,或者參数过多,使得函数过 ...

- Locally Weighted Linear Regression 局部加权线性回归-R实现

局部加权线性回归 [转载时请注明来源]:http://www.cnblogs.com/runner-ljt/ Ljt 作为一个初学者,水平有限,欢迎交流指正. 线性回归容易出现过拟合或欠拟合的问 ...

- Logistic Regression Algorithm解决分类问题

在线性回归算法中,我们看到,在training set中,输入矩阵X与向量y的值都是连续的.所以在二维空间中,我们可以用一条直线去模拟X与y的变化关系,寻找参数向量theta的取值.如根据房屋面积预测 ...

随机推荐

- 谈一下你对 uWSGI 和 nginx 的理解??

1.uWSGI 是一个 Web 服务器,它实现了 WSGI 协议.uwsgi.http 等协议.Nginx 中HttpUwsgiModule 的作用是与 uWSGI 服务器进行交换.WSGI 是一种 ...

- 在 linux 中 find 和 grep 的区别??

Linux 系统中 grep 命令是一种强大的文本搜索工具,它能使用正则表达式搜索文本,并把匹配的行打印出来.grep 全称是 Global Regular Expression Print,表示全局 ...

- jenkins使用记录转自https://my.oschina.net/sanpeterguo/blog/197931

摘要: jenkins(持续集成开源工具)提供了丰富的api接口,基本上所有的操作都可以使用curl来从后台调度,包括:创建项目,禁用项目,启用项目,获取项目描述,获取配置文件,普通触发,scm触发, ...

- C#设计模式:享元模式(Flyweight Pattern)

一,什么是享元模式? 享元模式(Flyweight Pattern):采用共享技术来避免大量拥有相同内容对象的开销,主要用于减少创建对象的数量,以减少内存占用和提高性能 1,根本的思路就是对象的重用2 ...

- 6个优秀的微信小程序ui组件库

开发微信小程序的过程中,选择一款好用的组件库,可以达到事半功倍的效果.自从微信小程序面世以来,不断有一些开源组件库出来,下面6款就是排名比较靠前,用户使用量与关注度比较高的小程序UI组件库.还没用到它 ...

- openstack stein部署手册 5. placement

# 建立数据库用户及权限 create database placement; grant all privileges on placement.* to placement@'localhost' ...

- Windows 好用的护眼软件

目录 1. 按 2. Windows10自带夜间模式 3. Iris Pro 3.1. 介绍 3.1.1. 保护用眼,改善睡眠 3.1.2. ×9 种不同的预设搭配 3.1.3. 计时器 3.1.4. ...

- 12.解决SUSE Linux无法使用SSH登录的问题

问题: SUSE_Linux 无法使用SSH连接登录. 解决: 1.关闭防火墙命令如下: linux:~ # /etc/init.d/SuSEfirewall2_init stop linux:~ # ...

- tenorflow 模型调优

# Create the Timeline object, and write it to a json from tensorflow.python.client import timeline t ...

- python实现通过企业微信发送消息

实现了通过企业微信发送消息,平时用于运维的告警还是不错的,相对于邮件来说,实时性更高,不过就是企业微信比较麻烦,此处不做过多解释. 企业微信api的详细请看:http://work.weixin.qq ...