[转帖]TiKV读写流程浅析

https://www.cnblogs.com/luohaixian/p/15227838.html

1.TiKV框架图和模块说明

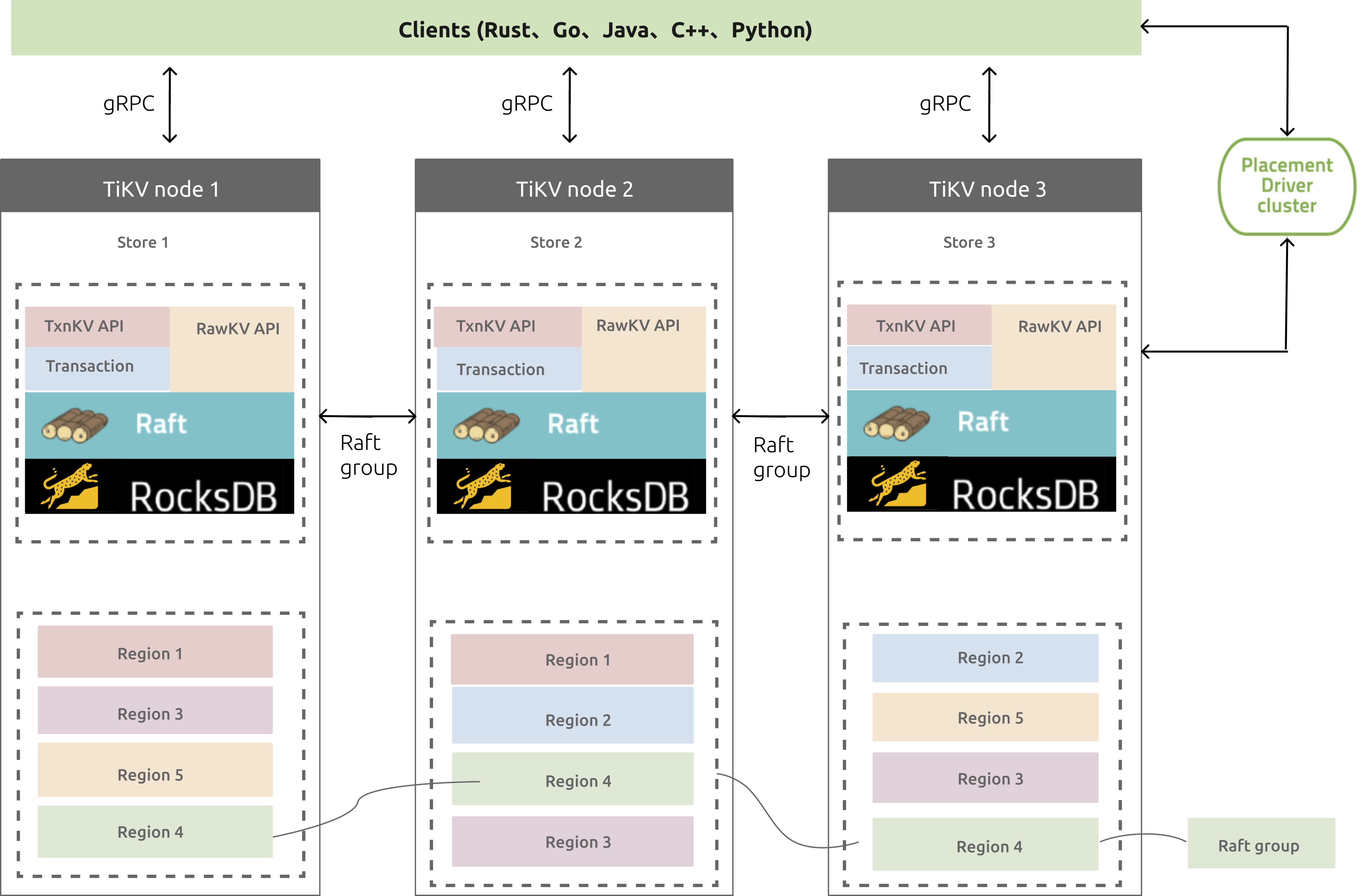

图1 TiKV整体架构图

1.1.各模块说明

PD Cluster:它是由多个PD节点组成的etcd集群,PD是具有“上帝视角”的管理组件,负责存储元数据和进行负载均衡,比如Region对应的range段信息、调度Region切分和合并等;

gRPC:开源远程过程调用系统,客户端服务端可基于该协议进行请求通信;

Placement Driver:管理TiKV集群,管理着整个集群的元数据信息,负责检查数据一致性和数据自动平衡迁移;

TiKV node:用来存储键值对的节点;

TxnKV API:支持事务操作的API;

RawKV API:不保证事务的的API;

Raft:一致性算法,TiKV集群使用了该算法来同步节点数据;

RocksDB:TiKV的真实后端存储组件,RocksDB本身是个开源的键值对存储系统;

Region:键值对数据移动的基本单位,每个region被复制到多个Nodes;

Raft group:多个同Region就组成一个Raft group,比如图中不同颜色的Region,同颜色的就组成一个Raft group;

Leader:每个Raft gorup会有个Leader,负责处理客户端的请求读或写,请求会先到Leader节点,再由Leader节点通知从节点修改。

1.2.功能特性

(1)多副本数据和数据自动均衡;

(2)容错和数据恢复;

(3)支持设置key的过期时间;

(4)支持原子性的CAS(compare-and-swap);

(5)支持分布式事务;

2.TiKV工作流程原理

2.1. 分布式事务

TiKV的事务模型是使用Percolator Transaction model。

该事务模型依赖于一个时间戳服务,我们称它为timestamp oracle,它会定时预先分配一个范围时间戳,并且会将最大的那个时间戳保存到磁盘上,然后即可在内存中递增产生范围内的时间戳给请求,这样即使该时间戳服务宕机了,下一次它预分配的也会从之前在磁盘上保存的那个最高时间戳后开始进行预分配,保证分配的时间戳永远是不会回退的。该时间戳服务是嵌入到PD服务里的,由PD leader进行服务。

Percolator最先是应用在google的BigTable项目上的,它是一个支持单行事务的分布式存储系统。

Percolator有CF(column family )的概念,类似于Rocksdb中的CF,每个CF会对应一个LSM Tree,但共享与一个WAL。

Percolator有5个CF,分别是lock、data、write、notify和ack;

Tikv里只涉及到前面3个,这里只讲述前面3个。

当开启一个事务写入一个 key-value 的时候:

Prewrite阶段(两阶段中的第一阶段):

lock CF:将该key的lock放到lock CF;

data CF:将该key对应的value放到data CF;

Commit阶段(两阶段中的第二阶段):

write CF:将相对应的commit信息放到write CF;

写数据过程:

在提交数据时采用两阶段提交。

Prewrite阶段:

(1)获取事务的开始时间戳start_ts;

(2)将事务涉及到的多个数据在lock CF中进行写入,写入时会检查是否该数据是否已经被其它事务锁住,如果是则进行回滚;并且从多个数据中选择一个作为primary lock,其它的使用secondary lock,secondary lock里包含了primary对应数据的信息;

(3)将新数据写入到data CF中,同时在写入时也需要检查该数据是否有大于start_ts时间戳的事务更新提交,如果有则表示有冲突,需要进行回滚

如果Prewrite阶段没有冲突,则Prewrite阶段成功,进入Commit阶段。

Commit阶段:

(1)获取commit时间戳commit_ts;

(2)对primary的数据进行写入,将commit信息写入到write CF中,从lock CF中移除该数据的primary lock;

(3)对Secondary的数据进行写入,类似primary一样的操作;

注意:commit阶段当完成了第(2)步的primary数据的commit后就表示这个事务已经成功了,即使第(3)步的Secondary的数据commit失败了也不影响整个事务表示成功,所以commit阶段当完成了前两步就向客户端表示事务成功,第(3)是使用异步步的方式进行commit的。原因是Prewrite阶段上锁成功表示commit阶段不会有冲突问题,所以一般都会成功,但有一种情况会失败,那就是比如发生了类似宕机这样的事情,那么此时Secondary锁还会在lock CF里,所以其它事务在检测该数据锁时是判断不了该数据事务是否已提交的,它可以通过Secondary lock获取到之前Primary的信息,然后去查找对应的Primary数据是否commit成功,如果是则表示该事务已经提交成功了,继续执行,如果Primary lock也还存在还未提交则上锁失败。

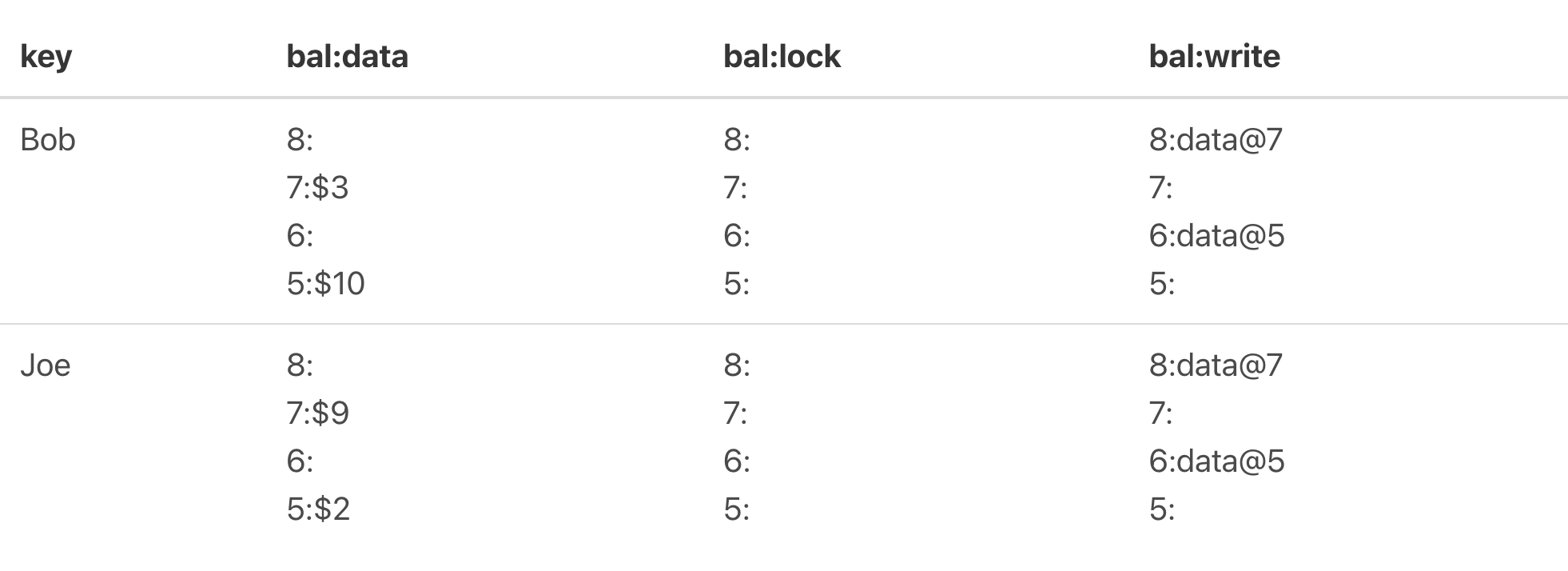

举例:

假设Bob有10元,Joe有2元,现在Bob要转7元给Joe。

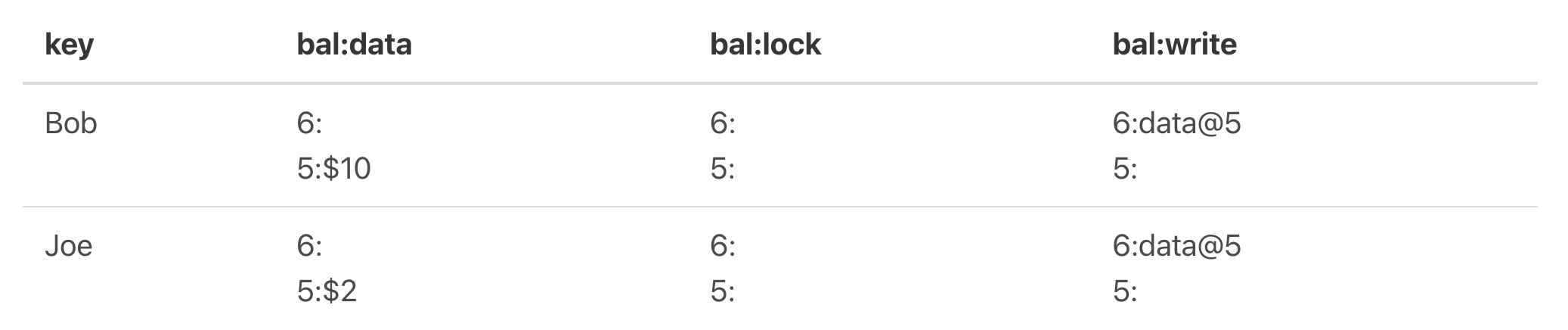

图2

如上图,这里涉及到两个key,Bob和Joe,它们目前key情况是最新提交是6,对应的data值是10和2。

现在进行转账操作,进行数据提交,那么在Prewrite阶段,就要进行lock CF写入和data CF写入,写入后如下图:

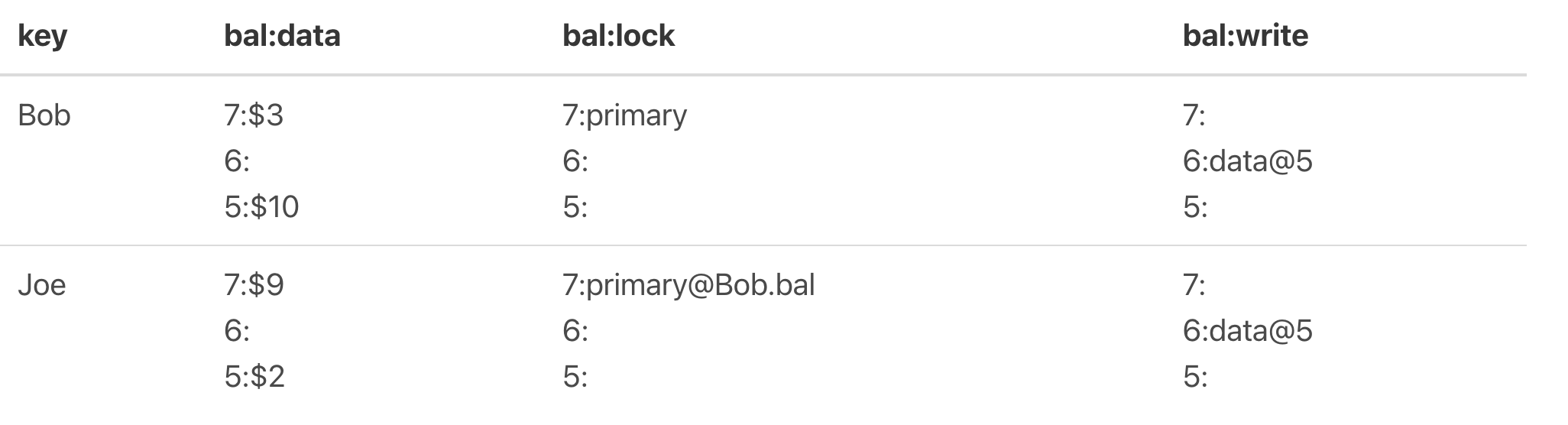

图3

可以看到Bob该key被选中为Primary,并且data里都写上了经过转账后的值,分别为3和9,并且前面的7为申请的start_ts。

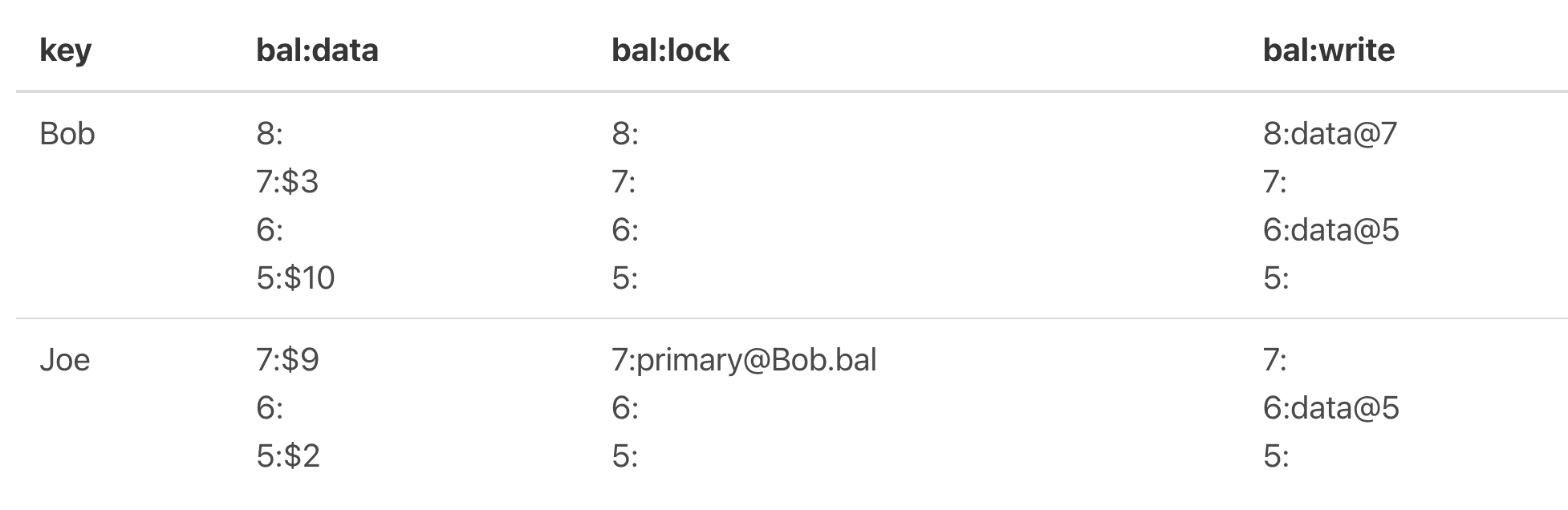

Prewrite阶段顺利,进入commit阶段,先primary的key进行commit,commit后的情况如下图:

图4

可以看到Bob的primary lock已经移除,Joe的还没commit。

Joe的也进行commit得到如下图所示:

图5

读过程:

假设以图5为例,读取Bob key的值。

(1)首先也需要申请一个start_ts;

(2)然后在lock CF上搜索Bob key在[0, start_ts]上有没有被上锁,如果有则读取失败待会进行重试,可以看到Bob key上是没有锁的;

(3)从write中获取[0, start_ts]最新的写事务提交值,取到了该key最新写事务的start_ts,从图中可以看到是7;

(4)通过7去获取data CF上的start_ts为7时的值,从图中可知是3,获取成功并返回。

TiKV中的Percolator跟上述讲的类似,不过它的CF是defautl、lock和write,default对应的是上面所描述的data。同时也做了一些优化。

从上面过程中,我们看到在写入data时,是将key和start_ts一起写入的,start_ts是一个8bytes的值,会将它用大端序表示并进行取反(最新事务start_ts比旧事务start_ts大,取反后就会比旧start_ts小了),这样做的目的是因为rocksdb存储的LSM Tree的key是按序存放的,所以相同的key的不同版本会是相邻的且最新的事务的key排在前面,这样在查找最新事务提交时就会最先找到。

优化点:

(1)一个事务多个keys的Prewrite会分发到多个tikv节点进行并发预写,当有一个失败时,则进行回滚;

(2)对于比较小的value,在两阶段提交时,数据最后不放入data CF里,而是直接存放到write CF里,这样就不用先在write CF找,然后再在data CF里找,只需要一个LSM Tree的查找;

(3)如果事务只读取单个key,没必要获取start_ts,直接从write CF里读取最新版本的提交;

(4)由于单个Region的多个key的写入是原子方式写入的,所以对于一个事务,如果涉及的写入的key都是在同一个Region的话,就可以不使用两阶段提交方式写入了,直接1阶段提交写入。

2.2. 写入流程

在TiKV中,Region是保存key的基本单元,client端在读写数据时,都会先从pd中获取指定key对应的Region信息,比如Region对应的leader tikv节点,然后向该节点发起请求,同时该Region的信息也会被缓存下来可用来加速后续的同样在该Region的key的读写。

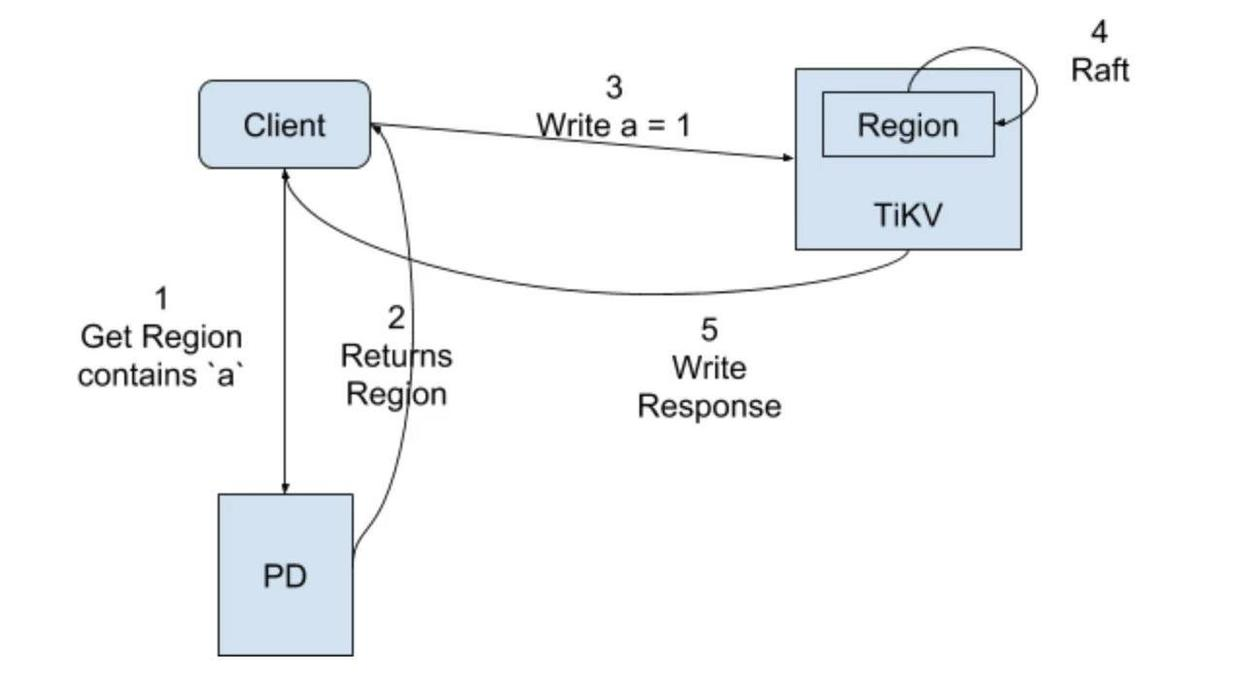

非事务的写入流程图:

非事务写入流程:

(1)client端获取操作的key所在的Region信息;

(2)PD返回该key所在Region的信息,包括Region对应的TiKV Leader节点信息等;

(3)向TiKV服务发起写请求;

(4)由于Region是一个Raft group,这期间会进行一个Raft协议共识,会让该Region的followers节点也收到该操作日志(把操作当做一个日志,进行日志复制,应用时解析该日志进行执行),收到半数以上回复时即Leader节点应用该日志并回复客户端,且在下一次心跳时告诉客户端应用该日志;

(5)回复处理结果。

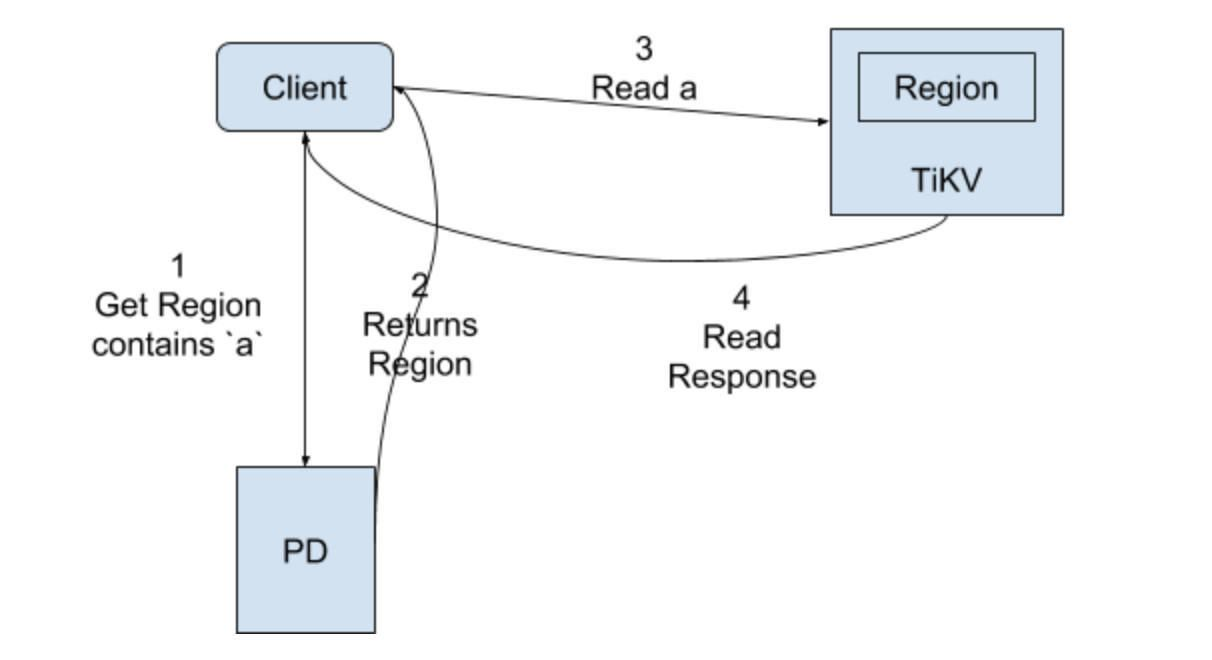

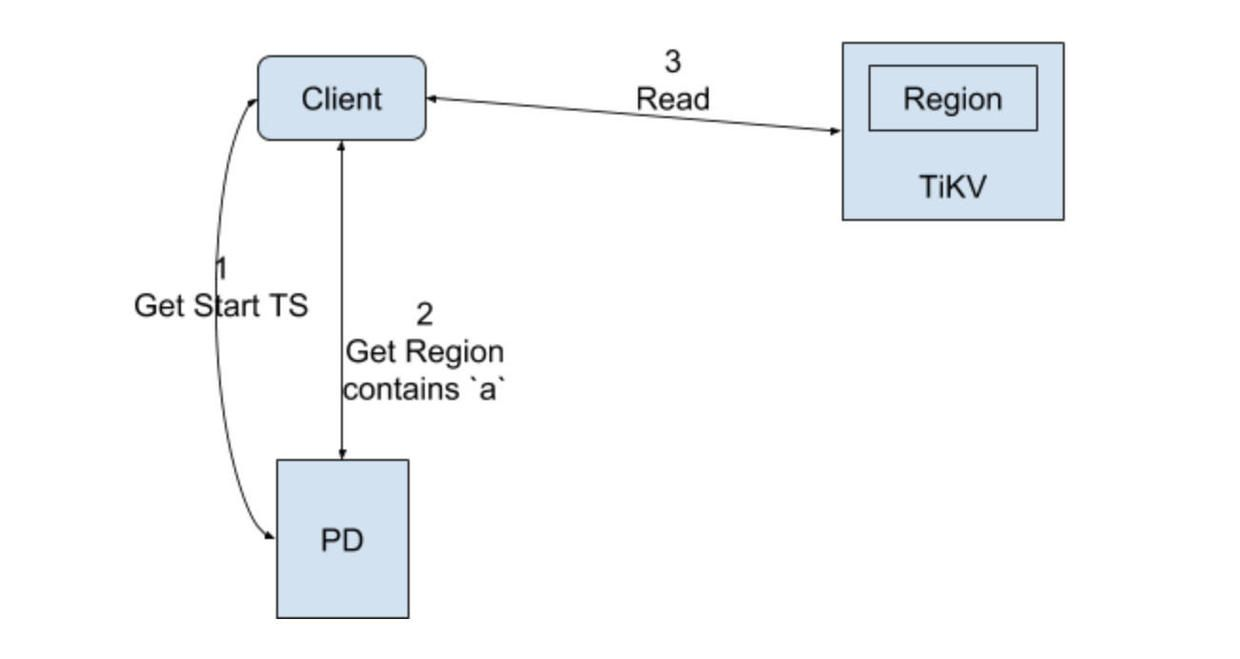

非事务的读取流程图:

非事务读取流程:

(1)向PD获取Region的信息;

(2)返回Region信息;

(3)请求TiKV节点读取key值;

(4)返回key值信息;

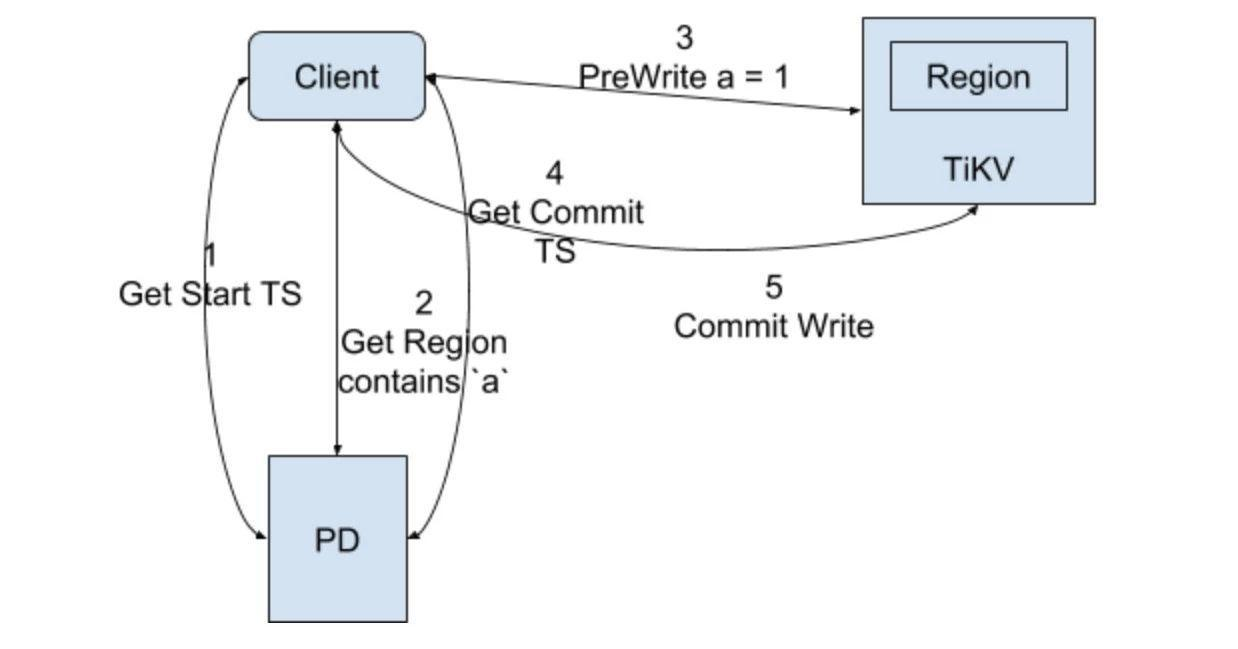

事务写请求图:

事务写请求流程:

注意,这里图中只写了事务中只有一个key更改的情况,没有代表性,流程里讲时会加入b也更改,且与a在不同的Region。

(1)开启事务获取事务start_ts;

(2)client端获取a和b的Region信息,假设a对应Region1,b对应Region2,那么在Prewrite阶段,client端会并行分别向这两个Region节点发送写请求进行预写,同时参数里会带上start_ts和Primary或Secondary,预写入的过程就类似于上面写的Percolator的Prewrite的过程,这里以key a为例讲述具体写入CF的过程,假设申请的start_ts是10,key b也是一样的,如果两者有一个Prewrite阶段失败,那么就是失败,进行回滚操作;

首先是写lock CF:

lock CF:W a = Primary

然后是data CF:

data CF:a_10 = new_value

(3)当key a和b的Prewrite都成功的情况下进行Commit阶段;

(4)申请commit_ts,假设是11;

(5)此时client端只会先向key a的Region1发起commit请求(因为它是Primary lock),然后就是Percolator的commit阶段

写write CF,它的值是start_ts:

write CF:a_11 = 10

(6)key a的commit成功则向用户返回事务成功了,然后再异步提交key b的commit,这里key b就算失败也无碍的原因在Percolator里说过了,本质就是其实CF里都已经记录下最新值的修改了,只是Secondary的lock没有移除掉。

事务的读请求流程图:

从Leader Region节点读取值。

2.3.Range划分

tikv的range是一种按照key字节序进行排序的可看做是无限的sorted map,如果将该range按指定的点进行切分成多段range,那么每段range就是一个region;

tikv初始只有一个region,可以记为["", ""),region遵循左闭右开,比如如果使用key为abc1对该region进行切分则会得到两个region:

region1:["", "abc")

region2:["abc", "")

默认配置下,一个Region的保存上限大小是96M,当Region保存的数据大于96M时,就会进行Region自动切分,分成均衡的两个Region。

配置参数:region-split-size

TiKV在4.0版本引入了Load Base Split特性,该特性是用来解决Region热点问题,当大量请求都打到一个Region时,由于一个Region的读写都是由一个节点上的Leader进行处理的,导致大部分请求由一个节点处理,会造成瓶颈,该功能特性的原理是基于统计的信息进行判断,如果某个Region 10s内的qps或流量超过了配置文件中指定的值,则会对其进行Region拆分,并被调度分配到不同的节点上以打散热点Region。

相关配置参数:

QPS阈值参数:split.qps-threshold

流量阈值参数:split.byte-threshold

除了分裂,Region也会进行合并操作,避免有大量的空Region存在,造成大量的通信和管理开销。

系统会定时的去轮询检测所有Region,如果Region的大小大于max-merge-region-size配置值(默认20M),则不会与相邻的Region进行合并;如果Region的key的数量大于max-merge-region-keys配置值(默认

200000个)则不会与相邻的Region进行合并;否则其它情况都会与相邻的Region进行合并。

[转帖]TiKV读写流程浅析的更多相关文章

- TiKV事务实现浅析

TiKV事务实现浅析 Percolator事务的理论基础 Percolator的来源 Percolator事务来源于Google在设计更新网页索引的系统时提出的论文Large-scale Increm ...

- 玩转Windows服务系列——服务运行、停止流程浅析

通过研究Windows服务注册卸载的原理,感觉它并没有什么特别复杂的东西,Windows服务正在一步步退去它那神秘的面纱,至于是不是美女,大家可要睁大眼睛看清楚了. 接下来研究一下Windows服务的 ...

- HBase 数据读写流程

HBase 数据读写流程 2016-10-18 杜亦舒 读数据 HBase的表是按行拆分为一个个 region 块儿,这些块儿被放置在各个 regionserver 中 假设现在想在用户表中获取 ro ...

- HDFS文件读写流程

一.HDFS HDFS全称是Hadoop Distributed System.HDFS是为以流的方式存取大文件而设计的.适用于几百MB,GB以及TB,并写一次读多次的场合.而对于低延时数据访问.大量 ...

- Android 4.4 Kitkat Phone工作流程浅析(六)__InCallActivity显示更新流程

本文来自http://blog.csdn.net/yihongyuelan 转载请务必注明出处 本文代码以MTK平台Android 4.4为分析对象,与Google原生AOSP有些许差异,请读者知悉. ...

- 玩转Windows服务系列——服务运行、停止流程浅析

原文:玩转Windows服务系列——服务运行.停止流程浅析 通过研究Windows服务注册卸载的原理,感觉它并没有什么特别复杂的东西,Windows服务正在一步步退去它那神秘的面纱,至于是不是美女,大 ...

- PHP容器--Pimple运行流程浅析

需要具备的知识点 闭包 闭包和匿名函数在PHP5.3.0中引入的. 闭包是指:创建时封装周围状态的函数.即使闭包所处的环境不存在了,闭包中封装的状态依然存在. 理论上,闭包和匿名函数是不同的概念.但是 ...

- 【转】linux IO子系统和文件系统读写流程

原文地址:linux IO子系统和文件系统读写流程 我们含有分析的,是基于2.6.32及其后的内核. 我们在linux上总是要保存数据,数据要么保存在文件系统里(如ext3),要么就保存在裸设备里.我 ...

- zookeeper的读写流程

zookeeper的读写流程 基本架构 节点数要求是奇数. 常用的接口是 get/set/create/getChildren. 读写流程 写流程 客户端连接到集群中某一个节点 客户端发送写请求 服务 ...

- Hadoop---HDFS读写流程

Hadoop---HDFS HDFS 性能详解 HDFS 天生是为大规模数据存储与计算服务的,而对大规模数据的处理目前还有没比较稳妥的解决方案. HDFS 将将要存储的大文件进行分割,分割到既定的存储 ...

随机推荐

- Shiro 的基本使用

简介 Apache Shiro 是一个强大的.灵活的开源安全框架,可以干净地处理验证.授权.企业会话管理和加密等功能 相关特性 Apache Shiro 具有的主要特性如下图所示: 主要关注的地方在于 ...

- 占位图片(Placeholder Image)

一.引言 在网页设计和开发中,占位图片(Placeholder Image)是一种常见的技术手段,用于在用户上传图片之前或者图片加载失败时,展示一个临时替代的图片,以提高用户体验.本文将详细介绍占位图 ...

- SaaS 营销怎么做?几点思考

按大部分 SaaS 公司组织架构,梳理了这 4 大业务部门(产品.市场.销售.服务-客户成功)的职责和客户价值链条.如图: 根据客户价值体验地图,分为两块过程: 客户营销过程 客户成功过程 针对 Sa ...

- 从4个特点为你解密华为云媒体网络底座AND

本文分享自华为云社区<解密华为云媒体网络底座ADN>,作者: Satan.D . 互联网的痛点与解决思路 互联网自1968年起源依赖,已经发展了半个多世纪.互联网仅从中文字面意思,可以简单 ...

- LiteOS基于Sensorhub的超声波模组移植

摘要:本文为你带来LiteOS基于Sensorhub的超声波模组移植的应用. 1.Sensor Hub LiteOS传感框架即Sensor Hub,是一个基于Huawei LiteOS物联网操作系统的 ...

- 5月20日,GaussDB将有大事发生

摘要:5月20日,华为云TechWave云原生2.0专题将线上举行,更多云原生创新技术和丰富实践还将与大家见面,GaussDB也将再次迎来升级亮相! 本文分享自华为云社区<华为云TechWave ...

- 再获信通院权威认证,优等生华为云GaussDB数据库凭什么?

摘要:在八大项测试中,华为云 GaussDB的两款数据库都以优异的成绩通过.那么这两款数据库究竟是凭借什么获此殊荣呢? 近期,中国信通院公布了第十三批数据库产品基础能力.性能和稳定性评审结果.在本次评 ...

- 前端资源共享方案对比-笔记:iframe/JS-SDK/微前端

前端页面资源如何分享,常见的有iframe,其次是js-sdk.这两类的在地图类工具经常用.微前端是最佳比较火的方式.本篇是他们的对比分析. 下一篇讲 BK-VISION如何在让用户自由选择 ifra ...

- linux 账号管理 添加用户与修改用户权限与密码

添加用户 useradd zhoulujun 修改用户密码 passwd zhoulujun 修改用户组 usermod -g root zhoulujun 记住这个几个就够了--

- Kubernetes(K8S) 配置管理 Secret 介绍

Secret 作用:加密数据(base64)存在 etcd 里面,让 Pod 容器以挂载 Volume 方式进行访问 场景:凭证 [root@k8smaster ~]# echo -n 'admin' ...