Excel文件 利用MySQL/Python 实现自动处理数据的功能

问题描述:

在没有服务器存储数据,只有excel文件的情况下,如何利用SQL和python实现数据分析和数据自动处理的功能?

例如:消费者购买商品时,会挑选商品然后再对商品付款。现在需要查找出用户挑中但是没有付款的商品并标识为未下单,付款的商品标注为下单。并且每隔一段时间自动执行上述操作。

目的:定时抽取上面的数据分析用户购买商品的行为。对比付款和选中未下单的商品的性能、价格等信息来发掘用户喜好,从而提高选品下单率。

注意:

- 用户的信息主要以excel的形式存储,没有服务器。

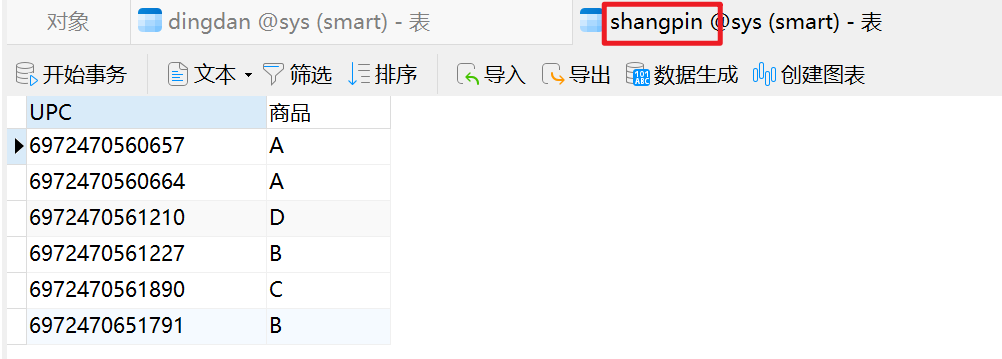

- 商品表里面存了用户挑选的商品信息。

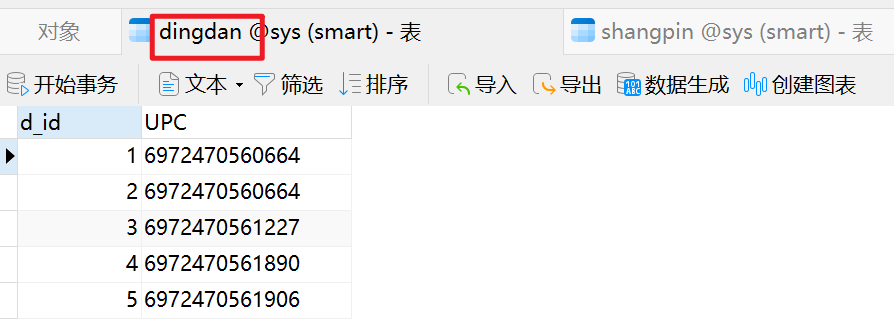

- 订单表里面存了用户付款的商品信息。

解决方案:

一、SQL查询

首先想到的是利用SQL语言实现这样的查询。具体实现过程如下:

(1) 建立dingdan表和shangpin表:

-- ----------------------------

-- Table structure for dingdan

-- ----------------------------

DROP TABLE IF EXISTS `dingdan`;

CREATE TABLE `dingdan` (

`d_id` int(11) NOT NULL,

`UPC` varchar(255) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,

PRIMARY KEY (`d_id`) USING BTREE

) ENGINE = InnoDB CHARACTER SET = utf8 COLLATE = utf8_general_ci ROW_FORMAT = Dynamic;

-- ----------------------------

-- Records of dingdan

-- ----------------------------

INSERT INTO `dingdan` VALUES (1, '6972470560664');

INSERT INTO `dingdan` VALUES (2, '6972470560664');

INSERT INTO `dingdan` VALUES (3, '6972470561227');

INSERT INTO `dingdan` VALUES (4, '6972470561890');

INSERT INTO `dingdan` VALUES (5, '6972470561906');

SET FOREIGN_KEY_CHECKS = 1;

-- ----------------------------

-- Table structure for shangpin

-- ----------------------------

DROP TABLE IF EXISTS `shangpin`;

CREATE TABLE `shangpin` (

`UPC` varchar(255) CHARACTER SET utf8 COLLATE utf8_general_ci NOT NULL,

`商品` varchar(255) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL,

PRIMARY KEY (`UPC`) USING BTREE

) ENGINE = InnoDB CHARACTER SET = utf8 COLLATE = utf8_general_ci ROW_FORMAT = Dynamic;

-- ----------------------------

-- Records of shangpin

-- ----------------------------

INSERT INTO `shangpin` VALUES ('6972470560657', 'A');

INSERT INTO `shangpin` VALUES ('6972470560664', 'A');

INSERT INTO `shangpin` VALUES ('6972470561210', 'D');

INSERT INTO `shangpin` VALUES ('6972470561227', 'B');

INSERT INTO `shangpin` VALUES ('6972470561890', 'C');

INSERT INTO `shangpin` VALUES ('6972470651791', 'B');

SET FOREIGN_KEY_CHECKS = 1;

(2) 将excel数据导入SQL软件中。

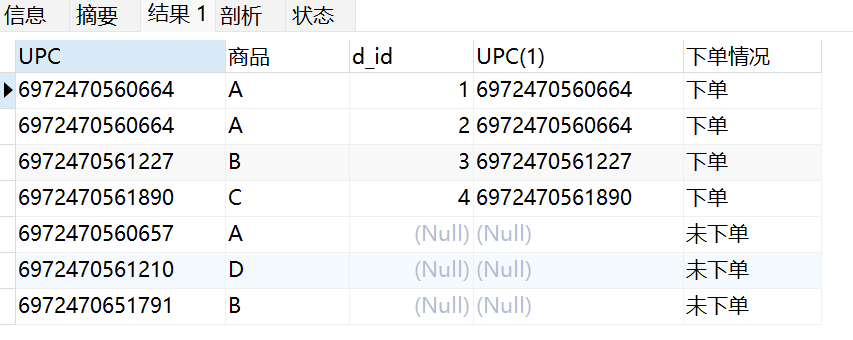

- 执行下面的查询语句进行查找:

-- 搜索未下单的商品信息

SELECT *,

if(bb.UPC IS NULL,'未下单', '下单') as 下单情况

FROM shangpin aa

LEFT JOIN dingdan bb

ON aa.UPC = bb.UPC

- 得到以下查询结果:

(3) 将搜索结果导出为excel。

(4) 隔一段时间,需要人工重复上面的操作。

二、SQL、python处理

利用SQL查询、python做定时处理。具体实现过程如下:

(1) 重复方案1中的步骤1和2,将数据导入到数据库中。

(2) 用python连接数据库并查找数据。

import pymysql #导入PyMySQL库

import datetime

import warnings

import pandas as pd

import matplotlib.pyplot as plt

warnings.filterwarnings('ignore')

# 1. 连接数据库,创建连接对象 db

# 连接对象作用是:连接数据库、发送数据库信息、处理回滚操作(查询中断时,数据库回到最初状态)、

# 创建新的光标对象

def connect_database(database, password):

db = pymysql.connect(host ="localhost", #host属性

user ="sys", #用户名

password = password, #此处填登录数据库的密码

database = database, #数据库名

charset="utf8" # 如果中文显示乱码,则需要添加charset = "utf8"

)

return db

def read_data(db):

# 2. 使用 cursor() 方法创建一个游标对象 cursor

cursor = db.cursor()

# 3. 利用MySQL语句查找数据并转化为FrameData(包含列名)

try:

# 使用 execute() 方法执行 SQL 查询

mysql = "SELECT *, if(bb.UPC IS NULL,'未下单', '下单') as 下单情况 FROM shangpin aa LEFT JOIN dingdan bb ON aa.UPC = bb.UPC" # SQL语句

cursor.execute(mysql)

data = cursor.fetchall()

# 下面为将获取的数据转化为 dataframe 格式

columnDes = cursor.description #获取连接对象的描述信息

#print("cursor.description中的内容:",columnDes)

columnNames = [columnDes[i][0] for i in range(len(columnDes))] #获取列名

df = pd.DataFrame([list(i) for i in data],columns=columnNames) #得到的data为二维元组,逐行取出,转化为列表,再转化为df

print(df)

"""

db.commit()若对数据库进行了修改,需进行提交之后再关闭

"""

# 提交到数据库执行

#db.commit()

#print("OK")

except:

# 如果发生错误则回滚

db.rollback()

print("失败")

"""

使用完成之后需关闭游标和数据库连接,减少资源占用,cursor.close(),db.close()

db.commit()若对数据库进行了修改,需进行提交之后再关闭

"""

# 关闭数据库连接

cursor.close()

db.close()

return df

(3) 做定时任务

## 定时任务

import time

from apscheduler.schedulers.blocking import BlockingScheduler

def job():

dt = time.strftime('%Y-%m-%d %H:%M:%S', time.localtime(time.time()))

print('{} --- {}'.format(text, t))

database = 'sys' #数据库名称

password = 'sys' #数据库用户密码

db = connect_database(database, password)

data_sp = read_data(db)

data_sp.to_excel('../data/data_ans.xlsx', sheet_name='未下单情况')

scheduler = BlockingScheduler()

# 在每天22和23点的25分,运行一次 job 方法

scheduler.add_job(job, 'cron', hour='22-23', minute='25')

scheduler.start()

## 测试

# 执行任务

def time_printer():

# 输出时间

now = datetime.datetime.now()

ts = now.strftime('%Y-%m-%d %H:%M:%S')

print('do func time :', ts)

# 定时任务

def loop_monitor():

while True:

time.sleep(20) # 暂停20秒

if __name__ == "__main__":

loop_monitor()

打开data_ans的excel文件即可查看数据。

程序需要一直运行,如果因为关机导致程序终止,需要重新运行。

三、python处理

python处理。具体实现过程如下:

(1) 导入excel数据并利用python完成数据查询,以excel的形式导出查询好的数据。

参考

import pandas as pd

def taskTime():

## 1. 分别导入2个表的数据

product = pd.read_excel('d:/python_code/crontab/data/taskdata.xlsx', sheet_name='商品') # 换成自己的路径和sheet名称

order = pd.read_excel('d:/python_code/crontab/data/taskdata.xlsx', sheet_name='订单')

## 2. 抽取数据

product=product.rename(columns={'UPC':'ID'}) # 对商品表里面的UPC重命名未ID(为了保留订单表里面的CPU着一列)

PO=pd.merge(product,order,left_on='ID', right_on='UPC',how='left') # 左连接抽取数据

PO.loc[pd.isnull(PO['UPC']), '下单情况'] = '未下单' # 找到选中但是未下单的数据标注为未下单

PO['下单情况'] = PO['下单情况'].fillna(value='下单') # 找到下单的数据,在'下单情况'这一列中标注为下单

## 3. 以excel的形式导出查询好的数据

PO = PO.loc[:, ['ID', 'UPC', '下单情况', '产品名称E', '产品参数C', '价格', '建议零售价','订单日期', '品牌', 'PO#', 'SKU','配置', '单价', '数量', '销售金额', '成本单价', '成本', '成本价含税/未税']] # 按列名导出需要的数据

PO.to_excel('d:/python_code/crontab/data/data_python.xlsx', sheet_name='未下单情况') # 导出excel表

return PO

if __name__ == "__main__":

taskTime()

print('执行成功')

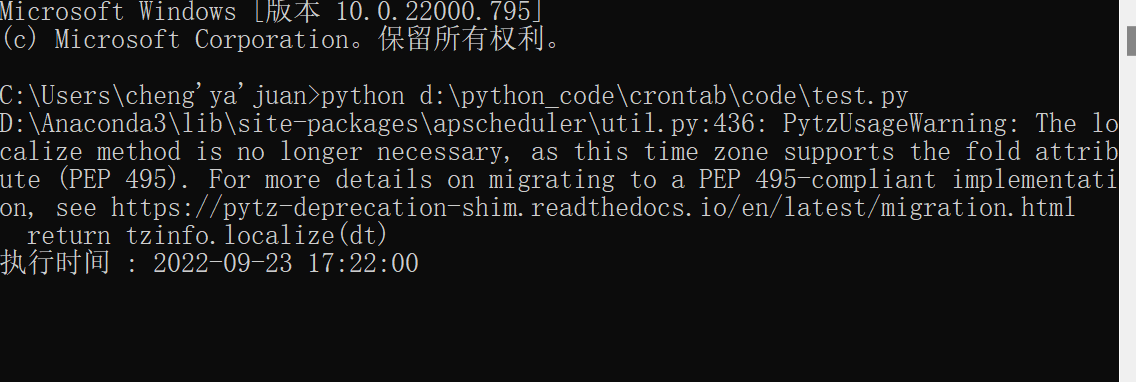

(2) 定时处理

## 2. 定时处理

import datetime

from apscheduler.schedulers.blocking import BlockingScheduler

def job():

now = datetime.datetime.now()

ts = now.strftime('%Y-%m-%d %H:%M:%S')

print('执行时间 :', ts) # 输出时间

taskTime() # 执行代码

scheduler = BlockingScheduler() ## 定时

# 在每天17和23点的25分,运行一次 job 方法

scheduler.add_job(job, 'cron', hour='17-23', minute='22')

scheduler.start()

打开data_python的excel文件即可查看数据。

程序需要一直运行,如果因为关机导致程序终止,需要重新运行。

四、优化python处理

1.手动执行代码

如果电脑需要关机,这时候代码不能一直运行,只能在需要数据的时候执行一下代码。有以下2个执行方法:

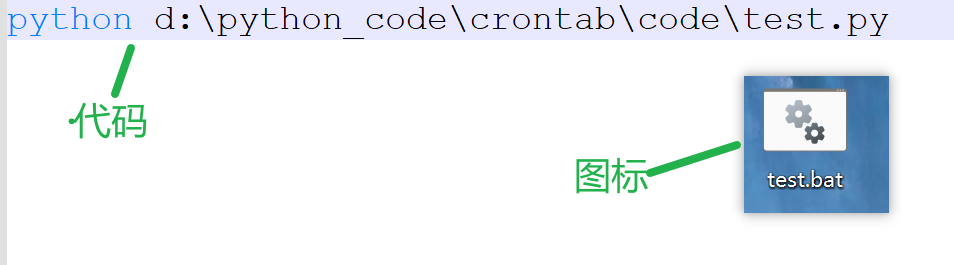

(1)用命令行执行代码,具体操作如下:

win + R 输入cmd 再输入 路径以及文件名

python d:\python_code\crontab\code\test.py

见下图

注意:数据还有代码的路径要写对

如果不想用命令行。直接用.bat文件执行也可以。

首先,需要新建一个.bat文件(用来运行脚本),在这个文件里面写上如下代码后保存:

python 路径\文件名.py

将这个文件放到桌面,使用时点击即可。

2.开机自动执行代码

将已经保存的.bat文件复制到该目录(C:\Users\Administrator\AppData\Roaming\Microsoft\Windows\Start Menu\Programs\Startup)下,可能杀毒软件会阻止,选择允许,然后重启电脑即可。

注:开机自启以后会打开一个cmd窗口,关闭窗口,python程序将停止运行。

注意:开启自启动可能会让电脑变慢、发热。。。

对比四种方案:

| 方案名称 | 优点 | 缺点 |

|---|---|---|

| SQL查询 | 代码简单,实现简单 | 数据一旦更新需要执行导入导出excel的操作。并且需要手动操作,不能自动提醒。 |

| SQL、python处理 | 避免导出excel;可以自动提醒 | 还是需要导入excel;同时操作SQL和python;自动提醒需要程序一直运行 |

| python处理 | 避免导入导出;可以自动提醒,只操作python | 查询时的处理不好做(对新手来说);自动提醒需要程序一直运行 |

| 优化python处理 | 避免导入导出;自动提醒不需要程序一直运行,开机自启动 | 需要配置一下 |

总结:

在没有服务器,以excel存储数据的情况下,同样可以利用SQL和python来做数据处理和分析,在遇到excel处理数据特别麻烦的时候可以选择上面的方案做处理,即可以锻炼自己的SQL和python编程的能力,又可以高效地解决问题。

Excel文件 利用MySQL/Python 实现自动处理数据的功能的更多相关文章

- MySql 利用mysql&mysqldum导入导出数据

MySql 利用mysql&mysqldum导入导出数据 by:授客 QQ:1033553122 测试环境 Linux下测试,数据库MySql 工具 mysqldump,该命令位于mysq ...

- 如何用Apache POI操作Excel文件-----如何在已有的Excel文件中插入一行新的数据?

在POI的第一节入门中,我们提供了两个简单的例子,一个是如何用Apache POI新建一个工作薄,另外一个例子是,如果用Apache POI新建一个工作表.那么在这个章节里面,我将会给大家演示一下,如 ...

- 使用Apache POI操作Excel文件---在已有的Excel文件中插入一行新的数据

package org.test; import java.io.File; import java.io.FileInputStream; import java.io.FileNotFoundEx ...

- 利用MYSQL的函数实现用户登录功能,进出都是JSON(第二版)

利用MYSQL的函数实现用户登录功能,进出都是JSON(第二版) CREATE DEFINER=`root`@`%` FUNCTION `uc_session_login`( `reqjson` JS ...

- excel文件 实现自动处理数据的功能

目录 问题描述: 解决方案: 一.SQL查询 二.SQL.python处理 三.python处理 四.优化python处理 1.手动执行代码 2.开机自动执行代码 对比四种方案: 总结: 问题描述: ...

- tp3.2.3运用phpexcel将excel文件导入mysql数据库

1,下载PHPExcel 2,配置将下载好的PHPExcel文件与PHPExcel.php 放到thinkphp 根目录 include/Library/Org/Util/下面 3,同时将PHPExc ...

- excel文件导入mysql

在数据处理的过程中,常常要把windows下的excel文件导入linux下的mysql.这其中会出现一些问题. 1.首先,要在mysql中建表.命令最好存在记事本中,可以随时修改,随时执行 crea ...

- 批处理快速合并多分Excel文件并将指定列的数据去重复

1.批处理快速合并多个excel文件方法: 新建一个.txt文本文件,就命名为合并.txt吧. 而后开启文件,复制以下代码到文件中: @echo off E: cd xls dir copy *.cs ...

- Excel 批量导入Mysql(创建表-追加数据)

之前弄数据库的时候, 测试excel导mysql, 中间用pandas 处理后再入库. 直接上代码, 此种有真意, 尽在不言中. #!/usr/bin/env python # coding: ut ...

- 不小心删除数据--利用MySQL的binlog恢复数据

MySQL Binary Log也就是常说的bin-log, ,是mysql执行改动产生的二进制日志文件,其主要作用有两个: * 数据回复 * 主从数据库.用于slave端执行增删改,保持与maste ...

随机推荐

- Java 中九种 Map 的遍历方式,你一般用的是哪种呢?

日常工作中 Map 绝对是我们 Java 程序员高频使用的一种数据结构,那 Map 都有哪些遍历方式呢?这篇文章阿粉就带大家看一下,看看你经常使用的是哪一种. 通过 entrySet 来遍历 1.通过 ...

- adb版本不同导致一个服务杀死另一个服务

前言 由于我用安装模拟器进行调试app,需要连接到固定端口, 而开发测试的时候用到eclipse中调用sdk中包含一个版本的adb, 另外Android killer中也包含一个版本的adb, 另外我 ...

- js 金钱3位格式化

function formatCash(str) { return str.split('').reverse().reduce((prev, next, index) => { return ...

- Fastjsonfan反序列化(1)

前言 之前只是对FastJson漏洞有简单的一个认知,虽然由于网上fastjson漏洞调试的文章很多,但是真正有着自己的理解并能清楚的讲述出来的文章少之又少.大多文章都是对已知的漏洞调用流程做了大量分 ...

- 数电第四周周结_by_yc

数电第四周周结 1.赋值语句 基本概念: 连续赋值: 1.连续赋值不能出现在过程块(如initial,always)中间: 2.连续赋值语句之间是并行的: 3. 只能对wire型变量进行赋 ...

- 错误:Required request parameter 'XXX' for method parameter type String is not present

错误信息:Required request parameter 'XXX' for method parameter type String is not present 这种都是前端请求方式不同,后 ...

- flutter系列之:移动端手势的具体使用

目录 简介 赋予widget可以点击的功能 会动的组件 可删除的组件 总结 简介 之前我们介绍了GestureDetector的定义和其提供的一些基本的方法,GestureDetector的好处就是可 ...

- Jmeter 函数助手之__time

接口中需要传入time时,可使用Jmeter 函数助手中的__time函数传入当前时间 格式和参数名称两个字段非必填,当都不填时直接点击生成按钮,得到13位时间戳:按图填写后,得到10位时间戳,获取当 ...

- 关于jQuery的操作

jQuery简介 简化了JS 类似于 后端 JDBC(操作数据库的基本API) dbutils(封装JDBC) xxx.jar 前端 JS ...

- JAVA中使用最广泛的本地缓存?Ehcache的自信从何而来2 —— Ehcache的各种项目集成与使用初体验

大家好,又见面了. 本文是笔者作为掘金技术社区签约作者的身份输出的缓存专栏系列内容,将会通过系列专题,讲清楚缓存的方方面面.如果感兴趣,欢迎关注以获取后续更新. 在上一篇文章<JAVA中使用最广 ...